メタがAIを連投して究極技を加速!初の AI 推論チップ、大規模モデルのトレーニング用に特別に設計された AI スーパーコンピューター

コンパイル済み | 李水清

編集 | Zhixixi ニュース 5 月 18 日(現地時間)、Meta は今後 10 年間の AI コンピューティング能力の需要の急激な増加に対応するため、壮大な計画を実行していると発表しました。 AI施設の次世代基盤。

Meta は、AI モデルを実行するための初のカスタム チップ、AI に最適化された新しいデータセンター設計、初のビデオ トランスコーディング ASIC、16,000 個の GPU の統合、AI スーパーコンピューター RSC など、AI の次世代インフラストラクチャ構築における最新の進捗状況を発表しました。 AIトレーニングの高速化などに利用されます。

▲メタ公式サイトのAIインフラ詳細公開

▲メタ公式サイトのAIインフラ詳細公開

Meta は AI を会社の中核インフラストラクチャーとみなしています。 Meta が 2010 年に最初のデータセンターに着工して以来、AI は、毎日 Meta ファミリのアプリケーションを使用する 30 億人以上の人々の原動力となっています。 2015 年の Big Sur ハードウェアから PyTorch の開発、そして昨年の Meta の AI スーパーコンピューターの初期展開に至るまで、Meta は現在、これらのインフラストラクチャをさらにアップグレードし、進化させています。

1. Meta の第一世代 AI 推論アクセラレーター、7nm プロセス、102.4TOPS の計算能力MTIA (Meta Training and Inference Accelerator) は、Meta が推論ワークロード用に社内でカスタマイズした最初のアクセラレータ チップ シリーズです。

AI ワークロードは Meta のビジネスのいたるところに存在しており、コンテンツ理解、情報フロー、生成 AI、広告ランキングなど、幅広いアプリケーション プロジェクトの基礎となっています。 AI モデルのサイズと複雑さが増大するにつれて、基盤となるハードウェア システムは、効率を維持しながらメモリと計算量を飛躍的に増加させる必要があります。しかし、Meta は、CPU がその規模に必要な効率レベルの要件を満たすことが難しいことに気づき、この課題に対処するために Meta が自社開発したトレーニングおよび推論アクセラレータ MTIA ASIC シリーズを設計しました。

2020 年以来、Meta は内部ワークロード用に第 1 世代の MTIA ASIC を設計しました。このアクセラレータはTSMCの7nmプロセスを使用し、800MHzで動作し、INT8精度で102.4TOPSの演算能力、FP16精度で51.2TFLOPSの演算能力を提供します。熱設計電力 (TDP) は 25W です。

レポートによると、MTIA は CPU よりも高いコンピューティング能力と効率を提供し、MTIA チップと GPU を同時に導入することで、各ワークロードのパフォーマンスが向上し、レイテンシーが短縮され、効率が向上します。

2. 次世代データセンターをレイアウトし、最初のビデオトランスコーディング ASIC を開発しますMeta の次世代データセンター設計は、現在の製品をサポートしながら、将来の世代の AI ハードウェアのトレーニングと推論をサポートします。この新しいデータセンターは AI 用に最適化され、液冷 AI ハードウェアと、データセンター規模の AI トレーニング クラスター用の数千の AI チップを接続する高性能 AI ネットワークをサポートします。

公式ウェブサイトによると、Meta の次世代データセンターも、より高速かつコスト効率よく構築され、Meta の成長するビデオを提供するために設計された Meta の初の社内開発 ASIC ソリューションである MSVP など、他の新しいハードウェアによって補完される予定です。仕事負荷が電力を供給します。生成 AI などの新しいテクノロジー コンテンツの出現により、ビデオ インフラストラクチャに対する人々の需要がさらに高まったため、Meta はスケーラブルなビデオ プロセッサ MSVP を発売することになりました。

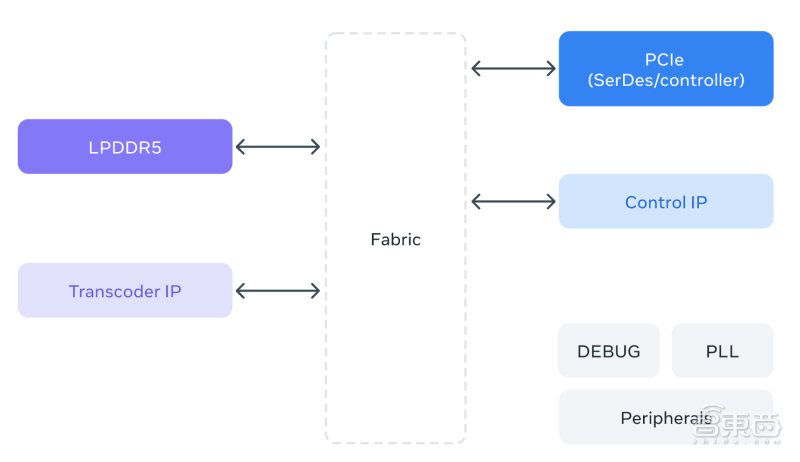

MSVP は、Meta が初めて自社開発したビデオトランスコーディング用 ASIC です。 MSVP はプログラム可能でスケーラブルであり、オンデマンドに必要な高品質のトランスコーディングだけでなく、ライブ ストリーミングに必要な低遅延と高速な処理時間を効率的にサポートするように構成できます。将来的には、MSVP は、AI 生成コンテンツ、VR (仮想現実) および AR (拡張現実) コンテンツを含む、メタ ファミリーのアプリケーションのすべてのメンバーに新しい形式のビデオ コンテンツを提供することにも役立ちます。

▲MSVP アーキテクチャ図

3. AI スーパーコンピューターは 16,000 個の GPU を統合し、LLaMA の大規模モデルをサポートしてトレーニングの反復を高速化します

Meta の発表によると、同社の AI スーパー コンピューター (RSC) は、世界最速の人工知能スーパーコンピューターの 1 つであり、次世代の大規模 AI モデルをトレーニングし、新しい AR ツールやコンテンツ理解システムに電力を供給するように設計されています。 、リアルタイム翻訳技術など。

Meta RSC は 16,000 個の GPU を備えており、3 レベルの Clos ネットワーク構造を通じてすべてアクセス可能で、2,000 の各トレーニング システムに全帯域幅を提供します。過去 1 年間、RSC は LLaMA のような研究プロジェクトを推進してきました。LLaMA は、今年初めに Meta によって構築され、オープンソース化された大規模な言語モデルであり、650 億のパラメーターの規模があります。 Meta によれば、その目標は、研究者が大規模なハードウェアを必要とせずに研究し、特定のタスクに合わせて微調整できる、より小型で高性能のモデルを提供することです。

1.4兆トークンに基づいてメタトレーニングされたLLaMA 65Bとより小規模なLLaMA 33B。その最小モデルである LLaMA 7B もトレーニングに 1 兆トークンを使用します。大規模に実行できるため、Meta はトレーニングと調整の繰り返しを加速し、他の企業よりも早くモデルをリリースできます。

結論: 大型モデル技術の適用により、大手メーカーはインフラストラクチャのレイアウトを加速する必要がありました

Meta がインフラストラクチャのほとんどをカスタム設計しているのは、主にこれにより、物理層からソフトウェア層、実際のユーザー エクスペリエンスに至るまで、エンドツーエンドのエクスペリエンスを最適化できるためです。スタックは上から下まで制御されるため、特定のニーズに合わせてカスタマイズできます。これらのインフラストラクチャは、より大規模で複雑な AI モデルの開発と展開において Meta をサポートします。

今後数年間で、チップ設計の専門化とカスタマイズが進み、ワークロードに特化した AI インフラストラクチャ、新しいシステムとツール、そして製品と設計のサポートの効率が向上するでしょう。これらは、最新の研究に基づいて構築されたますます洗練されたモデルと製品を提供し、世界中の人々がこの新しいテクノロジーを使用できるようにします。

出典:メタ公式ウェブサイト

以上がメタがAIを連投して究極技を加速!初の AI 推論チップ、大規模モデルのトレーニング用に特別に設計された AI スーパーコンピューターの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7442

7442

15

15

1371

1371

52

52

76

76

11

11

8

8

6

6

カーソルAIでバイブコーディングを試してみましたが、驚くべきことです!

Mar 20, 2025 pm 03:34 PM

カーソルAIでバイブコーディングを試してみましたが、驚くべきことです!

Mar 20, 2025 pm 03:34 PM

バイブコーディングは、無限のコード行の代わりに自然言語を使用してアプリケーションを作成できるようにすることにより、ソフトウェア開発の世界を再構築しています。 Andrej Karpathyのような先見の明に触発されて、この革新的なアプローチは開発を許可します

Dall-E 3の使用方法:ヒント、例、および機能

Mar 09, 2025 pm 01:00 PM

Dall-E 3の使用方法:ヒント、例、および機能

Mar 09, 2025 pm 01:00 PM

Dall-E 3:生成AI画像作成ツール 生成AIはコンテンツの作成に革命をもたらし、Openaiの最新の画像生成モデルであるDall-E 3が最前線にあります。 2023年10月にリリースされ、前任者のDall-EとDall-E 2に基づいています

2025年2月のトップ5 Genai発売:GPT-4.5、Grok-3など!

Mar 22, 2025 am 10:58 AM

2025年2月のトップ5 Genai発売:GPT-4.5、Grok-3など!

Mar 22, 2025 am 10:58 AM

2025年2月は、生成AIにとってさらにゲームを変える月であり、最も期待されるモデルのアップグレードと画期的な新機能のいくつかをもたらしました。 Xai’s Grok 3とAnthropic's Claude 3.7 SonnetからOpenaiのGまで

オブジェクト検出にYolo V12を使用する方法は?

Mar 22, 2025 am 11:07 AM

オブジェクト検出にYolo V12を使用する方法は?

Mar 22, 2025 am 11:07 AM

Yolo(あなたは一度だけ見ています)は、前のバージョンで各反復が改善され、主要なリアルタイムオブジェクト検出フレームワークでした。最新バージョンYolo V12は、精度を大幅に向上させる進歩を紹介します

SORA vs VEO 2:よりリアルなビデオを作成するのはどれですか?

Mar 10, 2025 pm 12:22 PM

SORA vs VEO 2:よりリアルなビデオを作成するのはどれですか?

Mar 10, 2025 pm 12:22 PM

GoogleのVEO 2とOpenaiのSORA:どのAIビデオジェネレーターが最高でしたか? どちらのプラットフォームも印象的なAIビデオを生成しますが、その強みはさまざまな領域にあります。 この比較は、さまざまなプロンプトを使用して、どのツールがニーズに最適かを明らかにします。 t

Google' s Gencast:Gencast Mini Demoを使用した天気予報

Mar 16, 2025 pm 01:46 PM

Google' s Gencast:Gencast Mini Demoを使用した天気予報

Mar 16, 2025 pm 01:46 PM

Google Deepmind's Gencast:天気予報のための革新的なAI 天気予報は、初歩的な観察から洗練されたAI駆動の予測に移行する劇的な変化を受けました。 Google DeepmindのGencast、グラウンドブレイク

ChatGpt 4 oは利用できますか?

Mar 28, 2025 pm 05:29 PM

ChatGpt 4 oは利用できますか?

Mar 28, 2025 pm 05:29 PM

CHATGPT 4は現在利用可能で広く使用されており、CHATGPT 3.5のような前任者と比較して、コンテキストを理解し、一貫した応答を生成することに大幅な改善を示しています。将来の開発には、よりパーソナライズされたインターが含まれる場合があります

chatgptよりも優れたAIはどれですか?

Mar 18, 2025 pm 06:05 PM

chatgptよりも優れたAIはどれですか?

Mar 18, 2025 pm 06:05 PM

この記事では、Lamda、Llama、GrokのようなChatGptを超えるAIモデルについて説明し、正確性、理解、業界への影響における利点を強調しています(159文字)