テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

LLM 推論は 3 倍高速になりました。 Microsoft が LLM Accelerator をリリース: 参照テキストを使用してロスレス アクセラレーションを実現

LLM 推論は 3 倍高速になりました。 Microsoft が LLM Accelerator をリリース: 参照テキストを使用してロスレス アクセラレーションを実現

LLM 推論は 3 倍高速になりました。 Microsoft が LLM Accelerator をリリース: 参照テキストを使用してロスレス アクセラレーションを実現

人工知能技術の急速な発展に伴い、ChatGPT、New Bing、GPT-4などの新製品や新技術が次々にリリースされており、基本的な大型モデルは多くのアプリケーションでますます重要な役割を担うことになります。

現在の大規模な言語モデルのほとんどは自己回帰モデルです。自己回帰は、モデルが出力時に単語ごとの出力を使用することが多いことを意味します。つまり、各単語を出力するときに、モデルは以前に出力した単語を入力として使用する必要があります。通常、この自己回帰モードでは、出力中の並列アクセラレータの完全な使用が制限されます。

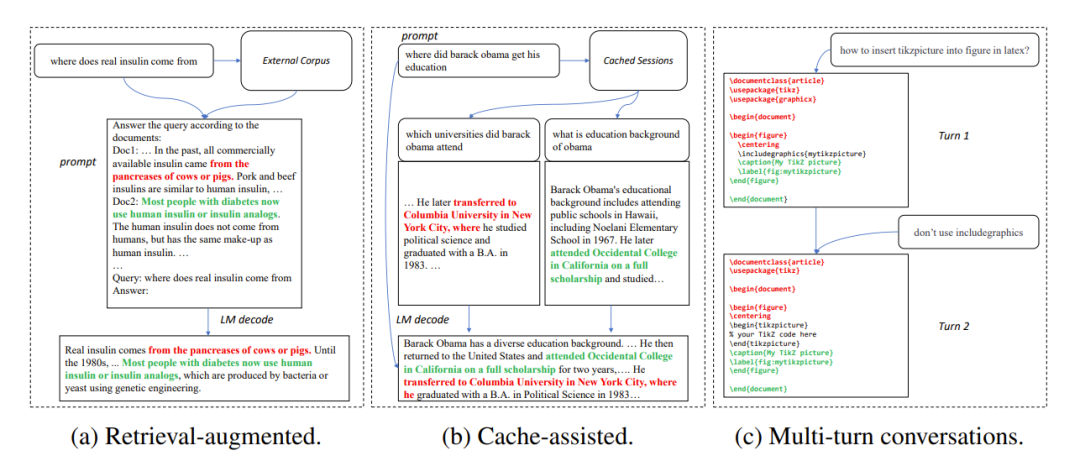

多くのアプリケーション シナリオでは、大規模なモデルの出力は、次の 3 つの一般的なシナリオのように、一部の参考テキストとよく似ています。

1. 検索拡張生成New Bing などの検索アプリケーションがユーザー入力に応答すると、まずユーザー入力に関連する情報を返します。次に、関連情報を使用して、言語モデルを使用して取得した情報を要約し、ユーザー入力に応答します。このシナリオでは、モデルの出力には、検索結果からの多数のテキストの断片が含まれることがよくあります。

#2. キャッシュされた生成を使用する

#言語モデルの大規模なデプロイメントのプロセスでは、履歴入力が必要になります。そして出力はキャッシュされます。新しい入力を処理するとき、取得アプリケーションはキャッシュ内で同様の入力を探します。したがって、モデルの出力は、キャッシュ内の対応する出力とよく似ています。

3. マルチターン会話での生成

ChatGPT などのアプリケーションを使用する場合、ユーザーはモデル ベースを使用することがよくあります。 on 出力が繰り返し変更を要求しました。この複数ターンの対話シナリオでは、多くの場合、モデルの複数の出力には少量の変更しかなく、高度な繰り返しが含まれます。

上記の観察に基づいて、研究者らは、自己回帰のボトルネックを突破するための焦点として参照テキストとモデル出力の再現性を使用し、並列アクセラレータの使用率を向上させ、高速化を目指しました。大規模言語モデルの推論と、出力と参照テキストの繰り返しを使用して、複数の単語を 1 ステップで出力する方法 LLM Accelerator が提案されています。

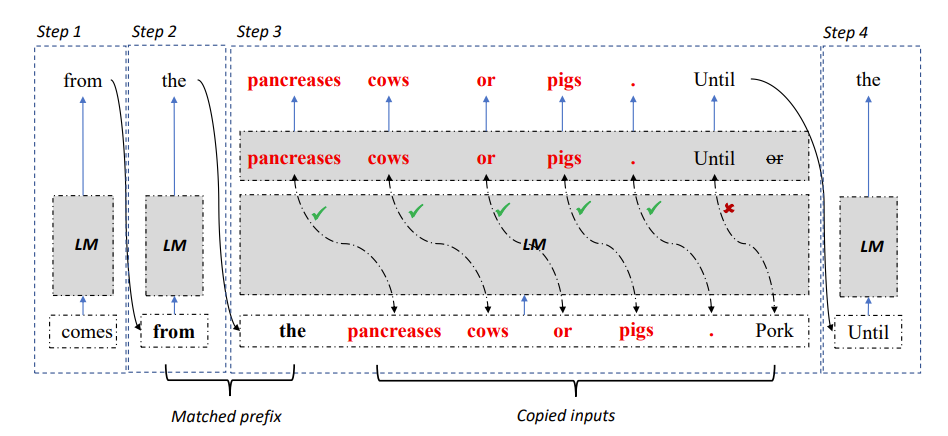

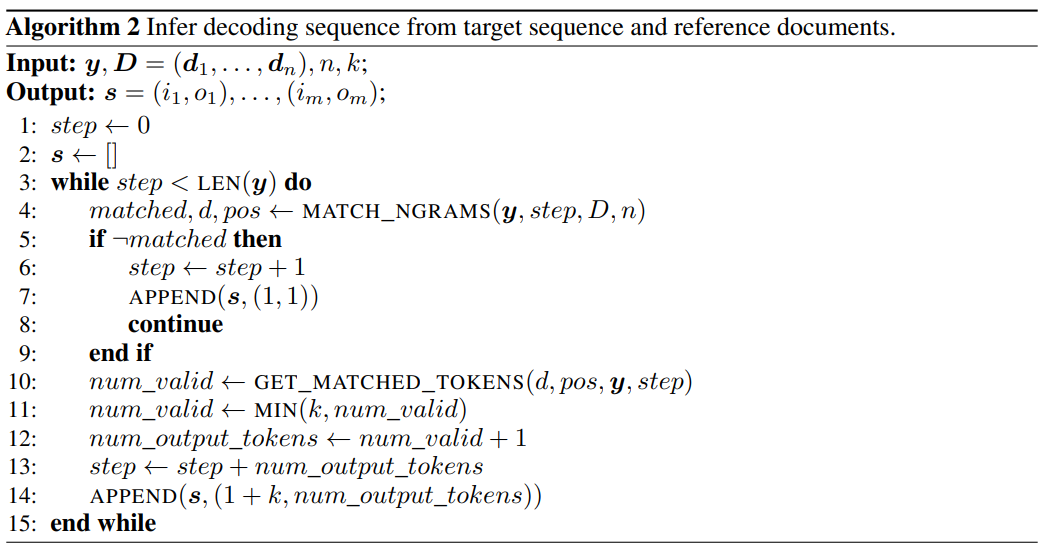

#図 2: LLM アクセラレータのデコード アルゴリズム

#図 2: LLM アクセラレータのデコード アルゴリズム

具体的には、各デコード ステップで、モデルが最初に既存の出力結果と参照テキストを一致させます。参照テキストが既存の出力と一致することが判明した場合、モデルは既存の参照テキストを延期して出力を続行する可能性があります。 。

したがって、研究者らは参照テキストの後続の単語をモデルへの入力として追加し、1 回のデコード ステップで複数の単語を出力できるようにしました。

入力と出力の正確性を保証するために、研究者はモデルによって出力された単語と参照文書から入力された単語をさらに比較しました。この 2 つが一致しない場合、間違った入力結果と出力結果は破棄されます。

上記の方法では、デコード結果がベースライン方法と完全に一致していることを保証でき、各デコードステップでの出力ワード数を増やすことができるため、大規模モデル推論のロスレス加速を実現できます。 。

LLM アクセラレータは追加の補助モデルを必要とせず、使いやすく、さまざまなアプリケーション シナリオに簡単に導入できます。

論文リンク: https://arxiv.org/pdf/2304.04487.pdf

プロジェクトリンク: https://github.com/microsoft/LMOps

LLM Accelerator を使用する場合、調整する必要があるハイパーパラメーターが 2 つあります。

1 つ目は、一致メカニズムをトリガーするために必要な出力と参照テキストの間で一致する単語の数です。一致する単語の数が長いほど精度が高く、単語がコピーされたことをより確実に確認できます。参照テキストからの正確な出力が得られ、不正確さが減少します。必要なトリガーと計算により、一致が短くなり、デコード手順が減り、潜在的に高速化が可能になります。

2 番目は、毎回コピーされる単語の数です。コピーされる単語が多いほど、高速化の可能性は大きくなりますが、より多くの誤った出力が破棄される可能性があり、コンピューティング リソースが無駄になります。 。研究者らは実験を通じて、より積極的な戦略(単一の単語トリガーに一致し、一度に 15 ~ 20 単語をコピーする)により、より優れた加速率を達成できることが多いことを発見しました。

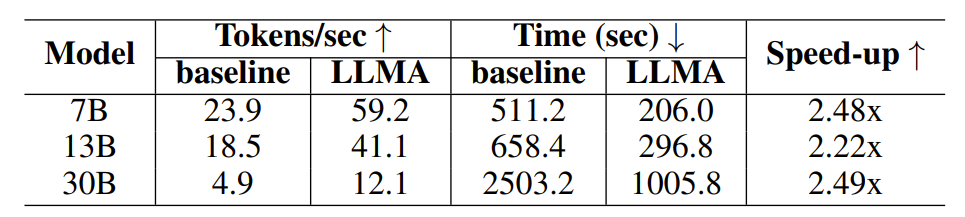

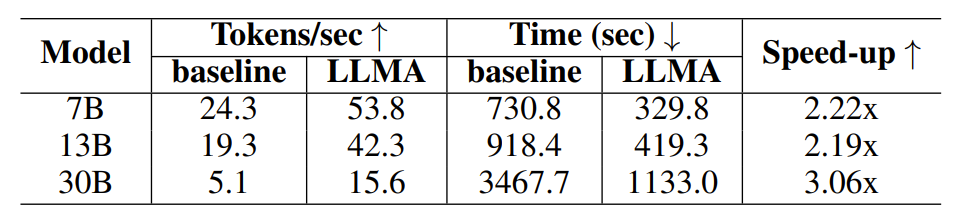

LLM アクセラレータの有効性を検証するために、研究者らは検索強化とキャッシュ支援生成に関する実験を実施し、MS-MARCO 段落検索データセットを使用して実験サンプルを構築しました。

検索強化実験では、研究者らは検索モデルを使用して各クエリに対して最も関連性の高いドキュメント 10 件を返し、それらをモデル入力としてクエリに接続しました。文書は参考テキストとして使用されました。

キャッシュ アシスト生成実験では、各クエリで 4 つの同様のクエリが生成され、モデルを使用して対応するクエリが参照テキストとして出力されます。

#表 1: 検索拡張生成シナリオでの時間の比較

#表 2: キャッシュを使用した生成シナリオでの時間の比較

#研究者らは、高品質の出力を得るために、OpenAI インターフェイスを通じて取得した Davinci-003 モデルの出力をターゲット出力として使用しました。必要な入力、出力、および参照テキストを取得した後、研究者らはオープンソースの LLaMA 言語モデルで実験を実施しました。LLaMA モデルの出力は Davinci-003 の出力と一致しないため、研究者らは目標指向のデコード手法を使用して、理想的な出力 (Davinci-003) での高速化率をテストしました。モデルの結果)。

研究者らはアルゴリズム 2 を使用して、貪欲なデコード中にターゲット出力を生成するために必要なデコード ステップを取得し、取得したデコード ステップに従って LLaMA モデルにデコードを強制しました。

7B および 13B パラメータのモデルの場合、研究者は 1 台の 32G NVIDIA V100 GPU で実験を実施し、30B パラメータのモデルの場合は 4 台の同一の GPU で実験を実施しました。の上。すべての実験では半精度浮動小数点数が使用され、デコードは貪欲デコードで、バッチ サイズは 1 です。

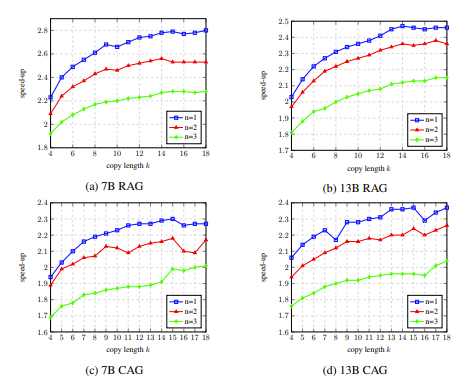

実験結果は、LLM アクセラレータがさまざまなモデル サイズ (7B、13B、30B) およびさまざまなアプリケーション シナリオ (検索強化、キャッシュ支援) で 2 ~ 3 倍のパフォーマンスを達成したことを示しています。 。

さらなる実験分析により、LLM Accelertator が必要なデコード ステップを大幅に削減できること、および加速比がデコード ステップの削減比と正の相関があることがわかりました。

デコード ステップが少ないということは、一方では各デコード ステップでより多くの出力ワードが生成されることを意味し、GPU コンピューティングの計算効率を向上させることができますが、他方では、マルチカードの並列処理 30B モデルでは、マルチカードの同期が少なくなり、速度がより速く向上します。

アブレーション実験では、開発セット上の LLM Accelertator のハイパーパラメータを分析した結果、単一の単語が一致したとき (つまり、コピー メカニズムがトリガーされたとき)、15ワードを使用する場合、最大の高速化率に達します (図 4 を参照)。

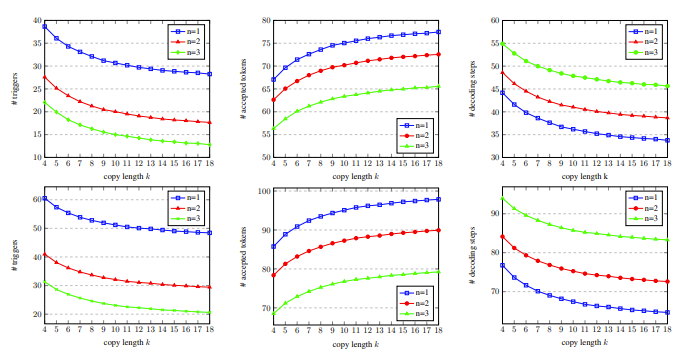

図 5 では、一致する単語の数が 1 であることがわかります。これにより、コピー メカニズムがより多くトリガーされる可能性があり、コピーの長さが増加するにつれて、各デコード ステップで受け入れられる出力単語が増加し、デコードステップが減少し、より高い加速比が得られます。

# 図 4: アブレーション実験における、開発における LLM Accelertator のハイパーパラメータの分析結果set

図 5: 異なる数の一致する単語 n と を使用した開発セット上copy Words 数 k のデコード ステップの統計データ

LLM Accelertator は、Microsoft Research Asia Natural Language Computing Group の大規模言語モデルの高速化に関する一連の作業の一部です。研究者は、より詳細な調査のために関連する問題を引き続き調査していきます。

以上がLLM 推論は 3 倍高速になりました。 Microsoft が LLM Accelerator をリリース: 参照テキストを使用してロスレス アクセラレーションを実現の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7464

7464

15

15

1376

1376

52

52

77

77

11

11

18

18

19

19

Microsoft bing国際版入口アドレス(bing検索エンジン入口)

Mar 14, 2024 pm 01:37 PM

Microsoft bing国際版入口アドレス(bing検索エンジン入口)

Mar 14, 2024 pm 01:37 PM

Bing は Microsoft が提供するオンライン検索エンジンで、検索機能が非常に強力で、国内版と海外版の 2 つの入り口があります。これら 2 つのバージョンへの入り口はどこですか?国際版にアクセスするにはどうすればよいですか?以下で詳細を見てみましょう。 Bing 中国語版 Web サイトの入り口: https://cn.bing.com/ Bing 国際版 Web サイトの入り口: https://global.bing.com/ Bing 国際版にアクセスするにはどうすればよいですか? 1. まず URL を入力して Bing を開きます: https://www.bing.com/ 2. 国内バージョンと国際バージョンのオプションがあることがわかりますので、国際バージョンを選択してキーワードを入力するだけです。

Microsoft の全画面ポップアップは、Windows 10 ユーザーに急いで Windows 11 にアップグレードするよう促します

Jun 06, 2024 am 11:35 AM

Microsoft の全画面ポップアップは、Windows 10 ユーザーに急いで Windows 11 にアップグレードするよう促します

Jun 06, 2024 am 11:35 AM

6 月 3 日のニュースによると、Microsoft はすべての Windows 10 ユーザーに全画面通知を積極的に送信し、Windows 11 オペレーティング システムへのアップグレードを奨励しています。この移行には、ハードウェア構成が新しいシステムをサポートしていないデバイスが含まれます。 2015 年以来、Windows 10 は市場シェアの 70% 近くを占め、Windows オペレーティング システムとしての優位性を確固たるものにしました。しかし、そのシェアは82%を大きく上回り、2021年に発売されるWindows 11のシェアを大きく上回っている。 Windows 11 は発売から 3 年近く経ちますが、市場への浸透はまだ遅いです。 Microsoft は、Windows 10 の技術サポートを 2025 年 10 月 14 日以降に終了すると発表しました。

Microsoft、Win11 8月累積アップデートをリリース:セキュリティの向上、ロック画面の最適化など。

Aug 14, 2024 am 10:39 AM

Microsoft、Win11 8月累積アップデートをリリース:セキュリティの向上、ロック画面の最適化など。

Aug 14, 2024 am 10:39 AM

8 月 14 日のこのサイトのニュースによると、今日の 8 月のパッチ火曜日イベント日に、Microsoft は 22H2 および 23H2 用の KB5041585 更新プログラム、および 21H2 用の KB5041592 更新プログラムを含む、Windows 11 システム用の累積的な更新プログラムをリリースしました。 8 月の累積更新プログラムで上記の機器がインストールされた後、このサイトに添付されるバージョン番号の変更は次のとおりです。 21H2 機器のインストール後、機器のインストール後、バージョン番号は Build22000.314722H2 に増加しました。バージョン番号は Build22621.403723H2 に増加しました。 装置のインストール後、バージョン番号は Build22631.4037 に増加しました。 Windows 1121H2 の更新プログラムの主な内容は次のとおりです。 改善: 改善されました。

Microsoft Edgeアップグレード:自動パスワード保存機能が禁止? !ユーザーはショックを受けました!

Apr 19, 2024 am 08:13 AM

Microsoft Edgeアップグレード:自動パスワード保存機能が禁止? !ユーザーはショックを受けました!

Apr 19, 2024 am 08:13 AM

4 月 18 日のニュース: 最近、Canary チャネルを使用している Microsoft Edge ブラウザーの一部のユーザーが、最新バージョンにアップグレードした後、パスワードを自動的に保存するオプションが無効になっていることに気づいたと報告しました。調査の結果、これは機能のキャンセルではなく、ブラウザのアップグレード後の軽微な調整であることが判明しました。 Edge ブラウザを使用して Web サイトにアクセスする前に、Web サイトのログイン パスワードを保存するかどうかを尋ねるウィンドウがブラウザにポップアップ表示されるとユーザーが報告しました。保存を選択すると、Edge は次回ログインするときに保存されたアカウント番号とパスワードを自動的に入力するため、ユーザーは非常に便利になります。しかし、最新のアップデートはデフォルト設定を変更する微調整に似ています。ユーザーはパスワードを保存することを選択し、設定で保存されたアカウントとパスワードの自動入力を手動でオンにする必要があります。

Microsoft Win11 の 7z および TAR ファイルを圧縮する機能は、24H2 バージョンから 23H2/22H2 バージョンにダウングレードされました

Apr 28, 2024 am 09:19 AM

Microsoft Win11 の 7z および TAR ファイルを圧縮する機能は、24H2 バージョンから 23H2/22H2 バージョンにダウングレードされました

Apr 28, 2024 am 09:19 AM

4 月 27 日のこのサイトのニュースによると、Microsoft は今月初めに Windows 11 Build 26100 プレビュー バージョン アップデートを Canary チャネルと Dev チャネルにリリースしました。これは Windows 1124H2 アップデートの RTM バージョンの候補になると予想されています。新バージョンの主な変更点は、ファイルエクスプローラー、Copilotの統合、PNGファイルメタデータの編集、TARおよび7z圧縮ファイルの作成など。 @PhantomOfEarth は、Microsoft が TAR および 7z 圧縮ファイルの作成など、24H2 バージョン (ゲルマニウム) の一部の機能を 23H2/22H2 (ニッケル) バージョンに継承していることを発見しました。図に示すように、Windows 11 は TAR のネイティブ作成をサポートします。

Microsoft Edge ブラウザーのアップデート: ユーザー エクスペリエンスを向上させるために「画像のズームイン」機能を追加しました

Mar 21, 2024 pm 01:40 PM

Microsoft Edge ブラウザーのアップデート: ユーザー エクスペリエンスを向上させるために「画像のズームイン」機能を追加しました

Mar 21, 2024 pm 01:40 PM

3月21日のニュースによると、Microsoftは最近ブラウザ「Microsoft Edge」をアップデートし、実用的な「画像拡大」機能を追加した。 Edge ブラウザを使用している場合、ユーザーは画像を右クリックするだけで、ポップアップ メニューでこの新機能を簡単に見つけることができます。さらに便利なのは、ユーザーが画像の上にカーソルを置き、Ctrl キーをダブルクリックして、画像をズームインする機能をすぐに呼び出すこともできることです。編集者の理解によれば、新しくリリースされた Microsoft Edge ブラウザーは、Canary チャネルで新機能についてテストされています。安定版ブラウザでは、実用的な「画像拡大」機能も正式に開始し、より便利な画像閲覧体験をユーザーに提供しています。海外の科学技術メディアも注目

Microsoftは、2024年後半にWindows 11でNTLMを段階的に廃止し、Kerberos認証に完全に移行する予定です

Jun 09, 2024 pm 04:17 PM

Microsoftは、2024年後半にWindows 11でNTLMを段階的に廃止し、Kerberos認証に完全に移行する予定です

Jun 09, 2024 pm 04:17 PM

2024 年後半、マイクロソフトの公式セキュリティ ブログは、セキュリティ コミュニティからの呼びかけに応えてメッセージを公開しました。同社は、セキュリティを向上させるために、2024 年後半にリリースされる Windows 11 から NTLAN Manager (NTLM) 認証プロトコルを廃止する予定です。これまでの説明によれば、マイクロソフトは以前にも同様の動きを行っているという。昨年 10 月 12 日、Microsoft は公式プレス リリースで、NTLM 認証方法を段階的に廃止し、より多くの企業とユーザーに Kerberos への切り替えを促すことを目的とした移行計画を提案しました。 NTLM 認証をオフにした後にハードウェア接続されたアプリケーションやサービスで問題が発生する可能性がある企業を支援するために、Microsoft は IAKerb と

マイクロソフト、新型Windows 11 AI PCを発売:革新的な「レビュー」機能を搭載

Jun 06, 2024 pm 01:52 PM

マイクロソフト、新型Windows 11 AI PCを発売:革新的な「レビュー」機能を搭載

Jun 06, 2024 pm 01:52 PM

5 月 21 日のニュースによると、マイクロソフトは本日、新キャンパスで開催された盛大なイベントで新しい Windows PC 製品である Windows 11 AI PC を一般に発表しました。この新製品は AI エクスペリエンスのために特別に設計されています。 Windows 11 AI PC は、優れたパフォーマンスとインテリジェントなデザインを備えており、よりインテリジェントで効率的なコンピューティング エクスペリエンスをユーザーに提供することを目指しています。この製品は、人工知能テクノロジーを使用して、より人間的なインタラクション方法を実現し、ユーザーに究極のユーザーエクスペリエンスをもたらします。同時に、Windows 11 AI PC には多くのインテリジェントな機能も統合されており、Windows 11 AI は PC ユーザーに大きなハイライトを提供できます。それは、その独自の「リコール」機能です。前代未聞のこの「記憶」