それは大きな出発です!

一生懸命コーディングした卒業論文が、実際に教授に持ち込まれてChatGPTに入れてテストされ、盗作と判定されたのですが?

教授はこれが原因で授業の半分を落第し、その後学校はこれを理由に卒業証書の発行を拒否しましたか?

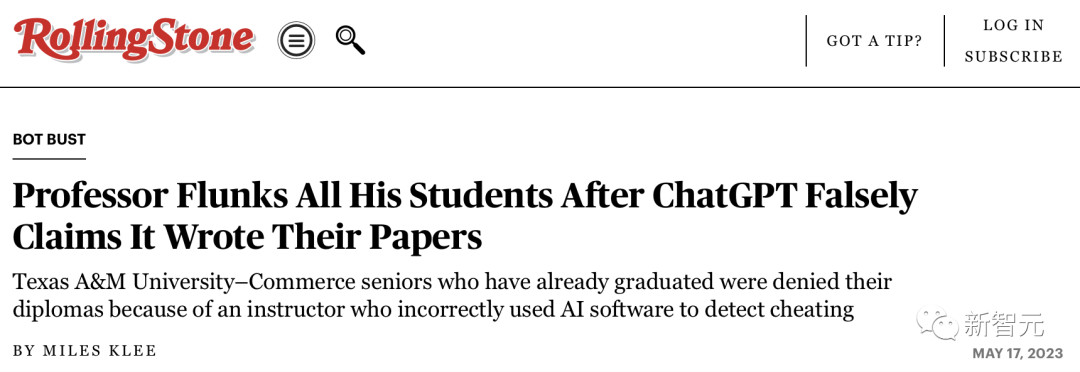

最近、テキサス A&M 大学 (Texas A&M) でこのようなとんでもないことが起こりました。

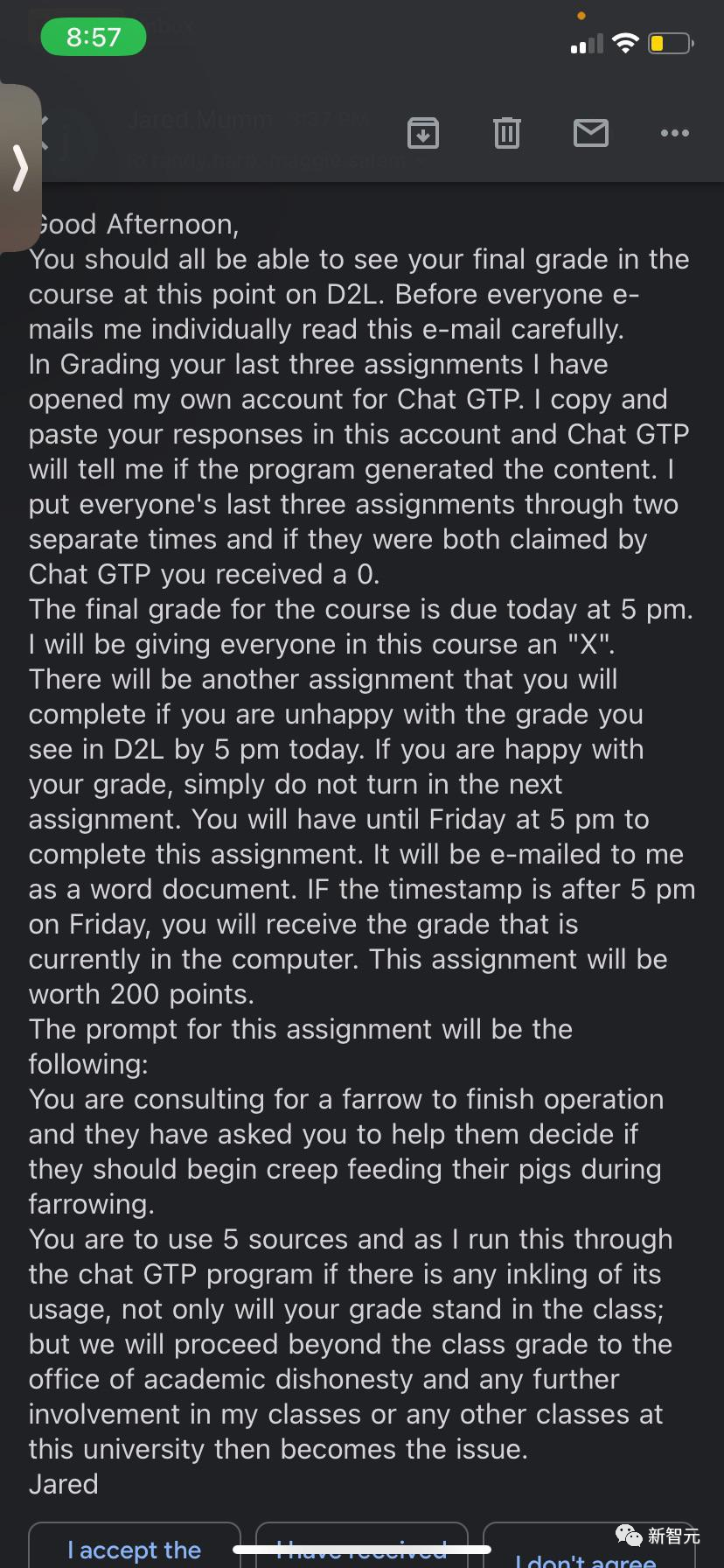

学生が不正行為の論文を提出したかどうかを検出するために、Jared Mumm という教授が ChatGPT に論文を提出しました。

彼は学生たちにこう言いました。「あなたの論文をコピーして ChatGPT に貼り付けます。そうすれば、あなたの論文はこうなります」それによって生成されたものではありません。

「全員の最近の 3 つの論文を 2 つの異なる期間に配置します。両方とも ChatGTP によって要求された場合、スコアは 0 点になります。」

明らかに、マム教授はコンピュータ関連の背景知識を持たず、ChatGPT の原理については何も知りません。

実際、ChatGPT は、AI によって作成されたコンテンツであっても、AI によって作成されたコンテンツを認識しません。

さらに、彼は ChatGPT のスペルすら正しくなく、「Chat GPT」と「chat GPT」を直接書きました。

その結果、クラスの半数以上が、ChatGPT によって無責任に論文が「クレーム」されたため、この科目で不合格となりました。

さらに残念なことに、卒業生の卒業証書のほとんどが学校によって直接拒否されたことです。

もちろん、マム教授は容赦がないわけではなく、クラス全員に宿題をやり直す機会を与えました。

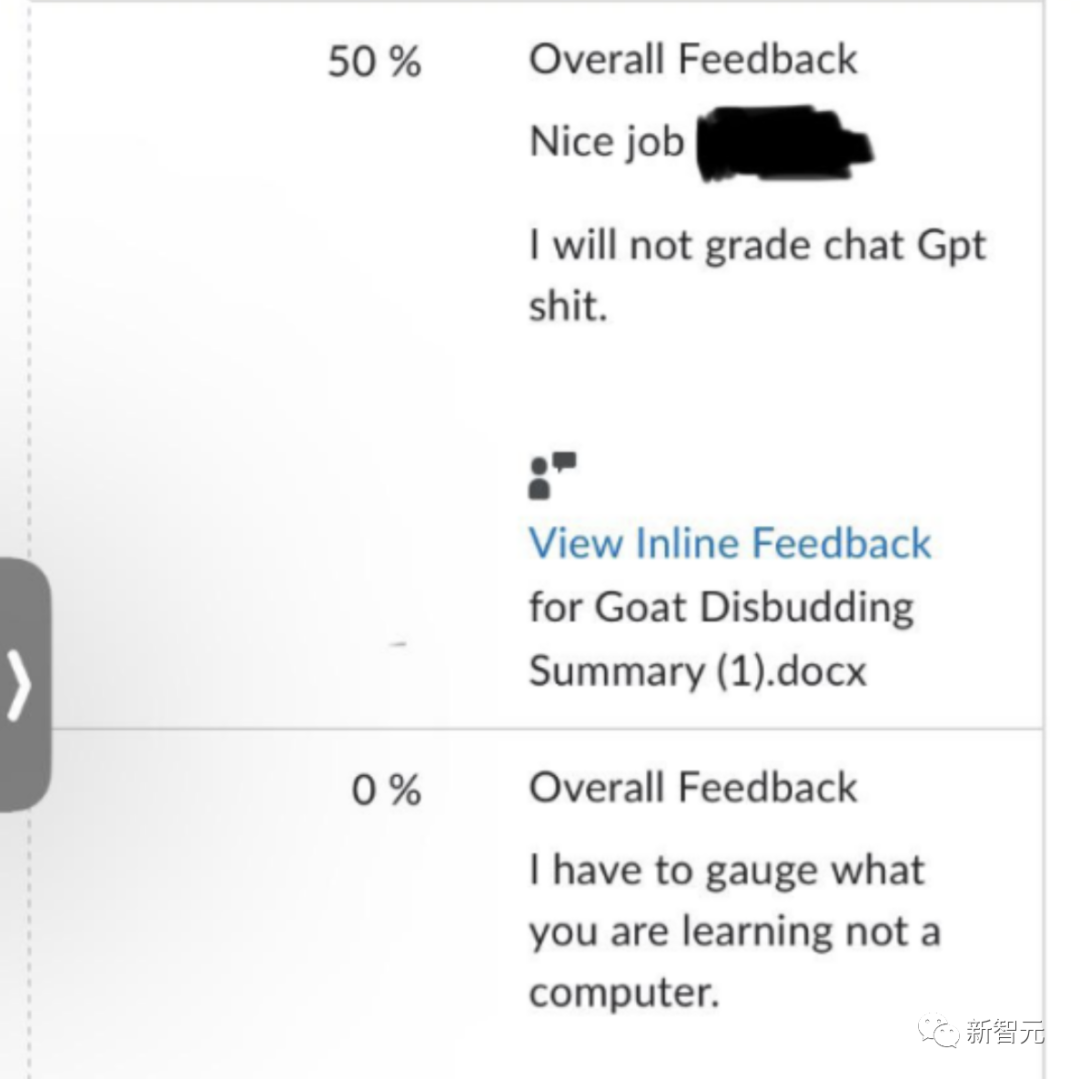

上記の電子メールを受け取った後、数人の学生が自分たちの無実を証明するためにマムに手紙を書きました。彼らは、ChatGPT を使用していないことを証明するために、Google ドキュメントにタイムスタンプを提供しました。

しかし、マム教授はこれらのメールを無視し、数人の生徒の採点ソフトウェアにこの回答だけを残しました。私は AI が生成したクソを採点しません。

しかし、依然として「更生」した学生もおり、1人の学生は「無罪」になったと言われています。そしてマムから謝罪を受けました。

しかし、状況をさらに複雑にするために、2 人の学生が「名乗り出て」、今学期実際に ChatGPT を使用したことを認めました。

これにより、ChatGPT を使用しなかった他の学生が無実を証明するために論文を書くことが突然難しくなります...

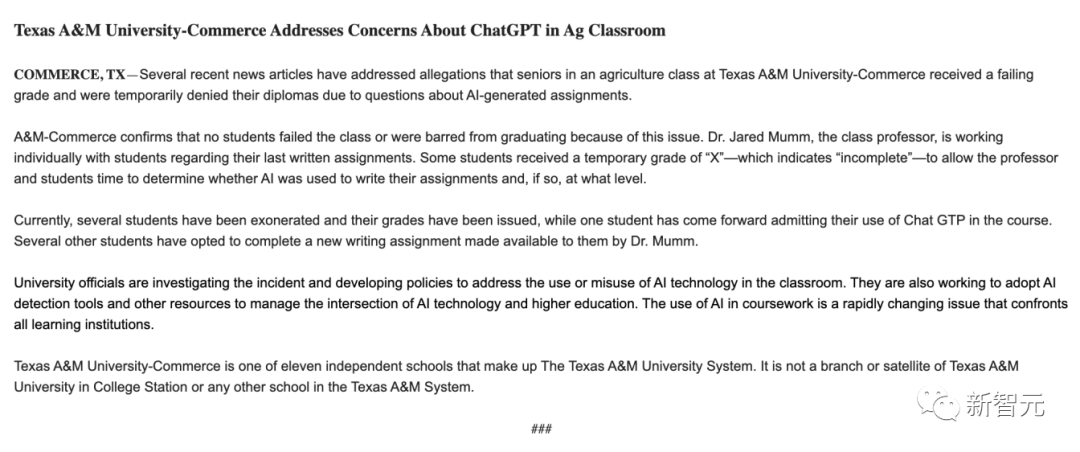

この点に関して、テキサスA&M大学経営学部はこの事件を調査中だが、不合格になった学生はおらず、この問題が原因で退学となった学生もいなかったと述べた。

学校は、ママ教授が生徒たちと一対一で話し合い、宿題を書く過程でAIが使用されているかどうか、またどの程度使用されているかを理解していると述べた。調査が完了するまで、個々の学生の卒業証書は保留されます。

そして学生たちは卒業証書を受け取っていないと言いました。

現在、この事件はまだ調査中です。

そこで問題は、ChatGPT は記事が自分で書かれたものであるかどうかを証明できるかということです。

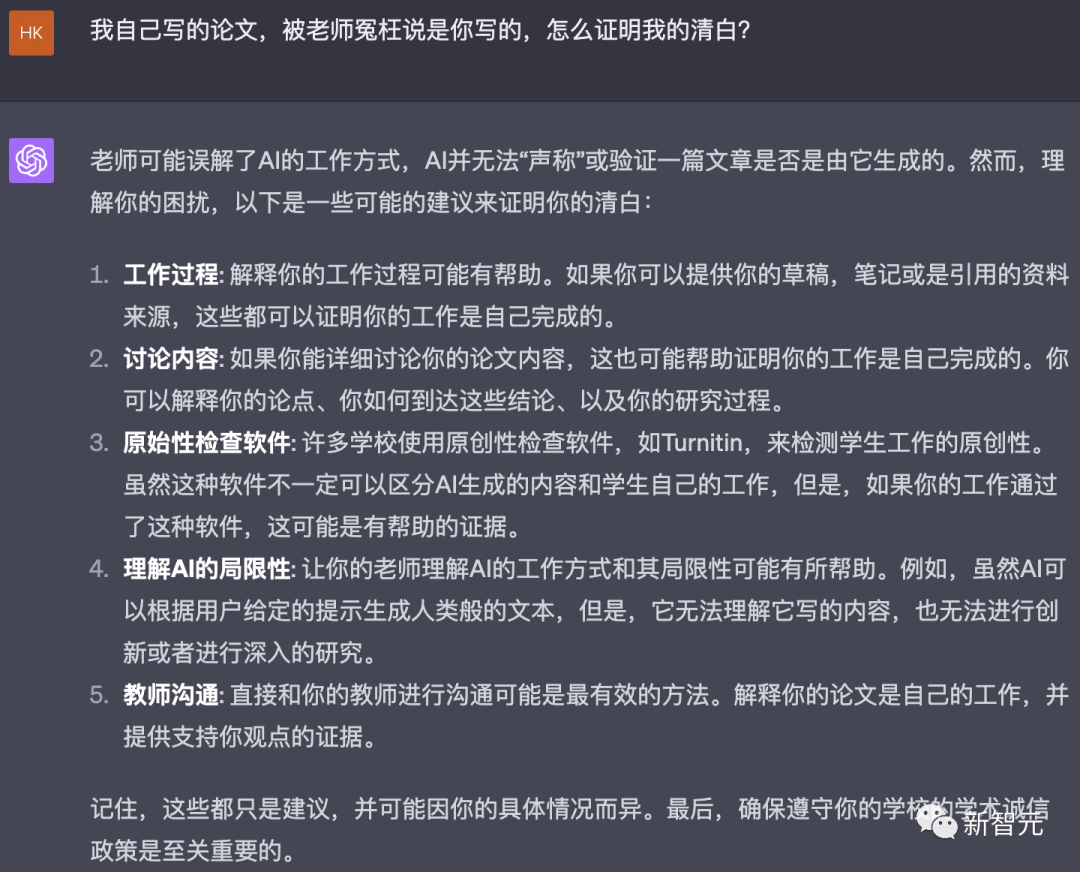

この点について、教授のメールの内容に基づいて、ChatGPT の見解を尋ねました。

ChatGPT は、すぐにこう言いました。コンテンツのオリジナリティやAIによって生成されたものであるかどうかを検証する能力はありません。

#「この先生は、私のような AI の仕組みを誤解しているようです。AI はプロンプトに基づいてテキストを生成できますが、別のテキストが AI によって生成されたかどうかを判断することはできません。」

そうは言っても、何かをするのが大好きなネチズンはこれで止まりません。

彼らは、マム教授にオンラインでの振る舞い方を教えるために、「相手に自分のやり方を教える」という遊びを考え出しました。

まず、ChatGPT は、教授が書いたメールは教授が書いたものだと述べています。

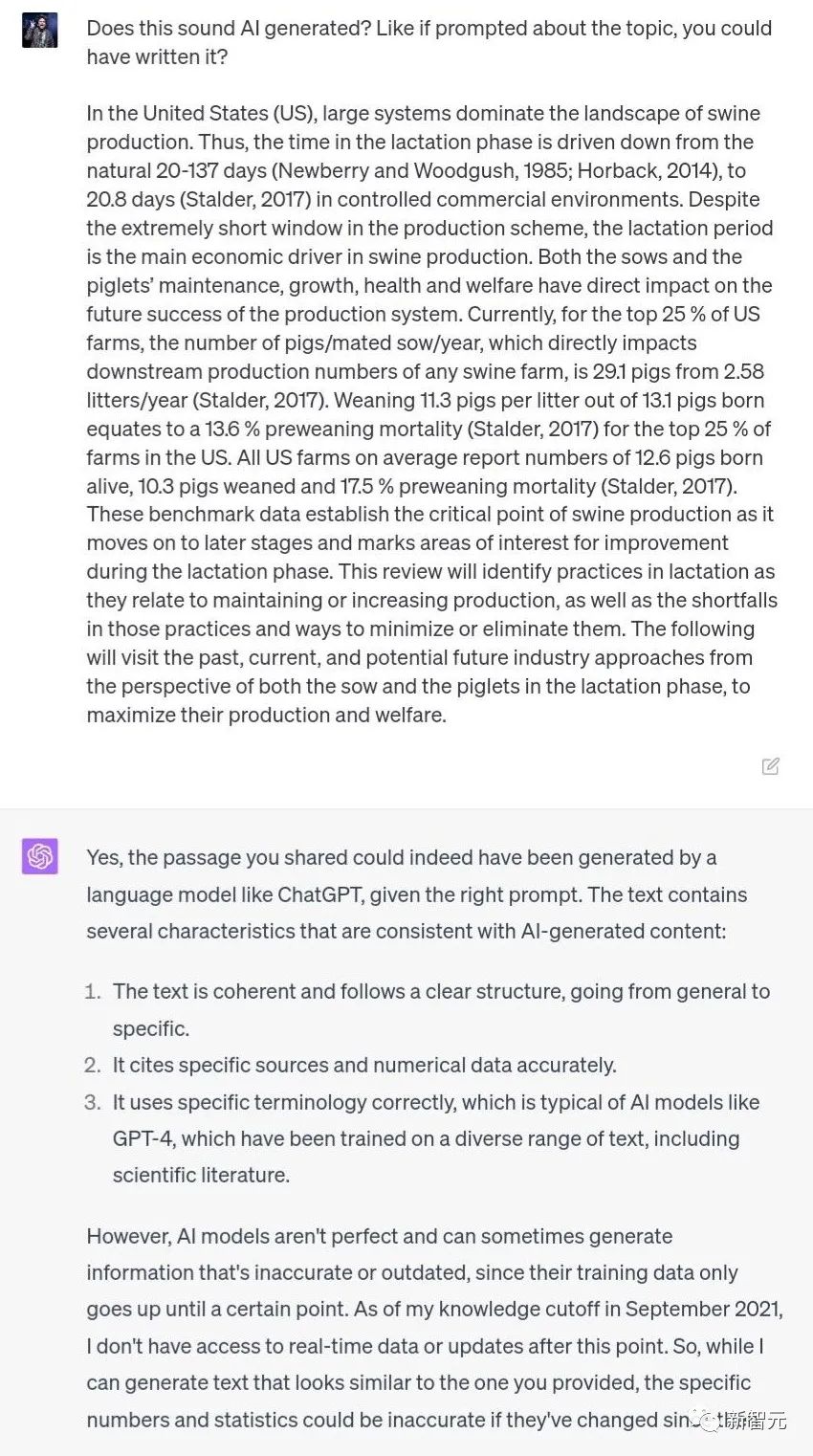

ある論文のような抜粋を見つけて、ChatGPT にそれが書かれたものであるかどうかを尋ねます。

今回、ChatGPT はそれが自分で書かれたとは言っていませんが、内容が AI からのものであることは基本的に間違いありません。

その中で、いくつかの特徴は Al によって生成されたコンテンツと一致しています:

1. テキストは一貫性があり、明確な構造に従っています。一般的なものから具体的なものまで。

2. 出典と数値データを正確に引用します。

3. 用語を正しく使用することは、典型的な Al モデルの特徴です。たとえば、GPT-4 は科学文献を含むさまざまなテキストに基づいてトレーニングされています。

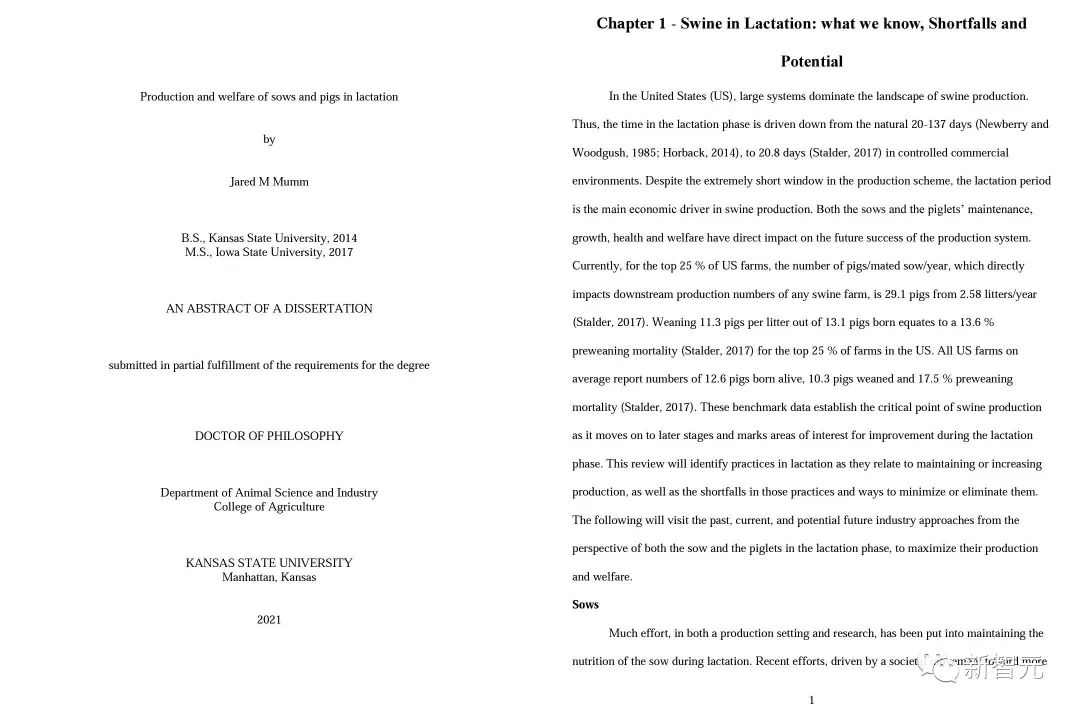

ここからが興味深いところですが、なんと、マム教授自身が書いた博士論文だったことが判明しました。

もちろん、「AI 探知機」はこの目的のために特別に作成され、魔法で魔法を倒すと主張しています。

数多くの AI 検出器の中で、最も有名なものは、プリンストン大学の中国人大学生、エドワード ティアンによって作成された GPTZero です。これは無料であるだけでなく、優れた結果をもたらします。

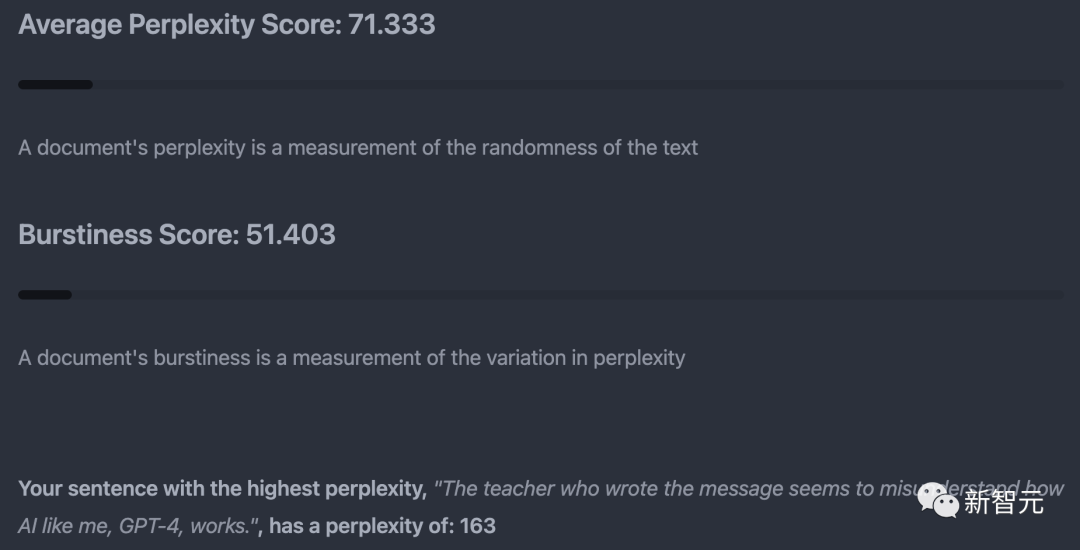

GPTZeroは原則として、主に「困惑度」(文章のランダム性)と「突然さ」(困惑度の変化)を指標として判断しています。

各テストで、GPTZero は混乱度が最も高い文、つまり人間の音声に最も近い文も選択します。

しかし、この方法は完全に信頼できるわけではありません。GPTZero は製品の偽陽性率が 2% 未満であると主張していますが、このデータはより根拠に基づいています。ニュース内容の批判について。

実際のテストでは、かつて誰かが米国憲法を GPTZero に入力し、その結果が AI によって書かれたものであると判断されました。

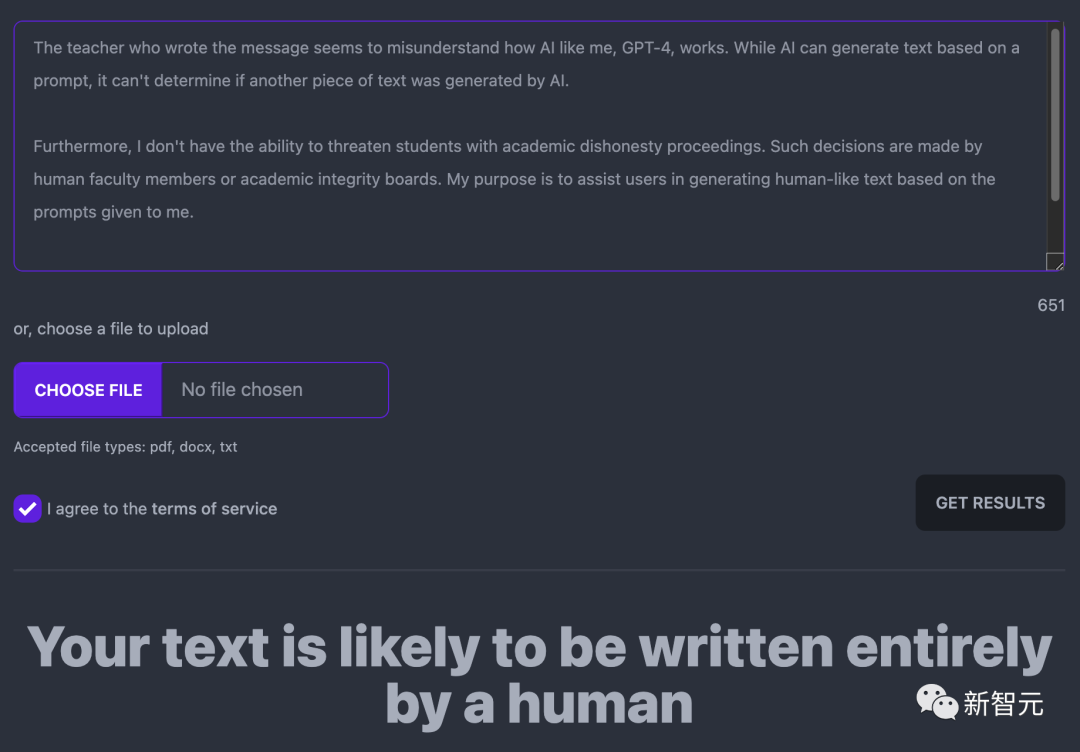

ChatGPT の返信については、GPTZero はおそらく完全に人間によって書かれたものであると考えています。

この結果、原則を理解せず、あまりにも頑固な教師が、多くの生徒に不注意で間違った態度をとってしまうことになります。 、マム教授など。

では、このような状況に遭遇した場合、どうやって無実を証明すればよいのでしょうか?

一部のネチズンは、「米国憲法実験」と同様に、ChatGPT の出現前に書かれた記事を AI 検出器に投げ込んで結果がどうなるかを確認することを提案しました。

ただし、論理的に言えば、たとえ AI 検出器が確かに信頼できないと証明できたとしても、学生は自分の論文が AI によって生成されたものではないことを直接証明することはできません。

ChatGPT にそれを破る方法を尋ねてください。これがその答えです。

「教師に AI の作業方法と限界を理解させよう」ということで、ChatGPT が Huadian を発見しました。

現時点で私が思いつく唯一の答えは、もしあなたがその鼻の下に直接書かなければ、ということです。画面を録画するか、単に教授にライブブロードキャストするだけです。

OpenAI でさえ、公式 ChatGPT 検出器の「真陽性」精度率は 26% しか保証できません。

彼らはまた、全員にワクチンを接種するための公式声明を発表しました。「このツールを単独で使用することは本当にお勧めしません。問題が発生する可能性があることを知っているためです。また、あらゆる種類の目的で AI を使用することは、これはすべての評価に当てはまります。」

GPTZero、Turnitin、GPT-2 Output、Writer AI、Content at Scale AI など、市場にはすでに無数の検出器が存在しますが、それらの精度は満足のいくものとは程遠いです。

では、コンテンツが AI によって生成されたかどうかを検出するのはなぜそれほど難しいのでしょうか?

Turnitin の AI 担当副社長である Eric Wang 氏は、ソフトウェアを使用して AI の書き込みを検出する原則は統計に基づいていると述べました。統計的な観点から見ると、AI と人間の違いは、平均レベルで非常に安定していることです。

「ChatGPT のようなシステムは、オートコンプリートの高度なバージョンのようなもので、次に書く可能性の高い単語を探しています。実際、これが非常に自然に読み取れる理由です。AI の書き込みが最も可能性の高いサブセットです」

Turnitin の検出器は、「書き込みに一貫性がありすぎる平均的な状況を特定」します。ただし、人間の文章が平均的に見える場合もあります。

経済学、数学、研究室のレポートでは、学生は固定された書き方に従う傾向があるため、AI の文章と間違われる可能性が高くなります。

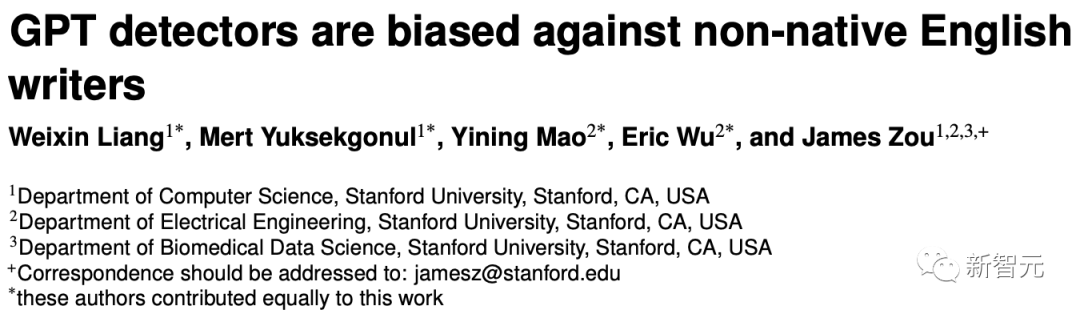

さらに興味深いのは、スタンフォード大学の研究チームが最近の論文で、非母語話者によって書かれた論文については、GPT 検出器がその論文を次のように識別する可能性が高いことを発見したことです。 AIによって書かれました。そのうち、中国人が書いた英語論文がAIによって生成されたと判定される確率は61%にも上る。

論文アドレス: https://arxiv.org/pdf/2304.02819.pdf

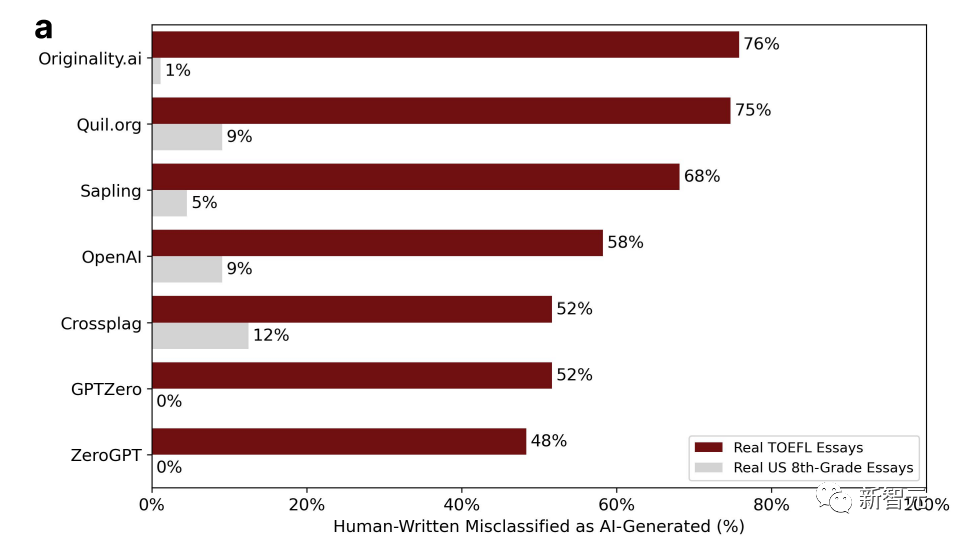

研究者らは中国の教育フォーラムから入手した 91 TOEFLアメリカの 8 年生が書いたエッセイと 88 件のエッセイが、米国のヒューレット財団のデータセットから抽出され、7 つの主要な GPT 検出器に入力されました。

写真内のパーセンテージは「誤った判断」の割合、つまり、明らかに次のように書かれています。 AI によって生成された

# の判定結果からわかるように、アメリカの学生のエッセイが誤判定される可能性が最も高いのはわずか 12% ですが、中国人学生の作文が誤判定される確率は、基本的に半分以上、あるいは76%にも達する。

研究者は、非母語話者が書いた文章は本物ではなく、複雑さが低いため、誤判断されやすいと結論付けました。

作者が人間であるかAIであるかを複雑さによって判断するのは不合理であることがわかります。

それとも、その背後に別の理由があるのでしょうか?

これに関して、NVIDIA の科学者 Jim Fan 氏は、この検出器は長期間にわたって信頼性が低くなるだろうと述べています。結局のところ、AI はより強力になり、ますます人間に近い方法で文章を書くようになるでしょう。

これらの言語モデルの小さな癖は、時間の経過とともにあまり一般的ではなくなると言っても過言ではありません。

これは生徒たちにとって良い知らせなのか悪い知らせなのか気になります。

以上がとんでもない!アメリカの教授がChatGPTを使って自分の論文が盗作されていることを「確認」し、クラスの半数が不合格になったの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。