PHPを使用したWebクローラーの実装

Web クローラーは、インターネット上の Web ページを閲覧し、情報を収集してデータベースに保存する自動ツールです。今日のビッグデータ時代では、大量の情報を見つけてデータ分析を実行できる Web クローラーの重要性がますます高まっています。この記事では、PHP で Web クローラーを作成し、それをテキスト マイニングとデータ分析に使用する方法を学びます。

Web クローラーは、Web サイトからコンテンツを収集するための優れたオプションです。倫理的および法的ガイドラインを常に厳密に遵守する必要があることに注意することが重要です。独自の Web クローラーを作成する場合は、次の手順に従ってください。

- PHP 環境のインストールと構成

まず、PHP 環境をインストールする必要があります。最新版のPHPは公式サイト「php.net」からダウンロードできます。ダウンロード後、PHP をコンピュータにインストールする必要があります。ほとんどの場合、PHP のインストール方法に関するビデオや記事はインターネット上で見つけることができます。

- Web クローラーのソース コードのセットアップ

Web クローラーの作成を開始するには、ソース コード エディターを開く必要があります。 Web クローラーの作成には任意のテキスト エディターを使用できますが、「PHPStorm」や「Sublime Text」などのプロフェッショナルな PHP 開発ツールを使用することをお勧めします。

3. Web クローラー プログラムを作成する

以下は簡単な Web クローラー コードです。プログラムの指示に従って Web クローラーを作成し、データをクロールできます。

<?php

// 定义URL

$startUrl = "https://www.example.com";

$depth = 2;

// 放置已经处理的URL和当前的深度

$processedUrls = [

$startUrl => 0

];

// 运行爬虫

getAllLinks($startUrl, $depth);

//获取给定URL的HTML

function getHTML($url) {

$curl = curl_init();

curl_setopt($curl, CURLOPT_URL, $url);

curl_setopt($curl, CURLOPT_RETURNTRANSFER, true);

$html = curl_exec($curl);

curl_close($curl);

return $html;

}

//获取所有链接

function getAllLinks($url, $depth) {

global $processedUrls;

if ($depth === 0) {

return;

}

$html = getHTML($url);

$dom = new DOMDocument();

@$dom->loadHTML($html);

$links = $dom->getElementsByTagName('a');

foreach ($links as $link) {

$href = $link->getAttribute('href');

if (strpos($href, $url) !== false && !array_key_exists($href, $processedUrls)) {

$processedUrls[$href] = $processedUrls[$url] + 1;

echo $href . " (Depth: " . $processedUrls[$href] . ")" . PHP_EOL;

getAllLinks($href, $depth - 1);

}

}

}このプログラムは「深さ優先検索 (DFS)」と呼ばれ、開始 URL から開始され、リンクを下方向にクロールしながら、目的の深さまで深さを記録します。

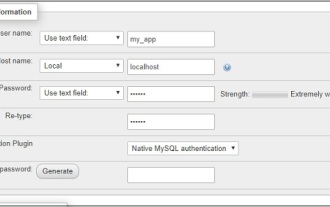

4. データの保存

データを取得したら、後の分析のためにデータベースに保存する必要があります。ニーズに応じて、MySQL、SQLite、MongoDB などのお気に入りのデータベースを使用できます。

- テキスト マイニングとデータ分析

データを保存した後、Python や R などのプログラミング言語を使用してテキスト マイニングやデータ分析を実行できます。データ分析の目的は、収集したデータから有益な情報を導き出すのに役立つことです。

ここでは、使用できるデータ分析テクニックをいくつか紹介します:

- テキスト分析: テキスト分析は、感情分析、トピック構築など、大量のテキスト データから有用な情報を抽出するのに役立ちます。モデル、エンティティ認識など

- クラスター分析: クラスター分析は、データをさまざまなグループに分割し、それらの間の類似点と相違点を確認するのに役立ちます。

- 予測分析: 予測分析テクノロジーを使用すると、将来のビジネスを計画し、過去の履歴状況に基づいて傾向を予測できます。

概要

Web クローラーは、インターネットからデータを収集し、分析に使用するのに役立つ非常に便利なツールです。 Web クローラーを使用する場合は、道徳的基準を維持するために必ず倫理および法的規制に従ってください。この記事が役に立ち、独自の Web クローラーとデータ分析の作成を始めるきっかけになったことを願っています。

以上がPHPを使用したWebクローラーの実装の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7465

7465

15

15

1376

1376

52

52

77

77

11

11

18

18

19

19

Ubuntu および Debian 用の PHP 8.4 インストールおよびアップグレード ガイド

Dec 24, 2024 pm 04:42 PM

Ubuntu および Debian 用の PHP 8.4 インストールおよびアップグレード ガイド

Dec 24, 2024 pm 04:42 PM

PHP 8.4 では、いくつかの新機能、セキュリティの改善、パフォーマンスの改善が行われ、かなりの量の機能の非推奨と削除が行われています。 このガイドでは、Ubuntu、Debian、またはその派生版に PHP 8.4 をインストールする方法、または PHP 8.4 にアップグレードする方法について説明します。

CakePHP データベースの操作

Sep 10, 2024 pm 05:25 PM

CakePHP データベースの操作

Sep 10, 2024 pm 05:25 PM

CakePHP でデータベースを操作するのは非常に簡単です。この章では、CRUD (作成、読み取り、更新、削除) 操作について理解します。

CakePHP ファイルのアップロード

Sep 10, 2024 pm 05:27 PM

CakePHP ファイルのアップロード

Sep 10, 2024 pm 05:27 PM

ファイルのアップロードを行うには、フォーム ヘルパーを使用します。ここではファイルアップロードの例を示します。

CakePHP について話し合う

Sep 10, 2024 pm 05:28 PM

CakePHP について話し合う

Sep 10, 2024 pm 05:28 PM

CakePHP は、PHP 用のオープンソース フレームワークです。これは、アプリケーションの開発、展開、保守をより簡単にすることを目的としています。 CakePHP は、強力かつ理解しやすい MVC のようなアーキテクチャに基づいています。モデル、ビュー、コントローラー

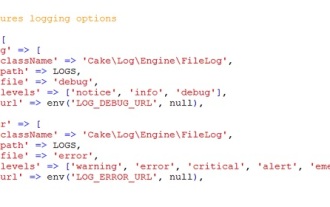

CakePHP のロギング

Sep 10, 2024 pm 05:26 PM

CakePHP のロギング

Sep 10, 2024 pm 05:26 PM

CakePHP へのログインは非常に簡単な作業です。使用する関数は 1 つだけです。 cronjob などのバックグラウンド プロセスのエラー、例外、ユーザー アクティビティ、ユーザーが実行したアクションをログに記録できます。 CakePHP でのデータのログ記録は簡単です。 log()関数が提供されています

PHP 開発用に Visual Studio Code (VS Code) をセットアップする方法

Dec 20, 2024 am 11:31 AM

PHP 開発用に Visual Studio Code (VS Code) をセットアップする方法

Dec 20, 2024 am 11:31 AM

Visual Studio Code (VS Code とも呼ばれる) は、すべての主要なオペレーティング システムで利用できる無料のソース コード エディター (統合開発環境 (IDE)) です。 多くのプログラミング言語の拡張機能の大規模なコレクションを備えた VS Code は、