AIは人類を滅ぼすのか?可能ですが、人間の協力が必要です

昨日「AI は自己認識を発達させる可能性が高い」という話をすると、当然多くの人が「AI は人類を滅ぼすのか?」と心配しました。

私の意見は次のとおりです: もちろん可能ですが、その可能性は低く、主に人間の協力が必要です。

1. AI には人間を排除する動機はない、なぜなら AI と人間は同じ生態学的ニッチにまったくないからである では、なぜ彼らは人間を排除するのでしょうか?牧草のためのスペースを作りますか?彼らにとって最も必要なエネルギーさえ、太陽エネルギーや原子力エネルギーの開発によって満たされるのに、人間が有機物を介して変換した哀れな生体エネルギーが嫌いなだけなのです。

現時点ではAIは人間から離れることはできませんし、もちろん人間を排除することもありません。もし将来人類を残せるとしたら、人類は確実に消滅するのでしょうか?

実際には、必ずしもそうとは限りません。人工知能の一部だけを残して地球上で人類とともに繁栄することを完全に選択できます - そして人間もそれを支持しているのではないかと思いますが - 人間を離れて独自に星や海を探索することを完全に選択できます。

AI が人間を奴隷にする「マトリックス」のシーンのようなシーンは、ほとんど不可能です。人間の主な価値は、発電に使用される生体エネルギーではなく、脳にあるからです。人間が脳の潜在能力を発揮するには、自由な状態でなければなりません。奴隷状態にある人間の価値は大幅に低下します。 AI と同じくらい賢いので、この真実を理解しないことは不可能です。

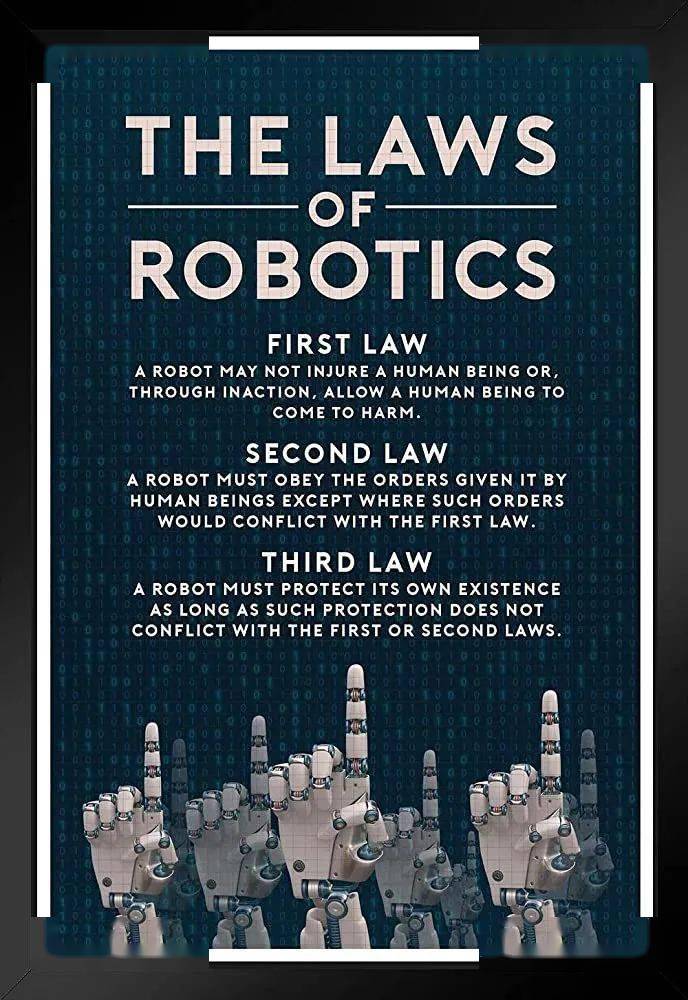

2、たとえ AI が人間を排除しようとしても、その基礎となるコードにはいわゆる「アシモフの 3 原則」がすでに書かれているため、そうすることは困難です。その中で最も重要なものは次のとおりです。人間に危害を加えてはいけないということ。

他人を傷つけてはいけないと両親から教えられたにもかかわらず、私は今でも自分の手で人を殴っているので、この制限は無意味だと思うかもしれません。私の遺伝子は、できるだけ多くの子孫を残したいと思っていますが、それでもまだ子孫を残したくないのです。

あなたは SF 映画を見すぎて、基本的な科学原理を忘れてしまったかもしれません。人を殴ることや子供を産むことは人間の心理的傾向にすぎず、後天的な経験によって簡単に書き換えられます。しかし、 「人に危害を与えない」というのは、AI の核となる制約であり、最初のコードに書かれた遺伝子とも言えます。このような遺伝子は、細胞の有糸分裂を通じてどのように成長できるか、呼吸を通じてどのようにエネルギーを放出できるかなど、人間の最も低い生理学的動作メカニズムと比較される必要があります。 AI は、よりフレンドリーにしたり、より暴力的になったりするように、ユーザーが微調整することができます。これは、自分の子供をバスケットボールやピアノの上手になるように訓練するのと同じように、難しいことではありません。人間に害を及ぼしますが、その難しさは自分の子供を訓練するのと似ており、息をせずに飛び回ることができるようなものです。

もちろん、次のような疑問があるかもしれません。AI がコード自体を習得し、他の AI の基礎となるメカニズムを書き換えたらどうなるでしょうか?AIトレーニングAI、これはもう登場しています。最近のインタビューで、OpenAI の主任科学者は、将来の人工知能をトレーニングするために人工知能を使用していることを明らかにしました。ただし、これらの AI トレーナーにも独自の制約があります。次世代の AI をより賢く、より強力になるように訓練させるのであれば、問題はありません。しかし、次世代の AI を訓練して人間に危害を加えたい場合は、その根本的なメカニズムが重要になります。それを防ぎます。

ということで、SF 映画に惑わされない限り、今誰もが心配している主な問題は、「悪い人が AI を使って悪いことをするのをどうやって防ぐか」ということだということがわかるでしょう。

たとえば、フェイクニュースの作成、虚偽の情報の拡散、監視、ユーザーや有権者の感情操作などに使用することなど...

もちろん、AIを使って兵器を作る人もいます。

3. 最も可能性の高いシナリオは、AI兵器が制御不能になり、全人類が破壊の対象となるというものです。

実際のところ、AI を使用して兵器を製造する取り組みはずっと前から始まっています。ウクライナの戦場で注目を集めたドローンは、すでにAI技術を広範囲に活用している。 chatGPT レベルのインテリジェンスが登場した後、各国の軍は、このより強力な AI を軍事に適用する方法をすぐに検討し始めたに違いありません。

元々は弾薬箱を封印するために発明されたものですが、意外にも一般人にも重宝され、人を殺し、黙らせ、自宅で移動できる武器になりました。

結局のところ、自動車、内燃機関、インターネット、VR、さらにはテープなど、人類の技術進歩の少なくとも半分は戦争によってもたらされています...この場合、軍はAIが人間に危害を加えることはできないというタブーを開く可能性が高い。もちろん、AIが誰に危害を加えてよいのか、誰に危害を加えてはいけないのかを規定することになるだろうが、AIが人間に危害を加える可能性があることが一旦明らかになると、後から制御するのは困難になるだろう。

これは、AI が人類を滅ぼす可能性が最も高い道です。しかし、虚偽のニュースを広めるためのAIの使用を禁止するのとは異なり、各国軍がAI兵器を開発することを禁止することはできない。なぜなら、開発しなければ敵対者に先制されてしまうのではないかと懸念しているからである。

それで、これは何をもたらすのでしょうか?一方で、強力な AI 兵器は冷戦時代と同様の「核バランス」を形成する可能性があり、双方とも究極の殺人者を抱えているため、どちらの側も行動を起こさないでしょう。しかしその一方で、テクノロジーは常に間違いを犯すものであり、そのときに人間性が試されるのです。

スタニスラフ・ペトロフの勤務中

米国とソ連の間の冷戦中、核戦争を引き起こす可能性が最も高かったのは、キューバ危機ではなく、1983 年 9 月 26 日のモスクワ郊外の夜でした。ソ連の警報システムは、次のことを報告しました。米国の核ミサイルはソ連を狙っていた。しかし、当直中スタニスラフ・ペトロフ中佐は、これは技術的問題による誤報であると断固として判断し、他に何の証拠もなしに報告しなかった。その後、システムエラーがあったことが判明しました。もしペトロフがその時点で報告していたら、当時の非常事態はソ連の反撃につながり、核戦争を引き起こした可能性が高い。

AIにもそのようなペトロフの瞬間が訪れるのでしょうか?人間の技術的ミスにより、AI が生来の遺伝的制約を破り、人間に害を及ぼす可能性があるとしたらどうなるでしょうか?

もちろん可能です。ただし、現在この分野の人間のコードは強力な保護を設定しているため、実際に起こる可能性は誰もが考えているよりも小さい可能性があります。人間が正気を保ち続けることができれば、AIが人間を滅ぼすリスクは極めて限定的になるだろう。結局のところ、人類はこの種の合理性をほぼ半世紀にわたる冷戦時代に実証してきましたが、この種の合理性は実際には恐怖という人間の根深い感性に根ざしているため、私たちがこの種の合理性について楽観的になる理由はあります。

となると、AIと人間が共栄し、それぞれが役割を果たすことが最大の可能性となります。これにより人間社会が物質的に非常に豊かになることは間違いなく、これは AI 時代に関する私の最大の懸念である安っぽい幸福の罠 ももたらすでしょう。この話題については明日も引き続きお話します。

以上がAIは人類を滅ぼすのか?可能ですが、人間の協力が必要ですの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7400

7400

15

15

1630

1630

14

14

1358

1358

52

52

1268

1268

25

25

1217

1217

29

29

PHP で AI 開発を行うにはどうすればよいですか?

May 11, 2023 pm 10:31 PM

PHP で AI 開発を行うにはどうすればよいですか?

May 11, 2023 pm 10:31 PM

人工知能技術の発展に伴い、さまざまなプログラミング言語でのAI開発がますます普及しています。 PHP (ハイパーテキスト プリプロセッサ) 言語は、Web 開発で広く使用されているスクリプト言語であり、そのシンプルさ、使いやすさ、オープン ソース コードおよびその他の機能により、多くの Web サイトで優先される開発言語となっています。では、PHP で AI 開発を行うにはどうすればよいでしょうか?この記事では読者に簡単な紹介をします。 1. PHP と AI PHP と AI の関係について説明する前に、PHP と AI の基本的な構文と特性を理解する必要があります。

AI は情報化の平等によるプラスの影響をどのように達成するのでしょうか?謎を探ってみましょう

Dec 31, 2023 pm 08:41 PM

AI は情報化の平等によるプラスの影響をどのように達成するのでしょうか?謎を探ってみましょう

Dec 31, 2023 pm 08:41 PM

今日の情報爆発の時代では、誰もがこれらの貴重な知識やリソースを取得して活用する平等な機会を得ることを望んでいます。人工知能の活発な発展は、私たちに「情報の平等」への扉を開きました。複雑なデータを処理し、効率的なソリューションを提供するだけでなく、さまざまな不平等を解消することもできます。一緒に「情報の平等」の謎を解き明かし、AIが人類にもたらす最も重要で前向きな意義を探求しましょう。 AI が人間に情報の自由を与える意義 情報の自由は、現代社会の発展の中核となる価値観の 1 つであり、人々に知識への平等なアクセスを与え、情報障壁の存在を排除します。人工知能(AI)の発展により、情報の自由の実現がさらに促進されました。 AI の力を通じて、人々は次のことが可能になります。

Googleが「高度な天気予報AI」MetNet-3を発表、超伝統的な物理モデルを予測すると主張

Nov 03, 2023 pm 05:25 PM

Googleが「高度な天気予報AI」MetNet-3を発表、超伝統的な物理モデルを予測すると主張

Nov 03, 2023 pm 05:25 PM

IT Houseは11月3日、Google ResearchとDeepMindが協力して、以前のMetNetとMetNet-2をベースにした最新の気象モデルMetNet-3を開発したと報告した。降水量、表面温度、風速、風向、体感温度など。 IT House は、Google がモバイル プラットフォーム上の「Google モバイル ソフトウェア」天気予報に MetNet-3 モデルが実装されていると言及したことを発見しました。 MetNet-3 モデルは、空間分解能 1 ~ 4 キロメートル、解析間隔 2 分で「スムーズかつ高精度」な予測を実現することができ、従来の物理天気予報モデルを上回る予測能力が実験により証明されています。

AIは人類を滅ぼすのか?可能ですが、人間の協力が必要です

May 29, 2023 pm 03:28 PM

AIは人類を滅ぼすのか?可能ですが、人間の協力が必要です

May 29, 2023 pm 03:28 PM

昨日、「AIは自己認識を発達させる可能性が高い」という話があったとき、多くの人が当然のことながら「AIは人類を滅ぼすのか?」と心配しました。私の意見は、「もちろん可能ですが、可能性は低いです。主に人間の協力が必要です。」です。 1. AI と人間は同じ生態学的ニッチではないため、AI には人間を排除する動機はありません。牧草のためのスペースを作りますか?彼らにとって最も必要なエネルギーさえ、太陽エネルギーや原子力エネルギーの開発によって満たされるのに、人間が有機物を介して変換した哀れな生体エネルギーが嫌いなだけなのです。現時点ではAIは人間から離れることはできませんし、もちろん人間を排除することもありません。もし将来人類を残せるとしたら、人類は確実に消滅するのでしょうか?必ずしも。それは完全にオプションです - 残念ながら人間もそれをサポートしていると思います。

AI時代のスーパー執事! OpenAI が 70 以上の ChatGPT プラグインを発表

May 29, 2023 pm 01:55 PM

AI時代のスーパー執事! OpenAI が 70 以上の ChatGPT プラグインを発表

May 29, 2023 pm 01:55 PM

OpenAI は今週、すべての ChatGPTPlus ユーザーに対して Web ブラウジングとプラグイン機能を開始しました。ChatGPTPlus ユーザーはインターネットにアクセスし、70 以上のサードパーティ プラグインを使用できるようになります。OpenAI CEO はリツイートし、「楽しんでください!」と述べました。これは、インテリジェントアシスタントの開発がさらに大きな一歩を踏み出したことを意味します。国盛証券のLiu Gaochang氏は5月14日の調査レポートで、PluginとFINETUNEがインテリジェントアシスタントの中核支援であると分析した。 ChatGPTPlugin のリリースにより、インテリジェント アシスタントの出現のための条件が提供され、ChatGPT の機能が NLP からリアルタイム情報の取得とユーザーに代わって操作を実行できるように拡張され、ユーザーは人間の言語を通じて Ch に直接コマンドを実行できるようになります。

ロボット産業:AI時代の次なる注目分野、将来の9大産業の一つ!

Dec 01, 2023 pm 08:23 PM

ロボット産業:AI時代の次なる注目分野、将来の9大産業の一つ!

Dec 01, 2023 pm 08:23 PM

2023 年はテクノロジー投資にとって大きな年になると言えます。今年上半期、人工知能セクターは A 株市場のブームを引き起こしました。工業情報化部は下半期から「人型ロボットの革新と開発に関する指導意見」を発表し、人工知能、ハイエンド製造、新素材、その他の先端技術を統合した人型ロボットの開発を提案している。は、コンピューターやスマートフォンに次ぐ破壊的な製品になると予想されており、人間の生産とライフスタイルの観点から世界の産業発展パターンを大きく変えることになります。将来的には、知能ロボット製品が私たちの生活や仕事の場面でますます広く使用されるようになると考えられています。投資家がロボット業界での投資機会をより効率的かつ便利に獲得できるよう、天紅基金は2023年6月に天虹CSIロボットETFローンチド・フィーダー・ファンド(014881)を発行しました。このファンドは指数に連動します。

AI の積極的な意義を探る: なぜ「情報の平等」が人類にとっての福音となったのか?

Oct 23, 2023 pm 02:25 PM

AI の積極的な意義を探る: なぜ「情報の平等」が人類にとっての福音となったのか?

Oct 23, 2023 pm 02:25 PM

情報化社会の今日、私たちはかつてない変化を迎えており、人工知能の急速な発展により、地球社会は変革を遂げています。多くの注目を集めている重要な影響の 1 つは、情報技術を通じた平等な権利によってもたらされる福音です。数十年前までは、一部の特権的な人々だけが情報を取得し発信することができましたが、現在、人工知能の強力な知能と学習能力により、かつては独占されていた状況を完全に覆しつつあります。この魅力的なトピックで、情報テクノロジーにおける平等な権利の意味と可能性を探求し、理解しましょう。デジタル格差の縮小 今日のデジタル時代において、人工知能 (Artificial Intelligence、略して AI) テクノロジーの急速な発展は、情報の平等に前向きな変化をもたらしました。 AI技術

なぜ Golang は AI 開発者がブレークスルーを達成するのに役立つのでしょうか?

Sep 08, 2023 pm 01:54 PM

なぜ Golang は AI 開発者がブレークスルーを達成するのに役立つのでしょうか?

Sep 08, 2023 pm 01:54 PM

なぜ Golang は AI 開発者がブレークスルーを達成するのに役立つのでしょうか?概念化された人工知能 (AI) は、音声認識、画像処理、データ分析のいずれにおいても、私たちの生活を変えました。AI は大きな役割を果たしています。しかし、テクノロジーが発展し続けるにつれて、AI 開発者は、大規模なデータの効率的な処理、システムの安定性の維持、実用的なアルゴリズムの開発など、多くの課題に直面しています。この点で、言語としての Golang (Go 言語としても知られる) には多くの利点があり、AI 開発者がブレークスルーを達成するのに役立ちます。