Meta は聖書を使用して超多言語モデルをトレーニングします。1107 言語を認識し、4017 言語を識別します

聖書にバベルの塔の話がありますが、人類は天国につながることを願って一致団結して高い塔を建てる計画を立てましたが、神が人間の言語を混乱させて計画は失敗したと言われています。今日、AI テクノロジーは人間の言語間の障壁を取り除き、人類が文明的なバベルの塔を構築するのに役立つと期待されています。

最近、Meta による研究がこの側面に向けて重要な一歩を踏み出しました。彼らは新しく提案された手法を大規模多言語音声 (MMS) と呼び、「聖書」に基づいて使用されました。

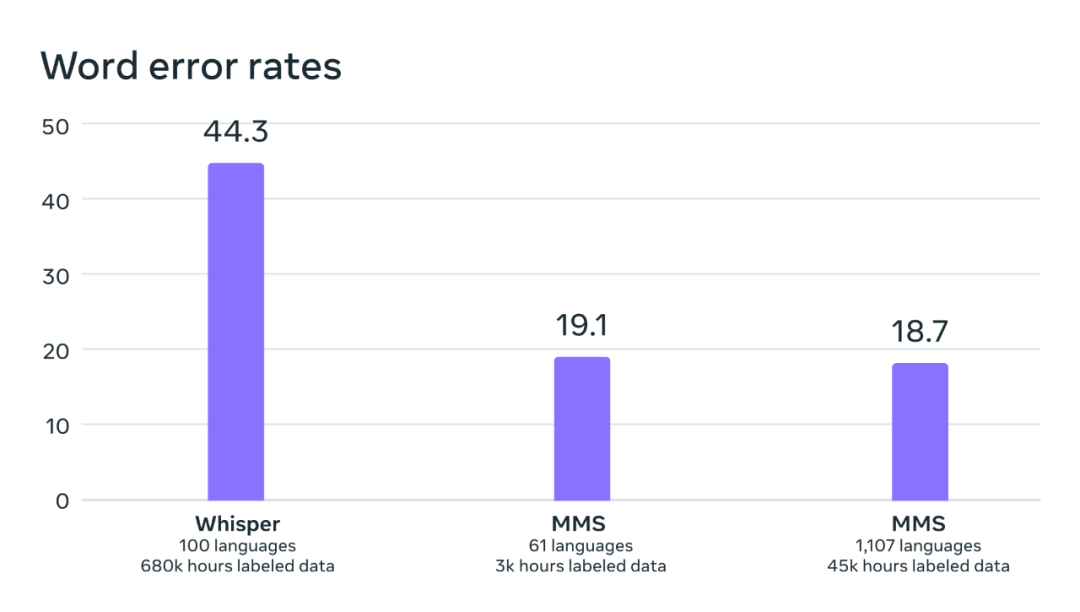

- #wave2vec 2.0 を使用して 1107 言語でトレーニングし、10 億のパラメータを持つ多言語音声認識が得られました。 OpenAI の Whisper モデルと比較して、このモデルのエラー率は 50% 以上減少しました。

- 単一の音声合成モデルは、これらの 1107 言語の音声合成 (TTS) をサポートします。

- 4017 言語を識別できる言語認識分類器を開発しました。

Meta は、多くの希少言語におけるデータ不足の問題をどのように解決しますか?彼らが使用した方法は興味深いもので、宗教コーパスを使用しています。なぜなら、聖書のようなコーパスには最も「整合性のある」音声データがあるからです。このデータセットは宗教的な内容に偏っており、主に男性の声を特徴としていますが、この論文は、このモデルが女性の声を使用した場合でも他の領域でも同様に良好に機能することを示しています。これはベースモデルの創発的な動作であり、本当に驚くべきことです。さらに驚くべきことは、Meta が新しく開発されたすべてのモデル (音声認識、TTS、言語認識) を無料でリリースしたことです。

- # モデルのダウンロード: https://github.com/facebookresearch/fairseq/tree/main/examples/mms

- 論文アドレス: https://research.facebook.com/publications/scaling-speech-technology-to-1000-langages/

数千の単語を認識できる音声モデルを作成するために、最初の課題は、さまざまな言語の音声データを収集することです。現在利用可能な最大の音声データセットはたったの 1 つだけであるためです。 100言語まで。この問題を克服するために、メタ研究者は、多くの異なる言語に翻訳されている聖書などの宗教文書を使用し、それらの翻訳は広範囲に研究されてきました。これらの翻訳には、さまざまな言語で読み上げた音声録音が含まれており、これらの音声も一般公開されています。研究者らは、これらの音声を使用して、1,100 の言語で新約聖書を読む人々の音声を含むデータセットを作成しました。音声の長さは 1 言語あたり平均 32 時間でした。

その後、他の多くのキリスト教の朗読の注釈なしの録音が含まれ、利用可能な言語の数が 4,000 以上に増加しました。このデータセットのフィールドは単一で、ほとんどが男性の声で構成されていますが、分析結果は、Meta が新たに開発したモデルが女性の声でも同様に良好に機能し、このモデルがより宗教的な言語を生成することに特に偏っていないことを示しています。研究者らはブログで、これは主に彼らが使用したコネクショニスト時間分類法によるものであり、この手法は大規模言語モデル (LLM) やシーケンスツーシーケンス音声認識モデルよりもはるかに優れていると述べています。

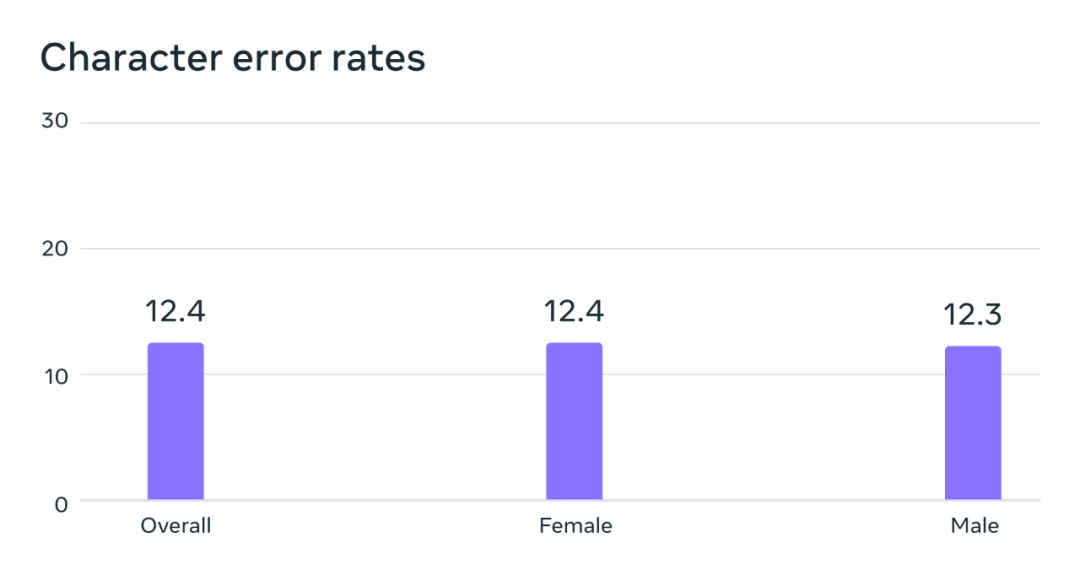

# 潜在的なジェンダーバイアス状況の分析。 FLEURS ベンチマークでは、多言語音声 (MMS) データセットでトレーニングされたこの自動音声認識モデルは、男性の声と女性の声で同様のエラー率を示します。

機械学習アルゴリズムで使用できるようにデータの品質を向上させるために、いくつかの前処理方法も採用されました。まず、100 を超える言語の既存データで位置合わせモデルをトレーニングし、それを 20 分を超える非常に長い録音を処理できる効率的な強制位置合わせアルゴリズムと組み合わせました。その後、複数ラウンドの位置合わせプロセスを経た後、相互検証フィルタリングの最終ステップが実行され、モデルの精度に基づいて位置ずれの可能性があるデータが除去されます。他の研究者が新しい音声データ セットを作成しやすくするために、Meta はアライメント アルゴリズムを PyTorch に追加し、アライメント モデルをリリースしました。

一般的に使用可能な教師あり音声認識モデルをトレーニングするには、言語ごとに 32 時間のデータだけでは十分ではありません。したがって、彼らのモデルは、自己教師あり音声表現学習に関する以前の研究である wav2vec 2.0 に基づいて開発されており、学習に必要なラベル付きデータの量を大幅に削減できます。具体的には、研究者らは、これまでの研究の 5 倍以上の言語である 1,400 以上の言語の約 500,000 時間の音声データを使用して自己教師ありモデルをトレーニングしました。次に、特定の音声タスク (多言語音声認識や言語認識など) に基づいて、研究者は結果のモデルを微調整します。

結果

研究者らは、新しく開発したモデルをいくつかの既存のベンチマークで評価しました。

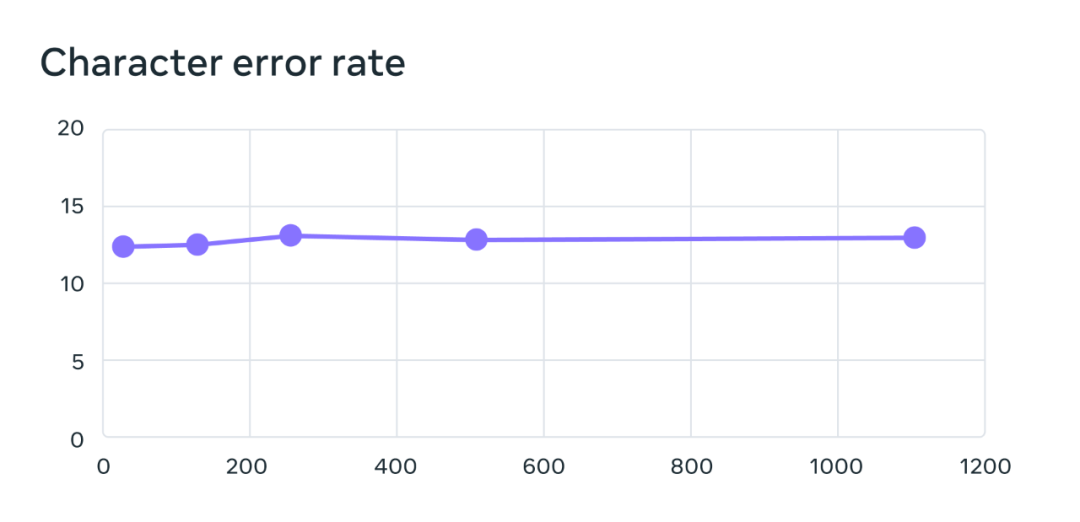

多言語音声認識モデルのトレーニングでは、10 億のパラメーターを持つ wav2vec 2.0 モデルが使用され、トレーニング データ セットには 1,100 以上の言語が含まれています。言語の数が増えるとモデルのパフォーマンスは確かに低下しますが、その低下は非常にわずかです。言語の数が 61 から 1107 に増加しても、文字エラー率は 0.4% しか増加しませんが、言語のカバレッジはさらに増加します。 18倍以上。

FLEURS 61言語のベンチマークテストでは、言語数が増えるにつれて文字誤り率が変化し、エラー率が高いほど、モデルは悪くなります。

研究者らは、OpenAI の Whisper モデルを比較したところ、彼らのモデルの単語誤り率は Whisper の半分しかないのに対し、新しいモデルは 11 倍多くの言語をサポートしていることを発見しました。この結果は、新しい方法の優れた機能を示しています。

直接比較できる 54 の FLEURS 言語のベンチマークにおける OpenAI Whisper と MMS の単語エラー率の比較。

次に、メタ研究者は、以前の既存のデータ セット (FLEURS や CommonVoice など) と新しいデータ セットを使用して、言語識別 (LID) モデルもトレーニングし、FLEURS LID タスクを評価しました。 。結果は、新しいモデルが優れたパフォーマンスを発揮するだけでなく、40 倍以上の言語をサポートしていることを示しています。

前回の調査でも、VoxLingua-107 ベンチマークでは 100 以上の言語のみがサポートされていましたが、MMS は 4000 以上の言語をサポートしています。

さらに、Meta は 1,100 の言語をサポートするテキスト読み上げシステムを構築しました。現在のテキスト読み上げモデルのトレーニング データは通常、単一の話者からの音声コーパスです。 MMS データの制限の 1 つは、多くの言語には話者の数が少なく、話者が 1 人の場合も多いことです。しかし、これはテキスト読み上げシステムを構築する際に利点となるため、Meta は 1,100 以上の言語をサポートする TTS システムを構築しました。研究者らは、これらのシステムによって生成される音声の品質は実際に非常に優れており、以下にいくつかの例を示します。

ヨルバ語、イロコ語、マイティリ語の MMS テキスト読み上げモデルのデモ。

にもかかわらず、研究者らは AI テクノロジーはまだ完璧ではなく、MMS についても同様であると述べています。たとえば、MMS は、音声をテキストに変換する際に、選択された単語やフレーズを誤って転記する可能性があります。これにより、出力に不快な表現や不正確な表現が含まれる可能性があります。研究者らは、責任を持って開発するためにAIコミュニティと協力することの重要性を強調した。

単一モデルで千の単語をサポートする価値

世界中の多くの言語が絶滅の危機に瀕しており、現在の音声認識および音声生成テクノロジーの限界この傾向はさらに加速するだけです。研究者はブログの中で次のように想像しました。優れたテクノロジーがあれば、情報を入手したりテクノロジーを使用したりするために自分の好きな言語を使用できるため、テクノロジーが人々に自分の言語を保持するよう促すことができるのかもしれません。

彼らは、MMS プロジェクトがこの方向への重要な一歩であると信じています。また、プロジェクトは今後も開発を続け、将来的にはさらに多くの言語をサポートし、方言やアクセントの問題も解決するだろうとも述べた。

以上がMeta は聖書を使用して超多言語モデルをトレーニングします。1107 言語を認識し、4017 言語を識別しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7455

7455

15

15

1375

1375

52

52

77

77

11

11

14

14

9

9

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google が推進する JAX のパフォーマンスは、最近のベンチマーク テストで Pytorch や TensorFlow のパフォーマンスを上回り、7 つの指標で 1 位にランクされました。また、テストは最高の JAX パフォーマンスを備えた TPU では行われませんでした。ただし、開発者の間では、依然として Tensorflow よりも Pytorch の方が人気があります。しかし、将来的には、おそらくより大規模なモデルが JAX プラットフォームに基づいてトレーニングされ、実行されるようになるでしょう。モデル 最近、Keras チームは、ネイティブ PyTorch 実装を使用して 3 つのバックエンド (TensorFlow、JAX、PyTorch) をベンチマークし、TensorFlow を使用して Keras2 をベンチマークしました。まず、主流のセットを選択します

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

目標検出は自動運転システムにおいて比較的成熟した問題であり、その中でも歩行者検出は最も初期に導入されたアルゴリズムの 1 つです。ほとんどの論文では非常に包括的な研究が行われています。ただし、サラウンドビューに魚眼カメラを使用した距離認識については、あまり研究されていません。放射状の歪みが大きいため、標準のバウンディング ボックス表現を魚眼カメラに実装するのは困難です。上記の説明を軽減するために、拡張バウンディング ボックス、楕円、および一般的な多角形の設計を極/角度表現に探索し、これらの表現を分析するためのインスタンス セグメンテーション mIOU メトリックを定義します。提案された多角形モデルの FisheyeDetNet は、他のモデルよりも優れたパフォーマンスを示し、同時に自動運転用の Valeo 魚眼カメラ データセットで 49.5% の mAP を達成しました。

Llama 70B を実行するシングル カードはデュアル カードより高速、Microsoft は FP6 を A100 オープンソースに強制導入

Apr 29, 2024 pm 04:55 PM

Llama 70B を実行するシングル カードはデュアル カードより高速、Microsoft は FP6 を A100 オープンソースに強制導入

Apr 29, 2024 pm 04:55 PM

FP8 以下の浮動小数点数値化精度は、もはや H100 の「特許」ではありません。 Lao Huang は誰もが INT8/INT4 を使用できるようにしたいと考え、Microsoft DeepSpeed チームは NVIDIA からの公式サポートなしで A100 上で FP6 の実行を開始しました。テスト結果は、A100 での新しい方式 TC-FPx の FP6 量子化が INT4 に近いか、場合によってはそれよりも高速であり、後者よりも精度が高いことを示しています。これに加えて、エンドツーエンドの大規模モデルのサポートもあり、オープンソース化され、DeepSpeed などの深層学習推論フレームワークに統合されています。この結果は、大規模モデルの高速化にも即座に影響します。このフレームワークでは、シングル カードを使用して Llama を実行すると、スループットはデュアル カードのスループットの 2.65 倍になります。 1つ