Meta の自社開発 AI チップの進捗状況: 最初の AI チップは 2025 年に発売され、ビデオ AI チップも登場する予定

5月19日のニュース、海外メディアTechcrunchによると、今朝のオンラインイベントで、Facebookの親会社Metaが、最近発売した広告デザイン・制作ツールGenerative AIをサポートできる自社開発AIチップの進捗状況を初めて明らかにした。テクノロジー。

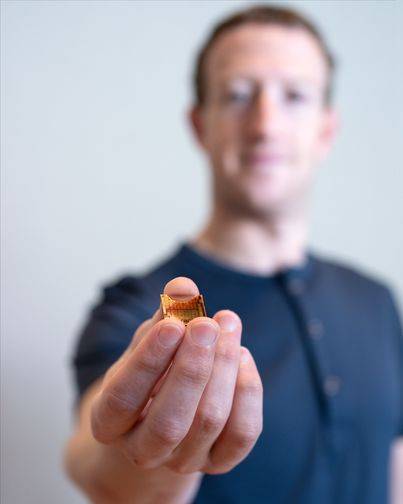

△Meta CEOのザッカーバーグ氏が初の自社開発AIチップMTIAを披露

Meta のインフラストラクチャ担当副社長 Alexis Bjorlin 氏は次のように述べています。人工知能研究の限界。」

初の自社開発AIチップMTIA過去 10 年ほどにわたって、Meta はトップのデータ サイエンティストの採用と新しいタイプの人工知能の構築に数十億ドルを費やしてきました。その中には、人工知能のアプリやサービス全体で発見エンジン、モデレーション フィルター、広告レコメンダーを強化しているものも含まれます。この企業は、特に生成 AI の分野において、多くの野心的な AI 研究イノベーションを製品に変えることに努めてきました。

2016 年以来、大手インターネット企業はクラウド AI チップの開発を積極的に行っています。 Google は、PaLM-2、Imagen などの生成 AI システムをトレーニングするための Tensor Processing Unit (TPU) と呼ばれる自社開発の AI チップを設計および導入しており、Amazon は 2 つの自社開発 AI チップ、AWS Trainium と AWS を AWS の顧客に提供しています。アプリケーション用の推論チップ。 MicrosoftはAMDと協力してAthenaと呼ばれるAIチップを開発しているとも噂されている。以前、Meta は主にサードパーティの CPU と、AI ワークロードを実行する AI アルゴリズムを高速化するように設計されたカスタム チップを組み合わせて使用していました。CPU は、そのようなタスクの処理において GPU よりも効率が低い傾向がありました。この状況を好転させるために、Meta は 2020 年に 7nm プロセスに基づく第 1 世代の自社開発 AI チップ MTIA (MTIA v1) を開発しました。

Meta は、AI チップを Meta Training and Inference Accelerator (略して MTIA) と呼び、AI のトレーニングと推論のワークロードを加速する AI チップの「ファミリー」の一部であると説明しています。 MTIA は ASIC であり、単一の基板上にさまざまな回路を組み合わせたチップであり、1 つ以上のタスクを並行して実行するようにプログラムできます。

紹介によると、MTIA v1は7nmプロセスを使用して製造されており、その内部128MBメモリは最大128GBまで拡張できます。 Meta氏によると、MTIAはAIレコメンデーションシステムに関連する作業を処理するために特別に使用でき、ユーザーが最適な投稿コンテンツを見つけてより迅速にユーザーに提示するのに役立ち、そのコンピューティングパフォーマンスと処理効率はCPUよりも優れているという。さらに、メタデザインのベンチマークテストでは、「低複雑さ」および「中複雑さ」の AI モデルの処理において、MTIA は GPU よりも効率的です

。

Meta 氏は、MTIA チップのメモリとネットワーク領域にはまだやるべきことがいくつかあり、AI モデルの規模が拡大するにつれてボトルネックが生じ、ワークロードを複数のチップに分散する必要があると述べています。最近、Meta はこの目的のために、オスロに拠点を置く英国のチップユニコーン Graphcore の AI ネットワーク技術チームを買収しました。現在、MTIA はメタ アプリケーション ファミリの「推奨ワークロード」のトレーニング機能よりも推論機能に重点を置いています。Meta は、MTIA の改善を継続することを強調しました。これにより、推奨されたワークロードを実行する際のワットあたりのパフォーマンスの点で会社の効率が「大幅に」向上しました。これにより、Meta は「より強化された」「最先端の」人工知能ワークロードを実行できるようになりました。 。

計画によると、Metaは2025年に自社開発のMTIAチップを正式に発売する予定です。

Meta の AI スーパーコンピューター RSC

報道によると、Meta は当初、自社開発のカスタム AI チップを 2022 年に大規模に発売する予定だったが、結局延期し、代わりにスーパーコンピューター Research SuperCluster (RSC) 向けに数十億ドル相当の Nvidia GPU を発注したとのこと。複数のデータセンターの再設計が必要でした。

報道によると、RSCは2022年1月にデビューし、ペンギン・コンピューティング、Nvidia、ピュア・ストレージと提携して設立され、拡張の第2フェーズを完了しました。 Meta によれば、同社には現在、16,000 個の Nvidia A100 GPU を搭載した合計 2,000 台の Nvidia DGX A100 システムが含まれています。とはいえ、RSC の現在のコンピューティング能力は Microsoft や Google の AI スーパーコンピューターに比べて遅れています。 Google は、AI に特化したスーパーコンピューターには 26,000 個の Nvidia H100 GPU が搭載されていると主張しています。 Meta 氏は、RSC の利点は、研究者が Meta の実稼働システムの実際の例を使用してモデルをトレーニングできることであると指摘しました。オープンソースと公開されているデータセットを活用していた同社の以前の AI インフラストラクチャとは異なり、このインフラストラクチャは現在利用可能です。

RSC AI スーパーコンピューターは、生成 AI を含む複数の分野で AI 研究を推進し、研究の限界を押し広げています。 「これはまさにAI研究の生産性に関するものです」とMetaの広報担当者は語った。私たちは、AI 研究者にモデルの開発を可能にする最先端のインフラストラクチャを提供し、AI を進歩させるためのトレーニング プラットフォームを提供したいと考えています。 ”

Meta は、RSC はピーク時に 5 エクサフロップス近くの計算能力に達し、世界最速の 1 つになると主張しています。

Meta は LLaMA トレーニングに RSC を使用します。RSC は「Large Scale Language Model Meta Artificial Intelligence」の頭字語を指します。 Meta によれば、最大の LLaMA モデルは 2,048 個の A100 GPU でトレーニングされ、21 日かかったという。

「独自のスーパーコンピューティング機能を構築することで、データセンターの設計からトレーニング フレームワークに至るまで、スタックのあらゆる層を制御できるようになります。」と Meta の広報担当者は付け加えました。「RSC は、Meta の AI 研究者が何兆ものデータから学習できる新しいより優れた AI モデルを構築するのに役立ちます。例; 何百もの異なる言語で連携して、新しい拡張現実ツールなどを開発します。

将来的には、Meta は自社開発の AI チップ MTIA を RSC に導入して、AI のパフォーマンスをさらに向上させる可能性があります。

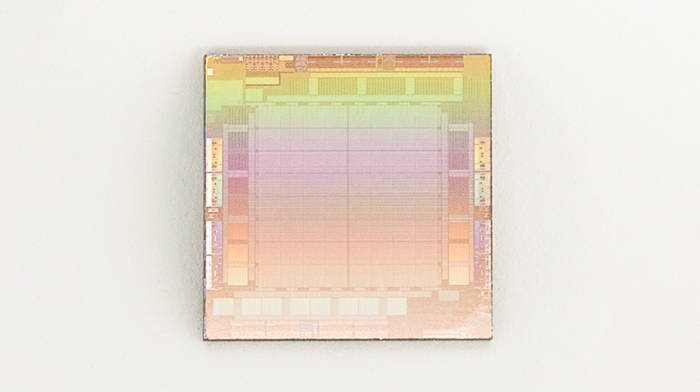

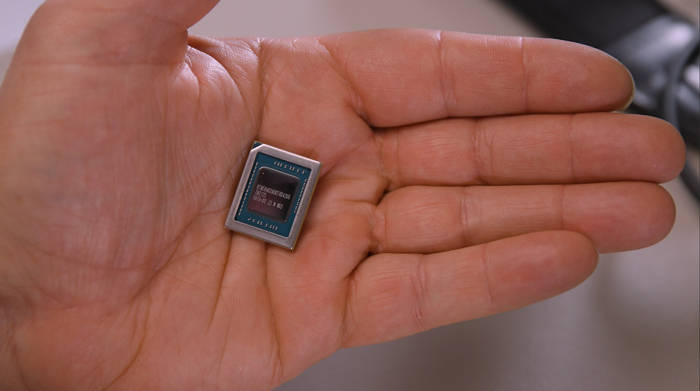

ビデオ処理用AIチップMSVP

MTIA に加えて、Meta は Meta Scalable Video Processor (MSVP) と呼ばれる別の AI チップも自社開発しています。これは主にビデオ オン デマンドとライブ ストリーミングの増大するデータ処理ニーズを満たすように設計されており、Meta は最終的に一部の成熟したビデオ プロセッサを実現したいと考えています。安定したオーディオおよびビデオ コンテンツの処理作業は MSVP によって実行されます。実際、Meta は何年も前にカスタムのサーバー側ビデオ処理チップの構想を開始し、2019 年にビデオのトランスコーディングと推論作業用の ASIC の発売を発表しました。これはこれらの取り組みの集大成であり、競争上の優位性を新たに推進するものです。特にライブビデオストリーミングの分野で顕著です。

「Facebook だけで、人々はビデオの視聴に時間の 50% を費やしています」と Meta テクニカル ディレクターの Harikrishna Reddy 氏と Yunqing Chen 氏は 19 日朝に公開されたブログ投稿で次のように書いています。 Facebook や Instagram は、さまざまなデバイス (モバイル、ラップトップ、テレビなど) に合わせて、異なるエンコード形式、解像度、品質を持つ複数のビットストリームにトランスコードされます。MSVP はプログラム可能でスケーラブルであり、必要な高品質のトランスコーディングを効率的にサポートするように構成できます。 VOD だけでなく、ライブ ストリーミングに必要な低遅延と高速な処理時間も備えています。」

△MSVP

△MSVP

Meta によると、最終的にはほとんどの「安定して成熟した」ビデオ処理ワークロードを MSVP にオフロードし、特定のカスタマイズと「大幅に」高い品質を必要とするワークロードにのみソフトウェア ビデオ エンコーディングを使用する計画であると述べています。メタ氏は、インテリジェントなノイズ低減や画像強調などの前処理方法だけでなく、アーティファクト除去や超解像度などの後処理方法を使用して、MSVP によるビデオ品質の向上を継続すると述べています。

「将来的には、MSVP により、短編ビデオを含むメタの最も重要なユースケースとニーズをさらにサポートできるようになり、生成 AI、AR/VR、その他のメタバース コンテンツの効率的な配信が可能になります」と、レディとチェンは述べました。

編集者: Xinzhixun-るるに剣

以上がMeta の自社開発 AI チップの進捗状況: 最初の AI チップは 2025 年に発売され、ビデオ AI チップも登場する予定の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7444

7444

15

15

1371

1371

52

52

76

76

11

11

9

9

6

6

新しいタイトル: NVIDIA H200 リリース: HBM 容量が 76% 増加、大規模モデルのパフォーマンスが 90% 大幅に向上する最も強力な AI チップ

Nov 14, 2023 pm 03:21 PM

新しいタイトル: NVIDIA H200 リリース: HBM 容量が 76% 増加、大規模モデルのパフォーマンスが 90% 大幅に向上する最も強力な AI チップ

Nov 14, 2023 pm 03:21 PM

11月14日のニュースによると、Nvidiaは現地時間13日午前の「Supercomputing23」カンファレンスで新しいH200 GPUを正式に発表し、GH200製品ラインをアップデートしたとのことだが、このうちH200は依然として既存のHopper H100アーキテクチャをベースに構築されている。ただし、人工知能の開発と実装に必要な大規模なデータ セットをより適切に処理するために、より多くの高帯域幅メモリ (HBM3e) が追加され、大規模なモデルを実行する全体的なパフォーマンスが前世代の H100 と比較して 60% ~ 90% 向上しました。 。アップデートされた GH200 は、次世代の AI スーパーコンピューターにも搭載されます。 2024 年には、200 エクサフロップスを超える AI コンピューティング能力がオンラインになるでしょう。 H200

MediaTekはGoogleからサーバーAIチップの大量注文を獲得し、高速Serdesチップを供給すると噂されている

Jun 19, 2023 pm 08:23 PM

MediaTekはGoogleからサーバーAIチップの大量注文を獲得し、高速Serdesチップを供給すると噂されている

Jun 19, 2023 pm 08:23 PM

6月19日の台湾メディアの報道によると、Google(グーグル)は、最新のサーバー向けAIチップの開発に向けてMediaTekに協力を打診し、ファウンドリ用のTSMCの5nmプロセスに引き渡す計画であるとのこと。来年初めに量産する予定。レポートによると、情報筋は、GoogleとMediaTekの今回の協力により、MediaTekにシリアライザおよびデシリアライザ(SerDes)ソリューションが提供され、Googleが自社開発したテンソルプロセッサ(TPU)の統合を支援して、Googleが最新のサーバーAIチップをより強力に作成できるよう支援することを明らかにしました。 CPU や GPU アーキテクチャよりも優れています。業界は、Google の現在のサービスの多くは AI に関連していると指摘しており、Google は何年も前にディープ ラーニング テクノロジーに投資しており、AI の計算を実行するのに GPU を使用するとコストが非常に高いことが判明しました。

AI における次の大きな要素: NVIDIA B100 チップと OpenAI GPT-5 モデルのピーク パフォーマンス

Nov 18, 2023 pm 03:39 PM

AI における次の大きな要素: NVIDIA B100 チップと OpenAI GPT-5 モデルのピーク パフォーマンス

Nov 18, 2023 pm 03:39 PM

世界で最も強力な AI チップとして知られる NVIDIA H200 のデビュー後、業界は NVIDIA のより強力な B100 チップに期待し始めました。同時に、今年最も人気のある AI スタートアップ企業である OpenAI も動き始めました。より強力で複雑な GPT-5 モデルを開発します。 Guotai Junan氏は最新の調査報告書の中で、無限の性能を備えたB100とGPT5が2024年にリリースされる予定であり、メジャーアップグレードにより前例のない生産性が解放される可能性があると指摘した。同庁は、AIが急速な発展期に入り、その認知度は2024年まで続くだろうと楽観的であると述べた。前世代の製品と比較して、B100 と GPT-5 はどの程度強力ですか? NVIDIA と OpenAI はすでにプレビューを行っています: B100 は H100 より 4 倍以上高速になる可能性があり、GPT-5 は超高速を達成する可能性があります

オンラインの噂によると、vivo は Microsoft Copilot に似た大規模な自社開発 AI モデルを発表する予定です

Oct 17, 2023 pm 05:57 PM

オンラインの噂によると、vivo は Microsoft Copilot に似た大規模な自社開発 AI モデルを発表する予定です

Oct 17, 2023 pm 05:57 PM

Vivo は、2023 年 11 月 1 日に深セン国際会議展示センターで「Together Together」をテーマにした 2023 年開発者カンファレンスを開催すると正式に発表しました。自社開発の大規模な AI モデル、自社開発のオペレーティング システム、システム、および OriginOS4 システム。最近、有名なデジタルブロガー「Digital Chat Station」は、Vivo の自社開発 AI 大型モデルが、Microsoft Copilot と同様に、サイドバーから呼び出される別個のフローティング ウィンドウと統合されたモードを備えた OriginOS4 上で起動されるというニュースを発表しました。 AIのデータ量とシステムの統合がうまく行われており、すべての従業員がインテリジェントなシステムを持っています。写真から判断すると、vivoの自社開発AI大型モデルは「JoviCopilot」と名付けられることになる。 JoviCopilot は次のことができると報告されています。

徹底解明: Apple 独自のカメラ ISP 開発の秘密!

Nov 11, 2023 pm 02:45 PM

徹底解明: Apple 独自のカメラ ISP 開発の秘密!

Nov 11, 2023 pm 02:45 PM

11月11日のニュースによると、最近、携帯電話チップ分野の権威である@手机Chip Daren氏が最新のWeiboで、Appleがモバイル分野での技術力をさらに強化するために2つの新しいM3シリーズチップを間もなく発売する予定であることを明らかにした。デバイスチップ。これら 2 つのチップは高度な 3nm テクノロジーを使用して、ユーザーにより優れたパフォーマンスとエネルギー効率をもたらします。これら 2 つのチップの詳細はまだ謎に包まれています。しかし、携帯電話チップの専門家によると、M3シリーズの4番目のチップはM3 Ultraと名付けられ、高度な「UltraFusion」技術が使用されるという。このテクノロジーの特徴は、2 つの M3Max チップを巧みにつなぎ合わせて、より強力な計算能力と処理速度をデバイスに提供することです。 M3シリーズ5番目のコアは

Kneron が最新の AI チップ KL730 を発表、軽量 GPT ソリューションの大規模アプリケーションを推進

Aug 17, 2023 pm 01:37 PM

Kneron が最新の AI チップ KL730 を発表、軽量 GPT ソリューションの大規模アプリケーションを推進

Aug 17, 2023 pm 01:37 PM

KL730 のエネルギー効率の向上により、人工知能モデルの実装における最大のボトルネックであるエネルギーコストが解決されました。KL730 チップは、業界および以前の Nerner チップと比較して、最先端の機能をサポートしています。 nanoGPT などの軽量 GPT 大規模言語モデルを実現し、毎秒 0.35 ~ 4 テラの効率的な計算能力を提供します。AI 企業の Kneron は本日、自動車グレードの NPU と画像信号処理 (ISP) を統合した KL730 チップのリリースを発表しました。安全で低エネルギーの AI を実現 この機能は、エッジ サーバー、スマート ホーム、自動車支援運転システムなどのさまざまなアプリケーション シナリオで活用されます。サンディエゴに本拠を置く Kneron は、画期的なニューラル プロセッシング ユニット (NPU) で知られており、その最新チップ KL730 は次のことを目指しています。

NVIDIA が新しい AI チップ H200 を発表、パフォーマンスが 90% 向上!中国のコンピューティング能力が独自の躍進を達成!

Nov 14, 2023 pm 05:37 PM

NVIDIA が新しい AI チップ H200 を発表、パフォーマンスが 90% 向上!中国のコンピューティング能力が独自の躍進を達成!

Nov 14, 2023 pm 05:37 PM

世界は依然として NVIDIA H100 チップに夢中であり、AI コンピューティング能力に対する需要の高まりに応えるために狂ったように購入していますが、NVIDIA は現地時間の月曜日、他の大規模 AI モデルと比較してトレーニングに使用される最新の AI チップ H200 を静かに発売しました。前世代製品H100、H200と比べて性能が約60%~90%向上しました。 H200 は Nvidia H100 のアップグレード バージョンであり、H100 と同様にホッパー アーキテクチャに基づいており、主なアップグレードには 141 GB の HBM3e ビデオ メモリが含まれており、ビデオ メモリの帯域幅は H100 の 3.35 TB/s から 4.8 TB/s に増加しています。 Nvidia の公式 Web サイトによると、H200 は HBM3e メモリを使用する同社初のチップでもあり、このメモリはより高速で大容量であるため、大規模な言語に適しています。

Kneron が最新 AI チップ KL730 の発売を発表

Aug 17, 2023 am 10:09 AM

Kneron が最新 AI チップ KL730 の発売を発表

Aug 17, 2023 am 10:09 AM

元の言葉によると、次のように書き換えることができます: (Global TMT 2023年8月16日) サンディエゴに本社を置き、画期的なニューラル プロセッシング ユニット (NPU) で知られる AI 企業 Kneron は、KL730 チップのリリースを発表しました。このチップは車載グレードの NPU と画像信号処理 (ISP) を統合し、エッジ サーバー、スマート ホーム、自動車支援運転システムなどのさまざまなアプリケーション シナリオに安全で低エネルギーの AI 機能を提供します。エネルギー効率の点では、以前の Nerner チップと比較してエネルギー効率が 3 ~ 4 倍向上し、主要産業の同様の製品と比べて 150% ~ 200% 高くなります。このチップは毎秒 0.35 ~ 4 テラの実効計算能力を備え、最先端の軽量 GPT ラージをサポートできます。