今年 3 月、AI トレンドの高まりに直面して、「シリコンバレーのナイフ王」は日本人の態度を変え、自ら率先して表舞台に立ち、AI を活用した DGX Cloud の立ち上げを発表しました。 -「レンタル」用のクラウド上の特定の GPU。

かつては、クラウド コンピューティング会社がコンピューティング能力の販売を担当していました。彼らはグラフィックス カードと人工知能アクセラレータの複数のモデルを購入し、ハードウェアのパフォーマンスや使用時間に基づいて価格を設定し、下流の顧客にレンタルします。

このプロセスでは、NVIDIA は GPU をクラウド コンピューティング プラットフォームに販売するか、AI 企業に直接販売します。たとえば、最初の NVIDIA DGX スーパーコンピューターは 2016 年に Huang 氏個人によって OpenAI に納入されましたが、コンピューティング パワーを直接販売したわけではありません。彼は「シャベル売り」とみなされる可能性があります。

DGX のクラウド移行に関しては、Nvidia は依然として DGX をクラウド プラットフォーム上でホストする必要がありますが、本質的に境界を越えています。

いつも裏方だったNVIDIAが今回、なぜ表舞台に踏み出すのか?

NVIDIA が今回の AI の潮流から最大の受益者であることは間違いありませんが、そのような受益者はいないかもしれません。

AIの学習に使用されるGPUチップの価格が高騰しており、A100とH100のチップ当たりの海外価格はそれぞれ15,000米ドルと40,000米ドルに上昇しており、A100を8台搭載し、80Gのストレージ容量を備えた国内AIサーバーの価格は高騰している。昨年半ばの8万台/台から、現在は165万台/台まで高騰しています。

しかし、すべての資金が Nvidia のポケットに流れ込んだわけではなく、プレミアムはチャネルに持ち去られました。重要なのは、Nvidia を売買する方法がないということです。

DGX Cloudはこうした状況下で登場したもので、本体価格が非常に安いようです。 8 個の H100 GPU モジュールを搭載した DGX Cloud の月額パッケージ料金はわずか 37,000 米ドルで、これは 1 台の H100 の価格に相当します。

コンピューティング能力と資金が緊急に必要であるにもかかわらず、資金が不足している AI 企業にとって、DGX Cloud は間違いなく、眠いときに空から降ってくる枕です。Nvidia にとって、クラウド コンピューティング能力を販売することは、お金を稼ぐだけでなく、顧客を拘束することにもなります。

一見win-winの状況の裏側では、AIを中心とした秘密の戦争が始まっています。

同等のコンピューティング能力

業界の特性の観点から見ると、クラウド コンピューティング能力に基づく今日の AIGC は以前の暗号資産マイニングと非常に似ていますが、必要なリソースは後者よりもはるかに高くなります。

Guosheng Securities はかつて、「Web3 の観点から見た AIGC コンピューティング能力の進化」の中で、暗号資産マイニングと AIGC 業界の類似点と相違点を比較しました:

1 AIGC 業界の電力消費量は、約 1.6 ~ 7.5 年以内にビットコイン マイニング業界の現在の電力消費量を超えるでしょう。主な原動力は、モデル パラメーター、日常アクティビティ、および数における GPT 大規模言語モデルの急速な成長です。モデルの;

###2 ビットコインマイニングと同様に、AIGC業界におけるコンピューティングパワーを原動力とするコンテンツは熾烈な競争が繰り広げられており、参加者は質の高いコンテンツを継続的かつ迅速に制作することによってのみ、獲得したユーザーの注目を低下させることはありません。これは、AIGC 業界の 2 つの大きな特徴、つまり高コストと持続可能性につながります。

このうち、コスト面は消費電力だけではありません。もちろん、消費電力は非常に直感的な証拠として利用できます。例えば、百度が温信宜燕の推論訓練に使用している陽泉スーパーコンピューティングセンターは、1時間当たり6万4000kW・h(度)を消費し、商用電力消費基準0.45元/kW・hによれば、年間電気代は2億5千万に達する。

コンピューティング能力への投資により、より大きなコストが発生します。

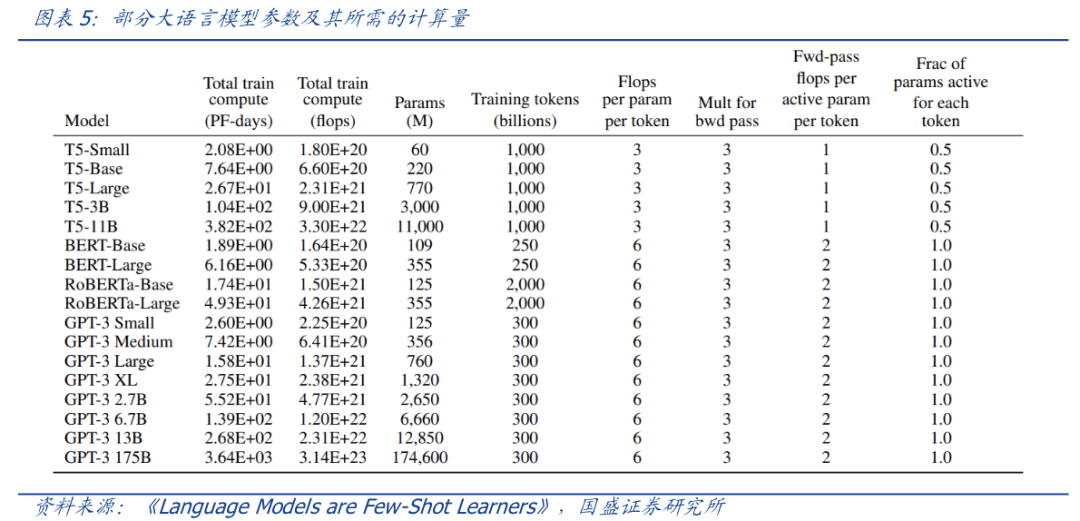

ChatGPT を例に挙げると、日常の活動と関連性の高い推論プロセスに必要な計算能力は考慮せず、トレーニング プロセスのみを考慮します。計算によると、1,750 億個のパラメータを持つ GPT-3 の 1 回のトレーニングが必要になります。約 6,000 枚の Nvidia A100 グラフィックス カードが必要ですが、インターネットが損失とみなされる場合、約数万枚の A100 が必要になります。

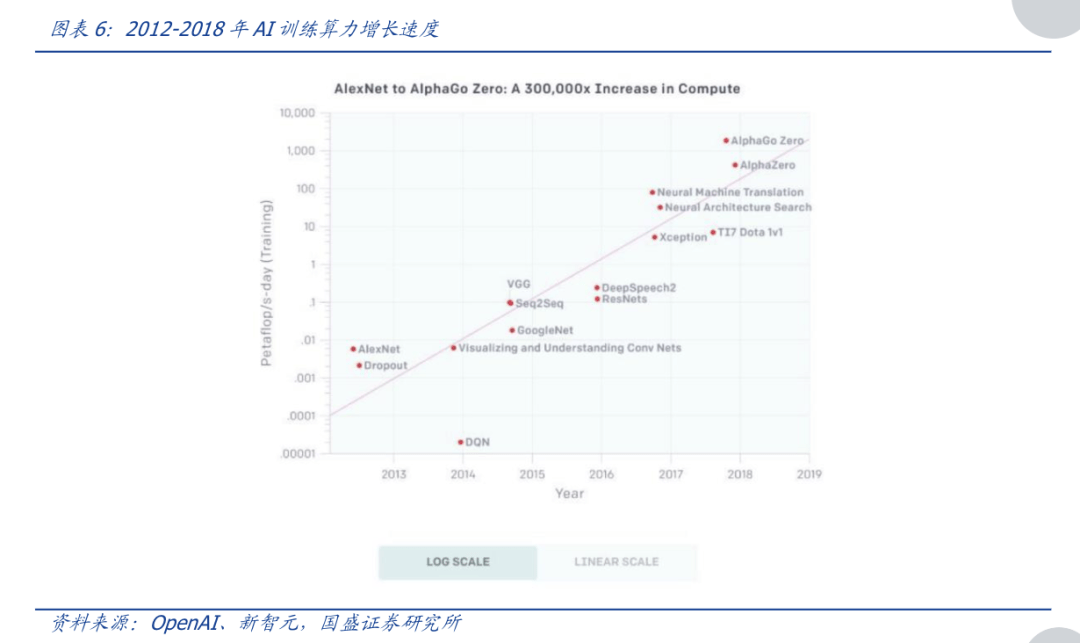

さらに、より大規模な AIGC モデルのリリースに伴い、必要なコンピューティング能力が急増しています。

OpenAI の計算によると、2012 年から 2018 年にかけて、AI のトレーニングに必要なコンピューティング能力は約 3 ~ 4 か月ごとに 2 倍になり、合計で 300,000 倍に増加しました (一方、同じ期間の成長においてムーアの法則はわずか 7 倍でした)。頭部トレーニング モデルに必要な計算能力は毎年 10 倍も増加しており、全体的な増加は指数関数的です。

現時点では、クラウド コンピューティング能力の利点が反映されており、それは 8 つの言葉で要約できます: 部分に分割し、オンデマンドで支払うことができます。

クラウド コンピューティング能力により、AIGC 大型モデル メーカーは、NVIDIA A100 グラフィックス カードなどのハードウェアを購入することなく、クラウド コンピューティング パワー プラットフォームによって提供されるハードウェアをオンデマンドで直接レンタルできるため、新興企業や非ヘッド モデル メーカーも参入を試みることができます。 AIGC フィールド。

この「パーツに分ける」アプローチでも、業界チェーンのすべての関係者にとって有益です:

1) 上流のコンピューティング パワー メーカーにとって、コンピューティング パワー ハードウェアがオフシーズンに入り在庫が増加した場合、クラウド コンピューティング パワーを販売することで収入の変動を平滑化し、ピーク シーズンに備えて「ライブ」電力を確保できます。市場の需要をタイムリーに;

2) 中流のクラウド サービス メーカーにとっては、顧客の流れの増加に役立ちます;

3) ダウンストリームのコンピューティング能力を要求する企業にとって、コンピューティング能力の使用のしきい値を最小限に抑え、すべての人に AIGC 時代の到来を促すことができます。

AIGC 大型モデル メーカーがより多くのリソースを移転する意欲があれば、クラウド プラットフォームとより緊密に連携することもできます。この点における典型的なケースは、Microsoft Cloud と OpenAI の協力であり、両者の協力はコンピューティング パワーのレンタルにとどまらず、資本と製品の統合にまで深く踏み込んでいます。

さらに、大規模モデルのコンテストでは、明らかなハードウェア投資コストに加えて、目に見えない時間コストも発生します。

一般に、大規模モデルの計算能力要件は 2 つの段階に分かれており、第 1 段階は ChatGPT と同様の大規模モデルを学習するプロセス、第 2 段階はこのモデルを商用化する推論プロセスです。

そして、このプロセスが長く続くほど、モデルはより良くなります。したがって、NVIDIA DGX Cloud を見ると、Lao Huang が何をしたかを理解するのは難しくありません。

クラウド手法を使用して、AI トレーニングに使用される GPU の価格を引き下げ、コンピューティング パワーへの平等なアクセスで中小企業を魅了し、大規模なモデル トレーニングの持続可能性の要素に基づいて顧客を結び付けます。シリコンバレー剣王』は一石二鳥です。

恩恵を受けるのは Nvidia ではないかもしれません

昨年 12 月以来、Nvidia A100 の価格は 5 か月間で 37.5% 上昇し、A800 の価格は同じ期間で 20.0% 上昇しました。

GPU の価格の高騰により、AIGC が大規模モデルをトレーニングする敷居が高まったことは間違いありませんが、大手メーカーの場合、価格の上昇に関係なく GPU を購入する必要があります。しかし、ウエスト企業にとっては、価格が上がらなければ、我慢して発注するかもしれないが、価格が上がってしまえば、GPU に頼るしかなくなる。トレーニングに必要なグラフィックス カードをすべて購入することもできます。

つまり、Lao Huang がこの時期に DGX Cloud を利用したのは、高級レンタカー会社を設立して、お金のない人が借りられるようにするようなものでした。

もちろん、この背後にあるもう 1 つの考慮事項は、競合他社に先んじて、より多くの中小規模の顧客を結び付けることです。

今回の AI ブームにおいて、OpenAI を除けば、最も輪から外れている AI 企業は、他でもない Midjourney と Authropic です。前者は最近 QQ チャネルと連携して国内事業を開始した AI 描画アプリケーションで、後者の創設者は OpenAI 出身で、同社の会話ロボット Claude は ChatGPT を直接ベンチマークしています。

この 2 社には、スーパーコンピューターを構築するために Nvidia GPU を購入せず、代わりに Google のコンピューティング サービスを利用したという共通点があります。

このサービスは、Google 独自の研究に焦点を当てた 4096 TPU v4 を統合したスーパーコンピューティング システムによって提供されます。

自社開発チップに取り組むもう 1 つの巨人は、この AI の波のリーダーであるマイクロソフトです。この Athena と呼ばれるチップは高度な 5nm プロセスを使用し、TSMC によって製造されていると噂されています。研究開発チームの数は 300 近くです。人々。

明らかに、このチップの目標は、高価な A100/H100 を置き換え、OpenAI にコンピューティング パワー エンジンを提供し、最終的には Microsoft の Azure クラウド サービスを通じて Nvidia のケーキを奪うことになります。

クラウド コンピューティング企業からの陰謀に加えて、Nvidia の主要顧客である Tesla も単独でやっていきたいと考えています。

2021 年 8 月、マスク氏は 3,000 個の独自の D1 チップで構築されたスーパーコンピューティング Dojo ExaPOD を外の世界に公開しました。そのうちの D1 チップは TSMC によって製造され、7nm プロセスを使用しており、3,000 個の D1 チップにより、Dojo は計算能力の点で世界第 5 位のコンピューターとなります。

これに比べて、禁止措置の影響を受ける国内企業も代替計画を持っていますが、短期的には依然として Nvidia に大きく依存しています。

国内のチップは、高い情報粒度を必要としないクラウド推論作業を実行できますが、ほとんどのチップは現在、超高度なコンピューティング能力を必要とするクラウドトレーニングを処理できません。

Suyuan Technology、Biren Technology、Tianshu Zhixin、Cambrian などの企業はいずれも独自のクラウド製品を発売しており、理論的なパフォーマンス指標は弱くありません。

以前に公開された情報によると、推論能力のある温信宜燕の訓練に使用されている百度の陽泉スーパーコンピューティング センターでは、A100 に加えて、百度が自社開発した Kunlun コアや Cambrian の Siyuan 590 など、いくつかの国産製品も使用されています。彼らは、思源が2023年の調達計画の約10%から20%を占めるというニュースがあります。

その中で、Wen Xinyiyan のチップ層コア機能は、自社開発の XPU-R アーキテクチャ、7nm プロセス、および GDDR6 高速ビデオ メモリを使用する Kunlun Core 第 2 世代 AI チップから来ており、汎用性とパフォーマンスが大幅に向上しています。 TOPS@ INT8 および 128 TFLOPS@FP16 の演算能力レベルは、前世代より 2 ~ 3 倍高くなります。

今年 3 月、Robin Li 氏も Yabuli China Entrepreneurs Forum で、Kunlun チップは現在大規模モデル推論に非常に適しており、将来的にはトレーニングにも適していると共有しました。

######終わり######RIVA128 から、NVIDIA はその驚くべき市場観察能力を実証してきました。過去 10 年ほどにわたって、仮想通貨マイニングからメタバース、AI ブームに至るまで、NVIDIA はそのトレンドを利用し、グラフィックス カードの顧客をゲーマーからテクノロジー大手まで拡大してきました。 戦争が拡大するにつれて、NVIDIA の市場価値も急上昇し、二流のチップ会社から業界全体で第 1 位になりました。しかし、Huang Renxun氏は、AI iPhoneの瞬間が到来したと述べ、NokiaがAppleに敗れたとしてもNvidiaが無敵でいられるわけがありません。

参考文献

[1] AIGC の長期的な選択肢: AI クラウド コンピューティング能力、国盛証券

[2] Web3 から見た AIGC コンピューティング能力進化理論、国盛証券

[3] Nvidia帝国に亀裂、源川研究所

[4] クラウドコンピューティングのパワーマイニングは、現在ビットコインに参入する最も安定した方法かもしれない、Odaily Planet Daily

[5] バイドゥの「Wen Xin Yi Yan」の専門家による解釈、ユニコーンシンクタンク

[6] 大型モデルの時代、国産GPUは猛烈なスピードで加速し、デジタルタイムはクリプトン

[7] NVIDIA Jensen Huang: AI スーパーコンピューティング機能は中国のクラウド サービス プロバイダーを通じて提供され、AI iPhone が登場します。最初の財務

[8] AI コンピューティングパワー産業チェーンの概要: テクノロジーの反復がボトルネックの突破を促進し、AIgc シナリオの増加がコンピューティングパワーの需要を促進、エッセンス証券

以上がクラウド コンピューティングの能力を超えて、AI との秘密の戦争が始まるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。