ビッグモデルの時代が到来!データセキュリティリスクにどう対処するか?小満耶 AI サミットの専門家からのヒント

ChatGPT のような大きな言語モデルの人気の背後にある理由は何ですか?どの業界に良いニュースをもたらすでしょうか?潜在的なバブルリスクはどこにあるのでしょうか? 5月25日から26日にかけて、2023 小満耶テクノロジーカンファレンスのサブフォーラム「インテリジェント時代に向けて文明の飛躍の実現」AIGC 特別サミットで、AI 分野の 20 名を超える研究者や実務家が AIGC のアプリケーションと新しいビジネス パラダイムについて議論しました。 、さまざまな業界や分野における新たな開発の道筋、潜在的なデータセキュリティリスクと倫理的問題。

26日のサミットでの新刊発売式では、『ビッグモデルの時代』の著者であり、アリババの元シニアプロダクトエキスパート兼事業部門副ゼネラルマネージャーで共同創業者兼チーフの龍志勇氏が登壇した。シリコンバレーのAIスタートアップの執行役員、受諾 インタビュー中、ナンドゥ氏は率直に、生成AIはまず標準化モデルに従い、開発は後であるべきだと述べた。大規模モデルの潜在的なバブルリスクに対処するには、技術的な手段と、モデルの自己評価、コンプライアンスアルゴリズムのレビューなど、および手動プロセス、さらに重要なことに、業界の問題解決の難しさとサイクルについて合理的な期待を持つことによってのみ、過度の楽観主義によって引き起こされるリスクを回避できます。

ビッグモデルが知的革命と産業再編の新たなラウンドを引き起こす

ChatGPT などの生成型人工知能の背後にある真のインテリジェントな「脳」は、大きな言語モデルです。大規模な生成事前トレーニング モデルに基づく技術の進歩により、個人や産業に複数の応用がもたらされ、知的革命と産業再建の新たなラウンドが引き起こされ、新たな脳とコンピューターのコラボレーション関係が構築されています。

大型モデルの時代が到来! Long Zhiyong 氏は、「ビッグ モデルの時代」では、テクノロジー、アプリケーション、産業変化の詳細な分析と詳細が提供され、ChatGPT ラージ モデルの背後にある原則が生き生きと説明され、ラージ モデルがどのように社会をインテリジェント革命の時代に押し上げるかを描いていることを明らかにしました。企業が大規模モデルを自社のビジネスに適用するための注意点と方法論をまとめ、個人と企業が変化に対処するための提案を提供します。同氏によると、大規模モデルは特にナレッジワーク、営利企業、クリエイティブエンターテインメントなどの分野に適用されており、主に漸進的イノベーションと破壊的イノベーションという2種類のイノベーションをもたらしているという。

サミットの基調講演で、人工知能科学者のLiu Zhiyi氏も、人工知能は経済社会発展のさまざまな分野に力を与えており、さまざまな下流分野の産業アップグレードのため大型モデルの需要が高まり続けていると述べました。中国の人工知能産業の市場規模は、2022年に3億7,000万元、2027年には15億3,700万元に達すると推定されています。今後も下流の製造、運輸、金融、金融など多くの分野に浸透していくことが予想されています。と医療の連携を図り、大規模導入を実現します。

「ビッグモデルの時代」は、5 月 26 日に開催された 2023 AIGC 特別サミット「インテリジェント時代に向けて文明の飛躍の実現」で発表されました。

生成型人工知能は信頼低下などのリスクをもたらす

しかし、大規模モデルの普及に伴い、潜在的なバブルも発生しています。 Samsung が ChatGPT を導入してから 20 日も経たないうちに、機密データが漏洩したことが明らかになりました。 AI 顔変更や AI ペインティングなどのテクノロジーによってもたらされる法的リスク、倫理的問題、データ セキュリティの問題に対する人々の関心が高まっています。

「ビッグモデル時代の AI 技術革新と倫理ガバナンス」について語る際、Liu Zhiyi 氏は、生成型人工知能には一定のリスクがあり、規模を拡大する際にこれらのリスクを考慮して軽減しなければ、変革の速度が低下する可能性があると述べました。が鈍くなるにもほどがあります。パフォーマンスを向上させるためにトレーニング済みモデルを継続的に更新すると、機密データ、プライバシー、セキュリティに関する懸念が生じる可能性があります。生成型 AI の開発、利用、議論、規制に携わるすべての人は、信頼の低下、従業員の長期的な失業リスク、偏見と差別、データ プライバシー、知的財産の保護などのリスクの管理に取り組む必要があります。

Liu Zhiyi は Nandu とのインタビューで 3 つの見解を共有しました。同氏は、まずAI技術が国民経済や社会システムのさまざまな分野に当然入り込むことになるが、技術そのものがディープニューラルネットワークのようなブラックボックスであるため、リスクが拡大するだろうと述べ、技術やアルゴリズムの計算を通じて、AI技術を活用することはできないと述べた。人はそのすべての段階を知っていますが、それを達成する方法は不透明で説明できないため、リスクが伴います。第二に、AI テクノロジーはデジタル世界の創造に関連していることがよくあります。例えば、偽の音声や画像を含む高度な偽造は、物理的アイデンティティをデジタルアイデンティティに変えることであり、デジタル経済が発展すればするほど、これらの技術的サポートが必要になり、依存性が強くなりますが、それがもたらすリスクも大きくなります。第三に、我が国はアプリケーションシナリオとエコロジーを非常に重視しており、アプリケーションシナリオの実現には革新的なものでなければならず、必然的にリスクが伴うことになるが、シナリオの革新に伴ってリスクは拡大するため、先制的な監視が行われることになる。中国政府が発表した「生成型人工知能サービスの管理に関する措置(意見草案)」と科学技術省が発表した「科学技術の倫理ガバナンスの強化に関する意見」は、いずれも一部のリスクを先制的に考慮したものである。

『ビッグモデルの時代』の著者であり、アリババの元上級製品専門家および事業部門副本部長であり、シリコンバレーの AI スタートアップ企業の共同創設者兼最高執行責任者である Long Zhiyong 氏が、新しい講演会で講演しました。書籍発売記念式典。

大規模モデル アルゴリズムの信頼性と透明性に関する要件を提示する

「GPT の大規模モデルにとって、データプライバシーは確かに重要な問題です。」 Long Zhiyong 氏は Nandu とのインタビューで、OpenAI は最近、米国での問い合わせに対応する際に事前の準備を行ったと述べました。 ChatGPT のチャット記録をオフにする。個人的なオプションとして、ユーザーは大規模モデルがトレーニングに自分のプライベート データを使用することを拒否できます。企業顧客に対して、OpenAI はプライベートにデプロイされたモデルを提供し、企業が微調整されたトレーニング データが共有されることを心配することを回避します。これらの施策は国内大型モデルにも採用される可能性が高い。

大規模モデルの潜在的なバブルリスクにどのように対処するか、そして強力な規制と生成人工知能の開発との関係のバランスをどう取るかについて、Long Zhiyong 氏は、生成 AI は最初に標準化、その後開発というモデルに従うべきであると率直に述べました。 AI 生成製品に対する法的責任の主要な担い手として、大規模モデルのサービス プロバイダーは AIGC コンテンツの正確性と価値指向に責任を負い、そのコンプライアンス圧力は依然として相当なものです。これは強い規範です。」と「北京」紙で述べられています。促進 「汎用人工知能の革新的開発のためのいくつかの措置」という文書では、生成 AI が科学研究などの非公共サービス分野で積極的な応用を達成するよう奨励されるべきであり、人工知能の中核分野で試験的に導入されるべきであると述べられています。 「中関村は包括的かつ慎重な規制試験を実施する。これは規範と開発のバランスを取る前向きなシグナルだと思う」

同氏は、規制当局の考え方では大規模なアルゴリズムの信頼性と透明性の向上が必要であると述べました。 「ビッグモデルの時代」では、潜在的な業界バブルリスクについて警告が発せられ、重要な要素の1つはビッグモデルの信頼性と透明性でした。 OpenAI の首席科学者であるイリヤ氏は、大規模なモデルの錯覚と情報の改ざんが、さまざまな業界での GPT の適用を妨げる主な障害であると考えています。幻覚問題の根絶が難しい理由は、第一に大規模モデルの学習目的と手法にあり、第二に、深層学習時代以来の AI のブラックボックス属性が不透明で、モデル内の特定の問題を特定できないことが挙げられます。大型モデルの新機能の出現メカニズムも透明かつ予測不可能であることを考慮すると、大型モデル業界では制御不能の中での制御性の追求と規制の範囲内での開発を追求することが最大の課題となっている。

制作:ナンドゥビッグデータ研究所

研究者: ユアン・ジョンシアン

以上がビッグモデルの時代が到来!データセキュリティリスクにどう対処するか?小満耶 AI サミットの専門家からのヒントの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7496

7496

15

15

1377

1377

52

52

77

77

11

11

19

19

52

52

ビッグモデルアプリ Tencent Yuanbao がオンラインになりました! Hunyuan がアップグレードされ、どこにでも持ち運べるオールラウンドな AI アシスタントが作成されました

Jun 09, 2024 pm 10:38 PM

ビッグモデルアプリ Tencent Yuanbao がオンラインになりました! Hunyuan がアップグレードされ、どこにでも持ち運べるオールラウンドな AI アシスタントが作成されました

Jun 09, 2024 pm 10:38 PM

5月30日、TencentはHunyuanモデルの包括的なアップグレードを発表し、Hunyuanモデルに基づくアプリ「Tencent Yuanbao」が正式にリリースされ、AppleおよびAndroidアプリストアからダウンロードできるようになりました。前のテスト段階のフンユアン アプレット バージョンと比較して、Tencent Yuanbao は、日常生活シナリオ向けの AI 検索、AI サマリー、AI ライティングなどのコア機能を提供し、Yuanbao のゲームプレイもより豊富で、複数の機能を提供します。 、パーソナルエージェントの作成などの新しいゲームプレイ方法が追加されます。 Tencent Cloud 副社長で Tencent Hunyuan 大型モデルの責任者である Liu Yuhong 氏は、「テンセントは、最初に大型モデルを開発しようとはしません。」と述べました。 Tencent Hunyuan の大型モデルは、ビジネス シナリオにおける豊富で大規模なポーランド テクノロジーを活用しながら、ユーザーの真のニーズを洞察します。

Bytedance Beanbao 大型モデルがリリース、Volcano Engine フルスタック AI サービスが企業のインテリジェントな変革を支援

Jun 05, 2024 pm 07:59 PM

Bytedance Beanbao 大型モデルがリリース、Volcano Engine フルスタック AI サービスが企業のインテリジェントな変革を支援

Jun 05, 2024 pm 07:59 PM

Volcano Engine の社長である Tan Dai 氏は、大規模モデルを実装したい企業は、モデルの有効性、推論コスト、実装の難易度という 3 つの重要な課題に直面していると述べました。複雑な問題を解決するためのサポートとして、適切な基本的な大規模モデルが必要です。また、サービスは低コストの推論を備えているため、大規模なモデルを広く使用できるようになり、企業がシナリオを実装できるようにするためには、より多くのツール、プラットフォーム、アプリケーションが必要になります。 ——Huoshan Engine 01 社長、Tan Dai 氏。大きなビーンバッグ モデルがデビューし、頻繁に使用されています。モデル効果を磨き上げることは、AI の実装における最も重要な課題です。 Tan Dai 氏は、良いモデルは大量に使用することでのみ磨かれると指摘しました。現在、Doubao モデルは毎日 1,200 億トークンのテキストを処理し、3,000 万枚の画像を生成しています。企業による大規模モデルシナリオの実装を支援するために、バイトダンスが独自に開発した豆包大規模モデルが火山を通じて打ち上げられます。

Shengteng AI テクノロジーを使用した秦嶺・秦川交通モデルは、西安のスマート交通イノベーション センターの構築を支援します

Oct 15, 2023 am 08:17 AM

Shengteng AI テクノロジーを使用した秦嶺・秦川交通モデルは、西安のスマート交通イノベーション センターの構築を支援します

Oct 15, 2023 am 08:17 AM

「高度な複雑性、高度な断片化、およびクロスドメイン」は、輸送業界のデジタル化およびインテリジェントなアップグレードに向かう上で常に主要な問題点でした。最近、チャイナビジョン、西安雁塔区政府、西安未来人工知能コンピューティングセンターが共同で構築したパラメータースケール1000億の「秦嶺・秦川交通モデル」は、スマート交通・交通分野を指向している。西安とその周辺地域にサービスを提供しており、この地域はスマート交通イノベーションの拠点となるでしょう。 「秦嶺・秦川交通モデル」は、オープンシナリオにおける西安の膨大な地元交通生態データ、中国科学ビジョンが自社開発したオリジナルの高度なアルゴリズム、そして西安未来人工知能コンピューティングセンターのShengteng AIの強力なコンピューティング能力を組み合わせたものです。道路網の監視を提供するため、緊急指令、メンテナンス管理、公共交通機関などのスマートな交通シナリオは、デジタルでインテリジェントな変化をもたらします。交通管理には都市ごとに異なる特徴があり、道路の交通状況も異なります。

NVIDIA の大規模モデル推論フレームワークを明らかにする: TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

NVIDIA の大規模モデル推論フレームワークを明らかにする: TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

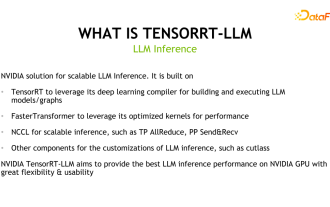

1. TensorRT-LLM の製品位置付け TensorRT-LLM は、NVIDIA が開発した大規模言語モデル (LLM) 向けのスケーラブルな推論ソリューションです。 TensorRT 深層学習コンパイル フレームワークに基づいて計算グラフを構築、コンパイル、実行し、FastTransformer の効率的なカーネル実装を利用します。さらに、デバイス間の通信には NCCL を利用します。開発者は、カットラスに基づいてカスタマイズされた GEMM を開発するなど、技術開発や需要の違いに基づいて特定のニーズを満たすためにオペレーターをカスタマイズできます。 TensorRT-LLM は、NVIDIA の公式推論ソリューションであり、高いパフォーマンスを提供し、実用性を継続的に向上させることに尽力しています。 TensorRT-LL

GPT-4をベンチマーク!中国移動の九天大型モデルが二重登録を通過

Apr 04, 2024 am 09:31 AM

GPT-4をベンチマーク!中国移動の九天大型モデルが二重登録を通過

Apr 04, 2024 am 09:31 AM

4月4日のニュースによると、中国サイバースペース局は最近、登録された大型モデルのリストを発表し、その中にチャイナモバイルの「九天自然言語インタラクション大型モデル」が含まれており、チャイナモバイルの九天AI大型モデルが生成人工言語を正式に提供できることを示した。外部世界への諜報機関。チャイナモバイルは、これは中央企業が開発した初めての大規模モデルであり、国家の「生成人工知能サービス登録」と「国内深層合成サービスアルゴリズム登録」の二重登録を通過したと述べた。報告によると、Juiutian の自然言語インタラクション大規模モデルは、強化された業界能力、セキュリティ、信頼性の特徴を持ち、フルスタック ローカリゼーションをサポートしており、90 億、139 億、570 億、1000 億などのさまざまなパラメータ バージョンを形成しており、クラウド、エッジ、エンドでは状況が異なりますが、柔軟に導入できます。

産業ナレッジグラフの高度な実践

Jun 13, 2024 am 11:59 AM

産業ナレッジグラフの高度な実践

Jun 13, 2024 am 11:59 AM

1. 背景の紹介 まず、Yunwen Technology の開発の歴史を紹介します。 Yunwen Technology Company ...2023 年は大規模モデルが普及する時期であり、多くの企業は大規模モデルの後、グラフの重要性が大幅に低下し、以前に検討されたプリセット情報システムはもはや重要ではないと考えています。しかし、RAG の推進とデータ ガバナンスの普及により、より効率的なデータ ガバナンスと高品質のデータが民営化された大規模モデルの有効性を向上させるための重要な前提条件であることがわかり、ますます多くの企業が注目し始めています。知識構築関連コンテンツへ。これにより、知識の構築と処理がより高いレベルに促進され、探索できる技術や方法が数多く存在します。新しいテクノロジーの出現によってすべての古いテクノロジーが打ち破られるわけではなく、新旧のテクノロジーが統合される可能性があることがわかります。

新しいテストベンチマークがリリース、最も強力なオープンソースのLlama 3が困惑

Apr 23, 2024 pm 12:13 PM

新しいテストベンチマークがリリース、最も強力なオープンソースのLlama 3が困惑

Apr 23, 2024 pm 12:13 PM

テストの問題が簡単すぎると、上位の生徒も下位の生徒も 90 点を獲得でき、その差は広がりません。Claude3、Llama3、さらには GPT-5 などのより強力なモデルが後にリリースされるため、業界はより困難で差別化されたモデルのベンチマークが緊急に必要です。大型モデルアリーナの背後にある組織 LMSYS は、次世代ベンチマーク Arena-Hard を発表し、広く注目を集めました。 Llama3 命令の 2 つの微調整されたバージョンの強度に関する最新のリファレンスもあります。全員が同様のスコアを持っていた以前の MTBench と比較すると、アリーナとハードの識別は 22.6% から 87.4% に増加し、一目で強くも弱くもなりました。 Arena-Hard は、アリーナからのリアルタイムの人間データを使用して構築されており、人間の好みとの一致率は 89.1% です。

Xiaomi Byteが力を合わせます! Xiao Ai の Doubao へのアクセスの大規模モデル: 携帯電話と SU7 にすでにインストールされています

Jun 13, 2024 pm 05:11 PM

Xiaomi Byteが力を合わせます! Xiao Ai の Doubao へのアクセスの大規模モデル: 携帯電話と SU7 にすでにインストールされています

Jun 13, 2024 pm 05:11 PM

6月13日のニュースによると、Byteの「Volcano Engine」公開アカウントによると、Xiaomiの人工知能アシスタント「Xiao Ai」はVolcano Engineとの協力に達し、両社はbeanbao大型モデルに基づいて、よりインテリジェントなAIインタラクティブ体験を実現するとのこと。 。 ByteDance が作成した大規模な豆包モデルは、毎日最大 1,200 億のテキスト トークンを効率的に処理し、3,000 万個のコンテンツを生成できると報告されています。 Xiaomi は、Doubao 大型モデルを使用して、独自モデルの学習能力と推論能力を向上させ、ユーザーのニーズをより正確に把握するだけでなく、より速い応答速度とより包括的なコンテンツ サービスを提供する新しい「Xiao Ai Classmate」を作成しました。たとえば、ユーザーが複雑な科学的概念について質問する場合、&ldq