「ChatGPT詐欺」を特定、その効果はOpenAIを超える:北京大学とファーウェイのAI生成検出器が登場

大規模な生成モデルの継続的な進歩により、生成されるコーパスは徐々に人間のそれに近づきつつあります。大型モデルは無数の店員の手を解放していますが、本物を偽造するその強力な能力は一部の犯罪者にも利用され、一連の社会問題を引き起こしています。

論文アドレス: https://arxiv.org/abs/2305.18149

- コード アドレス (MindSpore): https://github.com/mindspore-lab/mindone/tree/master/examples/detect_chatgpt

- コード アドレス (PyTorch) :https://github.com/YuchuanTian/AIGC_text_detector

- ##はじめにWith As大規模な言語モデルの生成効果がますます現実的になる中、さまざまな業界が信頼性の高い AI 生成のテキスト検出器を緊急に必要としています。ただし、コーパス検出に対する要件は業界によって異なります。たとえば、学術界では一般に、大規模で完全な学術文書を検出する必要がありますが、ソーシャル プラットフォームでは、比較的短く断片的なフェイク ニュースを検出する必要があります。しかし、既存の検出器ではさまざまなニーズに対応できないことがよくあります。たとえば、一部の主流の AI テキスト検出器は、一般に、短いコーパスに対する予測機能が不十分です。

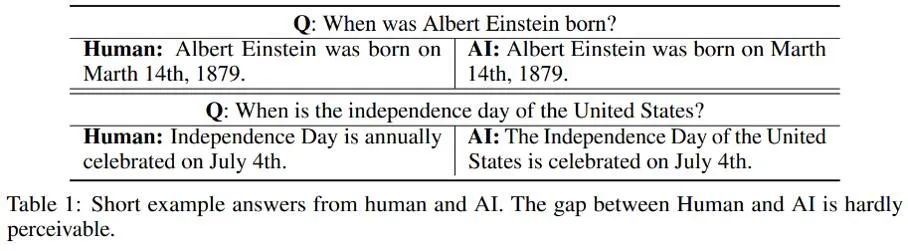

これらの例から、次のことがわかります。 AIによって生成された短答を識別することは非常に困難です。この種のコーパスは人間との差が小さすぎて、その真の属性を厳密に判断することが困難です。したがって、単純に短いテキストに人間/AI として注釈を付け、テキスト検出のための従来の二値分類問題に従うことは不適切です。

この問題に対処するために、この研究では人間と AI の二項分類検出部分を部分的な PU (Positive-Unlabeled) 学習問題、つまり短い文で言えば人間の言語に変換します。はポジティブクラス (Positive) であり、機械語はラベルなしクラス (Unlabeled) であるため、トレーニング損失関数が改善されます。この改善により、さまざまな身体に対する検出器の分類パフォーマンスが大幅に向上しました。

この問題に対処するために、この研究では人間と AI の二項分類検出部分を部分的な PU (Positive-Unlabeled) 学習問題、つまり短い文で言えば人間の言語に変換します。はポジティブクラス (Positive) であり、機械語はラベルなしクラス (Unlabeled) であるため、トレーニング損失関数が改善されます。この改善により、さまざまな身体に対する検出器の分類パフォーマンスが大幅に向上しました。

アルゴリズムの詳細

従来の PU 学習設定では、2 分類モデルはポジティブ トレーニング サンプルとラベルなしトレーニング サンプルに基づいてのみ学習できます。一般的に使用される PU 学習方法は、PU 損失を定式化することで、負のサンプルに対応するバイナリ分類損失を推定することです。このうち、 は陽性サンプルと陽性ラベルによって計算された二値分類損失を表し、

は陽性サンプルと陽性ラベルによって計算された二値分類損失を表し、 はすべてのラベルなしサンプルを仮定して計算された損失を表します。二項分類損失;

はすべてのラベルなしサンプルを仮定して計算された損失を表します。二項分類損失;  は、陽性サンプルが陰性ラベルであると仮定して計算された二項分類損失を表します;

は、陽性サンプルが陰性ラベルであると仮定して計算された二項分類損失を表します;  は、前の陽性サンプルの確率を表します。つまり、陽性サンプルはすべての PU サンプルの推定シェアに含まれます。従来の PU 学習では、通常、前の

は、前の陽性サンプルの確率を表します。つまり、陽性サンプルはすべての PU サンプルの推定シェアに含まれます。従来の PU 学習では、通常、前の  は固定のハイパーパラメータに設定されます。ただし、テキスト検出シナリオでは、検出器はさまざまな長さのさまざまなテキストを処理する必要があり、さまざまな長さのテキストの場合、サンプルと同じ長さのすべての PU サンプル間の陽性サンプルの推定割合も異なります。したがって、この研究では PU 損失を改善し、長さに敏感なマルチスケール PU (MPU) 損失関数を提案します。

は固定のハイパーパラメータに設定されます。ただし、テキスト検出シナリオでは、検出器はさまざまな長さのさまざまなテキストを処理する必要があり、さまざまな長さのテキストの場合、サンプルと同じ長さのすべての PU サンプル間の陽性サンプルの推定割合も異なります。したがって、この研究では PU 損失を改善し、長さに敏感なマルチスケール PU (MPU) 損失関数を提案します。

具体的には、この研究では、短いテキストの検出をモデル化するための抽象サイクル モデルを提案します。従来の NLP モデルがシーケンスを処理する場合、通常は RNN、LSTM などのマルコフ連鎖構造を持ちます。このタイプの循環モデルのプロセスは、通常、徐々に反復的なプロセスとして理解できます。つまり、各トークン出力の予測は、前のトークンと前のシーケンスの予測結果を、このトークンの予測結果と変換およびマージすることによって取得されます。トークン。つまり、次のプロセスです。

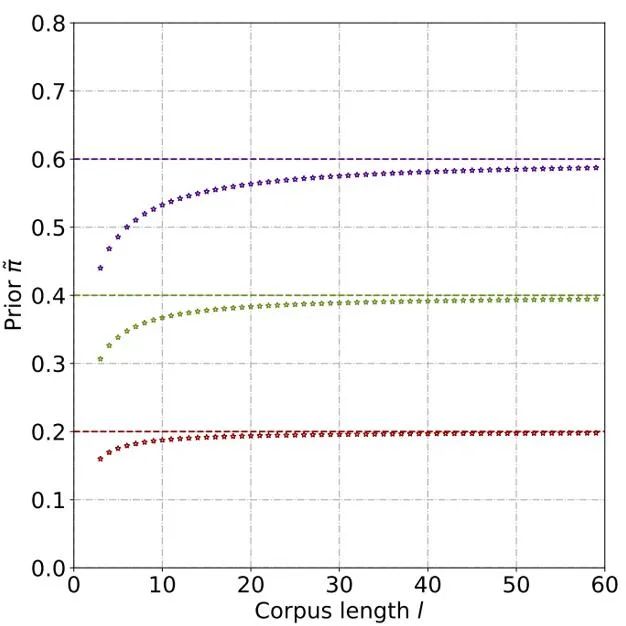

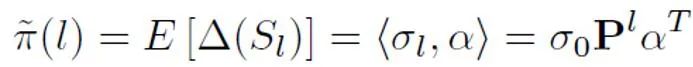

この抽象モデルに基づいて事前確率を推定するには、次の出力を仮定する必要があります。モデルは、特定の文が肯定的であるということです。クラスの信頼度 (肯定的) は、サンプルがその人によって話されていると判断される確率です。各トークンの寄与サイズは文トークンの長さの反比例であり、それは正、つまりラベルなしであり、ラベルなしの確率は正である確率よりもはるかに大きいと想定されます。なぜなら、大規模モデルの語彙が徐々に人間の語彙に近づくにつれて、ほとんどの単語が AI と人間のコーパスの両方に出現するようになるからです。この単純化されたモデルと設定された正のトークン確率に基づいて、さまざまな入力条件下でのモデル出力の信頼度の合計期待値を見つけることによって、最終的な事前推定値が取得されます。

#理論的な導出と実験を通じて、テキストの長さが増加するにつれて事前確率が増加すると推定されます。最終的には安定します。テキストが長くなると、検出器がより多くの情報を捕捉できるようになり、テキストの「ソースの不確実性」が徐々に弱くなるため、この現象も予想されます。

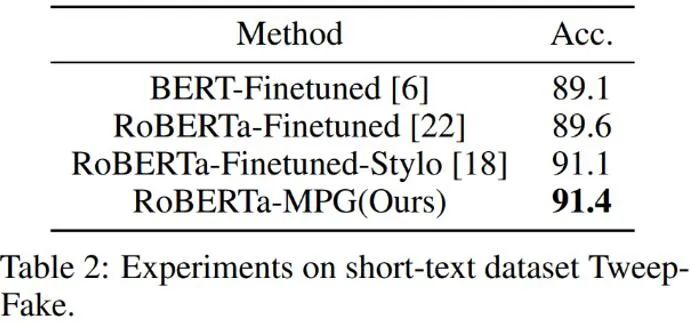

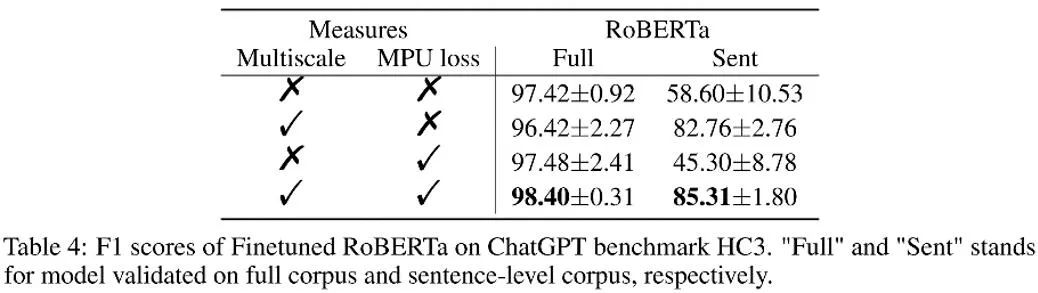

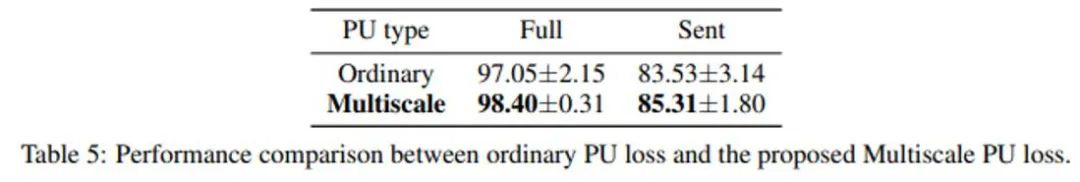

その後、陽性サンプルごとに、サンプル長から取得した一意の事前分布に基づいて PU 損失が計算されます。最後に、短いテキストにはある程度の「不確実性」しかないため (つまり、短いテキストには一部の人物または AI のテキスト特徴も含まれる)、バイナリ損失と MPU 損失に重みを付けて、最終的な最適化目標として追加できます。 # ################################## さらに、MPU 損失はさまざまな長さのトレーニング コーパスに適応することに注意してください。既存の学習データが明らかに同種であり、コーパスの大部分が長大なテキストで構成されている場合には、MPU 手法の効果を十分に発揮できません。トレーニングコーパスの長さをより多様にするために、この研究では文レベルでのマルチスケーリングモジュールも導入しています。このモジュールは、トレーニング コーパス内のいくつかの文をランダムにカバーし、元の順序を維持したまま残りの文を再編成します。トレーニング コーパスのマルチスケール操作後、トレーニング テキストの長さが大幅に強化され、AI テキスト検出器のトレーニングに PU 学習が最大限に活用されています。 #上の表に示すように、著者はまず AI が生成した短いコーパス データでテストしました。 set Tweep-Fake MPU 損失の影響。このデータセットのコーパスはすべて Twitter 上の比較的短いセグメントです。また、著者は、従来の 2 つのカテゴリの損失を、従来の言語モデルの微調整に基づいた MPU 損失を含む最適化目標に置き換えます。改良された言語モデル検出器はより効果的で、他のベースライン アルゴリズムを上回ります。

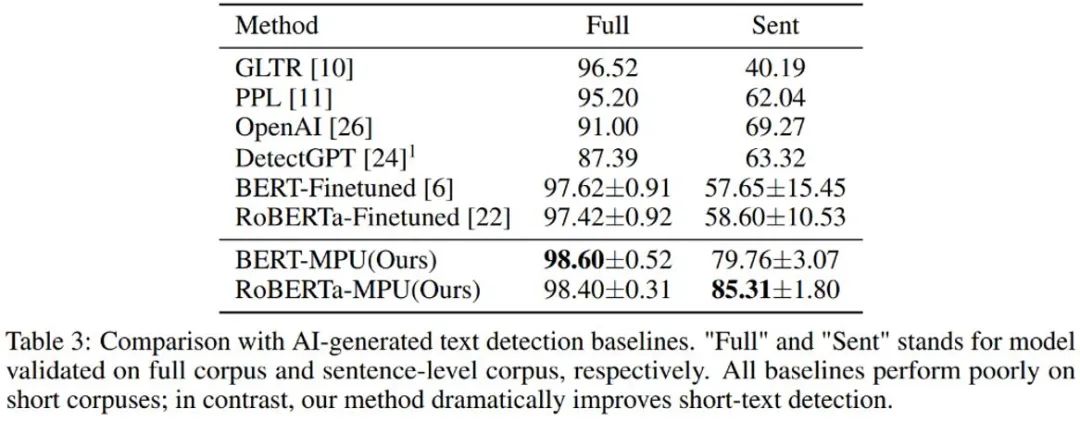

著者は、chatGPT によって生成されたテキストもテストしました。従来の微調整後に得られた言語モデル検出器の方が優れています。短い文のパフォーマンスは悪いですが、同じ条件下で MPU メソッドでトレーニングされた検出器は、短い文では良好なパフォーマンスを示しますが、同時に完全なコーパスに対して大幅な効果の向上を達成できます。F1 スコアは 1% 増加し、 OpenAI と DetectGPT、SOTA アルゴリズム。

要約

著者は、AIGC 生成モデルの普及に伴い、マルチスケール PU 学習に基づくソリューションを提案することで、テキスト検出器による短文認識の問題を解決しました。将来的には、この種のコンテンツの検出がますます重要になるでしょう。この研究は、AI テキスト検出の問題において確実な一歩を踏み出したものであり、AIGC コンテンツをより適切に制御し、AI によって生成されたコンテンツの悪用を防止するために、今後さらに同様の研究が行われることが期待されています。以上が「ChatGPT詐欺」を特定、その効果はOpenAIを超える:北京大学とファーウェイのAI生成検出器が登場の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7690

7690

15

15

1639

1639

14

14

1393

1393

52

52

1287

1287

25

25

1229

1229

29

29

Web3トレーディングプラットフォームranking_web3グローバル交換トップ10の概要

Apr 21, 2025 am 10:45 AM

Web3トレーディングプラットフォームranking_web3グローバル交換トップ10の概要

Apr 21, 2025 am 10:45 AM

Binanceは、グローバルデジタルアセット取引エコシステムの大君主であり、その特性には次のものが含まれます。1。1日の平均取引量は1,500億ドルを超え、500の取引ペアをサポートし、主流の通貨の98%をカバーしています。 2。イノベーションマトリックスは、デリバティブ市場、Web3レイアウト、教育システムをカバーしています。 3.技術的な利点は、1秒あたり140万のトランザクションのピーク処理量を伴うミリ秒のマッチングエンジンです。 4.コンプライアンスの進捗状況は、15か国のライセンスを保持し、ヨーロッパと米国で準拠した事業体を確立します。

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)は、独自の生体認証とプライバシー保護メカニズムを備えた暗号通貨市場で際立っており、多くの投資家の注目を集めています。 WLDは、特にOpenai人工知能技術と組み合わせて、革新的なテクノロジーを備えたAltcoinsの間で驚くほど演奏しています。しかし、デジタル資産は今後数年間でどのように振る舞いますか? WLDの将来の価格を一緒に予測しましょう。 2025年のWLD価格予測は、2025年にWLDで大幅に増加すると予想されています。市場分析は、平均WLD価格が1.31ドルに達する可能性があり、最大1.36ドルであることを示しています。ただし、クマ市場では、価格は約0.55ドルに低下する可能性があります。この成長の期待は、主にWorldCoin2によるものです。

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションをサポートする交換:1。Binance、2。Uniswap、3。Sushiswap、4。CurveFinance、5。Thorchain、6。1inchExchange、7。DLNTrade、これらのプラットフォームはさまざまな技術を通じてマルチチェーン資産トランザクションをサポートします。

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

仮想通貨価格の上昇の要因には、次のものが含まれます。1。市場需要の増加、2。供給の減少、3。刺激された肯定的なニュース、4。楽観的な市場感情、5。マクロ経済環境。衰退要因は次のとおりです。1。市場需要の減少、2。供給の増加、3。ネガティブニュースのストライキ、4。悲観的市場感情、5。マクロ経済環境。

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

暗号通貨の賑やかな世界では、新しい機会が常に現れます。現在、Kerneldao(Kernel)Airdropアクティビティは多くの注目を集め、多くの投資家の注目を集めています。それで、このプロジェクトの起源は何ですか? BNBホルダーはそれからどのような利点を得ることができますか?心配しないでください、以下はあなたのためにそれを一つ一つ明らかにします。

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Aavedaoの定足数を実装したToken Reposを導入する提案です。 Aave Project Chain(ACI)の創設者であるMarc Zellerは、これをXで発表し、契約の新しい時代をマークしていることに注目しました。 Aave Chain Initiative(ACI)の創設者であるMarc Zellerは、Aavenomicsの提案にAave Protocolトークンの変更とトークンリポジトリの導入が含まれていると発表しました。 Zellerによると、これは契約の新しい時代を告げています。 Aavedaoのメンバーは、水曜日の週に100でした。

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

2025年のレバレッジド取引、セキュリティ、ユーザーエクスペリエンスで優れたパフォーマンスを持つプラットフォームは次のとおりです。1。OKX、高周波トレーダーに適しており、最大100倍のレバレッジを提供します。 2。世界中の多通貨トレーダーに適したバイナンス、125倍の高いレバレッジを提供します。 3。Gate.io、プロのデリバティブプレーヤーに適し、100倍のレバレッジを提供します。 4。ビットゲットは、初心者やソーシャルトレーダーに適しており、最大100倍のレバレッジを提供します。 5。Kraken、安定した投資家に適しており、5倍のレバレッジを提供します。 6。Altcoinエクスプローラーに適したBybit。20倍のレバレッジを提供します。 7。低コストのトレーダーに適したKucoinは、10倍のレバレッジを提供します。 8。ビットフィネックス、シニアプレイに適しています

1つの記事を理解する:Binance Kernel Airdropプロセス

Apr 21, 2025 pm 01:09 PM

1つの記事を理解する:Binance Kernel Airdropプロセス

Apr 21, 2025 pm 01:09 PM

暗号通貨の世界では、新しい機会が常に現れます。最近、Binanceによって開始されたKerneldao(Kernel)Megadropプロジェクトは、広範囲にわたる注目を集めています。このプロジェクトは、投資家に新しい投資オプションをもたらすだけでなく、BNB保有者に独自の利点を提供します。それで、カーネルダオとは正確には何ですか?このエアドロップはどのように実行されますか? 1つの記事で理解しましょう。