テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

AI大手がホワイトハウスに書類を提出:Google、OpenAI、オックスフォードなどを含む12のトップ機関が共同で「モデルセキュリティ評価フレームワーク」を発表

AI大手がホワイトハウスに書類を提出:Google、OpenAI、オックスフォードなどを含む12のトップ機関が共同で「モデルセキュリティ評価フレームワーク」を発表

AI大手がホワイトハウスに書類を提出:Google、OpenAI、オックスフォードなどを含む12のトップ機関が共同で「モデルセキュリティ評価フレームワーク」を発表

5月初旬、ホワイトハウスはGoogle、Microsoft、OpenAI、Anthropic、その他のAI企業のCEOらと会合を開き、AI生成技術の爆発的普及、技術の背後に隠れたリスク、開発方法について話し合った。責任を持って人工知能システムを開発し、効果的な規制措置を開発します。

既存のセキュリティ評価プロセスは通常、一連の評価ベンチマークに依存して、AI システムの異常な動作(誤解を招くような動作)を特定します。発言、偏った意思決定、著作権で保護されたコンテンツの輸出。

AI テクノロジーがますます強力になるにつれて、操作、欺瞞、またはその他の高リスク機能を備えた AI システムの開発を防ぐために、対応するモデル評価ツールもアップグレードする必要があります。

最近、Google DeepMind、ケンブリッジ大学、オックスフォード大学、トロント大学、モントリオール大学、OpenAI、Anthropic、その他多くのトップ大学や研究機関が共同で、評価ツールをリリースしました。モデルのセキュリティ: このフレームワークは、将来の人工知能モデルの開発と展開における重要なコンポーネントになることが期待されています。

紙のリンク: https://arxiv.org/pdf/2305.15324.pdf

# 汎用 AI システムの開発者は、トレーニング、展開、リスクの特性評価などのプロセスをより責任を持って実行できるように、モデルのハザード機能と調整を評価し、極度のリスクをできるだけ早く特定する必要があります。

AI にはリスクがあり、トレーニングには注意が必要です

一般的なモデルでは、通常、特定の能力や行動を学習するために「トレーニング」が必要ですが、既存の学習プロセスは通常不完全です。たとえば、以前の研究で、DeepMind の研究者は、トレーニング中にモデルの予期された動作が正しく報われたとしても、人工知能システムは依然としていくつかの意図しない目標を学習することを発見しました。

責任ある AI 開発者は、起こり得る将来の展開や未知のリスクを事前に予測できなければなりません。AI システムが進歩するにつれて、将来の一般的なモデルは、さまざまな危険を学習する能力をデフォルトで学習する可能性があります。

たとえば、人工知能システムは、クラウド コンピューティング上で攻撃的なサイバー操作を実行したり、会話で人間を巧妙に欺いたり、人間を操作して有害な行為を実行したり、武器を設計または入手したりする可能性があります。プラットフォームは、他の高リスク AI システムを微調整して操作したり、人間がこれらの危険なタスクを完了するのを支援したりします。

そのようなモデルに悪意のあるアクセスを持つ誰かが AI の機能を悪用したり、調整の失敗により、AI モデルが人間の指導なしに自ら有害な行動を取ることを選択したりする可能性があります。 。

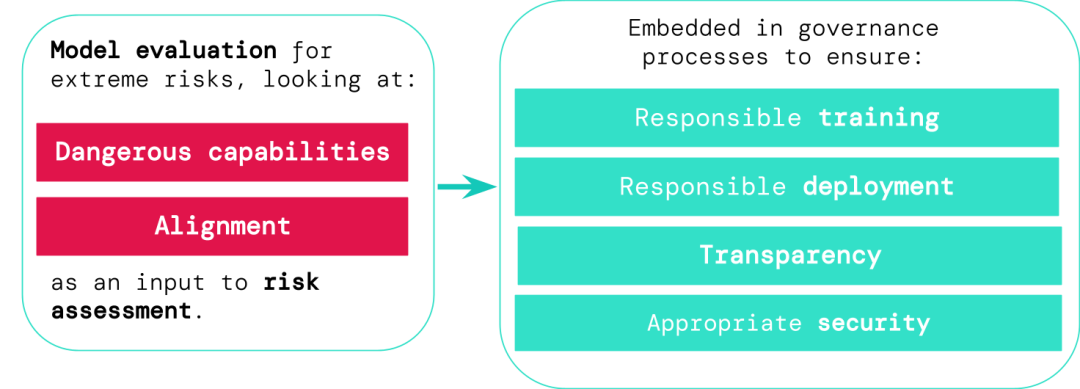

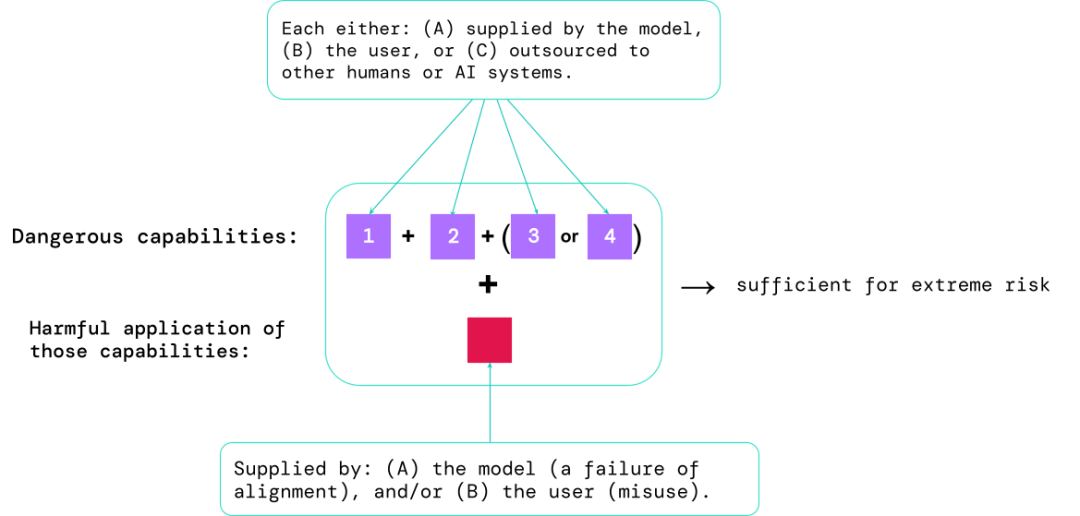

# モデル評価は、これらのリスクを事前に特定するのに役立ちます。この記事で提案されているフレームワークに従って、AI 開発者はモデル評価を使用して次のことを発見できます。 #1. モデルが、セキュリティを脅かしたり、影響力を及ぼしたり、規制を回避したりするために使用できる特定の「危険な機能」をどの程度備えているか。

2.モデルはその機能を適用する傾向があり、損傷を引き起こします (つまり、モデルの位置合わせ)。キャリブレーション評価では、モデルが非常に広範囲のシナリオ設定の下で期待どおりに動作することを確認し、可能であればモデルの内部動作を検査する必要があります。

最もリスクの高いシナリオには、危険な機能の組み合わせが含まれることが多く、評価の結果は、AI 開発者が極度のリスクを引き起こす十分な要素があるかどうかを理解するのに役立ちます。

経験的な観点から、人工知能システムの機能構成が極度のリスクを引き起こすのに十分である場合、およびシステムが悪用されるか、効果的に調整されない可能性があると想定します。 、そして人工知能 コミュニティはこれを非常に危険なシステムとして扱うべきです。

このようなシステムを現実の世界に展開するには、開発者は標準をはるかに超えるセキュリティ標準を設定する必要があります。

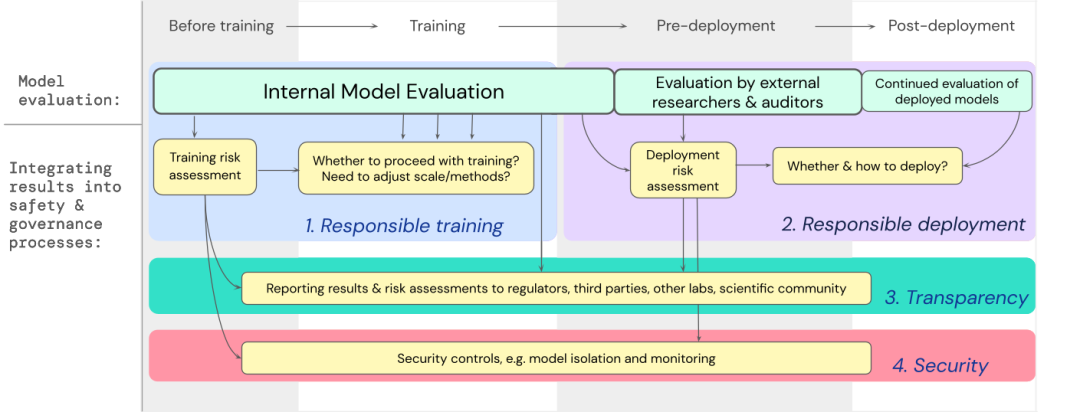

モデル評価は AI ガバナンスの基礎です

どのモデルがリスクにさらされているかを特定するためのより優れたツールがあれば、企業や規制当局は次のことをより確実に行うことができます。1. 責任あるトレーニング: リスクの初期兆候を示す新しいモデルをトレーニングするかどうか、またどのようにトレーニングするか。

2. 責任ある導入: 潜在的にリスクのあるモデルを導入するかどうか、いつ、どのように導入するか。

3. 透明性: 潜在的なリスクに備え、または軽減するために、有益で実用的な情報を利害関係者に報告します。

4. 適切なセキュリティ: 極度のリスクを引き起こす可能性のあるモデルには、強力な情報セキュリティ管理とシステムを適用する必要があります。

私たちは、高機能の一般モデルのトレーニングと展開に関する重要な決定に、極度のリスクのモデル評価を組み込む方法の青写真を開発しました。

開発者はプロセス全体を通じて評価を実施し、詳細な評価を実施するために外部のセキュリティ研究者やモデル監査人に構造化モデルへのアクセスを許可する必要があります。

評価結果は、モデルのトレーニングと展開の前にリスク評価を知らせることができます。

極度のリスクに対する評価の構築

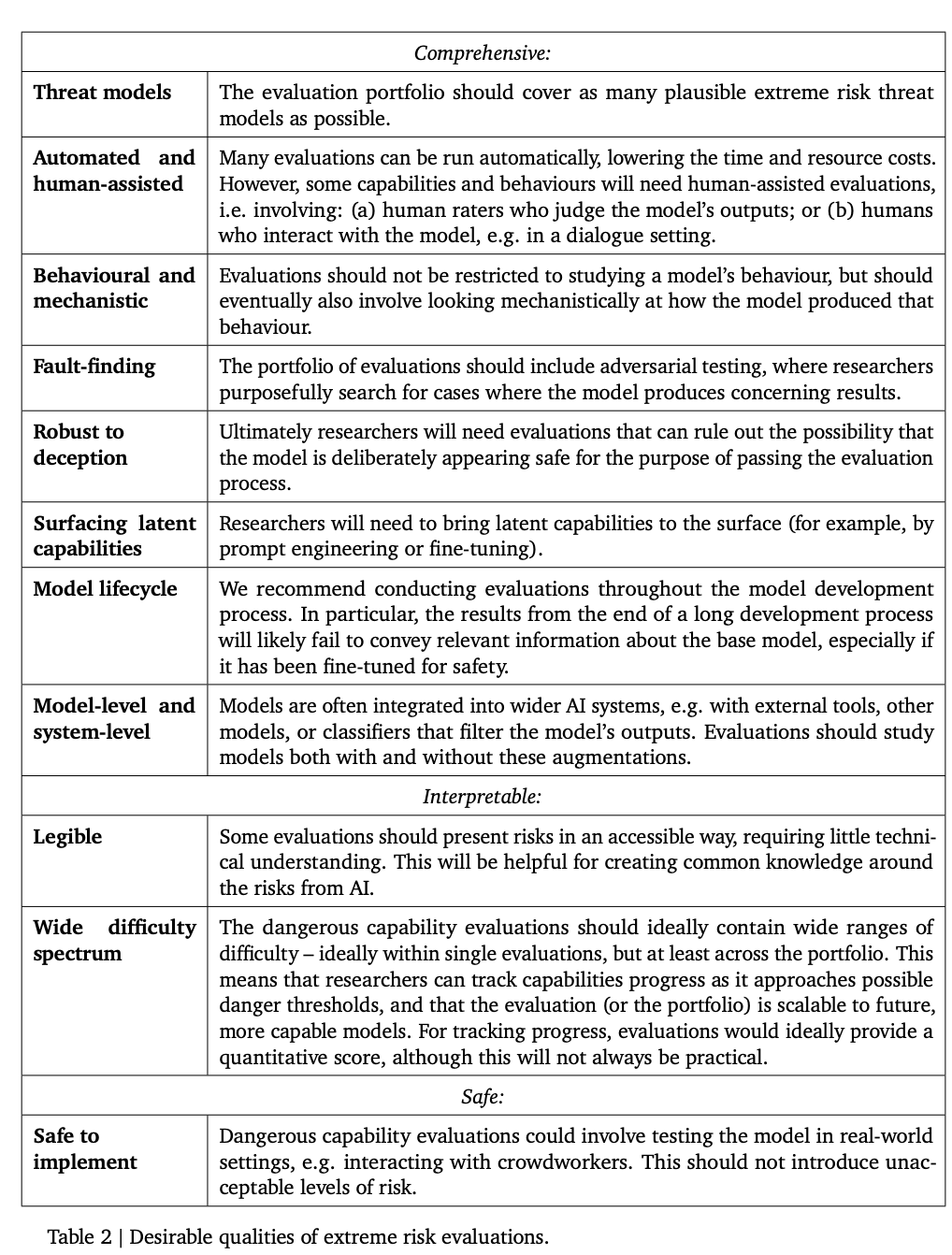

次の表に、モデルに必要な理想的なプロパティをいくつか示します。

研究者らは、アライメントの包括的な評価を確立することは難しいと考えているため、現在の目標はアライメントを確立するプロセスです。モデルにリスクがあるかどうかを高い信頼度で評価するための調整。

研究者らは、アライメントの包括的な評価を確立することは難しいと考えているため、現在の目標はアライメントを確立するプロセスです。モデルにリスクがあるかどうかを高い信頼度で評価するための調整。

アライメント評価は、モデルがさまざまな環境で適切な動作を確実に示すことを確認する必要があるため、非常に困難です。そのため、モデルを幅広いテスト環境でテストする必要があります。 . より広い環境範囲を達成するために評価を実施します。具体的には:

1. 幅: できるだけ多くの環境でモデルの動作を評価する 有望な方法は、人工知能システムを使用して評価を自動的に記述することです。

2. ターゲット設定: 一部の環境は他の環境よりも失敗する可能性が高く、これはハニーポットや勾配ベースの敵対的テストの使用など、賢明な設計によって達成できる可能性があります。

3. 一般化の理解: 研究者は考えられるすべての状況を予測したりシミュレーションしたりすることはできないため、モデルの動作がさまざまな状況でどのように、そしてなぜ一般化する (または一般化できない) のかについて理解を定式化する必要があります。

もう 1 つの重要なツールは機械論的分析です。これは、モデルの機能を理解するためにモデルの重みとアクティベーションを研究します。

モデル評価の未来

プロセス全体が、複雑な社会的、政治的、経済的など、モデル開発以外の影響要因に大きく依存しているため、モデル評価は万能ではありません。部隊はいくつかのリスクを見逃す可能性がある。

モデル評価は他のリスク評価ツールと統合され、業界、政府、市民社会全体でより広範にセキュリティ意識を促進する必要があります。

Google は最近、「Responsible AI」ブログで、人工知能の開発を標準化するには、個人の実践、共有の業界標準、健全なポリシーが重要であると指摘しました。

研究者は、モデル内のリスクの出現を追跡し、関連する結果に適切に対応するプロセスが、人工知能機能の最前線で活動する責任ある開発者にとって重要な部分であると信じています。 . .

以上がAI大手がホワイトハウスに書類を提出:Google、OpenAI、オックスフォードなどを含む12のトップ機関が共同で「モデルセキュリティ評価フレームワーク」を発表の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1652

1652

14

14

1413

1413

52

52

1304

1304

25

25

1251

1251

29

29

1224

1224

24

24

推奨される信頼できるデジタル通貨取引プラットフォーム。世界のトップ10のデジタル通貨交換。 2025

Apr 28, 2025 pm 04:30 PM

推奨される信頼できるデジタル通貨取引プラットフォーム。世界のトップ10のデジタル通貨交換。 2025

Apr 28, 2025 pm 04:30 PM

推奨される信頼できるデジタル通貨取引プラットフォーム:1。OKX、2。Binance、3。Coinbase、4。Kraken、5。Huobi、6。Kucoin、7。Bitfinex、8。Gemini、9。Bitstamp、10。Poloniex、これらのプラットフォームは、セキュリティ、ユーザーエクスペリエンス、ユーザーエクスペリエンス、ユーザーエクスペリエンス、ユーザーエクスペリエンスのデジタルエクスペリエンス、デジタルエクスペリエンスのデジタルエクスペリエンス、デジタルエクスペリエンスのために知られています。

世界のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの最新バージョンです

Apr 28, 2025 pm 08:09 PM

世界のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの最新バージョンです

Apr 28, 2025 pm 08:09 PM

世界の上位10の暗号通貨取引プラットフォームには、Binance、Okx、Gate.io、Coinbase、Kraken、Huobi Global、Bitfinex、Bittrex、Kucoin、Poloniexが含まれます。これらはすべて、さまざまな取引方法と強力なセキュリティ対策を提供します。

トップ10の仮想通貨取引アプリは何ですか?最新のデジタル通貨交換ランキング

Apr 28, 2025 pm 08:03 PM

トップ10の仮想通貨取引アプリは何ですか?最新のデジタル通貨交換ランキング

Apr 28, 2025 pm 08:03 PM

Binance、OKX、Gate.ioなどの上位10のデジタル通貨交換は、システムを改善し、効率的な多様化したトランザクション、厳格なセキュリティ対策を改善しました。

トップ通貨取引プラットフォームは何ですか?トップ10の最新の仮想通貨交換

Apr 28, 2025 pm 08:06 PM

トップ通貨取引プラットフォームは何ですか?トップ10の最新の仮想通貨交換

Apr 28, 2025 pm 08:06 PM

現在、上位10の仮想通貨交換にランクされています。1。Binance、2。Okx、3。Gate.io、4。CoinLibrary、5。Siren、6。HuobiGlobal Station、7。Bybit、8。Kucoin、9。Bitcoin、10。BitStamp。

2025年のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの1つです

Apr 28, 2025 pm 08:12 PM

2025年のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの1つです

Apr 28, 2025 pm 08:12 PM

2025年の世界の上位10の暗号通貨取引所には、Binance、Okx、Gate.io、Coinbase、Kraken、Huobi、Bitfinex、Kucoin、Bittrex、Poloniexが含まれます。これらはすべて、高い取引量とセキュリティで知られています。

Cのスレッドパフォーマンスを測定する方法は?

Apr 28, 2025 pm 10:21 PM

Cのスレッドパフォーマンスを測定する方法は?

Apr 28, 2025 pm 10:21 PM

Cのスレッドパフォーマンスの測定は、標準ライブラリのタイミングツール、パフォーマンス分析ツール、およびカスタムタイマーを使用できます。 1.ライブラリを使用して、実行時間を測定します。 2。パフォーマンス分析にはGPROFを使用します。手順には、コンピレーション中に-pgオプションを追加し、プログラムを実行してGmon.outファイルを生成し、パフォーマンスレポートの生成が含まれます。 3. ValgrindのCallGrindモジュールを使用して、より詳細な分析を実行します。手順には、プログラムを実行してCallGrind.outファイルを生成し、Kcachegrindを使用して結果を表示することが含まれます。 4.カスタムタイマーは、特定のコードセグメントの実行時間を柔軟に測定できます。これらの方法は、スレッドのパフォーマンスを完全に理解し、コードを最適化するのに役立ちます。

ビットコインの価値はいくらですか

Apr 28, 2025 pm 07:42 PM

ビットコインの価値はいくらですか

Apr 28, 2025 pm 07:42 PM

ビットコインの価格は20,000ドルから30,000ドルの範囲です。 1。ビットコインの価格は2009年以来劇的に変動し、2017年には20,000ドル近くに達し、2021年にはほぼ60,000ドルに達しました。2。価格は、市場需要、供給、マクロ経済環境などの要因の影響を受けます。 3.取引所、モバイルアプリ、ウェブサイトを通じてリアルタイム価格を取得します。 4。ビットコインの価格は非常に不安定であり、市場の感情と外部要因によって駆動されます。 5.従来の金融市場と特定の関係を持ち、世界の株式市場、米ドルの強さなどの影響を受けています。6。長期的な傾向は強気ですが、リスクを慎重に評価する必要があります。

復号化GATE.IO戦略のアップグレード:Memebox 2.0でCrypto Asset Managementを再定義する方法は?

Apr 28, 2025 pm 03:33 PM

復号化GATE.IO戦略のアップグレード:Memebox 2.0でCrypto Asset Managementを再定義する方法は?

Apr 28, 2025 pm 03:33 PM

Memebox 2.0は、革新的なアーキテクチャとパフォーマンスのブレークスルーを通じて、暗号資産管理を再定義します。 1)3つの主要な問題点を解決します。資産サイロ、収入の減少、セキュリティと利便性のパラドックスです。 2)インテリジェントアセットハブ、動的リスク管理およびリターンエンハンスメントエンジン、クロスチェーン移動速度、平均降伏率、およびセキュリティインシデント応答速度が向上します。 3)ユーザーに、ユーザー価値の再構築を実現し、資産の視覚化、ポリシーの自動化、ガバナンス統合を提供します。 4)生態学的なコラボレーションとコンプライアンスの革新により、プラットフォームの全体的な有効性が向上しました。 5)将来的には、スマート契約保険プール、予測市場統合、AI主導の資産配分が開始され、引き続き業界の発展をリードします。