テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

GPT-3 はオープンソースになる予定です! Sam Altman 氏は、GPU が緊急に必要であること、そして GPT-4 マルチモーダル機能が来年利用可能になることを明らかにしました

GPT-3 はオープンソースになる予定です! Sam Altman 氏は、GPU が緊急に必要であること、そして GPT-4 マルチモーダル機能が来年利用可能になることを明らかにしました

GPT-3 はオープンソースになる予定です! Sam Altman 氏は、GPU が緊急に必要であること、そして GPT-4 マルチモーダル機能が来年利用可能になることを明らかにしました

公聴会の後、サム・アルトマンはチームをヨーロッパへの「旅行」に連れて行った。

最近のインタビューで、アルトマン氏はそれを隠さず、彼自身の AI のすべての進歩は GPU が追いつくまで待たなければならないことを明らかにしました。

彼は OpenAI の API と製品計画について話し、多くの人々の注目を集めました。

多くのネチズンは、私がアルトマンの率直さが好きだと言いました。

十分な GPU があれば、2024 年にはほとんどの Plus ユーザーが GPT-4 のマルチモーダル機能を利用できるようになるはずであることは言及する価値があります。

Microsoft の兄貴分が OpenAI 用に構築するために 12 億米ドルを費やしたスーパーコンピューターは、GPT-4 ランタイムに必要な計算能力を満たすには程遠いです。何しろ、GPT-4のパラメータは100兆個あると言われています。

さらに、Altman 氏は、GPT-3 も OpenAI のオープンソース計画に含まれていることを明らかにしました。

このインタビューで OpenAI の「秘密」が明らかになりすぎたかどうかはわかりませんが、ソース原稿は削除されているので、急いでコーディングしてください。

重要なポイント

最新のインタビューは、AI開発プラットフォームHumanloopのCEO、Raza Habib氏が司会を務め、インタビューを受けました。 Altman と他の 20 人の開発者。

このディスカッションでは、開発者の実際的な問題だけでなく、OpenAI の使命や AI の社会的影響に関するより大きな問題についても触れます。

重要なポイントは次のとおりです:

1. OpenAI は GPU を緊急に必要としています

2. OpenAI の最近のロードマップ: GPT-4 マルチモーダルは 2024 年にオープン予定

3. API 経由でアクセスされる ChatGPT プラグイン近い将来リリースされません

4. OpenAI は、ChatGPT を超スマートな作業アシスタントにすることを目的として、ChatGPT (「キラー アプリケーション」) のみを作成します

##5. オープンソース計画の GPT-3

6. モデル パフォーマンスのスケーリング則は引き続き有効です

次に、サム・アルトマンの発言を6つの主要なポイントから紹介します 何が起こったのか?

OpenAI は現在、GPU に大きく依存していますインタビューのすべてのトピックは、「OpenAI には GPU が不足している」という点を中心に展開していました。

これにより、短期計画の多くが遅れました。

現在、OpenAI の多くの顧客が API の信頼性と速度について不満を抱いています。 Sam Altman 氏は、主な理由は GPU が短すぎることであると説明しました。

OpenAI は、NVIDIA DGX-1 スーパーコンピューターの最初の顧客です ## 、32,000 トークンをサポートするコンテキストの長さは、まだより多くの人に展開できません。

OpenAI はまだ技術的な障害を克服していないため、今年は 10 万から 100 万のトークンをサポートするコンテキストを備えているように見えますが、研究で画期的な進歩を遂げる必要があります。

Fine-Tuning API も現在、GPU の可用性によって制限されています。

OpenAI は、アダプターや LoRa のような効率的な微調整メソッドをまだ使用していないため、微調整の実行と管理には非常に多くの計算量がかかります。

ただし、将来的には微調整のサポートが強化される予定です。 OpenAI は、コミュニティ提供モデルのマーケットプレイスをホストすることもあります。

最後に、専用容量のプロビジョニングも GPU の可用性によって制限されます。

今年の初めに、顧客が同社の新しい機械学習モデルを専用の容量で実行できるようにするために、OpenAI が新しい開発者プラットフォーム Foundry を密かに立ち上げていることがネチズンによって明らかにされました。

この製品は、「大規模なワークロードを実行する最先端の顧客向けに設計されています」。このサービスを利用するには、顧客は前払いで 10 万ドルを支払う必要があります。

しかし、公開されている写真情報からも分かるように、この作例は決して安価なものではない。

GPT-3.5 の軽量バージョンを実行するには、3 か月の委任で 78,000 ドル、1 年間で 264,000 ドルの費用がかかります。

裏を返せば、GPU の消費量が高額であることもわかります。

OpenAI の短期ロードマップ

Altman 氏は、OpenAI API の暫定的な短期ロードマップを共有しました:

2023 :

· 速くて安い GPT-4 ーーこれは OpenAI にとって最優先事項です。

一般に、OpenAI の目標は、「スマート コスト」を可能な限り削減することです。そのため、彼らは API のコストを引き続き削減するために懸命に努力するでしょう。

·コンテキスト ウィンドウの延長 - 近い将来、コンテキスト ウィンドウは最大 100 万個のトークンをサポートする可能性があります。

· 微調整 API – 微調整 API は最新モデルに拡張されますが、正確な形式は開発者の内容によって異なります。本当に欲しいです。

·Memory API ーー現状では上記の送信でほとんどのトークンが無駄になっていますが、将来的には会話履歴を記憶できるAPI版も登場予定です。

#2024:

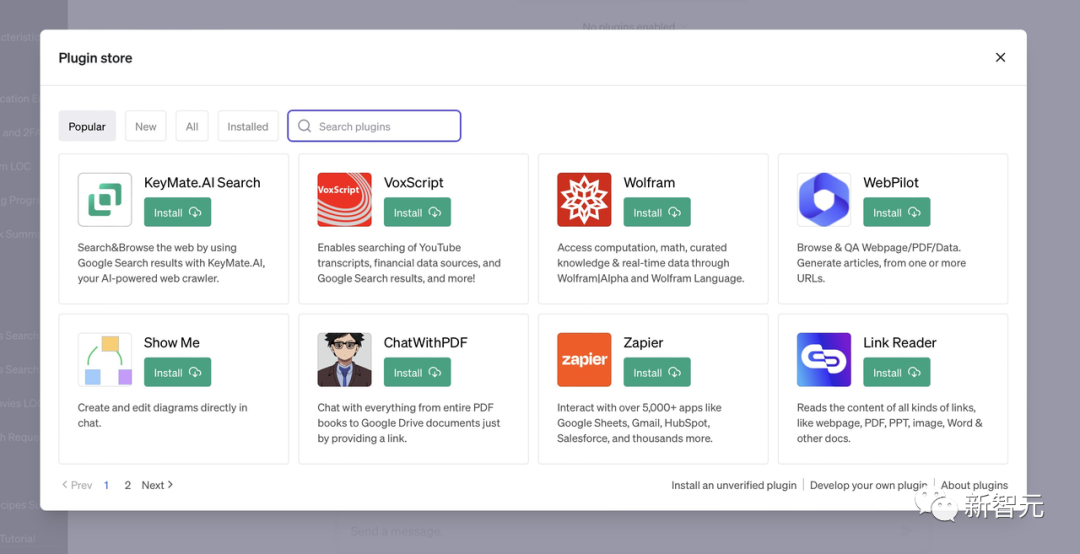

##マルチモーダル機能—GPT -4 はリリース時に強力なマルチモーダル機能を実証しましたが、GPU が満足するまで、この機能をすべての人に拡張することはできません。このプラグインには「PMF がない」ため、短期的には API に表示されなくなります

多くの開発者が ChatGPT プラグインへのアクセスに非常に興味を持っていますAPI を通じて提供されますが、サムは、これらのプラグインはすぐにはリリースされないと言いました。「ブラウジングを除いて、プラグイン システムは PMF を見つけられませんでした。」

ChatGPT を除いて、OpenAI はこれ以上の製品をリリースしません

OpenAI のあらゆる動きは開発者を震え上がらせます。多くの開発者は、OpenAI が競合する製品をリリースする可能性がある場合、OpenAI API を使用してアプリケーションを構築することに不安を感じていると述べました。

そしてAltman氏は、OpenAIはChatGPT以外の製品をこれ以上リリースしないだろうと述べた。

彼の意見では、偉大な企業には「キラー アプリケーション」があり、ChatGPT はこの記録を破るアプリケーションとなるでしょう。

規制は必要ですが、オープンソースも必要です

アルトマン氏は将来のモデルの規制を求めていますが、既存のモデルが危険であるとは考えていません。彼は、既存のモデルを規制したり禁止したりするのは大きな間違いであると信じています。

インタビューの中で、彼はオープンソースの重要性に対する信念を繰り返し述べ、OpenAI が GPT-3 をオープンソースにすることを検討していると述べました。

さて、OpenAI がオープンソースではない理由の 1 つは、大規模なモデルをホストして提供する能力を持っている個人や企業がどれだけあるのかを疑問に思っているからです。

モデルのパフォーマンスの「スケーリング則」は依然として有効です

最近、多くの記事で、巨大な人工知能モデルの時代は終わったと主張しています。しかし、それはアルトマンの当初の意図を正確に反映しているわけではありません。

ただし、OpenAI は、わずか数年でモデルをすでに何百万回もスケールアップしているため、この拡大率を維持することはできません。

これは、OpenAI がモデルを今後も大きくしようとしないという意味ではなく、モデルが複数回注文されるのではなく、おそらく年間 1 倍か 2 倍しか増加しないことを意味します。大きさ。スケーリングの法則が引き続き有効であるという事実は、AGI 開発のスケジュールに重要な意味を持ちます。

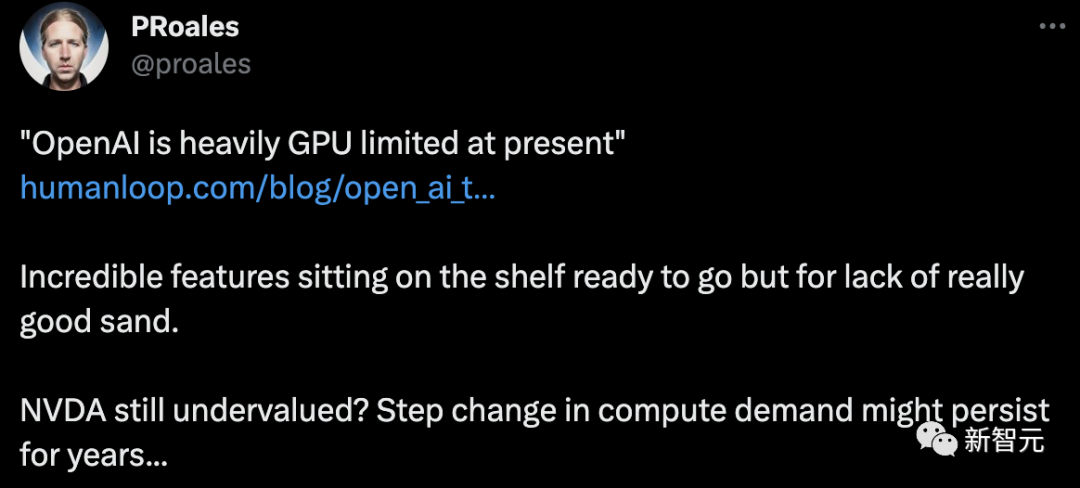

スケーリングの前提として、AGI の構築に必要なほとんどの部分がおそらくすでに用意されており、残りの作業のほとんどは、既存のメソッドをより大きなモデルとより大きなデータ セットに拡張することになります。 スケーリングの時代が終わったなら、おそらく AGI の実現はさらに遠くなると予想する必要があります。スケーリングの法則が引き続き有効であるということは、AGI の実装スケジュールが短縮されることを強く示唆しています。 一部のネチズンは、 #OpenAI: 保護しなければならないと冗談を言いました。規制を通じて私たちの堀を守ります。 OpenAI は、Meta が我々の堀に潜んでいると再び言及しました。これは、我々のモデルがオープンソースである必要があることも意味するはずです。 GPT-3 が LLMa のように本当にオープンソースである場合、M1 チップで使用できるようになるまでに約 5 日かかるだろうと言う人もいます。走っています。 コミュニティ開発者は、モデルをオープンソース化することを条件として、OpenAI による GPU ボトルネックの解決を支援できます。数日以内に、開発者は CPU やエッジ デバイス上でそれを実行できるようになります。 GPU 不足に関しては、OpenAI の資本チェーンに問題があり、余裕がないのではないかと考える人もいます。 しかし、明らかに供給が不足していると言う人もいます。チップ製造に革命が起こらない限り、コンシューマー向け GPU と比較して供給不足が常に存在する可能性があります。 Nvidia の価値がまだ過小評価されているのではないかと疑うネチズンもいます。コンピューティング需要の段階的変化は何年にもわたって続く可能性があります... NVIDIA は 1 兆ドルクラブに加わったばかりなので、無制限のコンピューティング パワー需要により、チップ工場が2兆ドルを超える世界。 #参考: ##https://www.php.cn/link /c55d22f5c88cc6f04c0bb2e0025dd70b ##https://www.php.cn/link/d5776aeecb3c45ab15adce6f5cb355f3#ネチズンからの熱いコメント

以上がGPT-3 はオープンソースになる予定です! Sam Altman 氏は、GPU が緊急に必要であること、そして GPT-4 マルチモーダル機能が来年利用可能になることを明らかにしましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7564

7564

15

15

1386

1386

52

52

86

86

11

11

28

28

99

99

オープンソースのフリーテキスト注釈ツールのおすすめ 10 選

Mar 26, 2024 pm 08:20 PM

オープンソースのフリーテキスト注釈ツールのおすすめ 10 選

Mar 26, 2024 pm 08:20 PM

テキスト注釈は、テキスト内の特定のコンテンツにラベルまたはタグを対応させる作業です。その主な目的は、特に人工知能の分野で、より深い分析と処理のためにテキストに追加情報を提供することです。テキスト注釈は、人工知能アプリケーションの教師あり機械学習タスクにとって非常に重要です。これは、自然言語テキスト情報をより正確に理解し、テキスト分類、感情分析、言語翻訳などのタスクのパフォーマンスを向上させるために AI モデルをトレーニングするために使用されます。テキスト アノテーションを通じて、AI モデルにテキスト内のエンティティを認識し、コンテキストを理解し、新しい同様のデータが出現したときに正確な予測を行うように教えることができます。この記事では主に、より優れたオープンソースのテキスト注釈ツールをいくつか推奨します。 1.LabelStudiohttps://github.com/Hu

オープンソースの無料画像注釈ツールおすすめ 15 選

Mar 28, 2024 pm 01:21 PM

オープンソースの無料画像注釈ツールおすすめ 15 選

Mar 28, 2024 pm 01:21 PM

画像の注釈は、ラベルまたは説明情報を画像に関連付けて、画像の内容に深い意味と説明を与えるプロセスです。このプロセスは機械学習にとって重要であり、画像内の個々の要素をより正確に識別するために視覚モデルをトレーニングするのに役立ちます。画像に注釈を追加することで、コンピュータは画像の背後にあるセマンティクスとコンテキストを理解できるため、画像の内容を理解して分析する能力が向上します。画像アノテーションは、コンピュータ ビジョン、自然言語処理、グラフ ビジョン モデルなどの多くの分野をカバーする幅広い用途があり、車両が道路上の障害物を識別するのを支援したり、障害物の検出を支援したりするなど、幅広い用途があります。医用画像認識による病気の診断。この記事では主に、より優れたオープンソースおよび無料の画像注釈ツールをいくつか推奨します。 1.マケセンス

win10gpu共有メモリをオフにする方法

Jan 12, 2024 am 09:45 AM

win10gpu共有メモリをオフにする方法

Jan 12, 2024 am 09:45 AM

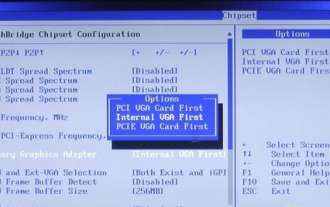

コンピューターにある程度詳しい友人なら、GPU には共有メモリがあることを知っているはずですが、多くの友人は、共有メモリによってメモリの数が減り、コンピューターに影響が出るのではないかと心配して、GPU をオフにしたいと考えています。見る。 win10gpu 共有メモリをオフにする: 注: GPU の共有メモリをオフにすることはできませんが、その値を最小値に設定することはできます。 1. 起動時に DEL を押して BIOS に入ります。一部のマザーボードでは、F2/F9/F12 を押して入る必要があります。BIOS インターフェイスの上部には、「メイン」、「詳細」、その他の設定を含む多くのタブがあります。「チップセット」を見つけます。 " オプション。以下のインターフェイスで SouthBridge 設定オプションを見つけ、Enter をクリックして入力します。

GPU ハードウェア アクセラレーションを有効にする必要がありますか?

Feb 26, 2024 pm 08:45 PM

GPU ハードウェア アクセラレーションを有効にする必要がありますか?

Feb 26, 2024 pm 08:45 PM

ハードウェア アクセラレーション GPU を有効にする必要がありますか?テクノロジーの継続的な開発と進歩に伴い、コンピューター グラフィックス処理の中核コンポーネントとして GPU (グラフィックス プロセッシング ユニット) が重要な役割を果たしています。ただし、ハードウェア アクセラレーションをオンにする必要があるかどうかについて疑問を抱くユーザーもいるかもしれません。この記事では、GPU のハードウェア アクセラレーションの必要性と、ハードウェア アクセラレーションをオンにした場合のコンピューターのパフォーマンスとユーザー エクスペリエンスへの影響について説明します。まず、ハードウェア アクセラレーションによる GPU がどのように動作するかを理解する必要があります。 GPUは特化型

ニュースによると、AMDが新しいRX 7700M / 7800MラップトップGPUを発売するとのこと

Jan 06, 2024 pm 11:30 PM

ニュースによると、AMDが新しいRX 7700M / 7800MラップトップGPUを発売するとのこと

Jan 06, 2024 pm 11:30 PM

TechPowerUp によると、1 月 2 日のこのサイトのニュースによると、AMD は Navi32 GPU をベースにしたノートブック用グラフィックス カードを間もなく発売する予定で、具体的なモデルは RX7700M と RX7800M になる可能性があります。現在、AMD は、ハイエンド RX7900M (72CU)、メインストリーム RX7600M/7600MXT (28/32CU) シリーズ、RX7600S/7700S (28/32CU) シリーズなど、さまざまな RX7000 シリーズ ノートブック GPU を発売しています。 Navi32GPU は 60CU なので、AMD が RX7700M や RX7800M にするか、低消費電力モデル RX7900S を作るかもしれません。 AMDが期待しているのは、

Beelink EX グラフィックス カード拡張ドックは、GPU パフォーマンスの損失ゼロを約束します

Aug 11, 2024 pm 09:55 PM

Beelink EX グラフィックス カード拡張ドックは、GPU パフォーマンスの損失ゼロを約束します

Aug 11, 2024 pm 09:55 PM

最近発売された Beelink GTi 14 の際立った機能の 1 つは、ミニ PC の下に隠し PCIe x8 スロットがあることです。同社は発売時に、これにより外部グラフィックスカードをシステムに接続しやすくなると述べた。ビーリンクにはnがあります

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

顔の検出および認識テクノロジーは、すでに比較的成熟しており、広く使用されているテクノロジーです。現在、最も広く使用されているインターネット アプリケーション言語は JS ですが、Web フロントエンドでの顔検出と認識の実装には、バックエンドの顔認識と比較して利点と欠点があります。利点としては、ネットワーク インタラクションの削減とリアルタイム認識により、ユーザーの待ち時間が大幅に短縮され、ユーザー エクスペリエンスが向上することが挙げられます。欠点としては、モデル サイズによって制限されるため、精度も制限されることが挙げられます。 js を使用して Web 上に顔検出を実装するにはどうすればよいですか? Web 上で顔認識を実装するには、JavaScript、HTML、CSS、WebRTC など、関連するプログラミング言語とテクノロジに精通している必要があります。同時に、関連するコンピューター ビジョンと人工知能テクノロジーを習得する必要もあります。 Web 側の設計により、次の点に注意してください。

AMD FSR 3.1 のリリース: フレーム生成機能は Nvidia GeForce RTX および Intel Arc GPU でも動作します

Jun 29, 2024 am 06:57 AM

AMD FSR 3.1 のリリース: フレーム生成機能は Nvidia GeForce RTX および Intel Arc GPU でも動作します

Jun 29, 2024 am 06:57 AM

AMD は、今年の第 2 四半期に FSR 3.1 をリリースするという 24 年 3 月の当初の約束を果たしました。 3.1 リリースを本当に際立たせているのは、フレーム生成側がアップスケーリング側から切り離されていることです。これにより、Nvidia および Intel GPU の所有者は FSR 3 を適用できるようになります。