NeRF の新しい研究結果がここにあります: 3D シーンは髪まで正確に、物体なしで跡形もなく削除されます

Neural Radiation Fields (NeRF) は、新しいビュー合成方法として人気があります。 NeRF は、より広範囲のアプリケーションやデータセットに急速に一般化していますが、NeRF モデリング シナリオを直接編集することは依然として大きな課題です。重要なタスクは、3D シーンから不要なオブジェクトを削除し、周囲のシーンとの一貫性を維持することです。このタスクは 3D イメージの修復と呼ばれます。 3D では、ソリューションは複数のビューにわたって一貫しており、幾何学的に有効である必要があります。

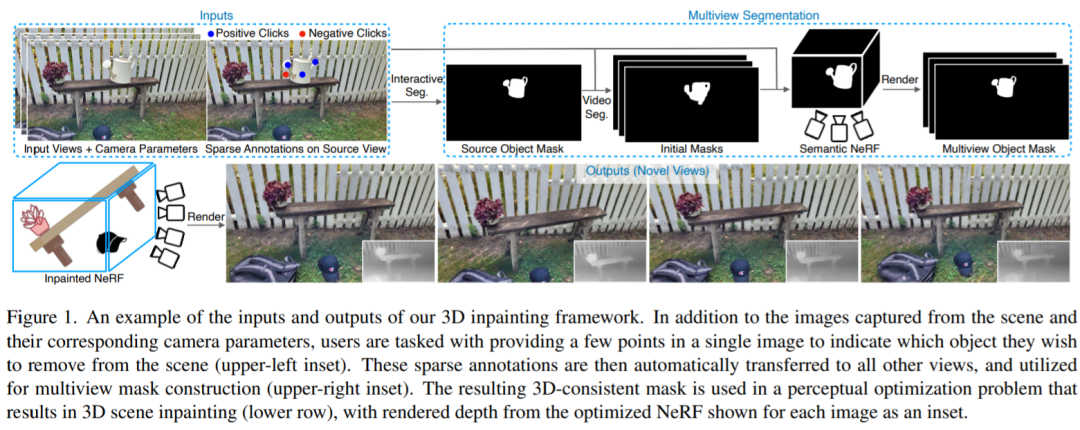

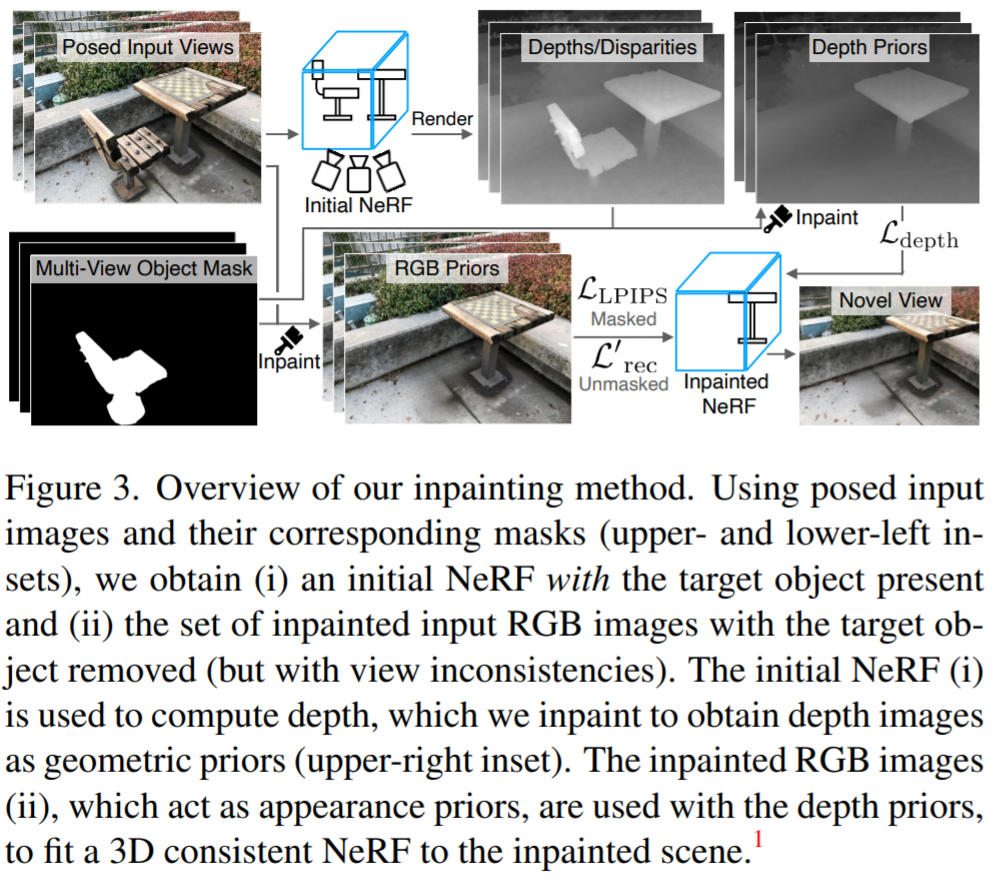

この記事では、サムスン、トロント大学、その他の機関の研究者が、単一の入力におけるポーズ画像の少数セットと疎性を考慮して、これらの課題を解決するための新しい 3D 修復手法を提案します。画像に注意してください。提案されたモデル フレームワークは、最初にターゲット オブジェクトの 3 次元セグメンテーション マスクを迅速に取得してそのマスクを使用し、次に学習された 2 次元画像を使用してその情報を修復および抽出する知覚最適化に基づく方法を導入します。ビューの一貫性を確保しながら、3 次元空間に変換します。

この研究は、困難な現実のシーン データセットでトレーニングすることにより、3D シーン内修復手法を評価するための新しいベンチマークももたらします。特に、このデータセットには、ターゲット オブジェクトがある場合とない場合の同じシーンのビューが含まれており、3D 空間での修復タスクのより原則的なベンチマークが可能になります。

- #論文アドレス: https://arxiv.org/pdf/2211.12254.pdf

- Paper ホームページ: https://spinnerf3d.github.io/

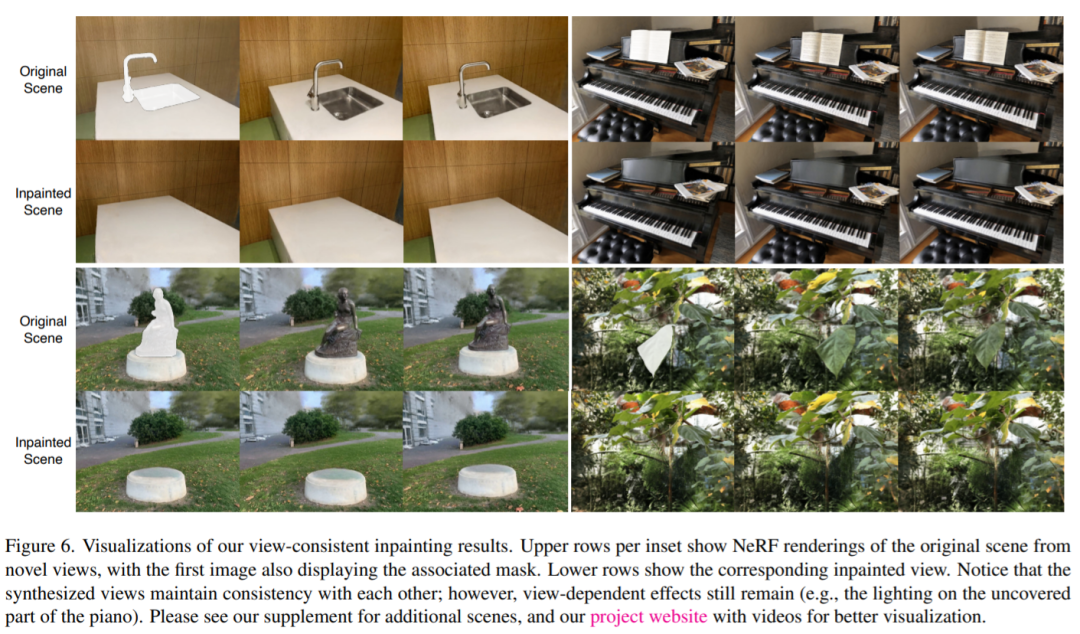

以下この効果は、いくつかのオブジェクトを削除した後でも、周囲のシーンとの一貫性を維持できることを示しています。

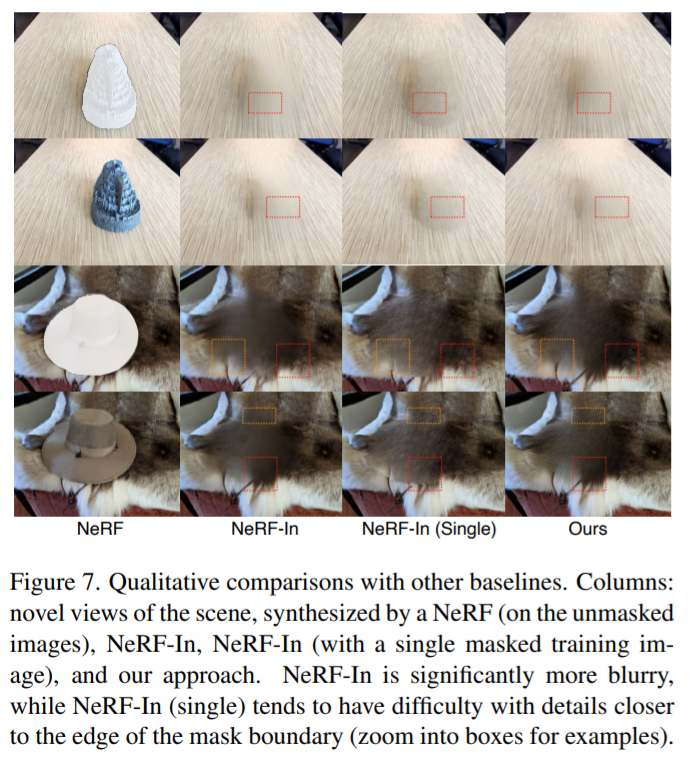

この記事の方法と他の方法の比較メソッド、その他のメソッド 明らかな成果物がありますが、この記事のメソッドはそれほど明白ではありません:

著者は、統合された方法を使用しています。3D シーン編集タスクにおけるさまざまな課題に対処するために、この方法では、シーンのマルチビュー画像を取得し、ユーザー入力を使用して 3D マスクを抽出し、NeRF トレーニングを使用してそれをマスク画像に適合させます。ターゲットオブジェクトは合理的に立体的に見え、幾何学的形状が置き換えられます。既存のインタラクティブな 2D セグメンテーション手法では 3D の側面が考慮されておらず、現在の NeRF ベースの手法ではスパース アノテーションを使用して良好な結果を得ることができず、十分な精度が得られません。現在の NeRF ベースのアルゴリズムの中には、オブジェクトの削除を許可するものもありますが、新たに生成された空間部分を提供しようとするものではありません。現在の研究の進歩によると、この研究は、単一のフレームワークでインタラクティブなマルチビュー セグメンテーションと完全な 3D 画像復元を同時に処理する最初の作品です。

研究者は、セグメンテーションと画像復元に既製の 3D フリー モデルを利用し、一貫したビューで出力を 3D 空間に転送します。 2D インタラクティブ セグメンテーションの研究に基づいて構築された提案されたモデルは、ターゲット オブジェクト上でマウスを使用してユーザーが調整した少数の画像ポイントから開始します。これに基づいて、彼らのアルゴリズムはビデオベースのモデルでマスクを初期化し、セマンティック マスクの NeRF を当てはめることによって一貫した 3D セグメンテーションにトレーニングします。次に、事前トレーニングされた 2D 画像復元がマルチビュー画像セットに適用され、NeRF フィッティング プロセスを使用して 3D 画像シーンが再構成され、知覚損失を使用して 2D 画像の不一致を制限し、正規化された画像のジオメトリが制限されます。深度画像領域のマスク。全体として、以下の図に示すように、オブジェクトの選択から埋め込みシーンの新しいビューの合成まで、ユーザーの負担を最小限に抑えた統合フレームワークで完全なアプローチを提供します。

要約すると、この研究の貢献は次のとおりです。

- ユーザー インタラクション オブジェクトの選択から始まり、3D 修復された NeRF シーンで終わる完全な 3D シーン操作プロセス;

- 2 次元セグメンテーションモデルマルチビュー状況に拡張され、まばらな注釈から 3D 一貫性のあるマスクを復元できます。

- は、2D 画像修復を使用した、新しい最適化ベースの 3D 修復式であるビューの一貫性と知覚的妥当性を保証します。

- 対応する操作後の Groud Truth を含む、3D 編集タスク評価用の新しいデータ セット。

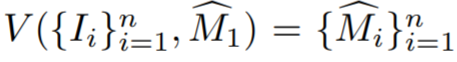

メソッドに特有の、この研究ではまず、単一ビューの注釈から大まかな 3D マスクを初期化する方法について説明します。注釈付きのソース コード ビューを I_1 として示します。オブジェクトとソース ビューに関するまばらな情報を対話型セグメンテーション モデルにフィードします。このモデルは、初期ソース オブジェクト マスク  を推定するために使用されます。次に、トレーニング ビューはビデオ シーケンスとして扱われ、

を推定するために使用されます。次に、トレーニング ビューはビデオ シーケンスとして扱われ、 を計算するためのビデオ インスタンス セグメンテーション モデル V が与えられ、

を計算するためのビデオ インスタンス セグメンテーション モデル V が与えられ、 # が計算されます。ここで、

# が計算されます。ここで、 は、I_i のオブジェクト マスクの初期推定値です。トレーニング ビューは実際には隣接するビデオ フレームではなく、ビデオ セグメンテーション モデルは 3D で未知であることが多いため、初期マスクは境界付近で不正確になることがよくあります。

は、I_i のオブジェクト マスクの初期推定値です。トレーニング ビューは実際には隣接するビデオ フレームではなく、ビデオ セグメンテーション モデルは 3D で未知であることが多いため、初期マスクは境界付近で不正確になることがよくあります。

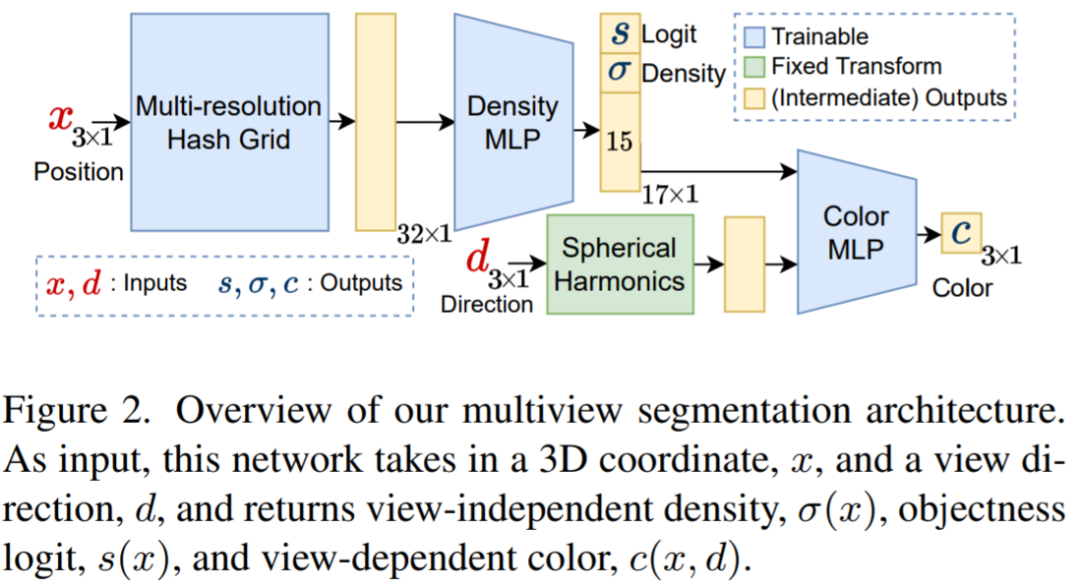

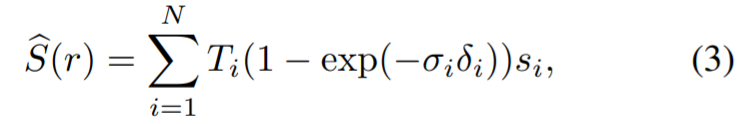

マルチビュー セグメンテーション モジュールは、入力 RGB 画像、対応するカメラの固有パラメータと外部パラメータ、および初期パラメータを取得します。セマンティック NeRF をトレーニングするためのマスク。上の図は、セマンティック NeRF で使用されるネットワークを示しています。点 x とビュー ディレクトリ d に対して、密度 σ と色 c に加えて、プレシグモイド オブジェクト ロジット s (x) を返します。高速収束を実現するために、研究者らはインスタント NGP を NeRF アーキテクチャとして使用しました。光線 r に関連する望ましい客観性は、密度に対する色ではなく、r 上の点の対数を方程式で表すことによって得られます。

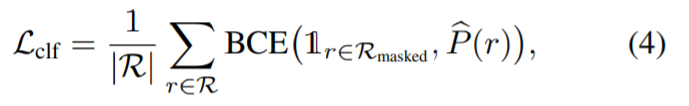

##分類損失は監視に使用されます。

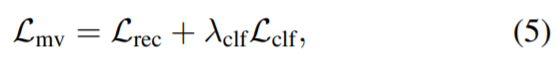

## は、以下に基づいて監視に使用されます。 NeRF のマルチビュー セグメンテーション モデルの全体的な損失は次のとおりです。

##最後に、最適化に 2 つの段階が使用され、さらに改善されます。マスク コード; 初期 3D マスクを取得した後、マスクはトレーニング ビューからレンダリングされ、(ビデオ セグメンテーション出力の代わりに) 初期仮説として 2 次マルチビュー セグメンテーション モデルを監視するために使用されます。

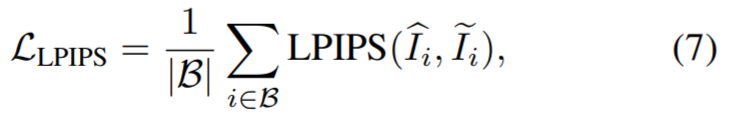

#この研究は、ビューの一貫性を備えた修復方法を提案し、入力は RGB です。まず、イメージとマスクのペアをイメージ インペインターに転送して、RGB イメージを取得します。各ビューは独立して修復されるため、修復されたビューは NeRF 再構築を監視するために直接使用されます。この論文では、マスクを生成するための損失として平均二乗誤差 (MSE) を使用する代わりに、研究者らは知覚損失 LPIPS を使用して画像のマスクされた部分を最適化し、同時に MSE を使用してマスクされていない部分を最適化することを提案しています。この損失は次のように計算されます。

#この研究は、ビューの一貫性を備えた修復方法を提案し、入力は RGB です。まず、イメージとマスクのペアをイメージ インペインターに転送して、RGB イメージを取得します。各ビューは独立して修復されるため、修復されたビューは NeRF 再構築を監視するために直接使用されます。この論文では、マスクを生成するための損失として平均二乗誤差 (MSE) を使用する代わりに、研究者らは知覚損失 LPIPS を使用して画像のマスクされた部分を最適化し、同時に MSE を使用してマスクされていない部分を最適化することを提案しています。この損失は次のように計算されます。

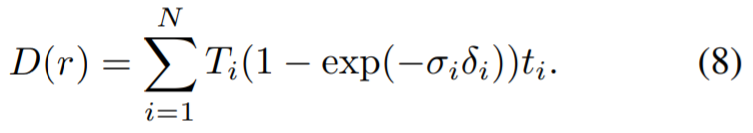

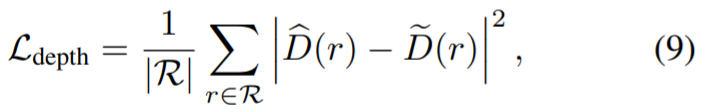

知覚的な損失があっても、ビュー間の違いを修復すると、誤った結果が得られます。低品質のジオメトリに収束します (たとえば、各ビューからの異なる情報を考慮して、「ぼやけた」ジオメトリ測定値がカメラの近くに形成される場合があります)。したがって、研究者らは生成された深度マップを NeRF モデルの追加のガイダンスとして使用し、知覚損失を計算するときに重みを分離し、知覚損失を使用してシーンの色のみを適合させました。これを行うために、不要なオブジェクトを含む画像に最適化された NeRF を使用し、トレーニング ビューに対応する深度マップをレンダリングしました。計算方法は、点の色の代わりにカメラまでの距離を使用することです。

# 次に、レンダリングされた深度はインペインター モデルに入力され、インペイントされた深度マップが取得されます。研究の結果、RGB などの深度レンダリングに LaMa を使用すると、十分に高品質な結果が得られることがわかりました。この NeRF は、マルチビュー セグメンテーションに使用されるのと同じモデルにすることができます。人間の注釈が付けられたマスクなど、他のソースがマスクの取得に使用される場合、新しい NeRF がシーンにインストールされます。これらの深度マップは、ペイントされた NeRF のジオメトリを監視するために使用され、レンダリングされた深度がインペインター モデルに供給されて、ペイントされた深度マップが取得されます。研究の結果、RGB などの深度レンダリングに LaMa を使用すると、十分に高品質な結果が得られることがわかりました。この NeRF は、マルチビュー セグメンテーションに使用されるのと同じモデルにすることができます。人間の注釈が付けられたマスクなど、他のソースがマスクの取得に使用される場合、新しい NeRF がシーンにインストールされます。次に、これらの深度マップを使用して、インペイントされた深さまでのレンダリング深度によって、インペイントされた深さまで  ## の距離だけインペイントされた NeRF のジオメトリを監視します。

## の距離だけインペイントされた NeRF のジオメトリを監視します。

#実験結果

定性的に言えば、以下の図は、研究者のセグメンテーション モデルの結果と、NVOS およびいくつかのビデオ セグメンテーション手法の出力を比較しています。比較する。彼らのモデルは、3D ビデオ セグメンテーション モデルの厚いエッジと比較して、ノイズを低減し、ビューの一貫性を向上させます。 NVOS は研究者の新しいモデルで使用されているスパース ポイントの代わりに落書きを使用していますが、新しいモデルの MVSeg は視覚的に NVOS よりも優れています。 NVOS コードベースは利用できないため、研究者は NVOS 上で公開されている定性的結果を再現しました (その他の例については補足文書を参照してください)。

#

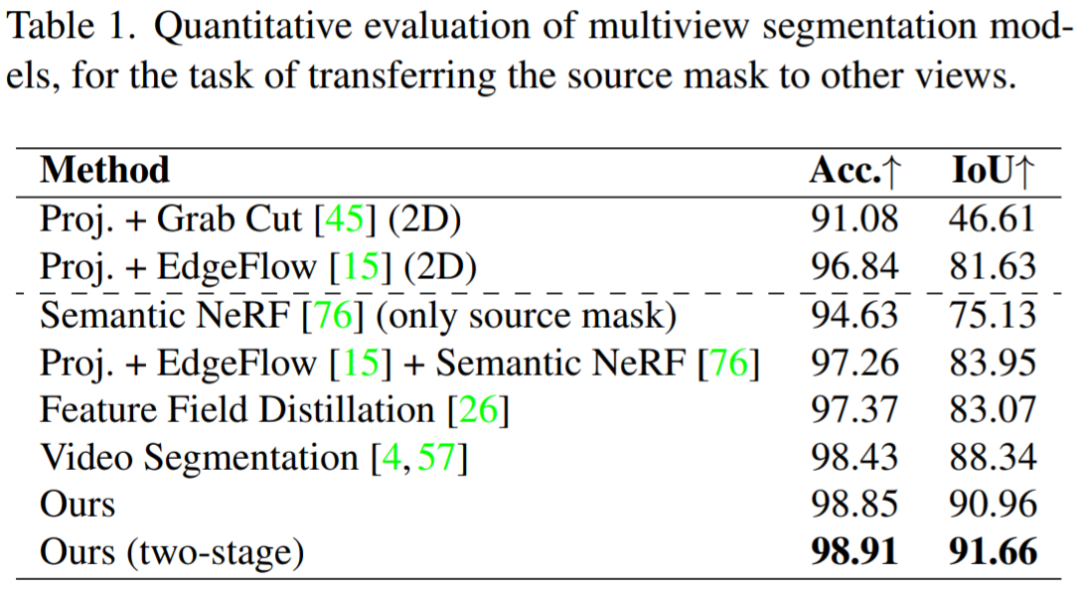

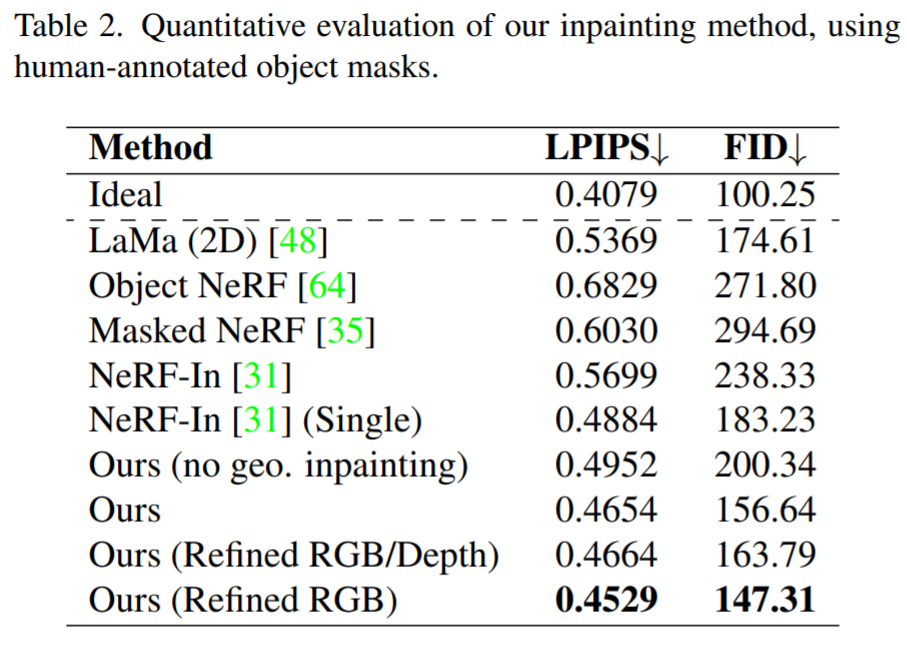

次の表は、MV 手法とベースラインとの比較を示しており、全体として、新しく提案された手法は他の 2D および 3D 修復手法よりも大幅に優れています。以下の表は、幾何学的構造からガイダンスを削除すると、修復されたシーンの品質が低下することをさらに示しています。

#定性的な結果を図 6 と図 7 に示します。図 6 は、私たちの方法が、光沢のある表面とマットな表面の一貫したビューを含む、詳細なテクスチャを持つビュー一貫性のあるシーンを再構築できることを示しています。図 7 は、私たちの知覚的手法がマスク領域の正確な再構成制約を軽減し、それによってすべての画像を使用する際のぼやけの出現を防ぎ、同時に単一ビュー監視によって引き起こされるアーティファクトを回避することを示しています。

以上がNeRF の新しい研究結果がここにあります: 3D シーンは髪まで正確に、物体なしで跡形もなく削除されますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7445

7445

15

15

1371

1371

52

52

76

76

11

11

10

10

6

6

vue.jsのストリングをオブジェクトに変換するためにどのような方法が使用されますか?

Apr 07, 2025 pm 09:39 PM

vue.jsのストリングをオブジェクトに変換するためにどのような方法が使用されますか?

Apr 07, 2025 pm 09:39 PM

vue.jsのオブジェクトに文字列を変換する場合、標準のjson文字列にはjson.parse()が推奨されます。非標準のJSON文字列の場合、文字列は正規表現を使用して処理し、フォーマットまたはデコードされたURLエンコードに従ってメソッドを削減できます。文字列形式に従って適切な方法を選択し、バグを避けるためにセキュリティとエンコードの問題に注意してください。

VueおよびElement-UIカスケードドロップダウンボックスVモデルバインディング

Apr 07, 2025 pm 08:06 PM

VueおよびElement-UIカスケードドロップダウンボックスVモデルバインディング

Apr 07, 2025 pm 08:06 PM

VueとElement-UIカスケードドロップダウンボックスv-Modelバインディング共通ピットポイント:V-Modelは、文字列ではなく、カスケード選択ボックスの各レベルで選択した値を表す配列をバインドします。 SelectedOptionsの初期値は、nullまたは未定義ではなく、空の配列でなければなりません。データの動的読み込みには、非同期でデータの更新を処理するために非同期プログラミングスキルを使用する必要があります。膨大なデータセットの場合、仮想スクロールや怠zyな読み込みなどのパフォーマンス最適化手法を考慮する必要があります。

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue axiosのタイムアウトを設定するために、Axiosインスタンスを作成してタイムアウトオプションを指定できます。グローバル設定:Vue.Prototype。$ axios = axios.create({Timeout:5000});単一のリクエストで:this。$ axios.get( '/api/users'、{timeout:10000})。

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

この記事では、MySQLデータベースの操作を紹介します。まず、MySQLWorkBenchやコマンドラインクライアントなど、MySQLクライアントをインストールする必要があります。 1. mysql-uroot-pコマンドを使用してサーバーに接続し、ルートアカウントパスワードでログインします。 2。CreatedAtaBaseを使用してデータベースを作成し、データベースを選択します。 3. createTableを使用してテーブルを作成し、フィールドとデータ型を定義します。 4. INSERTINTOを使用してデータを挿入し、データをクエリし、更新することでデータを更新し、削除してデータを削除します。これらの手順を習得することによってのみ、一般的な問題に対処することを学び、データベースのパフォーマンスを最適化することでMySQLを効率的に使用できます。

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

700万のレコードを効率的に処理し、地理空間技術を使用したインタラクティブマップを作成します。この記事では、LaravelとMySQLを使用して700万を超えるレコードを効率的に処理し、それらをインタラクティブなマップの視覚化に変換する方法について説明します。最初の課題プロジェクトの要件:MySQLデータベースに700万のレコードを使用して貴重な洞察を抽出します。多くの人は最初に言語をプログラミングすることを検討しますが、データベース自体を無視します。ニーズを満たすことができますか?データ移行または構造調整は必要ですか? MySQLはこのような大きなデータ負荷に耐えることができますか?予備分析:キーフィルターとプロパティを特定する必要があります。分析後、ソリューションに関連している属性はわずかであることがわかりました。フィルターの実現可能性を確認し、検索を最適化するためにいくつかの制限を設定しました。都市に基づくマップ検索

vue.js文字列タイプの配列をオブジェクトの配列に変換する方法は?

Apr 07, 2025 pm 09:36 PM

vue.js文字列タイプの配列をオブジェクトの配列に変換する方法は?

Apr 07, 2025 pm 09:36 PM

概要:Vue.js文字列配列をオブジェクト配列に変換するための次の方法があります。基本方法:定期的なフォーマットデータに合わせてマップ関数を使用します。高度なゲームプレイ:正規表現を使用すると、複雑な形式を処理できますが、慎重に記述して考慮する必要があります。パフォーマンスの最適化:大量のデータを考慮すると、非同期操作または効率的なデータ処理ライブラリを使用できます。ベストプラクティス:コードスタイルをクリアし、意味のある変数名とコメントを使用して、コードを簡潔に保ちます。

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニアの求人事業者:サークル場所:リモートオフィスジョブタイプ:フルタイム給与:$ 130,000- $ 140,000職務記述書サークルモバイルアプリケーションとパブリックAPI関連機能の研究開発に参加します。ソフトウェア開発ライフサイクル全体をカバーします。主な責任は、RubyonRailsに基づいて独立して開発作業を完了し、React/Redux/Relay Front-Endチームと協力しています。 Webアプリケーションのコア機能と改善を構築し、機能設計プロセス全体でデザイナーとリーダーシップと緊密に連携します。肯定的な開発プロセスを促進し、反復速度を優先します。 6年以上の複雑なWebアプリケーションバックエンドが必要です

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLの起動が失敗する理由はたくさんあり、エラーログをチェックすることで診断できます。一般的な原因には、ポートの競合(ポート占有率をチェックして構成の変更)、許可の問題(ユーザー許可を実行するサービスを確認)、構成ファイルエラー(パラメーター設定のチェック)、データディレクトリの破損(テーブルスペースの復元)、INNODBテーブルスペースの問題(IBDATA1ファイルのチェック)、プラグインロード障害(エラーログのチェック)が含まれます。問題を解決するときは、エラーログに基づいてそれらを分析し、問題の根本原因を見つけ、問題を防ぐために定期的にデータをバックアップする習慣を開発する必要があります。