Java による分散コンピューティングおよびデータ分析テクノロジー

ビッグデータ時代の到来により、データ量の爆発的な増加は、従来のコンピューティング手法に大きな影響をもたらしました。この問題を解決するために、分散コンピューティングとデータ分析技術が登場しました。 Java は汎用プログラミング言語として、分散コンピューティングとデータ分析の分野で優れたパフォーマンスを示しています。

1. 分散コンピューティング テクノロジ

分散コンピューティングは、コンピューティング タスクをいくつかのサブタスクに分割するテクノロジです。各サブタスクは異なるコンピュータ上で実行でき、その結果は次のようになります。最終結果にマージされます。このテクノロジーにより、コンピューティング効率が大幅に向上し、システムのスケーラビリティが向上します。

分散コンピューティング テクノロジにおいて、Java で最も一般的に使用されるツールは Hadoop と Spark です。 Hadoop は Java ベースのビッグ データ分散処理フレームワークであり、大量のデータを分散して処理し、複数のコンピュータ ノードにわたってデータを保存および処理できます。 Spark は、Hadoop クラスター上で実行できる大規模なデータ セットを処理するための高速な汎用エンジンを提供する、もう 1 つの Java ベースのフレームワークです。

2. データ分析テクノロジー

データ分析とは、さまざまなテクノロジーやツールを使用して大量のデータを処理および分析し、データの背後に隠されたパターンや傾向を発見することを指します。 Java には、データ分析のための優れたツールやフレームワークも数多くあります。

- Mahout

Mahout は、大規模なデータセットのデータマイニングとデータ分析に使用できる Java ベースの機械学習プラットフォームです。クラスタリング、分類などを含む多くの機械学習アルゴリズムを提供します。

- Weka

Weka は、データ マイニング、予測モデリング、クラスター分析などに使用できる Java ベースのオープンソース機械学習ツールです。多くのデータ前処理および機械学習アルゴリズムを提供します。

- ELK

ELK は、Logstash、Elasticsearch、Kibana の 3 つのスムーズなコラボレーション ツールで構成されるユニバーサル ログ データ分析ソリューションです。 Logstash はログ データ コレクター、Elasticsearch は分散検索および分析エンジン、Kibana はリアルタイムでログ データをカウントおよび分析するために使用できるユーザー フレンドリーな Web フロントエンドです。

3. 結論

Java は、分散コンピューティングとデータ分析の分野で優れたパフォーマンスとスケーラビリティを示しています。さまざまなオープンソース ツールとフレームワークは、Java 開発者が大規模なデータ セットをより迅速に処理および分析するのに役立ちます。アプリケーションの設計と実装のプロセス中、開発者は、パフォーマンスとスケーラビリティを確保するために、特定のニーズに基づいて適切な分散コンピューティングおよびデータ分析ツールとフレームワークを選択する必要があります。

以上がJava による分散コンピューティングおよびデータ分析テクノロジーの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7685

7685

15

15

1639

1639

14

14

1393

1393

52

52

1287

1287

25

25

1229

1229

29

29

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

9 月 23 日、論文「DeepModelFusion:ASurvey」が国立国防技術大学、JD.com、北京理工大学によって発表されました。ディープ モデルの融合/マージは、複数のディープ ラーニング モデルのパラメーターまたは予測を 1 つのモデルに結合する新しいテクノロジーです。さまざまなモデルの機能を組み合わせて、個々のモデルのバイアスとエラーを補償し、パフォーマンスを向上させます。大規模な深層学習モデル (LLM や基本モデルなど) での深層モデルの融合は、高い計算コスト、高次元のパラメーター空間、異なる異種モデル間の干渉など、いくつかの課題に直面しています。この記事では、既存のディープ モデル フュージョン手法を 4 つのカテゴリに分類します。 (1) 「パターン接続」。損失低減パスを介して重み空間内の解を接続し、より適切な初期モデル フュージョンを取得します。

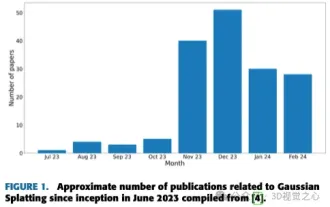

単なる 3D ガウス以上のもの!最先端の 3D 再構成技術の最新概要

Jun 02, 2024 pm 06:57 PM

単なる 3D ガウス以上のもの!最先端の 3D 再構成技術の最新概要

Jun 02, 2024 pm 06:57 PM

上記と著者の個人的な理解は、画像ベースの 3D 再構成は、一連の入力画像からオブジェクトまたはシーンの 3D 形状を推測することを含む困難なタスクであるということです。学習ベースの手法は、3D形状を直接推定できることから注目を集めています。このレビュー ペーパーは、これまでにない新しいビューの生成など、最先端の 3D 再構成技術に焦点を当てています。入力タイプ、モデル構造、出力表現、トレーニング戦略など、ガウス スプラッシュ メソッドの最近の開発の概要が提供されます。未解決の課題と今後の方向性についても議論します。この分野の急速な進歩と 3D 再構成手法を強化する数多くの機会を考慮すると、アルゴリズムを徹底的に調査することが重要であると思われます。したがって、この研究は、ガウス散乱の最近の進歩の包括的な概要を提供します。 (親指を上にスワイプしてください

Golang とフロントエンド テクノロジーの組み合わせ: Golang がフロントエンド分野でどのような役割を果たすかを探る

Mar 19, 2024 pm 06:15 PM

Golang とフロントエンド テクノロジーの組み合わせ: Golang がフロントエンド分野でどのような役割を果たすかを探る

Mar 19, 2024 pm 06:15 PM

Golang とフロントエンド テクノロジーの組み合わせ: Golang がフロントエンド分野でどのような役割を果たしているかを調べるには、具体的なコード例が必要です。インターネットとモバイル アプリケーションの急速な発展に伴い、フロントエンド テクノロジーの重要性がますます高まっています。この分野では、強力なバックエンド プログラミング言語としての Golang も重要な役割を果たします。この記事では、Golang がどのようにフロントエンド テクノロジーと組み合わされるかを検討し、具体的なコード例を通じてフロントエンド分野での可能性を実証します。フロントエンド分野における Golang の役割は、効率的で簡潔かつ学びやすいものとしてです。

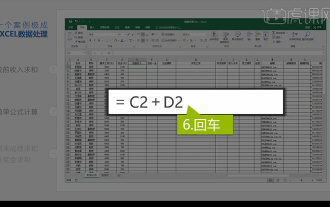

Excelデータの統合分析

Mar 21, 2024 am 08:21 AM

Excelデータの統合分析

Mar 21, 2024 am 08:21 AM

1. このレッスンでは、Excel の統合データ分析について説明します。ケースを通して完成させます。教材を開いて、セル E2 をクリックして数式を入力します。 2. 次に、セル E53 を選択して、以下のすべてのデータを計算します。 3. 次に、セル F2 をクリックし、計算する数式を入力します。同様に、下にドラッグすると、必要な値を計算できます。 4. セル G2 を選択し、「データ」タブをクリックし、「データ検証」をクリックして、選択して確認します。 5. 同じ方法を使用して、計算が必要な下のセルを自動的に入力してみましょう。 6. 次に、実際の賃金を計算し、セル H2 を選択して数式を入力します。 7. 次に、値のドロップダウン メニューをクリックして、他の数値をクリックします。

おすすめのデータ分析サイトは何ですか?

Mar 13, 2024 pm 05:44 PM

おすすめのデータ分析サイトは何ですか?

Mar 13, 2024 pm 05:44 PM

推奨: 1. ビジネス データ分析フォーラム; 2. 全国人民代表大会経済フォーラム - 計量経済統計分野; 3. 中国統計フォーラム; 4. データ マイニング学習および交換フォーラム; 5. データ分析フォーラム; 6. ウェブサイト データ分析; 7 . データ分析; 8. データマイニング研究所; 9. S-PLUS、R 統計フォーラム。