RHEL 9/8 で高可用性 Apache (HTTP) クラスターをセットアップする方法

Pacemaker は、Linux のようなオペレーティング システムに適した高可用性クラスター ソフトウェアです。 Pacemaker は「クラスター リソース マネージャー」として知られており、クラスター ノード間のリソースのフェイルオーバーによってクラスター リソースの可用性を最大限に高めます。 Pacemaker は、ハートビートとクラスター コンポーネント間の内部通信に Corosync を使用し、クラスター内の投票 (クォーラム) も行います。

前提条件

始める前に、以下のものがあることを確認してください:

- 2 台の RHEL 9/8 サーバー

- Red Hat サブスクリプションまたはローカル構成されたリポジトリ

- SSH 経由で両方のサーバーにアクセス

- root または sudo 権限

- インターネット接続

ラボの詳細:

- サーバー 1: node1.example.com (192.168.1.6)

- サーバー 2: node2.example.com (192.168.1.7)

- VIP: 192.168.1.81

- 共有ディスク:

/dev/sdb(2GB)

早速、これらの手順について詳しく見ていきましょう。

1. /etc/hosts ファイルを更新します

両方のノードの /etc/hosts ファイルに次のエントリを追加します:

192.168.1.6node1.example.com192.168.1.7node2.example.com

2 , 高可用性パッケージ Pacemaker をインストールします

Pacemaker およびその他の必要なソフトウェア パッケージは、RHEL 9/8 のデフォルトのパッケージ リポジトリでは入手できません。したがって、可用性の高いウェアハウスを有効にする必要があります。両方のノードで次のサブスクリプション マネージャー コマンドを実行します。

RHEL 9 サーバーの場合:

$ sudo subscription-manager repos --enable=rhel-9-for-x86_64-highavailability-rpms

RHEL 8 サーバーの場合:

$ sudo subscription-manager repos --enable=rhel-8-for-x86_64-highavailability-rpms

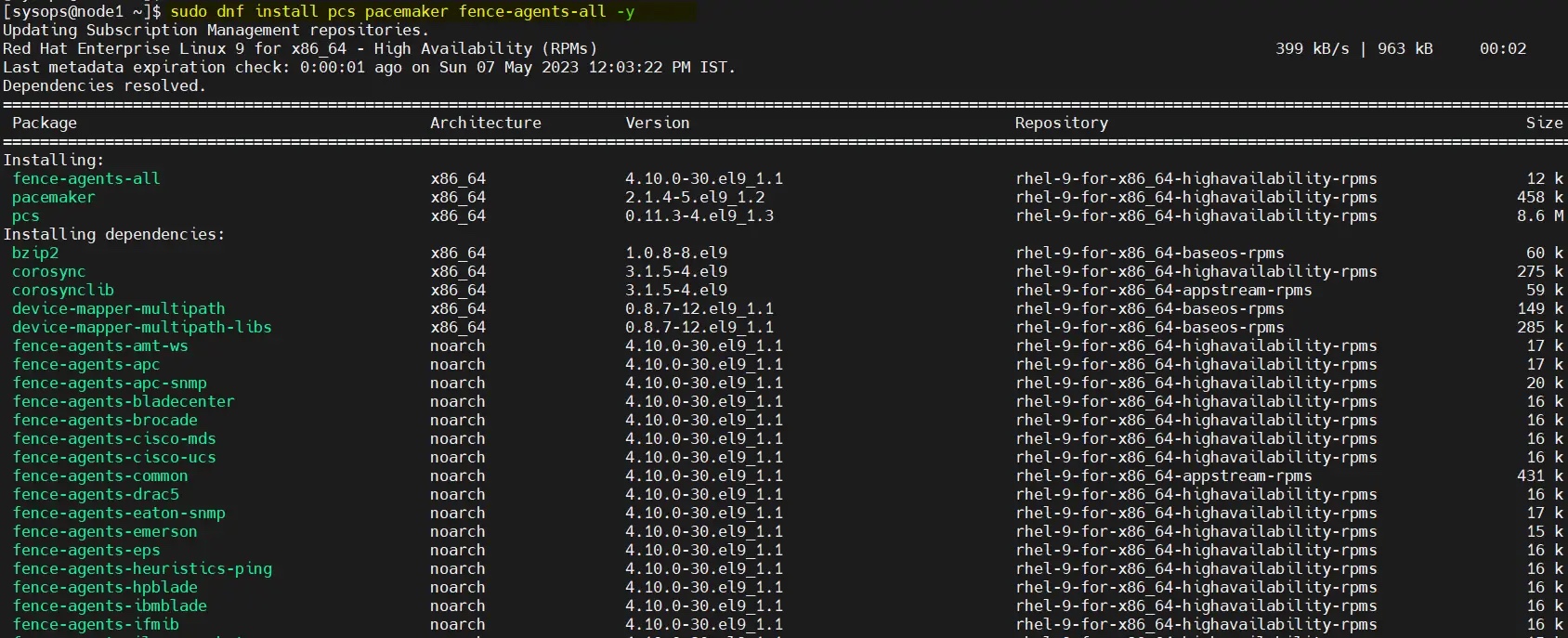

リポジトリを有効にした後、コマンドを実行して pacemaker パッケージをインストールします。両方のノード :

$ sudo dnf install pcs pacemaker fence-agents-all -y

RHEL 9/8 で高可用性 Apache (HTTP) クラスターをセットアップする方法

3. 高可用性ポートを許可するファイアウォール内

ファイアウォールで高可用性ポートを許可するには、各ノードで次のコマンドを実行します:

$ sudo firewall-cmd --permanent --add-service=high-availability$ sudo firewall-cmd --reload

4. hacluster ユーザーのパスワードを設定し、pcsd サービスを開始します

両方のサーバーで、hacluster ユーザーのパスワードを設定し、次の echo コマンドを実行します。

$ echo "<Enter-Password>" | sudo passwd --stdin hacluster

次のコマンドを実行して、クラスター サービスを開始して有効にします。両方のサーバーで:

$ sudo systemctl start pcsd.service$ sudo systemctl enable pcsd.service

5. 高可用性クラスターを作成します

pcs コマンドを使用して両方のノードを認証し、任意のノードから次のコマンドを実行します。私の場合、node1:

$ sudo pcs host auth node1.example.com node2.example.com

で hacluster ユーザーを使用して認証されて実行しています。

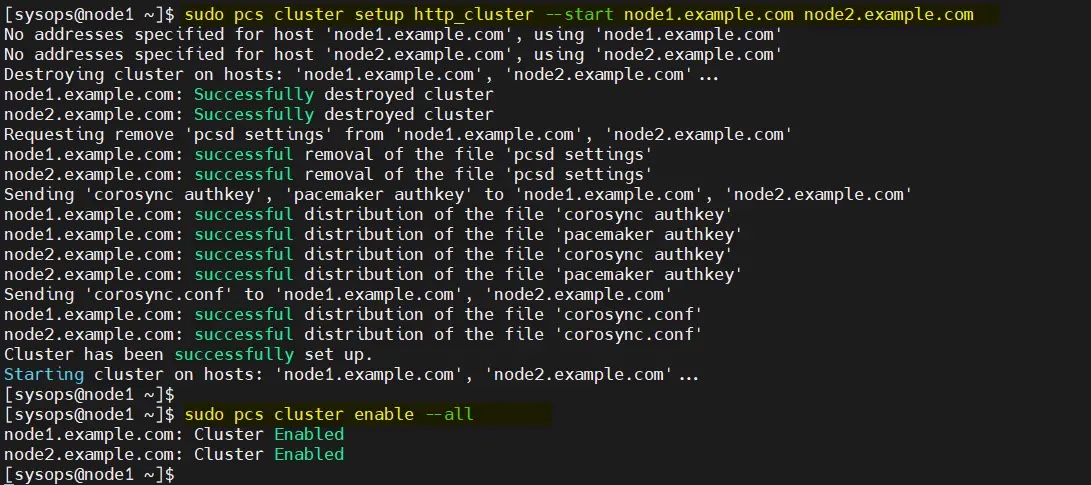

次の pcs cluster setup コマンドを使用して、クラスターに 2 つのノードを追加します。ここで使用するクラスター名は http_cluster です。 。 node1 でのみコマンドを実行します:

$ sudo pcs cluster setup http_cluster --start node1.example.com node2.example.com$ sudo pcs cluster enable --all

これら 2 つのコマンドの出力は次のとおりです:

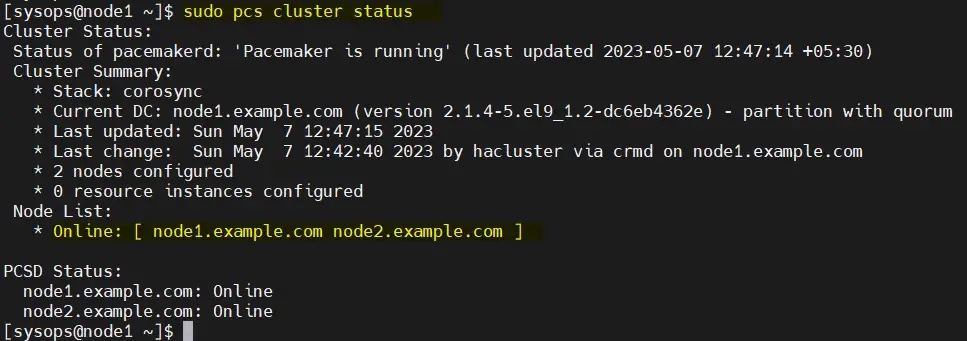

从任何节点验证初始集群状态:

$ sudo pcs cluster status

注意:在我们的实验室中,我们没有任何防护设备,因此我们将其禁用。但在生产环境中,强烈建议配置防护。

$ sudo pcs property set stonith-enabled=false$ sudo pcs property set no-quorum-policy=ignore

6、为集群配置共享卷

在服务器上,挂载了一个大小为 2GB 的共享磁盘(/dev/sdb)。因此,我们将其配置为 LVM 卷并将其格式化为 XFS 文件系统。

在开始创建 LVM 卷之前,编辑两个节点上的 /etc/lvm/lvm.conf 文件。

将参数 #system_id_source = "none" 更改为 system_id_source = "uname":

$ sudo sed -i 's/# system_id_source = "none"/ system_id_source = "uname"/g' /etc/lvm/lvm.conf

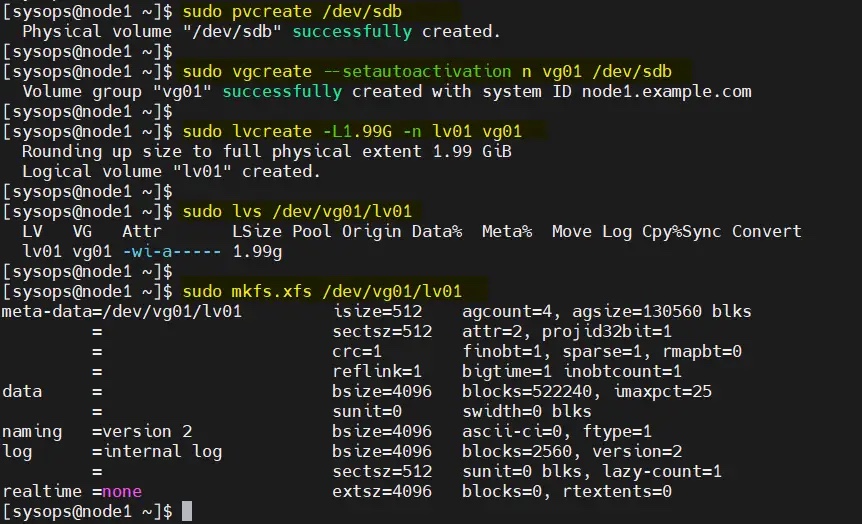

在 node1 上依次执行以下一组命令创建 LVM 卷:

$ sudo pvcreate /dev/sdb$ sudo vgcreate --setautoactivation n vg01 /dev/sdb$ sudo lvcreate -L1.99G -n lv01 vg01$ sudo lvs /dev/vg01/lv01$ sudo mkfs.xfs /dev/vg01/lv01

将共享设备添加到集群第二个节点(node2.example.com)上的 LVM 设备文件中,仅在 node2 上运行以下命令:

[sysops@node2 ~]$ sudo lvmdevices --adddev /dev/sdb

7、安装和配置 Apache Web 服务器(httpd)

在两台服务器上安装 Apache web 服务器(httpd),运行以下 dnf 命令:

$ sudo dnf install -y httpd wget

并允许防火墙中的 Apache 端口,在两台服务器上运行以下 firewall-cmd 命令:

$ sudo firewall-cmd --permanent --zone=public --add-service=http$ sudo firewall-cmd --permanent --zone=public --add-service=https$ sudo firewall-cmd --reload

在两个节点上创建 status.conf 文件,以便 Apache 资源代理获取 Apache 的状态:

$ sudo bash -c 'cat <<-END > /etc/httpd/conf.d/status.conf<Location /server-status>SetHandler server-statusRequire local</Location>END'$

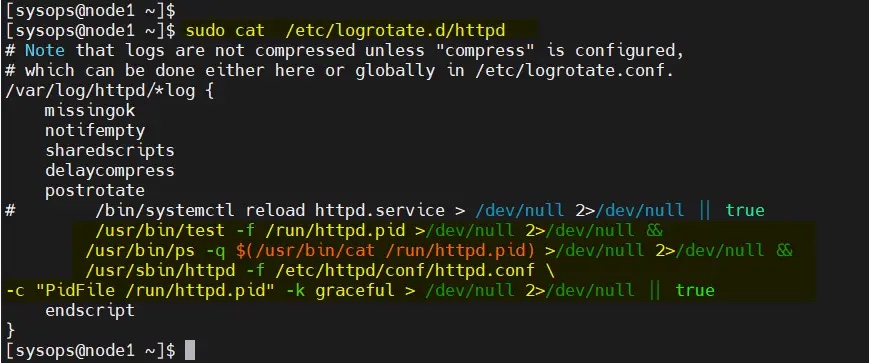

修改两个节点上的 /etc/logrotate.d/httpd:

替换下面的行

/bin/systemctl reload httpd.service > /dev/null 2>/dev/null || true

为

/usr/bin/test -f /run/httpd.pid >/dev/null 2>/dev/null &&/usr/bin/ps -q $(/usr/bin/cat /run/httpd.pid) >/dev/null 2>/dev/null &&/usr/sbin/httpd -f /etc/httpd/conf/httpd.conf \-c "PidFile /run/httpd.pid" -k graceful > /dev/null 2>/dev/null || true

保存并退出文件。

8、为 Apache 创建一个示例网页

仅在 node1 上执行以下命令:

$ sudo lvchange -ay vg01/lv01$ sudo mount /dev/vg01/lv01 /var/www/$ sudo mkdir /var/www/html$ sudo mkdir /var/www/cgi-bin$ sudo mkdir /var/www/error$ sudo bash -c ' cat <<-END >/var/www/html/index.html<html><body>High Availability Apache Cluster - Test Page </body></html>END'$$ sudo umount /var/www

注意:如果启用了 SElinux,则在两台服务器上运行以下命令:

$ sudo restorecon -R /var/www

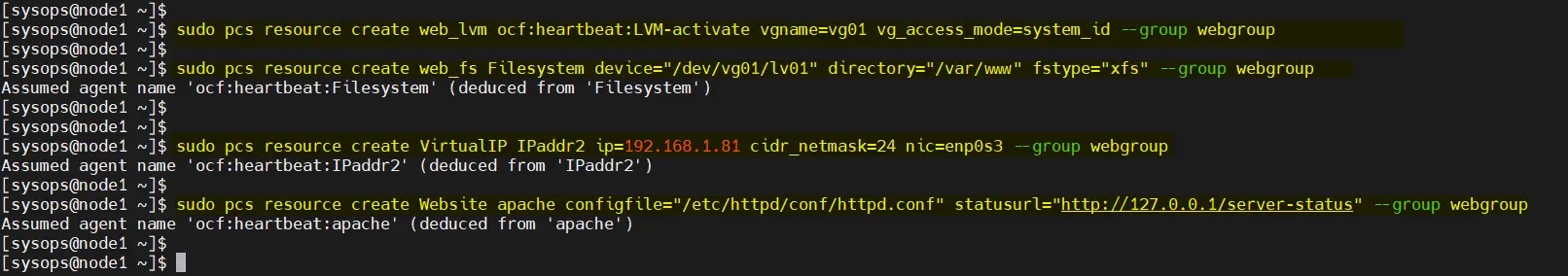

9、创建集群资源和资源组

为集群定义资源组和集群资源。在我的例子中,我们使用 webgroup 作为资源组。

-

web_lvm是共享 LVM 卷的资源名称(/dev/vg01/lv01) -

web_fs是将挂载在/var/www上的文件系统资源的名称 -

VirtualIP是网卡enp0s3的 VIP(IPadd2)资源 -

Website是 Apache 配置文件的资源。

从任何节点执行以下命令集。

$ sudo pcs resource create web_lvm ocf:heartbeat:LVM-activate vgname=vg01 vg_access_mode=system_id --group webgroup$ sudo pcs resource create web_fs Filesystem device="/dev/vg01/lv01" directory="/var/www" fstype="xfs" --group webgroup$ sudo pcs resource create VirtualIP IPaddr2 ip=192.168.1.81 cidr_netmask=24 nic=enp0s3 --group webgroup$ sudo pcs resource create Website apache configfile="/etc/httpd/conf/httpd.conf" statusurl="http://127.0.0.1/server-status" --group webgroup

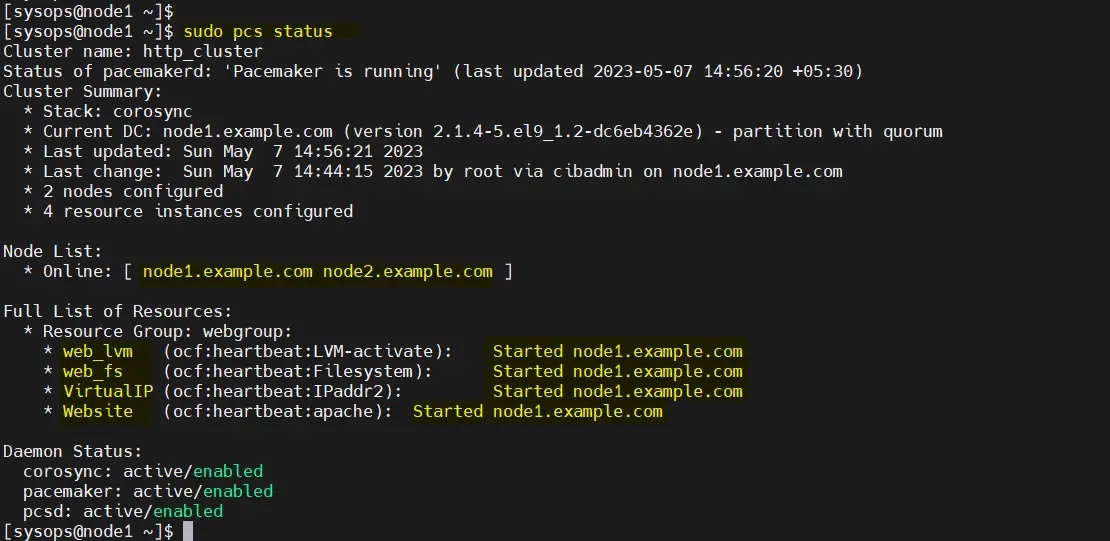

现在验证集群资源状态,运行:

$ sudo pcs status

很好,上面的输出显示所有资源都在 node1 上启动。

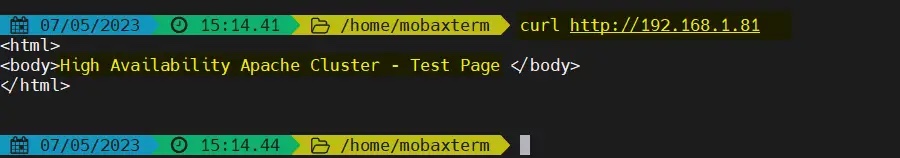

10、测试 Apache 集群

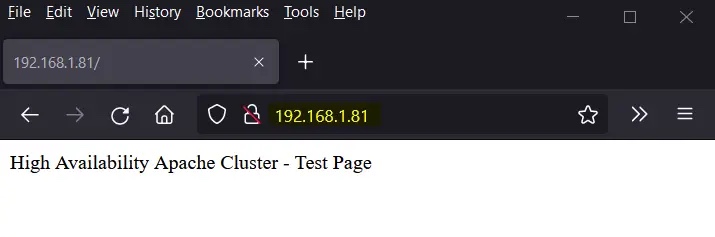

尝试使用 VIP(192.168.1.81)访问网页。

使用 curl 命令或网络浏览器访问网页:

$ curl http://192.168.1.81

或者

完美!以上输出确认我们能够访问我们高可用 Apache 集群的网页。

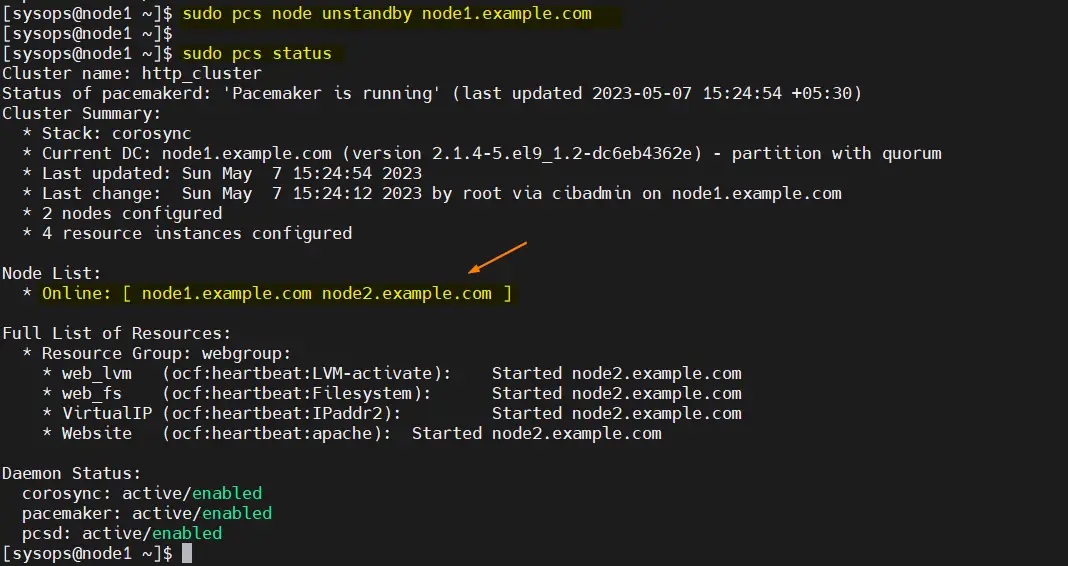

让我们尝试将集群资源从 node1 移动到 node2,运行:

$ sudo pcs node standby node1.example.com$ sudo pcs status

完美,以上输出确认集群资源已从 node1 迁移到 node2。

要从备用节点(node1.example.com)中删除节点,运行以下命令:

$ sudo pcs node unstandby node1.example.com

以上がRHEL 9/8 で高可用性 Apache (HTTP) クラスターをセットアップする方法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7454

7454

15

15

1374

1374

52

52

77

77

11

11

14

14

9

9

PHP フレームワークのパフォーマンス比較: 速度と効率の究極の対決

Apr 30, 2024 pm 12:27 PM

PHP フレームワークのパフォーマンス比較: 速度と効率の究極の対決

Apr 30, 2024 pm 12:27 PM

ベンチマークによると、Laravel はページの読み込み速度とデータベース クエリで優れており、CodeIgniter はデータ処理で優れています。 PHP フレームワークを選択するときは、アプリケーションのサイズ、トラフィック パターン、開発チームのスキルを考慮する必要があります。

Java 同時プログラミングで同時実行テストとデバッグを実行するにはどうすればよいですか?

May 09, 2024 am 09:33 AM

Java 同時プログラミングで同時実行テストとデバッグを実行するにはどうすればよいですか?

May 09, 2024 am 09:33 AM

同時実行テストとデバッグ Java 同時プログラミングにおける同時実行テストとデバッグは非常に重要であり、次の手法が利用可能です。 同時実行テスト: 単体テスト: 単一の同時タスクを分離してテストします。統合テスト: 複数の同時タスク間の相互作用をテストします。負荷テスト: 高負荷時のアプリケーションのパフォーマンスとスケーラビリティを評価します。同時実行デバッグ: ブレークポイント: スレッドの実行を一時停止し、変数を検査するかコードを実行します。ロギング: スレッドのイベントとステータスを記録します。スタック トレース: 例外のソースを特定します。視覚化ツール: スレッドのアクティビティとリソースの使用状況を監視します。

58 ポートレート プラットフォームの構築におけるアルゴリズムの適用

May 09, 2024 am 09:01 AM

58 ポートレート プラットフォームの構築におけるアルゴリズムの適用

May 09, 2024 am 09:01 AM

1. 58 Portraits プラットフォーム構築の背景 まず、58 Portraits プラットフォーム構築の背景についてお話ししたいと思います。 1. 従来のプロファイリング プラットフォームの従来の考え方ではもはや十分ではありません。ユーザー プロファイリング プラットフォームを構築するには、複数のビジネス分野からのデータを統合して、ユーザーの行動や関心を理解するためのデータ マイニングも必要です。最後に、ユーザー プロファイル データを効率的に保存、クエリ、共有し、プロファイル サービスを提供するためのデータ プラットフォーム機能も必要です。自社構築のビジネス プロファイリング プラットフォームとミドルオフィス プロファイリング プラットフォームの主な違いは、自社構築のプロファイリング プラットフォームは単一のビジネス ラインにサービスを提供し、オンデマンドでカスタマイズできることです。ミッドオフィス プラットフォームは複数のビジネス ラインにサービスを提供し、複雑な機能を備えていることです。モデリングを提供し、より一般的な機能を提供します。 2.58 中間プラットフォームのポートレート構築の背景のユーザーのポートレート 58

Eclipseにサーバーを追加する方法

May 05, 2024 pm 07:27 PM

Eclipseにサーバーを追加する方法

May 05, 2024 pm 07:27 PM

Eclipse にサーバーを追加するには、次の手順に従います。 サーバー ランタイム環境の作成 サーバーの構成 サーバー インスタンスの作成 サーバー ランタイム環境の選択 サーバー インスタンスの構成 サーバー デプロイメント プロジェクトの開始

回避モジュールは、アプリケーション層の DOS 攻撃から Web サイトを保護します。

Apr 30, 2024 pm 05:34 PM

回避モジュールは、アプリケーション層の DOS 攻撃から Web サイトを保護します。

Apr 30, 2024 pm 05:34 PM

Web サイトをオフラインにする攻撃方法はさまざまですが、より複雑な方法にはデータベースやプログラミングの技術的知識が必要です。より単純な方法は、「DenialOfService」(DOS) 攻撃と呼ばれます。この攻撃手法の名前は、一般の顧客や Web サイト訪問者からの通常のサービス要求を拒否させるという目的に由来しています。一般に、DOS 攻撃には 2 つの形式があります。OSI モデルの 3 番目と 4 番目の層、つまりネットワーク層の攻撃です。OSI モデルの 7 番目の層、つまり、アプリケーション層の攻撃です。攻撃 - ネットワーク層は、大量のジャンク トラフィックが Web サーバーに流れるときに発生します。スパム トラフィックがネットワークの処理能力を超えると、Web サイトがダウンします。 2 番目のタイプの DOS 攻撃はアプリケーション層で行われ、組み合わせて使用されます。

PHP を使用して Web サイトを展開および維持する方法

May 03, 2024 am 08:54 AM

PHP を使用して Web サイトを展開および維持する方法

May 03, 2024 am 08:54 AM

PHP Web サイトを正常に展開して維持するには、次の手順を実行する必要があります。 Web サーバー (Apache や Nginx など) を選択する PHP をインストールする データベースを作成して PHP に接続する コードをサーバーにアップロードする ドメイン名と DNS を設定する Web サイトのメンテナンスを監視する手順には、PHP および Web サーバーの更新、Web サイトのバックアップ、エラー ログの監視、コンテンツの更新が含まれます。

Kubernetes Operator を活用して PHP クラウド展開を簡素化するにはどうすればよいですか?

May 06, 2024 pm 04:51 PM

Kubernetes Operator を活用して PHP クラウド展開を簡素化するにはどうすればよいですか?

May 06, 2024 pm 04:51 PM

KubernetesOperator は、次の手順に従って PHP クラウド デプロイメントを簡素化します。 PHPOperator をインストールして、Kubernetes クラスターと対話します。 PHP アプリケーションをデプロイし、イメージとポートを宣言します。ログの取得、記述、表示などのコマンドを使用してアプリケーションを管理します。

PHP セキュリティのベスト プラクティスを実装する方法

May 05, 2024 am 10:51 AM

PHP セキュリティのベスト プラクティスを実装する方法

May 05, 2024 am 10:51 AM

PHP セキュリティのベスト プラクティスを実装する方法 PHP は、動的でインタラクティブな Web サイトの作成に使用される最も人気のあるバックエンド Web プログラミング言語の 1 つです。ただし、PHP コードはさまざまなセキュリティ脆弱性に対して脆弱になる可能性があります。 Web アプリケーションをこれらの脅威から保護するには、セキュリティのベスト プラクティスを実装することが重要です。入力検証 入力検証は、ユーザー入力を検証し、SQL インジェクションなどの悪意のある入力を防止するための重要な最初のステップです。 PHP は、filter_var() や preg_match() などのさまざまな入力検証関数を提供します。例: $username=filter_var($_POST['username'],FILTER_SANIT