テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

NetEase Yidun AI Lab の論文が ICASSP 2023 に選ばれました!ブラックテクノロジーにより、音声認識がより「聞きやすく」なり、より正確になります

NetEase Yidun AI Lab の論文が ICASSP 2023 に選ばれました!ブラックテクノロジーにより、音声認識がより「聞きやすく」なり、より正確になります

NetEase Yidun AI Lab の論文が ICASSP 2023 に選ばれました!ブラックテクノロジーにより、音声認識がより「聞きやすく」なり、より正確になります

2023-06-07 17:42:41 著者:李文文

すべての SF ファンは、旧友に話しかけるように、ほんの数語で星間宇宙船を打ち上げ、星と海を征服できるようになったり、アイアンマンの人工知能執事ジャービスが登場したりする未来を待ち望んでいます。ナノバトルアーマーのセットを作ることができます。実際、この写真は私たちから遠く離れたものではなく、iPhone の Siri と同じくらい私たちに近いものです。 その背後には自動音声認識テクノロジーがあります。 この主要テクノロジは、音声をコンピュータが認識できるテキストまたはコマンドに変換し、便利で効率的かつインテリジェントな人間とコンピュータの対話エクスペリエンスを実現します。

ディープラーニングなどの AI テクノロジーの発展により、音声認識テクノロジーは大幅に進歩しました。認識精度が大幅に向上しただけでなく、アクセント、ノイズ、背景音などの問題にもより適切に対処できるようになりました。しかし、テクノロジーが生活やビジネスに応用され続けるにつれて、理論研究から実用化、論文から製品に至るまで、考慮すべき実際的な要素が多すぎるため、依然としていくつかのボトルネックに遭遇することになります。 音声認識をより効果的にコンテンツレビューに役立てるにはどうすればよいですか?認識動作自体が人間の脳のように、コンテキストの理解に基づいて、より低コストでより正確な答えを与えるにはどうすればよいでしょうか? NetEase Intelligence の子会社である Yidun AI Lab は、新しいアプローチを提供しました。

Yidun が再びブラックテクノロジーを登場させ、賢い企業が世界へ向かっています!

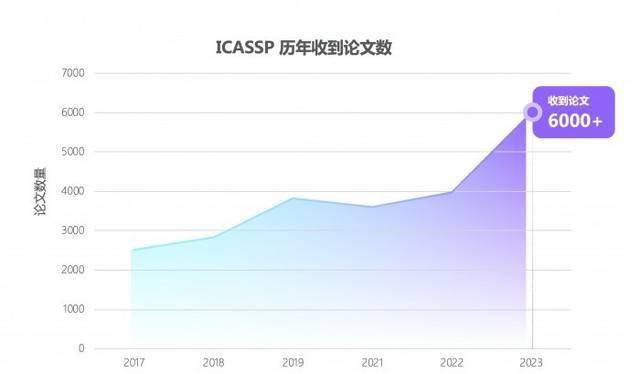

最近、世界的な音声音響カンファレンス ICASSP 2023 で選ばれた論文のリストが発表され、NetEase Intelligence Enterprise の子会社である Yidun AI Lab によって提出された論文が無事に採択されました。今年で48回目となるICASSP会議は、感染症流行後初のオフライン会議でもあり、会議関係者は最終的な論文採択数を発表していないが、提出された論文数は例年に比べて50%増加し、その数はなんと6,000。

このような熾烈な競争に直面して、NetEase Zhiqi Yidun AILab チームは音声認識に関する論文に頼りました 「ゲート型インタープレイヤー コラボレーションによる CTC ベースの ASRModels の改善 (より強力なモデルを実現するための CTC ベースのモデルの改善)」の構造) 》 は目立って、ギリシャのロードス島でのオフラインカンファレンスに参加するためのチケットを無事に入手しました。

「GIC」、音声認識のさらなる進歩を支援します

音声認識は本質的に音声シーケンスをテキスト シーケンスに変換することです。このような変換を完了するには、通常、CTC、アテンションベース、RNN トランスデューサーの 3 種類のモデルを使用します。これらは異なるパスを完了します。タスク中に使用されました:

CTC: ニューラル ネットワーク モデルに基づいて、トレーニング プロセス中にバックプロパゲーションを通じてモデル パラメーターが更新され、損失関数が最小限に抑えられます。このアルゴリズムでは、意味のない文字またはスペース記号を表すために「空白文字」が導入されます。 CTC は、音声認識における音響特徴のテキストへのマッピングなど、入力長と出力長に大きな差があるデータの処理に適しています。 アテンション ベース: アテンション メカニズムもニューラル ネットワーク モデルに基づいており、「アテンション」と呼ばれるテクノロジーを使用して入力に重み付けを行います。各タイム ステップで、モデルは現在の状態とすべての入力に基づいて分散重みベクトルを計算し、それをすべての入力に適用して重み付き平均を出力として生成します。

この方法により、モデルは現在の予測に関連する一部の情報に焦点を当てることができます;RNN-Transducer: Transcriptor、このアルゴリズムは、エンコーダー/デコーダー フレームワークと自己回帰モデリングのアイデアを組み合わせたもので、ターゲット シーケンスを生成するときに、ソース言語の文と生成された部分的なターゲット言語の文の間の相互作用を考慮します。他の 2 つの方法とは異なり、

RNN-Transducer はエンコーダ段階とデコーダ段階を明確に区別せず、ソース言語からターゲット言語に直接変換するため、ソース言語の文と生成された部分的なターゲット言語の文の間で同時に考慮することができます。 。後者の 2 つと比較すると、

CTCには自然な非自己回帰デコード特性が備わっており、デコード速度は比較的高速ですが、依然としてパフォーマンス上の欠点があります: 1. CTC アルゴリズムは 条件付き独立性仮定

を設定します。つまり、CTC は各タイム ステップの出力が独立していると仮定します。これは音声認識タスクにとっては合理的ではなく、「ジ ロウ」という発音が発音された場合、予測されるテキストの内容はコンテキストによって異なるはずです。上の文が「食べるのが好きです」であれば「鶏肉」の確率が高く、同様に上の文が「腕がある」であれば「筋肉」の確率が高いはずです。CTC トレーニングに合格すると、上記を無視して「筋肉を食べるのが好きです」などの面白いテキストを出力するのは簡単です; 2. モデリングの観点から見ると、アテンションベースのモデルと RNN トランスデューサー モデルは、前のタイム ステップの入力と出力に基づいて現在のタイム ステップの出力を予測しますが、CTC モデルは入力のみを使用します。 CTC モデルのモデリング プロセス中、テキスト情報は監視信号としてネットワークに返されるだけであり、モデルの予測を明示的に促進するためのネットワークへの入力としては機能しません。

CTC のデコード効率を維持しながら、上記 2 つの欠点を可能な限り解決したいと考えています。したがって、CTC モデル自体から開始して、CTC ベースのモデルにテキスト情報を導入する軽量モジュールを設計して、モデルが音響情報とテキスト情報を統合し、テキスト シーケンス コンテキストと の間の相互作用を学習できるようにしたいと考えています。 CTC アルゴリズム の条件付き独立性の仮定を緩和します。しかし、その過程で 2 つの問題に遭遇しました: CTC モデル (エンコーダー CTC 構造) にテキスト情報を挿入するにはどうすればよいですか?テキストの特徴と音響の特徴を適応的に融合するにはどうすればよいでしょうか?

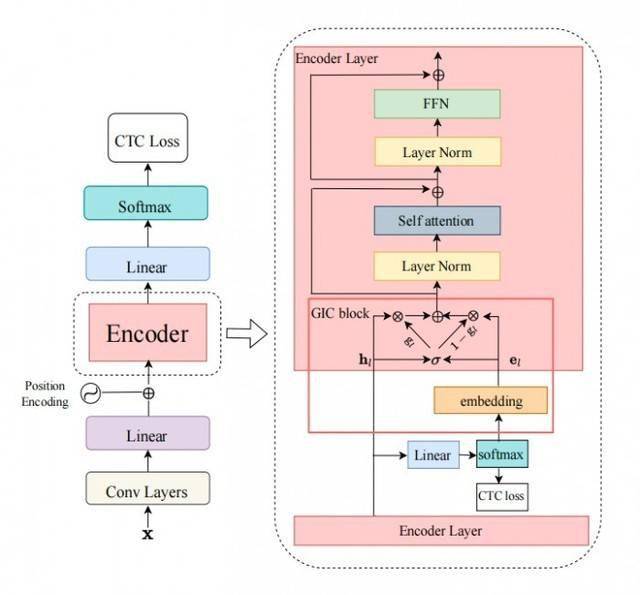

上記の目標を達成するために、Gated Interlayer Collaboration (GIC と略称) メカニズムを設計しました。 GIC モジュールは主に埋め込み層とゲート ユニットで構成されます。このうち、埋め込み層は音声入力フレームごとにテキスト情報を生成するために使用され、ゲーティングユニットはテキスト情報と音響情報を適応的に融合するために使用されます。

具体的には、私たちの方法はマルチタスク学習 (Multi-taskLearning) フレームワークに基づいており、エンコーダ モジュール (Encoder) の中間層の出力を使用して補助 CTC 損失を計算します。は最後の層と中間層の CTC 損失であり、層による CTC 損失の加重合計です。 GIC は、ネットワークの中間層の予測、つまりソフトマックス出力の確率分布を各フレームのソフト ラベルとして使用し、ドット積埋め込み層行列の合計を各フレームのテキスト表現として使用します。最後に、生成されたテキスト表現と音響表現はゲート制御ユニットを通じて適応的に融合され、次の層への新しい特徴入力になります。現時点での新機能はテキスト特徴と音響特徴を組み合わせているため、Encoder モジュールの次の層は音響シーケンス コンテキスト情報とテキスト シーケンス コンテキスト情報を学習できます。 モデル全体の枠組みを次の図に示します。

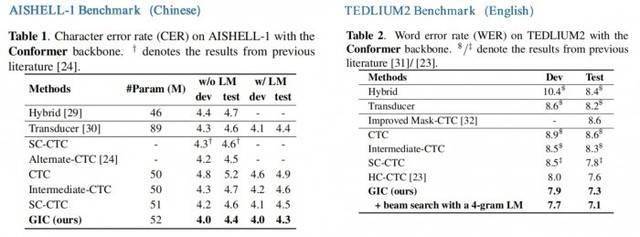

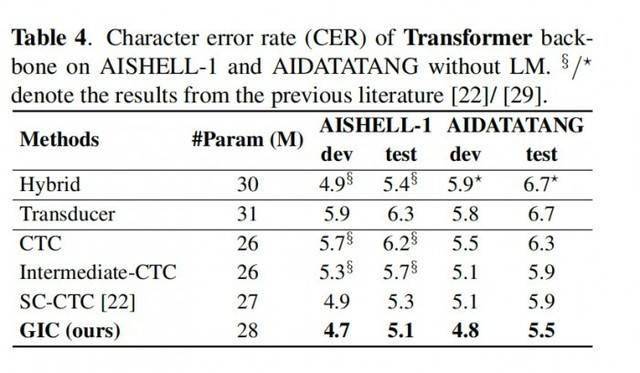

Conformer モデルと Transformer モデルの実験では次のことがわかります:1. GIC

中国語と英語の両方でシーン認識をサポートし、精度の大幅なパフォーマンス向上を達成しました; 2. GIC モデルのパフォーマンスは、同じパラメーター スケールのアテンションベースおよび RNN トランスデューサー モデルのパフォーマンスを上回り、非自己回帰デコードの利点があり、

デコード速度が数倍向上します; 3. 元の CTC モデルと比較して、GIC は複数のオープンソース データ セット

で 10% をはるかに超える相対的なパフォーマンス向上を実現しています。適合者

モデルに基づく結論 トランスフォーマー

モデルに基づいた結論 GIC は、CTC モデルのパフォーマンスを大幅に向上させます。元の CTC モデルと比較して、GIC モジュールは約 200 万個の追加パラメータをもたらしますが、このうち、中間層の補助 CTC 損失の計算に使用される線形層は最後の層と共有され、追加パラメータは生じません。複数の中間層が埋め込み層を共有し、1.3M にほぼ等しい 256*5000 パラメータをもたらします。また、複数のコントロールゲートユニットに必要な追加パラメータの量は、256*256*2*k で、合計約 0.6M になります。

最先端のテクノロジーが高度なビジネスを生み出す

論文内の GIC は、NetEase Yidun のコンテンツ レビュー ビジネスに適用されています。

NetEase Intelligence 傘下のデジタル コンテンツ リスク管理のワンストップ ブランドとして、Yidun はデジタル コンテンツのセキュリティ リスク管理とスパム対策情報における技術研究開発と革新に長年注力してきました。その中で、音声をキャリアとして使用するデジタルコンテンツに対して、Yidunは歌、ラジオ、テレビ番組、生放送などのさまざまなタイプのオーディオコンテンツを含むさまざまなオーディオコンテンツ監査エンジンを提供し、コンテンツを迅速に検出してフィルタリングします。コンテンツの音声を広告することで、悪質なコンテンツによる社会的影響を軽減し、良好なネットワーク環境を構築します。特定の意味内容を持つ音声の場合、Yidun は音声認識技術を使用して音声ファイル内の音声内容をテキスト コンテンツに変換し、検出モジュールを使用してテキストを分析および処理することで、音声の自動レビューとフィルタリングを実現します。コンテンツ。

したがって、音声認識の精度は音声コンテンツレビューの効率と精度に密接に関係しており、お客様の業務運営の安全性と安定性に直接影響します。

論文の内容レビューにおける GIC の適用により、大幅な改善が達成されました。

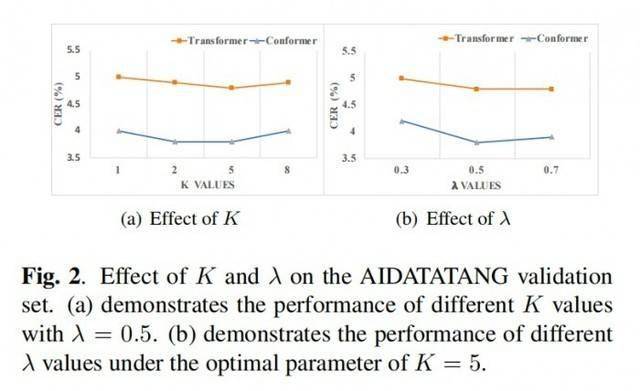

実際のアプリケーション プロセスでは、デバッグが必要な 2 つのハイパーパラメーター、つまりマルチタスク学習係数 lambda と中間層の数 k があります。 18 層エンコーダ構造では、k=5 および lambda=0.5 の方がより良い実験結果が得られることがわかりました。次に、この設定から開始して微調整して、最適なハイパーパラメーターを決定します。?

舞台裏のヒーロー: NetEase Zhiqi Yidun AI Lab

Yidun AI Lab チームがこのような栄誉を受けたのはこれが初めてではありません。

NetEase Intelligent Enterprise 傘下の技術チームとして、常に人工知能研究の最前線に立っている Yidun AI Lab は、洗練、軽量化、俊敏性を中心とした包括的で厳格、安全で信頼できる AI 技術能力の構築に取り組んでおり、継続的に取り組んでいます。デジタルコンテンツのリスク管理サービスレベルの向上。これに先立ち、チームは複数の AI アルゴリズム コンテストで優勝し、重要な賞を受賞しました:

2019 年第 1 回中国人工知能コンテスト国旗認識トラックで最も先進的な A レベルの証明書を取得

2020 年第 2 回中国人工知能コンテストビデオディープ偽造検出トラックで最も先進的な A レベルの証明書を取得2021 年第 3 回中国人工知能コンテストビデオのディープ偽造検出とオーディオのディープ偽造検出トラックの 2 つの最も高度な A レベル証明書

2021中国人工知能産業発展同盟の「イノベーションスター」および「革新的人物」

2021 第 16 回全国ヒューマンコンピュータ音声コミュニケーション学術会議 (NCMMSC2021) 「長短ビデオ多言語マルチモーダル認識コンテスト」 - 中国語長短ビデオ 生音声キーワード (VKW) ダブルトラックチャンピオン

2021年浙江省政府発行の科学技術進歩賞の一等賞を受賞

2022 ICPR マルチモーダル字幕認識コンペティション (MSR コンペティション、中国初のマルチモーダル字幕認識コンペティション) トラック 3「視覚と音声を統合したマルチモーダル字幕認識システム」優勝

未来はここにあり、AI の iPhone の時代が到来しました。イドゥンは今日、音声学の学術の殿堂に無事入りました。将来、テクノロジーはビジネスのあらゆる側面に成果と進歩をもたらします。イドゥンは常にあなたのそばにいます。

以上がNetEase Yidun AI Lab の論文が ICASSP 2023 に選ばれました!ブラックテクノロジーにより、音声認識がより「聞きやすく」なり、より正確になりますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7569

7569

15

15

1386

1386

52

52

87

87

11

11

28

28

107

107

カーソルAIでバイブコーディングを試してみましたが、驚くべきことです!

Mar 20, 2025 pm 03:34 PM

カーソルAIでバイブコーディングを試してみましたが、驚くべきことです!

Mar 20, 2025 pm 03:34 PM

バイブコーディングは、無限のコード行の代わりに自然言語を使用してアプリケーションを作成できるようにすることにより、ソフトウェア開発の世界を再構築しています。 Andrej Karpathyのような先見の明に触発されて、この革新的なアプローチは開発を許可します

2025年2月のトップ5 Genai発売:GPT-4.5、Grok-3など!

Mar 22, 2025 am 10:58 AM

2025年2月のトップ5 Genai発売:GPT-4.5、Grok-3など!

Mar 22, 2025 am 10:58 AM

2025年2月は、生成AIにとってさらにゲームを変える月であり、最も期待されるモデルのアップグレードと画期的な新機能のいくつかをもたらしました。 Xai’s Grok 3とAnthropic's Claude 3.7 SonnetからOpenaiのGまで

オブジェクト検出にYolo V12を使用する方法は?

Mar 22, 2025 am 11:07 AM

オブジェクト検出にYolo V12を使用する方法は?

Mar 22, 2025 am 11:07 AM

Yolo(あなたは一度だけ見ています)は、前のバージョンで各反復が改善され、主要なリアルタイムオブジェクト検出フレームワークでした。最新バージョンYolo V12は、精度を大幅に向上させる進歩を紹介します

クリエイティブプロジェクトのための最高のAIアートジェネレーター(無料&有料)

Apr 02, 2025 pm 06:10 PM

クリエイティブプロジェクトのための最高のAIアートジェネレーター(無料&有料)

Apr 02, 2025 pm 06:10 PM

この記事では、トップAIアートジェネレーターをレビューし、その機能、創造的なプロジェクトへの適合性、価値について説明します。 Midjourneyを専門家にとって最高の価値として強調し、高品質でカスタマイズ可能なアートにDall-E 2を推奨しています。

ChatGpt 4 oは利用できますか?

Mar 28, 2025 pm 05:29 PM

ChatGpt 4 oは利用できますか?

Mar 28, 2025 pm 05:29 PM

CHATGPT 4は現在利用可能で広く使用されており、CHATGPT 3.5のような前任者と比較して、コンテキストを理解し、一貫した応答を生成することに大幅な改善を示しています。将来の開発には、よりパーソナライズされたインターが含まれる場合があります

ベストAIチャットボットが比較されました(chatgpt、gemini、claude& more)

Apr 02, 2025 pm 06:09 PM

ベストAIチャットボットが比較されました(chatgpt、gemini、claude& more)

Apr 02, 2025 pm 06:09 PM

この記事では、ChatGpt、Gemini、ClaudeなどのトップAIチャットボットを比較し、自然言語の処理と信頼性における独自の機能、カスタマイズオプション、パフォーマンスに焦点を当てています。

次のラグモデルにミストラルOCRを使用する方法

Mar 21, 2025 am 11:11 AM

次のラグモデルにミストラルOCRを使用する方法

Mar 21, 2025 am 11:11 AM

Mistral OCR:マルチモーダルドキュメントの理解により、検索された世代の革命を起こします 検索された生成(RAG)システムはAI機能を大幅に進めており、より多くの情報に基づいた応答のために膨大なデータストアにアクセスできるようになりました

トップAIライティングアシスタントは、コンテンツの作成を後押しします

Apr 02, 2025 pm 06:11 PM

トップAIライティングアシスタントは、コンテンツの作成を後押しします

Apr 02, 2025 pm 06:11 PM

この記事では、Grammarly、Jasper、Copy.ai、Writesonic、RytrなどのトップAIライティングアシスタントについて説明し、コンテンツ作成のためのユニークな機能に焦点を当てています。 JasperがSEOの最適化に優れているのに対し、AIツールはトーンの維持に役立つと主張します