Transformer 6 周年: 当時は NeurIPS Oral さえ入手できませんでしたが、8 人の著者が複数の AI ユニコーンを設立しました

ChatGPT から AI 描画テクノロジに至るまで、人工知能分野におけるこの最近のブレークスルーの波は、Transformer のおかげかもしれません。

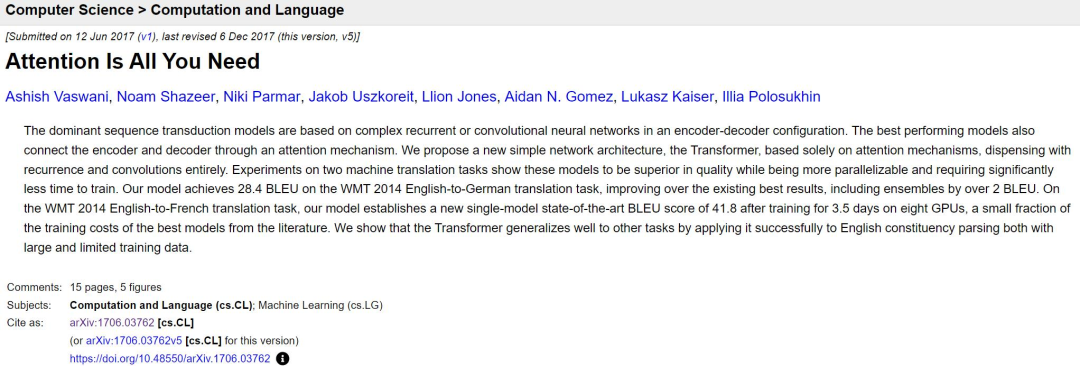

今日は、有名な変圧器の論文の提出から 6 周年です。

論文リンク: https://arxiv.org/abs/1706.03762

6年前、プレプリント論文プラットフォームarXivに少々大げさな名前の論文がアップロードされ、「xx is All You Need」という文がAI分野の開発者らによって繰り返し繰り返されました。論文タイトルのトレンドにもなり、Transformer はもはやトランスフォーマーを意味するものではなく、AI 分野における最先端のテクノロジーを意味するようになりました。

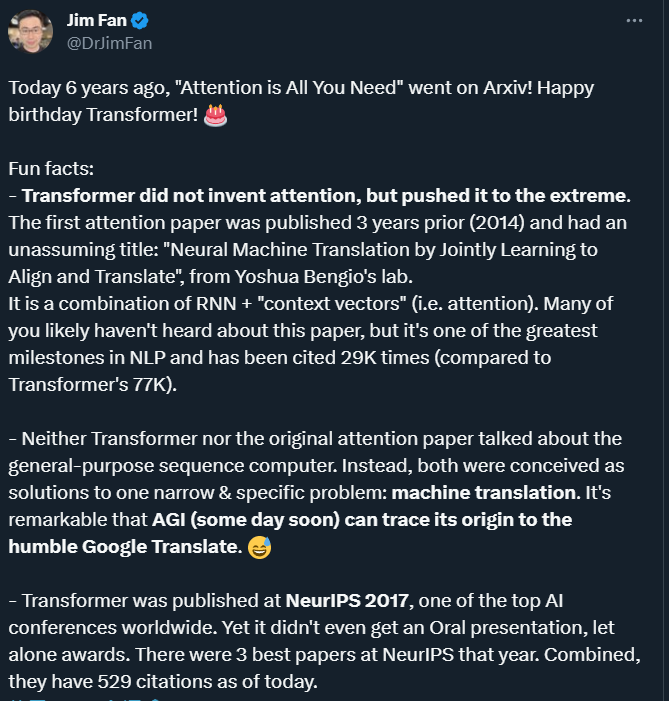

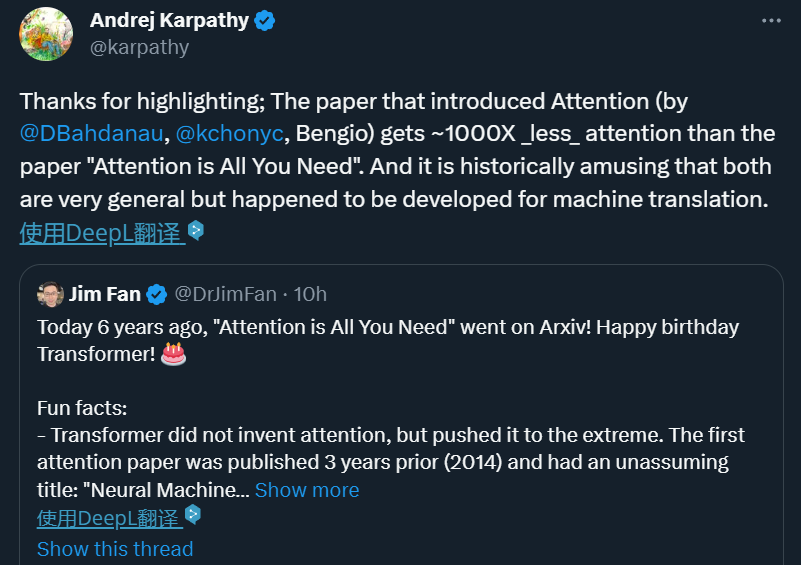

6 年後、この論文を振り返ると、NVIDIA AI 科学者 Jim Fan が要約したように、多くの興味深い側面やあまり知られていない側面を見つけることができます。

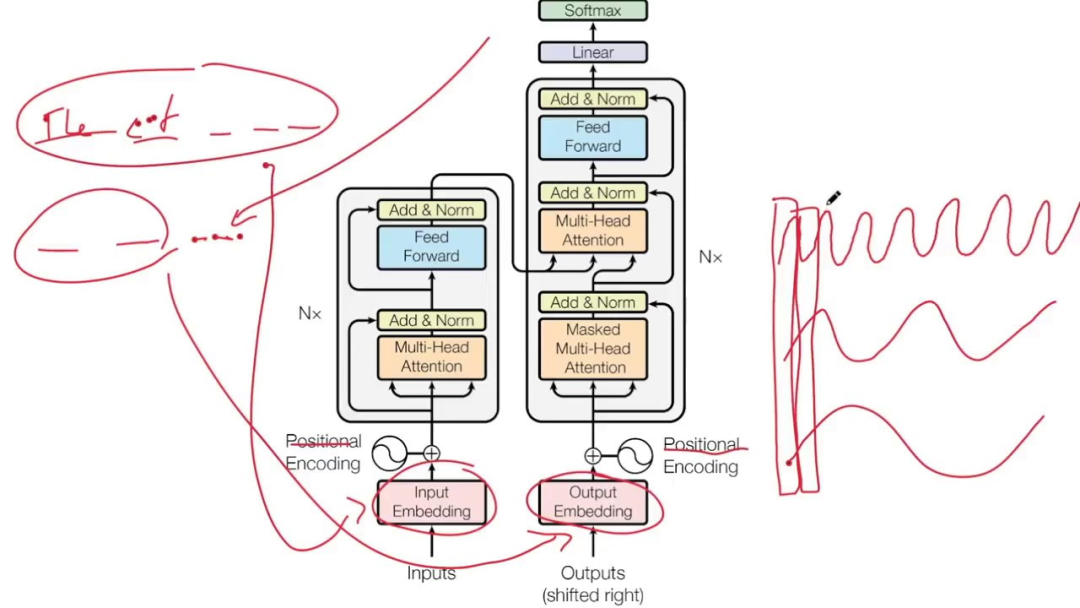

Transformer モデルは、伝統 CNN と RNN ユニットのネットワーク構造全体は、完全にアテンション メカニズムで構成されています。

Transformer の論文の名前は「Attending is All You Need」であり、そのおかげで私たちは注意のメカニズムを称賛し続けていますが、興味深い事実に注意してください。これは Transformer の論文ではありません。研究 研究者たちは注意力を発明しましたが、このメカニズムを極限まで推し進めました。

アテンション メカニズムは、深層学習のパイオニアであるヨシュア ベンジオ氏が率いるチームによって 2014 年に提案されました。

「Neural Machine Translation by Jointly」 Learning to Align and Translate」というタイトルは比較的シンプルです。

この ICLR 2015 論文で、Bengio らは、RNN の「コンテキスト ベクトル」 (つまり、注意) の組み合わせを提案しました。これは NLP 分野における最大のマイルストーンの 1 つですが、Transformer ほど知名度は低く、Bengio チームの論文はこれまでに 29,000 回引用され、Transformer は 77,000 回引用されています。

地域の情報を一切手放さないと、必然的に無駄な仕事が多くなり、生き残ることはできません。同様に、同様のメカニズムを深層学習ネットワークに導入すると、モデルが簡素化され、計算が高速化されます。本質的に、注意とは、大量の情報から少量の重要な情報をフィルタリングし、重要でない情報の大部分を無視しながら、この重要な情報に焦点を当てることです。

近年、アテンション メカニズムは、コンピューター ビジョンの方向で画像上の受容野をキャプチャしたり、画像内のキー トークンを特定したりするなど、深層学習のさまざまな分野で広く使用されています。 NLP、または特性。多数の実験により、アテンション メカニズムを備えたモデルが、画像分類、セグメンテーション、追跡、強調、および自然言語認識、理解、質問応答、翻訳などのタスクにおいて大幅なパフォーマンスの向上を達成したことが証明されています。

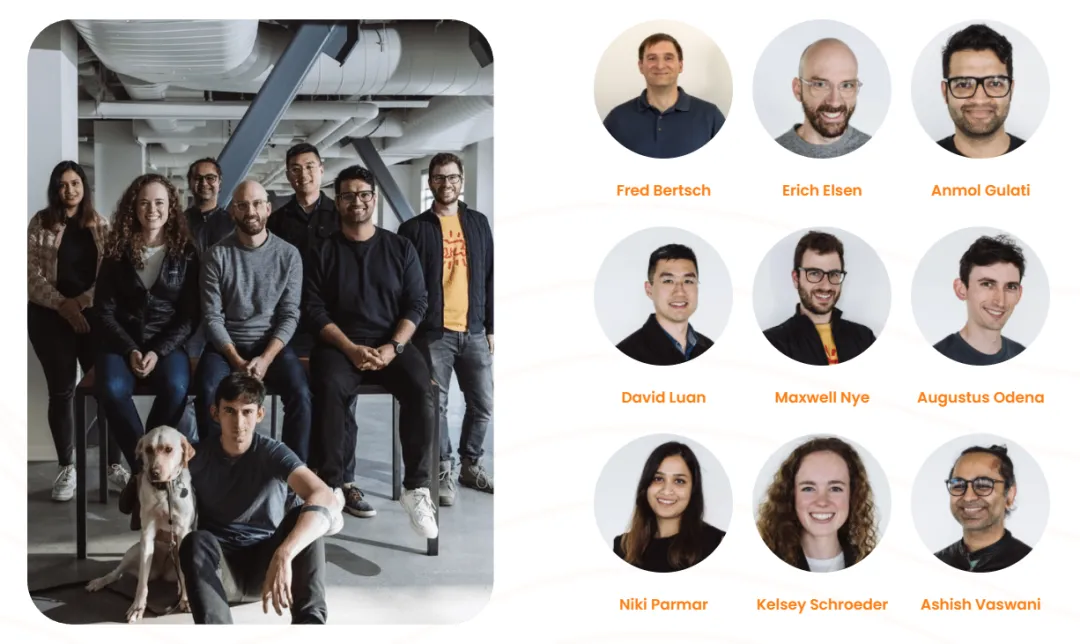

アテンション メカニズムを導入した Transformer モデルは、汎用シーケンス コンピュータとみなすことができます。アテンション メカニズムにより、モデルは入力シーケンスを処理する際に、シーケンス内の異なる位置の相関に基づいて異なる割り当てを割り当てることができます。アテンション ウェイトにより、Transformer は長距離の依存関係とコンテキスト情報をキャプチャできるようになり、シーケンス処理の効果が向上します。 しかし、当時、Transformer も最初の注目の論文もユニバーサル シーケンス コンピューターについては触れていませんでした。むしろ、著者らはこれを、機械翻訳という狭くて特定の問題を解決するためのメカニズムとして見ています。したがって、将来、AGI の起源をたどると、「謙虚な」Google 翻訳にまで遡ることができるかもしれません。 Transformer この論文は現在非常に影響力がありますが、2017 年のトップ AI ではありませんでした。その年、カンファレンス NeurIPS 2017 では、賞はおろか、口頭発表さえも得られませんでした。その年、カンファレンスには合計 3,240 件の論文投稿があり、そのうち 678 件がカンファレンス論文として選ばれました。Transformer 論文は受理された論文の 1 つでした。これらの論文のうち、40 件が口頭論文、112 件がスポットライト論文、そして 3 件が最優秀論文に選ばれました。論文、時間の試練賞、Transformer は賞の対象外です。 NeurIPS 2017 論文賞は逃しましたが、Transformer の影響は誰の目にも明らかです。 ジム・ファンは次のようにコメントしました: 影響力のある研究が影響力を持つようになる前に、人々がその重要性に気づくのが難しいのは審査員のせいではありません。ただし、幸運にもすぐに発見された論文もあり、たとえば、He Yuming 氏らが提案した ResNet が CVPR 2016 の最優秀論文を受賞しました。この研究は当然のことであり、AI のトップカンファレンスで正しく評価されました。しかし、2017 年の時点では、非常に賢明な研究者であっても、LLM によってもたらされる変化を予測することはできないかもしれません。1980 年代と同様に、2012 年以降にディープラーニングによってもたらされた津波を予測できた人はほとんどいませんでした。 当時、この論文の著者は 8 名で、Google とトロント大学の出身でした。 、そのほとんどは、論文の著者全員が元の機関を辞めています。 2022 年 4 月 26 日、「Adept」という会社が正式に設立されました。共同創設者は 9 名で、その中にはトランスフォーマー論文の著者の 2 人である Ashish Vaswani と Niki も含まれます。パルマル。 ##アシシュ バスワニ 南カリフォルニア大学で中国人学者の David Chiang 氏と Liang Huang 氏の指導のもとで博士号を取得し、主に言語モデリングにおける現代の深層学習の初期応用を研究しました。 2016 年に Google Brain に入社し、Transformer 研究を主導し、2021 年に Google を退社しました。 Niki Parmar 南カリフォルニア大学を修士号を取得して卒業し、2016 年に Google に入社しました。そこにいる間、彼女は Google 検索と広告用の Q&A モデルとテキスト類似性モデルをいくつか開発し、成功を収めました。彼女は、Transformer モデルを画像生成、コンピューター ビジョンなどの分野に拡張する初期の作業を主導しました。 2021年に彼女もGoogleを退職した。 退職後、2 人は Adept を共同設立し、それぞれ主任科学者 (Ashish Vaswani) と最高技術責任者 (Niki Parmar) を務めました。 Adept のビジョンは、さまざまなソフトウェア ツールや API を使用できるように訓練された「人工知能チームメイト」と呼ばれる AI を作成することです。 2023 年 3 月、アデプトはシリーズ B で 3 億 5,000 万米ドルの資金調達が完了したことを発表し、企業評価額は 10 億米ドルを超え、ユニコーン企業となりました。しかし、Adept が公的に資金を調達するまでに、Niki Parmar と Ashish Vaswani は Adept を去り、独自の新しい AI 会社を設立していました。しかし、この新会社は依然として機密扱いであり、会社に関する詳細な情報を入手することはできません。 もう一人の論文著者 Noam Shazeer は、Google の初期の最も重要な従業員の 1 人です。彼は 2000 年末に Google に入社し、2021 年に退社し、その後「Character.AI」という新興企業の CEO になりました。 Character.AI の創設者は、Noam Shazeer に加えて、Daniel De Freitas であり、2 人とも Google の LaMDA チームの出身です。以前、彼らは Google の会話プログラムをサポートする言語モデルである LaMDA を構築しました。 今年 3 月、Character.AI は 1 億 5,000 万米ドルの資金調達が完了し、評価額は 10 億米ドルに達したと発表しました。 ChatGPTが所属するOpenAIと競合する企業でもあり、わずか16ヶ月でユニコーンに成長した稀有な企業です。そのアプリケーションである Character.AI は、人間のようなテキスト応答を生成し、状況に応じた会話を行うことができるニューラル言語モデルのチャットボットです。 Character.AI は、2023 年 5 月 23 日に Apple App Store と Google Play ストアでリリースされ、最初の週に 170 万回以上ダウンロードされました。 2023 年 5 月、このサービスは c.ai と呼ばれる月額 9.99 ドルの有料サブスクリプションを追加しました。これにより、ユーザーは優先チャット アクセス、応答時間の短縮、新機能への早期アクセスなどの特典が得られます。 NeurIPS 2017 には受理されましたが、Oral すら獲得できませんでした

8 人の著者、それぞれ素晴らしい人生を歩んでいます

Aidan N. Gomez 2019 年に Google を退社その後、FOR.ai で研究者として働き、現在は Cohere の共同創設者兼 CEO です。

Cohere は、2019 年に設立された生成 AI スタートアップです。その中核事業には、NLP モデルの提供と、企業による人間とコンピューターのインタラクションの改善支援が含まれます。創設者の 3 人は Ivan Zhang、Nick Frosst、Aidan Gomez で、このうち Gomez と Frosst は Google Brain チームの元メンバーです。 2021 年 11 月、Google Cloud は Cohere と提携し、Google Cloud はその堅牢なインフラストラクチャを使用して Cohere プラットフォームを強化し、Cohere は Cloud の TPU を使用して製品の開発とデプロイを行うことを発表しました。

Cohere がシリーズ C 資金調達で 2 億 7,000 万米ドルを受け取り、時価総額 22 億米ドルのユニコーンになったことは注目に値します。

Łukasz Kaiser2021 年に Google を退職し、Google で働く I 7年9ヶ月勤務し、現在はOpenAIの研究員をしています。 Google で研究員として働きながら、機械翻訳、解析、その他のアルゴリズムおよび生成タスク用の SOTA ニューラル モデルの設計に参加し、TensorFlow システムと Tensor2Tensor ライブラリの共著者でもあります。

Jakob Uszkoreit は 2021 年に Google を退職し、Google After で働きました13 年後、彼は Inceptive に入社し、共同創設者になりました。 Inceptive は、深層学習を使用して RNA 医薬品を設計することに特化した AI 製薬会社です。

Jakob Uszkoreit は、Google で働いている間、Google アシスタントの言語理解チームの結成に参加し、初期には Google 翻訳にも取り組みました。

Illia Polosukhin は 2017 年に Google を退職し、現在は NEAR Co に勤務しています。 -.AI (ブロックチェーン基盤テクノロジー企業) の創設者兼 CTO。

Google に残っているのは リオン ジョーンズ だけです, 今年で Google に入社して 9 年目になります。

論文「Attention Is All You Need」の出版から 6 年が経過しました。著者には退職を選択する人もいれば、Google に残ることを選択する人もいます。何があろうとも、Transformer の影響力は続きます。

以上がTransformer 6 周年: 当時は NeurIPS Oral さえ入手できませんでしたが、8 人の著者が複数の AI ユニコーンを設立しましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7530

7530

15

15

1378

1378

52

52

82

82

11

11

21

21

76

76

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverのファイアウォールの構成は、サーバーのセキュリティを確保するための重要なステップです。以下は、iPtablesやFirewalldの使用を含む、一般的に使用されるファイアウォール構成方法です。 iPtablesを使用してファイアウォールを構成してIPTablesをインストールします(まだインストールされていない場合):sudoapt-getupdatesudoapt-getinstalliptablesview現在のiptablesルール:sudoiptables-l configuration

Debian Apacheログレベルを設定する方法

Apr 13, 2025 am 08:33 AM

Debian Apacheログレベルを設定する方法

Apr 13, 2025 am 08:33 AM

この記事では、DebianシステムのApachewebサーバーのロギングレベルを調整する方法について説明します。構成ファイルを変更することにより、Apacheによって記録されたログ情報の冗長レベルを制御できます。方法1:メイン構成ファイルを変更して、構成ファイルを見つけます。Apache2.xの構成ファイルは、通常/etc/apache2/ディレクトリにあります。ファイル名は、インストール方法に応じて、apache2.confまたはhttpd.confである場合があります。構成ファイルの編集:テキストエディターを使用してルートアクセス許可を使用して構成ファイルを開く(nanoなど):sudonano/etc/apache2/apache2.conf

Debian Readdirのパフォーマンスを最適化する方法

Apr 13, 2025 am 08:48 AM

Debian Readdirのパフォーマンスを最適化する方法

Apr 13, 2025 am 08:48 AM

Debian Systemsでは、Directoryコンテンツを読み取るためにReadDirシステム呼び出しが使用されます。パフォーマンスが良くない場合は、次の最適化戦略を試してください。ディレクトリファイルの数を簡素化します。大きなディレクトリをできる限り複数の小さなディレクトリに分割し、Readdirコールごとに処理されたアイテムの数を減らします。ディレクトリコンテンツのキャッシュを有効にする:キャッシュメカニズムを構築し、定期的にキャッシュを更新するか、ディレクトリコンテンツが変更されたときに、頻繁な呼び出しをreaddirに削減します。メモリキャッシュ(memcachedやredisなど)またはローカルキャッシュ(ファイルやデータベースなど)を考慮することができます。効率的なデータ構造を採用する:ディレクトリトラバーサルを自分で実装する場合、より効率的なデータ構造(線形検索の代わりにハッシュテーブルなど)を選択してディレクトリ情報を保存およびアクセスする

Debian Readdirが他のツールと統合する方法

Apr 13, 2025 am 09:42 AM

Debian Readdirが他のツールと統合する方法

Apr 13, 2025 am 09:42 AM

DebianシステムのReadDir関数は、ディレクトリコンテンツの読み取りに使用されるシステムコールであり、Cプログラミングでよく使用されます。この記事では、ReadDirを他のツールと統合して機能を強化する方法について説明します。方法1:C言語プログラムを最初にパイプラインと組み合わせて、cプログラムを作成してreaddir関数を呼び出して結果をinclude#include#include inctargc、char*argv []){dir*dir; structdireant*entry; if(argc!= 2){(argc!= 2){

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail ServerにSSL証明書をインストールする手順は次のとおりです。1。最初にOpenSSL Toolkitをインストールすると、OpenSSLツールキットがシステムに既にインストールされていることを確認してください。インストールされていない場合は、次のコマンドを使用してインストールできます。sudoapt-getUpdatesudoapt-getInstalopenssl2。秘密キーと証明書のリクエストを生成次に、OpenSSLを使用して2048ビットRSA秘密キーと証明書リクエスト(CSR)を生成します:Openss

Debian Readdirによるファイルソートを実装する方法

Apr 13, 2025 am 09:06 AM

Debian Readdirによるファイルソートを実装する方法

Apr 13, 2025 am 09:06 AM

Debian Systemsでは、Readdir関数はディレクトリコンテンツを読み取るために使用されますが、それが戻る順序は事前に定義されていません。ディレクトリ内のファイルを並べ替えるには、最初にすべてのファイルを読み取り、QSORT関数を使用してソートする必要があります。次のコードは、debianシステムにreaddirとqsortを使用してディレクトリファイルを並べ替える方法を示しています。

Debian OpenSSLでデジタル署名検証を実行する方法

Apr 13, 2025 am 11:09 AM

Debian OpenSSLでデジタル署名検証を実行する方法

Apr 13, 2025 am 11:09 AM

Debianシステムでのデジタル署名検証にOpenSSLを使用すると、次の手順に従うことができます。OpenSSL:Debianシステムがインストールされていることを確認してください。インストールされていない場合は、次のコマンドを使用してインストールできます。sudoaptupdatesudoaptinInstallopensslslに公開キーを取得できます。デジタル署名検証には、署名者の公開キーが必要です。通常、公開キーは、public_key.peなどのファイルの形で提供されます

Debian OpenSSLがどのように中間の攻撃を防ぐか

Apr 13, 2025 am 10:30 AM

Debian OpenSSLがどのように中間の攻撃を防ぐか

Apr 13, 2025 am 10:30 AM

Debian Systemsでは、OpenSSLは暗号化、復号化、証明書管理のための重要なライブラリです。中間の攻撃(MITM)を防ぐために、以下の測定値をとることができます。HTTPSを使用する:すべてのネットワーク要求がHTTPの代わりにHTTPSプロトコルを使用していることを確認してください。 HTTPSは、TLS(Transport Layer Security Protocol)を使用して通信データを暗号化し、送信中にデータが盗まれたり改ざんされたりしないようにします。サーバー証明書の確認:クライアントのサーバー証明書を手動で確認して、信頼できることを確認します。サーバーは、urlsessionのデリゲート方法を介して手動で検証できます