ウェブクローラーとは何ですか

テクニカル SEO に関しては、それがどのように機能するかを理解するのが難しい場合があります。しかし、ウェブサイトを最適化し、より多くの視聴者にリーチするには、できるだけ多くの知識を得ることが重要です。 SEO で重要な役割を果たすツールの 1 つが Web クローラーです。

Web クローラー (Web スパイダーとも呼ばれる) は、インターネット上のコンテンツを検索し、インデックスを作成するロボットです。基本的に、Web クローラーは、クエリが行われたときに Web ページ上のコンテンツを取得するために、そのコンテンツを理解する責任があります。

「これらの Web クローラーを実行しているのは誰ですか?」と疑問に思われるかもしれません。

通常、Web クローラーは独自のアルゴリズムを持つ検索エンジンによって操作されます。このアルゴリズムは、検索クエリに応じて関連情報を見つける方法を Web クローラーに指示します。

ウェブ スパイダーは、インターネット上で見つけられ、インデックス付けするように指示されたすべてのウェブ ページを検索 (クロール) し、分類します。したがって、ページが検索エンジンで見つけられたくない場合は、Web クローラーにページをクロールしないよう指示できます。

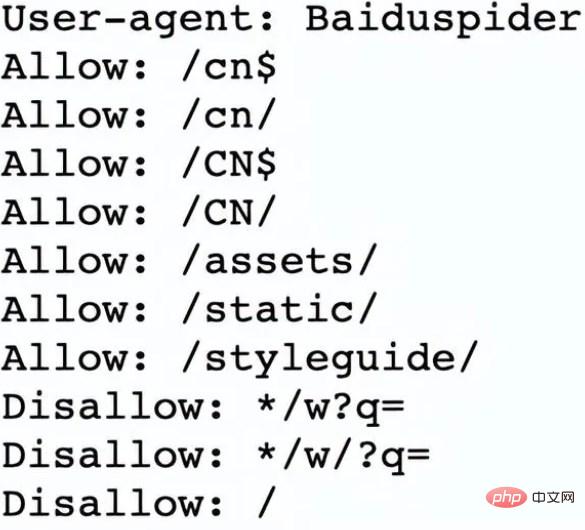

これを行うには、robots.txt ファイルをアップロードする必要があります。基本的に、robots.txt ファイルは、Web サイト上のページをクロールしてインデックスを作成する方法を検索エンジンに指示します。

たとえば、Nike.com/robots.txt を見てみましょう。

Nike は、robots.txt ファイルを使用して、Web サイト内のどのリンクがクロールされ、インデックスに登録されるかを決定します。

ファイルのこのセクションでは、次のことを決定します:

Web クローラー Baiduspider は最初の 7 つのリンクをクロールすることが許可されます

Webクローラーの Baiduspider は残りの 3 つのリンクのクロールを禁止されています。

これはナイキにとって有益です。なぜなら、同社のページの一部は検索に適しておらず、禁止されたリンクは最適化されたページに影響を与えないためです。ページはランク付けに役立ちます。サーチエンジン。

これで、Web クローラーとは何か、また Web クローラーがどのように仕事を遂行するのかがわかりました。次に、Web クローラーがどのように機能するかを確認してみましょう。

Web クローラーは、URL を検出し、Web ページを表示および分類することによって機能します。その過程で、他の Web ページへのハイパーリンクを見つけて、次にクロールするページのリストに追加します。 Web クローラーは賢く、各 Web ページの重要性を判断できます。

検索エンジンの Web クローラーは、インターネット全体をクロールすることはほとんどありません。代わりに、各 Web ページにリンクしている他のページの数、ページビュー、さらにはブランド権限などの要素に基づいて、各 Web ページの重要性を決定します。したがって、Web クローラーは、どのページをクロールするか、ページをクロールする順序、および更新をクロールする頻度を決定します。

たとえば、新しい Web ページがある場合、または既存の Web ページに変更が加えられた場合、Web クローラーはインデックスを記録して更新します。または、新しい Web ページがある場合は、検索エンジンにサイトをクロールするよう依頼できます。

Web クローラーがページ上にあると、コピー タグとメタ タグを調べてその情報を保存し、検索エンジンがキーワードでランク付けできるようにインデックスを作成します。

プロセス全体が始まる前に、Web クローラーは robots.txt ファイルを調べてどのページをクロールするかを確認します。そのため、これは技術的な SEO にとって非常に重要です。

最終的に、Web クローラーがページをクロールするときに、そのページがクエリの検索結果ページに表示されるかどうかが決まります。一部の Web クローラーは他のものとは動作が異なる場合があることに注意することが重要です。たとえば、どのページをクロールするのが最も重要かを決定する際に、さまざまな要素を使用する人もいます。

Web クローラーの仕組みを理解したところで、なぜ Web クローラーが Web サイトをクロールするのかについて説明します。

以上がウェブクローラーとは何ですかの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7513

7513

15

15

1378

1378

52

52

78

78

11

11

19

19

64

64

React と Python を使用して強力な Web クローラー アプリケーションを構築する方法

Sep 26, 2023 pm 01:04 PM

React と Python を使用して強力な Web クローラー アプリケーションを構築する方法

Sep 26, 2023 pm 01:04 PM

React と Python を使用して強力な Web クローラー アプリケーションを構築する方法 はじめに: Web クローラーは、インターネット経由で Web ページ データをクロールするために使用される自動プログラムです。インターネットの継続的な発展とデータの爆発的な増加に伴い、Web クローラーの人気はますます高まっています。この記事では、React と Python という 2 つの人気のあるテクノロジーを使用して、強力な Web クローラー アプリケーションを構築する方法を紹介します。フロントエンド フレームワークとしての React とクローラー エンジンとしての Python の利点を探り、具体的なコード例を示します。 1. のために

ウェブクローラーとは何ですか

Jun 20, 2023 pm 04:36 PM

ウェブクローラーとは何ですか

Jun 20, 2023 pm 04:36 PM

Web クローラー (Web スパイダーとも呼ばれる) は、インターネット上のコンテンツを検索し、インデックスを作成するロボットです。基本的に、Web クローラーは、クエリが行われたときに Web ページ上のコンテンツを取得するために、そのコンテンツを理解する責任があります。

Vue.js と Perl 言語を使用して効率的な Web クローラーとデータ スクレイピング ツールを開発します。

Jul 31, 2023 pm 06:43 PM

Vue.js と Perl 言語を使用して効率的な Web クローラーとデータ スクレイピング ツールを開発します。

Jul 31, 2023 pm 06:43 PM

Vue.js と Perl 言語を使用して、効率的な Web クローラーとデータ スクレイピング ツールを開発します。近年、インターネットの急速な発展とデータの重要性の増大に伴い、Web クローラーとデータ スクレイピング ツールの需要も増加しています。この文脈では、Vue.js と Perl 言語を組み合わせて効率的な Web クローラーとデータ スクレイピング ツールを開発することは良い選択です。この記事では、Vue.js と Perl 言語を使用してこのようなツールを開発する方法を紹介し、対応するコード例を添付します。 1. Vue.js と Perl 言語の概要

PHP を使用して簡単な Web クローラーを作成する方法

Jun 14, 2023 am 08:21 AM

PHP を使用して簡単な Web クローラーを作成する方法

Jun 14, 2023 am 08:21 AM

Web クローラーは、自動的に Web サイトにアクセスし、そこから情報をクロールする自動プログラムです。このテクノロジーは今日のインターネットの世界でますます一般的になり、データマイニング、検索エンジン、ソーシャルメディア分析などの分野で広く使用されています。 PHP を使用して簡単な Web クローラーを作成する方法を学びたい場合は、この記事で基本的なガイダンスとアドバイスを提供します。まず、いくつかの基本的な概念とテクニックを理解する必要があります。クロールターゲット クローラーを作成する前に、クロールターゲットを選択する必要があります。これは、特定の Web サイト、特定の Web ページ、またはインターネット全体である可能性があります。

大規模な Web クローラー開発に PHP と swoole を使用するにはどうすればよいですか?

Jul 21, 2023 am 09:09 AM

大規模な Web クローラー開発に PHP と swoole を使用するにはどうすればよいですか?

Jul 21, 2023 am 09:09 AM

大規模な Web クローラー開発に PHP と swoole を使用するにはどうすればよいですか?はじめに: インターネットの急速な発展に伴い、ビッグデータは今日の社会における重要なリソースの 1 つになりました。この貴重なデータを取得するために、Web クローラーが登場しました。 Web クローラーは、インターネット上のさまざまな Web サイトに自動的にアクセスし、そこから必要な情報を抽出します。この記事では、PHP と swoole 拡張機能を使用して、効率的で大規模な Web クローラーを開発する方法を検討します。 1. Web クローラーの基本原理を理解する Web クローラーの基本原理は非常に単純です。

PHP 学習ノート: Web クローラーとデータ収集

Oct 08, 2023 pm 12:04 PM

PHP 学習ノート: Web クローラーとデータ収集

Oct 08, 2023 pm 12:04 PM

PHP 学習メモ: Web クローラーとデータ収集 はじめに: Web クローラーは、インターネットからデータを自動的にクロールするツールで、人間の行動をシミュレートし、Web ページを閲覧し、必要なデータを収集できます。 PHP は、人気のあるサーバーサイド スクリプト言語として、Web クローラーとデータ収集の分野でも重要な役割を果たしています。この記事では、PHP を使用して Web クローラーを作成する方法を説明し、実践的なコード例を示します。 1. Web クローラーの基本原則 Web クローラーの基本原則は、HTTP リクエストを送信し、サーバーの H レスポンスを受信して解析することです。

PHP の簡単な Web クローラー開発例

Jun 13, 2023 pm 06:54 PM

PHP の簡単な Web クローラー開発例

Jun 13, 2023 pm 06:54 PM

インターネットの急速な発展に伴い、データは今日の情報化時代において最も重要なリソースの 1 つになりました。 Webクローラは、ネットワークデータを自動的に取得・処理する技術として、ますます注目と応用が進んでいます。この記事では、PHPを使って簡単なWebクローラーを開発し、ネットワークデータを自動取得する機能を実現する方法を紹介します。 1. Web クローラーの概要 Web クローラーとは、ネットワーク リソースを自動的に取得して処理する技術であり、主な動作プロセスはブラウザーの動作をシミュレートし、指定された URL アドレスに自動的にアクセスし、すべての情報を抽出することです。

PHP WebクローラのHTTPリクエストメソッドの詳細説明

Jun 17, 2023 am 11:53 AM

PHP WebクローラのHTTPリクエストメソッドの詳細説明

Jun 17, 2023 am 11:53 AM

インターネットの発展に伴い、あらゆる種類のデータにますますアクセスできるようになりました。データを取得するツールとして、Web クローラーはますます注目と注目を集めています。 Web クローラーでは、HTTP リクエストは重要なリンクです。この記事では、PHP Web クローラーでの一般的な HTTP リクエスト メソッドについて詳しく紹介します。 1. HTTP リクエスト メソッド HTTP リクエスト メソッドとは、クライアントがサーバーにリクエストを送信するときに使用するリクエスト メソッドを指します。一般的な HTTP リクエスト メソッドには、GET、POST、PU などがあります。