Scrapy 最適化のヒント: 重複 URL のクロールを減らし、効率を向上させる方法

Scrapy は、インターネットから大量のデータを取得するために使用できる強力な Python クローラー フレームワークです。ただし、Scrapy を開発する場合、重複した URL をクロールするという問題が頻繁に発生します。これは、多くの時間とリソースを無駄にし、効率に影響を与えます。この記事では、重複 URL のクロールを減らし、Scrapy クローラーの効率を向上させるための Scrapy 最適化テクニックをいくつか紹介します。

1. start_urls 属性と allowed_domains 属性を使用する

Scrapy クローラーでは、start_urls 属性を使用して、クロールする必要がある URL を指定できます。同時に、allowed_domains 属性を使用して、クローラーがクロールできるドメイン名を指定することもできます。これら 2 つの属性を使用すると、Scrapy がクロールする必要のない URL をすばやくフィルタリングして除外し、時間とリソースを節約しながら効率を向上させることができます。

2. Scrapy-Redis を使用して分散クロールを実装する

多数の URL をクロールする必要がある場合、単一マシンのクロールは非効率であるため、分散クロール テクノロジの使用を検討できます。 Scrapy-Redis は、Redis データベースを使用して分散クロールを実装し、Scrapy クローラーの効率を向上させる Scrapy 用のプラグインです。 settings.py ファイルで REDIS_HOST および REDIS_PORT パラメーターを設定すると、分散クロールを実現するために Scrapy-Redis が接続する Redis データベースのアドレスとポート番号を指定できます。

3. インクリメンタル クロール テクノロジを使用する

Scrapy クローラーの開発では、同じ URL を繰り返しクロールする必要があることがよくあり、これにより多くの時間とリソースが無駄になります。したがって、増分クロール手法を使用して、クロールの繰り返しを減らすことができます。増分クロール技術の基本的な考え方は、クロールされた URL を記録し、次回のクロール時にその記録に基づいて同じ URL がクロールされたかどうかを確認し、クロールされた場合はスキップするというものです。このようにして、重複した URL のクロールを削減し、効率を向上させることができます。

4. ミドルウェアを使用して重複 URL をフィルタリングする

増分クロール テクノロジに加えて、ミドルウェアを使用して重複 URL をフィルタリングすることもできます。 Scrapy のミドルウェアはカスタム プロセッサであり、Scrapy クローラーの実行中に、リクエストと応答はミドルウェアを通じて処理できます。カスタム ミドルウェアを作成することで URL 重複排除を実装できます。その中で、最も一般的に使用される重複排除方法は、Redis データベースを使用してクロールされた URL のリストを記録し、そのリストをクエリして URL がクロールされたかどうかを判断する方法です。

5. DupeFilter を使用して重複 URL をフィルタリングする

カスタム ミドルウェアに加えて、Scrapy は重複排除フィルタ DupeFilter も提供しており、これにより重複 URL のクロールを効果的に削減できます。 DupeFilter は各 URL をハッシュし、一意のハッシュ値をメモリに保存します。したがって、クロールプロセス中に、異なるハッシュ値を持つ URL のみがクロールされます。 DupeFilter の使用には、追加の Redis サーバー サポートは必要なく、軽量の重複 URL フィルタリング方法です。

概要:

Scrapy クローラーの開発では、重複 URL のクロールが一般的な問題です。重複 URL のクロールを減らし、Scrapy クローラーの効率を向上させるには、さまざまな最適化テクニックが必要です。この記事では、start_urls 属性と allowed_domains 属性の使用、Scrapy-Redis を使用した分散クロールの実装、増分クロール テクノロジーの使用、カスタム ミドルウェアを使用した重複 URL のフィルター、組み込み DupeFilter を使用した重複 URL のフィルターなど、一般的な Scrapy 最適化テクニックをいくつか紹介します。 。読者は、Scrapy クローラーの効率を向上させるために、自分のニーズに応じて適切な最適化方法を選択できます。

以上がScrapy 最適化のヒント: 重複 URL のクロールを減らし、効率を向上させる方法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7491

7491

15

15

1377

1377

52

52

77

77

11

11

19

19

41

41

htmlとurlの違いは何ですか

Mar 06, 2024 pm 03:06 PM

htmlとurlの違いは何ですか

Mar 06, 2024 pm 03:06 PM

相違点: 1. 定義が異なります。URL はユニフォーム リソース ロケーターであり、HTML はハイパーテキスト マークアップ言語です。 2. HTML には多数の URL を含めることができますが、URL 内に存在できる HTML ページは 1 つだけです。 3. HTML は is を指します。 Web ページ、url は Web サイトのアドレスを指します。

詳細な解釈: なぜ Laravel はカタツムリのように遅いのでしょうか?

Mar 07, 2024 am 09:54 AM

詳細な解釈: なぜ Laravel はカタツムリのように遅いのでしょうか?

Mar 07, 2024 am 09:54 AM

Laravel は人気のある PHP 開発フレームワークですが、カタツムリのように遅いと批判されることがあります。 Laravel の速度が満足できない原因は一体何でしょうか?この記事では、Laravel がカタツムリのように遅い理由をさまざまな側面から詳細に説明し、読者がこの問題をより深く理解できるように、具体的なコード例と組み合わせて説明します。 1. ORM クエリのパフォーマンスの問題 Laravel では、ORM (オブジェクト リレーショナル マッピング) は非常に強力な機能です。

Golang の GC 最適化戦略に関するディスカッション

Mar 06, 2024 pm 02:39 PM

Golang の GC 最適化戦略に関するディスカッション

Mar 06, 2024 pm 02:39 PM

Golang のガベージ コレクション (GC) は、開発者の間で常に話題になっています。高速プログラミング言語として、Golang の組み込みガベージ コレクターはメモリを適切に管理できますが、プログラムのサイズが大きくなるにつれて、パフォーマンスの問題が発生することがあります。この記事では、Golang の GC 最適化戦略を検討し、いくつかの具体的なコード例を示します。 Golang のガベージ コレクション Golang のガベージ コレクターは同時マークスイープ (concurrentmark-s) に基づいています。

C++ プログラムの最適化: 時間の複雑さを軽減する手法

Jun 01, 2024 am 11:19 AM

C++ プログラムの最適化: 時間の複雑さを軽減する手法

Jun 01, 2024 am 11:19 AM

時間計算量は、入力のサイズに対するアルゴリズムの実行時間を測定します。 C++ プログラムの時間の複雑さを軽減するためのヒントには、適切なコンテナー (ベクター、リストなど) を選択して、データのストレージと管理を最適化することが含まれます。クイックソートなどの効率的なアルゴリズムを利用して計算時間を短縮します。複数の操作を排除して二重カウントを削減します。条件分岐を使用して、不必要な計算を回避します。二分探索などのより高速なアルゴリズムを使用して線形探索を最適化します。

Laravelのパフォーマンスボトルネックを解読:最適化テクニックを完全公開!

Mar 06, 2024 pm 02:33 PM

Laravelのパフォーマンスボトルネックを解読:最適化テクニックを完全公開!

Mar 06, 2024 pm 02:33 PM

Laravelのパフォーマンスボトルネックを解読:最適化テクニックを完全公開! Laravel は人気のある PHP フレームワークとして、開発者に豊富な機能と便利な開発エクスペリエンスを提供します。ただし、プロジェクトのサイズが大きくなり、訪問数が増加すると、パフォーマンスのボトルネックという課題に直面する可能性があります。この記事では、開発者が潜在的なパフォーマンスの問題を発見して解決できるように、Laravel のパフォーマンス最適化テクニックについて詳しく説明します。 1. Eloquent の遅延読み込みを使用したデータベース クエリの最適化 Eloquent を使用してデータベースにクエリを実行する場合は、次のことを避けてください。

Laravel パフォーマンスのボトルネックが明らかに: 最適化ソリューションが明らかに!

Mar 07, 2024 pm 01:30 PM

Laravel パフォーマンスのボトルネックが明らかに: 最適化ソリューションが明らかに!

Mar 07, 2024 pm 01:30 PM

Laravel パフォーマンスのボトルネックが明らかに: 最適化ソリューションが明らかに!インターネット技術の発展に伴い、Web サイトやアプリケーションのパフォーマンスの最適化がますます重要になってきています。人気の PHP フレームワークである Laravel は、開発プロセス中にパフォーマンスのボトルネックに直面する可能性があります。この記事では、Laravel アプリケーションが遭遇する可能性のあるパフォーマンスの問題を調査し、開発者がこれらの問題をより適切に解決できるように、いくつかの最適化ソリューションと具体的なコード例を提供します。 1. データベース クエリの最適化 データベース クエリは、Web アプリケーションにおける一般的なパフォーマンスのボトルネックの 1 つです。存在する

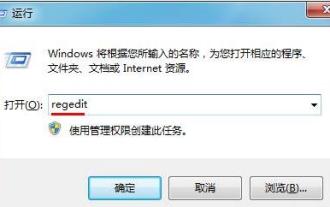

WIN7システムのスタートアップ項目を最適化する方法

Mar 26, 2024 pm 06:20 PM

WIN7システムのスタートアップ項目を最適化する方法

Mar 26, 2024 pm 06:20 PM

1. デスクトップでキーの組み合わせ (win キー + R) を押してファイル名を指定して実行ウィンドウを開き、[regedit] と入力して Enter キーを押して確定します。 2. レジストリ エディターを開いた後、[HKEY_CURRENT_USERSoftwareMicrosoftWindowsCurrentVersionExplorer] をクリックして展開し、ディレクトリに Serialize 項目があるかどうかを確認します。ない場合は、エクスプローラーを右クリックして新しい項目を作成し、Serialize という名前を付けます。 3. 次に、「シリアル化」をクリックし、右側のペインの空白スペースを右クリックして、新しい DWORD (32) ビット値を作成し、「Star」という名前を付けます。

Golangで正規表現を使用してURLを検出するにはどうすればよいですか?

May 31, 2024 am 10:32 AM

Golangで正規表現を使用してURLを検出するにはどうすればよいですか?

May 31, 2024 am 10:32 AM

正規表現を使用して Golang で URL を検出する手順は次のとおりです。 regexp.MustCompile(pattern) を使用して正規表現パターンをコンパイルします。パターンは、プロトコル、ホスト名、ポート (オプション)、パス (オプション)、およびクエリ パラメーター (オプション) と一致する必要があります。 regexp.MatchString(pattern,url) を使用して、URL がパターンと一致するかどうかを検出します。