ビッグデータの処理と分析をサポートするように Linux システムを構成する

ビッグ データの処理と分析をサポートするように Linux システムを構成する

要約: ビッグ データ時代の到来により、ビッグ データの処理と分析の需要が増加しています。この記事では、ビッグ データの処理と分析をサポートするために Linux システム上でアプリケーションとツールを構成する方法について説明し、対応するコード例を示します。

キーワード: Linux システム、ビッグデータ、処理、分析、構成、コード例

はじめに: ビッグデータは、新たなデータ管理および分析テクノロジーとして、さまざまな分野で広く使用されています。ビッグ データの処理と分析の効率と信頼性を確保するには、Linux システムを正しく構成することが非常に重要です。

1. Linux システムをインストールする

まず、Linux システムを正しくインストールする必要があります。一般的な Linux ディストリビューションには、Ubuntu、Fedora などが含まれます。独自のニーズに応じて、適切な Linux ディストリビューションを選択できます。インストールプロセス中に、システムのインストール完了後により詳細な構成を可能にするためにサーバーのバージョンを選択することをお勧めします。

2. システムをアップデートし、必要なソフトウェアをインストールする

システムのインストールが完了したら、システムをアップデートし、必要なソフトウェアをインストールする必要があります。まず、ターミナルで次のコマンドを実行してシステムを更新します:

sudo apt update sudo apt upgrade

次に、OpenJDK (Java Development Kit) をインストールします。これは、ほとんどのビッグ データ処理および分析アプリケーションは Java に基づいて開発されているためです:

sudo apt install openjdk-8-jdk

インストール完了後、以下のコマンドを実行することでJavaが正常にインストールされたか確認できます。

java -version

Javaのバージョン情報が出力されればインストールは成功です。

3. Hadoop の設定

Hadoop は、非常に大規模なデータ セットを処理できるオープン ソースのビッグ データ処理フレームワークです。 Hadoop を構成する手順は次のとおりです。

Hadoop をダウンロードして解凍します。

wget https://www.apache.org/dist/hadoop/common/hadoop-3.3.0.tar.gz tar -xzvf hadoop-3.3.0.tar.gz

ログイン後にコピー環境変数を構成します。

以下を追加します。コンテンツ~/.bashrcファイルに移動します:export HADOOP_HOME=/path/to/hadoop-3.3.0 export PATH=$PATH:$HADOOP_HOME/bin

ログイン後にコピーファイルを保存した後、次のコマンドを実行して構成を有効にします:

source ~/.bashrc

ログイン後にコピーログイン後にコピーHadoop のコア ファイルを構成する :

Hadoop の解凍ディレクトリに移動し、etc/hadoop/core-site.xmlファイルを編集し、次の内容を追加します:<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property> </configuration>

ログイン後にコピー次に、

etc/hadoop/hdfs -site.xmlファイルを編集し、次の内容を追加します:<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> </configuration>

ログイン後にコピーファイルを保存した後、次のコマンドを実行して Hadoop ファイル システムをフォーマットします:

hdfs namenode -format

ログイン後にコピー最後に、Hadoop を起動します:

start-dfs.sh

ログイン後にコピー4. Spark を構成する

Spark は、Hadoop で使用できる高速かつ多用途のビッグ データ処理および分析エンジンです。 Spark を構成する手順は次のとおりです:Spark をダウンロードして解凍します:

wget https://www.apache.org/dist/spark/spark-3.1.2/spark-3.1.2-bin-hadoop3.2.tgz tar -xzvf spark-3.1.2-bin-hadoop3.2.tgz

ログイン後にコピー環境変数を構成します:

以下を追加しますコンテンツ~/.bashrcファイルに移動します:export SPARK_HOME=/path/to/spark-3.1.2-bin-hadoop3.2 export PATH=$PATH:$SPARK_HOME/bin

ログイン後にコピーファイルを保存した後、次のコマンドを実行して構成を有効にします:

source ~/.bashrc

ログイン後にコピーログイン後にコピーSpark のコア ファイルを構成します。

Spark 解凍ディレクトリに入り、conf/spark-env.sh.templateファイルをコピーし、名前をconf/spark-env.sh に変更します。。conf/spark-env.shファイルを編集し、次の内容を追加します。export JAVA_HOME=/path/to/jdk1.8.0_* export HADOOP_HOME=/path/to/hadoop-3.3.0 export SPARK_MASTER_HOST=localhost export SPARK_MASTER_PORT=7077 export SPARK_WORKER_CORES=4 export SPARK_WORKER_MEMORY=4g

ログイン後にコピーこのうち、

JAVA_HOMEには Java のインストール パスを設定する必要があります。HADOOP_HOMEHadoop のインストール パスに設定する必要があります。SPARK_MASTER_HOSTは現在のマシンの IP アドレスに設定されます。

ファイルを保存した後、Spark を開始します:

start-master.sh

次のコマンドを実行して Spark のマスター アドレスを表示します:

cat $SPARK_HOME/logs/spark-$USER-org.apache.spark.deploy.master*.out | grep 'Starting Spark master'

Spark ワーカーを開始します:

start-worker.sh spark://<master-ip>:<master-port>

このうち、<master-ip>はSparkのMasterアドレスのIPアドレス、<master-port>はSparkのMasterアドレスのポート番号です。 。

概要: この記事では、Hadoop や Spark などのビッグ データの処理と分析のためのアプリケーションとツールをサポートするように Linux システムを構成する方法について説明します。 Linux システムを正しく構成することで、ビッグ データの処理と分析の効率と信頼性を向上させることができます。読者は、この記事のガイドラインとサンプル コードに従って、Linux システムの構成とアプリケーションを実践できます。

以上がビッグデータの処理と分析をサポートするように Linux システムを構成するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7552

7552

15

15

1382

1382

52

52

83

83

11

11

22

22

96

96

CSV ファイルを読み取り、pandas を使用してデータ分析を実行する

Jan 09, 2024 am 09:26 AM

CSV ファイルを読み取り、pandas を使用してデータ分析を実行する

Jan 09, 2024 am 09:26 AM

Pandas は、さまざまな種類のデータ ファイルを簡単に読み取り、処理できる強力なデータ分析ツールです。その中でも、CSV ファイルは最も一般的でよく使用されるデータ ファイル形式の 1 つです。この記事では、Pandas を使用して CSV ファイルを読み取り、データ分析を実行する方法と、具体的なコード例を紹介します。 1. 必要なライブラリをインポートする まず、以下に示すように、Pandas ライブラリと必要になる可能性のあるその他の関連ライブラリをインポートする必要があります。 importpandasaspd 2. Pan を使用して CSV ファイルを読み取ります。

データ分析手法の紹介

Jan 08, 2024 am 10:22 AM

データ分析手法の紹介

Jan 08, 2024 am 10:22 AM

一般的なデータ分析手法: 1. 比較分析手法; 2. 構造分析手法; 3. クロス分析手法; 4. 傾向分析手法; 5. 因果分析手法; 6. 関連分析手法; 7. クラスター分析手法; 8 , 主成分分析法; 9. 散布分析法; 10. マトリックス分析法。詳細な紹介: 1. 比較分析手法: 2 つ以上のデータを比較分析して、相違点やパターンを見つける手法; 2. 構造分析手法: 全体の各部分と全体を比較分析する手法; 3. クロス分析手法、など。

C++ テクノロジでのビッグ データ処理: グラフ データベースを使用して大規模なグラフ データを保存およびクエリする方法

Jun 03, 2024 pm 12:47 PM

C++ テクノロジでのビッグ データ処理: グラフ データベースを使用して大規模なグラフ データを保存およびクエリする方法

Jun 03, 2024 pm 12:47 PM

C++ テクノロジは、グラフ データベースを活用することで大規模なグラフ データを処理できます。具体的な手順には、TinkerGraph インスタンスの作成、頂点とエッジの追加、クエリの作成、結果値の取得、結果のリストへの変換が含まれます。

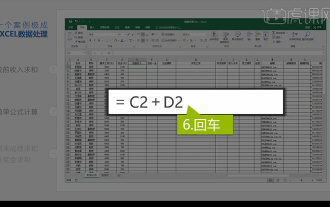

Excelデータの統合分析

Mar 21, 2024 am 08:21 AM

Excelデータの統合分析

Mar 21, 2024 am 08:21 AM

1. このレッスンでは、Excel の統合データ分析について説明します。ケースを通して完成させます。教材を開いて、セル E2 をクリックして数式を入力します。 2. 次に、セル E53 を選択して、以下のすべてのデータを計算します。 3. 次に、セル F2 をクリックし、計算する数式を入力します。同様に、下にドラッグすると、必要な値を計算できます。 4. セル G2 を選択し、「データ」タブをクリックし、「データ検証」をクリックして、選択して確認します。 5. 同じ方法を使用して、計算が必要な下のセルを自動的に入力してみましょう。 6. 次に、実際の賃金を計算し、セル H2 を選択して数式を入力します。 7. 次に、値のドロップダウン メニューをクリックして、他の数値をクリックします。

C++ テクノロジでのビッグ データ処理: ストリーム処理テクノロジを使用してビッグ データ ストリームを処理するにはどうすればよいですか?

Jun 01, 2024 pm 10:34 PM

C++ テクノロジでのビッグ データ処理: ストリーム処理テクノロジを使用してビッグ データ ストリームを処理するにはどうすればよいですか?

Jun 01, 2024 pm 10:34 PM

ストリーム処理技術は、ビッグデータ処理に使用されます。ストリーム処理は、データ ストリームをリアルタイムに処理する技術です。 C++ では、Apache Kafka をストリーム処理に使用できます。ストリーム処理は、リアルタイムのデータ処理、スケーラビリティ、およびフォールト トレランスを提供します。この例では、ApacheKafka を使用して Kafka トピックからデータを読み取り、平均を計算します。

おすすめのデータ分析サイトは何ですか?

Mar 13, 2024 pm 05:44 PM

おすすめのデータ分析サイトは何ですか?

Mar 13, 2024 pm 05:44 PM

推奨: 1. ビジネス データ分析フォーラム; 2. 全国人民代表大会経済フォーラム - 計量経済統計分野; 3. 中国統計フォーラム; 4. データ マイニング学習および交換フォーラム; 5. データ分析フォーラム; 6. ウェブサイト データ分析; 7 . データ分析; 8. データマイニング研究所; 9. S-PLUS、R 統計フォーラム。

データ分析と科学技術計算に numpy ライブラリを使用する方法を学びます

Jan 19, 2024 am 08:05 AM

データ分析と科学技術計算に numpy ライブラリを使用する方法を学びます

Jan 19, 2024 am 08:05 AM

情報時代の到来により、データ分析と科学計算はますます多くの分野で重要な部分を占めるようになりました。この過程において、データ処理と分析のためのコンピュータの使用は不可欠なツールとなっています。 Python では、numpy ライブラリは非常に重要なツールであり、これを使用すると、データをより効率的に処理および分析し、より速く結果を得ることができます。この記事では、numpy の一般的な機能と使い方を紹介し、さらに深く学ぶのに役立つ具体的なコード例をいくつか示します。 numpyライブラリのインストール

C++ テクノロジーでのビッグ データ処理: 効率的なテキスト マイニングとビッグ データ分析を実現するにはどうすればよいですか?

Jun 02, 2024 am 10:39 AM

C++ テクノロジーでのビッグ データ処理: 効率的なテキスト マイニングとビッグ データ分析を実現するにはどうすればよいですか?

Jun 02, 2024 am 10:39 AM

C++ はテキスト マイニングとデータ分析において重要な役割を果たし、複雑な分析タスクに効率的なテキスト マイニング エンジンと処理機能を提供します。テキスト マイニングの観点: C++ は、テキスト データから情報を抽出するテキスト マイニング エンジンを構築できます。ビッグ データ分析の観点では、C++ は巨大なデータ セットを処理する複雑な分析タスクに適しており、平均や標準偏差などの統計を計算できます。 。実際のケース: ある小売会社は、C++ で開発されたテキスト マイニング エンジンを使用して顧客レビューを分析し、製品の品質、顧客サービス、納期に関する洞察を明らかにしました。