0大規模モデルのコード微調整のコストは 20 ドル未満です (約 RMB 144 元)?

プロセスも非常に簡単で、たったの 5 ステップで完了します。

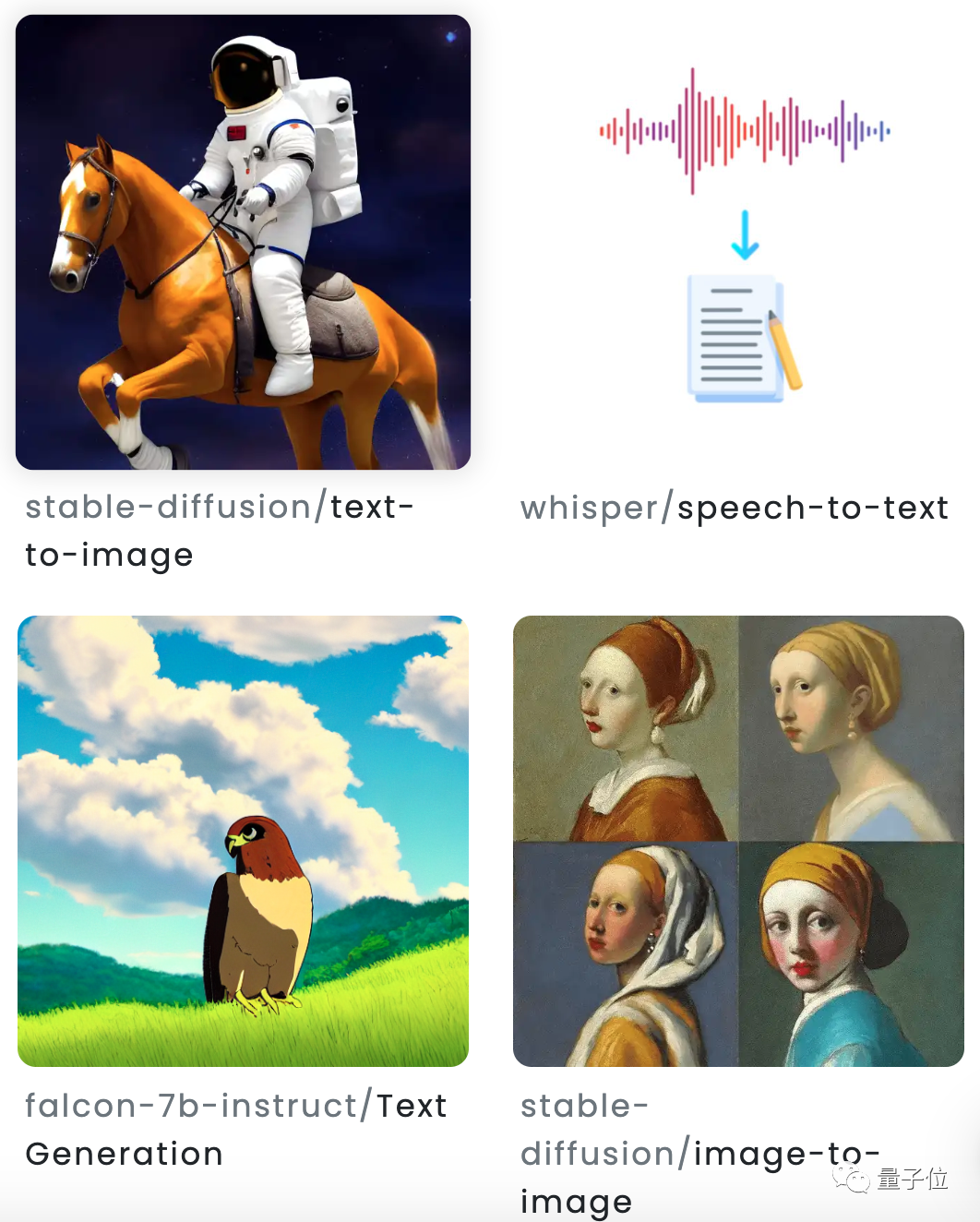

LLaMA、GPT、StableLM、その他の一般的なオープンソース生成モデルなどを解決できます。 写真

写真

Monster API です。

オープンソース分野でのこの新しい研究により、AI 開発のゲームルールが書き換えられ、AI アプリケーションの速度が加速されるのではないかと考える人もいます。 写真

写真

写真

写真

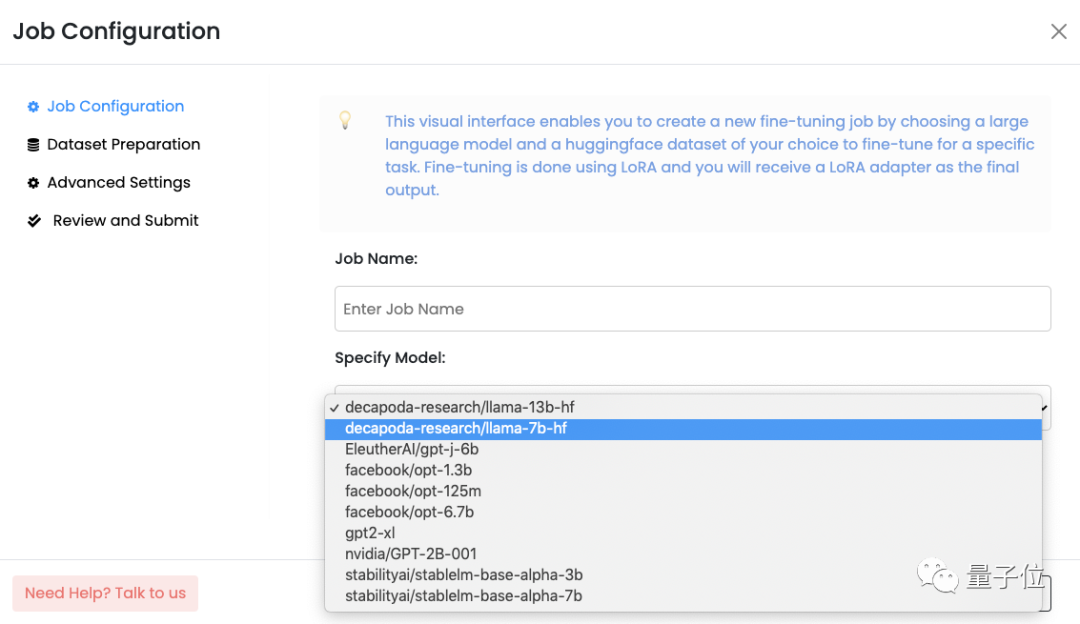

最初のステップ は、微調整するモデルを選択することです。

たとえば、LLaMA-7B、GPT-J-6B、StableLM-7B など、Monster API は少なくとも 10 個の基本的な大規模モデルを提供します。 図

図

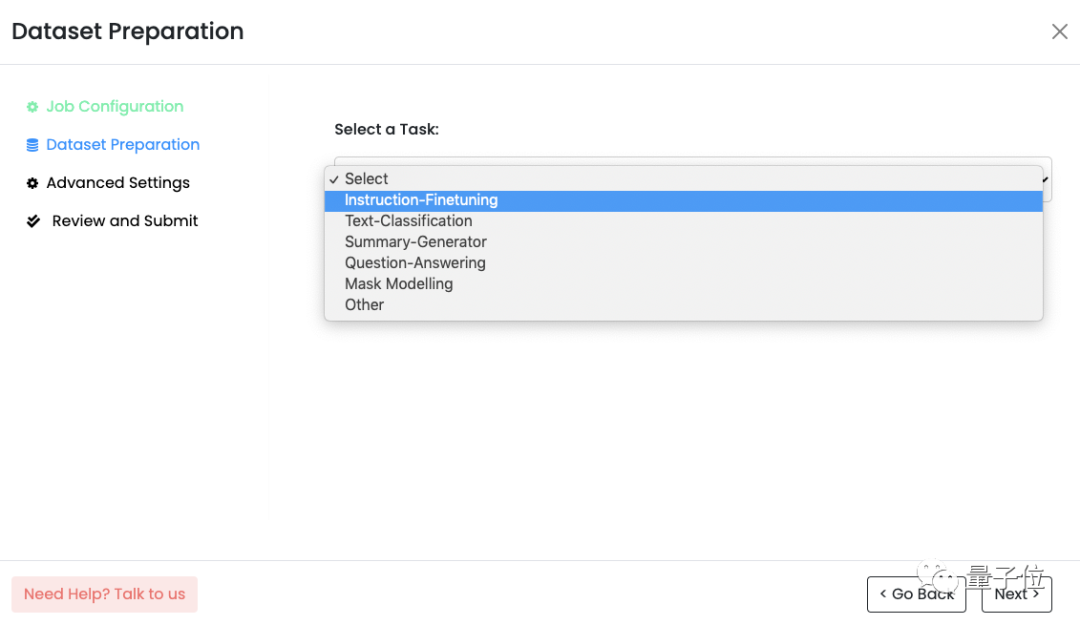

ステップ 2、微調整タスクを選択または作成します。たとえば、指示の微調整、テキスト分類など、またはカスタム タスクです。

図

図

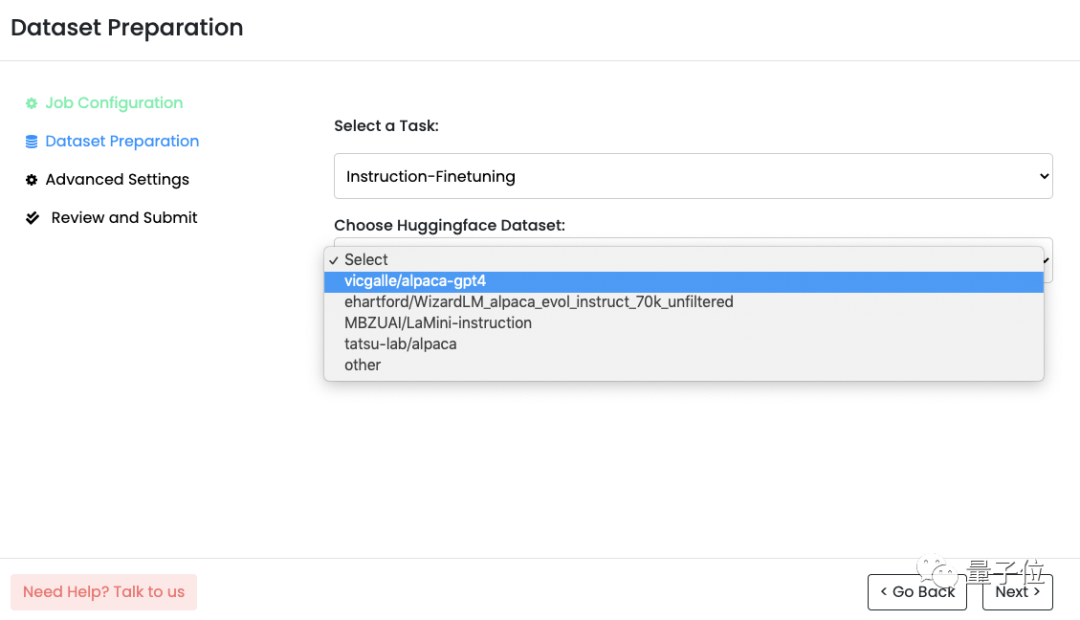

3 番目のステップ 、HuggingFace データ セットを選択します。

Monster API は、幅広い選択肢を使用して HuggingFace データ セットをシームレスに統合でき、タスク タイプに基づいてデータ セットを推奨することもできます。 また、形式は手動で設定する必要がなく、自動的に設定されます。 図

図

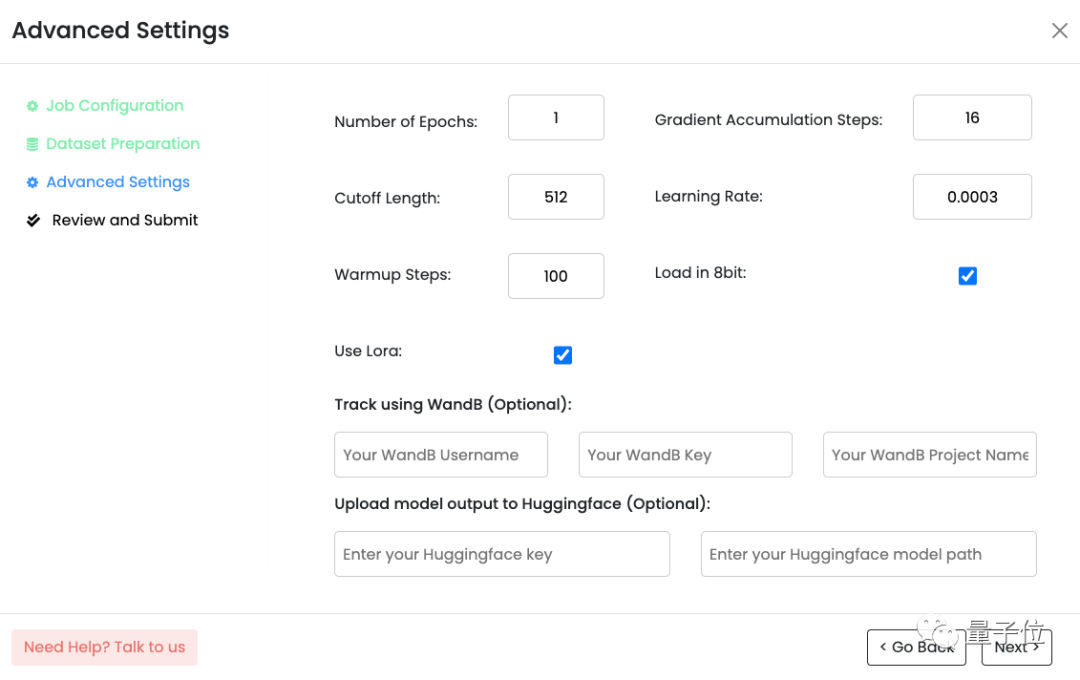

4 番目のステップ は、ハイパーパラメータを設定することです。

写真

写真

ステップ 5、確認して送信します。

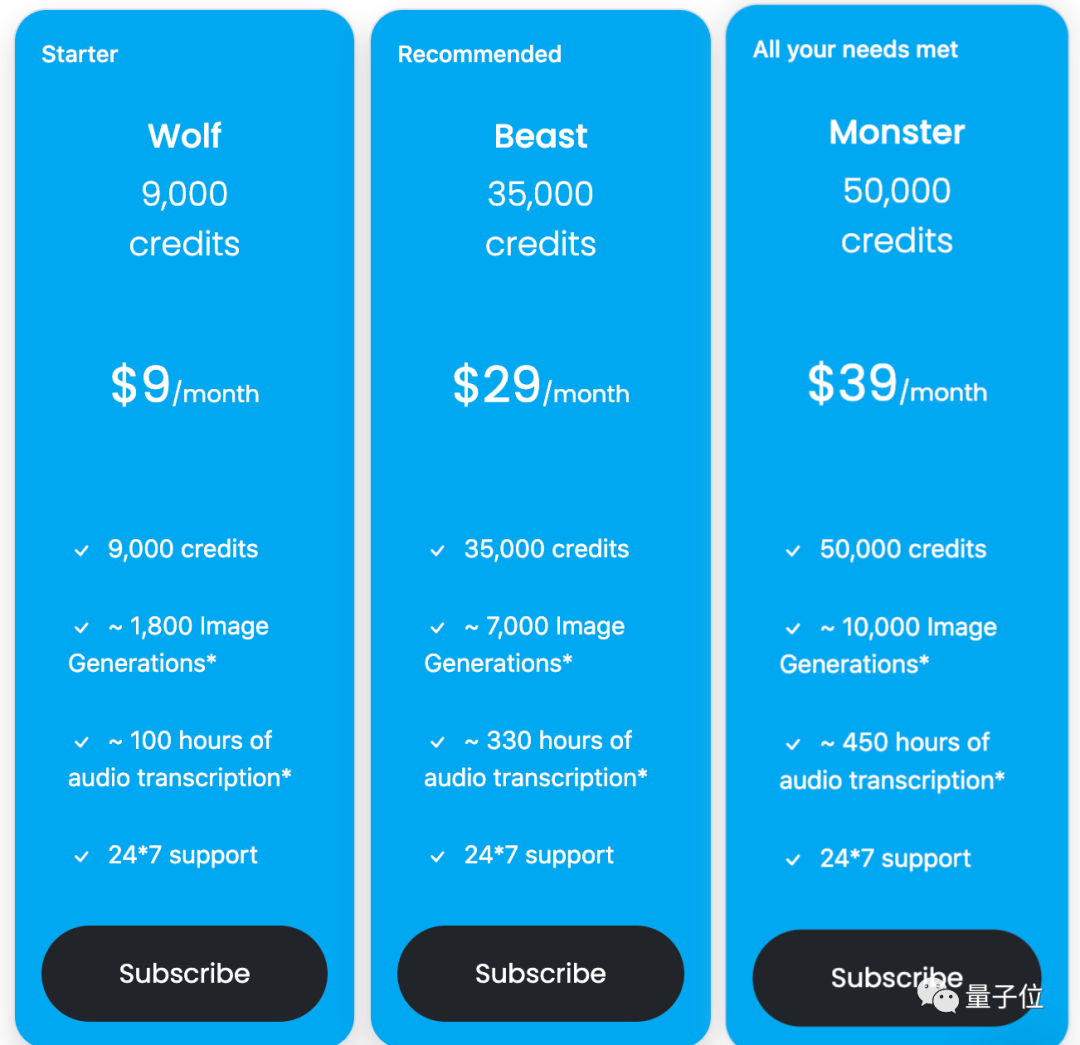

上記の手順をすべて設定したら、送信する前にエラーがないことを確認してください。 Monster API は、WandB のログを通じてタスクを監視できることを示します。 は、DataBricks Dolly 15k の微調整された LLaMA-7B を使用して 3 つのエポウチを完了するのにかかる費用は 20 米ドル未満 (人民元で約 144 元に相当) であるとブログに書きました。 公式サイトを見ると、ユーザー登録で2,500ポイントプレゼントとあります。メンバーシップは3つのレベルに分かれており、料金はそれぞれ月額9ドル/29ドル/39ドルです。 写真

写真

写真

写真

この AI スタートアップ企業は、自らを「GPU 分野の Airbnb」と位置づけ、世界中に点在する GPU リソースを柔軟にスケジュールし、開発者がより低価格で利用できるようにしています。

写真 創設者は、Gaurav Vij と Saurabh Vij の 2 人の兄弟です。

創設者は、Gaurav Vij と Saurabh Vij の 2 人の兄弟です。

兄弟は、技術を複数回繰り返した後、機械学習タスクで消費者グレードの GPU のパフォーマンスを最適化し、Whisper AI モデルの実行コストを AWS プラットフォームと比較して 90% 削減したと述べました。何万人もの開発者を助けるためにこの方法を使用しないでください。

同時に、同社の顧客の 1 人が分散 GPU コンピューティング リソースを使用することで 30 万ドルを節約したことも明らかにしました。

参考リンク:

[1]https://blog.monsterapi.ai/no-code-fine-tuning-llm/

[2] https://www.enterpriseai.news/2023/06/09/monster-api-launches-the-airbnb-of-gpus-with-1-1m-pre-seed/

#

以上が大型モデルの 0 コード微調整が人気で、必要な手順は 5 つだけで、コストはわずか 150 元ですの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。