PHP と phpSpider: 大規模なデータ クローリングにおけるパフォーマンスの問題にどう対処するか?

PHP と phpSpider: 大規模なデータ クローリングにおけるパフォーマンスの問題にどう対処するか?

インターネットの発展とデータの普及に伴い、必要な情報を取得するためにデータのクローリングに注目する企業や個人が増えています。大規模なデータ クローリング タスクでは、パフォーマンスが重要な考慮事項となります。この記事では、PHP と phpSpider を使用して大規模なデータ クロールのパフォーマンスの問題に対処する方法を紹介し、コード例で説明します。

1. マルチスレッドを使用する

大規模なデータをクロールする場合、マルチスレッドを使用すると、プログラムの実行効率が大幅に向上します。 PHP のマルチスレッド拡張機能 (PHP pthreads 拡張機能など) を使用すると、複数のクロール タスクを 1 つのプロセスで同時に実行できます。以下はマルチスレッドを使用したサンプル コードです:

<?php

$urls = array(

'https://example.com/page1',

'https://example.com/page2',

'https://example.com/page3',

// 更多待爬取的URL

);

$threads = array();

// 创建线程

foreach ($urls as $url) {

$thread = new MyThread($url);

$threads[] = $thread;

$thread->start();

}

// 等待线程执行完毕

foreach ($threads as $thread) {

$thread->join();

}

class MyThread extends Thread {

private $url;

public function __construct($url) {

$this->url = $url;

}

public function run() {

// 在这里写爬取逻辑

// 使用$this->url作为爬取的URL

}

}

?>2. ネットワーク アクセスの最適化

データをクロールする場合、ネットワーク アクセスはパフォーマンスのボトルネックの 1 つです。ネットワーク アクセスの効率を向上させるために、curl ライブラリや Guzzle などの優れた HTTP クライアント ライブラリを使用して、並列リクエストや接続プール管理などの機能を実装できます。

次のサンプル コードは、Guzzle ライブラリを使用して複数のリクエストを並列実行する方法を示しています:

<?php

require 'vendor/autoload.php'; // 请确保已安装Guzzle库

use GuzzleHttpClient;

use GuzzleHttpPool;

use GuzzleHttpPsr7Request;

$urls = array(

'https://example.com/page1',

'https://example.com/page2',

'https://example.com/page3',

// 更多待爬取的URL

);

$client = new Client();

$requests = function ($urls) {

foreach ($urls as $url) {

yield new Request('GET', $url);

}

};

$pool = new Pool($client, $requests($urls), [

'concurrency' => 10, // 并发请求数量

'fulfilled' => function ($response, $index) {

// 在这里处理请求成功的响应

// $response为响应对象

},

'rejected' => function ($reason, $index) {

// 在这里处理请求失败的原因

// $reason为失败原因

},

]);

$promise = $pool->promise();

$promise->wait();

?>3. キャッシュの合理的な使用

大規模なデータ クローリングでは、同じファイルにアクセスすることがよくあります。 URLを複数回。ネットワーク リクエストの数を減らし、プログラムのパフォーマンスを向上させるために、キャッシュ メカニズム (Memcached や Redis など) を合理的に使用して、クロールされたデータを保存できます。以下は、Memcached をキャッシュとして使用するサンプル コードです。

<?php

$urls = array(

'https://example.com/page1',

'https://example.com/page2',

'https://example.com/page3',

// 更多待爬取的URL

);

$memcached = new Memcached();

$memcached->addServer('localhost', 11211);

foreach ($urls as $url) {

$data = $memcached->get($url);

if ($data === false) {

// 如果缓存中没有数据,则进行爬取并存入缓存

// 爬取逻辑略

$data = $result; // 假设$result为爬取得到的数据

$memcached->set($url, $data);

}

// 使用$data进行后续数据处理

}

?>キャッシュを適切に使用することで、繰り返されるネットワーク リクエストを減らし、データ クロールの効率を向上させることができます。

概要:

この記事では、大規模なデータ クロールのパフォーマンスの問題に対処するために、マルチスレッドを使用し、ネットワーク アクセスを最適化し、キャッシュを合理的に使用する方法を紹介します。コード例では、PHP のマルチスレッド拡張機能、Guzzle ライブラリ、およびキャッシュ メカニズムを使用してクロール効率を向上させる方法を示します。実際のアプリケーションでは、特定のニーズや環境に応じて、他の方法を使用してパフォーマンスをさらに最適化できます。

以上がPHP と phpSpider: 大規模なデータ クローリングにおけるパフォーマンスの問題にどう対処するか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7467

7467

15

15

1376

1376

52

52

77

77

11

11

19

19

22

22

Ubuntu および Debian 用の PHP 8.4 インストールおよびアップグレード ガイド

Dec 24, 2024 pm 04:42 PM

Ubuntu および Debian 用の PHP 8.4 インストールおよびアップグレード ガイド

Dec 24, 2024 pm 04:42 PM

PHP 8.4 では、いくつかの新機能、セキュリティの改善、パフォーマンスの改善が行われ、かなりの量の機能の非推奨と削除が行われています。 このガイドでは、Ubuntu、Debian、またはその派生版に PHP 8.4 をインストールする方法、または PHP 8.4 にアップグレードする方法について説明します。

CakePHP について話し合う

Sep 10, 2024 pm 05:28 PM

CakePHP について話し合う

Sep 10, 2024 pm 05:28 PM

CakePHP は、PHP 用のオープンソース フレームワークです。これは、アプリケーションの開発、展開、保守をより簡単にすることを目的としています。 CakePHP は、強力かつ理解しやすい MVC のようなアーキテクチャに基づいています。モデル、ビュー、コントローラー

CakePHP ファイルのアップロード

Sep 10, 2024 pm 05:27 PM

CakePHP ファイルのアップロード

Sep 10, 2024 pm 05:27 PM

ファイルのアップロードを行うには、フォーム ヘルパーを使用します。ここではファイルアップロードの例を示します。

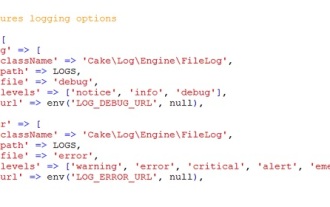

CakePHP のロギング

Sep 10, 2024 pm 05:26 PM

CakePHP のロギング

Sep 10, 2024 pm 05:26 PM

CakePHP へのログインは非常に簡単な作業です。使用する関数は 1 つだけです。 cronjob などのバックグラウンド プロセスのエラー、例外、ユーザー アクティビティ、ユーザーが実行したアクションをログに記録できます。 CakePHP でのデータのログ記録は簡単です。 log()関数が提供されています

PHP 開発用に Visual Studio Code (VS Code) をセットアップする方法

Dec 20, 2024 am 11:31 AM

PHP 開発用に Visual Studio Code (VS Code) をセットアップする方法

Dec 20, 2024 am 11:31 AM

Visual Studio Code (VS Code とも呼ばれる) は、すべての主要なオペレーティング システムで利用できる無料のソース コード エディター (統合開発環境 (IDE)) です。 多くのプログラミング言語の拡張機能の大規模なコレクションを備えた VS Code は、

CakePHP クイックガイド

Sep 10, 2024 pm 05:27 PM

CakePHP クイックガイド

Sep 10, 2024 pm 05:27 PM

CakePHP はオープンソースの MVC フレームワークです。これにより、アプリケーションの開発、展開、保守がはるかに簡単になります。 CakePHP には、最も一般的なタスクの過負荷を軽減するためのライブラリが多数あります。