8 月 31 日の IT ホーム ニュース Google Cloud は、本日開催された Cloud Next カンファレンスで、A3 仮想マシン インスタンスが来月開始されることを発表しました。 Google Cloud は、今年 5 月に開催された I/O Developer Conference で A3 インスタンスを発表しましたが、最大のハイライトは、生成 AI や大規模言語モデルのニーズを満たすために NVIDIA H100 Tensor Core GPU を搭載していることです。

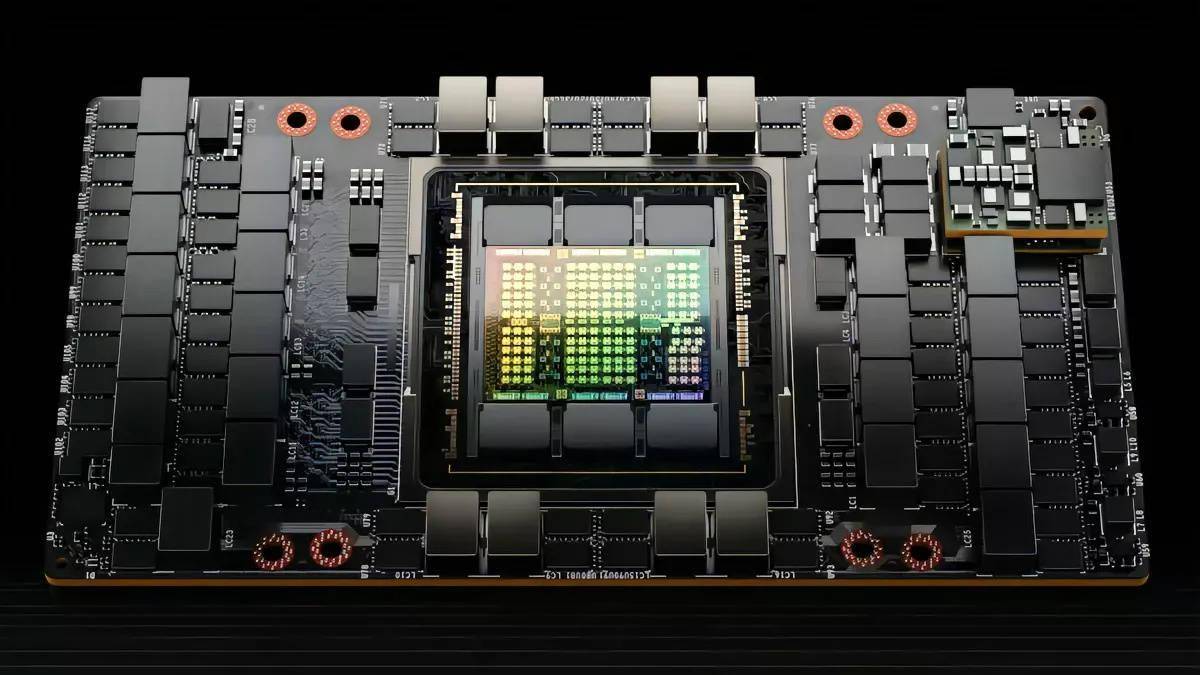

IT House は、A3 インスタンスが第 4 世代 Intel Xeon スケーラブル プロセッサ、2TB DDR5-4800 メモリ、および 8 基の NVIDIA H100 "Hopper" GPU を使用し、NVLink 4.0 および NVSwitch を通じて 3.6 TBps を達成していることを以前に報告しました。

新しい A3 スーパーコンピューターは、生成人工知能と大規模言語モデルにおける今日のイノベーションを推進する人工知能モデルで最も要求の厳しいタスクをトレーニングし提供するように特別に設計されています。レポートによると、このスーパーコンピューターは 26 エクサフロップスの人工知能パフォーマンスを提供できるそうです。本日の発表で、Google Cloud は、これまでで最もコスト効率が高くアクセスしやすいクラウド TPU である新しい TPU v5e も導入しました。これらの TPU とカスタム ASIC は、人工知能と機械学習のワークロードを高速化するように設計されています

SDxCentral のレポートによると、TPU v5e は、前世代の製品と比較して、1 ドルあたりのトレーニング パフォーマンスが 2 倍、1 ドルあたりの推論パフォーマンスが 2.5 倍向上しました

以上がGoogle は A3 インスタンスを立ち上げようとしています: NVIDIA H100 を搭載し、26 エクサフロップスの AI パフォーマンスを提供しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。