最近、Alibaba Cloud Linux 3 は、AI 開発エクスペリエンスをより効率的にするために、いくつかの最適化とアップグレードを提供しました。この記事は、「Alibaba Cloud Linux 3 の AI 機能の紹介」シリーズの記事のプレビューです。 Alibaba Cloud をデモンストレーションする例としての GPU インスタンス Linux 3 は AI エコシステムをサポートしています。次回は、ユーザーにすぐに使える AI 基本ソフトウェア環境を提供する Alinux ベースのクラウド市場イメージの紹介と、AMD ベースの AI 機能の差別化紹介の 2 つのシリーズ記事を掲載します。乞うご期待。 Alibaba Cloud Linux 3 の詳細については、公式 Web サイトをご覧ください: https://www.aliyun.com/product/ecs/alinux

Linux オペレーティング システムで人工知能 (AI) アプリケーションを開発する場合、開発者は次のようないくつかの課題に直面することがあります。

1. GPU ドライバー: Linux システムでのトレーニングまたは推論に NVIDIA GPU を使用するには、正しい NVIDIA GPU ドライバーをインストールして構成する必要があります。オペレーティング システムや GPU モデルが異なると異なるドライバーが必要になる場合があるため、追加の作業が必要になる場合があります。

2. AI フレームワークのコンパイル: Linux システム上で AI フレームワークを使用してプログラミングする場合は、適切なコンパイラーとその他の依存関係をインストールして構成する必要があります。これらのフレームワークではコンパイルが必要な場合が多いため、コンパイラーとその他の依存関係が正しくインストールされていること、およびコンパイラーが正しく構成されていることを確認する必要があります。

3. ソフトウェアの互換性: Linux オペレーティング システムはさまざまなソフトウェアやツールをサポートしていますが、バージョンやディストリビューションが異なると互換性の問題が発生する可能性があります。これにより、一部のプログラムが適切に実行されなかったり、一部のオペレーティング システムで使用できなくなったりすることがあります。したがって、研究開発担当者は、作業環境のソフトウェア互換性を理解し、必要な構成と変更を行う必要があります。

4. パフォーマンスの問題: AI ソフトウェア スタックは非常に複雑なシステムであり、通常、最高のパフォーマンスを達成するには、さまざまなモデルの CPU と GPU を専門的に最適化する必要があります。ソフトウェアとハードウェアのコラボレーションのパフォーマンスの最適化は、AI ソフトウェア スタックにとって困難なタスクであり、高度なテクノロジーと専門知識が必要です。

Alibaba Cloud Linux 3 (以下、「Alinux 3」) は、Alibaba Cloud の第 3 世代クラウド サーバー オペレーティング システムであり、Anolis OS に基づいて開発されたオペレーティング システム の商用バージョンであり、以下を提供します。 強力な AI 開発プラットフォーム を備えた開発者は、Dragon Lizard エコロジカル リポジトリ (epao) をサポートすることで、Alinux 3 はメインストリームの nvidia GPU および CUDA エコシステムの完全なサポートを実現し、AI 開発をより便利かつ効率的にします。さらに、Alinux 3 は、主流の AI フレームワークである TensorFlow/PyTorch や Intel/amd などのさまざまな CPU プラットフォームによる AI の最適化もサポートし、modelscope や Huggingface などの大規模モデル SDK のネイティブ サポートも導入し、開発者に豊富なリソースと道具。これらのサポートにより、Alinux 3 は完全な AI 開発プラットフォームとなり、環境をいじることなく AI 開発者の悩みを解決し、AI 開発エクスペリエンスをより簡単かつ効率的にします。

Alinux 3 は、開発者に強力な AI 開発プラットフォームを提供します。開発者が遭遇する可能性のある上記の課題を解決するために、Alinux 3 は次の最適化アップグレードを提供します。1.

Alinux 3 は、Dragon Lizard Ecological Software Repository (epao)を導入することにより、開発者がワンクリックで主流の NVIDIA GPU ドライバーと CUDA アクセラレーション ライブラリをインストールできるようにし、ドライバーのバージョンとマニュアルを一致させる必要がなくなりました。インストール時間。 2. epao ウェアハウスは、

主流の AI フレームワーク Tensorflow/PyTorch のバージョンサポートも提供しており、同時に AI フレームワークの依存関係の問題はインストール プロセス中に自動的に解決されます。開発者は追加のコンパイルを実行する必要がなく、システムの Python 環境を使用して迅速な開発を実現します。 3. Alinux 3 の AI 機能が開発者に提供される前に、

すべてのコンポーネントの互換性がテストされています. 開発者はワンクリックで対応する AI 機能をインストールできるため、環境構成で発生する可能性のある問題が排除されます。システムの依存関係を変更することで、使用時の安定性が向上しました。 4. Alinux 3 は、Intel/AMD などのさまざまなプラットフォーム上の CPU 向けに AI 向けに特別に最適化されており、

ハードウェアのパフォーマンスを最大限に発揮できるようになっています。5. AIGC 業界の急速な反復に を適応させるために、Alinux 3 は ModelScope や HuggingFace などの大規模モデル SDK のネイティブ サポートも導入し、開発者に豊富なリソースとツールを提供します。 。

多次元最適化のサポートにより、Alinux 3 は完全な AI 開発プラットフォームとなり、AI 開発者の課題を解決し、AI 開発エクスペリエンスをより簡単かつ効率的にしました。 以下では、Alibaba Cloud GPU インスタンスを例として使用して、AI エコシステムに対する Alinux 3 のサポートを示します。

1. GPU インスタンスを購入する

2. Alinux 3 イメージを選択します

3. epao リポジトリ設定をインストールします

dnf install -y anolis-epao-release

4. nvidia GPU ドライバーをインストールします

nvidia ドライバーをインストールする前に、nvidia ドライバーが正常にインストールされていることを確認するために、kernel-devel がインストールされていることを確認してください。

dnf install -y kernel-devel-$(uname-r)

nvidia ドライバーをインストールします:

dnf install -y nvidia-driver nvidia-driver-cuda

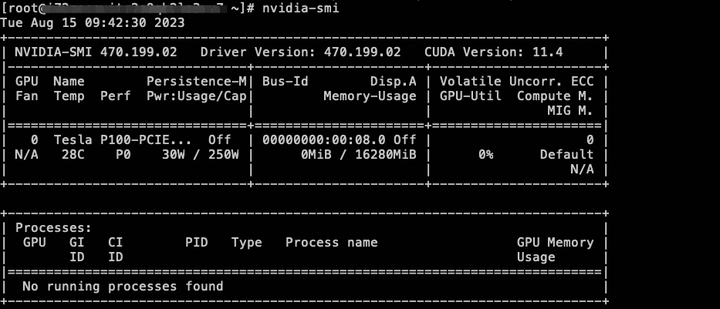

インストールが完了したら、nvidia-smi コマンドを使用して GPU デバイスのステータスを表示できます。

5. cuda エコロジカル ライブラリをインストールします

dnf install -y cuda

6. AI フレームワーク tensorflow/pytorch をインストールします

現在、tensorflow/pytorch の CPU 版を提供していますが、将来的には GPU 版の AI フレームワークもサポートする予定です。

dnf インストール tensorflow -y dnf インストール pytorch -y

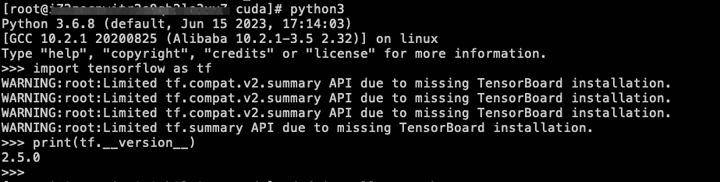

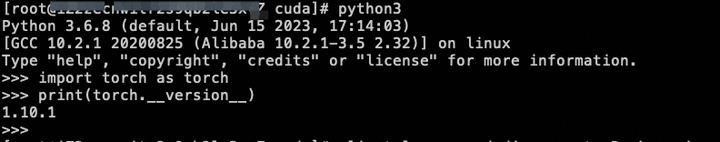

インストールが完了したら、簡単なコマンドでインストールが成功したかどうかを確認できます:

7. 導入モデル

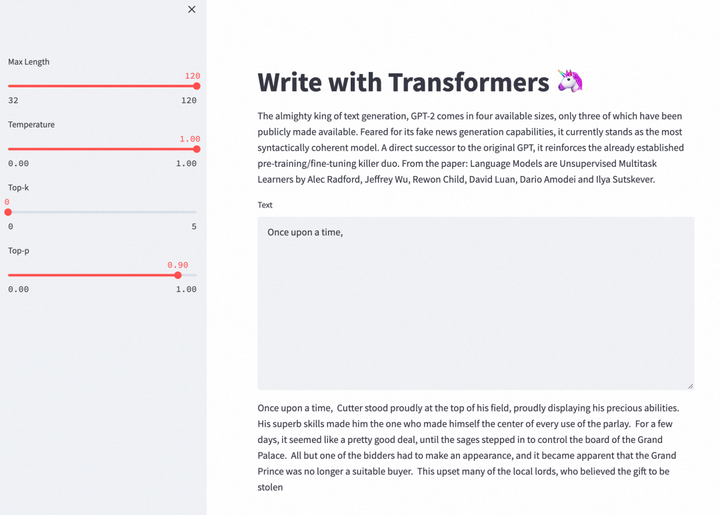

Alinux 3 の AI に対するエコロジカル サポートを使用して、GPT-2 Large モデルをデプロイして、この記事の執筆タスクを続行できます。

Git と Git LFS をインストールして、その後のモデルのダウンロードを容易にします。

dnf install -y git git-lfs wget

pip を更新して、その後の Python 環境のデプロイメントを容易にします。

python -m pip install --upgrade pip

Git LFS サポートを有効にします。

git lfs インストール

write-with-transformer プロジェクトのソース コードと事前トレーニングされたモデルをダウンロードします。 write-with-transformer プロジェクトは、GPT-2 ラージ モデルを使用してコンテンツを書き続けることができる Web ライティング APP です。

git clone https://huggingface.co/spaces/merve/write-with-transformer

GIT_LFS_SKIP_SMUDGE=1 git クローン https://huggingface.co/gpt2-large

wget https://huggingface.co/gpt2-large/resolve/main/pytorch_model.bin -O gpt2-large/pytorch_model.bin

write-with-transformer に必要な依存環境をインストールします。

cd ~/write-with-transformer

pip install --ignore-installed pyyaml==5.1

pip install -r 要件.txt

環境をデプロイした後、Web バージョンの APP を実行して、GPT-2 を利用して書く楽しみを体験できます。現在、GPT-2 は英語でのテキスト生成のみをサポートしています。

cd ~/write-with-transformer

sed -i 's?"gpt2-large"?"../gpt2-large"?g' app.py

sed -i '34s/10/32/;34s/30/120/' app.py

streamlit 実行 app.py --server.port 7860

エコー情報が外部 URL: http://

クリックして今すぐクラウド製品を無料でお試しください: https://click.aliyun.com/m/1000373503/

元のリンク: https://click.aliyun.com/m/1000379727/

この記事は Alibaba Cloud のオリジナルコンテンツであり、許可なく複製することはできません。

以上がGPU インスタンスを使用して、AI エコシステムに対する Alibaba Cloud Linux 3 のサポートを実証するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。