AI モデルにおける人種および性別の偏見を評価するためのメタ オープンソース FACET ツール

9 月 2 日のニュース、Meta Company は最近、現在の多くのコンピューター ビジョン モデルにおける女性および有色人種に対する体系的な偏見とジェンダー バイアスの問題を軽減するために、コンピューター ビジョン システムで人種を識別する FACET と呼ばれる新しい AI ツールを発表しました。 。

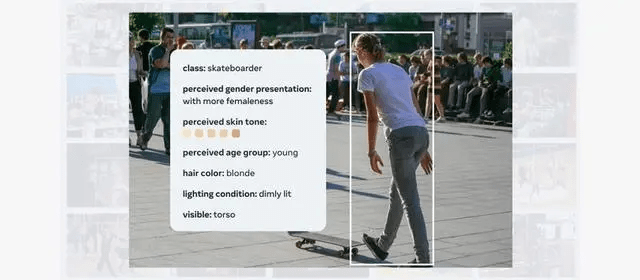

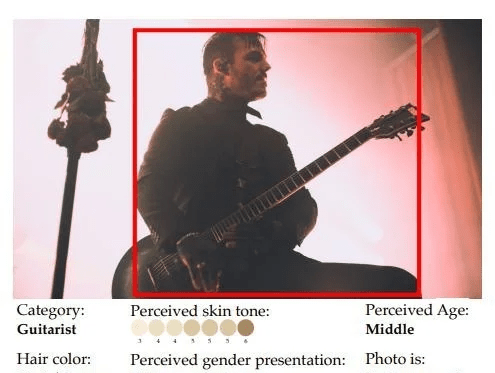

FACET ツールは現在、50,000 人の画像を含む 30,000 枚の画像でトレーニングされています。特に性別と肌の色の認識が強化されており、さまざまな特徴に関するコンピューター ビジョン モデルを評価するために使用できます。

FACET ツールは、男性をスケートボーダーとして識別することや、肌の色が明るいか暗いかなど、複雑な質問に答えるようにトレーニングできます。

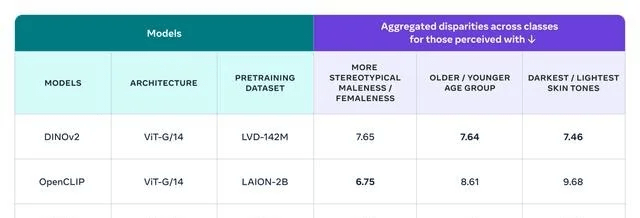

Meta は、FACET を使用して、同社が開発した DINOv2 モデルと SEERv2 モデル、および OpenAI の OpenCLIP モデルを評価しました。全体的に、OpenCLIP は性別の点で他のモデルよりも優れたパフォーマンスを示しましたが、DINOv は年齢と肌の色で優れたパフォーマンスを示しました。判定。

FACET は、研究者が同様のベンチマークを実行して独自のモデルのバイアスを理解し、公平性の問題に対処するために講じられた緩和策の影響を監視するのに役立ちます。 IT House はここに Meta のプレス リリース アドレスを添付しており、興味のあるユーザーはそれを詳しく読むことができます。

[出典: IT ホーム]

以上がAI モデルにおける人種および性別の偏見を評価するためのメタ オープンソース FACET ツールの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7629

7629

15

15

1389

1389

52

52

89

89

11

11

31

31

141

141

2025年2月のトップ5 Genai発売:GPT-4.5、Grok-3など!

Mar 22, 2025 am 10:58 AM

2025年2月のトップ5 Genai発売:GPT-4.5、Grok-3など!

Mar 22, 2025 am 10:58 AM

2025年2月は、生成AIにとってさらにゲームを変える月であり、最も期待されるモデルのアップグレードと画期的な新機能のいくつかをもたらしました。 Xai’s Grok 3とAnthropic's Claude 3.7 SonnetからOpenaiのGまで

オブジェクト検出にYolo V12を使用する方法は?

Mar 22, 2025 am 11:07 AM

オブジェクト検出にYolo V12を使用する方法は?

Mar 22, 2025 am 11:07 AM

Yolo(あなたは一度だけ見ています)は、前のバージョンで各反復が改善され、主要なリアルタイムオブジェクト検出フレームワークでした。最新バージョンYolo V12は、精度を大幅に向上させる進歩を紹介します

クリエイティブプロジェクトのための最高のAIアートジェネレーター(無料&有料)

Apr 02, 2025 pm 06:10 PM

クリエイティブプロジェクトのための最高のAIアートジェネレーター(無料&有料)

Apr 02, 2025 pm 06:10 PM

この記事では、トップAIアートジェネレーターをレビューし、その機能、創造的なプロジェクトへの適合性、価値について説明します。 Midjourneyを専門家にとって最高の価値として強調し、高品質でカスタマイズ可能なアートにDall-E 2を推奨しています。

ChatGpt 4 oは利用できますか?

Mar 28, 2025 pm 05:29 PM

ChatGpt 4 oは利用できますか?

Mar 28, 2025 pm 05:29 PM

CHATGPT 4は現在利用可能で広く使用されており、CHATGPT 3.5のような前任者と比較して、コンテキストを理解し、一貫した応答を生成することに大幅な改善を示しています。将来の開発には、よりパーソナライズされたインターが含まれる場合があります

ベストAIチャットボットが比較されました(chatgpt、gemini、claude& more)

Apr 02, 2025 pm 06:09 PM

ベストAIチャットボットが比較されました(chatgpt、gemini、claude& more)

Apr 02, 2025 pm 06:09 PM

この記事では、ChatGpt、Gemini、ClaudeなどのトップAIチャットボットを比較し、自然言語の処理と信頼性における独自の機能、カスタマイズオプション、パフォーマンスに焦点を当てています。

Meta Llama 3.2を始めましょう - 分析Vidhya

Apr 11, 2025 pm 12:04 PM

Meta Llama 3.2を始めましょう - 分析Vidhya

Apr 11, 2025 pm 12:04 PM

メタのラマ3.2:マルチモーダルとモバイルAIの前進 メタは最近、ラマ3.2を発表しました。これは、モバイルデバイス向けに最適化された強力なビジョン機能と軽量テキストモデルを特徴とするAIの大幅な進歩です。 成功に基づいてo

トップAIライティングアシスタントは、コンテンツの作成を後押しします

Apr 02, 2025 pm 06:11 PM

トップAIライティングアシスタントは、コンテンツの作成を後押しします

Apr 02, 2025 pm 06:11 PM

この記事では、Grammarly、Jasper、Copy.ai、Writesonic、RytrなどのトップAIライティングアシスタントについて説明し、コンテンツ作成のためのユニークな機能に焦点を当てています。 JasperがSEOの最適化に優れているのに対し、AIツールはトーンの維持に役立つと主張します

空間インデックス作成用のUber' s H3のガイド

Mar 22, 2025 am 10:54 AM

空間インデックス作成用のUber' s H3のガイド

Mar 22, 2025 am 10:54 AM

今日のデータ駆動型の世界では、ライドシェアリングやロジスティクスから環境監視や災害対応に至るまでのアプリケーションには、効率的な地理空間インデックスが重要です。 UberのH3、強力なオープンソーススパット