Googleの「大きな動き」によって何社のAIラベル会社が潰されるだろうか?

小さな手作り工房は結局、工場の組立ラインには敵いません。

現在の生成型 AI が元気に成長する子供のようなものだとすると、際限なく流れてくるデータが成長の糧となります。

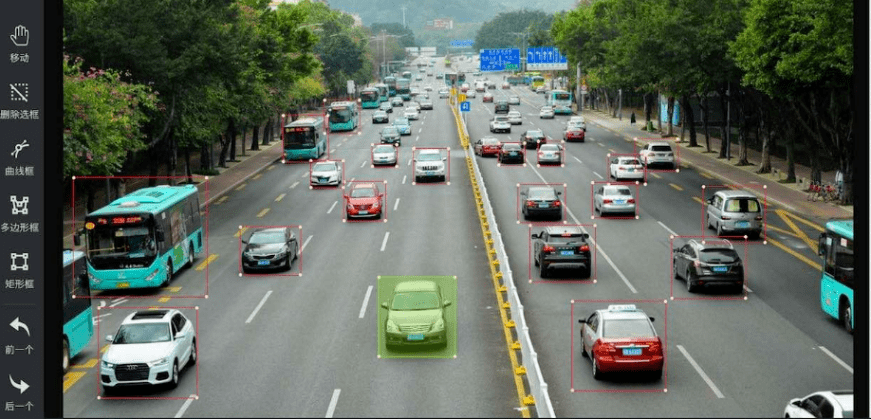

データアノテーションはこの「食べ物」を作るプロセスです

しかし、このプロセスは非常に複雑で面倒です。

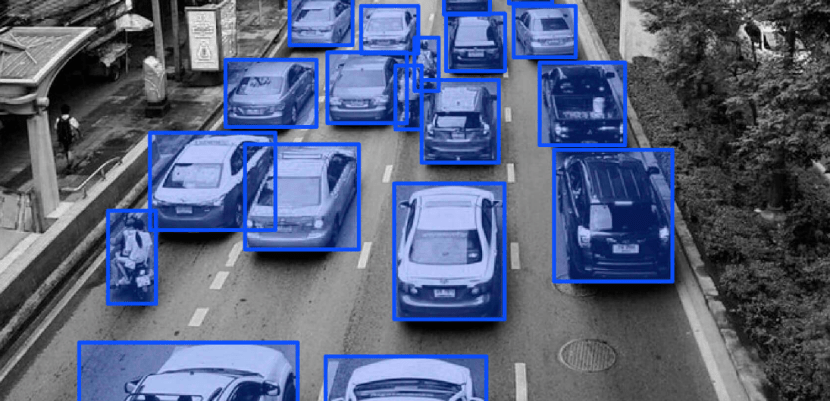

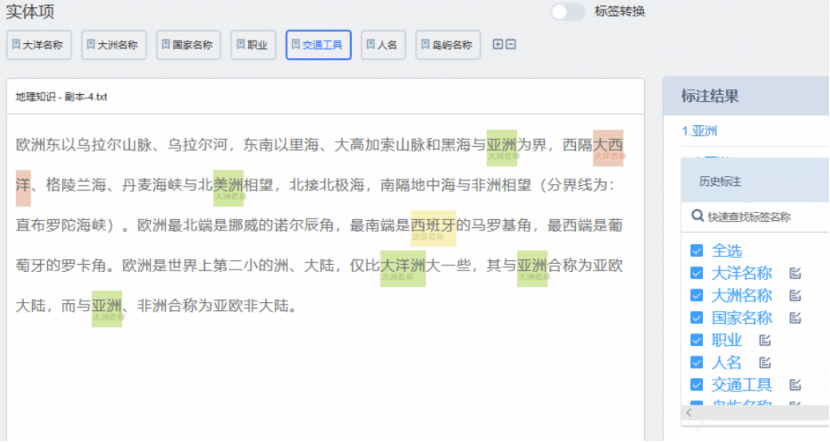

アノテーションを実行する「アノテーター」は、画像内のさまざまなオブジェクト、色、形状などを繰り返し識別する必要があるだけでなく、場合によってはデータをクリーニングして前処理する必要さえあります。

人工知能テクノロジーの継続的な進歩に伴い、手動によるデータ注釈の限界がますます明らかになってきています。手動のデータ注釈は時間とエネルギーを消費するだけでなく、品質を確保するのが難しい場合もあります

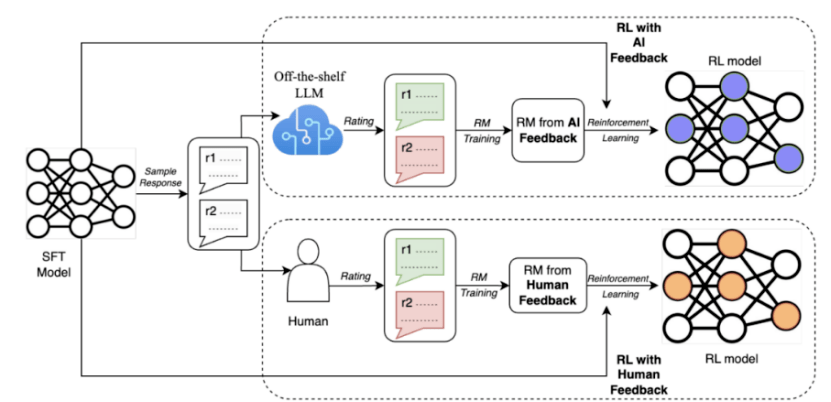

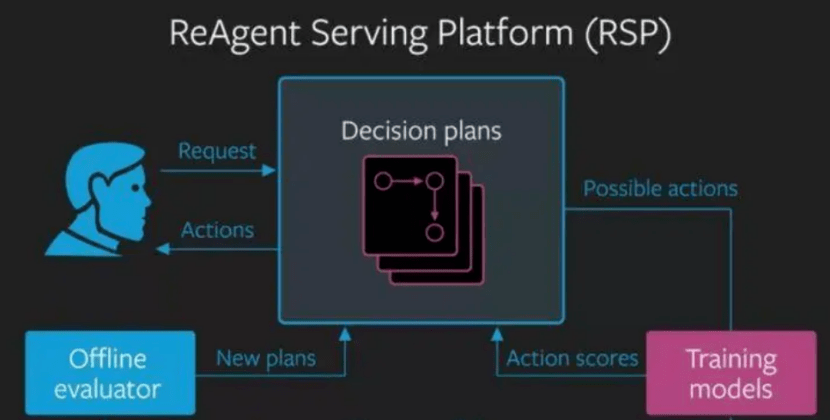

これらの問題を解決するために、Google は最近、AI フィードバック強化学習 (RLAIF) と呼ばれる方法を提案しました。これは、大規模なモデルを使用して人間の好みのアノテーションを置き換えます

研究結果は、RLAIF が人間のアノテーションに依存せずにヒューマン フィードバック強化学習 (RLHF) と同等の改善を達成でき、両方の勝率が 50% であることを示しています。さらに、この研究では、RLAIF と RLHF の両方が教師あり微調整 (SFT) のベースライン戦略よりも優れていることも判明しました。

これらの結果は、RLAIF が手動のアノテーションに依存する必要がなく、RLHF の実現可能な代替手段であることを示しています。

将来、このテクノロジーが実際に広く推進され、普及した場合、データの注釈付けを手動の「プルボックス」に依存している多くの企業は、絶望的な状況に直面することになるでしょうか?

01 データアノテーションの現在のステータス

国内アノテーション業界の現状を簡単にまとめると、業務量は多いものの、効率はあまり高くなく、恵まれない状態です。

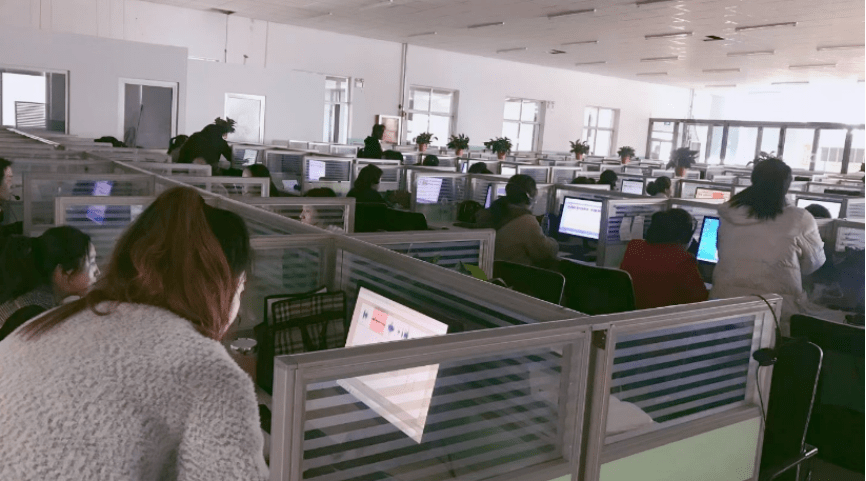

ラベル付けされた企業はAI分野ではデータファクトリーと呼ばれており、通常は東南アジアやアフリカ、あるいは中国の河南省、山西省、山東省など人材が豊富な地域に集中しています。コストを削減するために、ラベル会社の上司は郡内のスペースを借りてコンピューター機器を配置します。注文があれば近くでアルバイトスタッフを募集して対応し、注文がなければ解散して休憩するそうです。

簡単に言えば、この種の仕事は道端での一時的な装飾作業員に少し似ています。

ワークステーションでは、システムは「アノテーター」に一連のデータをランダムに提供します。これには通常、いくつかの質問といくつかの回答が含まれます。

ワークステーションでは、システムは「アノテーター」に一連のデータをランダムに提供します。これには通常、いくつかの質問といくつかの回答が含まれます。

その後、「アノテーター」はまず質問がどのタイプに属するかをマークし、次に回答をそれぞれ採点して並べ替える必要があります。

以前、国産の大型モデルとGPT-4などの先進的な大型モデルとの格差が話題になった際、国産データの質が低い理由をまとめていました。

データ品質が高くないのはなぜですか?理由の一部はデータ アノテーションの「パイプライン」にあります

現在、中国の大規模モデルには 2 種類のデータ ソースがあり、1 つはオープン ソース データ セット、もう 1 つはクローラーによってクロールされた中国のインターネット データです。

中国の大型モデルのパフォーマンスが十分でない主な理由の 1 つは、インターネット データの品質です。たとえば、専門家は通常、情報を検索するときに Baidu を使用しません。

したがって、医療や金融など、より専門的で垂直的なデータの問題に直面する場合は、専門チームと協力する必要があります。

したがって、医療や金融など、より専門的で垂直的なデータの問題に直面する場合は、専門チームと協力する必要があります。

しかし、この時点で問題が再び発生します。プロチームの場合、データの観点から復帰期間が長いだけでなく、先行者が損失を被る可能性が高くなります。

たとえば、あるアノテーション チームは多量のデータを作成するために多額の費用と時間を費やしましたが、他のチームはそれをパッケージ化して少額の金額で購入するだけかもしれません。

この「フリーライダーのジレンマ」に直面し、多くの国産大型モデルはデータは多いのに品質が高くないという奇妙な状況に陥っている

この場合、OpenAI などの大手 AI 企業は、この問題をどのように解決しているのでしょうか?

OpenAI は、データ アノテーションのコストを削減するために、安価で集約的な労働力の使用を諦めていません。

OpenAI は、データ アノテーションのコストを削減するために、安価で集約的な労働力の使用を諦めていません。

たとえば、有毒情報にラベルを付けるために、1 時間あたり 2 米ドルの料金で多数のケニア人労働者を雇っていたことが以前に明らかになりました。

ただし、重要な違いは、データ品質と注釈効率の問題をどのように解決するかです。

具体的には、この点における OpenAI と国内企業の最大の違いは、手動アノテーションの「主観性」と「不安定性」の影響をいかに軽減するかという点にあります。

02 OpenAIの手法 内容を書き換える場合、言語を中国語に書き換える必要があり、元の文章を表示する必要はありません

このようなヒューマン・アノテーターの「主観性」と「不安定性」を軽減するために、OpenAI は大きく 2 つの戦略を採用しています。

1. 人工フィードバックと強化学習の組み合わせ;

書き直す場合は、元の内容を中国語に変換する必要があります。書き換え後は次のようになります。 まず、ラベル付けについて説明します。 OpenAI の人工フィードバックと国産のものの最大の違いは、出力の変更やラベル付けではなく、主にインテリジェント システムの動作を並べ替えたりスコアリングしたりすることです。インテリジェント システムの動作とは、複雑な環境において、インテリジェント システムが独自の目標と戦略に従って実行する一連のアクションまたは決定を指します。

ゲームをする、ロボットを制御する、人々と話すなど。

インテリジェント システムの出力とは、記事を書く、絵を描くなどの単純なタスクにおいて、入力データに基づいて結果や回答を生成することを指します。

「好み」や「満足度」に基づくこの種の評価システムでは、特定のコンテンツの修正やマーキングが必要ないため、人間の主観や知識レベル、その他の要素がデータアノテーションの品質と精度に及ぼす影響が軽減されます

確かに、国内企業もラベル付けの際に「ソート」や「スコアリング」と同様のシステムを利用することになるでしょうが、インテリジェント企業の戦略を最適化するための報酬関数としてOpenAIのような「報酬モデル」が存在しないため、システムでは、そのような「並べ替え」や「スコアリング」は依然として本質的には出力を変更したり注釈を付けたりする方法です。

国内のデータ アノテーション ソースは、主にサードパーティのアノテーション会社またはテクノロジー企業の自社チームから提供されていますが、これらのチームはほとんどが学部生で構成されており、十分な専門性と経験が不足しているため、高品質で効率的なフィードバックを提供することが困難です。

対照的に、OpenAI の人的フィードバックは複数のチャネルとチームを通じて取得されます

OpenAI は、Scale AI、Appen、Lionbridge AI などの多くのデータ企業や機関と協力しており、オープンソース データ セットやインターネット クローラーを使用してデータを取得するだけでなく、より多様で高度なデータの取得にも取り組んでいます。 -品質データ

OpenAI は、Scale AI、Appen、Lionbridge AI などの多くのデータ企業や機関と協力しており、オープンソース データ セットやインターネット クローラーを使用してデータを取得するだけでなく、より多様で高度なデータの取得にも取り組んでいます。 -品質データ

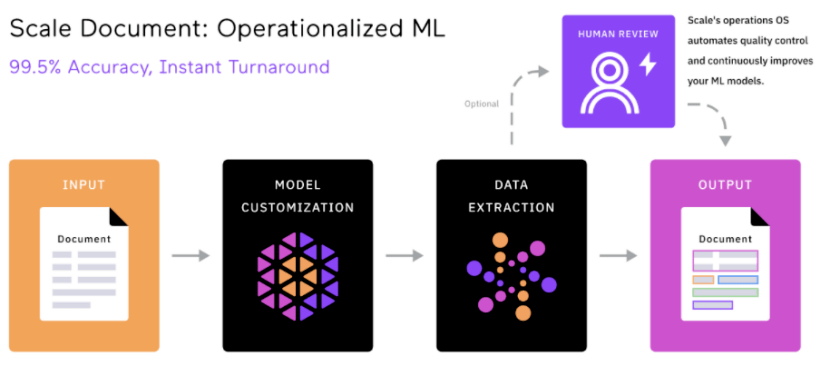

これらのデータ企業や機関のアノテーション方法は、国内のデータ企業や機関よりも「自動化」され、「インテリジェント」になっています

たとえば、Scale AI は、Snorkel と呼ばれるテクノロジーを使用しています。これは、複数の不正確なデータ ソースから高品質のラベルを生成できる、弱教師あり学習に基づくデータ ラベル付け手法です。

同時に、Snorkel は、ルール、モデル、知識ベースなどのさまざまな信号を使用して、各データ ポイントに手動で直接ラベルを付けることなく、データにラベルを追加することもできます。これにより、手動による注釈のコストと時間を大幅に削減できます。

同時に、Snorkel は、ルール、モデル、知識ベースなどのさまざまな信号を使用して、各データ ポイントに手動で直接ラベルを付けることなく、データにラベルを追加することもできます。これにより、手動による注釈のコストと時間を大幅に削減できます。

データ アノテーションのコストが削減され、サイクルが短縮されることで、競争上の優位性を持つデータ企業は、自動運転、大規模な言語モデル、合成データなど、価値が高く、困難で、しきい値の高い細分化を選択できるようになります。核となる競争力と差別化された利点を継続的に改善するための

このようにして、「先行者が苦しむ」というただ乗りのジレンマも、技術的および業界の強力な障壁によって解消されました。

このようにして、「先行者が苦しむ」というただ乗りのジレンマも、技術的および業界の強力な障壁によって解消されました。

AI 自動ラベル付けテクノロジーが実際に排除するのは、依然として純粋に手動ラベル付けを使用しているラベル付け会社だけであることがわかります。

データ アノテーションは「労働集約的」な業界のように聞こえますが、詳細を掘り下げてみると、高品質のデータを追求するのは簡単な作業ではないことがわかります。海外データアノテーションのユニコーンであるScale AIを代表とするScale AIは、アフリカなどからの安価な人材を活用するだけでなく、さまざまな業界の専門的なデータを扱うために数十人の博士号を採用している。

Scale AI が OpenAI などの大規模モデル企業に提供する最大の価値は、データ アノテーションの品質です

データ品質を最大限に確保するために、上記の AI 支援アノテーションの使用に加えて、Scale AI のもう 1 つの主要なイノベーションは、統合データ プラットフォームです。

これらのプラットフォームには、Scale Audit、Scale Analytics、ScaleData Quality などが含まれます。これらのプラットフォームを通じて、顧客は注釈プロセスのさまざまな指標を監視および分析し、注釈データを検証および最適化し、注釈の精度、一貫性、完全性を評価できます。

このような標準化され統一されたツールとプロセスは、ラベル会社における 「組立ライン工場」 と 「手作り工房」 を区別する重要な要素となっていると言えます。

この点に関して、国内のアノテーション会社のほとんどは依然としてデータアノテーションの品質をレビューするために「手動レビュー」を使用しており、EasyData Intelligence データ サービス プラットフォームなどのより高度な管理および評価ツールを導入しているのは、Baidu などの少数の大手企業だけです。

アノテーションの結果と指標を監視および分析するための専用ツールがない場合、主要なデータの監査に関して、データ品質管理は手動の経験に頼るしかなく、この方法は依然としてワークショップスタイルのレベルにしか到達できません

したがって、Baidu、となりのトトロ データなど、ますます多くの中国企業が機械学習と人工知能技術を使用して、データ アノテーションの効率と品質を向上させ、人間と機械のモデルを実現し始めています。コラボレーション###

この観点から見ると、人工知能ラベリングの出現は、国内のラベリング会社の終焉を意味するのではなく、技術的内容が欠如し、非効率で安価で労働集約的な従来のラベリング方法の終焉を意味します。以上がGoogleの「大きな動き」によって何社のAIラベル会社が潰されるだろうか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7748

7748

15

15

1643

1643

14

14

1397

1397

52

52

1291

1291

25

25

1234

1234

29

29

セサミオープンドア交換Webページ登録リンクゲートトレーディングアプリ登録Webサイト最新

Feb 28, 2025 am 11:06 AM

セサミオープンドア交換Webページ登録リンクゲートトレーディングアプリ登録Webサイト最新

Feb 28, 2025 am 11:06 AM

この記事では、SESAME Open Exchange(gate.io)Webバージョンの登録プロセスとGate Tradingアプリを詳細に紹介します。 Web登録であろうとアプリの登録であろうと、公式Webサイトまたはアプリストアにアクセスして、本物のアプリをダウンロードし、ユーザー名、パスワード、電子メール、携帯電話番号、その他の情報を入力し、電子メールまたは携帯電話の確認を完了する必要があります。

セサミオープンドアエクスチェンジウェブページログイン最新バージョンgateio公式ウェブサイトの入り口

Mar 04, 2025 pm 11:48 PM

セサミオープンドアエクスチェンジウェブページログイン最新バージョンgateio公式ウェブサイトの入り口

Mar 04, 2025 pm 11:48 PM

ログインステップやパスワード回復プロセスなど、セサミオープンエクスチェンジWebバージョンのログイン操作の詳細な紹介も、ログイン障害、ページを開くことができず、プラットフォームにスムーズにログインするのに役立つ検証コードを受信できません。

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか?

Feb 21, 2025 pm 10:57 PM

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか?

Feb 21, 2025 pm 10:57 PM

Bybit Exchangeリンクを直接ダウンロードしてインストールできないのはなぜですか? BYBITは、ユーザーにトレーディングサービスを提供する暗号通貨交換です。 Exchangeのモバイルアプリは、次の理由でAppStoreまたはGooglePlayを介して直接ダウンロードすることはできません。1。AppStoreポリシーは、AppleとGoogleがApp Storeで許可されているアプリケーションの種類について厳しい要件を持つことを制限しています。暗号通貨交換アプリケーションは、金融サービスを含み、特定の規制とセキュリティ基準を必要とするため、これらの要件を満たしていないことがよくあります。 2。法律と規制のコンプライアンス多くの国では、暗号通貨取引に関連する活動が規制または制限されています。これらの規制を遵守するために、BYBITアプリケーションは公式Webサイトまたはその他の認定チャネルを通じてのみ使用できます

Crypto Digital Asset Trading App(2025グローバルランキング)に推奨されるトップ10

Mar 18, 2025 pm 12:15 PM

Crypto Digital Asset Trading App(2025グローバルランキング)に推奨されるトップ10

Mar 18, 2025 pm 12:15 PM

この記事では、Binance、Okx、Gate.io、Bitflyer、Kucoin、Bybit、Coinbase Pro、Kraken、Bydfi、Xbit分散化された交換など、注意を払う価値のある上位10の暗号通貨取引プラットフォームを推奨しています。これらのプラットフォームには、トランザクションの数量、トランザクションの種類、セキュリティ、コンプライアンス、特別な機能の点で独自の利点があります。適切なプラットフォームを選択するには、あなた自身の取引体験、リスク許容度、投資の好みに基づいて包括的な検討が必要です。 この記事があなたがあなた自身に最適なスーツを見つけるのに役立つことを願っています

セサミオープンドアトレーディングプラットフォームダウンロードモバイルバージョンgateioトレーディングプラットフォームのダウンロードアドレス

Feb 28, 2025 am 10:51 AM

セサミオープンドアトレーディングプラットフォームダウンロードモバイルバージョンgateioトレーディングプラットフォームのダウンロードアドレス

Feb 28, 2025 am 10:51 AM

アプリをダウンロードしてアカウントの安全を確保するために、正式なチャネルを選択することが重要です。

Binance Binance公式Webサイト最新バージョンログインポータル

Feb 21, 2025 pm 05:42 PM

Binance Binance公式Webサイト最新バージョンログインポータル

Feb 21, 2025 pm 05:42 PM

Binance Webサイトログインポータルの最新バージョンにアクセスするには、これらの簡単な手順に従ってください。公式ウェブサイトに移動し、右上隅の[ログイン]ボタンをクリックします。既存のログインメソッドを選択してください。「登録」してください。登録済みの携帯電話番号または電子メールとパスワードを入力し、認証を完了します(モバイル検証コードやGoogle Authenticatorなど)。検証が成功した後、Binance公式WebサイトLogin Portalの最新バージョンにアクセスできます。

ビットゲット取引プラットフォーム公式アプリのダウンロードとインストールアドレス

Feb 25, 2025 pm 02:42 PM

ビットゲット取引プラットフォーム公式アプリのダウンロードとインストールアドレス

Feb 25, 2025 pm 02:42 PM

このガイドは、AndroidおよびiOSシステムに適した公式Bitget Exchangeアプリの詳細なダウンロードとインストール手順を提供します。このガイドは、公式ウェブサイト、App Store、Google Playなど、複数の権威ある情報源からの情報を統合し、ダウンロードおよびアカウント管理中の考慮事項を強調しています。ユーザーは、App Store、公式WebサイトAPKダウンロード、公式Webサイトジャンプ、完全な登録、ID検証、セキュリティ設定など、公式チャネルからアプリをダウンロードできます。さらに、ガイドはよくある質問や考慮事項をカバーします。

2025年のBitgetの最新のダウンロードアドレス:公式アプリを取得する手順

Feb 25, 2025 pm 02:54 PM

2025年のBitgetの最新のダウンロードアドレス:公式アプリを取得する手順

Feb 25, 2025 pm 02:54 PM

このガイドは、AndroidおよびiOSシステムに適した公式Bitget Exchangeアプリの詳細なダウンロードとインストール手順を提供します。このガイドは、公式ウェブサイト、App Store、Google Playなど、複数の権威ある情報源からの情報を統合し、ダウンロードおよびアカウント管理中の考慮事項を強調しています。ユーザーは、App Store、公式WebサイトAPKダウンロード、公式Webサイトジャンプ、完全な登録、ID検証、セキュリティ設定など、公式チャネルからアプリをダウンロードできます。さらに、ガイドはよくある質問や考慮事項をカバーします。