iPhone に隠されたロボット: GPT-2 アーキテクチャに基づいており、絵文字トークナイザーを備え、MIT 卒業生によって開発されました

愛好家たちが Apple の Transformer の「秘密」を暴露

大型モデルの波の影響で、保守的な Apple も記者会見のたびに必ず「Transformer」について言及する

たとえば, 今年のWWDCで、AppleはiOSとmacOSの新しいバージョンにTransformer言語モデルが組み込まれ、テキスト予測機能を備えた入力方法を提供すると発表しました。

Apple 関係者はこれ以上の情報を明らかにしませんでしたが、テクノロジー愛好家は待ちきれません。

Jack Cook という名前の人が翻訳に成功しました macOS Sonoma の新しい章が始まりました

- #モデル アーキテクチャに関して、ブラザー クック氏は、Apple の言語モデルは

- GPT-2built に基づいていると考えています。 トークナイザー

- に関して言えば、絵文字 はその中でも非常に顕著です。 詳細については、見てみましょう。

GPT-2 アーキテクチャに基づく

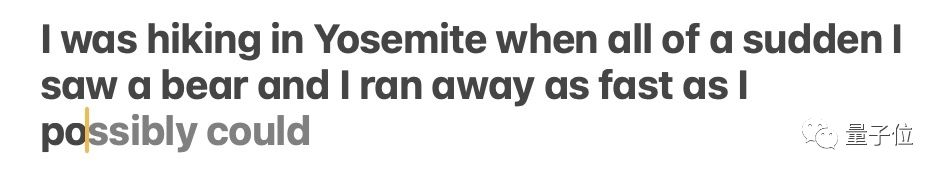

まず、Apple の Transformer ベースの言語モデルが iPhone、MacBook、その他のデバイスで実現できる機能を確認しましょう

必要な機能書き換え予定内容は主にインプットメソッドに反映されます。言語モデルのサポートにより、Apple 独自の入力メソッドは単語予測と誤り訂正機能を実現できます

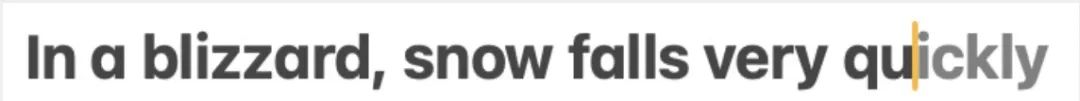

Jack Cook が詳細にテストし、主にこの機能が実現されることを発見しました単一の単語の予測です。

Jack Cook が詳細にテストし、主にこの機能が実現されることを発見しました単一の単語の予測です。

書き直す必要がある内容は次のとおりです: △出典: Jack Cook のブログ投稿

書き直す必要がある内容は次のとおりです: △出典: Jack Cook のブログ投稿

モデルは、今後複数の単語を予測することもありますが、これは文の意味が非常に明白な状況に限定されており、Gmail のオートコンプリート機能に似ています。

書き直す必要がある内容は次のとおりです: △出典: Jack Cook のブログ投稿

書き直す必要がある内容は次のとおりです: △出典: Jack Cook のブログ投稿

それでは、このモデルはどこに設置されているのでしょうか?徹底的に調査した結果、クック兄弟は次のように判断しました。

/System/Library/LinguisticData/RequiredAssets_en.bundle/AssetData/en.lm/unilm.bundle で予測テキスト モデルを見つけました。

理由は次のとおりです:

unilm.bundle 内の多くのファイルは macOS Ventura (13.5) には存在せず、macOS Sonoma ベータ (14.0) の新しいバージョンにのみ表示されます。- unilm.bundle には sp.dat ファイルがあり、Ventura および Sonoma ベータ版にありますが、Sonoma ベータ版は明らかにトークナイザーのように見えるトークンのセットで更新されています。

- sp.dat 内のトークンの数は、unilm.bundle 内の 2 つのファイル (unilm_joint_cpu.espresso.shape および unilm_joint_ane.espresso.shape) と一致します。これら 2 つのファイルは、Espresso/CoreML モデルの各レイヤーの形状を記述します。

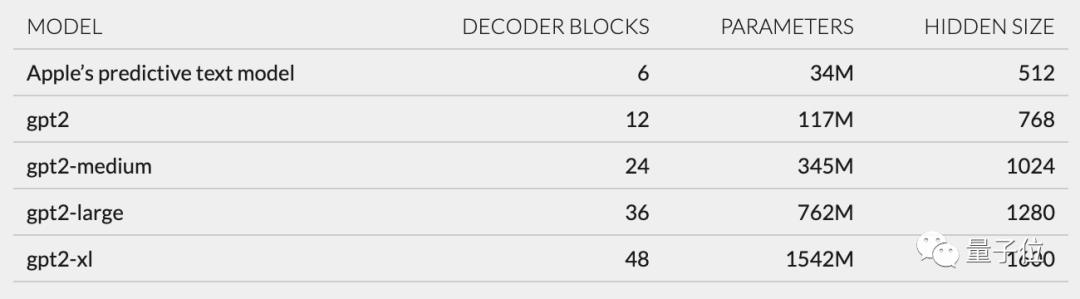

- unilm_joint_cpu で説明されているネットワーク構造に基づくさらなる推測では、Apple モデルは GPT-2 アーキテクチャに基づいて構築されていると考えられます

主なコンポーネントにはトークンの埋め込みと位置が含まれますエンコーディング、デコーダー ブロック、出力レイヤーでは、各デコーダー ブロックに「gpt2_transformer_layer_3d」のような単語が表示されます。

書き換える必要がある内容は次のとおりです。 △出典: Jack Cook のブログpost

書き換える必要がある内容は次のとおりです。 △出典: Jack Cook のブログpost

各層のサイズに基づいて、Apple モデルには約 3,400 万のパラメータがあり、隠れ層のサイズは 512 であると私は推測しました。言い換えれば、GPT-2

の最小バージョンよりも小さいということですが、これは主に Apple が電力消費があまりなく、同時に高速かつ頻繁に実行できるモデルを望んでいるからだと思います。

そして、WWDC での Apple の公式声明は、「キーがクリックされるたびに、iPhone はモデルを 1 回実行します」です。

ただし、これは、このテキスト予測モデルが文章や段落をうまく続けることができないことも意味します。

書き直す必要がある内容は次のとおりです。 △出典: In Jack Cook のブログ投稿

書き直す必要がある内容は次のとおりです。 △出典: In Jack Cook のブログ投稿

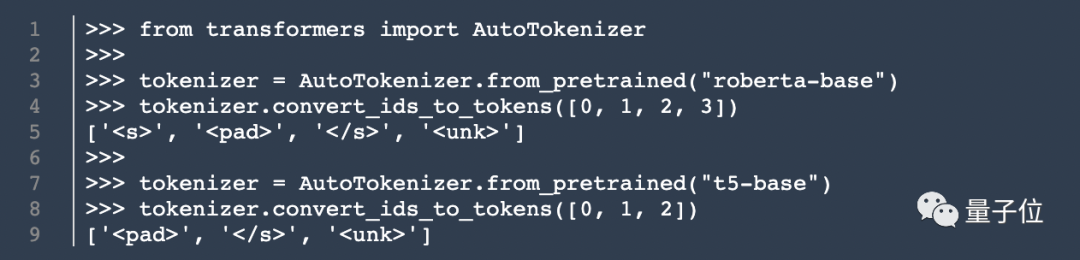

モデル アーキテクチャに加えて、Brother Cook はトークナイザー

(トークナイザー) に関する関連情報も掘り出しました。 彼は unilm.bundle/sp.dat で 15,000 個のトークンのセットを見つけました。これには 100 個の絵文字 が含まれていることは注目に値します。 このクックはそのクックではありませんが、私のブログ投稿は公開されるやいなや多くの注目を集めました 彼の調査結果に基づいて、ネチズンはユーザーエクスペリエンスと最先端のテクノロジーアプリケーションのバランスを取るためのAppleのアプローチについて熱心に議論しました。 ジャック クック自身の話に戻りますが、彼はコンピュータ サイエンスの学士号と修士号を取得して MIT を卒業し、現在インターネット社会科学の修士号取得に向けて勉強しています。オックスフォード大学。 彼は以前、NVIDIA でインターンとして、BERT などの言語モデルの研究に重点を置いていました。彼は、ニューヨーク タイムズ紙で自然言語処理のシニア R&D エンジニアも務めています。クックはクックを明らかにします

以上がiPhone に隠されたロボット: GPT-2 アーキテクチャに基づいており、絵文字トークナイザーを備え、MIT 卒業生によって開発されましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7557

7557

15

15

1384

1384

52

52

83

83

11

11

28

28

96

96

Centosシャットダウンコマンドライン

Apr 14, 2025 pm 09:12 PM

Centosシャットダウンコマンドライン

Apr 14, 2025 pm 09:12 PM

Centos Shutdownコマンドはシャットダウンし、構文はシャットダウン[オプション]時間[情報]です。オプションは次のとおりです。-hシステムをすぐに停止します。 -pシャットダウン後に電源をオフにします。 -r再起動; -t待機時間。時間は、即時(現在)、数分(分)、または特定の時間(HH:mm)として指定できます。追加の情報をシステムメッセージに表示できます。

CentOS HDFS構成をチェックする方法

Apr 14, 2025 pm 07:21 PM

CentOS HDFS構成をチェックする方法

Apr 14, 2025 pm 07:21 PM

CENTOSシステムでHDFS構成をチェックするための完全なガイドこの記事では、CENTOSシステム上のHDFSの構成と実行ステータスを効果的に確認する方法をガイドします。次の手順は、HDFSのセットアップと操作を完全に理解するのに役立ちます。 Hadoop環境変数を確認します。最初に、Hadoop環境変数が正しく設定されていることを確認してください。端末では、次のコマンドを実行して、Hadoopが正しくインストールおよび構成されていることを確認します。HDFS構成をチェックするHDFSファイル:HDFSのコア構成ファイルは/etc/hadoop/conf/ディレクトリにあります。使用

Centosのgitlabのバックアップ方法は何ですか

Apr 14, 2025 pm 05:33 PM

Centosのgitlabのバックアップ方法は何ですか

Apr 14, 2025 pm 05:33 PM

Centosシステムの下でのGitlabのバックアップと回復ポリシーデータセキュリティと回復可能性を確保するために、Gitlab on Centosはさまざまなバックアップ方法を提供します。この記事では、いくつかの一般的なバックアップ方法、構成パラメーター、リカバリプロセスを詳細に紹介し、完全なGitLabバックアップと回復戦略を確立するのに役立ちます。 1.手動バックアップGitlab-RakeGitlabを使用:バックアップ:コマンドを作成して、マニュアルバックアップを実行します。このコマンドは、gitlabリポジトリ、データベース、ユーザー、ユーザーグループ、キー、アクセスなどのキー情報をバックアップします。デフォルトのバックアップファイルは、/var/opt/gitlab/backupsディレクトリに保存されます。 /etc /gitlabを変更できます

CentosのPytorchのGPUサポートはどのようにサポートされていますか

Apr 14, 2025 pm 06:48 PM

CentosのPytorchのGPUサポートはどのようにサポートされていますか

Apr 14, 2025 pm 06:48 PM

Pytorch GPUアクセラレーションを有効にすることで、CentOSシステムでは、PytorchのCUDA、CUDNN、およびGPUバージョンのインストールが必要です。次の手順では、プロセスをガイドします。CUDAおよびCUDNNのインストールでは、CUDAバージョンの互換性が決定されます。NVIDIA-SMIコマンドを使用して、NVIDIAグラフィックスカードでサポートされているCUDAバージョンを表示します。たとえば、MX450グラフィックカードはCUDA11.1以上をサポートする場合があります。 cudatoolkitのダウンロードとインストール:nvidiacudatoolkitの公式Webサイトにアクセスし、グラフィックカードでサポートされている最高のCUDAバージョンに従って、対応するバージョンをダウンロードしてインストールします。 cudnnライブラリをインストールする:

Dockerの原則の詳細な説明

Apr 14, 2025 pm 11:57 PM

Dockerの原則の詳細な説明

Apr 14, 2025 pm 11:57 PM

DockerはLinuxカーネル機能を使用して、効率的で孤立したアプリケーションランニング環境を提供します。その作業原則は次のとおりです。1。ミラーは、アプリケーションを実行するために必要なすべてを含む読み取り専用テンプレートとして使用されます。 2。ユニオンファイルシステム(UnionFS)は、違いを保存するだけで、スペースを節約し、高速化する複数のファイルシステムをスタックします。 3.デーモンはミラーとコンテナを管理し、クライアントはそれらをインタラクションに使用します。 4。名前空間とcgroupsは、コンテナの分離とリソースの制限を実装します。 5.複数のネットワークモードは、コンテナの相互接続をサポートします。これらのコア概念を理解することによってのみ、Dockerをよりよく利用できます。

Centosはmysqlをインストールします

Apr 14, 2025 pm 08:09 PM

Centosはmysqlをインストールします

Apr 14, 2025 pm 08:09 PM

CentOSにMySQLをインストールするには、次の手順が含まれます。適切なMySQL Yumソースの追加。 yumを実行して、mysql-serverコマンドをインストールして、mysqlサーバーをインストールします。ルートユーザーパスワードの設定など、MySQL_SECURE_INSTALLATIONコマンドを使用して、セキュリティ設定を作成します。必要に応じてMySQL構成ファイルをカスタマイズします。 MySQLパラメーターを調整し、パフォーマンスのためにデータベースを最適化します。

Centosでgitlabログを表示する方法

Apr 14, 2025 pm 06:18 PM

Centosでgitlabログを表示する方法

Apr 14, 2025 pm 06:18 PM

CENTOSシステムでGitLabログを表示するための完全なガイドこの記事では、メインログ、例外ログ、その他の関連ログなど、CentosシステムでさまざまなGitLabログを表示する方法をガイドします。ログファイルパスは、gitlabバージョンとインストール方法によって異なる場合があることに注意してください。次のパスが存在しない場合は、gitlabインストールディレクトリと構成ファイルを確認してください。 1.メインGitLabログの表示

CentosでPytorchの分散トレーニングを操作する方法

Apr 14, 2025 pm 06:36 PM

CentosでPytorchの分散トレーニングを操作する方法

Apr 14, 2025 pm 06:36 PM

Pytorchの分散トレーニングでは、Centosシステムでトレーニングには次の手順が必要です。Pytorchのインストール:PythonとPipがCentosシステムにインストールされていることです。 CUDAバージョンに応じて、Pytorchの公式Webサイトから適切なインストールコマンドを入手してください。 CPUのみのトレーニングには、次のコマンドを使用できます。PipinstalltorchtorchtorchvisionTorchaudioGPUサポートが必要な場合は、CUDAとCUDNNの対応するバージョンがインストールされ、インストールに対応するPytorchバージョンを使用してください。分散環境構成:分散トレーニングには、通常、複数のマシンまたは単一マシンの複数GPUが必要です。場所

書き直す必要がある内容は次のとおりです: △出典: Jack Cook のブログ投稿

書き直す必要がある内容は次のとおりです: △出典: Jack Cook のブログ投稿 書き直す必要がある内容は次のとおりです: △出典: Jack Cook のブログ投稿

書き直す必要がある内容は次のとおりです: △出典: Jack Cook のブログ投稿 書き換える必要がある内容は次のとおりです。 △出典: Jack Cook のブログpost

書き換える必要がある内容は次のとおりです。 △出典: Jack Cook のブログpost 書き直す必要がある内容は次のとおりです。 △出典: In Jack Cook のブログ投稿

書き直す必要がある内容は次のとおりです。 △出典: In Jack Cook のブログ投稿