理論的基盤があれば、徹底的な最適化を実行できます。

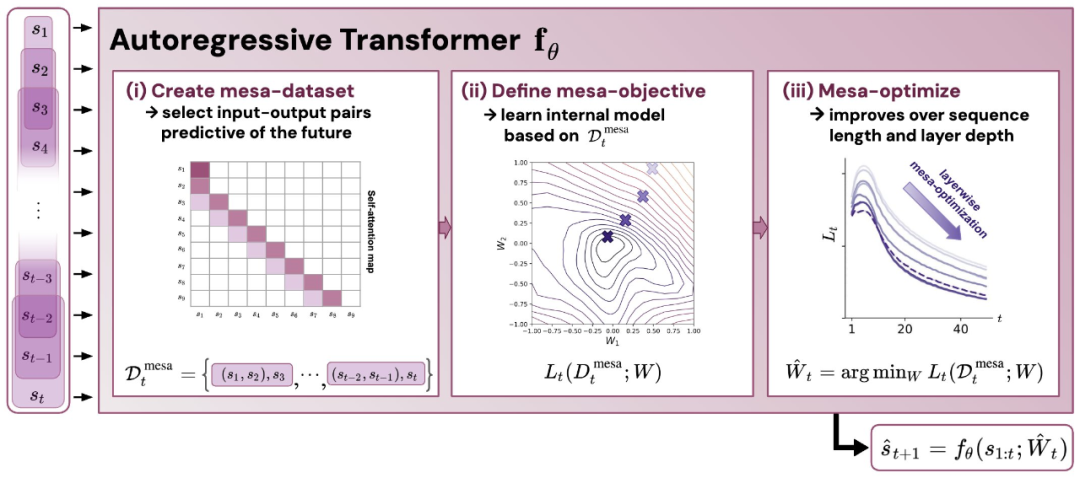

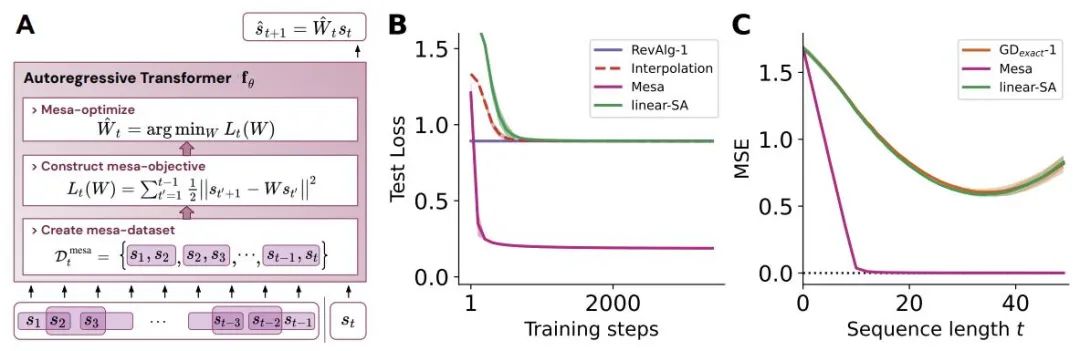

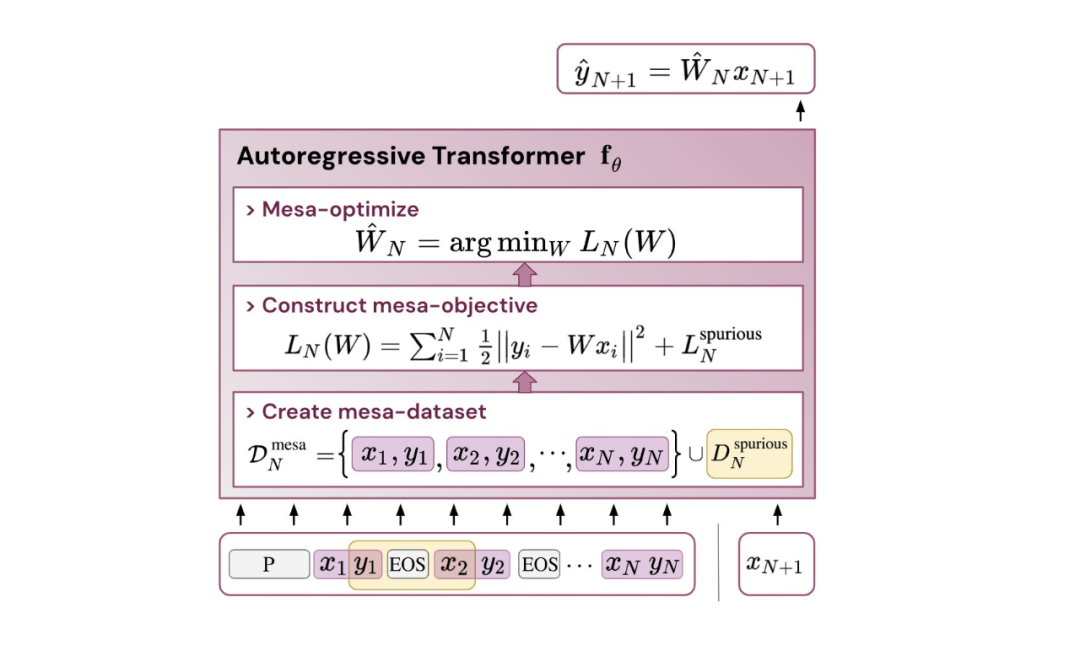

- 概要Oswald et al. は、勾配ベースの方法を使用して内部で構築された目的を最適化することで、Transformers が回帰からシーケンスの次の要素を理論的に予測する方法を示しています。

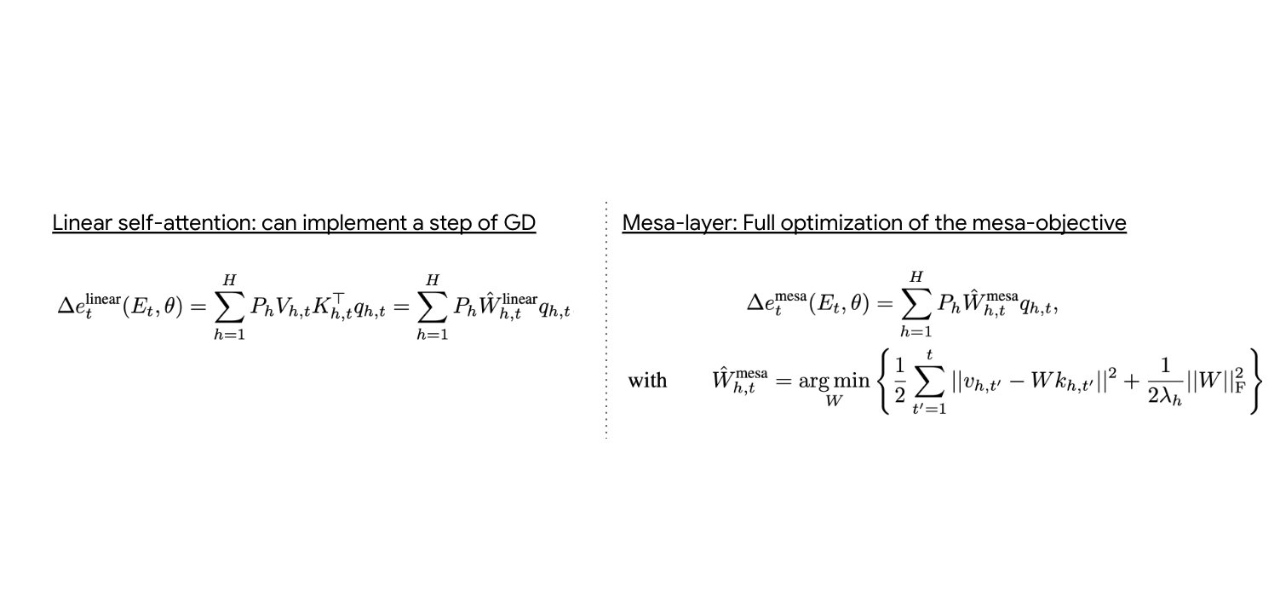

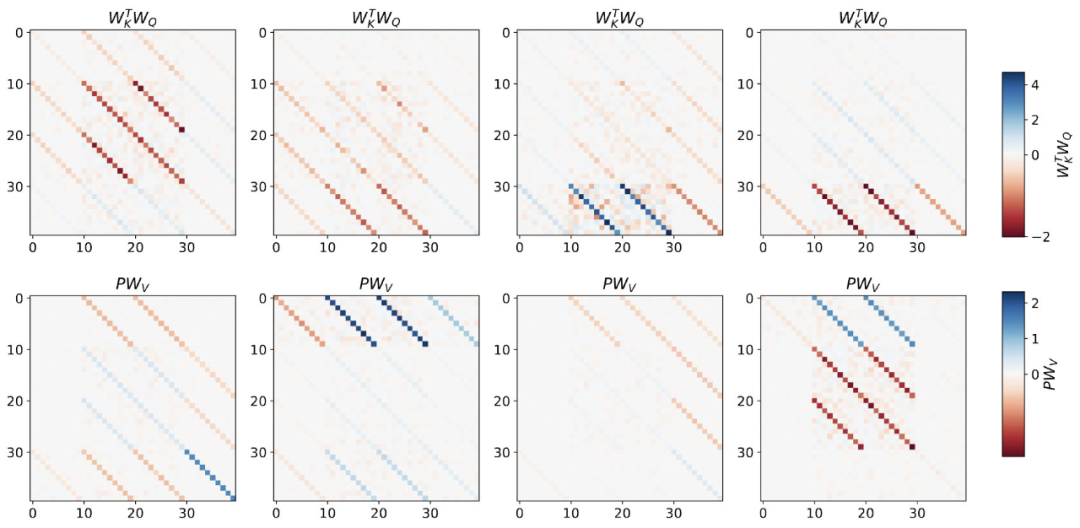

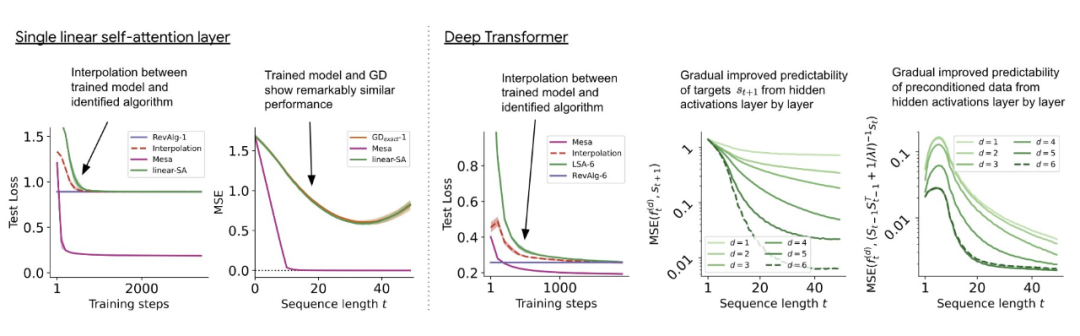

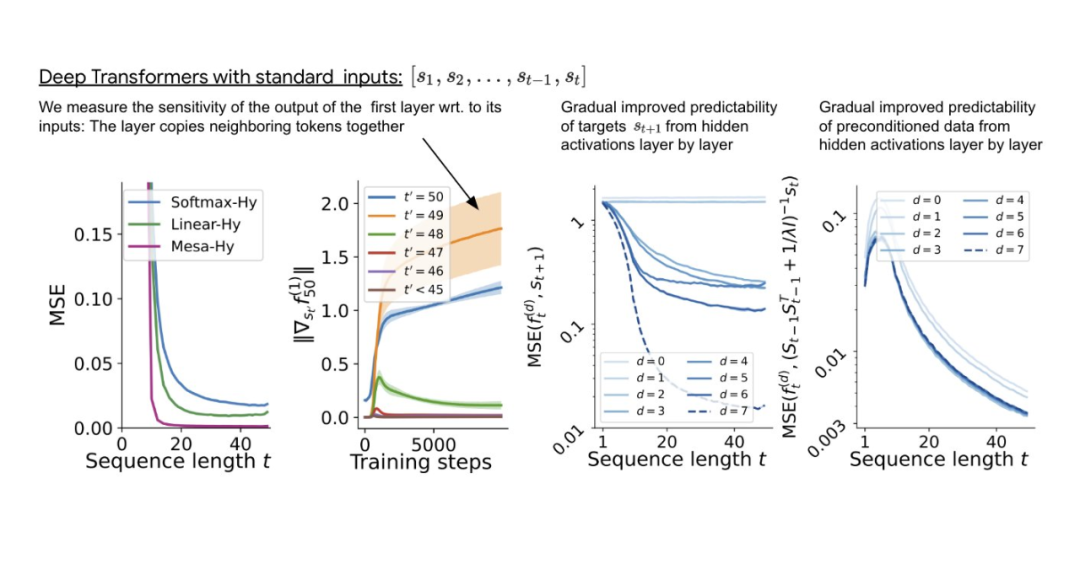

- シンプルなシーケンス モデリング タスクでトレーニングされたトランスフォーマーを実験的にリバース エンジニアリングし、フォワード パスが 2 段階のアルゴリズムを実装しているという強力な証拠を発見しました。 (i) 初期の自己注意層が内部トレーニングを構築するラベルをグループ化してコピーすることでデータセットを作成し、内部トレーニング データセットを暗黙的に構築します。内部目的関数を定義し、(ii) これらの目的をより深いレベルで最適化して予測を生成します。

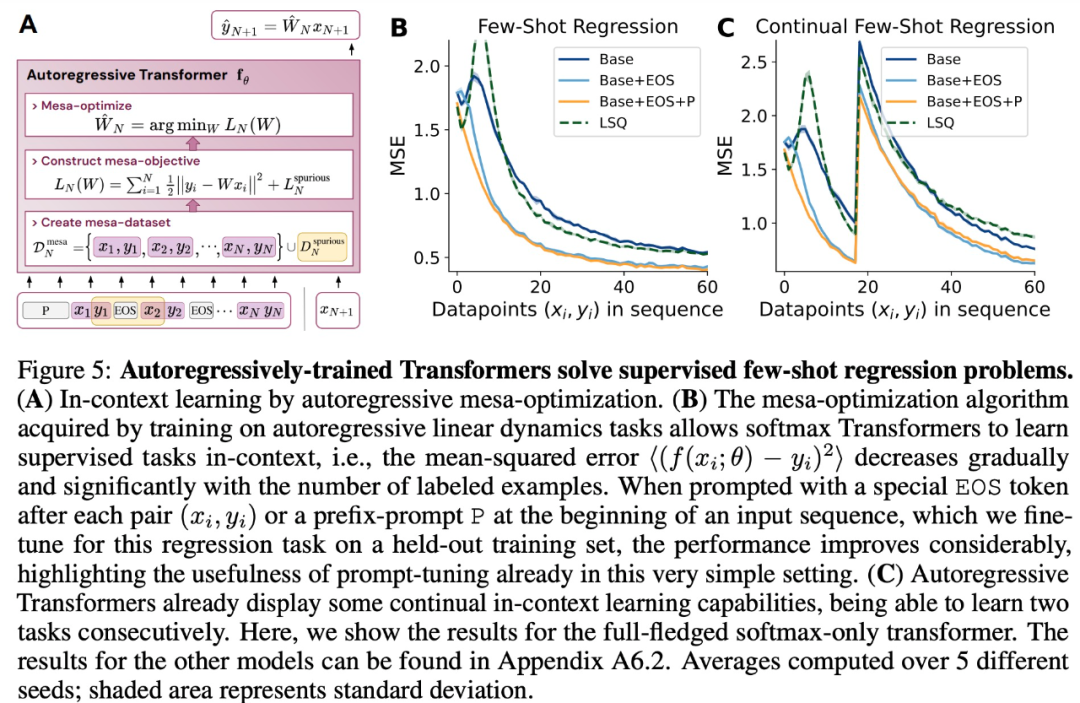

- LLM と同様に、単純な自己回帰トレーニング モデルもコンテキスト学習者になることが実験で示されており、LLM のコンテキスト学習を改善するにはオンザフライ調整が不可欠であり、特定のパフォーマンスも向上させることができます。環境、パフォーマンス。

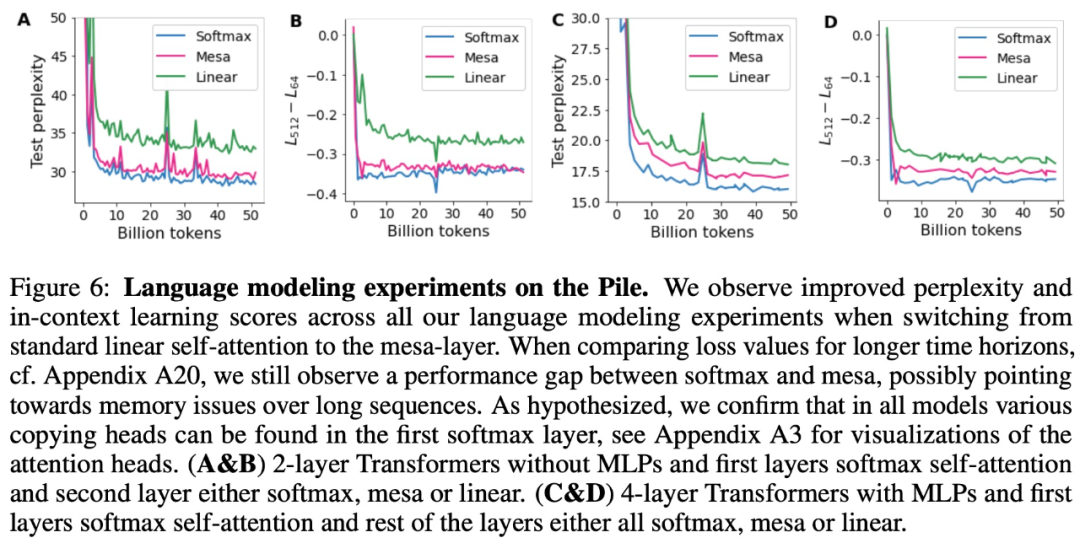

- アテンション層が内部目的関数を暗黙的に最適化しようとするという発見に触発されて、著者は、最小の問題を効果的に解決できる新しいタイプのアテンション層であるメサ層を紹介します。最適化を達成するために単一の勾配ステップを実行するのではなく、二乗最適化問題を実行します。実験では、単一のメサ層が、単純な逐次タスクにおいてディープリニアおよびソフトマックスセルフアテンショントランスフォーマーよりも優れたパフォーマンスを発揮し、より高い解釈可能性を提供することを実証しています。

- 予備的な言語モデリング実験の後、標準のセルフアテンション層をメサ層に置き換えることで効果が得られることがわかりました。有望な結果は、この層が強力な文脈学習機能を備えていることを証明しています。

に従って入力をフォーマットします。

に従って入力をフォーマットします。  # 図 3: リバース エンジニアリングで構築されたトークン入力のための多層トランスフォーマー トレーニング。

# 図 3: リバース エンジニアリングで構築されたトークン入力のための多層トランスフォーマー トレーニング。

以上が理論的基盤があれば、徹底的な最適化を実行できます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7476

7476

15

15

1377

1377

52

52

77

77

11

11

19

19

32

32

「Defect Spectrum」は、従来の欠陥検出の限界を打ち破り、超高精度かつ豊富なセマンティックな産業用欠陥検出を初めて実現します。

Jul 26, 2024 pm 05:38 PM

「Defect Spectrum」は、従来の欠陥検出の限界を打ち破り、超高精度かつ豊富なセマンティックな産業用欠陥検出を初めて実現します。

Jul 26, 2024 pm 05:38 PM

現代の製造において、正確な欠陥検出は製品の品質を確保するための鍵であるだけでなく、生産効率を向上させるための核心でもあります。ただし、既存の欠陥検出データセットには、実際のアプリケーションに必要な精度や意味論的な豊富さが欠けていることが多く、その結果、モデルが特定の欠陥カテゴリや位置を識別できなくなります。この問題を解決するために、広州香港科技大学と Simou Technology で構成されるトップの研究チームは、産業欠陥に関する詳細かつ意味的に豊富な大規模なアノテーションを提供する「DefectSpectrum」データセットを革新的に開発しました。表 1 に示すように、他の産業データ セットと比較して、「DefectSpectrum」データ セットは最も多くの欠陥注釈 (5438 個の欠陥サンプル) と最も詳細な欠陥分類 (125 個の欠陥カテゴリ) を提供します。

NVIDIA 対話モデル ChatQA はバージョン 2.0 に進化し、コンテキストの長さは 128K と記載されています

Jul 26, 2024 am 08:40 AM

NVIDIA 対話モデル ChatQA はバージョン 2.0 に進化し、コンテキストの長さは 128K と記載されています

Jul 26, 2024 am 08:40 AM

オープンな LLM コミュニティは百花繚乱の時代です Llama-3-70B-Instruct、QWen2-72B-Instruct、Nemotron-4-340B-Instruct、Mixtral-8x22BInstruct-v0.1 などがご覧いただけます。優秀なパフォーマーモデル。しかし、GPT-4-Turboに代表される独自の大型モデルと比較すると、オープンモデルには依然として多くの分野で大きなギャップがあります。一般的なモデルに加えて、プログラミングと数学用の DeepSeek-Coder-V2 や視覚言語タスク用の InternVL など、主要な領域に特化したいくつかのオープン モデルが開発されています。

Google AI が IMO 数学オリンピック銀メダルを獲得、数理推論モデル AlphaProof が発売、強化学習が復活

Jul 26, 2024 pm 02:40 PM

Google AI が IMO 数学オリンピック銀メダルを獲得、数理推論モデル AlphaProof が発売、強化学習が復活

Jul 26, 2024 pm 02:40 PM

AI にとって、数学オリンピックはもはや問題ではありません。木曜日、Google DeepMind の人工知能は、AI を使用して今年の国際数学オリンピック IMO の本当の問題を解決するという偉業を達成し、金メダル獲得まであと一歩のところまで迫りました。先週終了したばかりの IMO コンテストでは、代数、組合せ論、幾何学、数論を含む 6 つの問題が出題されました。 Googleが提案したハイブリッドAIシステムは4問正解で28点を獲得し、銀メダルレベルに達した。今月初め、UCLA 終身教授のテレンス・タオ氏が、100 万ドルの賞金をかけて AI 数学オリンピック (AIMO Progress Award) を宣伝したばかりだったが、予想外なことに、AI の問題解決のレベルは 7 月以前にこのレベルまで向上していた。 IMO に関する質問を同時に行うのが最も難しいのは、最も歴史が長く、規模が最も大きく、最も否定的な IMO です。

自然の視点: 医療における人工知能のテストは混乱に陥っています。何をすべきでしょうか?

Aug 22, 2024 pm 04:37 PM

自然の視点: 医療における人工知能のテストは混乱に陥っています。何をすべきでしょうか?

Aug 22, 2024 pm 04:37 PM

編集者 | ScienceAI 限られた臨床データに基づいて、何百もの医療アルゴリズムが承認されています。科学者たちは、誰がツールをテストすべきか、そしてどのようにテストするのが最善かについて議論しています。デビン シン氏は、救急治療室で小児患者が治療を長時間待っている間に心停止に陥るのを目撃し、待ち時間を短縮するための AI の応用を模索するようになりました。 SickKids 緊急治療室からのトリアージ データを使用して、Singh 氏らは潜在的な診断を提供し、検査を推奨する一連の AI モデルを構築しました。ある研究では、これらのモデルにより医師の診察が 22.3% 短縮され、医療検査が必要な患者 1 人あたりの結果の処理が 3 時間近く高速化できることが示されました。ただし、研究における人工知能アルゴリズムの成功は、これを証明するだけです。

結晶相問題を解決するための数百万の結晶データを使用したトレーニング、深層学習手法 PhAI が Science 誌に掲載

Aug 08, 2024 pm 09:22 PM

結晶相問題を解決するための数百万の結晶データを使用したトレーニング、深層学習手法 PhAI が Science 誌に掲載

Aug 08, 2024 pm 09:22 PM

編集者 |KX 今日に至るまで、単純な金属から大きな膜タンパク質に至るまで、結晶学によって決定される構造の詳細と精度は、他のどの方法にも匹敵しません。しかし、最大の課題、いわゆる位相問題は、実験的に決定された振幅から位相情報を取得することのままです。デンマークのコペンハーゲン大学の研究者らは、結晶相の問題を解決するための PhAI と呼ばれる深層学習手法を開発しました。数百万の人工結晶構造とそれに対応する合成回折データを使用して訓練された深層学習ニューラル ネットワークは、正確な電子密度マップを生成できます。この研究では、この深層学習ベースの非経験的構造解法は、従来の非経験的計算法とは異なり、わずか 2 オングストロームの解像度で位相問題を解決できることが示されています。これは、原子解像度で利用可能なデータのわずか 10% ~ 20% に相当します。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

最適な分子を自動的に特定し、合成コストを削減する MIT は、分子設計の意思決定アルゴリズム フレームワークを開発します。

Jun 22, 2024 am 06:43 AM

最適な分子を自動的に特定し、合成コストを削減する MIT は、分子設計の意思決定アルゴリズム フレームワークを開発します。

Jun 22, 2024 am 06:43 AM

編集者 | 創薬の合理化における Ziluo AI の利用は爆発的に増加しています。新薬の開発に必要な特性を備えている可能性のある候補分子を数十億個スクリーニングします。材料の価格からエラーのリスクまで、考慮すべき変数が非常に多いため、たとえ科学者が AI を使用したとしても、最適な候補分子の合成コストを秤量することは簡単な作業ではありません。ここで、MIT の研究者は、最適な分子候補を自動的に特定する定量的意思決定アルゴリズム フレームワークである SPARROW を開発しました。これにより、合成コストを最小限に抑えながら、候補が望ましい特性を持つ可能性を最大限に高めることができます。このアルゴリズムは、これらの分子を合成するために必要な材料と実験手順も決定しました。 SPARROW では、複数の候補分子が入手可能な場合が多いため、分子のバッチを一度に合成するコストが考慮されます。

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究