Zhiyuan は 3 億のセマンティック ベクトル モデルのトレーニング データを公開しており、BGE モデルは繰り返し更新され続けています。

大規模モデルの急速な開発と応用に伴い、大規模モデルの中核となる基本コンポーネントである埋め込みの重要性がますます高まっています。 Zhiyuan Company が 1 か月前にリリースした、オープンソースで商用利用可能な中国語 - 英語のセマンティック ベクトル モデル BGE (BAAI General Embedding) は、コミュニティで広く注目を集め、Hugging Face プラットフォームで数十万回ダウンロードされました。現在、BGE はバージョン 1.5 を迅速にリリースし、複数のアップデートを発表しています。その中で、BGE は 3 億個の大規模トレーニング データを初めてオープンソース化し、同様のモデルのトレーニングに役立つコミュニティを提供し、この分野の技術開発を促進しました

- #MTP データセット リンク: https://data.baai.ac.cn/details/BAAI-MTP

- BGE モデル リンク: https://huggingface.co /BAAI

- BGE コード リポジトリ: https:/ /www.php.cn/link /8944871f1c9865a77a3d9c92cadf124d

30 億の中国語と英語のベクトル モデル トレーニング データがオープン

業界初のオープンソースのセマンティック ベクトル モデル トレーニング データは 3 億件の中国語と英語のデータに達します

BGE の卓越した機能は、大規模で多様なトレーニング データに大きく由来しています。以前は、同業他社が同様のデータセットをリリースすることはほとんどありませんでした。今回のアップデートで、Zhiyuan は BGE トレーニング データを初めてコミュニティに公開し、このタイプのテクノロジーのさらなる開発の基礎を築きました。

MTPが今回公開したデータセットは、合計3億件の中国語と英語関連のテキストペアで構成されています。そのうち、中国語のレコードが 1 億件、英語のレコードが 2 億件あります。データのソースには、Wudao Corpora、Pile、DuReader、Sentence Transformer、およびその他のコーパスが含まれます。必要なサンプリング、抽出、洗浄を行った後、

# が得られます。詳細については、データハブ: https://data.baai.ac.cn# を参照してください。 ##MTP は、これまでで最大のオープンソースの中国語と英語関連のテキスト ペア データ セットであり、中国語と英語のセマンティック ベクトル モデルをトレーニングするための重要な基盤を提供します。

開発者コミュニティに応え、BGE 機能のアップグレード

コミュニティからのフィードバックに基づいて、BGE はバージョン 1.0 に基づいてさらに最適化されました。その性能はより安定し、優れています。具体的なアップグレード内容は以下の通りです。

#モデルアップデート。 BGE-*-zh-v1.5 は、トレーニング データをフィルタリングし、低品質のデータを削除し、トレーニング中の温度係数を 0.02 に増やすことで類似度分布の問題を軽減し、類似度の値をより安定させます。 ############ニューモデル。オープン ソースの BGE-reranker クロス エンコーダ モデルは、関連するテキストをより正確に検索でき、中国語と英語のバイリンガルをサポートします。ベクトルを出力する必要があるベクトル モデルとは異なり、BGE-reranker はテキスト ペア間の類似度を直接出力し、ランク付けの精度が高く、ベクトルの再現結果を並べ替えて、最終結果の関連性を向上させるために使用できます。

- 新機能。 BGE1.1では、ネガティブになりにくいサンプルマイニングスクリプトを追加 ネガティブになりにくいサンプルは、微調整後の検索効果を効果的に向上させることができます 微調整コードに微調整中の命令を追加する機能を追加 モデルの保存また、自動的に文変換形式に変換されるため、モデルの読み込みが容易になります。

- 最近、Zhiyuan と Hugging Face が、中国語のユニバーサル セマンティック ベクトル モデルを強化するために C-Pack を使用することを提案した技術レポートをリリースしたことは言及する価値があります。

- 《C-Pack: 一般的な中国語埋め込みを促進するためのパッケージ化されたリソース》

リンク: https://arxiv.org/pdf/2309.07597 .pdf

##開発者コミュニティで高い人気を獲得

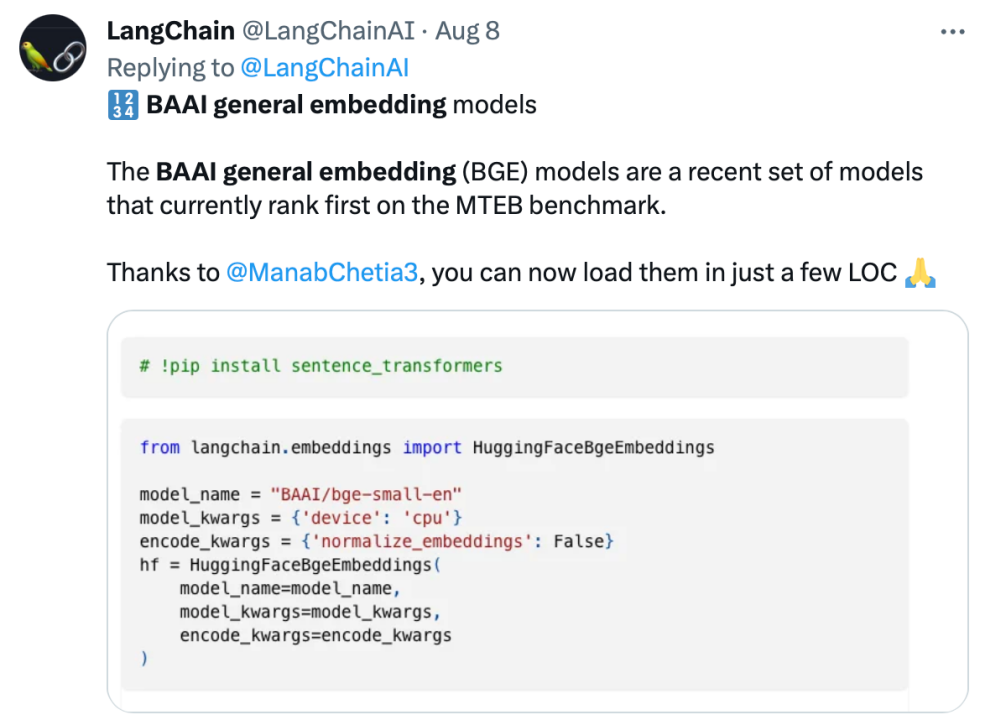

BGE は、リリース以来、大規模なモデル開発者コミュニティの注目を集めています。ダウンロード数は数十万回に達し、有名なオープンソース プロジェクト LangChain、LangChain-Chachat、llama_index などに統合されて使用されています。

Langchain LangChainの共同創設者兼CEOのオフィシャル・ハリソン・チェイス氏、ディープ・トレーディングの創設者ヤム・ペレグ氏、その他のコミュニティの影響力者はBGEについて懸念を表明した。

オープン ソースを遵守し、共同イノベーションを促進する Zhiyuan 大型モデル テクノロジ開発システム FlagOpen BGE は、埋め込みテクノロジとモデルに焦点を当てた新しい FlagEmbedding セクションを追加しました。BGE は、注目度の高いオープン ソース プロジェクトの 1 つです。 FlagOpen は、大型モデル時代の人工知能テクノロジー インフラストラクチャの構築に取り組んでおり、今後もより完全な大型モデルのフルスタック テクノロジーを学界や産業界に公開し続けます

以上がZhiyuan は 3 億のセマンティック ベクトル モデルのトレーニング データを公開しており、BGE モデルは繰り返し更新され続けています。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7647

7647

15

15

1392

1392

52

52

91

91

11

11

36

36

110

110

Web3トレーディングプラットフォームranking_web3グローバル交換トップ10の概要

Apr 21, 2025 am 10:45 AM

Web3トレーディングプラットフォームranking_web3グローバル交換トップ10の概要

Apr 21, 2025 am 10:45 AM

Binanceは、グローバルデジタルアセット取引エコシステムの大君主であり、その特性には次のものが含まれます。1。1日の平均取引量は1,500億ドルを超え、500の取引ペアをサポートし、主流の通貨の98%をカバーしています。 2。イノベーションマトリックスは、デリバティブ市場、Web3レイアウト、教育システムをカバーしています。 3.技術的な利点は、1秒あたり140万のトランザクションのピーク処理量を伴うミリ秒のマッチングエンジンです。 4.コンプライアンスの進捗状況は、15か国のライセンスを保持し、ヨーロッパと米国で準拠した事業体を確立します。

「ブラックマンデーセル」は、暗号通貨業界にとって厳しい日です

Apr 21, 2025 pm 02:48 PM

「ブラックマンデーセル」は、暗号通貨業界にとって厳しい日です

Apr 21, 2025 pm 02:48 PM

暗号通貨市場での突入は投資家の間でパニックを引き起こし、Dogecoin(Doge)は最も困難なヒット分野の1つになりました。その価格は急激に下落し、分散財務財務(DEFI)(TVL)の総価値が激しく減少しました。 「ブラックマンデー」の販売波が暗号通貨市場を席巻し、ドゲコインが最初にヒットしました。そのdefitVLは2023レベルに低下し、通貨価格は過去1か月で23.78%下落しました。 DogecoinのDefitVLは、主にSOSO値指数が26.37%減少したため、272万ドルの安値に低下しました。退屈なDAOやThorchainなどの他の主要なDefiプラットフォームも、それぞれ24.04%と20減少しました。

トップ10の暗号通貨交換プラットフォーム世界最大のデジタル通貨交換リスト

Apr 21, 2025 pm 07:15 PM

トップ10の暗号通貨交換プラットフォーム世界最大のデジタル通貨交換リスト

Apr 21, 2025 pm 07:15 PM

交換は、今日の暗号通貨市場で重要な役割を果たしています。それらは、投資家が取引するためのプラットフォームであるだけでなく、市場の流動性と価格発見の重要なソースでもあります。世界最大の仮想通貨交換はトップ10にランクされており、これらの交換は取引量がはるかに先を行っているだけでなく、ユーザーエクスペリエンス、セキュリティ、革新的なサービスに独自の利点を持っています。リストの上にある交換は通常、ユーザーベースが大きく、広範な市場の影響力があり、その取引量と資産タイプは、他の取引所で到達するのが難しいことがよくあります。

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

2025年のレバレッジド取引、セキュリティ、ユーザーエクスペリエンスで優れたパフォーマンスを持つプラットフォームは次のとおりです。1。OKX、高周波トレーダーに適しており、最大100倍のレバレッジを提供します。 2。世界中の多通貨トレーダーに適したバイナンス、125倍の高いレバレッジを提供します。 3。Gate.io、プロのデリバティブプレーヤーに適し、100倍のレバレッジを提供します。 4。ビットゲットは、初心者やソーシャルトレーダーに適しており、最大100倍のレバレッジを提供します。 5。Kraken、安定した投資家に適しており、5倍のレバレッジを提供します。 6。Altcoinエクスプローラーに適したBybit。20倍のレバレッジを提供します。 7。低コストのトレーダーに適したKucoinは、10倍のレバレッジを提供します。 8。ビットフィネックス、シニアプレイに適しています

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションをサポートする交換:1。Binance、2。Uniswap、3。Sushiswap、4。CurveFinance、5。Thorchain、6。1inchExchange、7。DLNTrade、これらのプラットフォームはさまざまな技術を通じてマルチチェーン資産トランザクションをサポートします。

ETHアップグレード後の損失を避ける方法

Apr 21, 2025 am 10:03 AM

ETHアップグレード後の損失を避ける方法

Apr 21, 2025 am 10:03 AM

ETHアップグレード後、初心者は損失を避けるために次の戦略を採用する必要があります。1。宿題をして、ETHの基本的な知識とアップグレードコンテンツを理解する必要があります。 2。ポジションを制御し、水を少量でテストし、投資を多様化します。 3.取引計画を立て、目標を明確にし、停止ポイントを設定します。 4.合理的にプロファイルし、感情的な意思決定を避けます。 5。正式で信頼できる取引プラットフォームを選択します。 6.短期的な変動の影響を避けるために、長期的な保持を検討してください。

Coinjie.comのペースに追いつく:暗号金融とAAASビジネスの投資見通しは何ですか

Apr 21, 2025 am 10:42 AM

Coinjie.comのペースに追いつく:暗号金融とAAASビジネスの投資見通しは何ですか

Apr 21, 2025 am 10:42 AM

Crypto FinanceとAAAS事業の投資見通しは次のように分析されます。1。暗号資金の機会には、市場規模の成長、徐々に明確な規制、アプリケーションシナリオの拡大が含まれますが、市場のボラティリティと技術的セキュリティの課題があります。 2。AAASビジネスの機会は、技術革新、データ価値マイニング、豊富なアプリケーションシナリオの促進にありますが、課題には技術的な複雑さと市場の受け入れが含まれます。

通貨交換サークルのトップ10のプラットフォームは何ですか?

Apr 21, 2025 pm 12:21 PM

通貨交換サークルのトップ10のプラットフォームは何ですか?

Apr 21, 2025 pm 12:21 PM

上位の交換には、次のものが含まれます。1。世界最大の取引量であるバイナンスは600通貨をサポートし、スポット処理料は0.1%です。 2。バランスの取れたプラットフォームであるOKXは、708の取引ペアをサポートし、永続的な契約処理手数料は0.05%です。 3。Gate.io、2700の小通貨をカバーし、スポット処理料は0.1%-0.3%です。 4。Coinbase、米国のコンプライアンスベンチマーク、スポット処理料は0.5%です。 5。Kraken、トップセキュリティ、および定期的な予備監査。