Google Cloudは、AIのニーズを満たすNVIDIA GPUを搭載したA3仮想マシンインスタンスを来月リリースすると発表した

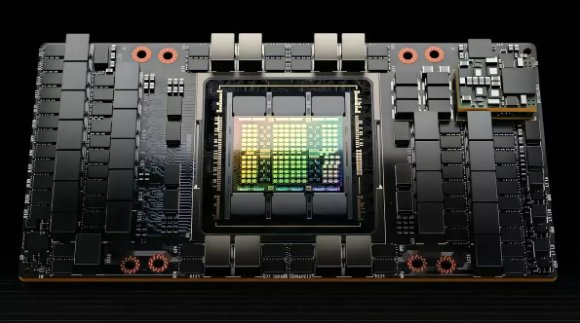

8月31日のニュースによると、Google Cloudは本日開催されたCloud Next Conferenceで来月A3仮想マシンインスタンスを開始すると発表した。この新しい仮想マシン インスタンスの最大のハイライトは、NVIDIA H100 が搭載されていることです。 Tensor Core GPU は、生成人工知能と大規模言語モデルのニーズを満たすことができます。

レポートによると、A3 インスタンスは第 4 世代 Intel Xeon スケーラブル プロセッサ、2TB DDR5-4800 メモリ、および 8 個の NVIDIA H100「ホッパー」を使用しています。 GPU。 NVlink 著 4.0 および NVSwitch、このインスタンスは 3.6 を実装します 二分帯域幅 (TBps)。新しい A3 スーパーコンピューターは、最も要求の厳しい人工知能モデルをトレーニングして提供し、生成人工知能と大規模な言語モデルのイノベーションを推進するように設計されています。このスーパーコンピュータは26の機能を提供できると言われています。 exaFlopsの人工知能性能。

さらに、Google Cloud は記者会見で新しい TPU v5e も紹介しました。このクラウド TPU は、これまでで最もコスト効率が高く、アクセスしやすいものです。これらの TPU またはカスタム ASIC は、人工知能と機械学習のワークロードを高速化することを目的としています。 SDxCentral によると、TPU v5e は、前世代と比較して 1 ドルあたりのトレーニング パフォーマンスを 2 倍にし、1 ドルあたりの推論パフォーマンスを 2.5 倍向上させます

以上がGoogle Cloudは、AIのニーズを満たすNVIDIA GPUを搭載したA3仮想マシンインスタンスを来月リリースすると発表したの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1662

1662

14

14

1419

1419

52

52

1311

1311

25

25

1261

1261

29

29

1234

1234

24

24

セサミオープンドアエクスチェンジウェブページログイン最新バージョンgateio公式ウェブサイトの入り口

Mar 04, 2025 pm 11:48 PM

セサミオープンドアエクスチェンジウェブページログイン最新バージョンgateio公式ウェブサイトの入り口

Mar 04, 2025 pm 11:48 PM

ログインステップやパスワード回復プロセスなど、セサミオープンエクスチェンジWebバージョンのログイン操作の詳細な紹介も、ログイン障害、ページを開くことができず、プラットフォームにスムーズにログインするのに役立つ検証コードを受信できません。

セサミオープンドア交換Webページ登録リンクゲートトレーディングアプリ登録Webサイト最新

Feb 28, 2025 am 11:06 AM

セサミオープンドア交換Webページ登録リンクゲートトレーディングアプリ登録Webサイト最新

Feb 28, 2025 am 11:06 AM

この記事では、SESAME Open Exchange(gate.io)Webバージョンの登録プロセスとGate Tradingアプリを詳細に紹介します。 Web登録であろうとアプリの登録であろうと、公式Webサイトまたはアプリストアにアクセスして、本物のアプリをダウンロードし、ユーザー名、パスワード、電子メール、携帯電話番号、その他の情報を入力し、電子メールまたは携帯電話の確認を完了する必要があります。

Crypto Digital Asset Trading App(2025グローバルランキング)に推奨されるトップ10

Mar 18, 2025 pm 12:15 PM

Crypto Digital Asset Trading App(2025グローバルランキング)に推奨されるトップ10

Mar 18, 2025 pm 12:15 PM

この記事では、Binance、Okx、Gate.io、Bitflyer、Kucoin、Bybit、Coinbase Pro、Kraken、Bydfi、Xbit分散化された交換など、注意を払う価値のある上位10の暗号通貨取引プラットフォームを推奨しています。これらのプラットフォームには、トランザクションの数量、トランザクションの種類、セキュリティ、コンプライアンス、特別な機能の点で独自の利点があります。適切なプラットフォームを選択するには、あなた自身の取引体験、リスク許容度、投資の好みに基づいて包括的な検討が必要です。 この記事があなたがあなた自身に最適なスーツを見つけるのに役立つことを願っています

OUYI OKEXアカウントを登録、使用、キャンセルする方法に関するチュートリアル

Mar 31, 2025 pm 04:21 PM

OUYI OKEXアカウントを登録、使用、キャンセルする方法に関するチュートリアル

Mar 31, 2025 pm 04:21 PM

この記事では、OUYI OKEXアカウントの登録、使用、キャンセル手順を詳細に紹介します。登録するには、アプリをダウンロードし、携帯電話番号または電子メールアドレスを入力して登録する必要があります。使用法は、ログイン、リチャージ、引き出し、取引、セキュリティ設定などの操作手順をカバーします。アカウントをキャンセルするには、OUYI Okexカスタマーサービスに連絡し、必要な情報を提供し、処理を待つ必要があり、最後にアカウントキャンセルの確認を取得する必要があります。 この記事を通じて、ユーザーはOUYI OKEXアカウントの完全なライフサイクル管理を簡単に習得し、デジタルアセットトランザクションを安全かつ便利に実施できます。

セサミオープンドアトレーディングプラットフォームダウンロードモバイルバージョンgateioトレーディングプラットフォームのダウンロードアドレス

Feb 28, 2025 am 10:51 AM

セサミオープンドアトレーディングプラットフォームダウンロードモバイルバージョンgateioトレーディングプラットフォームのダウンロードアドレス

Feb 28, 2025 am 10:51 AM

アプリをダウンロードしてアカウントの安全を確保するために、正式なチャネルを選択することが重要です。

Bitget公式Webサイトで最新のアプリを登録およびダウンロードする方法

Mar 05, 2025 am 07:54 AM

Bitget公式Webサイトで最新のアプリを登録およびダウンロードする方法

Mar 05, 2025 am 07:54 AM

このガイドは、AndroidおよびiOSシステムに適した公式Bitget Exchangeアプリの詳細なダウンロードとインストール手順を提供します。このガイドは、公式ウェブサイト、App Store、Google Playなど、複数の権威ある情報源からの情報を統合し、ダウンロードおよびアカウント管理中の考慮事項を強調しています。ユーザーは、App Store、公式WebサイトAPKダウンロード、公式Webサイトジャンプ、完全な登録、ID検証、セキュリティ設定など、公式チャネルからアプリをダウンロードできます。さらに、ガイドはよくある質問や考慮事項をカバーします。

なぜビテンサーはAIトラックの「ビットコイン」と言われているのですか?

Mar 04, 2025 pm 04:06 PM

なぜビテンサーはAIトラックの「ビットコイン」と言われているのですか?

Mar 04, 2025 pm 04:06 PM

元のタイトル:Bittensor = Aibitcoin:S4MMYETH、分散型AI研究元の翻訳:Zhouzhou、BlockBeats編集者注:この記事では、Bockchain Technologyを通じて中央集権的なAI企業の独占を破り、オープンおよび共同AI Ecosemsytemを促進することを望んでいます。 Bittensorは、さまざまなAIソリューションの出現を可能にし、Tao Tokensを通じてイノベーションを刺激するサブネットモデルを採用しています。 AI市場は成熟していますが、両節は競争リスクに直面し、他のオープンソースの対象となる場合があります

Binanceの登録方法に関する詳細なチュートリアル(2025初心者ガイド)

Mar 18, 2025 pm 01:57 PM

Binanceの登録方法に関する詳細なチュートリアル(2025初心者ガイド)

Mar 18, 2025 pm 01:57 PM

この記事では、ビナンスの登録とセキュリティ設定の完全なガイドを提供し、事前登録の準備(機器、電子メール、携帯電話番号、IDドキュメントの準備を含む)をカバーし、公式ウェブサイトとアプリに2つの登録方法、およびさまざまなレベルのID検証(KYC)プロセスを紹介します。さらに、この記事では、ファンドパスワードの設定、2要素検証(Google AuthenticatorおよびSMS検証を含む2FA)の有効化、アンチフィッシングコードのセットアップなどの主要なセキュリティ手順にも焦点を当て、ユーザーが暗号通貨トランザクションのBinance Binanceプラットフォームを安全かつ便利に登録および使用するのに役立ちます。 取引する前に、関連する法律や規制、市場のリスクを必ず理解してください。