画像 AI プロジェクト用のデータセットを準備する 7 つのステップ

翻訳者| ##データセットが機械学習プロジェクトで最も見落とされている部分である可能性があることに気づいたでしょうか。ほとんどの人にとって、データセットは、すぐにまとめられるかダウンロードされる既製の画像のコレクションにすぎません。実際、データセットは画像ベースの人工知能 (AI) プロジェクトの基礎です。高精度の達成を目指す機械学習プロジェクトでは、バランスの取れた適切に構造化されたデータセットを作成および管理することが重要です。

# ただし、データセットの作成は、何百もの画像を収集するほど簡単ではありません。 AIプロジェクトを始めようとすると、さまざまな隠れた危険に遭遇する可能性があります。以下では、データセットのサイズ、データの欠落の可能性、データセットのデータベースへの変換の重要性について洞察を得るために、独自のデータセットを作成するために実行できる 7 つの一般的な手順について説明します。

#注: これらの手順は主に、画像データセットを含むオブジェクト検出および分類プロジェクトに適用されます。 NLP

やグラフィックス プロジェクトなど、他のプロジェクト タイプでは、別のアプローチが必要です。手順

1: 画像サイズ

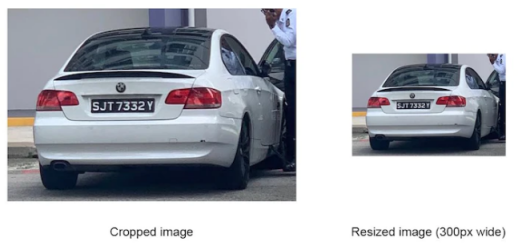

通常、ニューラル ネットワークは特定のサイズの画像のみを処理でき、しきい値を超える画像は強制的に縮小されます。これは、データセットを使用する前に、適切なニューラル ネットワークを選択し、それに応じて画像のサイズを変更する必要があることを意味しますご存じのとおり、画像のサイズを縮小すると、精度が大幅に低下したり、画像上の小さなオブジェクトが消えたりする可能性があり、認識プロセス全体に損害を与えます。以下に示すように、防犯カメラで撮影された画像からナンバー プレートの番号を検出する必要がありますが、ナンバー プレートは画像全体のほんの一部にすぎません。したがって、ニューラル ネットワークが画像を縮小すると、ナンバー プレート番号が小さすぎて認識できない可能性があります。下の図では、ネットワークが使用できる画像サイズを理解できれば、適切なデータセット画像をトリミングするのに役立ちます。

ほとんどのニューラル ネットワークが処理できる画像サイズは、

Yolo のように比較的小さいですが、 v5x6などの最新のニューラル ネットワークは、より大きな解像度の画像を処理できます。たとえば、Yolo v5x

s 6

6

は、最大 1280 ピクセルの画像を処理できます。ワイドなイメージ。

#ステップ 2:あなたの環境# #を理解する#ニューラル ネットワークが動作中に認識する必要がある実際の画像をデータ セットが正確に反映できるようにするには、次の点に注意する必要があります。データセットの収集: カメラの種類、スマートフォンカメラまたはセキュリティカメラ

画像のサイズカメラの設置場所(屋内か屋外か)

気象条件 (光、雨、霧、雪など)

- #ニューラル ネットワークが処理している実際の画像を明確に理解することで、対象となるオブジェクトを正確に反映するデータ セットを作成できます。そして彼らの環境。

- Google から一般的な画像を収集することは、大規模なデータセットを組み立てる最も簡単かつ迅速な方法と考えられるかもしれません。しかし、この方法では高精度の要求を達成することが実際には困難です。以下に示すように、Google や写真データベースの画像は、実際のカメラで撮影した画像と比較して「美化」されることがよくあります

- Aデータセットが「美しすぎる」と、テストの精度が高くなる可能性があります。これは、ニューラル ネットワークがテスト データ (データセットから精製された画像のコレクション) 上でのみ良好に機能するが、現実世界の状況ではパフォーマンスが低下し、精度が低下することを意味します。

- ステップ 3

形式とコメント

注意する必要があるもう 1 つの重要な側面は、画像の形式です。プロジェクトを開始する前に、選択したフレームワークがサポートする形式と、画像がこれらの要件を満たせるかどうかを確認してください。現在のフレームワークは複数の画像形式をサポートできますが、

.jfif などの形式には依然として問題があります。

などの形式には依然として問題があります。

注釈データを使用して、境界ボックス、ファイル名、および使用できるさまざまな構造を指定できます。一般に、ニューラル ネットワークとフレームワークが異なれば、必要なアノテーション方法も異なります。境界ボックスの位置を含む絶対座標を必要とするもの、相対座標を必要とするもの、各画像に注釈付きの個別の .txt ファイルを伴うもの、または 1 つのファイルのみを必要とするものもあります。すべてのコメントが含まれています。ご覧のとおり、データセットに優れた画像が含まれていても、フレームワークがアノテーションを処理できない場合は役に立ちません。

ステップ 4: トレーニングと検証のサブセット

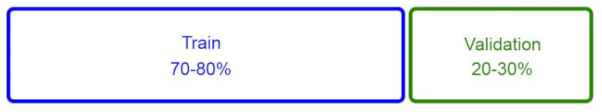

トレーニングの目的で、データセットは通常 2 つのサブセットに分割されます:

- #トレーニング サブセット- 画像のセットです。ニューラル ネットワークは、この一連の画像でトレーニングされます。その割合は、画像総数の 70% ~ 80% です。

- 検証サブセット- は、トレーニング セット中にニューラル ネットワークがどの程度学習するかを確認するために使用される小さな画像です。その割合は、画像総数の 20% から 30% の間です。

通常、ニューラル ネットワークは、トレーニング サブセットから抽出されたオブジェクトの特徴を使用して、外観を「学習」します。オブジェクトの。つまり、トレーニング期間 (エポック) の後、ニューラル ネットワークは検証サブセット データを調べ、何ができるかを推測しようとします。 "Look " をそれらのオブジェクトに送信します。推測が正しいか間違っているかにかかわらず、その構造により、ニューラル ネットワークはさらに学習することができます。

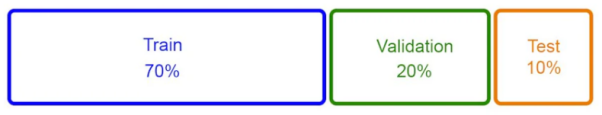

この方法は広く使用されており、良好な結果が得られることが証明されていますが、データを組み合わせる別のアプローチを採用することを好みます。セットは次のように分かれています。サブセット:

- トレーニング サブセット - は画像の総数の ## を占めます # 70% 検証サブセット

- - 画像の総数を考慮 20% テスト データ セット

- - 約。期限が切れている画像の合計数の 10%

##このセットには、ニューラル ネットワークがこれまでに見たことのないデータセットの画像が含まれているため、開発者はこのサブセットでモデルをテストして、手動で実行した場合にどの程度うまく機能するか、どの画像で問題があるかを確認できます。言い換えれば、このサブセットは、プロジェクトの開始前にニューラル ネットワークが間違いを犯す可能性のある場所を特定するのに役立ち、それによってプロジェクト開始後の過剰な再トレーニングを回避できます。

##このセットには、ニューラル ネットワークがこれまでに見たことのないデータセットの画像が含まれているため、開発者はこのサブセットでモデルをテストして、手動で実行した場合にどの程度うまく機能するか、どの画像で問題があるかを確認できます。言い換えれば、このサブセットは、プロジェクトの開始前にニューラル ネットワークが間違いを犯す可能性のある場所を特定するのに役立ち、それによってプロジェクト開始後の過剰な再トレーニングを回避できます。

Step

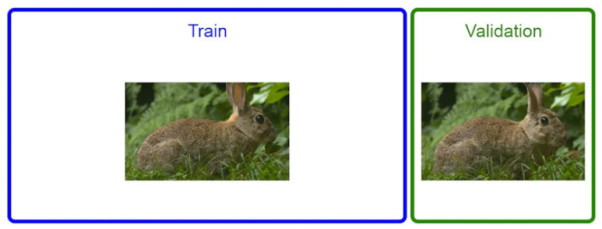

5: データ欠落データをマシンのトレーニングに使用する場合学習アルゴリズムには、予測しようとしている情報が正確に含まれているため、データ侵害が発生する可能性があります。以下の図に示すように、画像認識の観点から見ると、トレーニング サブセットと検証サブセット内の同じオブジェクトの写真が非常に似ている場合にデータ漏洩が発生します。明らかに、データの欠落はニューラル ネットワークの品質に非常に悪影響を及ぼします。

本質的に、モデルはトレーニング データ セット内の画像を認識した後、まずその特徴を抽出し、次にその特徴を抽出します。検証データセットを使用して、見たのとまったく同じ (またはよく似た) 画像を見つけます。したがって、モデルは実際に学習していると言うよりも、単にさまざまな情報を記憶していると言った方が適切です。場合によっては、検証データセットでは非常に高い精度 (例:

という高さ) が得られますが、運用環境では精度が非常に低くなります。 最も一般的に使用されるデータセットのセグメント化方法の 1 つは、データをランダムにシャッフルし、上位の

70%を選択することです。 画像はトレーニング サブセットに配置され、残りの 30% は検証サブセットに配置されます。この方法では、データの欠落が発生しやすいです。以下の図に示すように、当面の優先事項は、データセットからすべての「重複」写真を削除し、両方のサブセットに類似の写真が存在するかどうかを確認することです。

このために、簡単なスクリプトを使用して重複の削除を自動的に実行できます。もちろん、重複のしきい値を調整することもできます。たとえば、完全に重複した画像、または 90% 程度の類似性を持つ画像のみを削除するなどです。一般に、重複コンテンツがより多く削除されるほど、ニューラル ネットワークが生成する精度は高くなります。

#ステップ 6: 大規模なデータセット データベース

##データセットが非常に大きい場合、たとえば、 10million 画像を超え、数十の Forオブジェクト クラスとサブクラスを使用する場合は、データ セット情報を保存するための単純なデータベースを作成することをお勧めします。この背後にある理由は実際には非常に単純です。大規模なデータ セットでは、すべてのデータを追跡するのが困難です。したがって、データを構造化して処理しなければ、データを正確に分析することはできません。

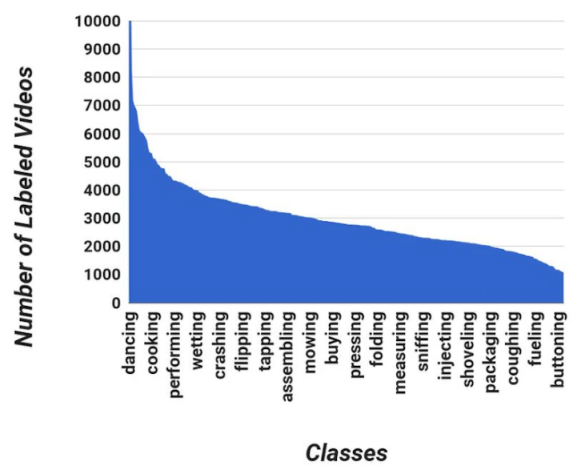

データベースを通じて、データ セットを迅速に診断し、次のことを確認できます。特定のカテゴリ内の画像が少なすぎると、ニューラル ネットワークによる処理が困難になります。オブジェクトを認識する; カテゴリ間の画像の分布が均等ではない; 特定のカテゴリに Google 画像が多すぎるため、そのカテゴリの精度スコアが低くなる、など。

#単純なデータベースを使用すると、次の情報を含めることができます:

- #ファイル名

- ファイルパス

- コメントデータ

- クラス データ

- データ ソース (運用環境、Google など)

- オブジェクト タイプ、名前、およびその他のオブジェクト関連情報

#Step

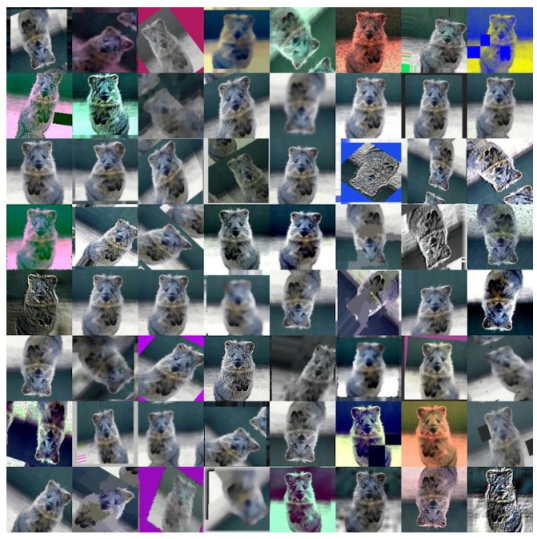

7 :Dataset Augmentation 画像の数を増やすために使用される手法として、データ拡張はデータの単純または複雑な変換です。反転やスタイル変換などのプロセスにより、データの有効性を向上させることができます。これに基づいて得られる有効なデータセットは過度のトレーニングを必要としません。以下の画像に示すように、このようなデータ変換は、単に画像を

90 度回転するだけの単純なものもあれば、逆光の写真をシミュレートするために画像に太陽フレアを追加するような複雑なものもあり得ます。またはレンズフレア。

通常、これらの拡張変換は自動化されます。たとえば、データ拡張専用の

通常、これらの拡張変換は自動化されます。たとえば、データ拡張専用の

Python ライブラリを準備できます。現在、データ拡張には次の 2 種類があります。

事前トレーニング拡張- - トレーニング プロセスの開始 以前は、データが拡張され、トレーニング サブセットに追加されました。もちろん、そのような追加は、前述したデータの欠落を避けるためにデータセットがトレーニングと検証のサブセットに分割された後にのみ行うことができます。 #トレーニング中の機能強化 -

- PyTorch# に似たものを使用します。 ## フレームには画像変換テクノロジーが組み込まれています。 データ セットのサイズを 10 倍に増やしても、ニューラル ネットワークの効率が 10 倍になるわけではないことに注意してください。実際、これによりネットワークのパフォーマンスが以前よりも低下する可能性があります。したがって、運用環境に関連する拡張機能のみを使用する必要があります。たとえば、建物に設置されたカメラは、正常に動作しているときは雨にさらされることはありません。したがって、画像に「雨」の強調を追加する必要はまったくありません。

小さな knot

AI をビジネスに応用しようとしている人にとって、データセットは最も興味のない部分です。しかし、データセットが画像認識プロジェクトの重要な部分であることは否定できません。さらに、ほとんどの画像認識プロジェクトでは、データセットの管理と編成にチームが多くの時間を費やすことがよくあります。最後に、データセットを適切に処理して AI プロジェクトから最良の結果を得る方法をまとめます。

- 画像のサイズをトリミングまたは調整するニューラル ネットワークの要件を満たすために

- ##天候や照明条件に基づいて実際の画像を収集 # ニューラル ネットワークの要件に従ってアノテーションを構築します。

- # ネットワークのトレーニングにすべての画像を使用することは避けてください。パーツはテスト用に予約する必要があります

- データの欠落を避けるために検証データ セット内の重複した画像を削除してください

- データ セットを迅速に診断するためのデータベースを作成します

- #画像の数を増やすためにデータ拡張の使用を最小限に抑えます

- 翻訳者紹介

ジュリアン・チェン (51CTO コミュニティー編集者) は 10 年以上の経験があります。 IT 経験 プロジェクトの実装経験。内部および外部のリソースとリスクの管理と制御に優れ、ネットワークと情報セキュリティの知識と経験の普及に重点を置いています。

#元のタイトル:

画像ベースの AI プロジェクト用にデータセットを準備する 7 つのステップ by オレグ・ココリン

以上が画像 AI プロジェクト用のデータセットを準備する 7 つのステップの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7697

7697

15

15

1640

1640

14

14

1393

1393

52

52

1287

1287

25

25

1229

1229

29

29

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

検索強化生成およびセマンティック メモリを AI コーディング アシスタントに組み込むことで、開発者の生産性、効率、精度を向上させます。 JanakiramMSV 著者の EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG から翻訳。基本的な AI プログラミング アシスタントは当然役に立ちますが、ソフトウェア言語とソフトウェア作成の最も一般的なパターンに関する一般的な理解に依存しているため、最も適切で正しいコードの提案を提供できないことがよくあります。これらのコーディング アシスタントによって生成されたコードは、彼らが解決する責任を負っている問題の解決には適していますが、多くの場合、個々のチームのコーディング標準、規約、スタイルには準拠していません。これにより、コードがアプリケーションに受け入れられるように修正または調整する必要がある提案が得られることがよくあります。

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

AIGC について詳しくは、51CTOAI.x コミュニティ https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou を参照してください。これらの質問は、インターネット上のどこでも見られる従来の質問バンクとは異なります。既成概念にとらわれずに考える必要があります。大規模言語モデル (LLM) は、データ サイエンス、生成人工知能 (GenAI)、および人工知能の分野でますます重要になっています。これらの複雑なアルゴリズムは人間のスキルを向上させ、多くの業界で効率とイノベーションを推進し、企業が競争力を維持するための鍵となります。 LLM は、自然言語処理、テキスト生成、音声認識、推奨システムなどの分野で幅広い用途に使用できます。 LLM は大量のデータから学習することでテキストを生成できます。

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

8月1日の本サイトのニュースによると、SKハイニックスは本日(8月1日)ブログ投稿を発表し、8月6日から8日まで米国カリフォルニア州サンタクララで開催されるグローバル半導体メモリサミットFMS2024に参加すると発表し、多くの新世代の製品。フューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) の紹介。以前は主に NAND サプライヤー向けのフラッシュ メモリ サミット (FlashMemorySummit) でしたが、人工知能技術への注目の高まりを背景に、今年はフューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) に名前が変更されました。 DRAM およびストレージ ベンダー、さらに多くのプレーヤーを招待します。昨年発売された新製品SKハイニックス

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究