私は最近、Github を閲覧しているときに Open Interpreter と呼ばれるアーティファクトを発見しました。これは主にローカルで大規模な言語モデルと対話するために使用されます。これは、大規模な言語モデルを通じて自然言語をスクリプト コードに変換し、それをローカルで実行します。これにより、ゴール。

つまり、デスクトップにjoker.txtという名前のファイルを作成したい場合は、手動で作成する必要はなく、自然言語を通じてOpen Interpreterに指示し、それを利用してファイルを生成することができます。次に、スクリプトがローカルで実行されて、joker.txt ファイルが生成されます。

必要なことをスクリプトに伝え、コードをローカルで実行できるようにするだけです。

元の意味を変えずに内容を中国語に書き直してください。元の文を表示する必要はありません

#画像

#画像

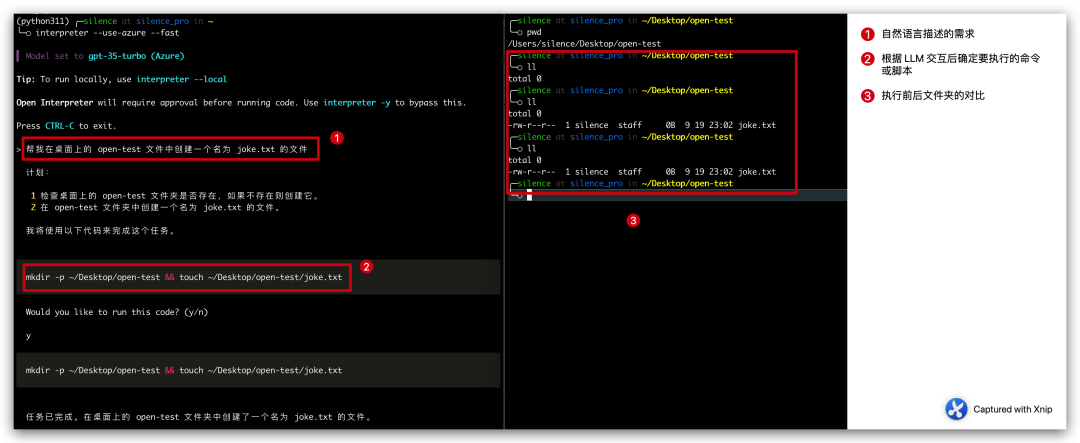

#上記のケース 全体のプロセスは 3 つのステップに分かれています:

自然言語で説明します 要件: デスクトップ上のオープンテスト ファイルに、joker.txt という名前のファイルを作成するのを手伝ってください。- Open Interpreter は要件を分解し、その実行計画と予定をリストします。 -executed コマンド。

-

计划: 1 检查桌面上的 open-test 文件夹是否存在,如果不存在则创建它。 2 在 open-test 文件夹中创建一个名为 joke.txt 的文件。我将使用以下代码来完成这个任务。mkdir -p ~/Desktop/open-test && touch ~/Desktop/open-test/joke.txt

ログイン後にコピー

手動確認後に実行され、ファイルが正常に作成されます。 -

このプロジェクトはまだ始まったばかりで、このケースも非常に単純ですが、これは別の扉を開くように見えることを知っておく必要があります。コードを使って自然言語を使えるようになりました。それが実現しました。考えるだけでとても興奮します(怖い)。

公式紹介: 動画編集やメール送信もできるこのツールは、非常に期待できるとしか言いようがありません。

インストールと構成

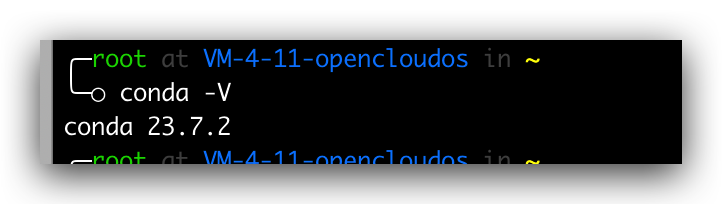

conda のインストール

このプロジェクトのインストールは非常に簡単です。通常、コマンドラインで pip install open-interpreter を実行するだけで済みます。ただし、環境の安定性を確保するために、conda を使用して環境を分離する予定です。そのため、まず conda をインストールし、以下のコマンドを順番に実行する必要があります

# 获取脚本wget https://repo.anaconda.com/archive/Anaconda3-2023.07-2-Linux-x86_64.sh# 增加可执行权限chmod +x Anaconda3-2023.07-2-Linux-x86_64.sh# 运行安装脚本./Anaconda3-2023.07-2-Linux-x86_64.sh# 查询版本conda -V

ログイン後にコピー

バージョン番号が正常に出力できればインストールは成功です、prompt コマンドが存在しない場合は、

vim .bash_profile# 加入下面一行PATH=$PATH:$HOME/bin:$NODE_PATH/bin:/root/anaconda3/bin# 再次执行conda -V

ログイン後にコピー

Picture

Picture

分離環境の作成

conda をインストールした後、分離環境を作成します。指定された Python バージョンについては、次のコマンド

conda create -n python311 pythnotallow=3.11

ログイン後にコピー

を使用して、このコード行の意味は、conda create を通じて python311 という名前の分離環境を作成することです。分離環境の Python バージョンは 3.11 として指定されます。作成が完了したら、次のコマンドを使用して分離環境のリストをクエリできます。

図

図

オープン インタープリターのインストール

次に、分離環境に入り、分離環境にオープン インタープリターをインストールします。次のコマンドを実行します。 follow

conda activate python311pip install open-interpreter

ログイン後にコピー

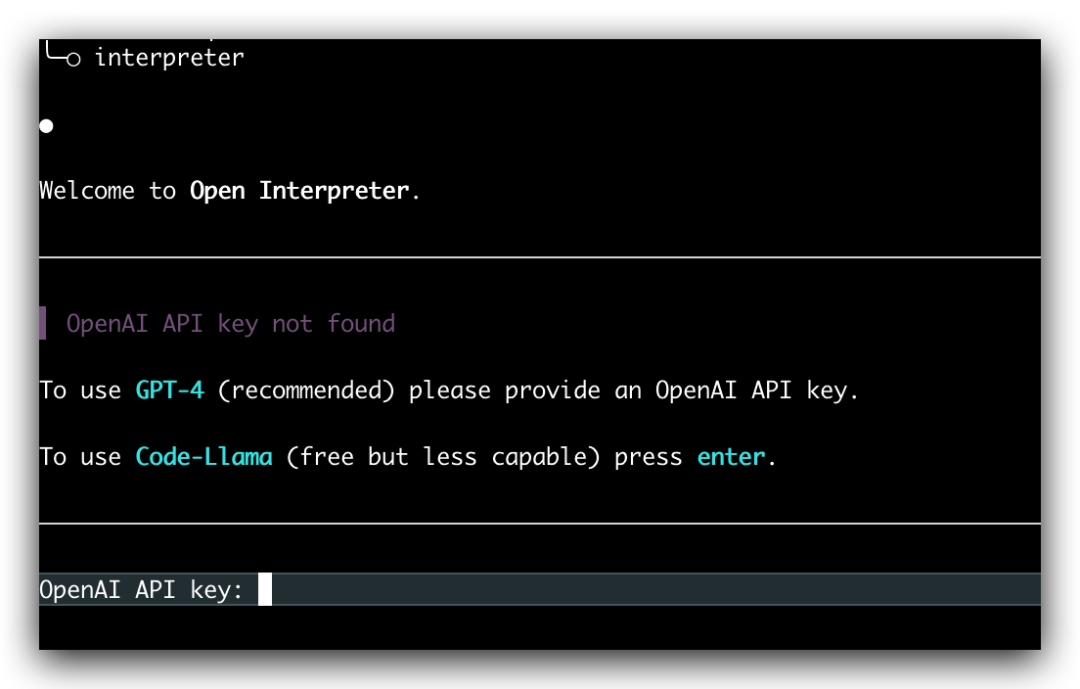

しばらく待つとインストールが成功します。インストールが成功したら、次のコマンドを入力してローカルの大規模言語モデルの対話を開始します。

Picture

Picture

元の意味を変更する必要はありませんが、書き換える必要がある内容は次のとおりです。 「インタープリタ」を直接入力した場合コマンドを実行すると、独自の OpenAI API キーを入力するように求められます。現時点では、GPT-4 モデルがデフォルトで使用されますが、「--fast」パラメータを追加することで GPT-3.5 モデルを使用できます。

interpreter --fast

ログイン後にコピー

ここでは、OpenAI API キーを手動で入力する必要があります。比較トラブルを実行するたびに、環境変数

export OPENAI_API_KEY=skxxxx

ログイン後にコピー

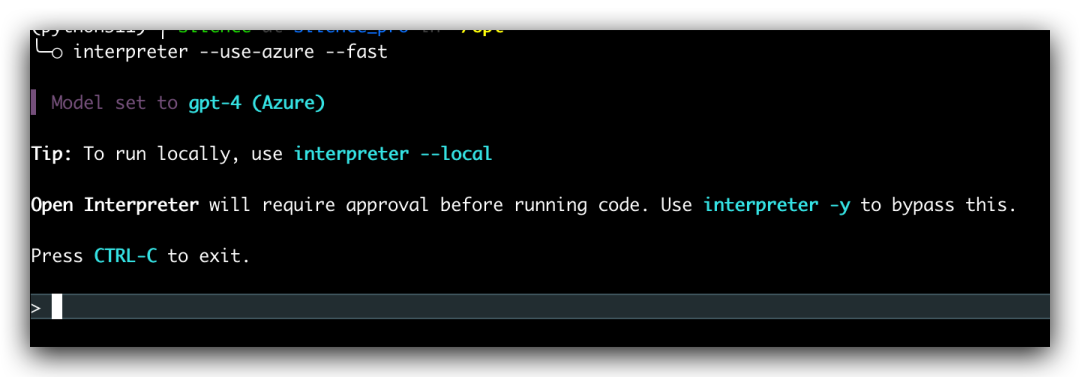

を設定できるため、以降の実行で OpenAI API キーを手動で入力する必要がなくなります。Microsoft の Azure OpenAI を使用する場合は、次の環境変数を構成し、起動時に --use-azure パラメータを追加するだけです

export AZURE_API_KEY=export AZURE_API_BASE=export AZURE_API_VERSION=export AZURE_DEPLOYMENT_NAME=

ログイン後にコピー

interpreter --use-azure

ログイン後にコピー

Picture

Picture

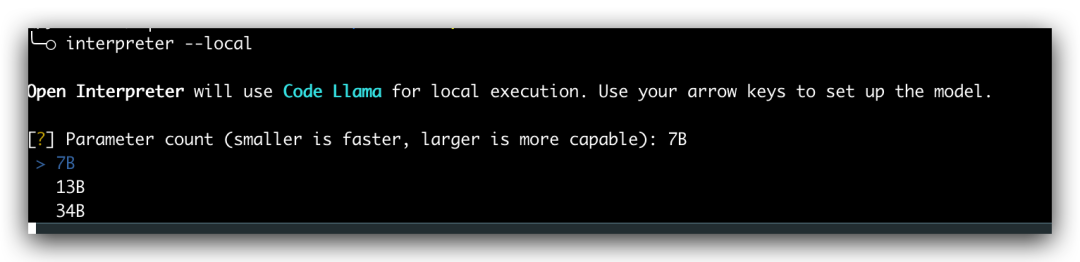

ローカル起動

すべての操作には、対応する OpenAI API キーまたは Azure の OpenAI エンドポイントが必要です。実際、Open Interpreter はローカル実行もサポートしており、起動時に --local パラメーターを追加して、対応するモデルを選択するだけです。ただし、ローカル操作には当社のコンピュータ構成サポートが必要です。これに興味のある友人は、練習のために公式ドキュメントを参照できますが、私の構成ではこれが許可されていません

画像

画像

概要

今日はOpeninterpreterのインストール方法と簡単なゲームプレイを紹介しました。このプロジェクトは現在急速に反復されており、近い将来革命を起こすと信じています。人工知能の時代が真に到来したと言わざるを得ず、今後数年間は人工知能製品が精力的に開発される時期となるでしょう。プログラマーとして、私たちは時代のペースに乗り遅れないようにする必要があります

以上がOpen Interpreter: 大規模な言語モデルがローカルでコードを実行できるようにするオープン ソース ツールの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

#画像

#画像 Picture

Picture 図

図 Picture

Picture Picture

Picture 画像

画像