実際の展開: エンドツーエンドの検出と追跡のための動的シーケンシャル ネットワーク

この記事は自動運転ハート公式アカウントの許可を得て転載しておりますので、転載については出典元にご連絡ください。

自社開発チップを開発する一部の大手メーカーを除いて、ほとんどの自動運転企業は NVIDIA チップを使用すると思いますが、TensorRT は、さまざまな NVIDIA GPU ハードウェア上で動作する C 推論です。プラットフォームフレーム。 Pytorch、TF、またはその他のフレームワークを使用してトレーニングしたモデルは、まず onnx 形式に変換し、次に TensorRT 形式に変換してから、TensorRT 推論エンジンを使用してモデルを実行することで、NVIDIA GPU でのこのモデルの実行速度が向上します。 。

一般的に、onnx と TensorRT は比較的固定されたモデル (すべてのレベルでの固定入力および出力形式、単一分岐などを含む) のみをサポートし、最大でも最も外側の動的入力をサポートします (onnx は設定によってエクスポートできます)。 Dynamic_axes パラメータは、動的な変更を可能にする次元を決定します) しかし、認識アルゴリズムの最前線で活動している友人なら、重要な開発トレンドがエンドツーエンド (エンドツーエンド) であることを知っているでしょう。目標追跡、軌道予測、意思決定や計画など自動運転のあらゆる側面に対応し、前後のフレームと密接に関連するタイミングモデルである必要があるエンドツーエンドの目標検出と目標を実現するMUTR3Dモデルトラッキングは典型的な例として使用できます (モデルの紹介については、次を参照してください:)

MOTR/MUTR3D では、真のエンドツーエンドを実現するためのラベル割り当てメカニズムの理論と例を詳細に説明します。マルチターゲット追跡を終了します。詳細については、リンクをクリックしてください: https://zhuanlan.zhihu.com/p/609123786

このモデルを TensorRT 形式に変換し、fp16 の精度アライメントを含む精度アライメントを実現すると、一連の問題に直面する可能性があります。複数の if-else 分岐、サブネットワーク入力形状の動的変更、動的処理を必要とするその他の操作や演算子などの動的要素

#Picture

#Picture

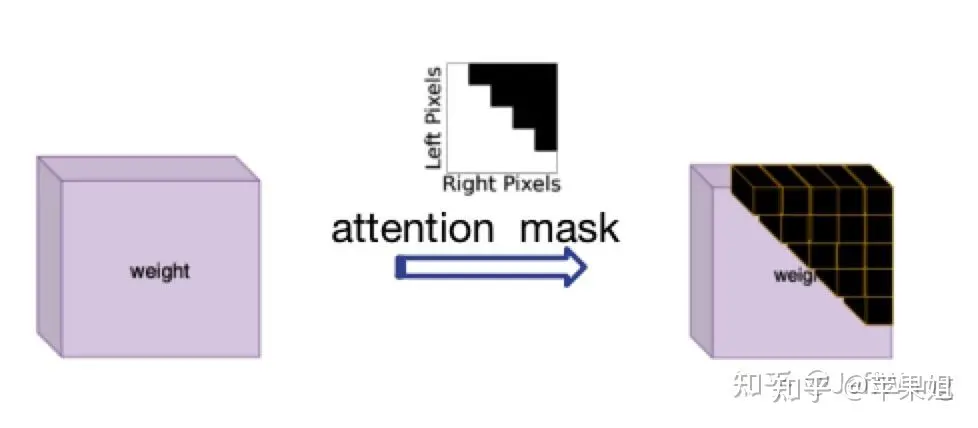

この問題に対する解決策は、DN-DETR[1] からインスピレーションを得たもので、nn.MultiheadAttendant の 'attn_mask' パラメーターに対応する、attention_mask を使用することで、情報のやり取りを必要としないクエリをブロックします。当初、これは NLP ではセット内の各文の長さが一貫していないためであり、現在のニーズを正確に満たしています。ただし、True はブロックする必要があるクエリを表し、False は有効なクエリを表すことに注意する必要があります。

写真

写真

アテンション マスク図attention_mask の計算ロジックは少し複雑なので、多くの操作を TensorRT に変換すると新たな問題が発生する可能性があるため、計算する必要があります。モデルの外でモデルに入力変数として入力され、トランスフォーマーに渡されます。サンプル コードは次のとおりです:

data['attn_masks'] = attn_masks_init.clone().to(device)data['attn_masks'][active_prev_num:max_num, :] = Truedata['attn_masks'][:, active_prev_num:max_num] = True[1]DN-DETR: Accelerate DETR Training by Introducing Query DeNoising

4。QIM

QIM に対するパディングの影響は次のとおりです。トランスフォーマによって出力されたクエリに対する MUTR3D の後処理モジュールです。主に 3 つのステップに分かれています。最初のステップは、アクティブなクエリをフィルタリングすることです。つまり、現在のフレームで検出されたターゲットのクエリは、 obj_idxs >= 0 かどうか (トレーニング フェーズには、推論フェーズには関係しない、ランダムなドロップ クエリと fp クエリのランダムな追加も含まれます)。2 番目のステップは、最初のステップ用の更新クエリです。セルフ アテンション、クエリ出力値の ffn、およびクエリ入力値とのショートカット接続を含むフィルタリングされたクエリ。3 番目のステップは、更新されたクエリを、次のフレームの入力として再生成された初期クエリと結合することです。ポイント 3 で述べた問題が 2 番目のステップでもまだ存在していることがわかります。つまり、セルフ アテンションはすべてのクエリと相互作用するわけではなく、アクティブなクエリ間の情報とのみ相互作用するため、ここでもアテンション マスクを使用する必要があります。

QIM モジュールはオプションですが、実験によると、モデルの精度を向上させるのに役立つことがわかっています。QIM を使用したい場合は、このアテンション マスクはモデルの外部で取得できないため、モデル内で計算する必要があります。モデル. 現在のフレームの検出結果を知る. tensorRT の構文制限により、多くの操作は変換に失敗するか、望ましい結果が得られません. 多くの実験の後、結論は、インデックス スライスの割り当てを直接使用することです (同様のポイント 3 の例 コード) 演算は通常サポートされていません。行列計算を使用するのが最適ですが、計算に関しては、アテンション マスクの bool 型を float 型に変換する必要があります。最後に、アテンション マスクは必要があります。使用する前に bool 型に変換し直す必要があります。コード例は次のとおりです:

obj_mask = (obj_idxs >= 0).float()attn_mask = torch.matmul(obj_mask.unsqueeze(-1), obj_mask.unsqueeze(0)).bool()attn_mask = ~attn_mask

5.出力結果に対するパディングの影響

上記 4 点を完了した後モデル変換 tensorRT のロジックには基本的に問題がないことは確認できますが、検証を重ねても一部のフレームで出力結果に問題が発生するので困惑しますが、データをフレームごとに解析してみると次のことがわかります。一部のフレームのパディング クエリがトランスフォーマーの計算に参加していない場合でも、より高いスコアが得られ、間違った結果が得られる可能性があります。この場合、データ量が多い場合は、パディング クエリのみが実行されるため、実際にこのような可能性があります。の初期値は 0 で、参照点も [0,0] で、他のランダムに初期化されたクエリと同じ操作を実行しますが、結局はパディング クエリなので、その結果を使用するつもりはありません。フィルタリングする必要があります。

入力クエリの結果をフィルタリングするにはどうすればよいですか?クエリに入力されるトークンはインデックス位置のみであり、他の情報は特定されません。インデックス情報は実際にはポイント 3 で使用されるアテンション マスクに記録され、モデルの外部から渡されます。このマスクは 2 次元であり、いずれかの次元 (任意の行または列) を使用して、塗りつぶされた track_score を直接 0 に設定できます。ステップ 4 の注意事項に注意してください。つまり、インデックス付きスライス割り当ての代わりに行列計算を使用するようにしてください。また、計算は float 型に変換する必要があります。以下はコード例です:

mask = (~attention_mask[-1]).float()track_scores = track_scores * mask

6. track_id を動的に更新する方法

モデル本体に加えて、実際には track_id を動的に更新する非常に重要なステップがあります。モデルがエンドツーエンドで達成できることは重要な要素ですが、元のモデルの track_id を更新する方法は比較的複雑なループ判定、つまりスコア thresh より高く、新しいターゲットである場合は代入するという比較的複雑なループ判定になります。新しい obj_idx であり、それがフィルター スコアしきい値より低く、古いターゲットである場合、対応する消失時間は 1、消失時間が miss_tolerance を超える場合、対応する obj_idx は -1 に設定され、つまりターゲットは破棄されます。

tensorRT が if-else マルチブランチ ステートメントをサポートしていないことはわかっています (まあ、私は知りませんが始めました)、これは頭痛の種です。更新された track_id もモデルの外に配置されている場合、 QIM は更新された track_id に基づいてクエリをフィルタリングするため、モデルのエンドツーエンドのアーキテクチャに影響を与えるだけでなく、QIM を使用できなくなります。そこで、私は更新された track_id をモデルに組み込むために知恵を絞りました。

また工夫を凝らしてください(もう限界です)、マスクを使って並列処理するなど、if-else 文は代替不可能ではありません。たとえば、条件付きでマスクに変換します (例: tensor[mask] = 0)。幸いなことに、ポイント 4 と 5 で説明した tensorRT はインデックス スライスの割り当て操作をサポートしていませんが、ブール値のインデックスの割り当てはサポートしています。スライス操作が暗黙的であるためであると推測されます。テンソルの形状を変更します。実験では、ブール値インデックスの割り当てはすべての場合にサポートされるわけではありません。次のような問題が発生しました:需要重新写的内容是:赋值的值必须是一个,不能是多个。例如,当我更新新出现的目标时,我不会统一赋值为某个ID,而是需要为每个目标赋予连续递增的ID。我想到的解决办法是先统一赋值为一个比较大且不可能出现的数字,比如1000,以避免与之前的ID重复,然后在后续处理中将1000替换为唯一且连续递增的数字。(我真是个天才)

如果要进行递增操作(+=1),只能使用简单的掩码,即不能涉及复杂的逻辑计算。例如,对disappear_time的更新,本来需要同时判断obj_idx >= 0且track_scores = 0这个条件。虽然看似不合理,但经过分析发现,即使将obj_idx=-1的非目标的disappear_time递增,因为后续这些目标并不会被选入,所以对整体逻辑影响不大

综上,最后的动态更新track_id示例代码如下,在后处理环节要记得替换obj_idx为1000的数值.:

def update_trackid(self, track_scores, disappear_time, obj_idxs):disappear_time[track_scores >= 0.4] = 0obj_idxs[(obj_idxs == -1) & (track_scores >= 0.4)] = 1000disappear_time[track_scores 5] = -1

至此模型部分的处理就全部结束了,是不是比较崩溃,但是没办法,部署端到端模型肯定比一般模型要复杂很多.模型最后会输出固定shape的结果,还需要在后处理阶段根据obj_idx是否>0判断需要保留到下一帧的query,再根据track_scores是否>filter score thresh判断当前最终的输出结果.总体来看,需要在模型外进行的操作只有三步:帧间移动reference_points,对输入query进行padding,对输出结果进行过滤和转换格式,基本上实现了端到端的目标检测+目标跟踪.

需要重新写的内容是:以上六点的操作顺序需要说明一下。我在这里按照问题分类来写,实际上可能的顺序是1->2->3->5->6->4,因为第五点和第六点是使用QIM的前提,它们之间也存在依赖关系。另外一个问题是我没有使用memory bank,即时序融合的模块,因为经过实验发现这个模块的提升效果并不明显,而且对于端到端跟踪机制来说,已经天然地使用了时序融合(因为直接将前序帧的查询信息带到下一帧),所以时序融合并不是非常必要

好了,现在我们可以对比TensorRT的推理结果和PyTorch的推理结果,会发现在FP32精度下可以实现精度对齐,非常棒!但是,如果需要转换为FP16(可以大幅降低部署时延),第一次推理会发现结果完全变成None(再次崩溃)。导致FP16结果为None一般都是因为出现数据溢出,即数值大小超限(FP16最大支持范围是-65504~+65504)。如果你的代码使用了一些特殊的操作,或者你的数据天然数值较大,例如内外参、姿态等数据很可能超限,一般可以通过缩放等方式解决。这里再说一下和我以上6点相关的一个原因:

7.使用attention_mask导致的fp16结果为none的问题

这个问题非常隐蔽,因为问题隐藏在torch.nn.MultiheadAttention源码中,具体在torch.nn.functional.py文件中,有以下几句:

if attn_mask is not None and attn_mask.dtype == torch.bool:new_attn_mask = torch.zeros_like(attn_mask, dtype=q.dtype)new_attn_mask.masked_fill_(attn_mask, float("-inf"))attn_mask = new_attn_mask可以看到,这一步操作是对attn_mask中值为True的元素用float("-inf")填充,这也是attention mask的原理所在,也就是值为1的位置会被替换成负无穷,这样在后续的softmax操作中,这个位置的输入会被加上负无穷,输出的结果就可以忽略不记,不会对其他位置的输出产生影响.大家也能看出来了,这个float("-inf")是fp32精度,肯定超过fp16支持的范围了,所以导致结果为none.我在这里把它替换为fp16支持的下限,即-65504,转fp16就正常了,虽然说一般不要修改源码,但这个确实没办法.不要问我怎么知道这么隐蔽的问题的,因为不是我一个人想到的.但如果使用attention_mask之前仔细研究了原理,想到也不难.

好的,以下是我在端到端模型部署方面的全部经验分享,我保证这不是标题党。由于我对tensorRT的接触时间不长,所以可能有些描述不准确的地方

需要进行改写的内容是:原文链接:https://mp.weixin.qq.com/s/EcmNH2to2vXBsdnNvpo0xw

以上が実際の展開: エンドツーエンドの検出と追跡のための動的シーケンシャル ネットワークの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1659

1659

14

14

1416

1416

52

52

1310

1310

25

25

1258

1258

29

29

1232

1232

24

24

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

上記と著者の個人的な理解 3 次元ガウシアンプラッティング (3DGS) は、近年、明示的な放射線フィールドとコンピューター グラフィックスの分野で出現した革新的なテクノロジーです。この革新的な方法は、数百万の 3D ガウスを使用することを特徴とし、主に暗黙的な座標ベースのモデルを使用して空間座標をピクセル値にマッピングする神経放射線場 (NeRF) 方法とは大きく異なります。明示的なシーン表現と微分可能なレンダリング アルゴリズムにより、3DGS はリアルタイム レンダリング機能を保証するだけでなく、前例のないレベルの制御とシーン編集も導入します。これにより、3DGS は、次世代の 3D 再構築と表現にとって大きな変革をもたらす可能性のあるものとして位置付けられます。この目的を達成するために、私たちは 3DGS 分野における最新の開発と懸念について初めて体系的な概要を提供します。

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

昨日の面接で、ロングテール関連の質問をしたかと聞かれたので、簡単にまとめてみようと思いました。自動運転のロングテール問題とは、自動運転車におけるエッジケース、つまり発生確率が低い考えられるシナリオを指します。認識されているロングテール問題は、現在、単一車両のインテリジェント自動運転車の運用設計領域を制限している主な理由の 1 つです。自動運転の基礎となるアーキテクチャとほとんどの技術的問題は解決されており、残りの 5% のロングテール問題が徐々に自動運転の開発を制限する鍵となってきています。これらの問題には、さまざまな断片的なシナリオ、極端な状況、予測不可能な人間の行動が含まれます。自動運転におけるエッジ シナリオの「ロング テール」とは、自動運転車 (AV) におけるエッジ ケースを指します。エッジ ケースは、発生確率が低い可能性のあるシナリオです。これらの珍しい出来事

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

0.前面に書かれています&& 自動運転システムは、さまざまなセンサー (カメラ、ライダー、レーダーなど) を使用して周囲の環境を認識し、アルゴリズムとモデルを使用することにより、高度な知覚、意思決定、および制御テクノロジーに依存しているという個人的な理解リアルタイムの分析と意思決定に。これにより、車両は道路標識の認識、他の車両の検出と追跡、歩行者の行動の予測などを行うことで、安全な運行と複雑な交通環境への適応が可能となり、現在広く注目を集めており、将来の交通分野における重要な開発分野と考えられています。 。 1つ。しかし、自動運転を難しくしているのは、周囲で何が起こっているかを車に理解させる方法を見つけることです。これには、自動運転システムの 3 次元物体検出アルゴリズムが、周囲環境にある物体 (位置を含む) を正確に認識し、記述することができる必要があります。

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

原題: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving 論文リンク: https://arxiv.org/pdf/2402.02519.pdf コードリンク: https://github.com/HKUST-Aerial-Robotics/SIMPL 著者単位: 香港科学大学DJI 論文のアイデア: この論文は、自動運転車向けのシンプルで効率的な動作予測ベースライン (SIMPL) を提案しています。従来のエージェントセントとの比較

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

この 1 か月間、いくつかのよく知られた理由により、私は業界のさまざまな教師やクラスメートと非常に集中的な交流をしてきました。この交換で避けられない話題は当然、エンドツーエンドと人気の Tesla FSDV12 です。この機会に、現時点での私の考えや意見を整理し、皆様のご参考とご議論に役立てたいと思います。エンドツーエンドの自動運転システムをどのように定義するか、またエンドツーエンドで解決することが期待される問題は何でしょうか?最も伝統的な定義によれば、エンドツーエンド システムとは、センサーから生の情報を入力し、関心のある変数をタスクに直接出力するシステムを指します。たとえば、画像認識では、従来の特徴抽出 + 分類子方式と比較して、CNN はエンドツーエンドと言えます。自動運転タスクでは、各種センサー(カメラ/LiDAR)からのデータを入力