テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

パラメータ数は7億7千万、5,400億PaLMを突破! UW Google、トレーニング データの 80% のみが必要な「段階的蒸留」を提案 | ACL 2023

パラメータ数は7億7千万、5,400億PaLMを突破! UW Google、トレーニング データの 80% のみが必要な「段階的蒸留」を提案 | ACL 2023

パラメータ数は7億7千万、5,400億PaLMを突破! UW Google、トレーニング データの 80% のみが必要な「段階的蒸留」を提案 | ACL 2023

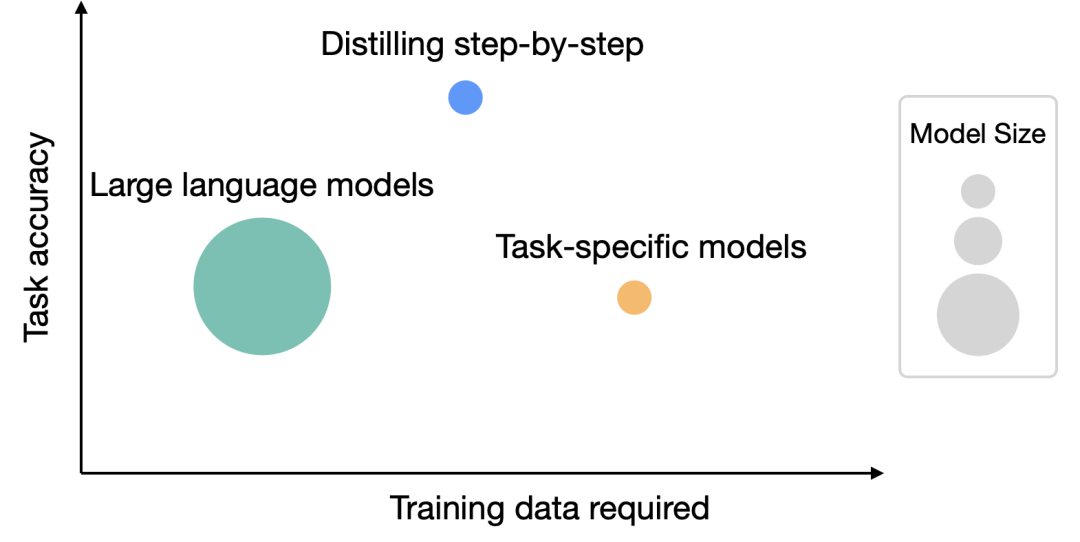

大規模な言語モデルはパフォーマンスに優れており、ゼロまたは数ショットのヒントで新しいタスクを解決できます。しかし、LLM はメモリ利用効率が低く、大量のコンピューティング リソースを必要とするため、実際のアプリケーション展開ではあまり実用的ではありません。たとえば、1,750 億個のパラメータを持つ言語モデル サービスを実行するには、少なくとも 350 GB のビデオ メモリが必要です。現在の最先端の言語モデルには 5,000 億を超えるパラメーターがあり、多くの研究チームにはそれらを実行するための十分なリソースがなく、実際のアプリケーションでの低遅延パフォーマンスを満たすことができません。

手動でラベル付けされたデータや、LLM で生成されたラベルを使用した蒸留を使用して、より小規模なタスク固有のモデルをトレーニングする研究もいくつかありますが、LLM と同等のパフォーマンスを達成するには、微調整と蒸留に大量のトレーニング データが必要です。 。

大規模モデルのリソース要件の問題を解決するために、ワシントン大学と Google は協力して、「ステップバイステップ蒸留」と呼ばれる新しい蒸留メカニズムを提案しました。段階的な蒸留により、蒸留されたモデルのサイズは元のモデルより小さくなりますが、パフォーマンスは向上し、微調整および蒸留プロセス中に必要なトレーニング データの量は少なくなります

#論文を表示するには、次のリンクをクリックしてください: https://arxiv.org/abs/2305.02301

#論文を表示するには、次のリンクをクリックしてください: https://arxiv.org/abs/2305.02301

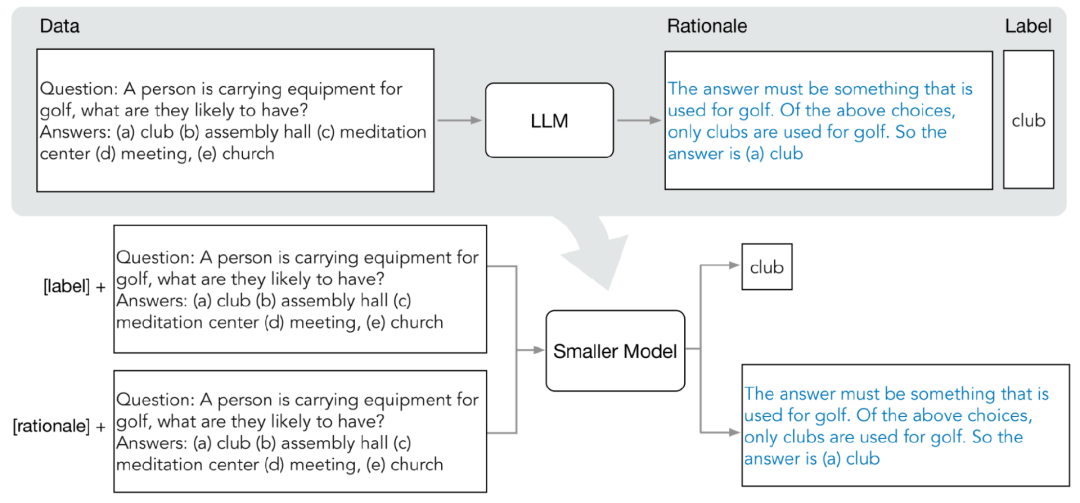

分配蒸留メカニズムは、LLM から予測理由を抽出します (理論的根拠 ) は、マルチタスク フレームワーク内で小規模モデルをトレーニングするための追加の監視情報として使用されます。

4 つの NLP ベンチマークの実験後、次のことがわかりました:

分配蒸留には主に 2 つの段階が含まれます:

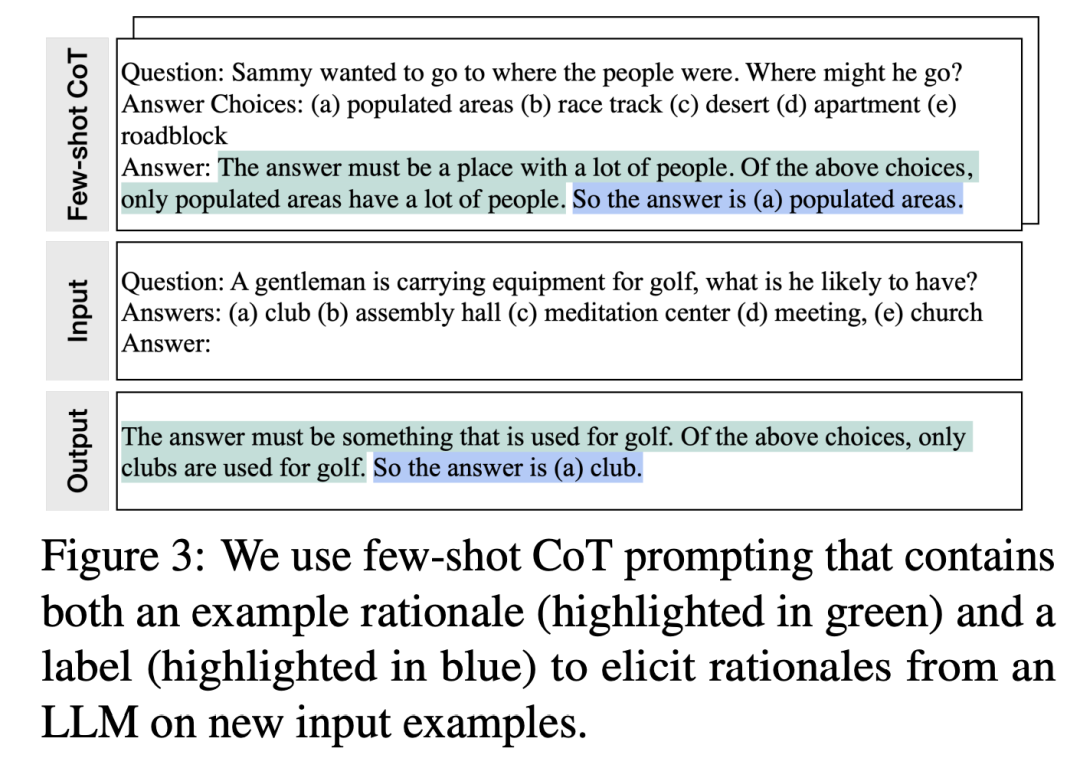

#研究者は、少数サンプルの思考連鎖 (CoT) プロンプトを使用して、LLM から予測中間ステップを抽出します。

対象タスクを決定したら、まず LLM 入力プロンプトでいくつかのサンプルを準備します。各例は、入力、原理、出力を含むトリプレットで構成されています。 プロンプトを入力した後、LLM はトリプレットのデモンストレーションを模倣して、他の新しい問題を生成できます。たとえば、予測原理などです。常識的な質問と回答のタスクで、 という入力質問が与えられた場合:

という入力質問が与えられた場合:

サミーは群衆が集まる場所に行きたいと考えています。彼はどこを選ぶでしょうか?オプションは次のとおりです: (a) 人口密集地域、(b) 競馬場、(c) 砂漠、(d) アパート、(e) 道路障害物

(サミーは人々がいる場所に行きたかった。彼はどこへ行くのでしょう? 回答の選択肢: (a) 人口密集地域、(b) 競馬場、(c) 砂漠、(d) アパート、(e) 道路封鎖)

段階的な改良の後、LLM あなたは「(a) 人口密集地」の設問に正解し、「答えは人の多い場所でなければなりません。上記の選択肢のうち、人が多いのは人口密集地だけです。」の設問にその理由を述べることができる。 徐々に改良を加えた結果、LLM は正解は「(a) 人口密集地域」であると結論付けることができ、質問の回答理由を「答えは多くの人が集まる場所でなければなりません。上記の選択肢のうち、人口密集地域のみです」と回答しました。たくさんの人がいます。「人。」

プロンプトで根拠と組み合わせた CoT 例を提供することにより、コンテキスト学習機能により、LLM は、遭遇していない質問タイプに対して適切な回答理由を生成できるようになります

2. トレーニング ミニ モデル

トレーニング プロセスをマルチタスク問題として構築することで、予測の理由を抽出し、トレーニング用の小規模モデルに組み込むことができます。

標準のラベル予測タスクに加えて、研究者らはまた、新しい理由生成タスクを使用して小規模モデルをトレーニングしました。これにより、モデルは予測のための中間推論ステップを生成する方法を学習し、結果ラベルをより適切に予測できるようにモデルをガイドできるようになりました。

入力プロンプトにタスクのプレフィックス「label」と「rationale」を追加して、ラベル予測タスクと理由生成タスクを区別します。

実験結果

実験では、研究者らはLLMベースラインとして5,400億個のパラメータを持つPaLMモデルを選択し、タスク関連の下流小規模モデルとしてT5モデルを使用しました。

この研究では、自然言語推論用の e-SNLI と ANLI、常識的な質問応答用の CQA、および算術数学のアプリケーション問題用の SVAMP という 4 つのベンチマーク データセットで実験を実施しました。これら 3 つの異なる NLP タスクについて実験を行いました。

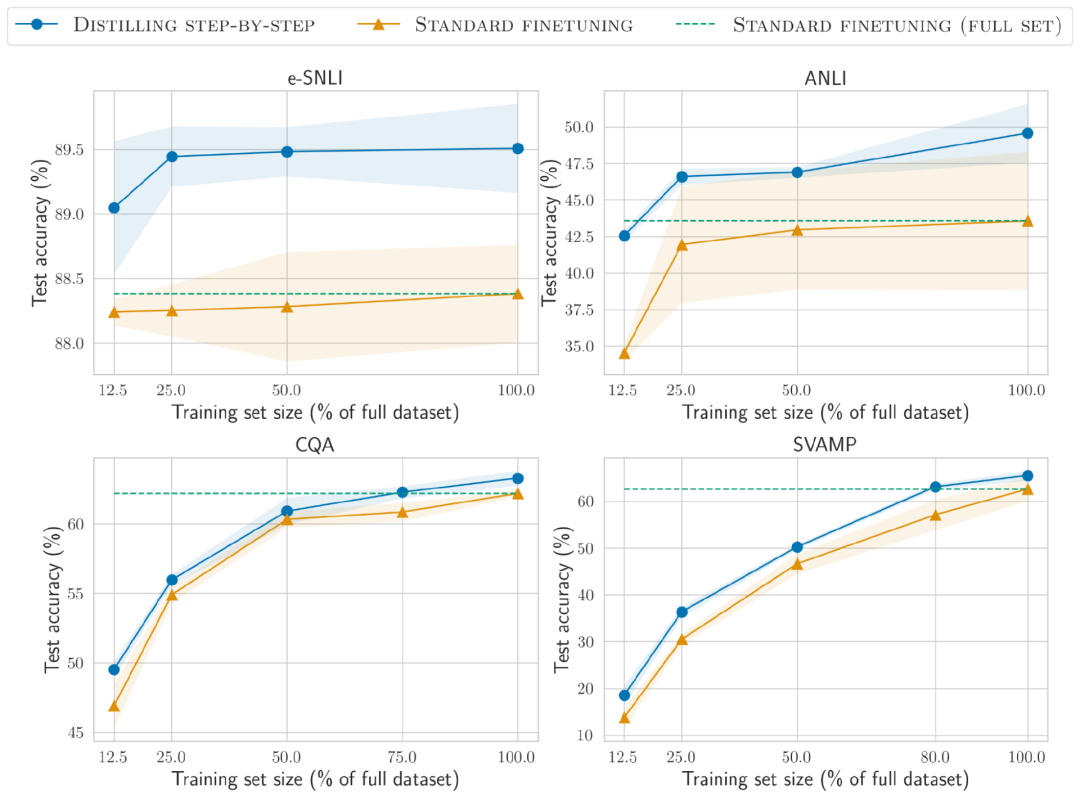

トレーニング データが少ない

段階的蒸留法の方が、標準の微調整よりもパフォーマンスが高く、必要なトレーニング データが少なくなります

e-SNLI データセットでは、完全なデータセットの 12.5% を使用したときに標準の微調整よりも優れたパフォーマンスが達成されますが、ANLI では、わずか 75%、25%、および 20% を使用した場合に達成されます。トレーニング データは CQA と SVAMP でそれぞれ必要です。

手動でラベル付けされたさまざまなサイズのデータセットに対して 220M T5 モデルを使用した標準的な微調整と比較して、すべてのデータセットで使用するトレーニング サンプルの数が少ない場合、分布の抽出が優れています。少数ショットの CoT 蒸留によって LLM を実行すると、サイズははるかに小さくなりますが、パフォーマンスは向上します。

e-SNLI データ セットでは、220M T5 モデルを使用すると 540B PaLM よりも優れたパフォーマンスが得られます。ANLI では、770M T5 モデルを使用すると、540B PaLM よりも優れたパフォーマンスが得られます。モデル サイズはわずか 1/700 #より小さなモデル、より少ないデータ

モデルのサイズとトレーニング データを削減しながら、数ショット PaLM# を超えるパフォーマンスを達成することに成功しました。 ## ANLI では、データセット全体の 80% のみを使用しながら、770M T5 モデルを使用して 540B PaLM を上回りました

##標準的な微調整では、完全な 100% データセットでも PaLM のパフォーマンス レベルを維持できます。これは、段階的な蒸留によってモデル サイズとトレーニング データの量を同時に削減できるため、LLM を超えるパフォーマンスを達成できることを示しています。

以上がパラメータ数は7億7千万、5,400億PaLMを突破! UW Google、トレーニング データの 80% のみが必要な「段階的蒸留」を提案 | ACL 2023の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7517

7517

15

15

1378

1378

52

52

79

79

11

11

21

21

66

66

Debian Readdirによるファイルソートを実装する方法

Apr 13, 2025 am 09:06 AM

Debian Readdirによるファイルソートを実装する方法

Apr 13, 2025 am 09:06 AM

Debian Systemsでは、Readdir関数はディレクトリコンテンツを読み取るために使用されますが、それが戻る順序は事前に定義されていません。ディレクトリ内のファイルを並べ替えるには、最初にすべてのファイルを読み取り、QSORT関数を使用してソートする必要があります。次のコードは、debianシステムにreaddirとqsortを使用してディレクトリファイルを並べ替える方法を示しています。

Debian Readdirのパフォーマンスを最適化する方法

Apr 13, 2025 am 08:48 AM

Debian Readdirのパフォーマンスを最適化する方法

Apr 13, 2025 am 08:48 AM

Debian Systemsでは、Directoryコンテンツを読み取るためにReadDirシステム呼び出しが使用されます。パフォーマンスが良くない場合は、次の最適化戦略を試してください。ディレクトリファイルの数を簡素化します。大きなディレクトリをできる限り複数の小さなディレクトリに分割し、Readdirコールごとに処理されたアイテムの数を減らします。ディレクトリコンテンツのキャッシュを有効にする:キャッシュメカニズムを構築し、定期的にキャッシュを更新するか、ディレクトリコンテンツが変更されたときに、頻繁な呼び出しをreaddirに削減します。メモリキャッシュ(memcachedやredisなど)またはローカルキャッシュ(ファイルやデータベースなど)を考慮することができます。効率的なデータ構造を採用する:ディレクトリトラバーサルを自分で実装する場合、より効率的なデータ構造(線形検索の代わりにハッシュテーブルなど)を選択してディレクトリ情報を保存およびアクセスする

Debian Apacheログレベルを設定する方法

Apr 13, 2025 am 08:33 AM

Debian Apacheログレベルを設定する方法

Apr 13, 2025 am 08:33 AM

この記事では、DebianシステムのApachewebサーバーのロギングレベルを調整する方法について説明します。構成ファイルを変更することにより、Apacheによって記録されたログ情報の冗長レベルを制御できます。方法1:メイン構成ファイルを変更して、構成ファイルを見つけます。Apache2.xの構成ファイルは、通常/etc/apache2/ディレクトリにあります。ファイル名は、インストール方法に応じて、apache2.confまたはhttpd.confである場合があります。構成ファイルの編集:テキストエディターを使用してルートアクセス許可を使用して構成ファイルを開く(nanoなど):sudonano/etc/apache2/apache2.conf

Debian OpenSSLがどのように中間の攻撃を防ぐか

Apr 13, 2025 am 10:30 AM

Debian OpenSSLがどのように中間の攻撃を防ぐか

Apr 13, 2025 am 10:30 AM

Debian Systemsでは、OpenSSLは暗号化、復号化、証明書管理のための重要なライブラリです。中間の攻撃(MITM)を防ぐために、以下の測定値をとることができます。HTTPSを使用する:すべてのネットワーク要求がHTTPの代わりにHTTPSプロトコルを使用していることを確認してください。 HTTPSは、TLS(Transport Layer Security Protocol)を使用して通信データを暗号化し、送信中にデータが盗まれたり改ざんされたりしないようにします。サーバー証明書の確認:クライアントのサーバー証明書を手動で確認して、信頼できることを確認します。サーバーは、urlsessionのデリゲート方法を介して手動で検証できます

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail ServerにSSL証明書をインストールする手順は次のとおりです。1。最初にOpenSSL Toolkitをインストールすると、OpenSSLツールキットがシステムに既にインストールされていることを確認してください。インストールされていない場合は、次のコマンドを使用してインストールできます。sudoapt-getUpdatesudoapt-getInstalopenssl2。秘密キーと証明書のリクエストを生成次に、OpenSSLを使用して2048ビットRSA秘密キーと証明書リクエスト(CSR)を生成します:Openss

Debian Readdirが他のツールと統合する方法

Apr 13, 2025 am 09:42 AM

Debian Readdirが他のツールと統合する方法

Apr 13, 2025 am 09:42 AM

DebianシステムのReadDir関数は、ディレクトリコンテンツの読み取りに使用されるシステムコールであり、Cプログラミングでよく使用されます。この記事では、ReadDirを他のツールと統合して機能を強化する方法について説明します。方法1:C言語プログラムを最初にパイプラインと組み合わせて、cプログラムを作成してreaddir関数を呼び出して結果をinclude#include#include inctargc、char*argv []){dir*dir; structdireant*entry; if(argc!= 2){(argc!= 2){

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverのファイアウォールの構成は、サーバーのセキュリティを確保するための重要なステップです。以下は、iPtablesやFirewalldの使用を含む、一般的に使用されるファイアウォール構成方法です。 iPtablesを使用してファイアウォールを構成してIPTablesをインストールします(まだインストールされていない場合):sudoapt-getupdatesudoapt-getinstalliptablesview現在のiptablesルール:sudoiptables-l configuration

Debian syslogを学ぶ方法

Apr 13, 2025 am 11:51 AM

Debian syslogを学ぶ方法

Apr 13, 2025 am 11:51 AM

このガイドでは、Debian SystemsでSyslogの使用方法を学ぶように導きます。 Syslogは、ロギングシステムとアプリケーションログメッセージのLinuxシステムの重要なサービスです。管理者がシステムアクティビティを監視および分析して、問題を迅速に特定および解決するのに役立ちます。 1. syslogの基本的な知識Syslogのコア関数には以下が含まれます。複数のログ出力形式とターゲットの場所(ファイルやネットワークなど)をサポートします。リアルタイムのログ表示およびフィルタリング機能を提供します。 2。syslog(rsyslogを使用)をインストールして構成するDebianシステムは、デフォルトでrsyslogを使用します。次のコマンドでインストールできます:sudoaptupdatesud