コンピュータビジョンにおける人間の姿勢推定の問題

コンピュータ ビジョンにおける人間の姿勢推定の問題には、特定のコード例が必要です

人間の姿勢推定は、コンピュータ ビジョンの分野における重要な研究方向であり、その目標は、画像や動画からデータを取得し、関節位置や関節角度などの人体の姿勢情報を正確に取得します。人間の姿勢推定は、モーション キャプチャ、人間とコンピュータのインタラクション、仮想現実など、多くの応用分野で幅広く応用されています。この記事では、人間の姿勢推定の基本原理を紹介し、具体的なコード例を示します。

人間の姿勢推定の基本原理は、画像内の人体の主要なポイント (頭、肩、手、足など) を分析することによって人体の姿勢を推定することです。この目標を達成するには、畳み込みニューラル ネットワーク (CNN) やリカレント ニューラル ネットワーク (RNN) などの深層学習モデルを使用できます。

以下は、オープン ソース ライブラリ OpenPose を使用して人間の姿勢推定を実装するサンプル コードです:

import cv2

import numpy as np

from openpose import OpenPose

# 加载OpenPose模型

openpose = OpenPose("path/to/openpose/models")

# 加载图像

image = cv2.imread("path/to/image.jpg")

# 运行OpenPose模型

poses = openpose.detect(image)

# 显示姿态估计结果

for pose in poses:

# 绘制骨骼连接

image = openpose.draw_skeleton(image, pose)

# 绘制关节点

image = openpose.draw_keypoints(image, pose)

# 显示图像

cv2.imshow("Pose Estimation", image)

cv2.waitKey(0)

cv2.destroyAllWindows()上記のサンプル コードでは、最初に必要なライブラリをインポートし、次に OpenPose モデルをロードします。そして画像を読み込みます。次に、OpenPose モデルを実行してポーズを検出します。返される結果は、複数のポーズを含むリストです。最後に、OpenPose が提供する描画機能を使用して姿勢推定結果を描画し、画像を表示します。

なお、上記のサンプルコードはデモ用であり、実際には人間の姿勢推定を実現するには、より複雑な前処理、後処理、パラメータ調整のプロセスが必要となります。さらに、OpenPose は、ユーザーが使用できるより多くの機能とオプションを提供するオープン ソース ライブラリです。

つまり、人間の姿勢推定は、画像内の重要な点を分析することで人体の姿勢を推定する、コンピューター ビジョンの分野における重要な課題です。この記事では、オープンソース ライブラリ OpenPose を使用して人間の姿勢推定を実装するためのサンプル コードを提供します。読者は、必要に応じて、より詳細な研究開発を行うことができます。

以上がコンピュータビジョンにおける人間の姿勢推定の問題の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7563

7563

15

15

1385

1385

52

52

84

84

11

11

28

28

99

99

ORB-SLAM3を超えて! SL-SLAM: 低照度、重度のジッター、弱いテクスチャのシーンはすべて処理されます。

May 30, 2024 am 09:35 AM

ORB-SLAM3を超えて! SL-SLAM: 低照度、重度のジッター、弱いテクスチャのシーンはすべて処理されます。

May 30, 2024 am 09:35 AM

以前に書きましたが、今日は、深層学習テクノロジーが複雑な環境におけるビジョンベースの SLAM (同時ローカリゼーションとマッピング) のパフォーマンスをどのように向上させることができるかについて説明します。ここでは、深部特徴抽出と深度マッチング手法を組み合わせることで、低照度条件、動的照明、テクスチャの弱い領域、激しいセックスなどの困難なシナリオでの適応を改善するように設計された多用途のハイブリッド ビジュアル SLAM システムを紹介します。当社のシステムは、拡張単眼、ステレオ、単眼慣性、ステレオ慣性構成を含む複数のモードをサポートしています。さらに、他の研究にインスピレーションを与えるために、ビジュアル SLAM と深層学習手法を組み合わせる方法も分析します。公開データセットと自己サンプリングデータに関する広範な実験を通じて、測位精度と追跡堅牢性の点で SL-SLAM の優位性を実証しました。

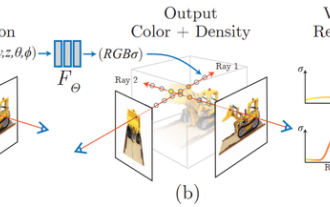

NeRFとは何ですか? NeRF ベースの 3D 再構成はボクセルベースですか?

Oct 16, 2023 am 11:33 AM

NeRFとは何ですか? NeRF ベースの 3D 再構成はボクセルベースですか?

Oct 16, 2023 am 11:33 AM

1 はじめに Neural Radiation Fields (NeRF) は、深層学習とコンピューター ビジョンの分野におけるかなり新しいパラダイムです。この技術は、ECCV2020 の論文「NeRF: Representing Scenes as Neural Radiation Fields for View Synthesis」(最優秀論文賞を受賞) で紹介され、それ以来非常に人気となり、現在までに 800 件近く引用されています [1]。このアプローチは、機械学習による 3D データの従来の処理方法に大きな変化をもたらします。神経放射線場のシーン表現と微分可能なレンダリング プロセス: カメラ光線に沿って 5D 座標 (位置と視線方向) をサンプリングして画像を合成し、これらの位置を MLP に入力して色と体積密度を生成し、体積レンダリング技術を使用してこれらの値を合成します。 ; レンダリング関数は微分可能であるため、渡すことができます。

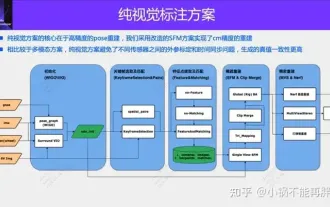

自動運転の初の純粋な視覚的静的再構築

Jun 02, 2024 pm 03:24 PM

自動運転の初の純粋な視覚的静的再構築

Jun 02, 2024 pm 03:24 PM

純粋に視覚的な注釈ソリューションでは、主に視覚に加えて、GPS、IMU、および車輪速度センサーからのデータを動的注釈に使用します。もちろん、量産シナリオでは、純粋な視覚である必要はありません。一部の量産車両には固体レーダー (AT128) などのセンサーが搭載されています。大量生産の観点からデータの閉ループを作成し、これらすべてのセンサーを使用すると、動的オブジェクトのラベル付けの問題を効果的に解決できます。しかし、私たちの計画には固体レーダーはありません。したがって、この最も一般的な量産ラベル ソリューションを紹介します。純粋に視覚的な注釈ソリューションの中核は、高精度のポーズ再構築にあります。再構築の精度を確保するために、Structure from Motion (SFM) のポーズ再構築スキームを使用します。でもパスする

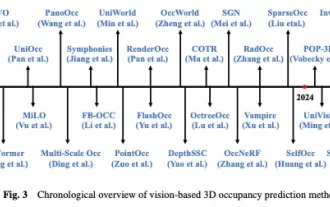

Occと自動運転の過去と現在を見てみよう!最初のレビューでは、機能強化/量産展開/アノテーションの効率化という 3 つの主要テーマを包括的にまとめています。

May 08, 2024 am 11:40 AM

Occと自動運転の過去と現在を見てみよう!最初のレビューでは、機能強化/量産展開/アノテーションの効率化という 3 つの主要テーマを包括的にまとめています。

May 08, 2024 am 11:40 AM

以上、筆者個人の理解 近年、自動運転はドライバーの負担軽減や運転の安全性の向上につながる可能性があるため、注目が高まっています。ビジョンベースの 3 次元占有予測は、自動運転の安全性に関する費用対効果の高い包括的な調査に適した新たな認識タスクです。オブジェクト中心の知覚タスクと比較して 3D 占有予測ツールの優位性は多くの研究で実証されていますが、この急速に発展している分野に特化したレビューはまだあります。このホワイトペーパーでは、まずビジョンベースの 3D 占有予測の背景を紹介し、このタスクで直面する課題について説明します。次に、現在の 3D 占有予測手法の現状と開発傾向を、機能強化、展開の容易さ、ラベル付けの効率という 3 つの側面から包括的に説明します。やっと

3D ビジョンには点群の登録が不可欠です。すべての主流のソリューションと課題を 1 つの記事で理解する

Apr 02, 2024 am 11:31 AM

3D ビジョンには点群の登録が不可欠です。すべての主流のソリューションと課題を 1 つの記事で理解する

Apr 02, 2024 am 11:31 AM

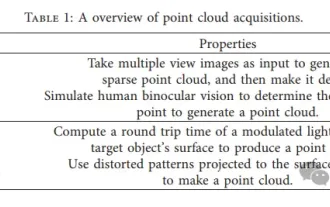

点の集合体である点群は、3D再構築、工業用検査、ロボット操作などを通じて、物体の3次元(3D)表面情報の取得と生成に変化をもたらすことが期待されています。最も困難だが重要なプロセスは、点群の登録です。つまり、2 つの異なる座標で取得された 2 つの点群を位置合わせして一致させる空間変換を取得します。このレビューは、点群登録の概要と基本原理を紹介し、さまざまな方法を体系的に分類して比較し、点群登録に存在する技術的問題を解決することで、分野外の学術研究者やエンジニアに指導を提供し、統一されたビジョンに関する議論を促進することを目的としています。点群登録用。一般的な点群取得方法はアクティブ方式とパッシブ方式に分けられ、センサーが能動的に点群を取得するのがアクティブ方式で、点群は後で再構成されます。

口を動かすだけで原神がプレイできる! AIを使ってキャラクターを切り替えて敵を攻撃するネチズン「アヤカ、神里流フロストデストラクションを使って」

May 13, 2023 pm 07:52 PM

口を動かすだけで原神がプレイできる! AIを使ってキャラクターを切り替えて敵を攻撃するネチズン「アヤカ、神里流フロストデストラクションを使って」

May 13, 2023 pm 07:52 PM

過去 2 年間で世界中で人気を博した国産ゲームといえば、間違いなく原神が挙げられます。 5月に発表された今年第1四半期のモバイルゲーム収益調査報告書によると、「原神」が5億6,700万ドルの絶対的な優位性を獲得し、カードを引くモバイルゲームの中で断然1位を獲得したことも発表された。わずか 18 年でオンライン化され、数か月後、モバイル プラットフォームだけでの総収益は 30 億米ドル (約 130 億リンギット) を超えました。さて、Xumi オープン前の最後の 2.8 アイランド バージョンは長い間待ち望まれており、長いドラフト期間を経て、ようやく新しいプロットとプレイできるエリアが登場しました。でも、「肝臓皇帝」が何人いるのかは分かりませんが、島の探索が完了し、また草が生え始めました。宝箱は合計 182 個 + モラボックス 1 個 (含まれていません) 草期間が長くても心配する必要はありません。いや、長い草のあいだに

AAAI2024: Far3D - 150m まで直接到達する視覚的な 3D ターゲット検出の革新的なアイデア

Dec 15, 2023 pm 01:54 PM

AAAI2024: Far3D - 150m まで直接到達する視覚的な 3D ターゲット検出の革新的なアイデア

Dec 15, 2023 pm 01:54 PM

最近、Arxiv で純粋視覚周囲知覚に関する最新の研究を読みました。この研究は PETR シリーズの手法に基づいており、長距離ターゲット検出の純粋視覚問題の解決に焦点を当てており、知覚範囲を 150 メートルに拡張しています。この論文の手法と結果は非常に参考になるので、解釈してみました 原題:Far3D: Expanding the Horizon for Surround-view3DObject Detection 論文リンク: https://arxiv.org/abs/2308.09616 :北京工業大学 & Megvii Technology タスクの背景 自動運転の理解における 3D 物体検出

厳水成が担当し、「ユニバーサルビジュアルマルチモーダル大型モデル」の究極の形を確立しました。統一理解・生成・分割・編集

Apr 25, 2024 pm 08:04 PM

厳水成が担当し、「ユニバーサルビジュアルマルチモーダル大型モデル」の究極の形を確立しました。統一理解・生成・分割・編集

Apr 25, 2024 pm 08:04 PM

最近、Yan Shuicheng 教授のチームは、Vitron のユニバーサル ピクセル レベルのビジュアル マルチモーダル大規模言語モデルを共同でリリースし、オープンソース化しました。プロジェクトのホームページとデモ: https://vitron-llm.github.io/ 論文リンク: https://is.gd/aGu0VV オープンソース コード: https://github.com/SkyworkAI/Vitron これは強力なコードです一般的なビジョン マルチモーダル大規模モデルは、視覚的な理解から視覚的な生成まで、低レベルから高レベルまでの一連の視覚タスクをサポートし、大規模言語モデル業界を長年悩ませてきた画像/ビデオモデルの分離問題を解決します。包括的な統合された静的画像を提供し、動的ビデオ コンテンツを理解、生成、セグメント化、編集します。