強化学習における報酬設計の問題

強化学習における報酬設計の問題には特定のコード例が必要です

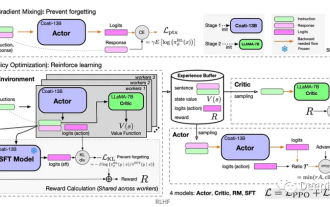

強化学習は、環境との相互作用を通じて学習することを目標とする機械学習手法です。累積報酬を最大化します。強化学習では、報酬は重要な役割を果たし、エージェントの学習プロセスにおける信号であり、エージェントの行動を導くために使用されます。ただし、報酬の設計は難しい問題であり、合理的な報酬の設計は強化学習アルゴリズムのパフォーマンスに大きな影響を与える可能性があります。

強化学習では、報酬はエージェントと環境の間のコミュニケーションの架け橋として見なされ、エージェントに現在のアクションの良し悪しを伝えることができます。一般に、報酬は、疎報酬と密報酬の 2 種類に分類できます。疎な報酬は、タスク内の特定のいくつかの時点でのみ与えられる報酬を指しますが、密な報酬はすべての時点で報酬シグナルを持ちます。密な報酬は、より多くのフィードバック情報を提供するため、疎な報酬よりもエージェントが正しいアクション戦略を学習しやすくなります。ただし、現実世界のタスクでは報酬がまばらになることがより一般的であり、報酬の設計に課題をもたらします。

報酬設計の目標は、エージェントが最適な戦略を迅速かつ効果的に学習できるように、可能な限り最も正確なフィードバック信号をエージェントに提供することです。ほとんどの場合、エージェントが所定の目標に到達した場合には高い報酬を与え、エージェントが誤った決定を下した場合には低い報酬またはペナルティを与える報酬関数が必要です。ただし、適切な報酬関数を設計するのは簡単な作業ではありません。

報酬設計の問題を解決するための一般的なアプローチは、人間の専門家に基づくデモンストレーションを使用してエージェントの学習をガイドすることです。この場合、人間の専門家がエージェントに一連のサンプル アクション シーケンスとその報酬を提供し、エージェントはこれらのサンプルから学習してタスクに慣れ、その後の対話での戦略を徐々に改善していきます。この方法は報酬設計の問題を効果的に解決できますが、人件費も増加し、専門家のサンプルが完全に正しいとは限らない可能性があります。

もう 1 つのアプローチは、逆強化学習 (逆強化学習) を使用して報酬設計問題を解決することです。逆強化学習は、観察された行動から報酬関数を導出する方法です。エージェントが学習プロセス中に潜在的な報酬関数を最大化しようと試みることを前提としています。観察された行動からこの潜在的な報酬関数を逆導出することにより、エージェントはより多くの情報を提供できます。正確な報酬シグナル。逆強化学習の中核となる考え方は、観察された行動を最適な戦略として解釈し、この最適な戦略に対応する報酬関数を推定することでエージェントの学習を導くことです。

以下は、逆強化学習の簡単なコード例で、観察された動作から報酬関数を推測する方法を示しています:

import numpy as np

def inverse_reinforcement_learning(expert_trajectories):

# 计算状态特征向量的均值

feature_mean = np.mean(expert_trajectories, axis=0)

# 构建状态特征矩阵

feature_matrix = np.zeros((len(expert_trajectories), len(feature_mean)))

for i in range(len(expert_trajectories)):

feature_matrix[i] = expert_trajectories[i] - feature_mean

# 使用最小二乘法求解奖励函数的权重向量

weights = np.linalg.lstsq(feature_matrix, np.ones((len(expert_trajectories),)))[0]

return weights

# 生成示例轨迹数据

expert_trajectories = np.array([[1, 1], [1, 2], [2, 1], [2, 2]])

# 使用逆强化学习得到奖励函数的权重向量

weights = inverse_reinforcement_learning(expert_trajectories)

print("奖励函数的权重向量:", weights)上記のコードは、最小二乗法を使用して報酬関数を解決します。重みベクトルは、任意の状態特徴ベクトルの報酬を計算するために使用できます。逆強化学習を通じて、サンプル データから適切な報酬関数を学習し、エージェントの学習プロセスをガイドできます。

要約すると、報酬の設計は強化学習における重要かつ困難な問題です。合理的な報酬設計は、強化学習アルゴリズムのパフォーマンスに大きな影響を与える可能性があります。人間の専門家ベースのデモンストレーションや逆強化学習などの方法を活用することで、報酬設計の問題を解決し、学習プロセスを導くための正確な報酬信号をエージェントに提供できます。

以上が強化学習における報酬設計の問題の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7563

7563

15

15

1384

1384

52

52

84

84

11

11

28

28

99

99

強化学習における報酬関数設計の問題

Oct 09, 2023 am 11:58 AM

強化学習における報酬関数設計の問題

Oct 09, 2023 am 11:58 AM

強化学習における報酬関数設計の問題 はじめに 強化学習は、エージェントと環境の間の相互作用を通じて最適な戦略を学習する方法です。強化学習では、報酬関数の設計がエージェントの学習効果にとって重要です。この記事では、強化学習における報酬関数の設計の問題を調査し、具体的なコード例を示します。報酬関数の役割と目標報酬関数は強化学習の重要な部分であり、特定の状態でエージェントが取得する報酬値を評価するために使用されます。その設計は、エージェントが最適なアクションを選択することで長期的な疲労を最大化するようにガイドするのに役立ちます。

C++ の深層強化学習テクノロジー

Aug 21, 2023 pm 11:33 PM

C++ の深層強化学習テクノロジー

Aug 21, 2023 pm 11:33 PM

深層強化学習技術は、人工知能の分野の一つとして大きな注目を集めており、複数の国際コンペティションで優勝しており、パーソナルアシスタント、自動運転、ゲームインテリジェンスなどの分野でも広く利用されています。深層強化学習を実現するプロセスにおいて、ハードウェア リソースが限られている場合、効率的で優れたプログラミング言語である C++ が特に重要になります。深層強化学習は、その名前が示すように、深層学習と強化学習の 2 つの分野のテクノロジーを組み合わせたものです。簡単に理解すると、ディープ ラーニングとは、多層のニューラル ネットワークを構築することでデータから特徴を学習し、意思決定を行うことを指します。

Panda-Gym のロボット アーム シミュレーションを使用した Deep Q-learning 強化学習

Oct 31, 2023 pm 05:57 PM

Panda-Gym のロボット アーム シミュレーションを使用した Deep Q-learning 強化学習

Oct 31, 2023 pm 05:57 PM

強化学習 (RL) は、エージェントが試行錯誤を通じて環境内でどのように動作するかを学習できる機械学習手法です。エージェントは、望ましい結果につながるアクションを実行すると、報酬または罰を受けます。時間の経過とともに、エージェントは期待される報酬を最大化するアクションを取ることを学習します。RL エージェントは通常、逐次的な決定問題をモデル化するための数学的フレームワークであるマルコフ決定プロセス (MDP) を使用してトレーニングされます。 MDP は 4 つの部分で構成されます。 状態: 環境の可能な状態のセット。アクション: エージェントが実行できる一連のアクション。遷移関数: 現在の状態とアクションを考慮して、新しい状態に遷移する確率を予測する関数。報酬機能:コンバージョンごとにエージェントに報酬を割り当てる機能。エージェントの目標は、ポリシー機能を学習することです。

C++ コードで発生する「エラー: クラス 'ClassName' の再定義」問題を解決する

Aug 25, 2023 pm 06:01 PM

C++ コードで発生する「エラー: クラス 'ClassName' の再定義」問題を解決する

Aug 25, 2023 pm 06:01 PM

C++ コードの「error:redefiningofclass'ClassName'」問題を解決する C++ プログラミングでは、さまざまなコンパイル エラーが頻繁に発生します。よくあるエラーの 1 つは、「error:redefiningofclass 'ClassName'」 (クラス 'ClassName' の再定義エラー) です。このエラーは通常、同じクラスが複数回定義されている場合に発生します。この記事では、

クラスタリングアルゴリズムにおけるクラスタリング効果評価問題

Oct 10, 2023 pm 01:12 PM

クラスタリングアルゴリズムにおけるクラスタリング効果評価問題

Oct 10, 2023 pm 01:12 PM

クラスタリング アルゴリズムのクラスタリング効果評価問題には、特定のコード例が必要です クラスタリングは、データをクラスタリングすることによって、類似したサンプルを 1 つのカテゴリにグループ化する教師なし学習手法です。クラスタリングアルゴリズムでは、クラスタリングの効果をどのように評価するかが重要な問題となります。この記事では、一般的に使用されるいくつかのクラスタリング効果評価指標を紹介し、対応するコード例を示します。 1. クラスタリング効果評価指標 シルエット係数 シルエット係数は、サンプルの近さや他のクラスタとの分離度を計算することでクラスタリング効果を評価します。

iPhone の一般的な問題を診断する方法を教えます

Dec 03, 2023 am 08:15 AM

iPhone の一般的な問題を診断する方法を教えます

Dec 03, 2023 am 08:15 AM

強力なパフォーマンスと多彩な機能で知られる iPhone は、複雑な電子機器によく見られる、時折起こる問題や技術的な困難を免れません。 iPhone の問題が発生するとイライラすることもありますが、通常は警報を発する必要はありません。この包括的なガイドでは、iPhone の使用に関連して最も一般的に遭遇する課題のいくつかをわかりやすく説明することを目的としています。当社の段階的なアプローチは、これらの一般的な問題の解決に役立つように設計されており、機器を最高の動作状態に戻すための実用的な解決策とトラブルシューティングのヒントを提供します。不具合やより複雑な問題に直面している場合でも、この記事はそれらを効果的に解決するのに役立ちます。一般的なトラブルシューティングのヒント 具体的なトラブルシューティング手順を詳しく説明する前に、役立つ情報をいくつか紹介します。

PHP エラーの解決: 親クラスの継承時に問題が発生しました

Aug 17, 2023 pm 01:33 PM

PHP エラーの解決: 親クラスの継承時に問題が発生しました

Aug 17, 2023 pm 01:33 PM

PHP エラーの解決: 親クラスの継承時に発生する問題 PHP では、継承はオブジェクト指向プログラミングの重要な機能です。継承により、元のコードを変更することなく、既存のコードを再利用し、拡張および改善できます。継承は開発で広く使用されていますが、親クラスから継承するときにエラーの問題が発生することがあります。この記事では、親クラスから継承するときに発生する一般的な問題の解決に焦点を当て、対応するコード例を示します。質問 1: 親クラスが見つかりません。親クラスの継承処理中に、システムが親クラスを見つからない場合、

jQueryがform要素の値を取得できない問題の解決方法

Feb 19, 2024 pm 02:01 PM

jQueryがform要素の値を取得できない問題の解決方法

Feb 19, 2024 pm 02:01 PM

jQuery.val() が使用できない問題を解決するには、具体的なコード例が必要です フロントエンド開発者にとって、jQuery の使用は一般的な操作の 1 つです。その中でも、.val() メソッドを使用してフォーム要素の値を取得または設定する操作は、非常に一般的な操作です。ただし、特定のケースでは、.val() メソッドを使用できないという問題が発生する可能性があります。この記事では、いくつかの一般的な状況と解決策を紹介し、具体的なコード例を示します。問題の説明 jQuery を使用してフロントエンド ページを開発する場合、時々次のような問題が発生します。