強化学習における報酬関数設計の問題

強化学習における報酬関数設計の問題

はじめに

強化学習は、エージェントと環境の間の相互作用を通じて最適な戦略を学習する方法です。強化学習では、報酬関数の設計がエージェントの学習効果にとって重要です。この記事では、強化学習における報酬関数の設計の問題を調査し、具体的なコード例を示します。

- 報酬関数の役割と目標

報酬関数は強化学習の重要な部分であり、特定の状態でエージェントによって得られる報酬値を評価するために使用されます。その設計は、エージェントが最適なアクションを選択することで長期的な累積報酬を最大化するようにガイドするのに役立ちます。

優れた報酬関数には、次の 2 つの目標がある必要があります:

(1) エージェントが最適な戦略を学習できるように十分な情報を提供する;

(2) 適切な報酬フィードバック ガイドを通じてエージェントは非効果的で有害な行動を回避します。

- 報酬関数設計における課題

報酬関数の設計は次の課題に直面する可能性があります:

(1) スパース: 場合によっては、環境の報酬信号が非常にスパースである可能性があります。その結果、学習プロセスが遅くなったり、不安定になったりします。

(2) 誤解を招く: 報酬シグナルが正しくない、または不十分であると、エージェントが間違った戦略を学習する可能性があります。

(3) 高次元性: 多数の状態とアクションがある複雑な環境では、報酬関数を設計することがより困難になります。

(4) 目標の矛盾: 目標が異なると、短期目標と長期目標のバランスなど、報酬関数の設計において矛盾が生じる可能性があります。 - 報酬関数設計の方法

報酬関数設計の課題を克服するために、次の方法を使用できます:

(1) 手動設計: 以前の情報に基づく知識と経験、報酬関数を手動で設計します。このアプローチは通常、単純な問題には機能しますが、複雑な問題の場合は困難になる可能性があります。

(2) 報酬エンジニアリング: 補助的な報酬またはペナルティを導入することで、報酬関数のパフォーマンスを向上させます。たとえば、エージェントの学習をより適切に導くために、特定の状態やアクションに追加の報酬やペナルティを適用することができます。

(3) 適応報酬関数: 適応アルゴリズムを使用して報酬関数を動的に調整します。この方法では、時間の経過とともに報酬関数の重みを変更して、さまざまな段階の学習ニーズに適応できます。

- 具体的なコード例

次は、深層強化学習フレームワーク TensorFlow と Keras を使用したサンプル コードで、報酬関数がどのように設計されているかを示しています。

import numpy as np

from tensorflow import keras

# 定义强化学习智能体的奖励函数

def reward_function(state, action):

# 根据当前状态和动作计算奖励值

reward = 0

# 添加奖励和惩罚条件

if state == 0 and action == 0:

reward += 1

elif state == 1 and action == 1:

reward -= 1

return reward

# 定义强化学习智能体的神经网络模型

def create_model():

model = keras.Sequential([

keras.layers.Dense(64, activation='relu', input_shape=(2,)),

keras.layers.Dense(64, activation='relu'),

keras.layers.Dense(1)

])

model.compile(optimizer='adam', loss='mean_squared_error')

return model

# 训练智能体

def train_agent():

model = create_model()

# 智能体的训练过程

for episode in range(num_episodes):

state = initial_state

# 智能体根据当前策略选择动作

action = model.predict(state)

# 获得当前状态下的奖励值

reward = reward_function(state, action)

# 更新模型的权重

model.fit(state, reward)In上記のコードでは、reward_function 関数を定義することで報酬関数を設計し、エージェントのトレーニング時に現在の状態とアクションに基づいて報酬値を計算します。同時に、create_model 関数を使用してエージェントをトレーニングするためのニューラル ネットワーク モデルを作成し、model.predict 関数を使用して現在の戦略に基づいてアクションを選択します。

結論

強化学習における報酬関数の設計は、重要かつ困難な問題です。正しく設計された報酬関数は、エージェントが最適な戦略を学習するように効果的に導くことができます。この記事では、報酬関数の役割と目標、設計上の課題、具体的なコード例について説明することで、読者に強化学習における報酬関数の設計に関する参考とインスピレーションを提供したいと考えています。

以上が強化学習における報酬関数設計の問題の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1664

1664

14

14

1423

1423

52

52

1321

1321

25

25

1269

1269

29

29

1249

1249

24

24

Panda-Gym のロボット アーム シミュレーションを使用した Deep Q-learning 強化学習

Oct 31, 2023 pm 05:57 PM

Panda-Gym のロボット アーム シミュレーションを使用した Deep Q-learning 強化学習

Oct 31, 2023 pm 05:57 PM

強化学習 (RL) は、エージェントが試行錯誤を通じて環境内でどのように動作するかを学習できる機械学習手法です。エージェントは、望ましい結果につながるアクションを実行すると、報酬または罰を受けます。時間の経過とともに、エージェントは期待される報酬を最大化するアクションを取ることを学習します。RL エージェントは通常、逐次的な決定問題をモデル化するための数学的フレームワークであるマルコフ決定プロセス (MDP) を使用してトレーニングされます。 MDP は 4 つの部分で構成されます。 状態: 環境の可能な状態のセット。アクション: エージェントが実行できる一連のアクション。遷移関数: 現在の状態とアクションを考慮して、新しい状態に遷移する確率を予測する関数。報酬機能:コンバージョンごとにエージェントに報酬を割り当てる機能。エージェントの目標は、ポリシー機能を学習することです。

強化学習における報酬関数設計の問題

Oct 09, 2023 am 11:58 AM

強化学習における報酬関数設計の問題

Oct 09, 2023 am 11:58 AM

強化学習における報酬関数設計の問題 はじめに 強化学習は、エージェントと環境の間の相互作用を通じて最適な戦略を学習する方法です。強化学習では、報酬関数の設計がエージェントの学習効果にとって重要です。この記事では、強化学習における報酬関数の設計の問題を調査し、具体的なコード例を示します。報酬関数の役割と目標報酬関数は強化学習の重要な部分であり、特定の状態でエージェントが取得する報酬値を評価するために使用されます。その設計は、エージェントが最適なアクションを選択することで長期的な疲労を最大化するようにガイドするのに役立ちます。

C++ の深層強化学習テクノロジー

Aug 21, 2023 pm 11:33 PM

C++ の深層強化学習テクノロジー

Aug 21, 2023 pm 11:33 PM

深層強化学習技術は、人工知能の分野の一つとして大きな注目を集めており、複数の国際コンペティションで優勝しており、パーソナルアシスタント、自動運転、ゲームインテリジェンスなどの分野でも広く利用されています。深層強化学習を実現するプロセスにおいて、ハードウェア リソースが限られている場合、効率的で優れたプログラミング言語である C++ が特に重要になります。深層強化学習は、その名前が示すように、深層学習と強化学習の 2 つの分野のテクノロジーを組み合わせたものです。簡単に理解すると、ディープ ラーニングとは、多層のニューラル ネットワークを構築することでデータから特徴を学習し、意思決定を行うことを指します。

Go 言語を使用して深層強化学習の研究を行うにはどうすればよいですか?

Jun 10, 2023 pm 02:15 PM

Go 言語を使用して深層強化学習の研究を行うにはどうすればよいですか?

Jun 10, 2023 pm 02:15 PM

深層強化学習(DeepReinforcementLearning)は、深層学習と強化学習を組み合わせた高度な技術で、音声認識、画像認識、自然言語処理などの分野で広く利用されています。 Go 言語は、高速、効率的、信頼性の高いプログラミング言語として、深層強化学習の研究に役立ちます。この記事では、Go言語を使用して深層強化学習の研究を行う方法を紹介します。 1. Go 言語と関連ライブラリをインストールし、深層強化学習に Go 言語の使用を開始します。

Actor-Critic の DDPG 強化学習アルゴリズムを使用した二重関節ロボット アームの制御

May 12, 2023 pm 09:55 PM

Actor-Critic の DDPG 強化学習アルゴリズムを使用した二重関節ロボット アームの制御

May 12, 2023 pm 09:55 PM

この記事では、UnityML-Agents ツールキットを使用して開発された Unity ベースのシミュレーション プログラムである Reacher 環境で二重関節ロボット アームを制御するインテリジェント エージェントのトレーニングを紹介します。私たちの目標は、高精度でターゲット位置に到達することなので、ここでは、連続状態およびアクション空間用に設計された最先端の DeepDeterministicPolicyGradient (DDPG) アルゴリズムを使用できます。現実世界のアプリケーション ロボット アームは、製造、生産施設、宇宙探査、捜索救助活動において重要な役割を果たします。ロボットアームを高精度かつ柔軟に制御することが非常に重要です。強化学習技術を採用することで、これらのロボット システムはリアルタイムで動作を学習し、調整できるようになります。

強化学習のもう一つの革命! DeepMind が提案する「アルゴリズム蒸留」: 探索可能な事前トレーニング済み強化学習 Transformer

Apr 12, 2023 pm 06:58 PM

強化学習のもう一つの革命! DeepMind が提案する「アルゴリズム蒸留」: 探索可能な事前トレーニング済み強化学習 Transformer

Apr 12, 2023 pm 06:58 PM

現在のシーケンス モデリング タスクにおいて、Transformer は最も強力なニューラル ネットワーク アーキテクチャであると言えます。また、事前トレーニングされた Transformer モデルは、プロンプトを条件として使用したり、コンテキスト内学習を使用して、さまざまな下流タスクに適応したりできます。大規模な事前トレーニング済み Transformer モデルの汎化能力は、テキスト補完、言語理解、画像生成などの複数の分野で検証されています。昨年以来、オフライン強化学習 (オフライン RL) をシーケンス予測問題として扱うことで、モデルがオフライン データからポリシーを学習できることを証明する関連研究が行われてきました。しかし、現在のアプローチは、学習を含まないデータからポリシーを学習するか、

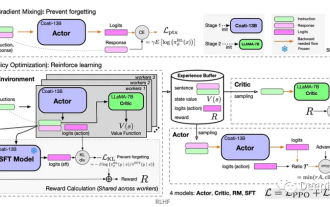

Kuaishou ユーザー維持率を向上させるために強化学習を使用する方法は?

May 07, 2023 pm 06:31 PM

Kuaishou ユーザー維持率を向上させるために強化学習を使用する方法は?

May 07, 2023 pm 06:31 PM

短編ビデオ レコメンデーション システムの中核的な目標は、ユーザー維持率を向上させて DAU の増加を促進することです。したがって、リテンションは各 APP の中核となるビジネス最適化指標の 1 つです。しかし、リテンションはユーザーとシステムの間の複数のインタラクションを経た長期的なフィードバックであり、それを単一の項目または単一のリストに分解することは困難であるため、従来のポイント単位とリストを使用してリテンションを直接最適化することは困難です。賢いモデルたち。強化学習 (RL) 手法は、環境と対話することで長期的な報酬を最適化し、ユーザー維持率を直接最適化するのに適しています。この研究では、保持最適化問題を、無限のホライズン要求粒度を備えたマルコフ決定プロセス (MDP) としてモデル化しています。ユーザーが推奨システムにアクションを決定するよう要求するたびに、複数の異なる短期フィードバック推定値 (視聴時間、視聴時間、

強化学習が再び Nature の表紙を飾り、自動運転の安全性検証の新しいパラダイムによりテスト走行距離が大幅に削減

Mar 31, 2023 pm 10:38 PM

強化学習が再び Nature の表紙を飾り、自動運転の安全性検証の新しいパラダイムによりテスト走行距離が大幅に削減

Mar 31, 2023 pm 10:38 PM

高密度強化学習を導入し、AI を使用して AI を検証します。自動運転車 (AV) 技術の急速な進歩により、私たちは 1 世紀前の自動車の出現以来見られない規模の輸送革命の頂点に立っています。自動運転技術は、交通安全、モビリティ、持続可能性を大幅に改善する可能性があるため、産業界、政府機関、専門機関、学術機関の注目を集めています。自動運転車の開発は、特にディープラーニングの出現により、過去 20 年間で大きく進歩しました。 2015 年までに、企業は 2020 年までに AV を量産すると発表し始めました。しかし今のところ、レベル 4 の AV は市場に存在しません。