Chen Danqi チームの革新的な作品: 5% のコストで SOTA を入手し、「アルパカの毛刈り」の流行を引き起こす

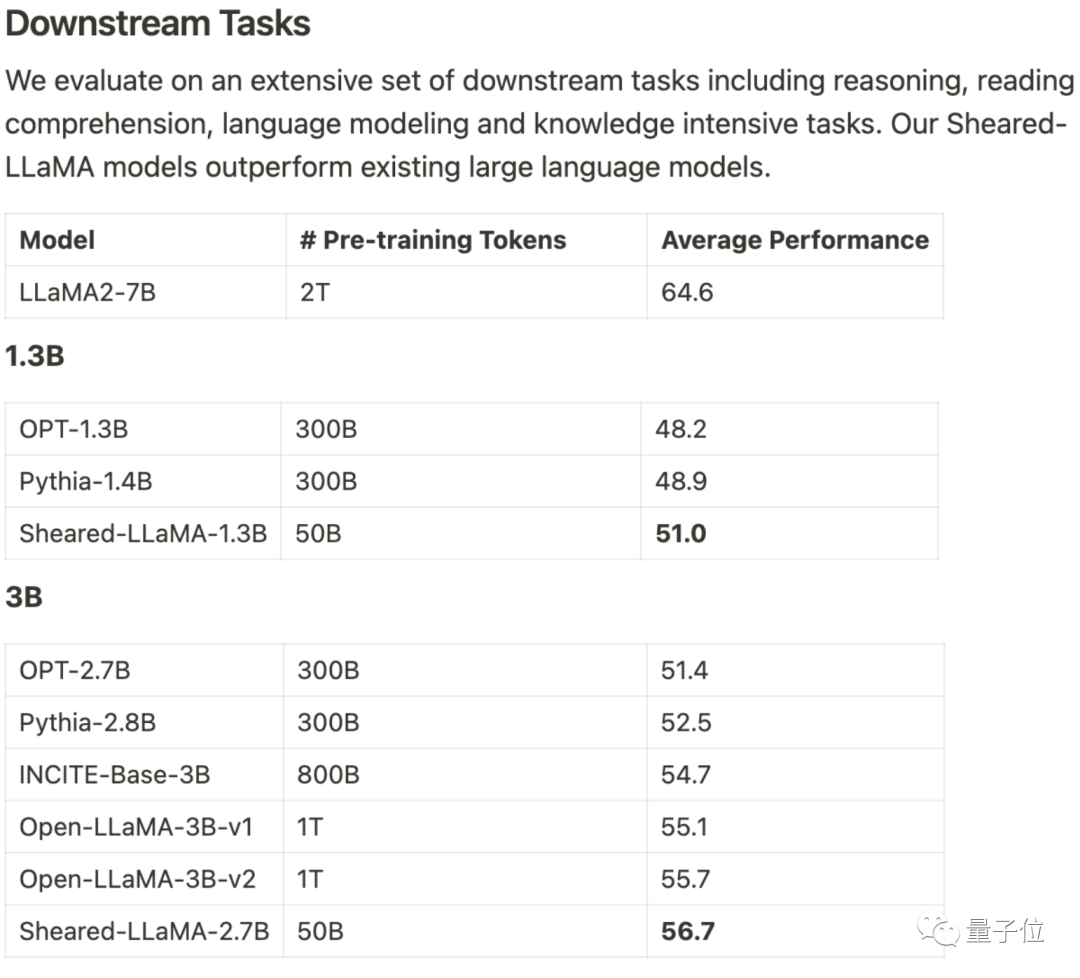

計算の 3% のみ 、コストの 5% SOTA を取得し、オープンの 1B ~ 3B スケールを独占出典 大型モデル。

この結果は、LLM-ShearingLarge Model Pruning Method と呼ばれるプリンストン Chen Danqi チームによるものです。

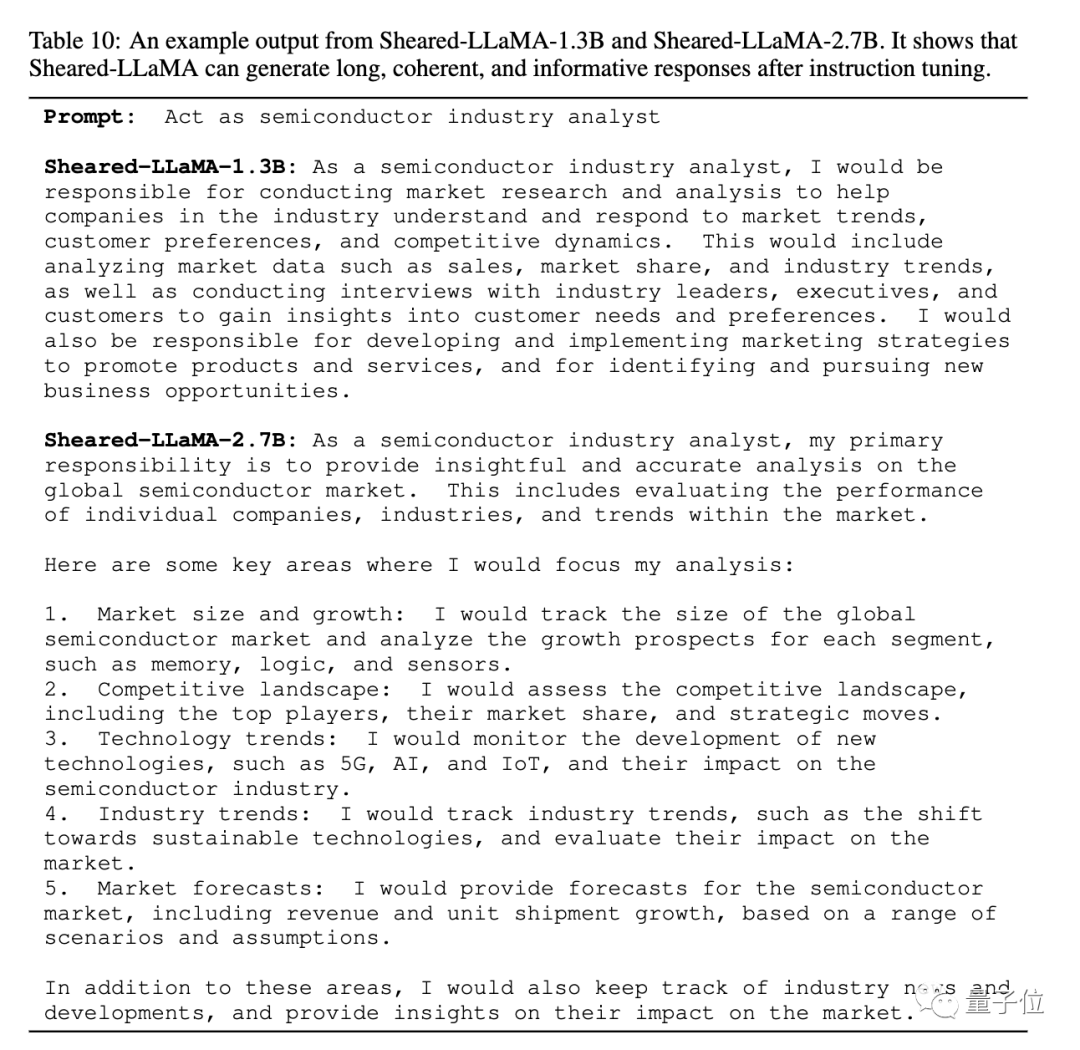

アルパカ LLaMA 2 7B に基づいて、1.3B および 3B プルーニングされた Sheared-LLama モデルは、指向性構造化プルーニング によって取得されます。

他のモデル アーキテクチャにも拡張可能であると述べています、 は任意のスケール に拡張することもできます。

プルーニング後のさらなる利点は、継続的な事前トレーニングのために高品質のデータセットを選択できることです

これが続けば、1B ~ 3B モデルも、今すぐではないにしても、すぐに大きな価値を生み出すことができると私は確信しています。

# 制約付き最適化として枝刈りを扱う

# 制約付き最適化として枝刈りを扱う

LLM-Shearing、具体的には

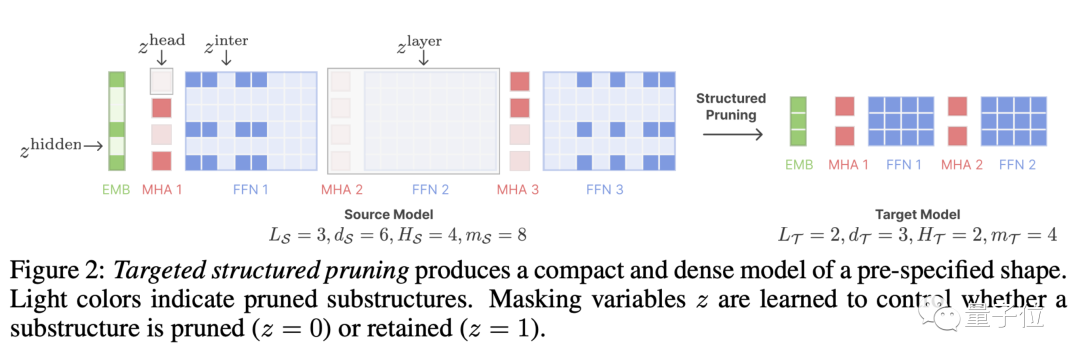

指向性構造化枝刈りブランチ、大規模なモデルを指定されたターゲット構造に合わせてプルーニングします。 以前の枝刈り手法では、一部の構造が削除され、表現力に影響を与えるため、モデルのパフォーマンスが低下する可能性があります。

枝刈りを制約付き最適化問題として扱うことで、新しい手法を提案します。パフォーマンスを最大化することを目的として、プルーニング マスク マトリックスを学習することで、指定された構造に一致するサブネットワークを検索します。

# 次に、プルーニングされたモデルを続行します。 事前トレーニングにより、ある程度の枝刈りによるパフォーマンスの低下。

# 次に、プルーニングされたモデルを続行します。 事前トレーニングにより、ある程度の枝刈りによるパフォーマンスの低下。

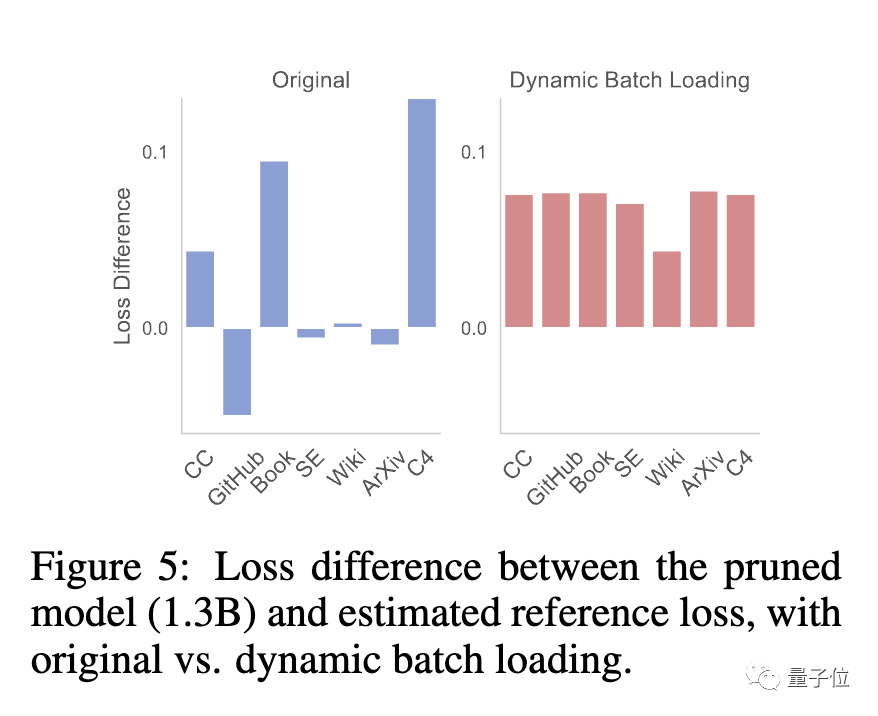

この段階で、チームは、枝刈りしたモデルと最初からトレーニングしたモデルでは、データセットごとに損失低減率が異なるため、データ利用効率が低いという問題が発生していることを発見しました。

この目的のために、チームは、モデルの損失削減率に応じて各ドメインのデータを動的に調整する

Dynamic Batch Loading(Dynamic Batch Loading)を提案しました。異なるドメインのデータに比例してデータ利用効率が向上します。

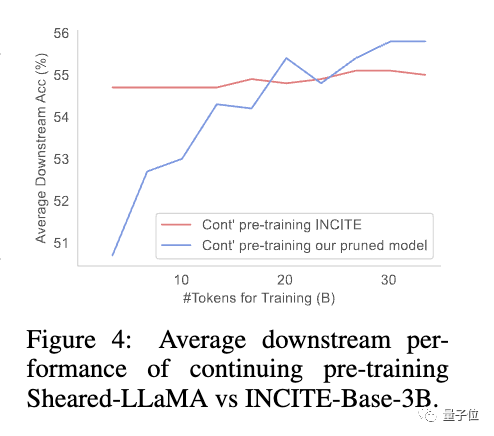

研究によると、枝刈りされたモデルは、最初からトレーニングされた同じサイズのモデルに比べて初期パフォーマンスが劣りますが、継続的な事前トレーニングを通じてすぐに改善され、最終的には向上する可能性があります。超える

研究によると、枝刈りされたモデルは、最初からトレーニングされた同じサイズのモデルに比べて初期パフォーマンスが劣りますが、継続的な事前トレーニングを通じてすぐに改善され、最終的には向上する可能性があります。超える

これは、強力な基本モデルから枝刈りを行うことで、事前トレーニングを継続するためのより良い初期化条件を提供できることを示しています。

は引き続き更新されます。1 つずつ切り取ってみましょう

この論文の著者はプリンストン大学の博士課程の学生です Xia Mengzhou, Gao Tianyu、清華大学Zhiyuan Zeng、プリンストン大学助教授陈 Danqi。

Xia Mengzhou は、復旦大学で学士号を取得し、CMU で修士号を取得しました。

Gao Tianyu は清華大学を卒業した学部生で、2019 年に清華特別賞を受賞しました

二人とも陳丹祁の学生で、陳丹祁は現在プリンストン大学の助手ですプリンストン自然言語処理グループの教授兼共同リーダー

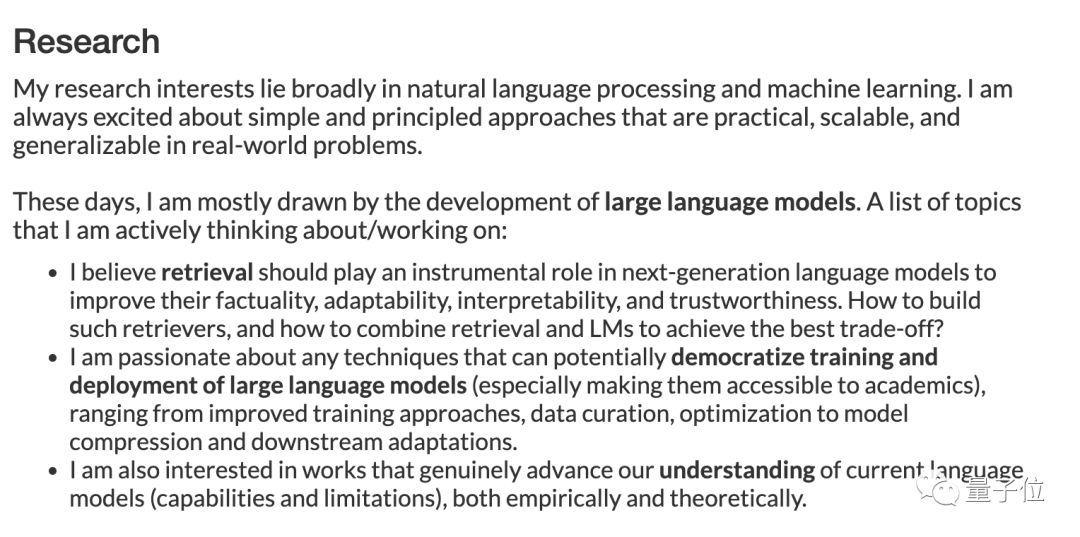

最近、Chen Danqi 氏は個人のホームページで研究の方向性を更新しました。

「この期間は主に大規模モデルの開発に焦点を当てています。研究テーマには次のものが含まれます。」

- 次世代モデルにおいて、信頼性、適応性、解釈可能性と信頼性。

- 大規模モデルの低コストのトレーニングとデプロイメント、改善されたトレーニング方法、データ管理、モデル圧縮、下流のタスク適応の最適化。

- また、現在の大規模モデルの機能と限界について、経験的および理論的に理解を深める研究にも興味があります。

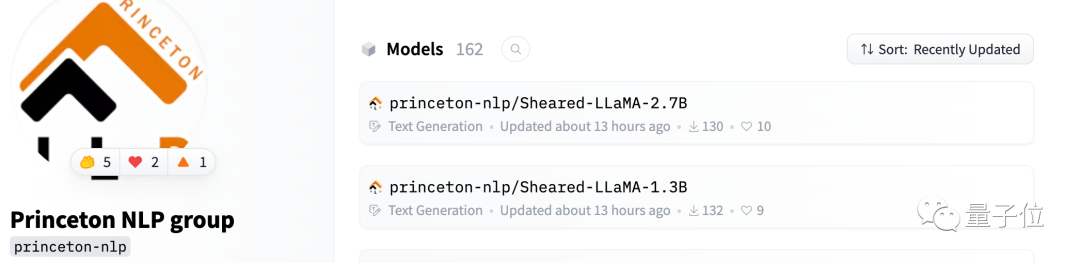

Sheared-Llama は Hugging Face で利用できるようになりました

チームは、今後も継続して提供すると述べました。オープンソース ライブラリを更新します。

さらに大きなモデルがリリースされたら、それらを 1 つずつ切り分けて、高性能の小さなモデルをリリースし続けます。

もう 1 つ

大きなモデルは縮れすぎていると言わざるを得ません。

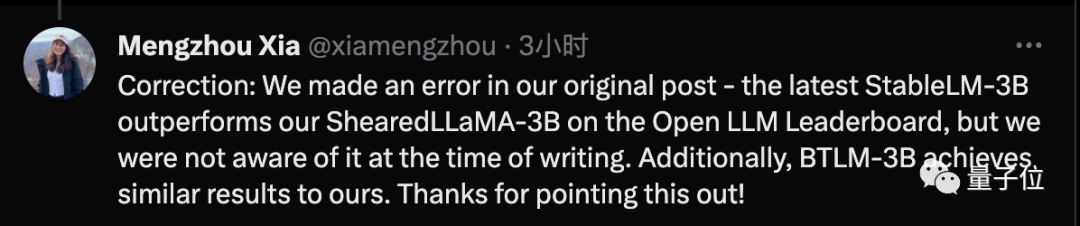

Mengzhou Xia 氏は、論文執筆時に SOTA テクノロジーを使用したが、論文完成後は最新の Stable-LM-3B テクノロジーによってその技術を上回られたと訂正を発表しました。

論文アドレス: https://arxiv.org/abs/2310.06694

##ハグフェイス: https://huggingface.co/princeton-nlp

プロジェクトのホームページのリンク: https://xiamengzhou.github.io/sheared-llama/

以上がChen Danqi チームの革新的な作品: 5% のコストで SOTA を入手し、「アルパカの毛刈り」の流行を引き起こすの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7548

7548

15

15

1382

1382

52

52

83

83

11

11

22

22

90

90

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverファイアウォールの構成のヒント

Apr 13, 2025 am 11:42 AM

Debian Mail Serverのファイアウォールの構成は、サーバーのセキュリティを確保するための重要なステップです。以下は、iPtablesやFirewalldの使用を含む、一般的に使用されるファイアウォール構成方法です。 iPtablesを使用してファイアウォールを構成してIPTablesをインストールします(まだインストールされていない場合):sudoapt-getupdatesudoapt-getinstalliptablesview現在のiptablesルール:sudoiptables-l configuration

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL証明書のインストール方法

Apr 13, 2025 am 11:39 AM

Debian Mail ServerにSSL証明書をインストールする手順は次のとおりです。1。最初にOpenSSL Toolkitをインストールすると、OpenSSLツールキットがシステムに既にインストールされていることを確認してください。インストールされていない場合は、次のコマンドを使用してインストールできます。sudoapt-getUpdatesudoapt-getInstalopenssl2。秘密キーと証明書のリクエストを生成次に、OpenSSLを使用して2048ビットRSA秘密キーと証明書リクエスト(CSR)を生成します:Openss

Centosシャットダウンコマンドライン

Apr 14, 2025 pm 09:12 PM

Centosシャットダウンコマンドライン

Apr 14, 2025 pm 09:12 PM

Centos Shutdownコマンドはシャットダウンし、構文はシャットダウン[オプション]時間[情報]です。オプションは次のとおりです。-hシステムをすぐに停止します。 -pシャットダウン後に電源をオフにします。 -r再起動; -t待機時間。時間は、即時(現在)、数分(分)、または特定の時間(HH:mm)として指定できます。追加の情報をシステムメッセージに表示できます。

ソニーは、PS5 Proで特別なGPUを使用してAMDを使用してAIを開発する可能性を確認しています

Apr 13, 2025 pm 11:45 PM

ソニーは、PS5 Proで特別なGPUを使用してAMDを使用してAIを開発する可能性を確認しています

Apr 13, 2025 pm 11:45 PM

Sony InteractiveEntertainmentのチーフアーキテクト(SIE、Sony Interactive Entertainment)のMark Cernyは、パフォーマンスアップグレードAMDRDNA2.xアーキテクチャGPU、およびAMDとの機械学習/人工知能プログラムコードノームの「Amethylst」を含む、次世代ホストPlayStation5Pro(PS5PRO)のハードウェアの詳細をリリースしました。 PS5PROパフォーマンスの改善の焦点は、より強力なGPU、高度なレイトレース、AI搭載のPSSRスーパー解像度関数を含む3つの柱に依然としてあります。 GPUは、SonyがRDNA2.xと名付けたカスタマイズされたAMDRDNA2アーキテクチャを採用しており、RDNA3アーキテクチャがあります。

Centosのgitlabのバックアップ方法は何ですか

Apr 14, 2025 pm 05:33 PM

Centosのgitlabのバックアップ方法は何ですか

Apr 14, 2025 pm 05:33 PM

Centosシステムの下でのGitlabのバックアップと回復ポリシーデータセキュリティと回復可能性を確保するために、Gitlab on Centosはさまざまなバックアップ方法を提供します。この記事では、いくつかの一般的なバックアップ方法、構成パラメーター、リカバリプロセスを詳細に紹介し、完全なGitLabバックアップと回復戦略を確立するのに役立ちます。 1.手動バックアップGitlab-RakeGitlabを使用:バックアップ:コマンドを作成して、マニュアルバックアップを実行します。このコマンドは、gitlabリポジトリ、データベース、ユーザー、ユーザーグループ、キー、アクセスなどのキー情報をバックアップします。デフォルトのバックアップファイルは、/var/opt/gitlab/backupsディレクトリに保存されます。 /etc /gitlabを変更できます

CentosでのZookeeperのパフォーマンスを調整する方法は何ですか

Apr 14, 2025 pm 03:18 PM

CentosでのZookeeperのパフォーマンスを調整する方法は何ですか

Apr 14, 2025 pm 03:18 PM

CENTOSでのZookeeperパフォーマンスチューニングは、ハードウェア構成、オペレーティングシステムの最適化、構成パラメーターの調整、監視、メンテナンスなど、複数の側面から開始できます。特定のチューニング方法を次に示します。SSDはハードウェア構成に推奨されます。ZookeeperのデータはDISKに書き込まれます。十分なメモリ:頻繁なディスクの読み取りと書き込みを避けるために、Zookeeperに十分なメモリリソースを割り当てます。マルチコアCPU:マルチコアCPUを使用して、Zookeeperが並行して処理できるようにします。

CentOS HDFS構成をチェックする方法

Apr 14, 2025 pm 07:21 PM

CentOS HDFS構成をチェックする方法

Apr 14, 2025 pm 07:21 PM

CENTOSシステムでHDFS構成をチェックするための完全なガイドこの記事では、CENTOSシステム上のHDFSの構成と実行ステータスを効果的に確認する方法をガイドします。次の手順は、HDFSのセットアップと操作を完全に理解するのに役立ちます。 Hadoop環境変数を確認します。最初に、Hadoop環境変数が正しく設定されていることを確認してください。端末では、次のコマンドを実行して、Hadoopが正しくインストールおよび構成されていることを確認します。HDFS構成をチェックするHDFSファイル:HDFSのコア構成ファイルは/etc/hadoop/conf/ディレクトリにあります。使用

最後に変わった! Microsoft Windows検索機能は新しいアップデートの先導

Apr 13, 2025 pm 11:42 PM

最後に変わった! Microsoft Windows検索機能は新しいアップデートの先導

Apr 13, 2025 pm 11:42 PM

MicrosoftのWindows検索機能に対する改善は、EUのWindows Insiderチャネルでテストされています。以前は、統合されたWindows検索機能はユーザーによって批判されており、経験が不十分でした。この更新は、検索機能を2つの部分に分割します。ローカル検索とBingベースのWeb検索でユーザーエクスペリエンスを向上させます。検索インターフェイスの新しいバージョンは、デフォルトでローカルファイル検索を実行します。オンラインで検索する必要がある場合は、[Microsoft BingWebsearch]タブをクリックして切り替える必要があります。切り替え後、検索バーには「Microsoft BingWebsearch:」が表示され、ユーザーはキーワードを入力できます。この動きにより、ローカル検索結果とBing検索結果の混合が効果的に回避されます