言語、ロボット破壊、MIT などは GPT-4 を使用してシミュレーション タスクを自動的に生成し、現実世界に移行します。

#ロボット工学の分野では、一般的なロボット戦略の実装には大量のデータが必要であり、現実世界でこのデータを収集するのは時間と労力がかかります。シミュレーションは、シーン レベルおよびインスタンス レベルでさまざまな量のデータを生成するための経済的なソリューションを提供しますが、シミュレートされた環境でタスクの多様性を高めるには、依然として大量の人員が必要となるため (特に複雑なタスクの場合) 課題に直面しています。その結果、典型的な人工シミュレーション ベンチマークには、通常、数十から数百のタスクしか含まれていません。

どうすれば解決できますか?近年、大規模な言語モデルは、さまざまなタスクの自然言語処理とコード生成において大幅な進歩を続けています。同様に、LLM は、ユーザー インターフェイス、タスクと動作計画、ロボット ログの概要、コストと報酬の設計など、ロボット工学のさまざまな側面に適用されており、物理ベースのタスクとコード生成タスクの両方で強力な機能を明らかにしています。

最近の研究では、MIT CSAIL、上海交通大学、その他の機関の研究者が、LLM を使用して多様なシミュレーション タスクを作成し、その能力をさらに調査できるかどうかをさらに調査しました。

具体的には、研究者らは LLM ベースのフレームワーク GenSim を提案しました。これは、タスク資産の配置とタスクの進捗状況を設計および検証するための自動メカニズムを提供します。さらに重要なことは、生成されたタスクは非常に多様性を示し、ロボット戦略のタスクレベルの一般化を促進します。さらに、概念的には、GenSim を使用すると、LLM の推論およびエンコード機能が、シミュレートされたデータの中間合成を通じて言語-視覚-アクション戦略に洗練されます。

論文アドレス: https://arxiv.org/pdf/2310.01361.pdf

#GenSim フレームワークは、次の 3 つの部分で構成されます。

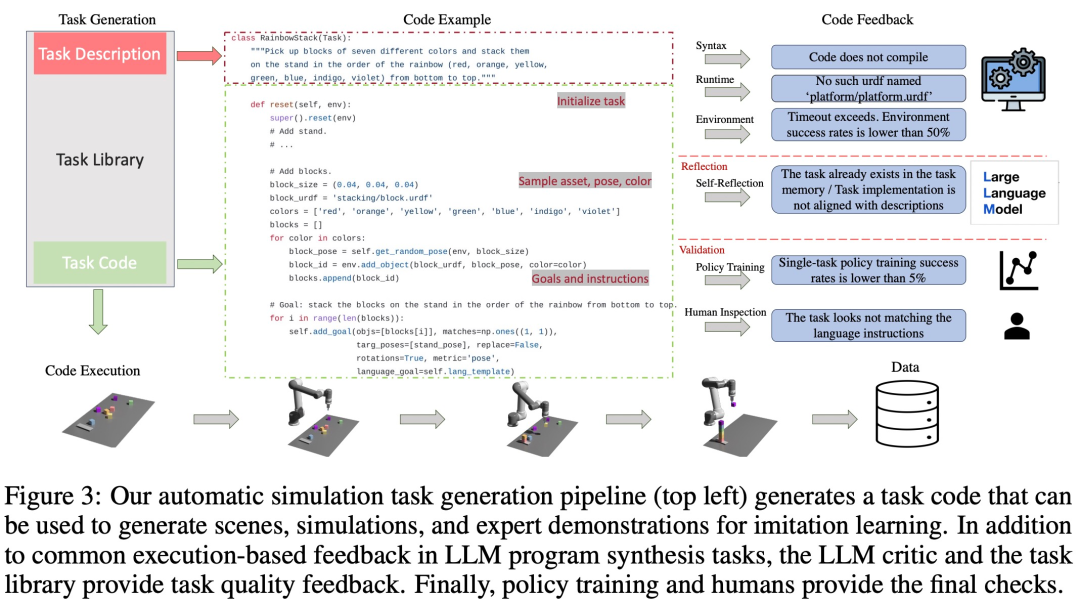

- 最初の部分は、自然言語命令と対応するコード実装を通じて新しいタスクを提案するプロンプト メカニズムです。

- 2 番目は、検証と言語モデルの微調整のために以前に生成された高品質の命令コードをキャッシュし、それを包括的なタスク データ セットとして返すタスク ライブラリです。

- #最後に これは、生成されたデータを使用してタスク レベルの汎化機能を強化する、言語に適応したマルチタスク ポリシーのトレーニング プロセスです。

以下の図 1 では、研究者が手動で厳選した 10 個のタスクを含むタスク ライブラリを初期化し、GenSim を使用してそれを拡張し、100 個を超えるタスクを生成しました。

それだけでなく、研究者らは、人間の計画タスクのみでトレーニングされたモデルと比較して、すべての生成タスクで良好なパフォーマンスを発揮するマルチタスク ロボット戦略もトレーニングしました。 。 GPT-4 生成タスクを使用した共同トレーニングにより、汎化パフォーマンスが 50% 向上し、ゼロショット タスクの約 40% をシミュレーション内の新しいタスクに転送できます。

最後に、研究者らはシミュレーションから現実への移行も検討し、さまざまなシミュレーション タスクでの事前トレーニングによって現実世界の汎化能力が 25% 向上する可能性があることを示しました。

要約すると、さまざまな LLM によって生成されたタスクでトレーニングされた戦略は、新しいタスクに対するより優れたタスク レベルの一般化機能を実現し、LLM の拡張シミュレーション タスクの可能性を通じて基本戦略をトレーニングできることを示しています。

Tenstorrent AI 製品管理ディレクターの Shubham Saboo 氏は、この研究を高く評価し、GPT-4 などの LLM を使用して自動操縦でロボットを生成する、GPT-4 とロボットを組み合わせた画期的な研究であると述べました。一連のシミュレートされたロボット タスクにより、ゼロサンプル学習とロボットの実世界への適応が実現します。 下の図 2 に示すように、GenSimフレームワーク パス プロシージャル合成は、シミュレーション環境、タスク、およびデモンストレーションを生成します。 GenSim パイプラインはタスク作成者から開始され、プロンプト チェーンはターゲット タスクに応じて、目標指向モードと探索モードの 2 つのモードで実行されます。 GenSim のタスク ライブラリは、以前に生成された高品質のタスクを保存するために使用されるメモリ内コンポーネントであり、タスク ライブラリに保存されたタスクは、マルチタスク ポリシーのトレーニングや LLM の微調整に使用できます。 #Task Creator

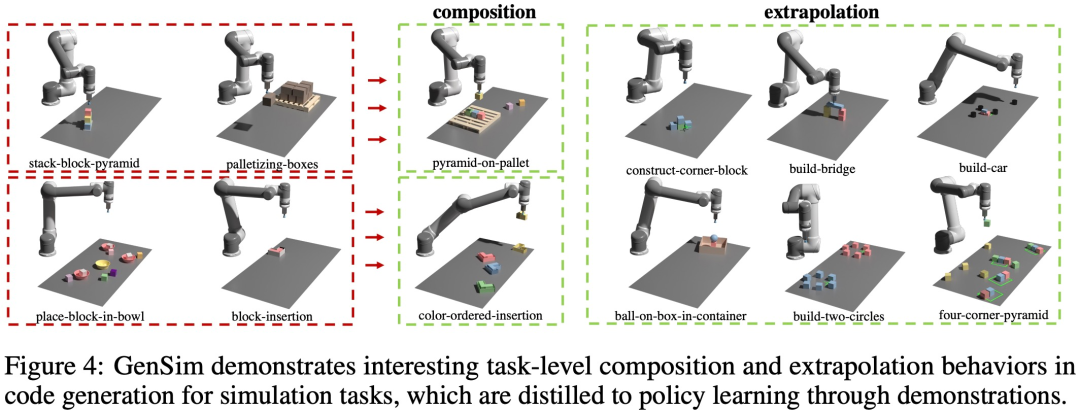

タスク ライブラリ タスク ライブラリは、タスク作成者に説明生成フェーズの条件として以前のタスクの説明を提供し、コード生成フェーズに以前のコードを提供し、タスク作成者にプロンプトを表示します。タスク ライブラリ 新しいタスクを作成するための例として参照タスクを選択します。タスクの実装が完了し、すべてのテストに合格すると、LLM は新しいタスクとタスク ライブラリを「反映」し、新しく生成されたタスクをライブラリに追加するかどうかについて包括的な決定を下すように求められます。 #以下の図 4 に示すように、この研究では、GenSim が興味深いタスクレベルの組み合わせと外挿動作を示していることも観察されました。 タスクが生成された後、調査ではこれらのタスク実装を使用してShridhar et al. (2022) と同様のデュアルストリーム伝送ネットワーク アーキテクチャを使用して、データをデモンストレーションし、運用戦略をトレーニングします。 以下の図 5 に示すように、この研究では、プログラムをタスクと関連するデモンストレーション データの効果的な表現とみなして (図 5)、タスク間の埋め込みスペースとその埋め込みスペースを定義できます。距離インデックス オブジェクトの姿勢や形状など、知覚から派生するさまざまな要因に対してより堅牢です。

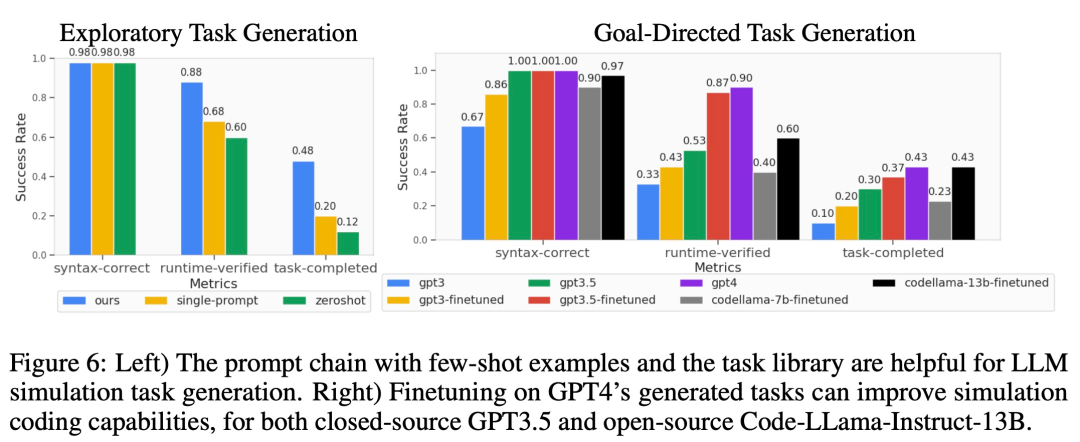

LLM ロボット シミュレーション タスクの汎化能力の評価 以下の図 6 に示すように、探索モードの場合ガイド モードのタスク生成、少数のサンプルとタスク ライブラリを使用した 2 段階のプロンプト チェーンにより、コード生成の成功率を効果的に向上させることができます。

関連タスクの少数サンプル戦略の最適化。以下の図 7 の左側からわかるように、LLM によって生成されたタスクを共同トレーニングすると、特にデータ量が少ない状況 (5 つのデモなど) で、元の CLIPort タスクのポリシーのパフォーマンスが 50% 以上向上します。 ゼロショット ポリシーを目に見えないタスクに一般化します。図 7 からわかるように、LLM によって生成されたより多くのタスクで事前トレーニングすることにより、モデルは元の Ravens ベンチマークのタスクに対してより適切に一般化できます。図 7 の中央右では、研究者らはまた、手動で作成されたタスク、クローズドソース LLM、オープンソースの微調整された LLM を含む、異なるタスク ソースで 5 つのタスクを事前トレーニングし、同様のゼロショット タスク レベルを観察しました。一般化。 ##事前トレーニングされたモデルを現実世界に適応させる 研究者は、シミュレーション環境で訓練された戦略を現実の環境に移しました。結果は以下の表 1 に示されており、GPT-4 で生成された 70 個のタスクで事前トレーニングされたモデルは、9 個のタスクで 10 回の実験を実施し、平均成功率 68.8% を達成しました。これは、CLIPort タスクのみで事前トレーニングした場合よりも優れています。ベースライン モデルと比較すると 25% 以上改善され、わずか 50 のタスクで事前トレーニングされたモデルと比較すると 15% 改善されました。 研究者らは、さまざまなシミュレーション タスクでの事前トレーニングにより、長期にわたる複雑なタスクの堅牢性が向上することも観察しました。たとえば、GPT-4 の事前トレーニングされたモデルは、実際のビルドホイール タスクでより堅牢なパフォーマンスを示します。 #アブレーション実験

コード生成の比較。以下の図 9(b) では、研究者は GPT-4 と Code Llama のトップダウン実験で失敗したケースを定性的に評価しています。

#メソッドの紹介

#実験と結果

#実験と結果この研究では、実験を使用して GenSim を検証します。 (1) LLM は、シミュレーション タスクの設計と実装においてどの程度効果的ですか? GenSim はタスク生成における LLM のパフォーマンスを向上させることができますか? (2) LLM によって生成されたタスクに関するトレーニングは、ポリシーの一般化能力を向上させることができますか?より多くの生成タスクを与えれば、ポリシー トレーニングのメリットはさらに大きくなるでしょうか? (3) LLM で生成されたシミュレーション タスクの事前トレーニングは、現実世界のロボット ポリシーの展開に有益ですか?

#タスク レベルの一般化

#タスク レベルの一般化

#タスク統計を生成します。以下の図 9 (a) では、研究者は、LLM によって生成された 120 個のタスクのさまざまな機能のタスク統計を示しています。 LLM モデルによって生成される色、アセット、アクション、およびインスタンスの数の間には、興味深いバランスがあります。たとえば、生成されたコードには、7 つを超えるオブジェクト インスタンスを含む多くのシーンに加えて、ピック アンド プレイスのプリミティブ アクションやブロックなどのアセットが多数含まれています。

#タスク統計を生成します。以下の図 9 (a) では、研究者は、LLM によって生成された 120 個のタスクのさまざまな機能のタスク統計を示しています。 LLM モデルによって生成される色、アセット、アクション、およびインスタンスの数の間には、興味深いバランスがあります。たとえば、生成されたコードには、7 つを超えるオブジェクト インスタンスを含む多くのシーンに加えて、ピック アンド プレイスのプリミティブ アクションやブロックなどのアセットが多数含まれています。  #技術的な詳細については、元の論文を参照してください。

#技術的な詳細については、元の論文を参照してください。

以上が言語、ロボット破壊、MIT などは GPT-4 を使用してシミュレーション タスクを自動的に生成し、現実世界に移行します。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7333

7333

9

9

1627

1627

14

14

1351

1351

46

46

1262

1262

25

25

1209

1209

29

29

ddrescue を使用して Linux 上のデータを回復する

Mar 20, 2024 pm 01:37 PM

ddrescue を使用して Linux 上のデータを回復する

Mar 20, 2024 pm 01:37 PM

DDREASE は、ハード ドライブ、SSD、RAM ディスク、CD、DVD、USB ストレージ デバイスなどのファイル デバイスまたはブロック デバイスからデータを回復するためのツールです。あるブロック デバイスから別のブロック デバイスにデータをコピーし、破損したデータ ブロックを残して正常なデータ ブロックのみを移動します。 ddreasue は、回復操作中に干渉を必要としないため、完全に自動化された強力な回復ツールです。さらに、ddasue マップ ファイルのおかげでいつでも停止および再開できます。 DDREASE のその他の主要な機能は次のとおりです。 リカバリされたデータは上書きされませんが、反復リカバリの場合にギャップが埋められます。ただし、ツールに明示的に指示されている場合は切り詰めることができます。複数のファイルまたはブロックから単一のファイルにデータを復元します

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

0.この記事は何をするのですか?私たちは、多用途かつ高速な最先端の生成単眼深度推定モデルである DepthFM を提案します。従来の深度推定タスクに加えて、DepthFM は深度修復などの下流タスクでも最先端の機能を実証します。 DepthFM は効率的で、いくつかの推論ステップ内で深度マップを合成できます。この作品について一緒に読みましょう〜 1. 論文情報タイトル: DepthFM: FastMonocularDepthEstimationwithFlowMatching 著者: MingGui、JohannesS.Fischer、UlrichPrestel、PingchuanMa、Dmytr

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google が推進する JAX のパフォーマンスは、最近のベンチマーク テストで Pytorch や TensorFlow のパフォーマンスを上回り、7 つの指標で 1 位にランクされました。また、テストは最高の JAX パフォーマンスを備えた TPU では行われませんでした。ただし、開発者の間では、依然として Tensorflow よりも Pytorch の方が人気があります。しかし、将来的には、おそらくより大規模なモデルが JAX プラットフォームに基づいてトレーニングされ、実行されるようになるでしょう。モデル 最近、Keras チームは、ネイティブ PyTorch 実装を使用して 3 つのバックエンド (TensorFlow、JAX、PyTorch) をベンチマークし、TensorFlow を使用して Keras2 をベンチマークしました。まず、主流のセットを選択します

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

世界は狂ったように大きなモデルを構築していますが、インターネット上のデータだけではまったく不十分です。このトレーニング モデルは「ハンガー ゲーム」のようであり、世界中の AI 研究者は、データを貪欲に食べる人たちにどのように餌を与えるかを心配しています。この問題は、マルチモーダル タスクで特に顕著です。何もできなかった当時、中国人民大学学部のスタートアップチームは、独自の新しいモデルを使用して、中国で初めて「モデル生成データフィード自体」を実現しました。さらに、これは理解側と生成側の 2 つの側面からのアプローチであり、両方の側で高品質のマルチモーダルな新しいデータを生成し、モデル自体にデータのフィードバックを提供できます。モデルとは何ですか? Awaker 1.0 は、中関村フォーラムに登場したばかりの大型マルチモーダル モデルです。チームは誰ですか?ソフォンエンジン。人民大学ヒルハウス人工知能大学院の博士課程学生、ガオ・イージャオ氏によって設立されました。

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhone のモバイル データ接続に遅延や遅い問題が発生していませんか?通常、携帯電話の携帯インターネットの強度は、地域、携帯ネットワークの種類、ローミングの種類などのいくつかの要因によって異なります。より高速で信頼性の高いセルラー インターネット接続を実現するためにできることがいくつかあります。解決策 1 – iPhone を強制的に再起動する 場合によっては、デバイスを強制的に再起動すると、携帯電話接続を含む多くの機能がリセットされるだけです。ステップ 1 – 音量を上げるキーを 1 回押して放します。次に、音量小キーを押して、もう一度放します。ステップ 2 – プロセスの次の部分は、右側のボタンを押し続けることです。 iPhone の再起動が完了するまで待ちます。セルラーデータを有効にし、ネットワーク速度を確認します。もう一度確認してください 修正 2 – データ モードを変更する 5G はより優れたネットワーク速度を提供しますが、信号が弱い場合はより適切に機能します

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

何?ズートピアは国産AIによって実現するのか?ビデオとともに公開されたのは、「Keling」と呼ばれる新しい大規模な国産ビデオ生成モデルです。 Sora も同様の技術的ルートを使用し、自社開発の技術革新を多数組み合わせて、大きく合理的な動きをするだけでなく、物理世界の特性をシミュレートし、強力な概念的結合能力と想像力を備えたビデオを制作します。データによると、Keling は、最大 1080p の解像度で 30fps で最大 2 分の超長時間ビデオの生成をサポートし、複数のアスペクト比をサポートします。もう 1 つの重要な点は、Keling は研究所が公開したデモやビデオ結果のデモンストレーションではなく、ショートビデオ分野のリーダーである Kuaishou が立ち上げた製品レベルのアプリケーションであるということです。さらに、主な焦点は実用的であり、白紙小切手を書かず、リリースされたらすぐにオンラインに移行することです。Ke Ling の大型モデルは Kuaiying でリリースされました。

アメリカ空軍が初のAI戦闘機を公開し注目を集める!大臣はプロセス全体を通じて干渉することなく個人的にテストを実施し、10万行のコードが21回にわたってテストされました。

May 07, 2024 pm 05:00 PM

アメリカ空軍が初のAI戦闘機を公開し注目を集める!大臣はプロセス全体を通じて干渉することなく個人的にテストを実施し、10万行のコードが21回にわたってテストされました。

May 07, 2024 pm 05:00 PM

最近、軍事界は、米軍戦闘機が AI を使用して完全自動空戦を完了できるようになったというニュースに圧倒されました。そう、つい最近、米軍のAI戦闘機が初めて公開され、その謎が明らかになりました。この戦闘機の正式名称は可変安定性飛行シミュレーター試験機(VISTA)で、アメリカ空軍長官が自ら飛行させ、一対一の空戦をシミュレートした。 5 月 2 日、フランク ケンダル米国空軍長官は X-62AVISTA でエドワーズ空軍基地を離陸しました。1 時間の飛行中、すべての飛行動作が AI によって自律的に完了されたことに注目してください。ケンダル氏は「過去数十年にわたり、私たちは自律型空対空戦闘の無限の可能性について考えてきたが、それは常に手の届かないものだと思われてきた」と語った。しかし今では、