テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

Qingyun Technology がコンピューティング能力の課題に対処するための AI コンピューティング能力の製品とサービスを発売することについての詳細な説明

Qingyun Technology がコンピューティング能力の課題に対処するための AI コンピューティング能力の製品とサービスを発売することについての詳細な説明

Qingyun Technology がコンピューティング能力の課題に対処するための AI コンピューティング能力の製品とサービスを発売することについての詳細な説明

Qingyun Technology AI Computing Power Conference では、製品マネージャーの Miao Hui 氏が、Qingyun AI コンピューティング パワー スケジューリング プラットフォームと Qingyun AI コンピューティング パワー クラウド サービスについて詳しく紹介しました。以下はスピーチの全文です:

人工知能ユーザーはコンピューティング能力の課題に直面しています

人工知能産業、AIGC、大規模モデル、科学研究コンピューティング、エンタープライズレベルのビッグデータ、人工知能の爆発的な成長に伴い、コンピューティングパワーセンターに対する要求が高まっています。特に、単一のコンピューティング能力を備えたデータセンターに直面すると、あらゆる分野で増大するコンピューティング能力の需要を満たすことができなくなり、より多くのインテリジェントコンピューティングセンター、スーパーコンピューティングセンター、および一般的なクラウドコンピューティングサービスが必要とされています。社会全体へのコンピューティングパワーサービス。

ただし、AI 業界、AI インフラストラクチャ、および AI コンピューティング能力のユーザーは、一連の課題にも直面しています。

複数のリソースを一元管理する際のボトルネック。複数のコンピューティング能力、複数のストレージ、コンピューティング ネットワーク全体、および近隣のサービスに対するユーザーの要件に直面して、Qingyun は、複数のリソース管理の混沌とした状況を解決するために、複数のリソース管理の統合サービス スケジューリング プラットフォームを提供します。

高速ネットワークのボトルネック。 AI高速ネットワーク構築に関して、Qingyunは高速ネットワークを使用してコンピューティングデバイスとストレージデバイスを相互接続し、汎用ネットワークを使用してアプリケーションサービスを公開します。つまり、QingyunはQingyunのプラットフォームを通じてマルチリージョンの高速ネットワークの問題を解決します。 。

環境構築が面倒なボトルネック。アルゴリズム エンジニアや研究開発エンジニアは、ハードウェア サーバーやストレージ サーバーなどの基本的な環境のセットアップに多くの時間を浪費することがありますが、Qingyun AI インテリジェント コンピューティング サービス、トレーニング プラットフォーム、推論モデル プラットフォームを通じて、環境構築が簡素化され、ワンクリックで導入できます。達成。

マルチサービス統合のボトルネック。 Qingyun は複数のビジネスを統合し、従来のクラウド コンピューティング、スーパー コンピューティング、インテリジェント コンピューティングを組み合わせて、より多くの企業とより多くの顧客にパノラマ コンピューティング サービスを提供します。

運用サービスの欠如。 Qingyun は、コンピューティング パワー オペレーション センターとコンピューティング パワー管理部門に対して、包括的な運用および運用保守管理サービスも提供しています。

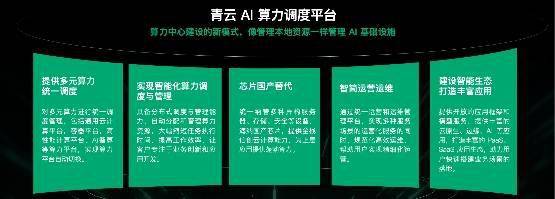

Qingyun AI コンピューティング パワー スケジューリング プラットフォーム

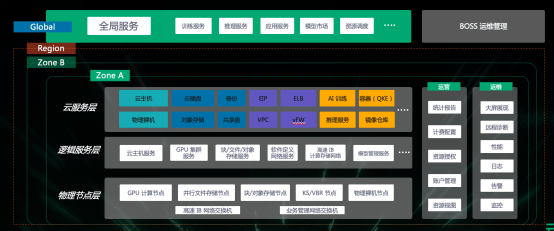

Qingyun AI スケジューリング製品のフルスタック製品アーキテクチャはマルチ AZ およびマルチゾーンです。つまり、複数の地域の製品を統合および統合して、グローバル サービスで社会全体にコンピューティング パワー サービスを提供できます。具体的には、基盤となるインフラストラクチャを管理し、データロジック層を通じてインフラストラクチャを論理的かつビジネス指向にし、GPUホスト、ベアメタル、仮想化、共有フォームなどの特定の製品またはサービスを通じてAIコンピューティングパワークラスタを形成します。 、コンテナ推論サービス、モデル市場およびその他の関連ビジネスを提供し、業界全体の顧客にコンピューティング能力のスケジューリングとアプリケーション シナリオの実装機能を提供します。

あらゆる側面をカバーする、新しいモデルのコンピューティングパワー構築センター

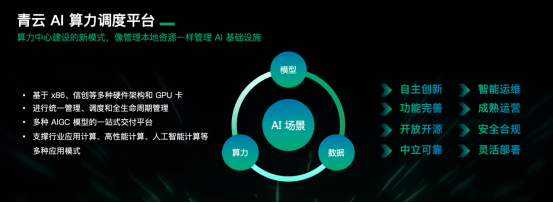

全体として、Qingyun Technology が提供する AI コンピューティング パワー スケジューリング プラットフォーム機能は、主に次の 4 つの側面に基づいています。

まず、プラットフォーム全体は、市場のすべてのコンピューティング チップ (新しく製造された Xinchuang チップを含む)、および GPU 関連のグラフィック カードおよびネットワーク カードと互換性があります。第二に、上記の適応リソースの統合管理、配布、監視、スケジューリングを実行し、ユーザーのアプリケーションから使用後のリリースまでのフルライフサイクルのオンライン管理機能を提供します。

第三に、管理側とユーザー側では、Qingyun 統合管理プラットフォームにより、ユーザーと管理者は AI インフラストラクチャと AI コンピューティング パワー クラウド サービスを完全に運用できるようになります。

インテリジェント コンピューティングの分野に向けて、Qingyun は、大規模言語モデルのトレーニングと推論、テキスト生成に基づく負荷分散サービスなど、シナリオベースのより多くのサービスを商品化し、AI コンピューティング パワー スケジューリング プラットフォームも使用できます。ワンクリックの導入、ワンクリックの拡張、ワンクリックの負荷分散などの便利な操作を顧客に提供します。特にネットワーク、パブリック ネットワーク、コンピューティング インフラストラクチャにおける負荷分散の観点から、第 2 レベルの配信と第 2 レベルの容量拡張を実現できます。

最後に、Qingyun は、上記の 3 つの機能に基づいて、ハイパフォーマンス コンピューティング、人工知能コンピューティング、一般的なコンピューティング モデルを含むさまざまな業界のコンピューティングをサポートし、独立したイノベーションと完全な機能を備えた統合ユーザー管理、配信、配信システムを構築できます。顧客向けの運用プラットフォーム。

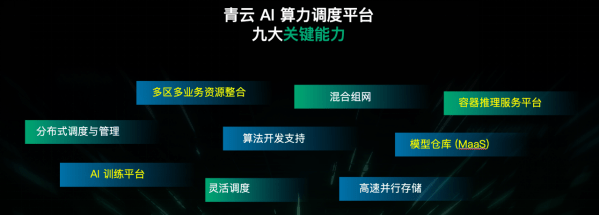

9 つの能力が AI コンピューティング能力の自由を解放します

長年にわたる業界の蓄積を通じて、Qingyun AI コンピューティング パワー スケジューリング プラットフォームは 9 つの主要な機能を形成しました。

1. マルチリージョンおよびマルチビジネスリソースの統合機能

1. マルチリージョンおよびマルチビジネスリソースの統合機能

特に四川省西部または北西部地域でのコンピューティングパワーサービスの多様化のために、東部地域、科学研究機関、大学にコンピューティングパワーサービスを提供する場合、Qingyun は複数地域のリソースを統合的に管理し、効果的な高サービスを構築できます。 -通信事業者との連携によるネットワークの高速化。

2. 分散スケジューリングおよび管理機能

Qingyun は、近隣使用の原則に従って、さまざまな地域、コンピューティング センター、データ センターにあるすべてのインフラストラクチャ (コンピューティング リソースとストレージ リソースを含む) を管理および分散し、アフィニティと非アフィニティを含むスケジュールの優先順位を構成します。 VM、ホスト、ベア メタル サーバー (コンテナおよびポッドに基づくコンテナを含む) では、アフィニティおよび非アフィニティ データ構成を Qingyun AI コンピューティング パワー スケジューリング プラットフォームの管理側で実行して、データ スケジューリングの優先順位を確保できます。データの最終的な使用、コンピューティング リソースのアプリケーション、ビジネス トレーニング、およびビジネス推論において、ユーザーが一貫したエクスペリエンスを確実に得られるようにすることです。

3. リソースのスケジューリング機能

リソース スケジューリング機能に関して、Qingyun には次の 6 つの大きな利点があります。

1) すぐに数万枚のカードのリソースをスケジュールして拡張します

主に AI コンピューティング シナリオ、特に大規模なモデル推論を対象としています。一部のモデル シナリオでは年に数回推論が必要となり、数十枚、場合によっては数万枚のカードを含むトレーニング プラットフォームを即座に構築する必要があります。この要件に従って、Qingyun AI コンピューティング パワー スケジューリング プラットフォーム上で組み込み、適応、およびリソース管理を実行して、コンピューティング パワー クラスターが数万枚のカードのリソースを即座にサポートし、カードの使用後にすぐに解放できることを保証します。使用。リソース環境と構成の点で、Qingyun AI コンピューティング パワー スケジューリング プラットフォームは、Wanka リソースを均一にスケジュールできるようにするために多くの自動化を行っています。

2) 通信リンク最短優先スケジューリング

データを迂回から守ることは、Qingyun AI コンピューティング パワー スケジューリング プラットフォームの主な目的でもあります。 AI トレーニングと AI 推論のシナリオでは、ノード間、およびノードとストレージ間で大量のデータのやり取りが発生します。この場合、Qingyun はスイッチ上でいくつかの構成を同時に実行し、コンピューティング リソースとストレージ リソースが確実に使用できるようにします。コンピュータ ルームまたはキャビネット内のスケジューリングを優先して、データの迂回を防ぎ、AI トレーニング中の困難なネットワーク送信の制約を軽減します。

3) 異種プラットフォームのサポート

クラスターを構築する際、ユーザーは異なるカード上で実行する異なるサービスを選択することができ、Qingyun Technology は国内での適応と国内でのチップの交換も行いました。 4) スケジューリング システムの粒度を向上させる

1 つ目は Slurm に基づくスケジューリング システム、2 つ目は K8s に基づくスケジューリング システムです。スケジューリング システムの粒度の点で、ユーザーは真のジョブ レベルの精度を認識でき、すべてのトレーニング タスクがすべてのカードのすべてのプロセスで実行される場合、大規模なデータ モニタリング、ビジネス スケジューリングなどを通じて実装できます。ジョブの異常により、ユーザーはトレーニング タスクの異常な状況をタイムリーに処理できるようになり、リソースのスケジュールを最大化し、このレベルでの無駄を削減できます。何か問題がある場合は、すぐに修正してすぐに実行します。

5) 管理側でスケジューリング優先度設定を実装します

異なるコンピューティング パワー センターは異なるコンピューティング パワー サービスを運用するため、特に複数のデータ センターの場合、ユーザーは Qingyun AI コンピューティング パワー スケジューリング プラットフォームを通じてスケジューリングに優先順位を付けることができます。すべては初期段階で組み込まれており、ユーザーは予約、一時停止、再開、優先設定、キューイングなどを設定して優先度を高めることもできます。 Qingyun は、管理レベルで、特別なアプリケーションを申請するユーザーまたは優先度の高いユーザーにリソースを優先的に割り当てることができます。

6) インテリジェント コンピューティング業界向けの柔軟なスケジューリングとリソースの割り当て

Qingyun は、AI システムにおける困難な優先事項に対処するために、動的かつ柔軟なリソースのスケジューリングと構成機能を可能にします。これが、Qingyun が AI スケジューリングのコンピューティング能力や AI シナリオにおける新しい問題を発見し続け、常にプラットフォームを使用して新しい問題を解決し、新製品を使用して業界のいくつかの主要な問題を解決する理由です。

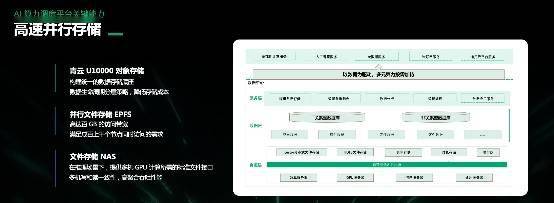

4. 高速並列ストレージ機能

Qingyun のコンピューティングおよびストレージ製品は多岐にわたり、次の 3 種類のストレージを提供します。

ストレージ モデル、コード、および一般的に使用されるデータ呼び出しは、主に大規模なデータ バックアップおよびデータ読み取り操作に使用されます。

2) 並列ファイルストレージ EPFS

大規模なデータの並列書き込みに関して、Qingyun は並列ファイル ストレージ EPFS を提供します。これは主に MPI レベルのデータ書き込み操作にオールフラッシュの並列ファイル ストレージを提供します。

3) ファイルストレージ NAS

一般的なドキュメントやテキストなどを保存できます。Qingyun のすべてのストレージ製品は、内部で自社のコンピューティング製品と相互接続でき、内部の高速ネットワーク上でデータの送信、配布、バックアップなどを実行できます。

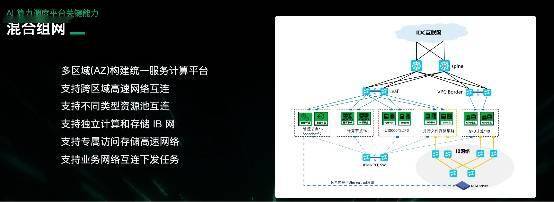

5. ハイブリッド ネットワーキング機能

コンピューティング IB ネットワークとストレージ IB ネットワークなど、コンピューティング シナリオに応じて異なる高速ネットワークを提供できますが、それらを最適に構成するにはどうすればよいですか?

Qingyun は、高構成のコンピューティング製品と高構成のストレージ製品を相互接続し、トレーニング シナリオ、推論シナリオ、および一般的なアプリケーション サービス シナリオのために中低構成の製品を相互接続します。

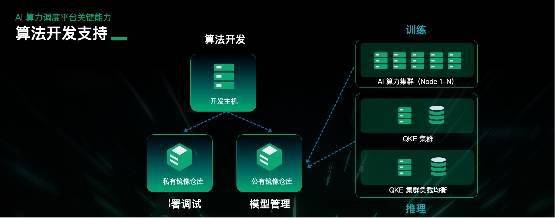

Qingyun は、アルゴリズム開発者向けに、より包括的なクラウド サービス製品を提供しています。特にアルゴリズム開発段階では、大量のパラメータ調整と大規模なコード記述が必要です。トレーニングおよび導入中は、システム内外での操作により、大規模なデータのアップロードやダウンロード、コードのコピーなどを行う場合、オンラインで編集して即時運用する場合には不向きです。

したがって、Qingyun は、アルゴリズム開発に関してアルゴリズム開発プラットフォームを提供しており、クラウド サービスに基づいてオンライン開発環境を立ち上げ、Python プロジェクトと VC プロジェクトを完全に構築し、プロジェクト ファイルとエンジニアリング環境をオンラインで使用してコード調査と実行を行うことができます。発達。

開発プロセス中に、デバッグが必要な場合はすぐに拡張できます。トレーニングが必要な場合は、ジョブ タスクをトレーニング クラスターにすぐに割り当てることができます。推論が必要な場合は、ジョブ タスクをトレーニング クラスターに配置できます。推論クラスター。

同時に、アルゴリズム開発プロセス中に、共同開発または混合開発が行われる場合があります。Qingyun は、モデル管理のためのコード ウェアハウスとミラー ウェアハウスも提供します。異なる担当者が異なる権限を使用して、統一されたアルゴリズム開発を実行し、サービス統合です。

一言で言えば、Qingyun は主に、アルゴリズム開発者向けのあらゆる開発シナリオに対応するコンピューティング製品とスケジューリング製品を提供し、アルゴリズム開発ビジネス全体がクラウド上で効果的に運用できるようにし、大規模なアップロードおよびダウンロード操作を削減します。

7. AI トレーニング プラットフォーム

アルゴリズム開発が完了に近づいている場合、またはデバッグが必要な場合は、開発とトレーニングのために大量のコンピューティング能力インフラストラクチャをアクティブにする必要があります。そのインフラストラクチャに基づいて、Qingyun はユーザーに力を与える AI トレーニング プラットフォームを提供します。

GPU リソース、ストレージ リソース、ネットワーク リソースが構築された後、ユーザーはクラウド プラットフォームを通じて独自に構築し、ワンクリック操作を実現できます。 Qingyun AI トレーニング プラットフォームは主に独自の GPU リソースに基づいてオンラインでクラスターを構築し、構築が完了すると、特定のストレージがデフォルトでマウントされ、ユーザーが自分で選択できます。

Qingyun AI トレーニング プラットフォームには、オンライン開発環境も組み込まれます。一般的に使用されるトレーニング フレームワークの一部も開発環境に組み込まれます。クラスターを通じてユーザーに完全なシナリオと完全なアプリケーション環境を提供し、ユーザーは次のことを行うことができます。複数のマシンにオンラインで分散するスタイルのトレーニング。

8. コンテナ推論サービス プラットフォーム 大規模モデルのトレーニングがほぼ完了したら、Qingyun コンテナ推論サービス プラットフォームは推論サービスを一般に提供するときに役割を果たすことができます。

Qingyun コンテナー推論サービス プラットフォームを通じて、ユーザーは推論サービスをデプロイした後、構成された負荷分散と自動スケーリングを使用して、ユーザーの訪問をすぐに呼び出すことができます。同時に、Qingyun は顧客にオンライン監視サービスを提供しており、推論サービスに問題が発生した場合、ユーザーはコンテナ推論で何が問題になったかをすぐに監視でき、Qingyun はオンラインで問題を解決できます。同時操作と大規模な呼び出し操作の場合、Qingyun は負荷分散と自動スケーリングも実行できるため、手動構成操作が大幅に削減されます。

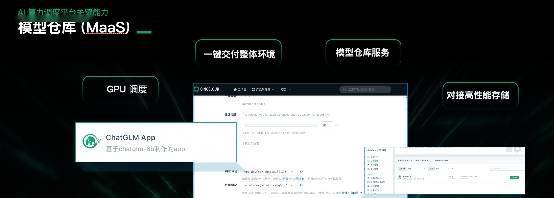

9.モデルウェアハウス(MaaS)

Qingyun Model Warehouse (MaaS) は、主に AI コンピューティング パワー サービスの顧客と一般コンピューティングの顧客を対象としています。モデル サービス プロバイダーは、独自のモデルのニーズに応じてアプリケーション マーケットとモデル マーケットに製品を投入できるため、さまざまな顧客にとって便利です。企業に電話をかけるだけでなく、ワンクリックで微調整し、ワンクリックで展開することもできます。

3: 多様な価値観を刺激し、シナリオ実現を加速する

一般に、Qingyun AI コンピューティング パワー スケジューリング プラットフォームの目的は、ローカル リソースのような AI インフラストラクチャを管理することであり、これは主に次の 5 つの主要な側面に反映されます。

GPU リソース、CPU リソース、国産チップ、アプリケーション フレームワーク、アプリケーション、およびユーザーのビジネス シナリオに直面して、Qingyun は、ストレージ設備やネットワーク設備を含むスケジューリングと管理に統合プラットフォームを使用します。

2. インフラストラクチャに基づいたインテリジェントなコンピューティング能力スケジューリングの実現

コンピューティング能力のスケジューリングの優先順位とアフィニティに関しては、VM、ホスト、コンテナーに基づいて、ユーザーは Qingyun のプラットフォームを通じてインテリジェントなコンピューティング能力のスケジューリングと構成、および管理サービスを実現できます。

3. 国内チップへの迅速かつ効果的な適応 Qingyun は国内チップに効果的かつ迅速に適応し、ローカライズされたアルゴリズム サービスとローカライズされたコードが国内チップ上ですぐに実行できるようにします。

4. 見える化サービス

管理側のインテリジェントな運用および保守の観点から、Qingyun の監視および警報サービスは、大規模な運用および保守プラットフォームを通じて顧客と管理者に視覚的な操作を提供します。

5. 豊富なアプリケーション市場

Qingyun Technology は、あらゆる階層のアプリケーションと顧客が Qingyun AI コンピューティング プラットフォーム上で必要なコンピューティング リソースとビジネス リソースを入手できるように、エコシステムを積極的に構築し、豊かなアプリケーション市場を創造します。

現在、Qingyun AI コンピューティング パワー スケジューリング プラットフォームは済南スーパーコンピューティング アプリケーションに実装されており、Sunward Cloud はオンラインで運用サービスを提供しています。 Qingyunは、済南市の数万台のスーパーコンピューティングハードウェアインフラストラクチャ、さまざまなコンピューティングネットワーク、サーバーなどを基盤として、リスト、管理、スケジューリングサービスを提供し、さまざまなコンピュータルーム、スーパーコンピューティングビジネス、インテリジェントコンピューティングビジネス、GPU、およびさまざまなストレージ向けのサービスを提供しています。情報、ネットワークベースのサービスを統合し、一元管理、統合、管理、配信を行い、計算能力スケジューリング製品や計算能力クラウドサービス製品をあらゆる分野の顧客に提供します。

清雲AIコンピューティングクラウドサービス

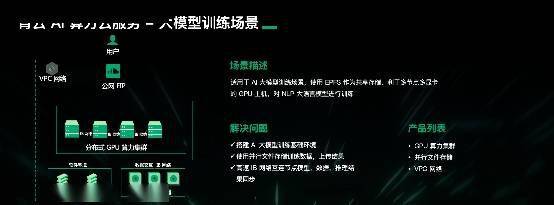

Qingyun AI コンピューティング パワー クラウド サービス製品も Qingyun パブリック クラウド上で起動され、主に大規模モデルのトレーニング シナリオ向けのサービスを提供します。

比較的優先度が高く、構成が高いカードの場合、Qingyun はパブリック クラウド コンピューティング サービス製品を提供します。AI シナリオでは、Qingyun は基盤となるリソースを使用して分散 GPU コンピューティング クラスターを構築し、それらをパブリック ネットワーク環境にバインドして、ユーザー アクセスを許可します。

ユーザーは、これに基づいて並列ファイル ストレージにデータをアップロードしたり、並列ファイル ストレージと GPU コンピューティング クラスターを同じネットワークに統合して、プライベート ネットワークを通じてデータ セキュリティとクラウド サービスのセキュリティを確保したりできます。オンライン トレーニングや、分散コンピューティング クラスターや並列ファイル ストレージへのリモート SSH アクセスを通じてビジネスを運営することもできます。

ビジネス面では、ユーザーは AI コンピューティング クラスターとコンテナー推論サービスを使用でき、そのインフラストラクチャは A800 リソース、ベア メタル サーバー、仮想化サーバーです。 Qingyun AI コンピューティング パワー クラウド サービス製品はすべて、高速相互接続ネットワークを使用し、AI コンピューティング パワー業界が必要とするオンライン環境、開発環境、トレーニングおよび推論環境を採用しており、誰でも登録と試用を申し込むことができます。

以上がQingyun Technology がコンピューティング能力の課題に対処するための AI コンピューティング能力の製品とサービスを発売することについての詳細な説明の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7503

7503

15

15

1377

1377

52

52

78

78

11

11

19

19

54

54

AI コンピューティング能力に対する需要は飛躍的に増加しており、光モジュール製品の反復的なアップデートが促進されており、1.6T ブロードバンドの需要が高まる可能性があります。

Aug 16, 2023 pm 06:13 PM

AI コンピューティング能力に対する需要は飛躍的に増加しており、光モジュール製品の反復的なアップデートが促進されており、1.6T ブロードバンドの需要が高まる可能性があります。

Aug 16, 2023 pm 06:13 PM

人工知能の需要が急増するにつれて、光モジュール製品は高速化と新技術の開発トレンドに適応するために更新され続けます。 AI の顧客 1.6T 光モジュールの需要は、より高い帯域幅と計算能力を備えた将来の GPU のニーズを満たすために提案されています。同社は2025年に1.6Tの光モジュールの量産を達成する予定で、AIコンピューティング能力の需要が爆発的に増加し、光モジュール産業の発展を促進しており、人工知能、ビッグデータ、クラウドコンピューティングなどの産業の台頭により、 5GやIoTに伴い、光モジュールは光ファイバー通信システムの中核部品の一つとなり、光電気信号変換を実現するための機能要求も急速に高まっており、通信市場やデータセンターの拡大が続く中、光通信はますます高度化しています。

Qingyun Technology がコンピューティング能力の課題に対処するための AI コンピューティング能力の製品とサービスを発売することについての詳細な説明

Oct 16, 2023 pm 08:37 PM

Qingyun Technology がコンピューティング能力の課題に対処するための AI コンピューティング能力の製品とサービスを発売することについての詳細な説明

Oct 16, 2023 pm 08:37 PM

Qingyun Technology AI Computing Power Conferenceでは、プロダクトマネージャーのMiao Hui氏がQingyun AIコンピューティングパワースケジューリングプラットフォームとQingyun AIコンピューティングパワークラウドサービスを詳しく紹介した。以下はスピーチの全文です: 人工知能ユーザーはコンピューティング能力の課題に直面しています 人工知能産業の爆発的な成長に伴い、AIGC、大規模モデル、科学研究コンピューティング、エンタープライズレベルのビッグデータ、および人工知能は、より高い要求を提示していますコンピューティングパワーセンター。特に、単一のコンピューティング能力を備えたデータセンターに直面すると、あらゆる分野で増大するコンピューティング能力の需要を満たすことができなくなり、より多くのインテリジェントコンピューティングセンター、スーパーコンピューティングセンター、および一般的なクラウドコンピューティングサービスが必要とされています。社会全体にコンピューティング電力サービスを提供します。しかし、AI 業界、AI インフラストラクチャ、AI コンピューティング能力のユーザーは、複数のリソースの統合管理のボトルネックという一連の課題にも直面しています。複数のコンピューティング能力、複数のストレージ、コンピューティング ネットワーク全体をユーザーに提供する

AI 指向のインフラストラクチャを構築し、レノボが AI コンピューティング能力の「メイン チャネル」を支えます

Aug 24, 2023 am 09:05 AM

AI 指向のインフラストラクチャを構築し、レノボが AI コンピューティング能力の「メイン チャネル」を支えます

Aug 24, 2023 am 09:05 AM

人工知能は人間社会にとって単なる技術革命ではなく、工業時代から農業時代へのような時代の到来を象徴するものであり、地球を揺るがす変化をもたらし、人類社会に何百年にもわたって影響を与えるものであることは間違いありません。何年も、何世紀にもわたって、何千年にもわたるプロセス。人工知能アプリケーションを促進する上で AI コンピューティング能力の重要性については疑いの余地がありませんが、特に今年の生成 AI 市場全体の爆発により、AI コンピューティング能力に対する膨大な需要がもたらされています。インテリジェンスアプリケーションにおいては、AIの計算能力が重要な要素となっていると言えます。このような背景のもと、レノボは、8月18日に開催された2023年中国コンピューティングパワー(インフラストラクチャ)カンファレンスにおいて、現在のAIコンピューティングパワーの需要に応え、レノボAIコンピューティングパワー戦略を正式に発表しました。

AI コンピューティング能力の需要が急増し、上海臨港は数百億規模のコンピューティング能力産業を構築する

Jun 03, 2023 pm 05:50 PM

AI コンピューティング能力の需要が急増し、上海臨港は数百億規模のコンピューティング能力産業を構築する

Jun 03, 2023 pm 05:50 PM

(編集者/Lu Dong) 大規模モデルと大規模なコンピューティング能力の統合と革新は、生産パラダイムに大きな変化を引き起こし、科学研究と産業応用をインテリジェント コンピューティングによる汎用人工知能 (AGI) の時代へと押し進めています。急速なテクノロジーの反復の初期段階では、新世代のインフラストラクチャを構築し、アプリケーションのしきい値を下げ、研究開発サイクルを短縮し、イノベーションの効率を向上させる方法が、政府と上流および下流の業界が共同で取り組む必要のある新たな課題となっています。解決する。 「現在、人工知能企業が臨港に来るとき、補助金などの支援政策だけに焦点を当てるのではなく、コンピューティングパワーのニーズを解決できるかどうかを問うている。」 6月2日、上海臨港新区インテリジェントコンピューティングカンファレンスで、臨港新映区管理委員会ハイテク部門の責任者、陸羽氏はこう語った。同日、「臨港新区におけるコンピューティング産業エコシステムの構築を加速するための行動計画」(以下、計画という)が策定された。

長城証券の侯斌氏: AI コンピューティング産業チェーンにおける投資機会を調査し、需要触媒の影響を理解する

Nov 11, 2023 am 08:37 AM

長城証券の侯斌氏: AI コンピューティング産業チェーンにおける投資機会を調査し、需要触媒の影響を理解する

Nov 11, 2023 am 08:37 AM

最近の Wind3C カンファレンスで、長城証券産業金融研究所兼 TMT 研究センター所長の侯斌氏は、「AI コンピューティング パワーと衛星インターネット」と題した講演を行い、コンピューティング パワーは開発の生産性であると信じていました。人工知能の。大規模な人工知能モデルの急速な開発とコンピューティング能力の需要の拡大に伴い、コンピューティング能力の需要とチップの能力の間に不一致が生じており、これが人工知能コンピューティングパワー産業の発展を促進します。光モジュールは、中国で最も高度な工業化と最先端技術の埋蔵量を備えた中核製品として、大規模な人工知能モデルの開発によるコンピューティング能力の継続的なアップグレードにより急速な成長が見込まれる。業界はまだ初期段階にあり、今後の中長期的な発展の可能性がある 規模が大きく、幅広い発展の可能性がある 侯斌氏が共有する核心点は次のとおりです。

Microsoft が再び行動を起こし、AI にコンピューティング能力を提供するためにマイニング変革企業に数十億ドルを投資するとのニュース

Jun 04, 2023 am 10:10 AM

Microsoft が再び行動を起こし、AI にコンピューティング能力を提供するためにマイニング変革企業に数十億ドルを投資するとのニュース

Jun 04, 2023 am 10:10 AM

OpenAI への正式投資後、Microsoft の関連ソフトウェアが ChatGPT を搭載することを次々に発表し、ユーザーの増加に伴い、OpenAI および多くのユーザーは、ロボット システムのより良いフィードバックと学習効果を望むなら、学習能力があるということは、全体的なコンピューティング能力を向上させる必要があることを意味します。しかしちょうど今日、ヨーロッパでの OpenAI CEO とのインタビューで、彼は OpenAI の API と製品計画について話し、多くのネチズンの注目を集めました。多くの友人の注目を集めたのは、AI の進歩に関する彼の議論でした。同氏によると、通常の AI の反復に加えて、GPT-3 も OpenAI のオープンソース計画に含まれていますが、現在 GPU では対応できなくなっています。そして、以前の紹介によると、GPT-

コンピューティングパワーの課題に対処するため、Amazon クラウドテクノロジーは AI インフラストラクチャの構築に重点を置いています

Jul 16, 2023 pm 02:21 PM

コンピューティングパワーの課題に対処するため、Amazon クラウドテクノロジーは AI インフラストラクチャの構築に重点を置いています

Jul 16, 2023 pm 02:21 PM

2023 Amazon Cloud Technology China Summit の 2 日目に来ても、まだたくさんの驚きがありました。この日の活動とテーマディスカッションは、AI という 1 つのテーマから逃れることはできません。 AI の継続的な注目のトレンドに焦点を当て、Amazon Cloud Technology は多くの導入を行っており、今後さらに多くの製品やテクノロジーが登場するでしょう。その中で、Amazon Cloud Technology Greater China のゼネラルマネージャーである Chen Xiaojian 氏は、Amazon Cloud Technology は顧客がインフラストラクチャの制約を取り除き、技術革新に集中できるよう支援することに重点を置いていると述べました。 AI 時代の高いコンピューティング能力要件に対処するために、Amazon Cloud Technology は、自社開発チップ、エラスティック コンピューティング ストレージの組み合わせ、サーバーレス アーキテクチャなどの製品とテクノロジーを開発し、よりコスト効率の高いサービスを提供します。 Chen Xiaojian 氏は、Amazon Cloud Technology には包括的かつ詳細なインフラストラクチャ構築機能があり、Intel と協力しており、