自動運転シミュレーションの壮大な世界観!自動運転シミュレーション業界について語ろう!

こんにちは、親愛なるリスナーの皆さん!シミュレーション グランド ビュー ガーデン プログラムの時間です!今日は自動運転シミュレーション業界について簡単に紹介します。

まず、自動運転にシミュレーションが必要な理由について話しましょう。数年前、『If You Are the One』を視聴していた際、ゲストのファン・ランは国民の3分の2が自動運転を受け入れる場合にのみ自動運転を受け入れると述べたが、これは自動運転の安全性に対する一般の人々の懸念を反映していた。安全性を確保するために、自動運転アルゴリズムは実際に大規模に適用される前に、多数の路上テストを受ける必要があります。しかし、自動運転システムのテストは非常に「高価」です。時間と資本コストが膨大であるため、人々はできるだけ多くのテストをコンピュータ システムに移行し、シミュレーションを使用して自動運転システムの問題のほとんどを明らかにしたいと考えています。したがって、現場での路上試験の需要が減り、私たちの仕事が生まれました。

1. シミュレーション シナリオ

シミュレーション シナリオは、自動運転システムのテスト ケースです。中国自動車技術研究センターの分類によれば、自動運転テストシナリオは、[自然運転シナリオ] [危険労働条件シナリオ] [標準規制シナリオ] [パラメータ再編シナリオ]: 自然運転シナリオの 4 つの主要カテゴリに分類できます。自然な運転状態は、自動運転テスト シナリオを構築する際の最も基本的なデータ ソースであり、危険な労働条件シナリオには主に、多数の厳しい気象環境、複雑な道路交通、および典型的な交通事故が含まれます。 CIDASデータベース、自動運転の有効性を検証するために標準的な規制シナリオが使用される 基本的なテストシナリオは、自動運転車が持つべき基本的な機能をテストすることを目的として、既存の規格と評価手順を通じてテストシナリオを構築することである、パラメータの再編成シナリオとは、既存のシミュレーション シナリオをパラメータ化して完成させることです。シミュレーション シナリオのランダム生成または自動再構成には、無制限、スケーラビリティ、バッチ処理、および自動化という特徴があります。

シーンライブラリの構築プロセスは大きく分けて、実際の道路データや規制データなどの【データ収集】と、データから特徴を抽出して組み合わせる【データ加工】に分かれます。シナリオと [アプリケーション データ] を形成するため: シナリオ ライブラリのテストとフィードバック。

現時点では、自然な運転シーンの生成は基本的に自動化できます。収集車両は特定の形式に従ってデータを収集し、アルゴリズムは有用と思われる主要な断片のデータをフィルタリングし、アルゴリズムは車両の走行距離を計算します。フラグメント データの軌跡内の他の周囲の車両やその他の車両の軌跡を取得し、その軌跡を OpenScenario 形式のシーン ファイルなどのシーン記述ファイルに書き込みます。多くの既存のシミュレーション ソフトウェアは、この方法で取得したシーン ファイルをシミュレーションに直接使用できます。なお、この場合、シミュレーションソフト上で復元されるのは実際の採掘シーンの「ロジック」のみであり、シーン参加者はシミュレーションソフトの3Dモデルライブラリにある車両モデル「ベスト」を着用しています。現実生活の演出されたシーンや行動の断片。つまり、この方法で復元されたシーンは、制御アルゴリズムのテストは確実に満たすことができますが、結局のところ、前景の車両と背景は依然として 3 次元モデルによって再生されているため、当時のセンサー感知情報を復元することはできません。シミュレーションソフトのこと。センサーの感知情報を復元したい場合は、NERF を適用できます。

それでは、どのようなシミュレーション シナリオが価値があるのでしょうか?路上試験車両によって収集された自然な走行データの復元は、実際の道路状況に最も近く、ランダム性が高いと考えられていますが、現在の路上試験では走行に追いつくには時間がかかりすぎると思いませんか?そのためには、路上試験データを処理し、交通参加者の身元を抽出し、それらを再配置して組み合わせて、実際のデータに基づいたランダムなシーンを形成する必要があります。

たとえば、Baidu の 2019 年の人気論文では、同社の AADS シミュレーション システムが紹介されています。このシステムでは、ライダーと双眼カメラを備えた車が道路をスキャンするために使用され、自動運転シミュレーションのすべての情報を収集できます。取得したフッテージを取得し、入力フッテージを背景、シーンの照明、および前景のオブジェクトに自動的に分解します。ビュー合成技術により、静止した背景上で視点を変更し、任意の視点からの実画像を生成し、異なる環境を歩く車の動きをシミュレーションできます。では、これらの再編シナリオの有効性をどのように証明するのでしょうか?論文では、仮想シーンと実際のシーンにおける知覚アルゴリズムの認識効果を比較することで評価する方法について言及されているが、測定対象物の性能を測定ツールの評価に利用することも興味深い。その後、自動運転に適用される NERF 研究の一部でも、UniSim などのこの一連のアイデアが使用されました。

個人的には、自然運転データ シミュレーション シーンがどれほど効果的であっても、それは一部のアルゴリズムのテストにのみ適していると考えています。この方法がどのように使用されるかに関係なく、周囲の物体の軌跡が記録され、車の挙動に基づいてそれらを変更する方法はありません。これは映画とゲームの違いのようなもので、映画ではシーンを再生することしかできませんが、ゲームではインタラクションによってシーンを変えることができます。

おそらく近い将来、交通流シミュレーションと実際のデータを組み合わせて、ランダム シーン生成により、実際の交通状況と一致し、車両の挙動に応じて変化するシミュレーション シーンをバッチ作成できるようになるでしょう。

2. シミュレーション開発

#先ほどお話ししたシーンライブラリは、自動運転シミュレーション用のデータを準備しているとも言えます。テストを行っている場合、シミュレーション開発作業はツールを作成または改善することです。

シミュレーション開発には、おそらく次の側面が含まれます:

- [シナリオ ライブラリ]: 以前に何度も述べましたが、データ処理、深層学習、データベースなどの技術的な内容が含まれます

- [知覚]: シミュレーション環境では、環境情報をアルゴリズムに渡す必要があるため、カメラ、ライダー、ミリ波レーダー、超音波レーダーなどのさまざまなセンサー モデルを確立する必要があります。必要に応じて物理原理レベルのモデルや理想モデルを確立する必要がある。センサー モデリングで適切な作業を行うには、センサーの動作原理に関する理論的研究、コンピューター モデリングと物理プロセスのエンジニアリング実装機能、および大量の実験データのサポートが必要です。

- [車両ダイナミクス]: アルゴリズムによって出力される制御コマンドには制御オブジェクトが必要であるため、車両ダイナミクス モデルが必要です。これはほぼ別の主題です。ダイナミクス モデルを研究して使用する専門のエンジニアが存在します。自動運転シミュレーションでは、プロのダイナミクス モデルにアクセスするか、モデルを簡素化できる必要があります。

- [ミドルウェア]:アルゴリズムとシミュレーションプラットフォーム間、および機能の異なるシミュレーションプラットフォーム間での情報交換が必要となるため、大量のインターフェース開発が必要となります。自動運転の研究段階でより一般的に使用されるミドルウェアは ROS であり、応用段階でより一般的に使用されるミドルウェアは AUTOSAR ベースのミドルウェアです。

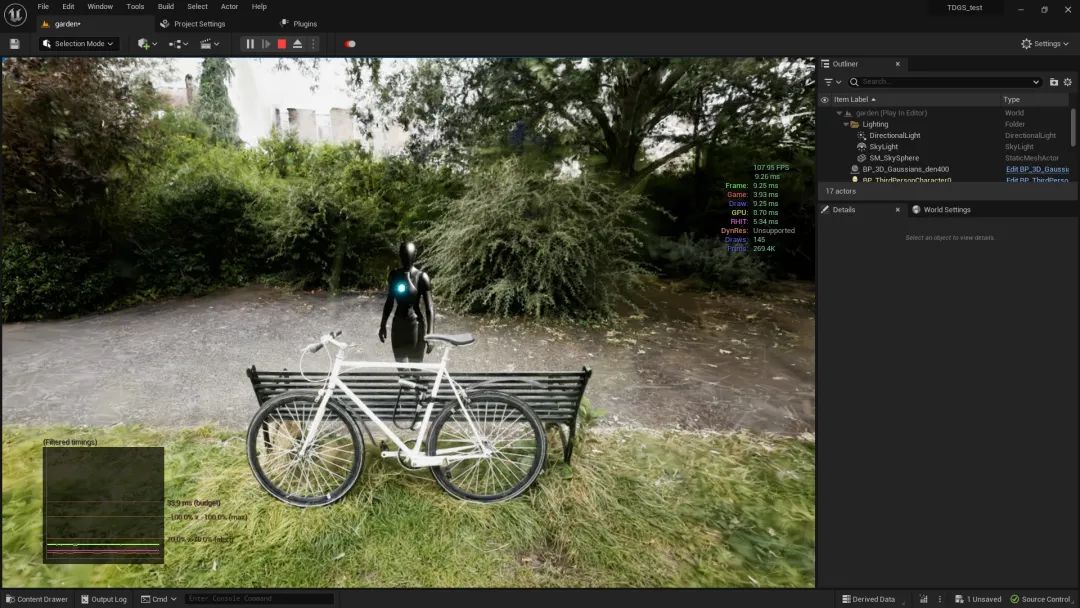

- [シミュレーション エンジン]: 一部の企業は自社開発のシミュレーション プラットフォームの開発を好むため、物理エンジンは動きと衝突を担当します。一般的に使用されるオープンソースのものは ODE、Bullet、DART などです。 3D表示を担うレンダリングエンジン OGRE、OpenGLなどのオープンソース。 Unreal と Unity は、物理学とレンダリングの両方でゲームの作成に一般的に使用される 2 つのエンジン セットです。

- [シミュレーションの高速化]: 並列コンピューティング、クラウド コンピューティングなどが含まれます。自動テストもここに含めることができます。

- [フロントエンド]: シミュレーションのダイナミクスにはディスプレイのインタラクションなどが必要になる場合があるため、多くのシミュレーション開発職が実際にフロントエンドを募集しているようです。

最後に、より高度な要件を持つ 8 番目のポイントがあると思います。それは、「どこもクリックしない」機能です。自動運転機能フレームワークの一部についてはどうですか?オープンソースのアルゴリズムを使用して残りを埋め、「閉ループ」を実行させることはできますか?

3. シミュレーション テスト

自動運転シミュレーション テストに必要なデータとツールが揃ったら、次のステップはシミュレーション テストです。今日は主に、いくつかの一般的なシミュレーション テスト リンクを紹介します。

- [MIL モデルインザループ]: 正直に言うと、モデルインザループとソフトウェアインザループの違いはよくわかりません (おそらくMBSE 手法の台頭と関連しています)。狭義には、モデルインザループは、実際のコードを作成してコンパイルする前に、MATLAB などのツールを使用してアルゴリズムの論理機能を検証するテストです。端的に言えば、simulinkモデルを使ってアルゴリズムを実装し、シミュレーションを行うことです。

- [SIL ソフトウェアインザループ]: テストには実際にコンパイルされたコード ソフトウェアを使用します。モデルインザループ テストに合格したのは当然です。SIL は問題があるかどうかのみ検出します。コード制作において。 HIL と同様に、SIL は、テスト対象オブジェクトのテスト対象機能に関係のない一連の動作環境およびその他の仮想化前の信号を提供する必要があります。

- [ループ内の HIL ハードウェア]: 大まかに言えば、ハードウェアをループ内でテストするあらゆる方法を HIL と呼ぶことができるため、特定のセンサーをテストすることも HIL テストと呼ぶことができます。狭義には、一般に、リアルタイムコンピュータを使用して制御対象の動作状態をシミュレートするシミュレーションモデルを実行し、I を通じてテスト対象の ECU に接続するコントローラのハードウェアインザループを指します。 /O インターフェイスを備え、テスト対象の ECU を総合的かつ包括的に監視し、システム テストを実行します。 HIL をはじめとするシミュレーション テストには、強力なリアルタイム パフォーマンスが要求されます。

- [VIL Vehicle-in-the-Loop]: Vehicle-in-the-Loopには大きく2つの方法があると理解しています。1つは、自動運転システムを搭載した車両をテストベンチに設置する方法です。 、車輪を取り外し、それらを模擬負荷の抗力に置き換えます モーターと、地形と路面によって車両に与えられるインセンティブは、テストベンチを通じてシミュレートされます。このようにして、優れた表示システムが追加されると、ドライバーインザループ シミュレーション システムとしても使用できます。もう 1 つは、車両をオープン スペースで運転できることです。現場で運転する場合、シミュレーション システムはセンサー入力を提供するため、車両が危険な場所にある場合でも、何もないフィールドでは、アルゴリズムは周囲にさまざまなシーンがあるとみなします。一般に、車両の GPS を使用して、位置と姿勢のフィードバックをシミュレーション システムに提供できます。

4. 日々の仕事

これまでのセクションで多くのことを述べてきましたが、それらはすべて私たちの業界の一般的な紹介であり、それらはすべて理解されています。象さん、このセクションでは私たちが日常的に行っていることについてお話します。これらの日常的なタスクは、もちろん 2 番目と 3 番目のセクションに含まれています:

- [知覚]: センサー モデルの構築は不可欠であり、各センサーの検出距離、検出角度範囲、解像度、歪みパラメーター、ノイズ パラメーターなどの一連のパラメーターに注意を払う必要があります。設置場所などのほか、ハードウェアの通信プロトコルなどもあります。次に、使用するシミュレーション ソフトウェア ツールに応じて、既存のタイプのセンサーを「構成」するか、シミュレーション ソフトウェアに基づいて新しいタイプのセンサーを開発するかが決まります。アルゴリズム モデルをトレーニングまたは評価するために、シミュレーションは多くの場合、2D/3D 境界ボックス、車線およびその他の地図情報、2D/3D 占有グリッドなどの真の値を提供する必要があります。シミュレーション ソフトウェアの既存の機能が満たせない場合は、要件に応じて、エンジニアが二次開発を行うことも必要です。

- [車両ダイナミクス]: 車両パラメータに従って、専門的なダイナミクス シミュレーション ソフトウェアで車両モデルを構成する必要があります。また、簡略化された数式に基づいて、簡略化された運動学およびダイナミクス モデルを直接作成できることも必要です。

- [ミドルウェア]: インターフェイスの開発は作業の重要な部分です。インターフェイスの開発は、テスト対象のオブジェクトとシミュレーション ソフトウェア間の「変換」を担当します。もう 1 つは、インターフェイスの API インターフェイスを使用することです。異なるレベルのシミュレーション プラットフォーム間の通信を実現するソフトウェアで、車両ダイナミクス シミュレーションと組み合わせたシーン シミュレーションや交通流シミュレーションなどの共同シミュレーションが、自動テスト管理ソフトウェアのスケジューリングに統合されます。

- [シミュレーション アクセラレーション]: 7x24 時間の中断のないテストを達成できれば、効率を向上させる方法でもあるため、私は自動テストもシミュレーション アクセラレーションに取り入れました。これには、シミュレーション プラットフォームの自動呼び出し、自動スクリプト作成、データの記録、ユースケースの要件に従ったデータの評価が含まれます。

- [ソフトウェア開発]: 自社開発のシミュレーション ソフトウェアを必要とする企業が主にこのビジネスを行っています。

もう 1 つのポイント 6. [要件分析]: シミュレーション開発エンジニアとして、あなたは自分が使用するツールを最もよく知っている人でなければなりません。そのため、顧客 (社内および社外の両方) が新しいニーズを持ったら、シミュレーション開発エンジニアは、技術的ソリューションを設計し、ニーズとテスト対象の特定の条件に基づいてソフトウェアとハードウェアの要件とプロジェクト計画を提案できなければなりません。そのため、場合によっては、製品管理作業とプロジェクト管理作業の両方を行う必要があります。

5. テクノロジー スタック

「テクノロジー スタック」という言葉は非常に異質に聞こえますが、実際にはこの位置をマスターする必要があります。何かを注文してください。昔、あるテレビシリーズを見たのですが、その中で救急科の医師が「私たちはヘビ油のようなもので、他の外科医は決して変わることができないのです」と自嘲していました。私は常々、シミュレーションエンジニアは病院の救急医のようなものだと思っていて、どのようなアルゴリズムをテストするのか、ナビゲーションや位置決め、制御計画、データ処理、パラメータの校正など、このアルゴリズム以外のすべてを準備する必要があることをすべて知っている必要があります。天文学と地理、医療占い、占星術、金彩画、グループと柳の判断...詳しい説明を求める必要はなく、アルゴリズムテストのニーズに迅速に応えることが最も重要です。

このいわゆる「全体像」はシミュレーション エンジニアの利点ですが、アルゴリズムを真に理解してのみ、真に改善に役立つシミュレーション作業を行うことができます。そうして初めて、さらに先に進むことができます。行き過ぎたので撤回します:

- [コード]: 主に C/Python ですが、フロントエンドの表示部分が関係する場合は使用しません。それを理解します。一般的に言えば、アルゴリズム開発ほど要件は高くありませんが、シミュレーション ソフトウェア開発を専門とする場合は別問題です。

- [ROS]: ROS は依然として自動運転とロボット アルゴリズム研究の分野で避けられない部分であり、ROS コミュニティは多くの既成ツールを提供しているため、これを取り上げました。

- [車両ダイナミクス]: 実際の車両エンジニアほど多くのことを知る必要はないかもしれませんが、基本原則を知っておく必要があります。さらに、さまざまな座標変換 (これには車両が含まれない場合もありますが、数学も含まれます) に習熟している必要があります。

- [センサー原理]: 自動運転車に搭載されたカメラ、ライダー、ミリ波レーダーなどのさまざまなセンサーはどのように機能するのか、出力信号はどのようなものなのか、重要なパラメーターは何なのか。

- [マップ]: センサー シミュレーションの入力として情報を抽出する必要がある場合があるため、opendrive や openscenario などのシミュレーション テスト シナリオで使用されるファイル形式を理解する必要があります。

上記は単なる私の個人的な要約です。同僚の方はここに追加してください。

記事の完成度を高めるため、このセクションでは、市販されている一般的に使用されているシミュレーション ソフトウェアについても簡単に紹介します (広告ではありません。そのようなソフトウェアは使用しないでください)。リストには載っていません)ご遠慮ください)。

- CarSim/CarMaker: これらのソフトウェアは両方とも強力なダイナミクス シミュレーション ソフトウェアであり、世界中の OEM やサプライヤーによって広く使用されており、一部の道路シーンをシミュレートすることもできます。

- Vissim/SUMO: Vissim は、ドイツの PTV 会社が提供する世界をリードする微細交通流シミュレーション ソフトウェアです。 Vissim はさまざまな複雑な交通環境を簡単に構築でき、シミュレーション シーンで自動車、トラック、鉄道交通機関、歩行者のインタラクティブな動作をシミュレートすることもできます。 SUMOは、インタラクティブな編集により、道路の追加、車線の接続関係の編集、交差点領域の処理、信号機のタイミングの編集などができるオープンソースソフトウェアです。

- PreScan: Siemens が買収した、アルゴリズムの作成とテストのための主なインターフェイスには、MIL、SIL、HIL に使用できる MATLAB と Simulink が含まれます。

- VTD: 商用ソフトウェアとして、VTD は強力な信頼性と包括的な機能を備えており、道路環境モデリング、交通シーン モデリング、気象および環境シミュレーション、シンプルで物理的に現実的なセンサー シミュレーション、シーン シミュレーション管理、高レベルの正確性をカバーします。 VTDは国内OEMメーカーで最も多く使われているシミュレーションソフトと言っても過言ではありません。 SIL から HIL、VIL までのフルサイクルの開発プロセスをサポートでき、オープン モジュラー フレームワークによりサードパーティのツールやプラグインと簡単に共同シミュレーションできます。

- CARLA/AirSim: 2 つのオープン ソース シミュレーション プラットフォームは、どちらも UE に基づいて開発されており、Unity バージョンもリリースされました。 CARLA は、シーンの生成と高精度マップのサポート、センサーと環境の柔軟な構成をサポートし、複数のカメラ、LIDAR、GPS などのセンサーをサポートし、環境の照明や天候も調整できます。 Microsoft の AirSim には、ドローンと車両の 2 つのモードがあります。車両モードの機能は非常に貧弱です。環境や車両モデルの構築は簡単ではありません。コミュニティは CARLA ほど活発ではありません。AirSim は、将来JDを書いてくれる人募集、あまり役に立ちません。さらに、国内の Sangxin Technology は最近、CARLA に基づいて開発された OASIS を開始しました。これは、現在ではオープンソースの CARLA の強化版と見なすことができます。

- 51SimOne/PanoSim: この 2 つは国産のシミュレーション ソフトウェアであり、シーン シミュレーション ソフトウェアの主な機能を満たすことができます。

最後に、もう 1 つの lgsvl: 本来、lgsvl の利点は Apollo との統合がより優れていることですが、公式の lgsvl はそれを放棄したと聞きました。このプロジェクトでは、この罠を放棄することをお勧めします。

6. 学習パス

最初の 5 つのセクションでの私の紹介を通じて、賢い学生は自動運転シミュレーション エンジニアになるための学習プロセスをすでに体験できると思います。私の最初の 5 つのセクションの内容を批判することで、若い同僚はすでに前進する道を描くことができます。しかし、このセクションでは、この点に関する表面的な理解をまだ書き留めておきます。

これまで何度も述べてきましたが、自動運転のシミュレーションは、コンピューター/制御/ロボット工学など、さまざまな専攻の学生を受け入れることができる学際的な分野であることが誰でもわかると思います。機械/車両/パワーエレクトロニクス等

経験とテクノロジーの観点から、仕事の要件をいくつか挙げてみましょう:

- コーディング能力: シミュレーション クラウド コンピューティング、クラウド サーバー、およびその他の関連開発を行う学生は、開発に C/Go/Java を使用することに熟練し、プログラミングの習慣を身につけ、一般的な設計パターンを習得する必要がある場合があります。 Linuxシステム、Docker技術、Kubernetes関連知識に精通した構造とアルゴリズム、クラウドサービス開発の経験を有し、高並列性、高再利用性、高自動化を備えた自社開発のシミュレーションテストプラットフォームを目指しています。また、自社開発のシミュレーションソフトウェアのポジションでは、しっかりとしたコンピュータの基礎に加えて、ゲームエンジンの開発経験が求められる場合もあるため、ゲーム開発に携わる学生が自動運転シミュレーション(テクニカルアートを含む)に転向することも可能です。二次開発と統合に既存のシミュレーション ソフトウェアを使用することを目標とする学生は、C/C と Python に習熟し、Linux/ROS 開発に精通している必要があるかもしれません。自動車グレードのミドルウェアの開発経験があればより良いでしょう。 AUTOSAR など。

- ソフトウェア経験: もちろん、自動運転シミュレーション ソフトウェアの実際の使用経験があればプラスとなりますが、商用ソフトウェアの多くは非常に高価であるため、この点に関しては学校の研究室や企業の力に大きく依存します。 。商用ソフトウェアのサポートがない現在、CARLA はオープンソース ソフトウェアの最適なソリューションであると思います。

- 現場の知識: 私は個人的に、自動運転シミュレーション エンジニアとして、アルゴリズムの原理実装のあらゆる側面を含め、自動運転アルゴリズムを深く理解することは不可能であると信じています。アルゴリズムを理解する アルゴリズムをよりよく理解できますか? シミュレーションをうまくやってください。さらに、コンピュータを専攻していない学生の場合は、機械、車両、機械、電子など、この分野の専門コースをよく学ぶことも非常に重要です。素晴らしいし、これからも使われます。

現在の自動運転業界は大きな変動を経験していますが、まとめると、シミュレーションエンジニアを活用できる主な企業のタイプは次のとおりです。アプリケーションモールディングシミュレーションソフトウェアを主に統合するOEM、しかし、新興勢力 基本的には自社で研究する必要がある; 自動運転ソリューションプロバイダー、つまりアルゴリズムの Tier 1 もほとんどが自社で研究とシミュレーションを行う可能性がある; シミュレーションソフトウェア会社は中国でこの分野でスタートしたばかりであり、彼らは基本的にはスタートアップです。

このセクションの最後に、従来の機械から「切り替え」た私の経験についてお話します。私が修士号を取得して卒業した学校はトランスコーディングの文化が強く、私のクラスの機械系大学院に入学した中国人学生は10人中78人ほどが卒業後コンピュータ業界に従事していました。比較的緩やかなコース選択制度のため、学生はコンピュータサイエンス学部のコースをできるだけ多く履修することが推奨されます。そのため、その2年間は日時計を維持するために塗油が燃やされ、貧困が常態化していました。しかし、仕事を見つけるために試験に合格する必要があったのかどうかは覚えていません。一言で言えば、機械はどのようにしてコンピューターに変化するのでしょうか。コンピューター サイエンスの学位を半分取得してください。実際、当時は機械学だけでなくすべての専攻が変わりつつあり、中国人学生だけでなく世界中の人が参加していました。

しかし、後から考えると、自分は同じ状況ではなかったので、変革の最良の機会を逃してしまったことに気づきました。独学となると、さらに難しくなります。最も重要なことは、時間がないことです。そのためには、効率的な学習教材と学習方法が必要です。そのため、相対的に言えばオンライン授業の方が指導してくれる先生がいる分効率的です。 Courseraのコースは良いのですが、比較的高価なようです。近年、オープンソースのネットワークリソースが増えてきましたが、受講するコースはあまり洗練されておらず、結局のところコンピュータが最も実用的で実践しやすいと言えます。データ構造やアルゴリズム、Cの入門書など、コンピュータの古典的な本もたくさんありますが、どれも読んだことがありません。

実のところ、変革するための最も簡単な方法の 1 つは、コンピュータ関連の仕事に直接従事することだと思います。需要を増やす最も早い方法は、上で述べた学習の方向性と時間の問題を解決することです。ただし、これによってパフォーマンスが標準以下になるという問題がある場合は、それについては何も言わなかったことにしてください。

7. NERF について

NERF には、「データ閉ループ」、「大規模モデル」、「エンドツー」が伴います。これらの新しいバズワードは共に、自動運転の分野で「波を起こしています」。わずか数年で、NERF はデビュー当時の単純な MLP ボリューム レンダリングではなくなりました。空間情報を保存するためのさまざまなキャリアがあります: ハッシュ テーブル、ボクセル グリッド、多次元ガウス関数... 新しいイメージング手法も登場しています。 U-net、CNN、ラスタライゼーション...自動運転の方向性は、NERF の小さな応用分野にすぎません。

NERF を自動運転シミュレーションの方向に適用すると、主に次のような問題に直面します。

自動運転データの収集方法により、シーンの範囲が「閉じられていない」ことになります。 : 屋外シーンには多数の遠景が含まれます。これは NERF の空間情報ストレージにとって大きな課題です。自動運転シーンには多数の動的オブジェクトが含まれており、NERF は動的オブジェクトと静的オブジェクトの分離を処理できる必要があります ( NERF モデルには一般に移行機能がなく、各シーンは個別の NERF モデルをトレーニングする必要がありますが、NERF のトレーニングはまだ比較的時間がかかるため、自動運転データに対する NERF の大規模な適用は困難です。まだ問題はあるだろう。

しかし、私は依然として NERF が自動運転シミュレーションに破壊的な開発をもたらし、最終的にはシミュレーションの知覚アルゴリズムにおけるドメイン ギャップを解消し、さらにはそれ以上のことを実現することを期待しており、同時に信じています。私が学んだ情報から判断すると、NERF は少なくとも次のブレークスルーをもたらすでしょう:

NERF の新しい透視画像合成機能は、知覚アルゴリズムのトレーニング データセットを強化できます。新しいセンサーの内部パラメーター (変更と同等) を生成できます。センサー構成)、外部パラメーター(修正された自車軌道)、写真、LIDAR 点群およびその他のデータを使用して、知覚アルゴリズムのトレーニング データをさらに提供します。この点に関しては、StreetSurf や UniSim などの研究を参照できます。動的オブジェクトが編集可能になると、将来的に NERF は、単純なドライブ テストや WorldSim の欠点を補うために、対象を絞った極端な状況やランダムな状況のシナリオを生成できるようになります。 NERF がトレーニングの再構築と都市レベルのシーンのリアルタイム レンダリングを同時に効果的に解決できれば、データ ドメイン ギャップのセンシングの問題なしに、NERF を XIL インザループ シミュレーション テストのプラットフォームとして完全に使用できます。また、エンドツーエンドのアルゴリズムの開発も促進されます。さらに、NERF のモデルはプラグインとしてゲーム エンジンに組み込むこともできるため (たとえば、3D ガウス スプラッティング用の UE プラグインがリリースされています)、NERF のストリート シーンの再構築をオリジナルの WorldSim システムに組み込むことができます。 。 AIGC 方向の大規模モデルと組み合わせると、NERF は新しいシーンを生成する可能性が高まり、照明、天候、オブジェクトの外観や動作などを任意に編集できるようになります。

したがって、シミュレーション エンジニアとして、私は同僚に NERF の進歩に細心の注意を払うことを強くお勧めします。さまざまな NERF 研究プロジェクトはまだ初期段階にありますが、ディープ ラーニングの進歩はハードウェアによって加速されています。 。

8. 最後に書きました

ここまで雑多に書きましたが、最後に少し思うことがあります。

シミュレーション開発の落とし穴は何ですか?技術的な落とし穴についてはここでは説明しませんが、全体的な考えをいくつか示します。それは、意味のない仕事に関わりすぎていないか注意することです。さまざまな人のために同様のプロジェクトを行うことはカウントされず、各プロジェクトを完了することが価値があるのです。既製のツールを使用せず、自分で研究しなければならない場合は、計算上、特定のツールへの依存から脱却することは価値があり、研究開発での多くの試みが後に不合理であることが判明したことは数え切れませんし、研究開発の失敗もまた価値があります。では、「意味のない」仕事とは一体何でしょうか?これは意見の問題であり、うまく要約することはできません。

この立場で他に何ができるでしょうか?仕事で計測対象についての理解が深まれば、ある方向性のアルゴリズム開発職への転向も考えられますし、ロボットやドローンのシミュレーション開発を検討することも可能です。

移動ロボットと自動運転の類似点は言うまでもありませんが、ここではドローンについて触れてみましょう。ドローン業界は確かに自動車業界ほど大きくありませんが、検査、航空写真、測量、地図作成などの着陸地点がすでに存在します。また、UAV には障害物回避や経路計画などの自動制御アルゴリズムも必要であり、UAV が使用するセンサーも無人車両と類似しているため、シミュレーション テストには、UAV にも豊かな視覚が必要であるという共通点があると言えます。画像やレーダー点群などの入力には、より洗練された動的モデルなどが必要です。

ロボットやドローンのシミュレーションについて学ぶことに興味のある学生は、Nvidia の Isaac ほど多くのコンピューティング リソースを必要としない、オープンソース シミュレーション プラットフォーム Gazebo (https://classic.gazebosim.org/) から始めることができます。とても背が高いです。

OSRF は Willow Garage から独立して今年で 11 年目となり、ロボット OS である ROS と Gazebo は 20 年以上の開発の歴史があります。 Gazebo は、大学院研究グループの科学研究ツールから独立したシミュレーション ソフトウェア ツールへと徐々に発展し、現在 11 リリース、第 2 世代点火では 7 リリースをリリースしています。

Gazebo は、ODE、Bullet などの物理エンジンをサポートしており、OGRE をレンダリング エンジンとして使用して、3 次元環境を作成し、カメラやセンサーなどのさまざまなセンサーからの情報をシミュレートできます。ロボット アームから車輪付きロボット、人型ロボットまで、豊富なロボット モデルを備えています。さらに重要なのは、Gazebo は当然、ROS プラットフォームでのアルゴリズムの包括的なサポートを提供します。結局のところ、デスクトップの完全な ROS バージョンをダウンロードしてインストールすると、Gazebo が付属します。もちろん、Gazebo はオープンソース ソフトウェアなのであくまで出発点であり、機能はバランスが取れていますが、すべての面で荒削りで奥が足りません。しかし、Taizu Changquanと同じように、Qiao FengがJuxian Villageでそれを使用すると、やはり異なります。

私は学生時代に Gazebo に出会い、その後ロボット シミュレーションの仕事に携わり、自動運転にキャリアを変えるまで Gazebo を使用していました。 Gazebo と私は同級生のようなもので、当時は若くて無知でした。仕事を終えて、私と彼女は再会し、関係を新たにすることにしました。2年以上、離れられなくなってしまいました。30歳を超えた今、私は彼女にメッセージを残しました。彼女とは別れます...さよならを言うときに私が言うのはただ一つです:お久しぶりです...

元のリンク: https://mp.weixin.qq.com/s/_bOe_g3mqoobJUbFS3SNWg

以上が自動運転シミュレーションの壮大な世界観!自動運転シミュレーション業界について語ろう!の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7569

7569

15

15

1386

1386

52

52

87

87

11

11

28

28

107

107

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

上記と著者の個人的な理解 3 次元ガウシアンプラッティング (3DGS) は、近年、明示的な放射線フィールドとコンピューター グラフィックスの分野で出現した革新的なテクノロジーです。この革新的な方法は、数百万の 3D ガウスを使用することを特徴とし、主に暗黙的な座標ベースのモデルを使用して空間座標をピクセル値にマッピングする神経放射線場 (NeRF) 方法とは大きく異なります。明示的なシーン表現と微分可能なレンダリング アルゴリズムにより、3DGS はリアルタイム レンダリング機能を保証するだけでなく、前例のないレベルの制御とシーン編集も導入します。これにより、3DGS は、次世代の 3D 再構築と表現にとって大きな変革をもたらす可能性のあるものとして位置付けられます。この目的を達成するために、私たちは 3DGS 分野における最新の開発と懸念について初めて体系的な概要を提供します。

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

昨日の面接で、ロングテール関連の質問をしたかと聞かれたので、簡単にまとめてみようと思いました。自動運転のロングテール問題とは、自動運転車におけるエッジケース、つまり発生確率が低い考えられるシナリオを指します。認識されているロングテール問題は、現在、単一車両のインテリジェント自動運転車の運用設計領域を制限している主な理由の 1 つです。自動運転の基礎となるアーキテクチャとほとんどの技術的問題は解決されており、残りの 5% のロングテール問題が徐々に自動運転の開発を制限する鍵となってきています。これらの問題には、さまざまな断片的なシナリオ、極端な状況、予測不可能な人間の行動が含まれます。自動運転におけるエッジ シナリオの「ロング テール」とは、自動運転車 (AV) におけるエッジ ケースを指します。エッジ ケースは、発生確率が低い可能性のあるシナリオです。これらの珍しい出来事

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

0.前面に書かれています&& 自動運転システムは、さまざまなセンサー (カメラ、ライダー、レーダーなど) を使用して周囲の環境を認識し、アルゴリズムとモデルを使用することにより、高度な知覚、意思決定、および制御テクノロジーに依存しているという個人的な理解リアルタイムの分析と意思決定に。これにより、車両は道路標識の認識、他の車両の検出と追跡、歩行者の行動の予測などを行うことで、安全な運行と複雑な交通環境への適応が可能となり、現在広く注目を集めており、将来の交通分野における重要な開発分野と考えられています。 。 1つ。しかし、自動運転を難しくしているのは、周囲で何が起こっているかを車に理解させる方法を見つけることです。これには、自動運転システムの 3 次元物体検出アルゴリズムが、周囲環境にある物体 (位置を含む) を正確に認識し、記述することができる必要があります。

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

原題: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving 論文リンク: https://arxiv.org/pdf/2402.02519.pdf コードリンク: https://github.com/HKUST-Aerial-Robotics/SIMPL 著者単位: 香港科学大学DJI 論文のアイデア: この論文は、自動運転車向けのシンプルで効率的な動作予測ベースライン (SIMPL) を提案しています。従来のエージェントセントとの比較

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

この 1 か月間、いくつかのよく知られた理由により、私は業界のさまざまな教師やクラスメートと非常に集中的な交流をしてきました。この交換で避けられない話題は当然、エンドツーエンドと人気の Tesla FSDV12 です。この機会に、現時点での私の考えや意見を整理し、皆様のご参考とご議論に役立てたいと思います。エンドツーエンドの自動運転システムをどのように定義するか、またエンドツーエンドで解決することが期待される問題は何でしょうか?最も伝統的な定義によれば、エンドツーエンド システムとは、センサーから生の情報を入力し、関心のある変数をタスクに直接出力するシステムを指します。たとえば、画像認識では、従来の特徴抽出 + 分類子方式と比較して、CNN はエンドツーエンドと言えます。自動運転タスクでは、各種センサー(カメラ/LiDAR)からのデータを入力

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

先頭と開始点に書かれている エンドツーエンドのパラダイムでは、統一されたフレームワークを使用して自動運転システムのマルチタスクを実現します。このパラダイムの単純さと明確さにも関わらず、サブタスクにおけるエンドツーエンドの自動運転手法のパフォーマンスは、依然としてシングルタスク手法に比べてはるかに遅れています。同時に、以前のエンドツーエンド手法で広く使用されていた高密度鳥瞰図 (BEV) 機能により、より多くのモダリティやタスクに拡張することが困難になります。ここでは、スパース検索中心のエンドツーエンド自動運転パラダイム (SparseAD) が提案されています。このパラダイムでは、スパース検索は、高密度の BEV 表現を使用せずに、空間、時間、タスクを含む運転シナリオ全体を完全に表します。具体的には、統合されたスパース アーキテクチャが、検出、追跡、オンライン マッピングなどのタスク認識のために設計されています。さらに、重い