4K 品質の 3D 複合ビデオがスライドショーでフリーズすることがなくなり、新しい方法によりレンダリング速度が 30 倍以上向上しました

4K 品質、60 フレームのビデオは一部のアプリの会員のみが視聴できますが、AI 研究者はすでに 4K レベルの 3D ダイナミック合成ビデオを実現しており、画像は非常に滑らかです。

#実生活で私たちが接するビデオのほとんどは 2D です。この種のビデオを見る場合、俳優の間を歩いたり、空間の隅に歩いたりするなど、見る角度を選択する方法がありません。 VR や AR デバイスの登場により、この欠点は補われ、3D ビデオによって視点が変更され、自由に動き回ることができ、没入感が大幅に向上しました。

しかし、この種の 3D ダイナミック シーンの合成は、画質と滑らかさの両方の点で常に困難でした。

最近、浙江大学、Xiangyan Technology、Ant Group の研究者らがこの問題に挑戦しました。 「4K4D: Real-Time 4D View Synthesis at 4K Resolution」というタイトルの論文で、高解像度の 3D 動的シーン合成のレンダリング速度を大幅に向上させる 4K4D と呼ばれる点群表現方法を提案しました。具体的には、RTX 4090 GPU を使用するこの方法では、4K 解像度で最大 80 FPS のフレーム レートで、1080p 解像度で最大 400 FPS のフレーム レートでレンダリングできます。全体として、以前の方法より 30 倍以上高速で、レンダリング品質は SOTA に達します。

以下は論文の紹介です。

#論文の概要

- ## 論文リンク: https://arxiv.org/pdf/2310.11448.pdf

- プロジェクトリンク: https://zju3dv.github.io/4k4d/

ダイナミック ビュー合成は、キャプチャしたビデオからダイナミック 3D シーンを再構築し、没入型の仮想リプレイを作成することを目的としています。 -コンピュータビジョンとコンピュータグラフィックスにおける研究課題。このテクノロジーの有用性の鍵となるのは、高忠実度でリアルタイムにレンダリングできることで、VR/AR、スポーツ放送、芸術的なパフォーマンスのキャプチャに使用できるようになります。従来のアプローチでは、動的な 3D シーンを一連のテクスチャ メッシュとして表現し、複雑なハードウェアを使用してそれらを再構築します。したがって、通常は制御された環境に限定されます。

最近、暗黙的ニューラル表現は、微分可能レンダリングを介して RGB ビデオから動的 3D シーンを再構築することに大きな成功を収めています。例えば、「多視点映像からのニューラル3D映像合成」では、対象シーンを動的な放射線場としてモデル化し、ボリュームレンダリングを用いて画像を合成し、入力画像と比較・最適化する。動的ビュー合成の結果は優れていますが、既存の方法では、高価なネットワーク評価のため、1080p 解像度で画像をレンダリングするのに数秒、あるいは数分かかることがよくあります。

静的ビュー合成メソッドからインスピレーションを得た一部の動的ビュー合成メソッドは、コストやネットワーク評価の数を削減することでレンダリング速度を向上させます。これらの戦略により、MLP マップは前景の動的な図形を 41.7 fps でレンダリングできます。ただし、MLP マップのリアルタイム パフォーマンスは、中程度の解像度 (384 × 512) の画像を合成する場合にのみ達成できるため、レンダリング速度の課題は残ります。 4K 解像度の画像をレンダリングすると、速度がわずか 1.3 FPS まで低下しました。

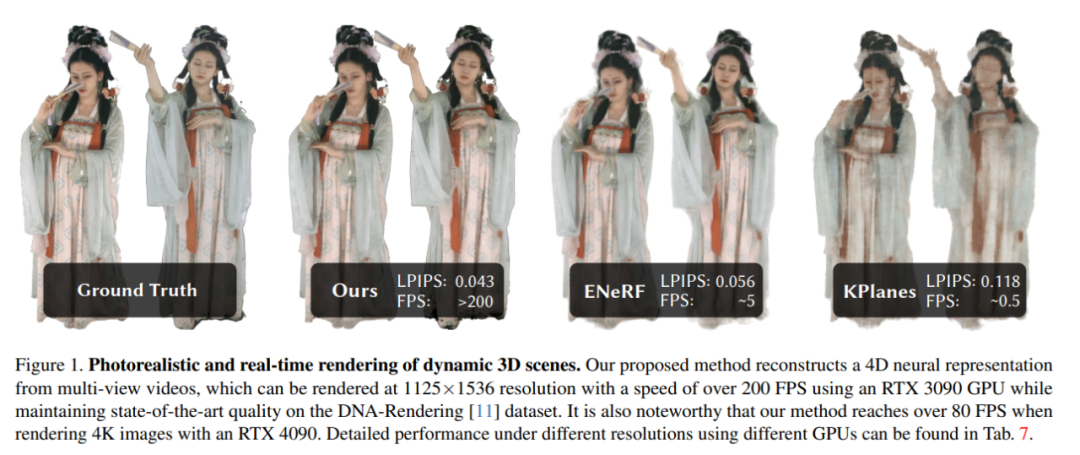

この論文では、研究者たちは、動的な 3D シーンのモデリングとレンダリングのための新しいニューラル表現である 4K4D を提案しています。図 1 に示すように、4K4D はレンダリング速度において以前の動的ビュー合成方式を大幅に上回り、レンダリング品質においても競争力があります。

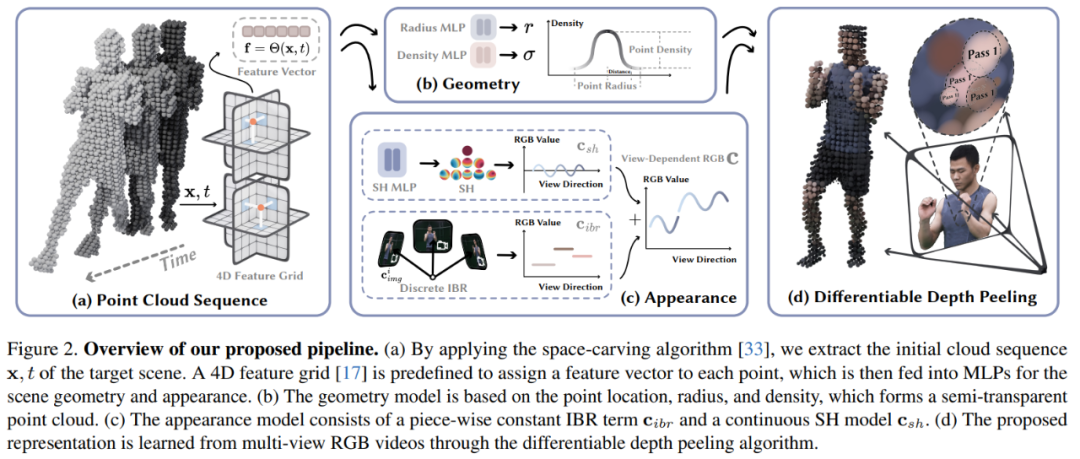

著者らは、彼らの中核となるイノベーションは 4D 点群表現とハイブリッド外観モデルにあると述べています。具体的には、動的なシーンの場合、空間彫刻アルゴリズムを使用して粗い点群シーケンスを取得し、各点の位置を学習可能なベクトルとしてモデル化します。また、各ポイントに特徴ベクトルを割り当てる 4D 特徴グリッドを導入し、それを MLP ネットワークに入力して、ポイントの半径、密度、球面調和関数 (SH) 係数を予測しました。 4D フィーチャ メッシュは点群に空間正則化を自然に適用し、最適化をより堅牢にします。研究者らは、4K4D に基づいて、ハードウェア ラスタライゼーションを使用して前例のないレンダリング速度を達成する微分可能な深度ピーリング アルゴリズムを開発しました。

研究者らは、MLP に基づく SH モデルでは動的なシーンの外観を表現することが難しいことを発見しました。この問題を軽減するために、SH モデルと組み合わせてシーンの外観を表現する画像混合モデルも導入されました。重要な設計は、画像ブレンディング ネットワークを視線方向から独立させ、トレーニング後に事前計算してレンダリング速度を向上させることができることです。諸刃の剣として、この戦略は、画像混合モデルを視線方向に沿って離散的にします。この問題は、連続 SH モデルを使用して解決できます。 SH モデルのみを使用する 3D ガウス スプラッティングと比較して、研究者が提案したハイブリッド外観モデルは、入力画像によってキャプチャされた情報を最大限に活用し、レンダリング品質を効果的に向上させます。

新しい手法の有効性を検証するために、研究者らは、NHR、ENeRF-Outdoo、DNA-Rendering、Neural3DV など、広く使用されている複数のマルチビュー動的新しいビュー合成データセットで 4K4D を評価しました。 。広範な実験により、4K4D はレンダリング速度が桁違いに速いだけでなく、レンダリング品質の点でも SOTA テクノロジーよりも大幅に優れていることがわかりました。 RTX 4090 GPU を使用するこの新しい方法では、1080p 解像度の DNA レンダリング データセットで 400 FPS、4k 解像度の ENeRF-Outdoor データセットで 80 FPS を達成します。

方法の紹介

ダイナミック 3D シーンをキャプチャするマルチビュー ビデオを考慮して、この論文はターゲット シーンを再構成し、ビュー合成を実行することを目的としています。リアルタイムで。モデル アーキテクチャ図を図 2 に示します:

次に、この記事では、点群を使用して動的シーンをモデル化するための関連知識を紹介します。 4Dエンベディング、幾何モデルと外観モデルを他の角度から拡張します。

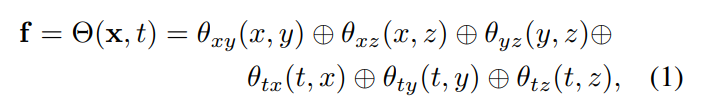

4D 埋め込み: ターゲット シーンの粗い点群が与えられた場合、この論文ではニューラル ネットワークとフィーチャ メッシュを使用して、その動的なジオメトリと外観を表現します。具体的には、この記事ではまず 6 つの特徴面 θ_xy、θ_xz、θ_yz、θ_tx、θ_ty、θ_tz を定義し、K-Planes 戦略を使用してこれらの 6 つの面を使用して 4D 特徴フィールド Θ(x, t) をモデル化します。

外観モデル: 図 2c に示すように、この記事では、画像ブレンディング テクノロジと球面調和関数 (SH) モデルを使用してハイブリッド外観モデルを構築します。画像ブレンディング テクノロジは離散的な外観モデルを表します。ビューの外観 c_ibr、SH モデルは、連続的なビュー依存の外観 c_sh を表します。 t 番目のフレームの点 x について、ビュー方向 d の色は次のようになります。

#微分可能深さピーリング

#この記事で提案する動的なシーン表現は、デプス ピーリング アルゴリズムを利用して画像にレンダリングできます。研究者らは、K レンダリング パスで構成されるデプス ピーリング アルゴリズムを実装するカスタム シェーダーを開発しました。つまり、研究者は特定のピクセル u に対して多段階の処理を実行し、K 回のレンダリングの後、最終的にピクセル u は分類点のセット {x_k|k = 1, ..., K} を取得しました。

#これらの点 {x_k|k = 1, ..., K} に基づいて、ボリューム レンダリングにおけるピクセル u の色は次のように表されます。

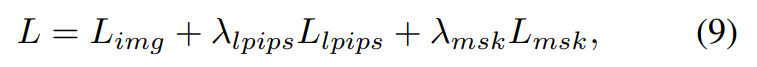

トレーニング プロセス中に、レンダリングされたピクセルの色 C (u) が与えられた場合、この論文ではそれを実際のピクセルの色 C_gt (u) と比較し、次の損失関数を使用してエンドツーエンドでモデルを最適化します。終了方法:

さらに、この記事では知覚損失も適用されます:

そしてマスク損失:

最終的な損失関数は次のように定義されます:

実験と結果

この論文では、DNA レンダリング、ENeRF-Outdoor、NHR、および Neural3DV データセットに対する 4K4D 手法を評価します。

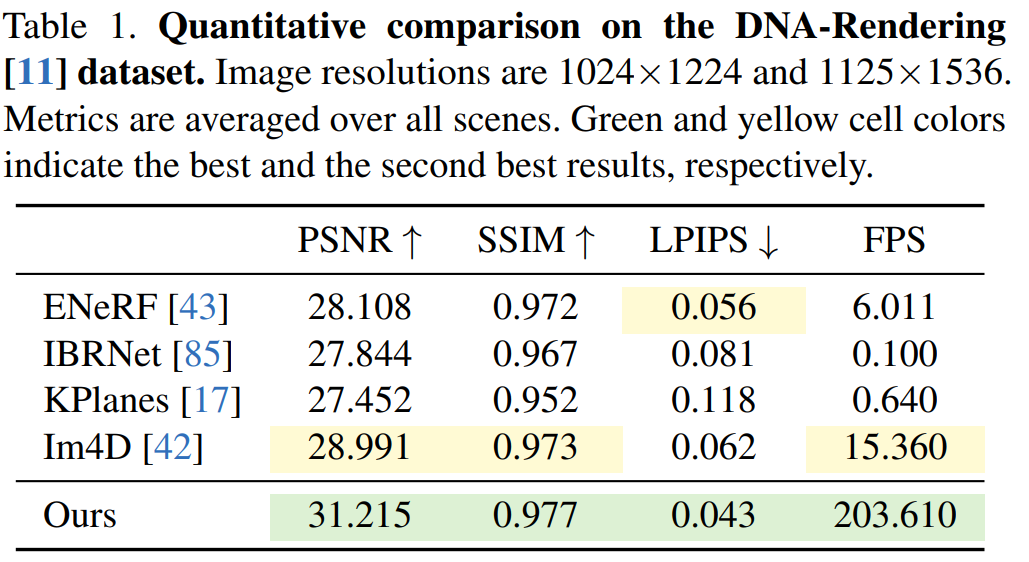

DNA レンダリング データセットの結果を表 1 に示します。結果は、4K4D レンダリング速度が SOTA パフォーマンスを備えた ENeRF よりも 30 倍以上高速であり、レンダリングが高速であることを示しています。品質が良くなります。

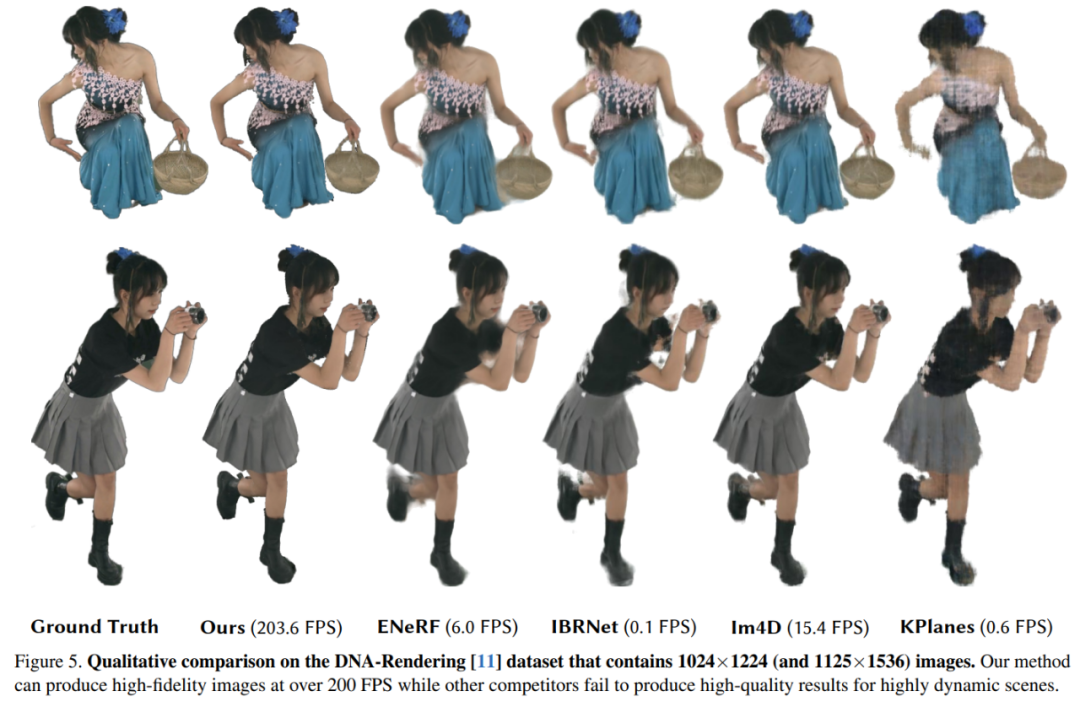

DNA レンダリング データセットの定性的な結果を図 5 に示します。KPlanes は 4D 動的シーンの詳細な外観とジオメトリを処理できません。一方、他の画像ベースの方法では高品質の外観が得られます。ただし、これらの方法ではオクルージョンやエッジの周囲でぼやけた結果が生成される傾向があり、その結果、視覚的な品質が低下します。一方、4K4D は 200 FPS 以上でより忠実度の高いレンダリングを生成できます。

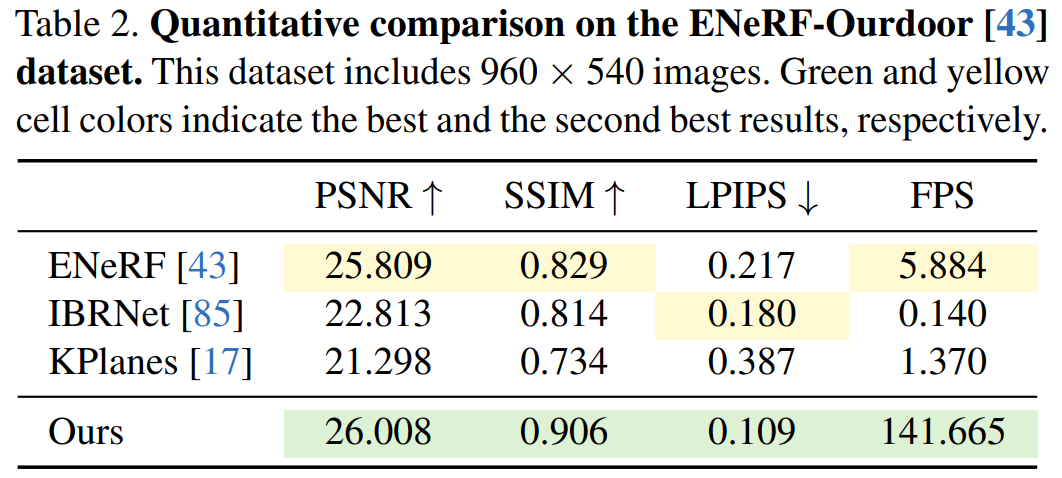

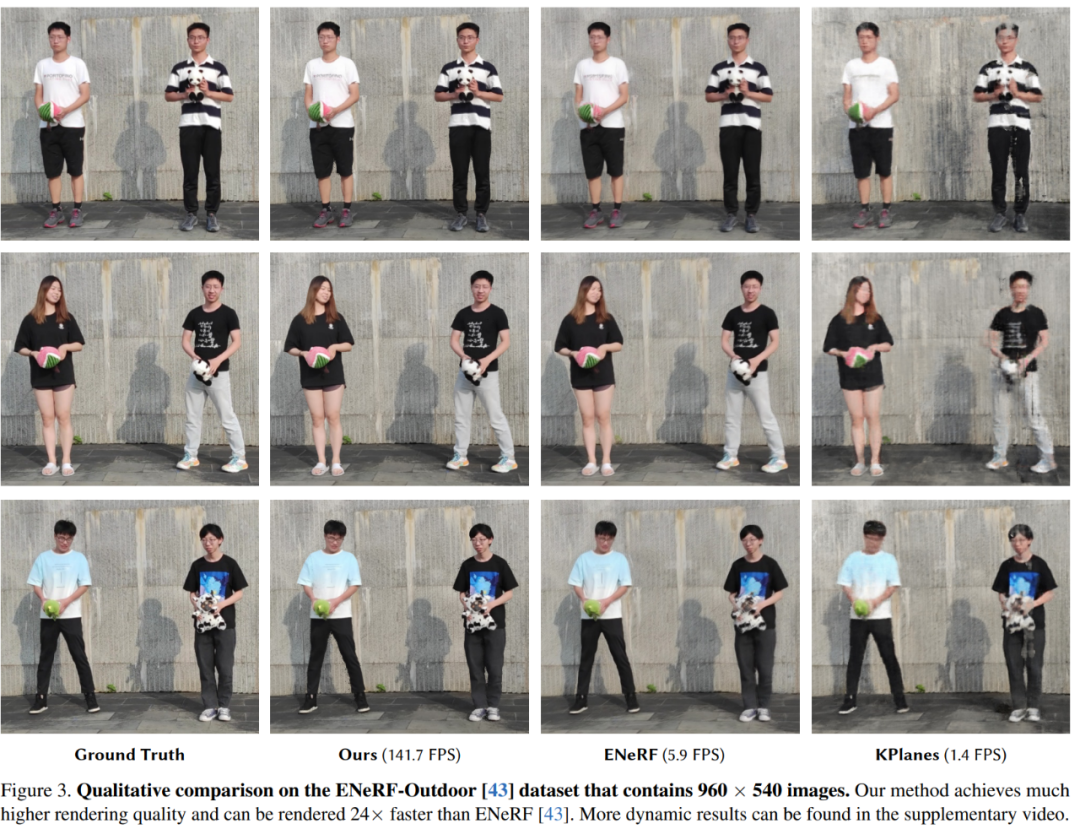

次に、ENeRFOutdoor データセットに対するさまざまな方法の定性的および定量的な結果を実験で示します。表 2 に示すように、4K4D は 140 FPS 以上でレンダリングしても大幅に優れた結果を達成しました。

ENeRF などの他の方法ではぼやけた結果が生成されますが、IBRNet のレンダリング結果には、図に示すように、画像のエッジの周囲に黒いアーティファクトが含まれています。 3 ディスプレイ; K-Planse は、動的な人体やさまざまな背景領域を再構成できません。

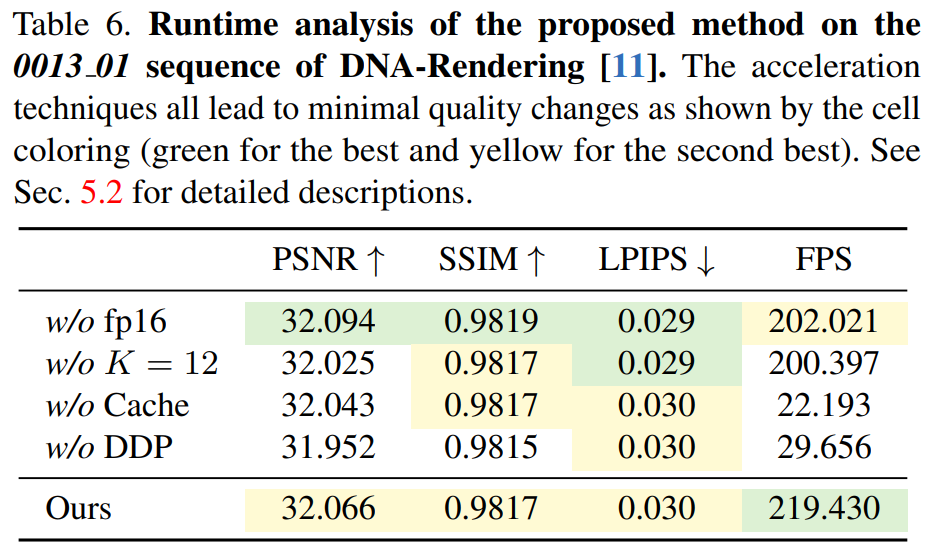

表 6 は、微分可能深度ピーリング アルゴリズムの有効性を示しており、4K4D は CUDA ベースの方法より 7 倍以上高速です。

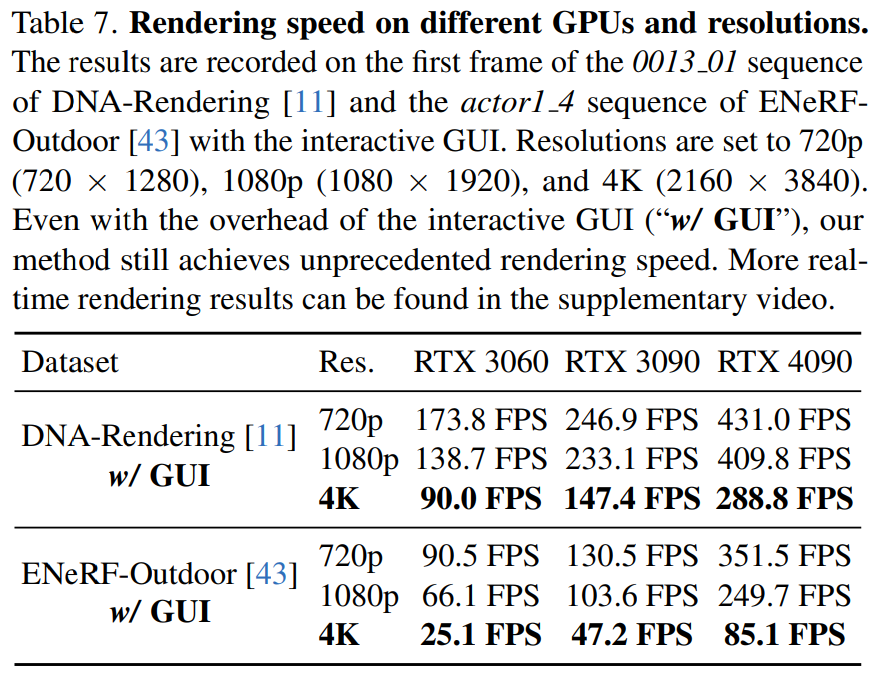

#この記事では、表 7 に、さまざまな解像度でのさまざまなハードウェア (RTX 3060、3090、および 4090) での 4K4D レンダリング速度も報告します。

詳細については、元の論文を参照してください。

以上が4K 品質の 3D 複合ビデオがスライドショーでフリーズすることがなくなり、新しい方法によりレンダリング速度が 30 倍以上向上しましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7461

7461

15

15

1376

1376

52

52

77

77

11

11

17

17

17

17

vue.jsのストリングをオブジェクトに変換するためにどのような方法が使用されますか?

Apr 07, 2025 pm 09:39 PM

vue.jsのストリングをオブジェクトに変換するためにどのような方法が使用されますか?

Apr 07, 2025 pm 09:39 PM

vue.jsのオブジェクトに文字列を変換する場合、標準のjson文字列にはjson.parse()が推奨されます。非標準のJSON文字列の場合、文字列は正規表現を使用して処理し、フォーマットまたはデコードされたURLエンコードに従ってメソッドを削減できます。文字列形式に従って適切な方法を選択し、バグを避けるためにセキュリティとエンコードの問題に注意してください。

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

この記事では、MySQLデータベースの操作を紹介します。まず、MySQLWorkBenchやコマンドラインクライアントなど、MySQLクライアントをインストールする必要があります。 1. mysql-uroot-pコマンドを使用してサーバーに接続し、ルートアカウントパスワードでログインします。 2。CreatedAtaBaseを使用してデータベースを作成し、データベースを選択します。 3. createTableを使用してテーブルを作成し、フィールドとデータ型を定義します。 4. INSERTINTOを使用してデータを挿入し、データをクエリし、更新することでデータを更新し、削除してデータを削除します。これらの手順を習得することによってのみ、一般的な問題に対処することを学び、データベースのパフォーマンスを最適化することでMySQLを効率的に使用できます。

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue axiosのタイムアウトを設定するために、Axiosインスタンスを作成してタイムアウトオプションを指定できます。グローバル設定:Vue.Prototype。$ axios = axios.create({Timeout:5000});単一のリクエストで:this。$ axios.get( '/api/users'、{timeout:10000})。

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

700万のレコードを効率的に処理し、地理空間技術を使用したインタラクティブマップを作成します。この記事では、LaravelとMySQLを使用して700万を超えるレコードを効率的に処理し、それらをインタラクティブなマップの視覚化に変換する方法について説明します。最初の課題プロジェクトの要件:MySQLデータベースに700万のレコードを使用して貴重な洞察を抽出します。多くの人は最初に言語をプログラミングすることを検討しますが、データベース自体を無視します。ニーズを満たすことができますか?データ移行または構造調整は必要ですか? MySQLはこのような大きなデータ負荷に耐えることができますか?予備分析:キーフィルターとプロパティを特定する必要があります。分析後、ソリューションに関連している属性はわずかであることがわかりました。フィルターの実現可能性を確認し、検索を最適化するためにいくつかの制限を設定しました。都市に基づくマップ検索

vue.js文字列タイプの配列をオブジェクトの配列に変換する方法は?

Apr 07, 2025 pm 09:36 PM

vue.js文字列タイプの配列をオブジェクトの配列に変換する方法は?

Apr 07, 2025 pm 09:36 PM

概要:Vue.js文字列配列をオブジェクト配列に変換するための次の方法があります。基本方法:定期的なフォーマットデータに合わせてマップ関数を使用します。高度なゲームプレイ:正規表現を使用すると、複雑な形式を処理できますが、慎重に記述して考慮する必要があります。パフォーマンスの最適化:大量のデータを考慮すると、非同期操作または効率的なデータ処理ライブラリを使用できます。ベストプラクティス:コードスタイルをクリアし、意味のある変数名とコメントを使用して、コードを簡潔に保ちます。

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLの起動が失敗する理由はたくさんあり、エラーログをチェックすることで診断できます。一般的な原因には、ポートの競合(ポート占有率をチェックして構成の変更)、許可の問題(ユーザー許可を実行するサービスを確認)、構成ファイルエラー(パラメーター設定のチェック)、データディレクトリの破損(テーブルスペースの復元)、INNODBテーブルスペースの問題(IBDATA1ファイルのチェック)、プラグインロード障害(エラーログのチェック)が含まれます。問題を解決するときは、エラーログに基づいてそれらを分析し、問題の根本原因を見つけ、問題を防ぐために定期的にデータをバックアップする習慣を開発する必要があります。

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニアの求人事業者:サークル場所:リモートオフィスジョブタイプ:フルタイム給与:$ 130,000- $ 140,000職務記述書サークルモバイルアプリケーションとパブリックAPI関連機能の研究開発に参加します。ソフトウェア開発ライフサイクル全体をカバーします。主な責任は、RubyonRailsに基づいて独立して開発作業を完了し、React/Redux/Relay Front-Endチームと協力しています。 Webアプリケーションのコア機能と改善を構築し、機能設計プロセス全体でデザイナーとリーダーシップと緊密に連携します。肯定的な開発プロセスを促進し、反復速度を優先します。 6年以上の複雑なWebアプリケーションバックエンドが必要です

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLインストール後にデータベースのパフォーマンスを最適化する方法

Apr 08, 2025 am 11:36 AM

MySQLパフォーマンスの最適化は、インストール構成、インデックス作成、クエリの最適化、監視、チューニングの3つの側面から開始する必要があります。 1。インストール後、INNODB_BUFFER_POOL_SIZEパラメーターやclose query_cache_sizeなど、サーバーの構成に従ってmy.cnfファイルを調整する必要があります。 2。過度のインデックスを回避するための適切なインデックスを作成し、説明コマンドを使用して実行計画を分析するなど、クエリステートメントを最適化します。 3. MySQL独自の監視ツール(ShowProcessList、ShowStatus)を使用して、データベースの健康を監視し、定期的にデータベースをバックアップして整理します。これらの手順を継続的に最適化することによってのみ、MySQLデータベースのパフォーマンスを改善できます。