初のマルチビュー自動運転シーンビデオ生成世界モデル | DrivingDiffusion: BEV データとシミュレーションの新しいアイデア

著者の個人的な考え

自動運転の分野では、BEV ベースのサブタスク/エンドツーエンド ソリューションの開発により、高品質 マルチビュー トレーニング データ とそれに対応する シミュレーション シーン構築 の重要性がますます高まっています。現在のタスクの問題点に対応して、「高品質」は 3 つの側面に分割できます。

- さまざまな次元でのロングテール シナリオ : 近距離の車両など。障害物データだけでなく、車の切断中の正確な進行角度だけでなく、収集が難しい車線データやランプ/合流/合流におけるさまざまな曲率を持つシーンも同様です。これらは多くの場合、大量のデータ収集と複雑なデータ マイニング戦略に依存しており、コストがかかります。

- 3D の真の価値 - 画像の高い一貫性 : 現在の BEV データ取得は、センサーの設置/校正、高精度マップ、再構成アルゴリズム自体のエラーの影響を受けることがよくあります。このため、データ内の [3D 真の値 - 画像センサー パラメーター] の各セットが正確で一貫していることを確認することが困難になります。

- 上記の条件を満たした時系列データ: 現在の認識/予測/意思決定/エンドツーに必要な連続フレームの多視点画像と対応する真の値-endおよびその他のタスクに不可欠です。

シミュレーションの場合、上記の条件を満たすビデオ生成は、レイアウトを通じて直接生成できます。これは間違いなく、マルチエージェント センサー入力を構築する最も直接的な方法です。 DrivingDiffusion は上記の問題を新たな視点で解決します。

普及促進とは何ですか?

- DrivingDiffusion は、自動運転シーン生成のための拡散モデル フレームワークであり、レイアウト制御された マルチビュー画像/ビデオ生成と SOTA を実装します。それぞれ実装されています。

- DrivingDiffusion-Future は、自動運転世界モデルとして、単一フレーム画像 に基づいて将来のシーンのビデオを予測し、主車両/他の車両の動作計画に影響を与える機能を備えています言語プロンプトについて。

DrivingDiffusion 生成の効果は何ですか?

必要な学生は、まずプロジェクトのホームページをご覧ください: https://drivingdiffusion.github.io(1) DrivingDiffusion

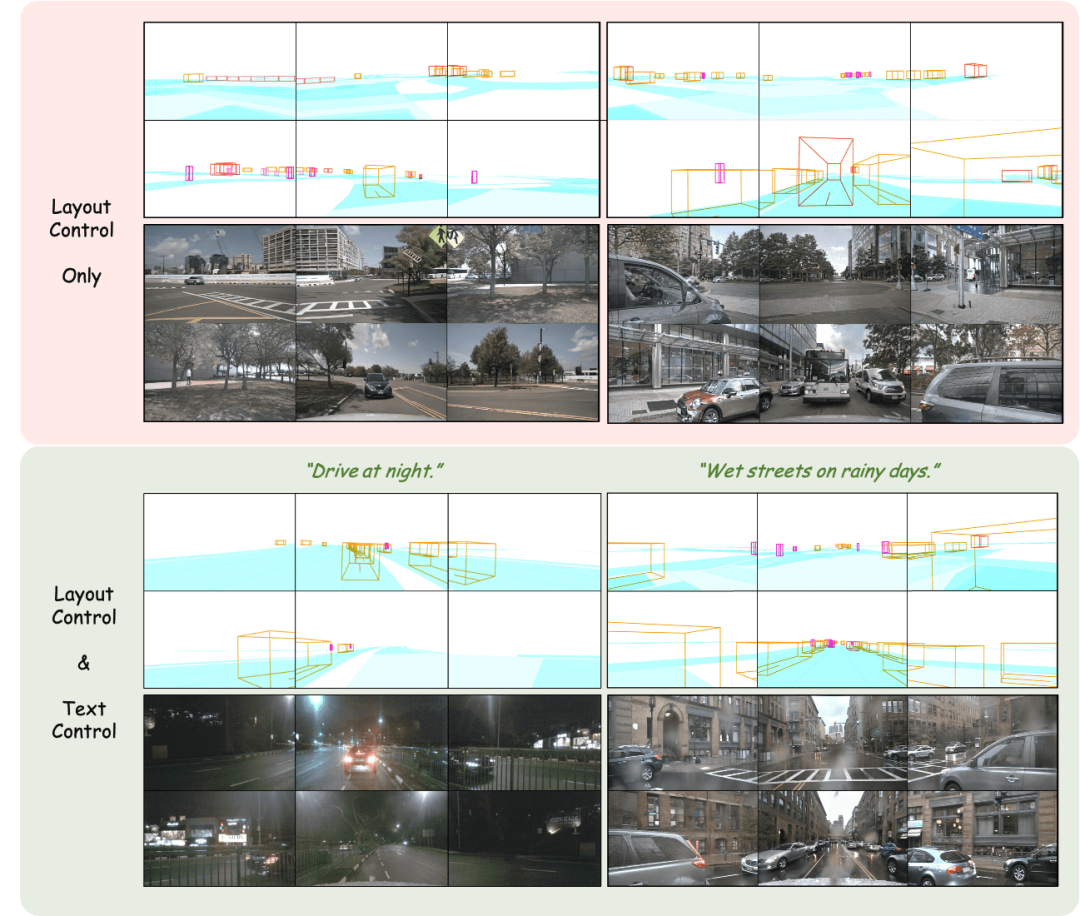

レイアウト制御されたマルチビュー イメージの生成

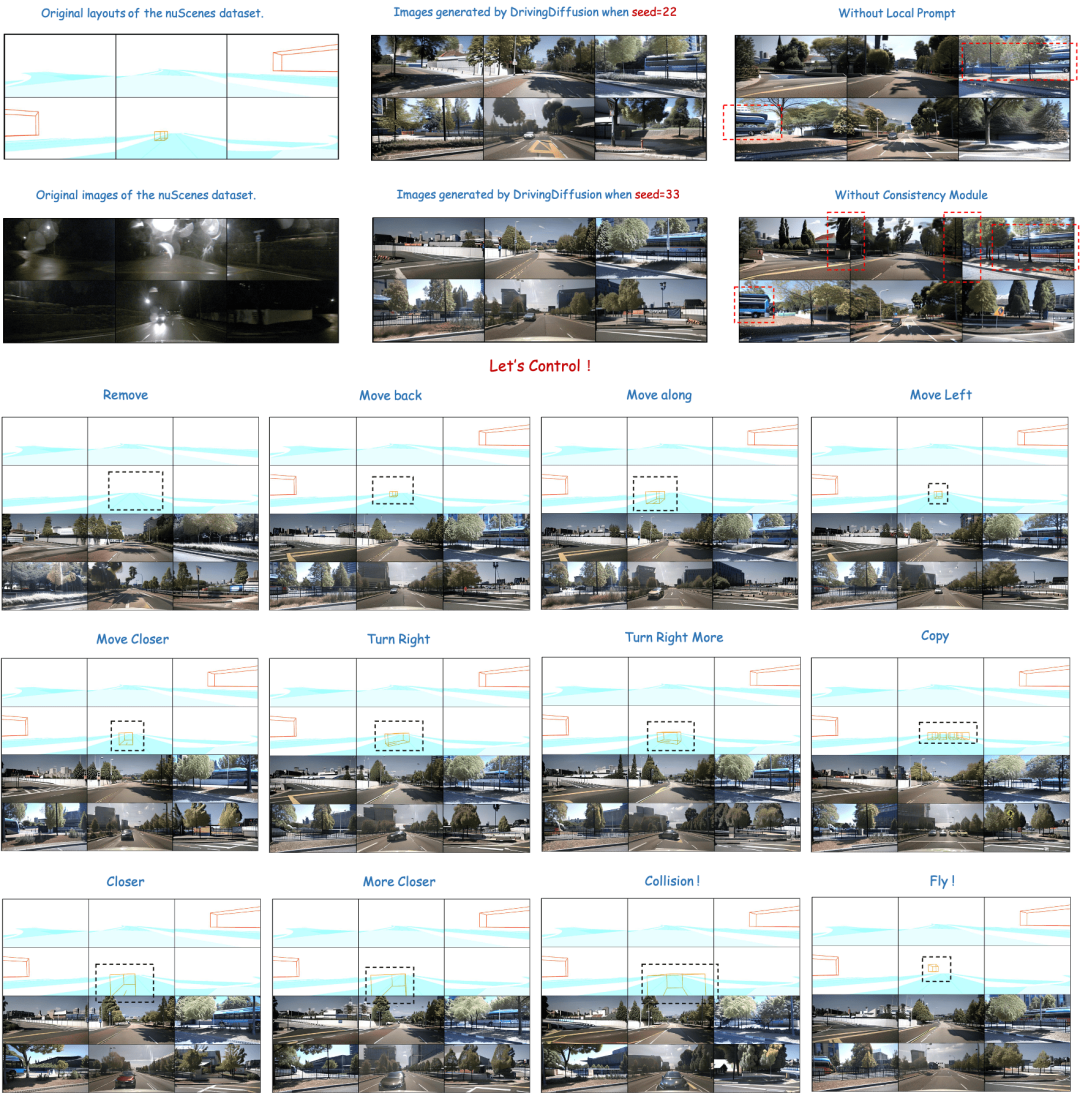

レイアウトの調整: 生成された結果を正確に制御

#レイアウト制御されたマルチビュー ビデオの生成

入力フレームのテキスト記述に基づいて後続のフレームを生成します

単一のフレーム画像を入力として使用し、主要な車/他の車のテキスト説明に基づいて後続のフレームの運転シーンを構築します。図中最初の3段目と4段目はそれぞれ自車両と他車両の挙動のテキスト記述制御後の生成効果を示している。 (緑色のボックスが入力、青色のボックスが出力です)

単一のフレーム画像を入力として使用し、主要な車/他の車のテキスト説明に基づいて後続のフレームの運転シーンを構築します。図中最初の3段目と4段目はそれぞれ自車両と他車両の挙動のテキスト記述制御後の生成効果を示している。 (緑色のボックスが入力、青色のボックスが出力です)

他のコントロールは必要ありません。単一フレームの画像を入力として使用して、後続の運転シーンのフレームを予測するだけです。 (緑のボックスが入力、青のボックスが出力)

他のコントロールは必要ありません。単一フレームの画像を入力として使用して、後続の運転シーンのフレームを予測するだけです。 (緑のボックスが入力、青のボックスが出力)

DrivingDiffusion は上記の問題をどのように解決しますか?

DrivingDiffusion は、まずシーン内のすべての 3D 真値 (障害物/道路構造物) を人工的に構築し、真値をレイアウト画像に投影した後、これをモデル入力として使用してマルチ- カメラの視点、実際の画像/ビデオ。 3D 真の値 (BEV ビューまたはエンコードされたインスタンス) がモデル入力として直接使用されず、パラメーターが投影後の入力に使用される理由は、体系的な 3D-2D 一貫性エラーを排除するためです。 (このようなデータセットでは、3D 真値 と 車両パラメータ が実際のニーズに応じて人工的に構築されます。前者は、希少なシーン データを自由に構築する機能をもたらします。 後者は、従来のデータ生成における幾何学的一貫性のエラーを排除します。)

現時点ではまだ 1 つの疑問が残っています。生成された画像/ビデオの品質が用途を満たすかどうかです。要件 ? シナリオ構築というと、誰もがシミュレーション エンジンの使用を思い浮かべますが、生成されるデータと実際のデータの間には大きな領域のギャップがあります。 GAN ベースの手法で生成された結果には、実際の実データの分布からの偏りがあることがよくあります。拡散モデルは、ノイズを学習してデータを生成するマルコフ連鎖の特性に基づいており、生成される結果の忠実度が高く、実際のデータの代替として使用するのに適しています。 DrivingDiffusion は、人工的に構築されたシーン と 車両パラメータ に基づいて シーケンシャル マルチビュー ビュー を直接生成します。これらは参照として使用できるだけでなく、ダウンストリームの自動運転タスク用 トレーニング データを使用して、自動運転アルゴリズムのフィードバック用のシミュレーション システムを構築することもできます。

ここでいう「人工的に構築されたシーン」には障害物と道路構造情報のみが含まれていますが、DrivingDiffusion のフレームワークでは、看板、信号機、工事エリア、さらには低レベルの占有グリッド/深度マップなどのレイアウト情報を簡単に導入できます。他の制御モード。DrivingDiffusion 手法の概要

マルチビュー ビデオを生成する場合、いくつかの問題があります:

- 比較的一般的画像生成の場合、マルチビュー ビデオ生成により、

- perspective と timing という 2 つの新しい次元が追加されます。長いビデオを生成できるフレームワークを設計するにはどうすればよいですか?ビュー間の一貫性とフレーム間の一貫性を維持するにはどうすればよいですか? 自動運転タスクの観点から見ると、シーン内のインスタンスは非常に重要です。生成されたインスタンスの品質を確保するにはどうすればよいですか?

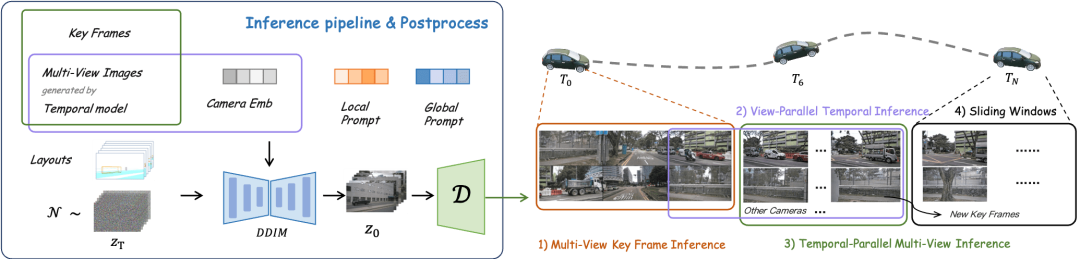

DrivingDiffusion は長いビデオ プロセスを生成します

単一フレーム マルチビュー モデル: マルチビュー キー フレームを生成します。 追加の制御としてフレームを使用するシングルビュー タイミング モデルとマルチビュー共有: 各ビューでタイミング拡張を並行して実行します。

追加の制御としてフレームを使用するシングルビュー タイミング モデルとマルチビュー共有: 各ビューでタイミング拡張を並行して実行します。

- 生成された結果を追加の制御として使用するシングル フレーム マルチビュー モデル: 微調整

- 新しいキーフレームを決定し、スライディング ウィンドウを通してビデオを拡張します。

- クロスビュー モデルと時間モデルのトレーニング フレームワーク

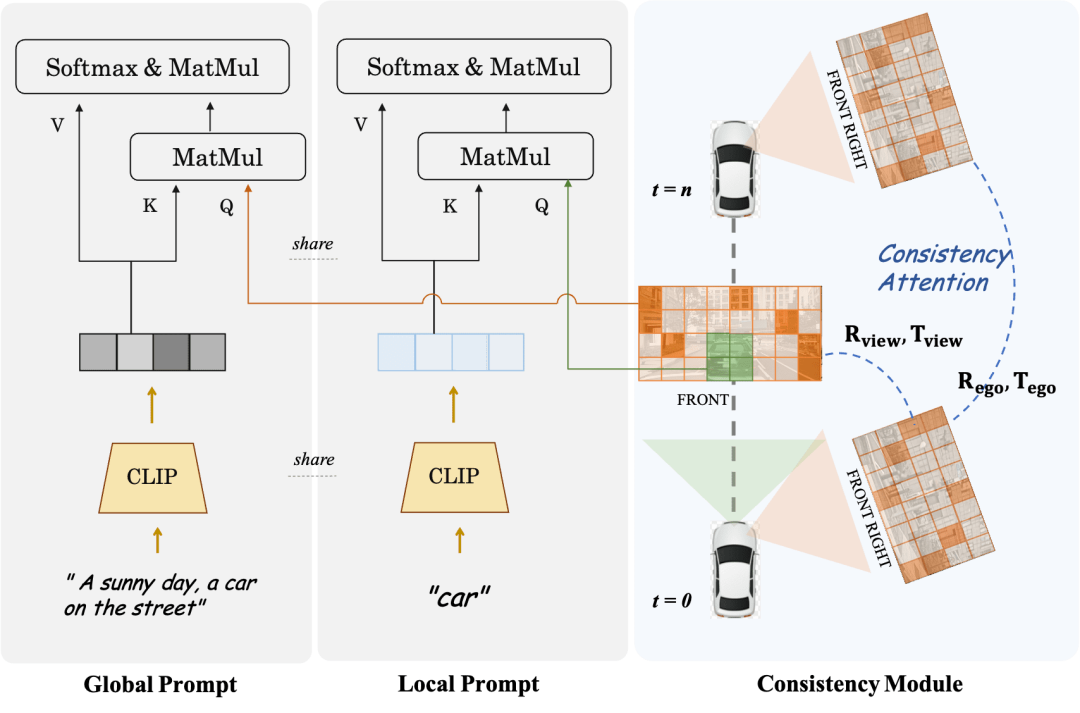

- マルチビュー モデルとシーケンシャル モデルの場合、3D-Unet の拡張次元はそれぞれ視点と時間です。どちらも同じレイアウト コントローラーを持っています。著者は、後続のフレームがマルチビュー キー フレームからシーン内の情報を取得し、さまざまなターゲットの関連情報を暗黙的に学習できると考えています。どちらも、それぞれ異なる整合性アテンション モジュールと同じローカル プロンプト モジュールを使用します。

- レイアウト エンコード: 障害物カテゴリ/障害物情報と道路構造物セグメンテーション レイアウトは、異なる固定エンコード値を使用して RGB 画像にエンコードされ、エンコード後にレイアウト トークンが出力されます。

- キー フレーム制御: すべてのタイミング拡張プロセスは、特定のキー フレームの多視点画像を使用します。これは、短いタイミング シーケンスの後続のフレームがキー フレームから情報を取得できるという前提に基づいています。すべての微調整プロセスでは、キー フレームと、それによって生成された後続フレームの多視点画像を追加の制御として使用し、フレームの視点間の一貫性を最適化した後に多視点画像を出力します。

- 特定の視点に基づく事前のオプティカル フロー: 時間モデルの場合、トレーニング中に特定の視点からのデータのみがサンプリングされます。また、事前に計算しておいた透視画像下の各画素位置のオプティカルフロー事前値を利用し、カメラIDトークンとしてエンコードすることで、拡散処理における時間埋め込みと同様の隠れ層のインタラクティブな制御を行う。

整合性モジュールとローカル プロンプト

##整合性モジュール は 2 つの部分に分かれています: 整合性注意メカニズム および 一貫性相関損失。

一貫性注意メカニズムは、隣接するビューとタイミング関連のフレーム間の相互作用に焦点を当てます。特に、フレーム間の一貫性については、重なり合う左右の隣接するビュー間の情報の相互作用のみに焦点を当てます。モデルでは、各フレームはキーフレームと前のフレームのみに焦点を当てます。これにより、グローバルな相互作用によって引き起こされる膨大な計算負荷が回避されます。 一貫性のある相関損失は、ピクセルレベルの相関とポーズの回帰によって幾何学的制約を追加します。その勾配は、事前トレーニングされたポーズ回帰子によって提供されます。リグレッサーは、LoFTR に基づいてポーズ回帰ヘッドを追加し、対応するデータセットの実データの真のポーズ値を使用してトレーニングされます。マルチビュー モデルと時系列モデルの場合、このモジュールはそれぞれカメラの相対姿勢と主車両の運動姿勢を監視します。ローカル プロンプト と グローバル プロンプト は連携して、CLIP と安定拡散 v1-4 のパラメータ セマンティクスを再利用して、特定のカテゴリ インスタンス領域をローカルに強化します。図に示すように、画像トークンとグローバル テキスト説明プロンプトのクロスアテンション メカニズムに基づいて、作成者は特定のカテゴリのローカル プロンプトを設計し、カテゴリのマスク領域で画像トークンを使用してローカル クエリをクエリします。プロンプト。このプロセスでは、元のモデル パラメーターのオープン ドメインでのテキスト ガイド付き画像生成の概念が最大限に活用されます。

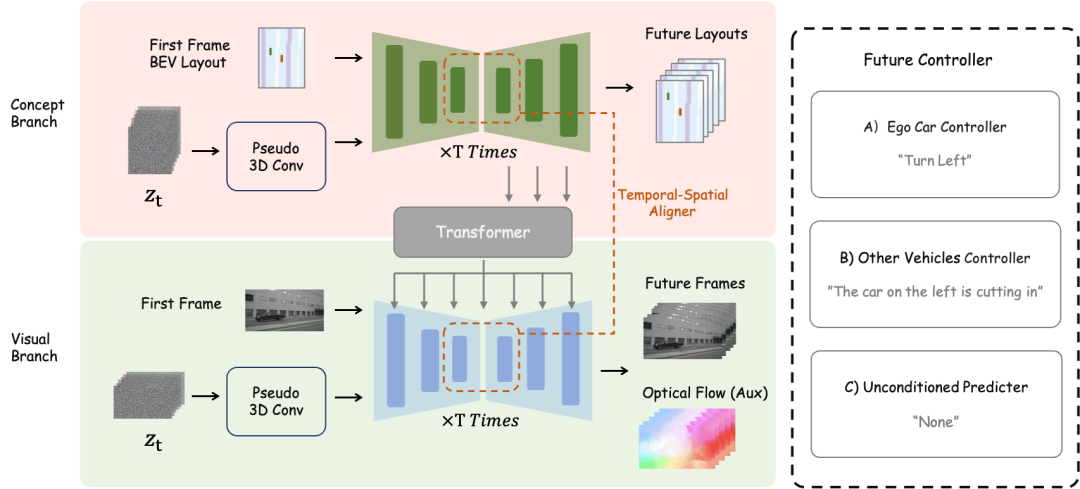

DrivingDiffusion-Future メソッドの概要

メイン車両制御テキスト記述コントローラと他の車両制御/環境テキスト記述コントローラが分離されていることは注目に値します。

実験分析

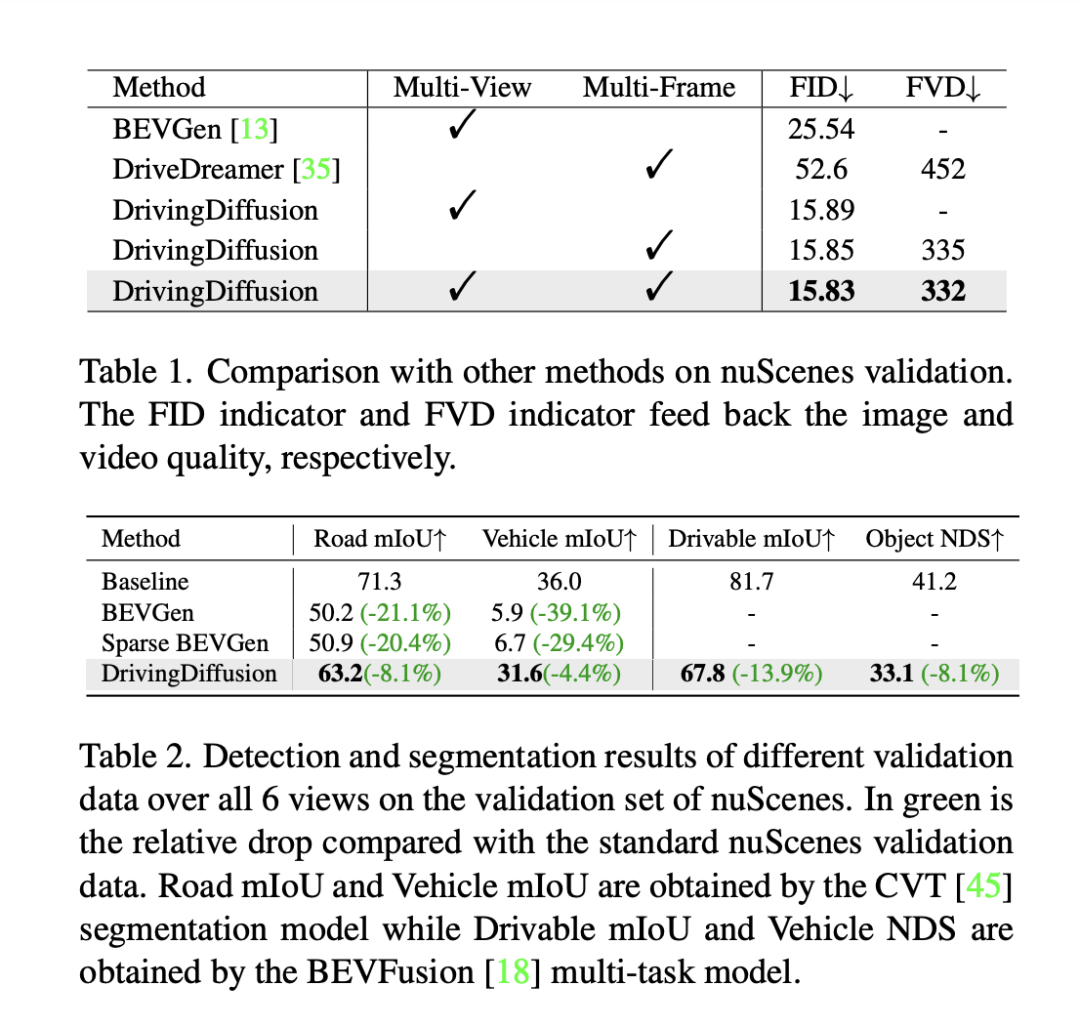

モデルのパフォーマンスを評価するために、DrivingDiffusion はフレームレベルのフレシェ開始距離 (FID) を使用して、生成された画像の品質を評価します。したがって、FVD を使用して生成された画像を評価します。すべてのメトリクスは、nuScenes 検証セットに基づいて計算されます。表 1 に示すように、自動運転シナリオにおける画像生成タスク BEVGen およびビデオ生成タスク DriveDreamer と比較して、DrivingDiffusion はさまざまな設定の下でパフォーマンス指標において大きな利点があります。

FID などの方法は、画像合成の品質を測定するためによく使用されますが、タスクの設計目標を完全にフィードバックするものではなく、さまざまなセマンティック カテゴリの合成品質を反映するものでもありません。このタスクは 3D レイアウトと一致するマルチビュー画像を生成することに特化しているため、DrivingDiffuison は、一貫性の観点からパフォーマンスを測定するために BEV 知覚モデル メトリクスを使用することを提案しています。CVT と BEVFusion の公式モデルを評価者として使用し、同じ実際の 3D モデルを使用します。 nuScenes 検証セットとして、レイアウト上で条件付きで画像を生成し、生成された画像の各セットに対して CVT および BevFusion 推論を実行し、予測結果を実際の結果と比較します。これには、運転可能エリアの平均交差 U (mIoU) スコアが含まれます。すべてのオブジェクト クラスの NDS 統計を表 2 に示します。実験結果は、合成データ評価セットの知覚指標が実際の評価セットの知覚指標に非常に近いことを示しており、これは生成された結果と 3D 真の値の高い一貫性、および画質の高い忠実度を反映しています。

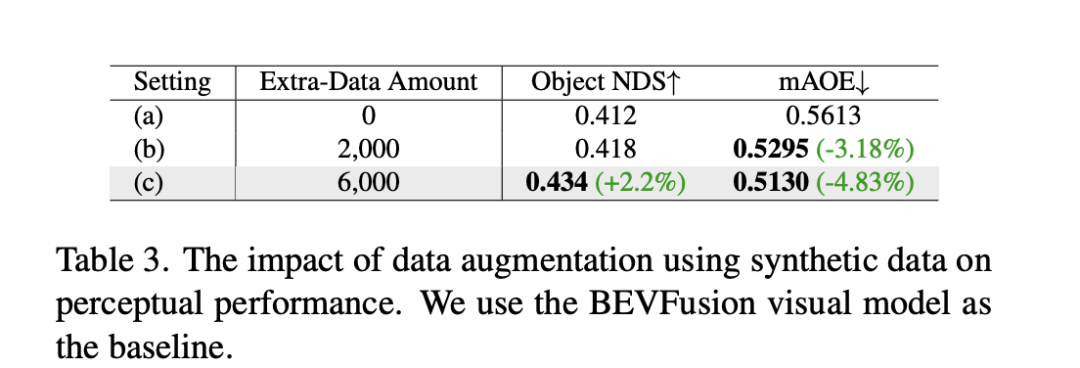

上記の実験に加えて、DrivingDiffusion は、解決する主な問題、つまり自動運転の下流タスクのパフォーマンスを向上させるために、合成データ トレーニングを追加する実験を実施しました。表 3 は、BEV 認識タスクにおける合成データ拡張によって達成されるパフォーマンスの向上を示しています。元のトレーニング データでは、特に小さなターゲット、近距離の車両、および車両の向きの角度について、ロングテール分布に問題があります。 DrivingDiffusion は、この問題を解決するために、限られたサンプルを使用してこれらのクラスの追加データを生成することに重点を置いています。障害物方向角度の分布の改善に焦点を当てた 2000 フレームのデータを追加した後、NDS はわずかに改善しましたが、mAOE は 0.5613 から 0.5295 に大幅に低下しました。トレーニングを支援するために、より包括的でまれなシーンに焦点を当てた 6000 フレームの合成データを使用した後、nuScenes 検証セットで大幅な強化が観察できます。NDS は 0.412 から 0.434 に増加し、mAOE は 0.5613 から 0.5130 に減少しました。これは、合成データのデータ拡張が認識タスクに大幅な改善をもたらす可能性があることを示しています。ユーザーは、実際のニーズに基づいてデータ内の各次元の分布に関する統計を作成し、ターゲットを絞った合成データでそれを補完できます。

DrivingDiffusionの意義と今後の取り組み

DrivingDiffusionは、自動運転シーンの多視点動画生成と未来予測を同時に実現するという非常に重要な機能です。自動運転タスクに。このうち、layout と parameters はすべて人工的に構築されており、3D と 2D の間の変換は学習可能なモデル パラメーターに依存するのではなく投影を通じて行われるため、前の取得プロセスでの幾何学的エラーが排除されます。データは、強力な実用的価値を持っています。同時に、DrivingDiffuison は非常にスケーラブルであり、新しいシーン コンテンツ レイアウトと追加のコントローラーをサポートし、超解像度とビデオ フレーム挿入テクノロジーを通じてロスレスに生成品質を向上させることもできます。

自動運転シミュレーションでは、ナーフの試みが増えています。しかし、ストリートビュー生成のタスクでは、動的コンテンツと静的コンテンツの分離、大規模なブロックの再構築、天候やその他の次元の外観制御の切り離しなど、膨大な作業量が発生します。トレーニング後にのみ、後続のシミュレーションで新しい視点合成タスクをサポートできるようになります。 DrivingDiffusion には、ビジュアルとテキストのつながり、ビジュアルコンテンツの概念理解など、ある程度の一般的な知識が当然含まれており、レイアウトを構築するだけで、ニーズに応じたシーンを迅速に作成できます。ただし、前述したように、プロセス全体は比較的複雑であり、長いビデオの生成には後処理モデルの微調整と拡張が必要です。 DrivingDiffusion は、視点次元と時間次元の圧縮を引き続き検討し、新しい視点の生成と変換のために Nerf を組み合わせ、生成の品質とスケーラビリティを向上させ続けます。

以上が初のマルチビュー自動運転シーンビデオ生成世界モデル | DrivingDiffusion: BEV データとシミュレーションの新しいアイデアの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7445

7445

15

15

1374

1374

52

52

76

76

11

11

14

14

6

6

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

なぜ自動運転ではガウス スプラッティングが非常に人気があるのに、NeRF は放棄され始めているのでしょうか?

Jan 17, 2024 pm 02:57 PM

上記と著者の個人的な理解 3 次元ガウシアンプラッティング (3DGS) は、近年、明示的な放射線フィールドとコンピューター グラフィックスの分野で出現した革新的なテクノロジーです。この革新的な方法は、数百万の 3D ガウスを使用することを特徴とし、主に暗黙的な座標ベースのモデルを使用して空間座標をピクセル値にマッピングする神経放射線場 (NeRF) 方法とは大きく異なります。明示的なシーン表現と微分可能なレンダリング アルゴリズムにより、3DGS はリアルタイム レンダリング機能を保証するだけでなく、前例のないレベルの制御とシーン編集も導入します。これにより、3DGS は、次世代の 3D 再構築と表現にとって大きな変革をもたらす可能性のあるものとして位置付けられます。この目的を達成するために、私たちは 3DGS 分野における最新の開発と懸念について初めて体系的な概要を提供します。

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

昨日の面接で、ロングテール関連の質問をしたかと聞かれたので、簡単にまとめてみようと思いました。自動運転のロングテール問題とは、自動運転車におけるエッジケース、つまり発生確率が低い考えられるシナリオを指します。認識されているロングテール問題は、現在、単一車両のインテリジェント自動運転車の運用設計領域を制限している主な理由の 1 つです。自動運転の基礎となるアーキテクチャとほとんどの技術的問題は解決されており、残りの 5% のロングテール問題が徐々に自動運転の開発を制限する鍵となってきています。これらの問題には、さまざまな断片的なシナリオ、極端な状況、予測不可能な人間の行動が含まれます。自動運転におけるエッジ シナリオの「ロング テール」とは、自動運転車 (AV) におけるエッジ ケースを指します。エッジ ケースは、発生確率が低い可能性のあるシナリオです。これらの珍しい出来事

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

カメラかライダーを選択しますか?堅牢な 3D オブジェクト検出の実現に関する最近のレビュー

Jan 26, 2024 am 11:18 AM

0.前面に書かれています&& 自動運転システムは、さまざまなセンサー (カメラ、ライダー、レーダーなど) を使用して周囲の環境を認識し、アルゴリズムとモデルを使用することにより、高度な知覚、意思決定、および制御テクノロジーに依存しているという個人的な理解リアルタイムの分析と意思決定に。これにより、車両は道路標識の認識、他の車両の検出と追跡、歩行者の行動の予測などを行うことで、安全な運行と複雑な交通環境への適応が可能となり、現在広く注目を集めており、将来の交通分野における重要な開発分野と考えられています。 。 1つ。しかし、自動運転を難しくしているのは、周囲で何が起こっているかを車に理解させる方法を見つけることです。これには、自動運転システムの 3 次元物体検出アルゴリズムが、周囲環境にある物体 (位置を含む) を正確に認識し、記述することができる必要があります。

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

原題: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving 論文リンク: https://arxiv.org/pdf/2402.02519.pdf コードリンク: https://github.com/HKUST-Aerial-Robotics/SIMPL 著者単位: 香港科学大学DJI 論文のアイデア: この論文は、自動運転車向けのシンプルで効率的な動作予測ベースライン (SIMPL) を提案しています。従来のエージェントセントとの比較

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

先頭と開始点に書かれている エンドツーエンドのパラダイムでは、統一されたフレームワークを使用して自動運転システムのマルチタスクを実現します。このパラダイムの単純さと明確さにも関わらず、サブタスクにおけるエンドツーエンドの自動運転手法のパフォーマンスは、依然としてシングルタスク手法に比べてはるかに遅れています。同時に、以前のエンドツーエンド手法で広く使用されていた高密度鳥瞰図 (BEV) 機能により、より多くのモダリティやタスクに拡張することが困難になります。ここでは、スパース検索中心のエンドツーエンド自動運転パラダイム (SparseAD) が提案されています。このパラダイムでは、スパース検索は、高密度の BEV 表現を使用せずに、空間、時間、タスクを含む運転シナリオ全体を完全に表します。具体的には、統合されたスパース アーキテクチャが、検出、追跡、オンライン マッピングなどのタスク認識のために設計されています。さらに、重い

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

この 1 か月間、いくつかのよく知られた理由により、私は業界のさまざまな教師やクラスメートと非常に集中的な交流をしてきました。この交換で避けられない話題は当然、エンドツーエンドと人気の Tesla FSDV12 です。この機会に、現時点での私の考えや意見を整理し、皆様のご参考とご議論に役立てたいと思います。エンドツーエンドの自動運転システムをどのように定義するか、またエンドツーエンドで解決することが期待される問題は何でしょうか?最も伝統的な定義によれば、エンドツーエンド システムとは、センサーから生の情報を入力し、関心のある変数をタスクに直接出力するシステムを指します。たとえば、画像認識では、従来の特徴抽出 + 分類子方式と比較して、CNN はエンドツーエンドと言えます。自動運転タスクでは、各種センサー(カメラ/LiDAR)からのデータを入力