NVIDIA が世界で最も強力な AI チップ H200 をリリース: H100 と比較してパフォーマンスがほぼ 2 倍に向上

NVIDIA が世界で最も強力な AI チップ H200 をリリース: H100 と比較してほぼ 2 倍のパフォーマンス

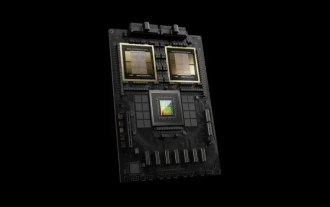

Quick Technology は本日 (11 月 14 日)、2023 年のグローバル スーパーコンピューティング カンファレンス (SC2023) で、チップ大手の Nvidia が現在世界で最も強力な AI チップである H100 チップの後継チップである H200 をリリースしたと報じました。

H200 のパフォーマンスは、H100 と比較して 60% ~ 90% 直接向上します

それだけでなく、H200 と H100 は両方とも NVIDIA Hopper アーキテクチャに基づいているため、H100 を使用している企業は 2 つのチップが相互に互換性があり、最新の H200 にシームレスに置き換えることができます。

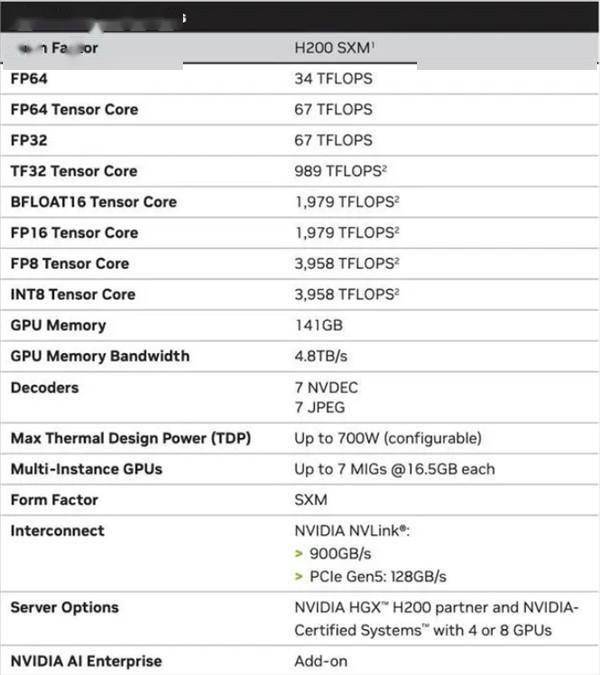

H200 は、HBM3e メモリを使用する NVIDIA の最初のチップであり、より高速で大容量であり、大規模な言語モデルのトレーニングと推論に非常に適しています。

HBM3e メモリに加えて、H200 のメモリ容量は 141GB で、帯域幅は H100 の 3.35TB/s から 4.8TB/s に増加しました。H200 のパフォーマンスの向上は主に大規模モデルの推論パフォーマンスに反映され、700 億のパラメーターを持つ大規模な Llama2 モデルにおける H200 の推論速度は H100 の 2 倍になり、H200 の推論エネルギー消費は直接的に削減されます。 H100に比べて半分になります。

H200 はより高いメモリ帯域幅を備えているため、メモリを大量に使用する高性能コンピューティング アプリケーションの場合、動作データにより効率的にアクセスできます。 H200 を使用すると、中央処理装置 (CPU) と比較して結果取得時間を最大 110 倍短縮できます

NVIDIA は、H200 は 2024 年の第 2 四半期に出荷される予定であると述べました。価格はまだ発表されていませんが、コンピューティング能力が不足する中、大手テクノロジー企業は依然として供給を蓄えることが予想されます。

以上がNVIDIA が世界で最も強力な AI チップ H200 をリリース: H100 と比較してパフォーマンスがほぼ 2 倍に向上の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7532

7532

15

15

1379

1379

52

52

82

82

11

11

21

21

84

84

NVIDIA が RTX HDR 機能を開始: サポートされていないゲームは AI フィルターを使用して HDR の豪華な視覚効果を実現します

Feb 24, 2024 pm 06:37 PM

NVIDIA が RTX HDR 機能を開始: サポートされていないゲームは AI フィルターを使用して HDR の豪華な視覚効果を実現します

Feb 24, 2024 pm 06:37 PM

2 月 23 日のこの Web サイトのニュースによると、NVIDIA は昨夜 NVIDIA アプリケーションを更新してリリースし、プレイヤーに新しい統合 GPU コントロール センターを提供し、プレイヤーはゲーム内フローティングによって提供される強力な記録ツールを通じて素晴らしい瞬間をキャプチャできるようになりました。窓。このアップデートでは、NVIDIA も RTXHDR 機能を導入しました。公式の紹介文はこのサイトに添付されています: RTXHDR は、ハイ ダイナミック レンジ (HDR) のゴージャスな視覚効果をゲームにシームレスに導入できる、AI を活用した新しいフリースタイル フィルターです。もともとHDRをサポートしています。この機能をさまざまな DirectX および Vulkan ベースのゲームで使用するには、HDR 互換モニターが必要です。プレーヤーが RTXHDR 機能を有効にすると、HD をサポートしていなくてもゲームが実行されます。

NVIDIA RTX 50 シリーズ グラフィックス カードには 16 ピン PCIe Gen 6 電源インターフェイスがネイティブに装備されていることが報告されています

Feb 20, 2024 pm 12:00 PM

NVIDIA RTX 50 シリーズ グラフィックス カードには 16 ピン PCIe Gen 6 電源インターフェイスがネイティブに装備されていることが報告されています

Feb 20, 2024 pm 12:00 PM

2 月 19 日のこの Web サイトのニュースによると、ムーアの LawisDead チャンネルの最新ビデオでアンカーのトムは、Nvidia GeForce RTX50 シリーズ グラフィックス カードに PCIeGen6 16 ピン電源インターフェイスがネイティブに装備されることを明らかにしました。トム氏は、ハイエンドのGeForceRTX5080およびGeForceRTX5090シリーズに加えて、ミッドレンジのGeForceRTX5060でも新しい電源インターフェースが可能になると述べた。 Nvidia は、サプライ チェーンを簡素化するために、将来的に各 GeForce RTX50 シリーズに PCIeGen6 16 ピン電源インターフェイスを搭載するという明確な要件を設定したと報告されています。このサイトに添付されているスクリーンショットは次のとおりです: Tom は、GeForceRTX5090 とも述べています

RTX5090の性能は大幅に向上しているのでしょうか?

Mar 05, 2024 pm 06:16 PM

RTX5090の性能は大幅に向上しているのでしょうか?

Mar 05, 2024 pm 06:16 PM

多くのユーザーは、次世代の新しい RTX5090 グラフィックス カードに興味を持っていますが、このグラフィックス カードのパフォーマンスが前世代と比較してどの程度向上しているかはわかりません。現在の情報から判断すると、このグラフィックス カードの全体的なパフォーマンスは次のとおりです。まだとても良いです。 RTX5090 のパフォーマンスの向上は明らかですか? 回答: それは依然として非常に明らかです。 1. このグラフィックス カードは、最大 3 GHz という限界を超える加速周波数を備えており、192 個のストリーミング マルチプロセッサ (SM) も搭載しており、最大 520 W の電力を生成することもあります。 2. RedGamingTech の最新ニュースによると、NVIDIARTX5090 は 3GHz のクロック周波数を超えると予想されており、これは間違いなく難しいグラフィックス操作や計算を実行する上でより大きな役割を果たし、よりスムーズでリアルなゲームを提供することになります。

NVIDIA RTX 4070 および 4060 Ti FE グラフィックス カードは、それぞれ希望小売価格 4599/2999 元を下回りました。

Feb 22, 2024 pm 09:43 PM

NVIDIA RTX 4070 および 4060 Ti FE グラフィックス カードは、それぞれ希望小売価格 4599/2999 元を下回りました。

Feb 22, 2024 pm 09:43 PM

2月22日の当ウェブサイトのニュースによると、一般的にNVIDIAとAMDはチャネル価格に制限を設けており、個人的に価格を大幅に引き下げた一部のディーラーも処罰される予定で、例えばAMDは最近、6750GREグラフィックスカードを以下の価格で販売したディーラーを処罰したという。最低価格 商人は罰せられた。このサイトは、Nvidia GeForce RTX 4070 および 4060 Ti が記録的な安値に落ちていることに気づきました。その創設者のバージョン、つまりグラフィックス カードのパブリック バージョンは、現在、JD.com の自営ストアで 200 元のクーポンを受け取ることができます。価格は4,599元と2,999元。もちろん、サードパーティのストアを考慮すれば、さらに安い価格もあります。パラメータに関しては、RTX4070 グラフィックス カードは 5888CUDA コアを備え、12GBGDDR6X メモリを使用し、ビット幅は 192bi です。

NVIDIA 対話モデル ChatQA はバージョン 2.0 に進化し、コンテキストの長さは 128K と記載されています

Jul 26, 2024 am 08:40 AM

NVIDIA 対話モデル ChatQA はバージョン 2.0 に進化し、コンテキストの長さは 128K と記載されています

Jul 26, 2024 am 08:40 AM

オープンな LLM コミュニティは百花繚乱の時代です Llama-3-70B-Instruct、QWen2-72B-Instruct、Nemotron-4-340B-Instruct、Mixtral-8x22BInstruct-v0.1 などがご覧いただけます。優秀なパフォーマーモデル。しかし、GPT-4-Turboに代表される独自の大型モデルと比較すると、オープンモデルには依然として多くの分野で大きなギャップがあります。一般的なモデルに加えて、プログラミングと数学用の DeepSeek-Coder-V2 や視覚言語タスク用の InternVL など、主要な領域に特化したいくつかのオープン モデルが開発されています。

「AI Factory」はソフトウェア スタック全体の再構築を促進し、NVIDIA はユーザーが展開できる Llama3 NIM コンテナを提供します

Jun 08, 2024 pm 07:25 PM

「AI Factory」はソフトウェア スタック全体の再構築を促進し、NVIDIA はユーザーが展開できる Llama3 NIM コンテナを提供します

Jun 08, 2024 pm 07:25 PM

6月2日の当サイトのニュースによると、現在開催中のHuang Renxun 2024 Taipei Computexの基調講演で、Huang Renxun氏は、生成人工知能がソフトウェアスタック全体の再構築を促進すると紹介し、NIM(Nvidia Inference Microservices)のクラウドネイティブマイクロサービスをデモしました。 。 Nvidia は、「AI ファクトリー」が新たな産業革命を引き起こすと信じています。Microsoft が開拓したソフトウェア業界を例に挙げると、Huang Renxun 氏は、生成人工知能がそのフルスタックの再構築を促進すると信じています。あらゆる規模の企業による AI サービスの導入を促進するために、NVIDIA は今年 3 月に NIM (Nvidia Inference Microservices) クラウドネイティブ マイクロサービスを開始しました。 NIM+ は、市場投入までの時間を短縮するために最適化されたクラウドネイティブのマイクロサービスのスイートです

複数の変革と AI 大手 Nvidia との協力を経て、なぜ Vanar Chain は 30 日間で 4.6 倍に急騰したのでしょうか?

Mar 14, 2024 pm 05:31 PM

複数の変革と AI 大手 Nvidia との協力を経て、なぜ Vanar Chain は 30 日間で 4.6 倍に急騰したのでしょうか?

Mar 14, 2024 pm 05:31 PM

最近、レイヤー1ブロックチェーンVanarChainは、その高い成長率とAI大手NVIDIAとの連携により市場の注目を集めています。 VanarChain の人気の背景には、複数のブランド変革を経たことに加え、メインゲーム、メタバース、AI などの人気コンセプトもプロジェクトに多くの人気と話題をもたらしたことです。変革前の Vanar (旧 TerraVirtua) は、有料サブスクリプションをサポートし、仮想現実 (VR) および拡張現実 (AR) コンテンツを提供し、暗号通貨による支払いを受け入れるプラットフォームとして 2018 年に設立されました。このプラットフォームは共同創設者の Gary Bracey と Jawad Ashraf によって作成されました。Gary Bracey はビデオ ゲームの制作と開発に携わった豊富な経験を持っています。

TrendForce: Nvidia の Blackwell プラットフォーム製品により、TSMC の CoWoS 生産能力は今年 150% 増加します

Apr 17, 2024 pm 08:00 PM

TrendForce: Nvidia の Blackwell プラットフォーム製品により、TSMC の CoWoS 生産能力は今年 150% 増加します

Apr 17, 2024 pm 08:00 PM

4月17日の当サイトのニュースによると、TrendForceは最近、Nvidiaの新しいBlackwellプラットフォーム製品に対する需要は強気で、2024年にはTSMCのCoWoSパッケージング総生産能力が150%以上増加すると予想されるレポートを発表した。 NVIDIA Blackwell の新しいプラットフォーム製品には、B シリーズ GPU と、NVIDIA 独自の GraceArm CPU を統合する GB200 アクセラレータ カードが含まれます。 TrendForce は、サプライチェーンが現在 GB200 について非常に楽観的であることを確認しており、2025 年の出荷台数は 100 万台を超え、Nvidia のハイエンド GPU の 40 ~ 50% を占めると予想されています。 Nvidiaは今年下半期にGB200やB100などの製品を提供する予定だが、上流のウェーハパッケージングではさらに複雑な製品を採用する必要がある。