11 月 16 日のニュースによると、Microsoft Ignite 2023 カンファレンスが本日開幕し、Nvidia の幹部がカンファレンスに出席し、TensorRT-LLM のアップデートと OpenAI Chat API のサポートの追加を発表しました。

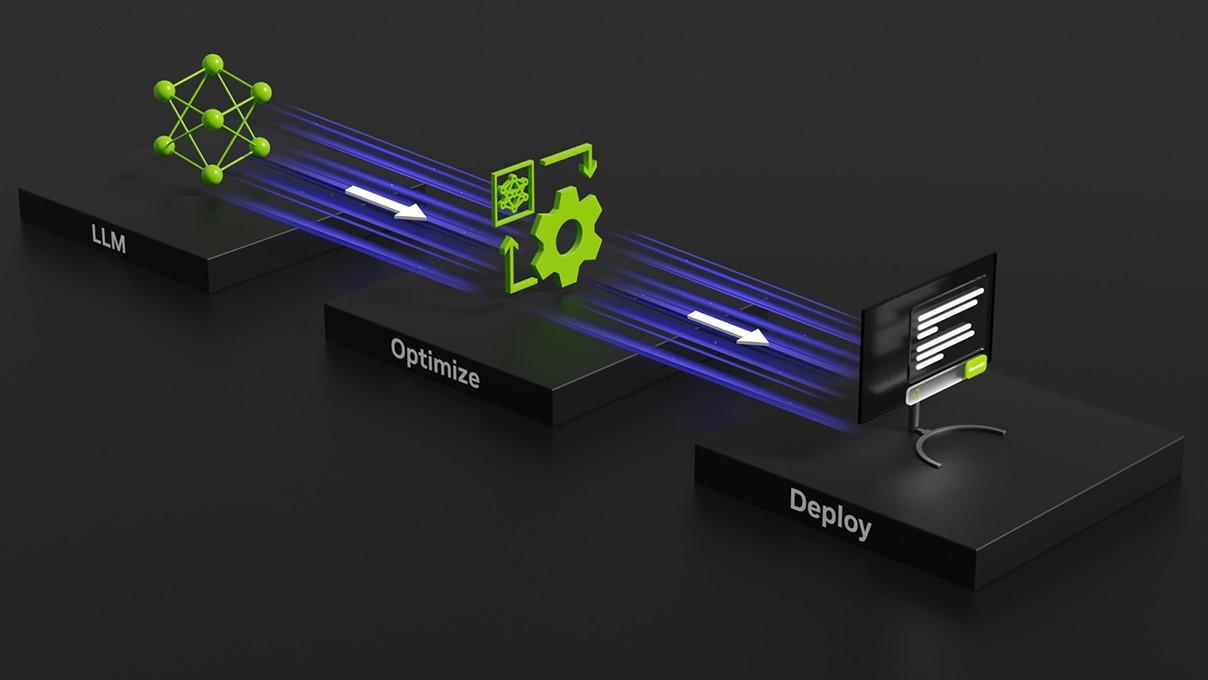

NVIDIA は、データ センターと Windows PC のサポートを目的として、今年 10 月に Tensor RT-LLM オープン ソース ライブラリをリリースしました。このオープンソース ライブラリの最大の特徴は、Windows PC に NVIDIA の GeForce RTX GPU が搭載されている場合、TensorRT-LLM により Windows PC 上での LLM の実行速度を 4 倍高速化できることです。 # #NVIDIA は、本日の Ignite 2023 カンファレンスで、TensorRT-LLM をアップデートし、OpenAI の Chat API サポートを追加し、DirectML 機能を強化して、Llama 2 や Stable Diffusion などの AI モデルのパフォーマンスを向上させることを発表しました。

ユーザーは、8 GB 以上のビデオ メモリを備えた GeForce RTX 30 シリーズおよび 40 シリーズ GPU で実行でき、一部のポータブル Windows デバイスでは高速で正確なネイティブ LLM 機能も使用できます

ユーザーは、8 GB 以上のビデオ メモリを備えた GeForce RTX 30 シリーズおよび 40 シリーズ GPU で実行でき、一部のポータブル Windows デバイスでは高速で正確なネイティブ LLM 機能も使用できます

以上がNVIDIA が TensorRT-LLM の新バージョンを発表: 推論機能が 5 倍に向上し、8GB 以上のグラフィックス カードでのローカル操作に適し、OpenAI の Chat API をサポートの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。