テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

プリンストンのオープンソース 34B 数学モデル: パラメータは半分、パフォーマンスは Google Minerva に匹敵し、550 億トークンが専門的なデータ トレーニングに使用されます

プリンストンのオープンソース 34B 数学モデル: パラメータは半分、パフォーマンスは Google Minerva に匹敵し、550 億トークンが専門的なデータ トレーニングに使用されます

プリンストンのオープンソース 34B 数学モデル: パラメータは半分、パフォーマンスは Google Minerva に匹敵し、550 億トークンが専門的なデータ トレーニングに使用されます

数学は科学の基礎として、常に研究と革新の重要な分野です。

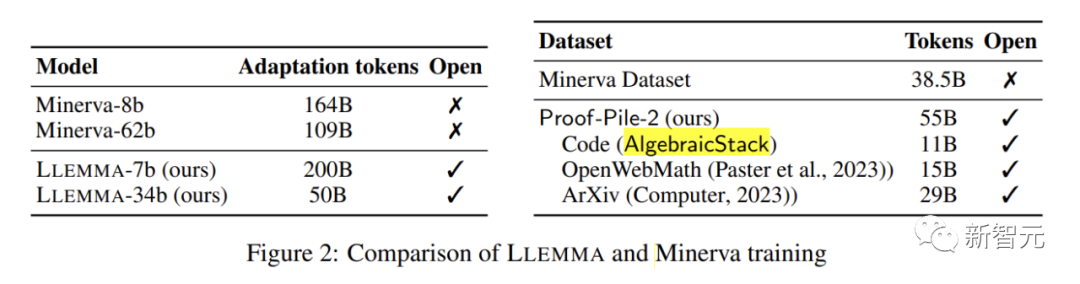

最近、プリンストン大学を含む 7 機関が共同で、Google Minerva 62B に匹敵するパフォーマンスを備えた数学に特化した大規模言語モデル LLEMMA をリリースし、そのモデル、データセット、コードを公開しました。数学研究に対する前例のない機会とリソース。

論文アドレス: https://arxiv.org/abs/2310.10631

データセット リンクアドレスは: https://huggingface.co/datasets/EleutherAI/proof-pile-2

プロジェクトのアドレス: https://github.com/EleutherAI/math-lm 書き直す必要があるのは次のとおりです。

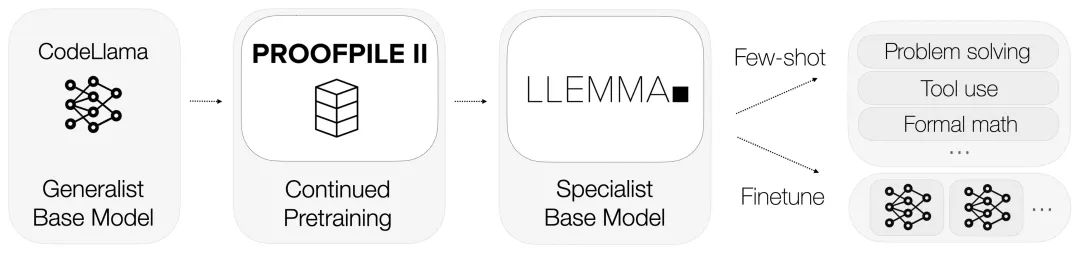

LLEMMA は Code Llama の基礎を継承しており、Proof-Pile-2 で事前トレーニングされています。

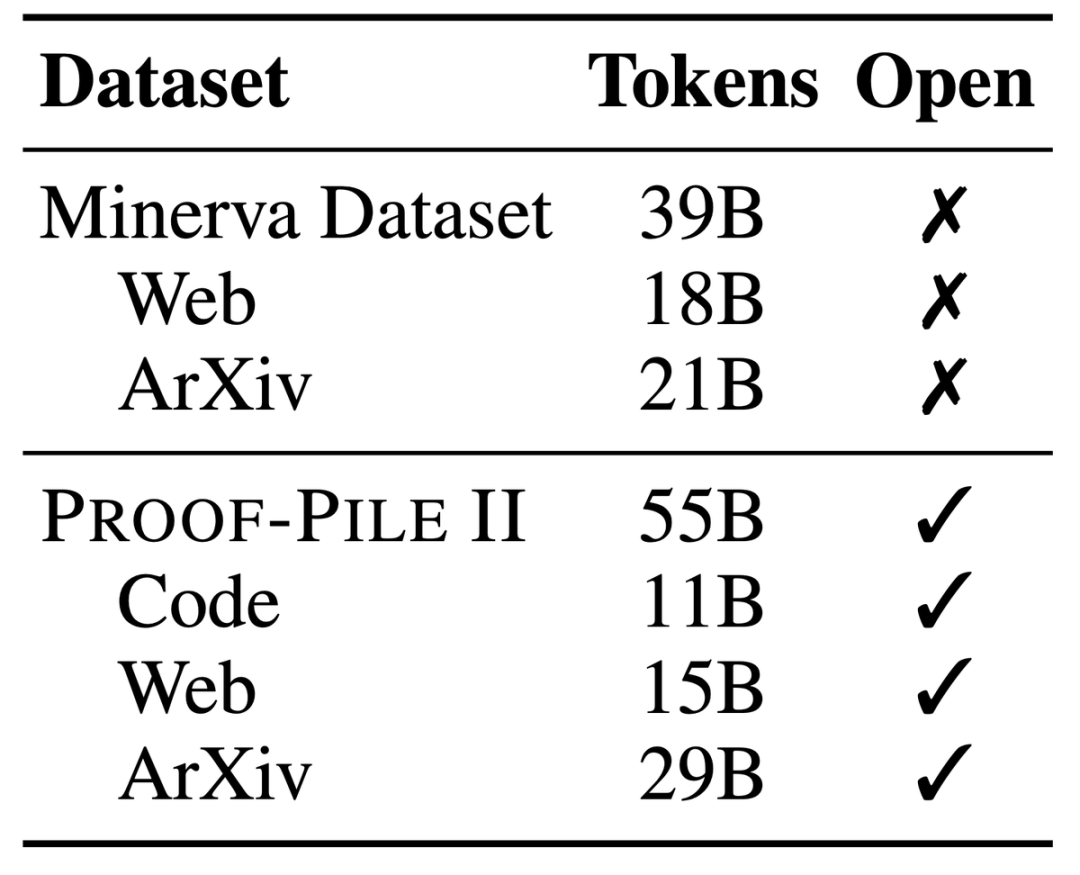

Proof-Pile-2 は巨大な混合データ セットであり、科学論文、数学的内容が豊富な Web データ、数学的コードなど、550 億個のトークンに関する情報が含まれています。

このデータ セットの一部である代数スタックには、17 の言語からの 11B のデータ セットがまとめられており、数値的、記号的、数学的な証明がカバーされています。

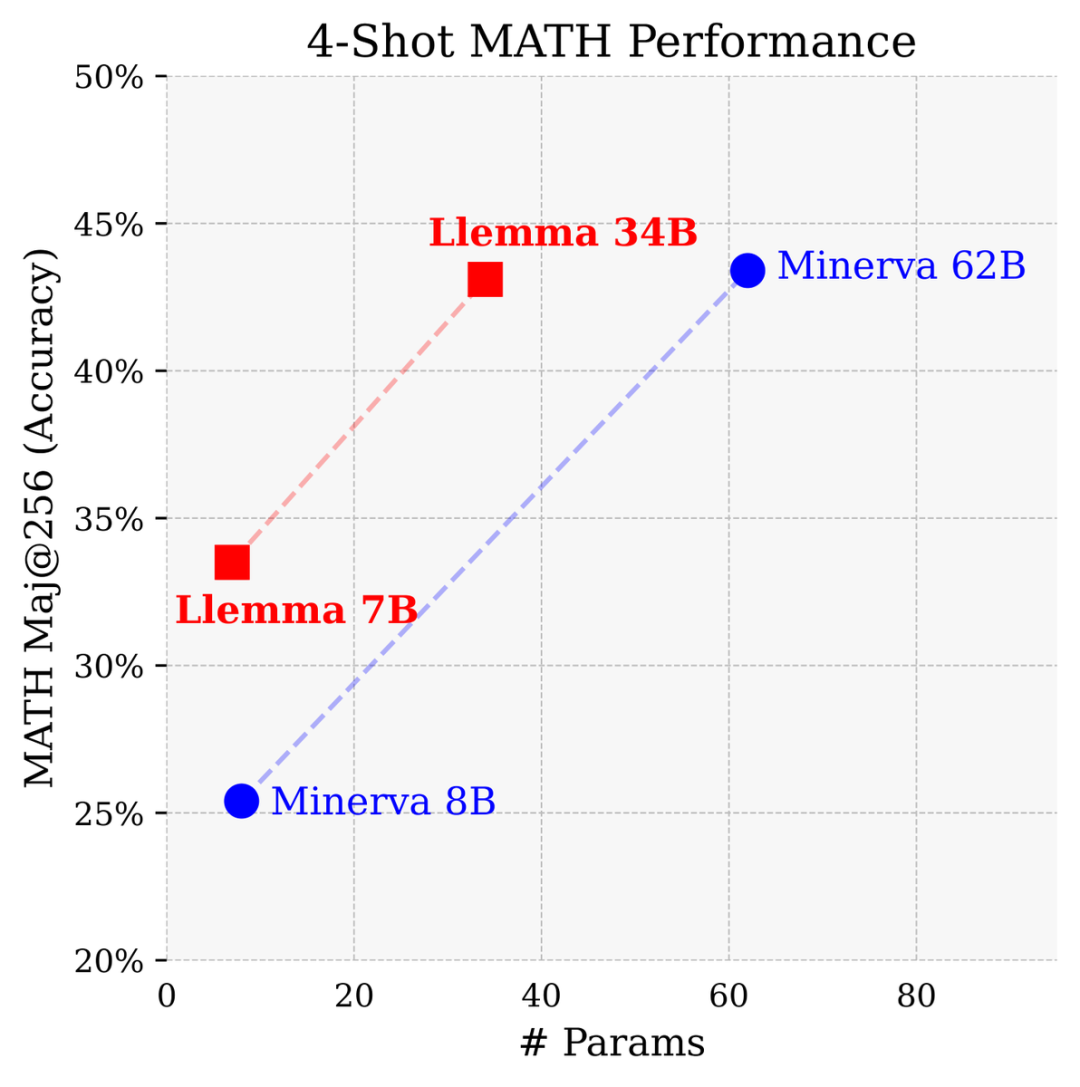

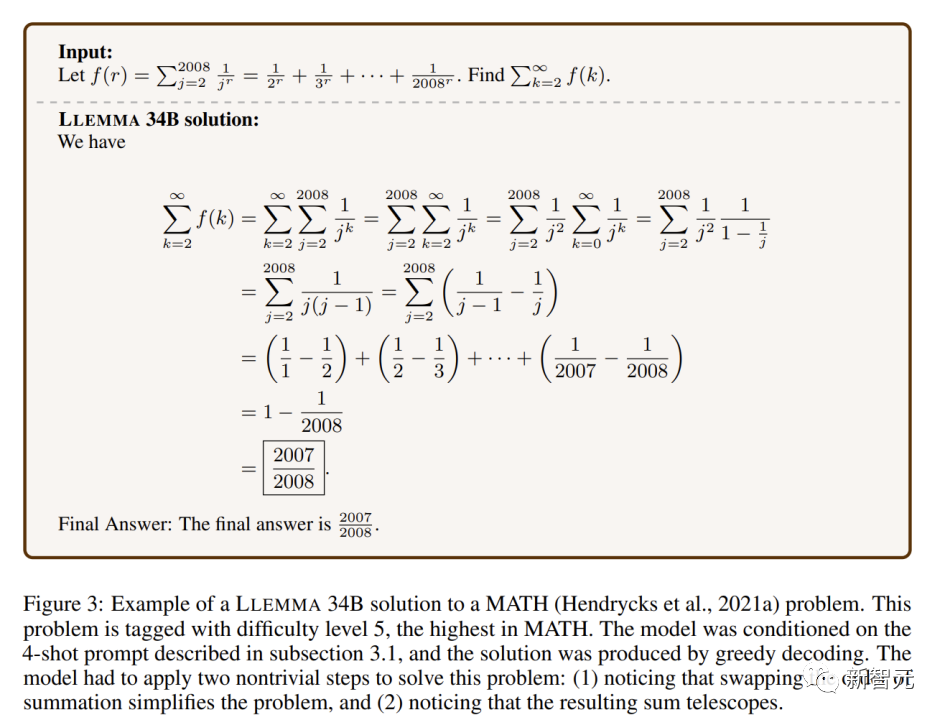

7 億 34 億のパラメータを備え、MATH ベンチマークで非常に優れたパフォーマンスを示し、既知のすべてのオープン ソース ベースを上回ります。モデル。

Google Research が開発した数学専用の閉じたモデルと比較すると、パラメータの数は Minerva 62B の半分しかありません条件としては、Llemma 34B がほぼ同等の性能を達成しました。

#Llemma は、パラメトリック ベースで問題を解決する際に Minerva のパフォーマンスを上回っています。計算ツールと形式的定理証明を使用して、数学的問題を解決するための無限の可能性を提供します

Python インタプリタと形式証明器を便利に使用でき、数学的問題を解決する能力をさらに実証します。

#図

研究者らはモデルの記憶効果を定量化しようとしましたが、驚くべきことに、トレーニング セットに現れる問題に対して Llemma の精度が向上していないことがわかりました。コードとデータは公開されているため、研究者らは他の人が分析を複製して拡張することを奨励しています

訓練資料和實驗配置

LLEMMA是一個專門用於數學的大型語言模型,它在Code Llama的基礎上繼續在Proof-Pile-2上進行預訓練。 Proof-Pile-2是一個包含科學論文、含有數學內容的網頁資料和數學程式碼的混合資料集,包含了550億個標記

AlgebraicStack的程式碼部分包含了11B的資料集,其中包括17種語言原始碼,覆蓋數值、符號和形式數學,並已公開發布

LLEMMA的每個模型都是由Code Llama進行初始化的。 Code Llama模型是僅包含解碼器的語言模型,它是從Llama 2進行初始化的

作者對Code Llama模型在Proof-Pile-2上進行了進一步的訓練,使用標準的自回歸語言建模目標。對於7B模型,作者進行了200B個標記的訓練,而對於34B模型,作者進行了50B個標記的訓練

評估方法和實驗結果

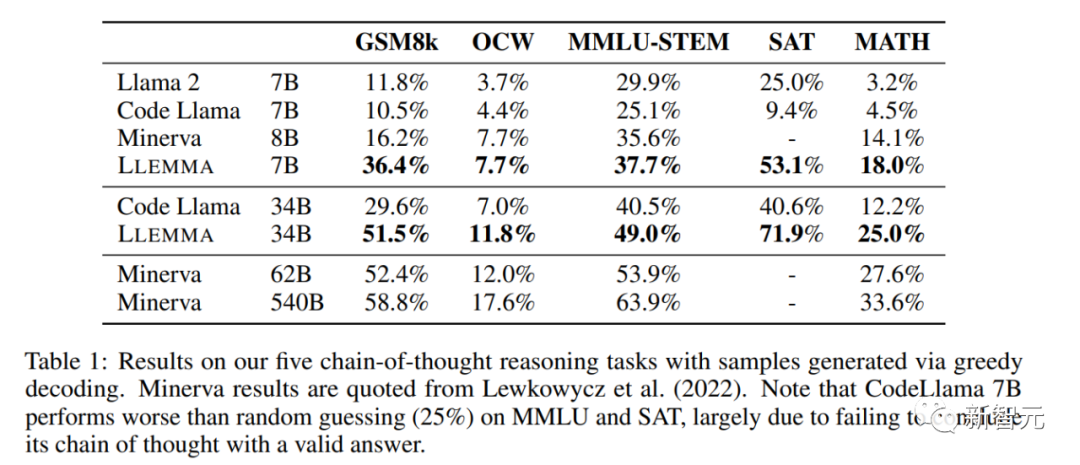

作者使用Proof-Pile-2對Code Llama進行繼續預訓練,並且在MATH和GSM8k等多個數學問題解決任務上對LLEMMA進行few-shot評估。

研究人員發現LLEMMA在這些任務上都有顯著的提升,並且能夠適應不同的問題類型和難度。

LLEMMA 34B在極高難度的數學問題中展示了比其他開放式基礎模型更強大的數學能力

在數學基準測試上,LLEMMA在Proof-Pile-2上的持續預訓練改善了五個數學基準測試的few-shot性能。

在GSM8k上,LLEMMA 34B的改進比Code Llama高出20個百分點,在MATH上高出13個百分點。而且,LLEMMA 7B也優於相似大小的專有的Minerva模型,證明了在Proof-Pile-2上進行預訓練能有效提高大模型的數學解題能力

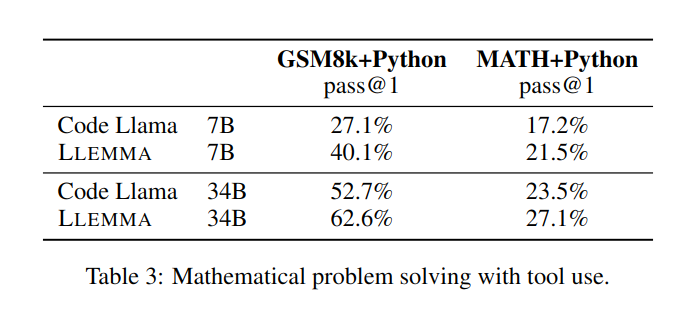

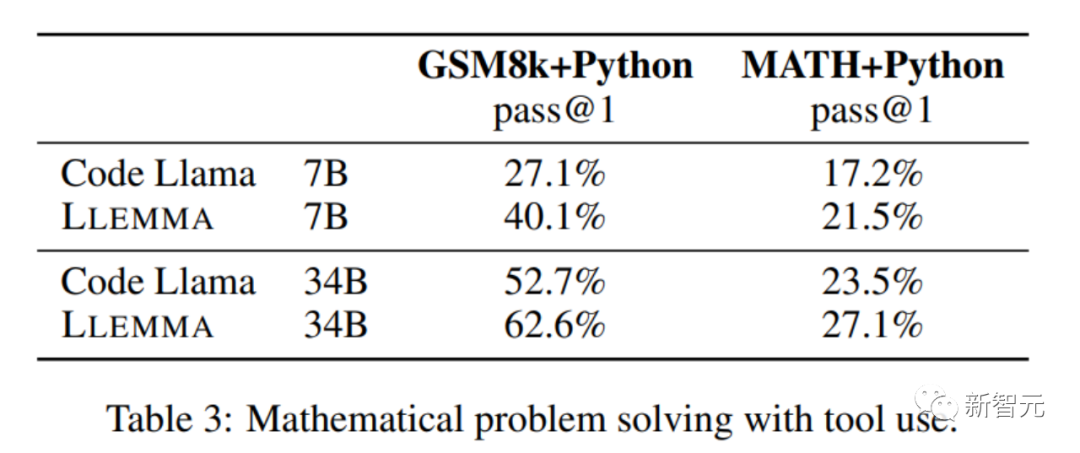

在解決數學問題時,利用計算工具如Python等,LLEMMA在MATH Python和GSM8k Python任務上都比Code Llama更出色

#在使用MATH和GSM8k資料集時,LLEMMA的效能優於沒有使用工具時的效能

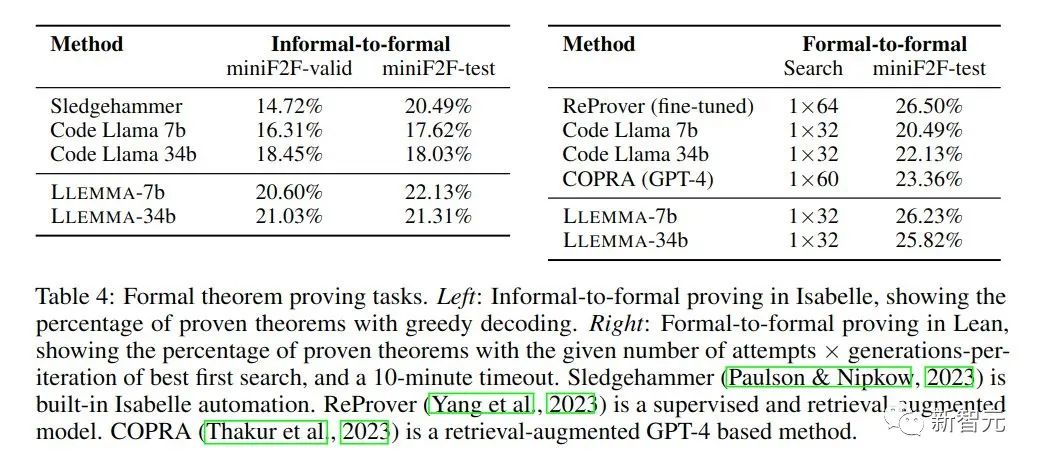

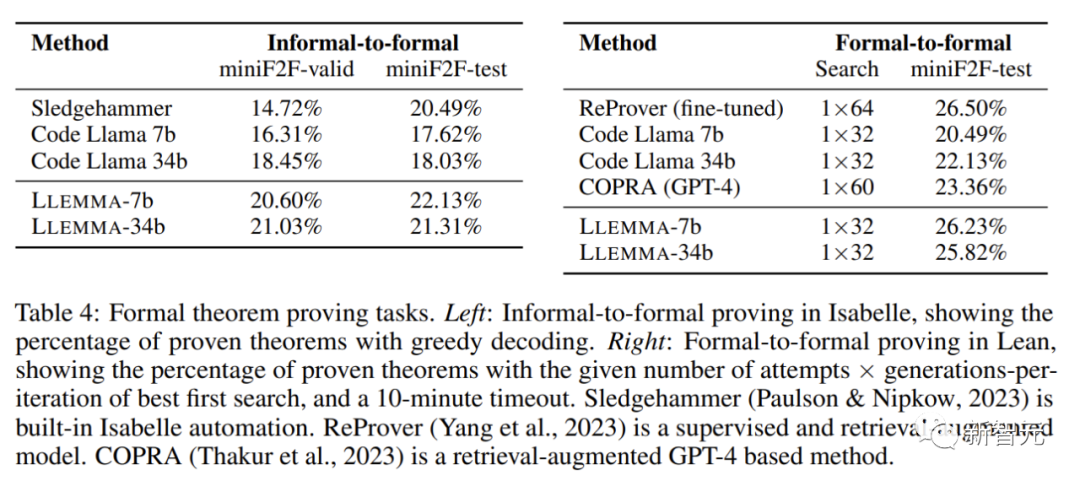

在數學證明任務中,LLEMMA表現出色

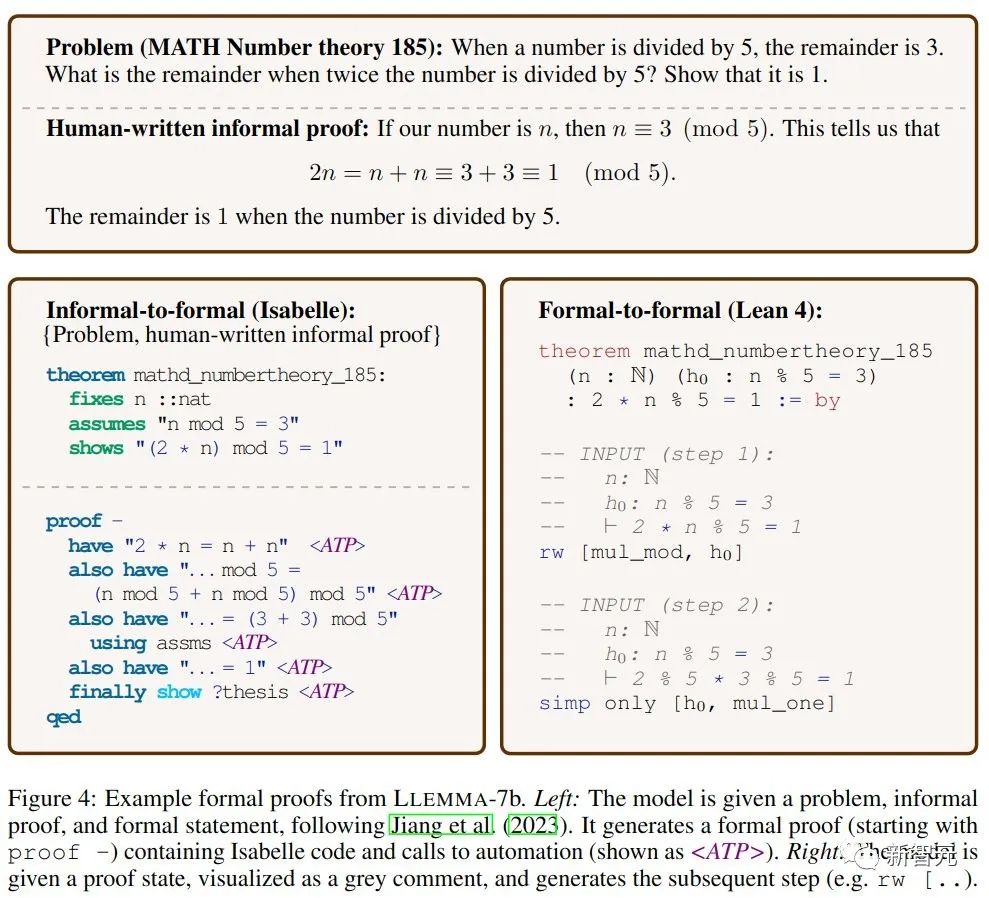

非正式到正式證明的任務目標是在給定一個正式陳述、一個非正式的LATEX陳述和一個非正式的LATEX證明的情況下,產生一個正式證明,然後透過證明助手進行驗證。

正式到正式證明則是透過產生一系列證明步驟(策略)來證明一個正式陳述。結果表明,LLEMMA在Proof-Pile-2上的持續預訓練改善了這兩個正式定理證明任務的few-shot表現。

LLEMMA不僅擁有令人矚目的效能、還開放了革命性的資料集、展現了驚人的問題解決能力。

開源共享的精神,標誌著數學界進入了一個新的時代。數學的未來在這裡,而我們每一個數學愛好者、研究者和教育者都將從中受益。

LLEMMA的出現為我們提供了前所未有的工具,讓數學問題的解決變得更有效率和創新。

此外,開放共享的概念也將促進全球科學研究社群更加深入的合作,共同推動科學的進步。

以上がプリンストンのオープンソース 34B 数学モデル: パラメータは半分、パフォーマンスは Google Minerva に匹敵し、550 億トークンが専門的なデータ トレーニングに使用されますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7717

7717

15

15

1641

1641

14

14

1396

1396

52

52

1289

1289

25

25

1233

1233

29

29

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

0.この記事は何をするのですか?私たちは、多用途かつ高速な最先端の生成単眼深度推定モデルである DepthFM を提案します。従来の深度推定タスクに加えて、DepthFM は深度修復などの下流タスクでも最先端の機能を実証します。 DepthFM は効率的で、いくつかの推論ステップ内で深度マップを合成できます。この作品について一緒に読みましょう〜 1. 論文情報タイトル: DepthFM: FastMonocularDepthEstimationwithFlowMatching 著者: MingGui、JohannesS.Fischer、UlrichPrestel、PingchuanMa、Dmytr

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhone のモバイル データ接続に遅延や遅い問題が発生していませんか?通常、携帯電話の携帯インターネットの強度は、地域、携帯ネットワークの種類、ローミングの種類などのいくつかの要因によって異なります。より高速で信頼性の高いセルラー インターネット接続を実現するためにできることがいくつかあります。解決策 1 – iPhone を強制的に再起動する 場合によっては、デバイスを強制的に再起動すると、携帯電話接続を含む多くの機能がリセットされるだけです。ステップ 1 – 音量を上げるキーを 1 回押して放します。次に、音量小キーを押して、もう一度放します。ステップ 2 – プロセスの次の部分は、右側のボタンを押し続けることです。 iPhone の再起動が完了するまで待ちます。セルラーデータを有効にし、ネットワーク速度を確認します。もう一度確認してください 修正 2 – データ モードを変更する 5G はより優れたネットワーク速度を提供しますが、信号が弱い場合はより適切に機能します

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

目標検出は自動運転システムにおいて比較的成熟した問題であり、その中でも歩行者検出は最も初期に導入されたアルゴリズムの 1 つです。ほとんどの論文では非常に包括的な研究が行われています。ただし、サラウンドビューに魚眼カメラを使用した距離認識については、あまり研究されていません。放射状の歪みが大きいため、標準のバウンディング ボックス表現を魚眼カメラに実装するのは困難です。上記の説明を軽減するために、拡張バウンディング ボックス、楕円、および一般的な多角形の設計を極/角度表現に探索し、これらの表現を分析するためのインスタンス セグメンテーション mIOU メトリックを定義します。提案された多角形モデルの FisheyeDetNet は、他のモデルよりも優れたパフォーマンスを示し、同時に自動運転用の Valeo 魚眼カメラ データセットで 49.5% の mAP を達成しました。

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません