テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

新技術の発表、IDEA Research Institute が T-Rex モデルをリリース、ユーザーが画像上で直接「プロンプト」プロンプトを選択できるようになりました

新技術の発表、IDEA Research Institute が T-Rex モデルをリリース、ユーザーが画像上で直接「プロンプト」プロンプトを選択できるようになりました

新技術の発表、IDEA Research Institute が T-Rex モデルをリリース、ユーザーが画像上で直接「プロンプト」プロンプトを選択できるようになりました

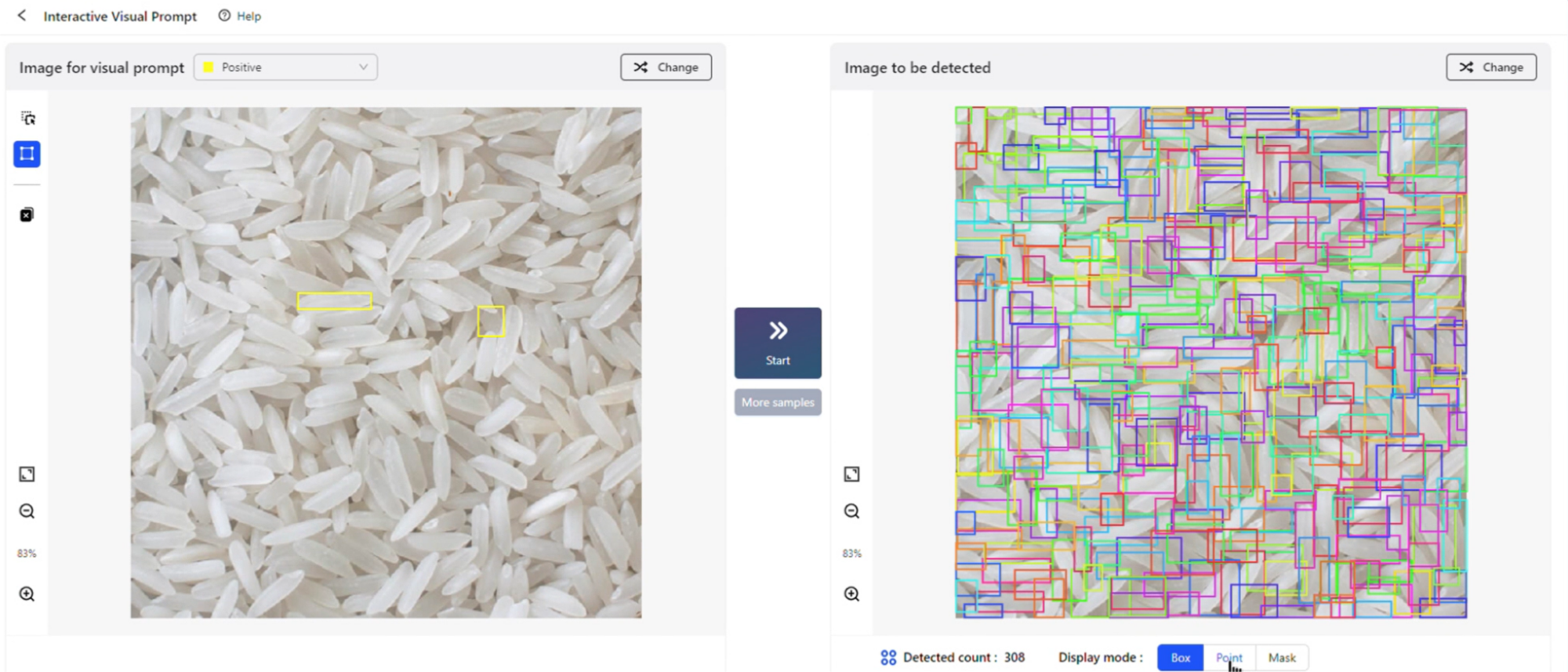

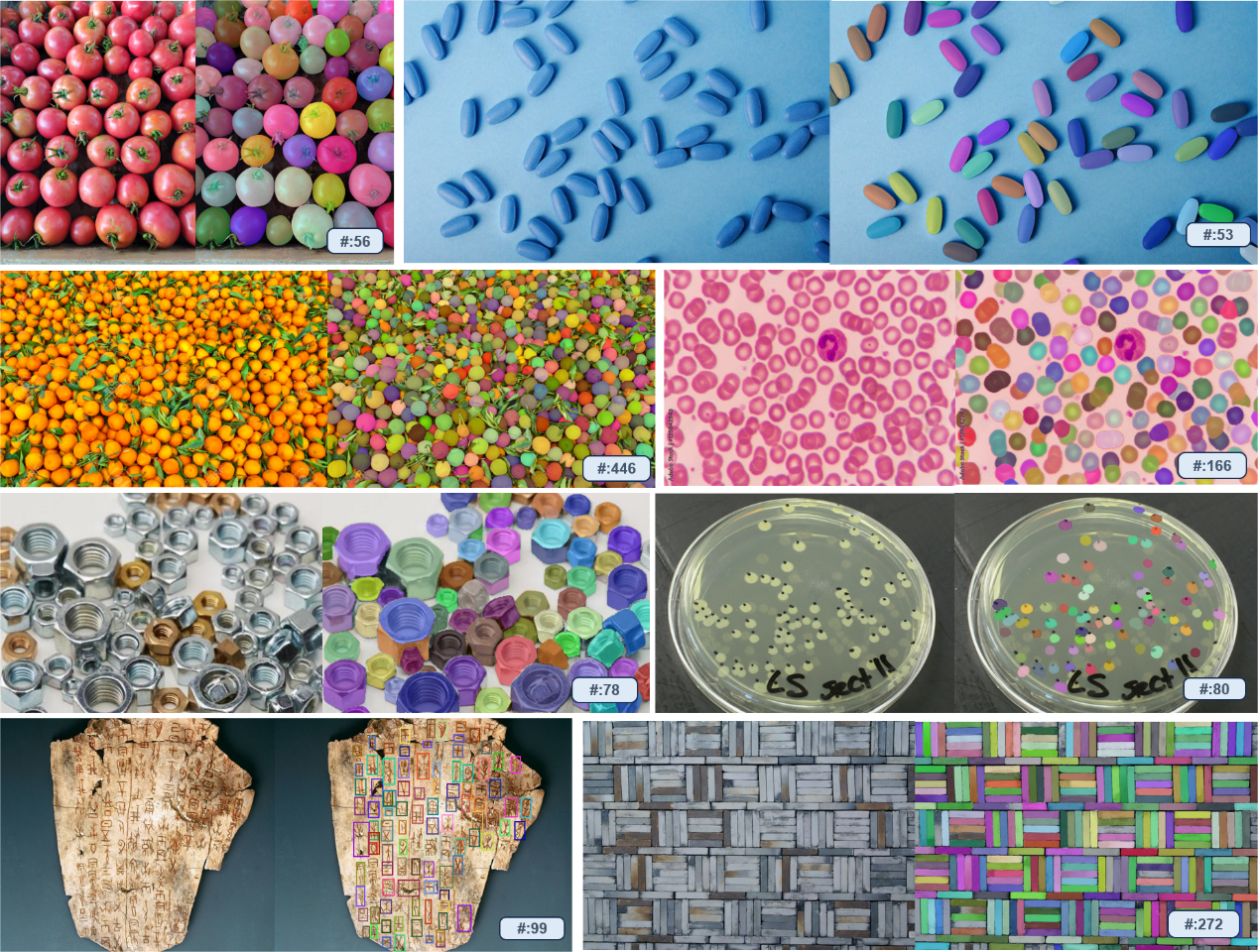

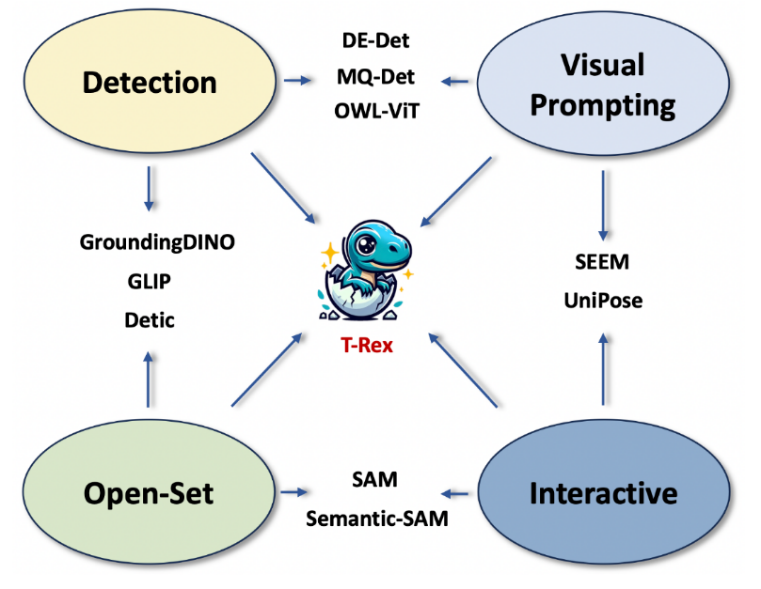

Grounded SAM の人気を受けて、IDEA Research Institute チーム が大ヒット作を携えて戻ってきました。新しいビジュアル プロンプト(ビジュアル プロンプト)モデルT-Rexx、特定されました画像による 箱から出してすぐに使えるフィギュア、 は、開集合検出の新しい世界を開きます。 ボックスを引いて検出し、完了です。閉幕したばかりの2023年のIDEAカンファレンスで、IDEA研究所の創設会長で国家工程院の外国人学者でもある沈祥陽氏は、視覚的な合図に基づく新しい目標検出体験をデモンストレーションし、新しい目標のモデル実験室(遊び場)を公開した。視覚キュー モデル T-Rex )、インタラクティブ ビジュアル プロンプト (iVP) は、現場で裁判のクライマックスの波を引き起こします。

は、開集合検出の新しい世界を開きます。 ボックスを引いて検出し、完了です。閉幕したばかりの2023年のIDEAカンファレンスで、IDEA研究所の創設会長で国家工程院の外国人学者でもある沈祥陽氏は、視覚的な合図に基づく新しい目標検出体験をデモンストレーションし、新しい目標のモデル実験室(遊び場)を公開した。視覚キュー モデル T-Rex )、インタラクティブ ビジュアル プロンプト (iVP) は、現場で裁判のクライマックスの波を引き起こします。

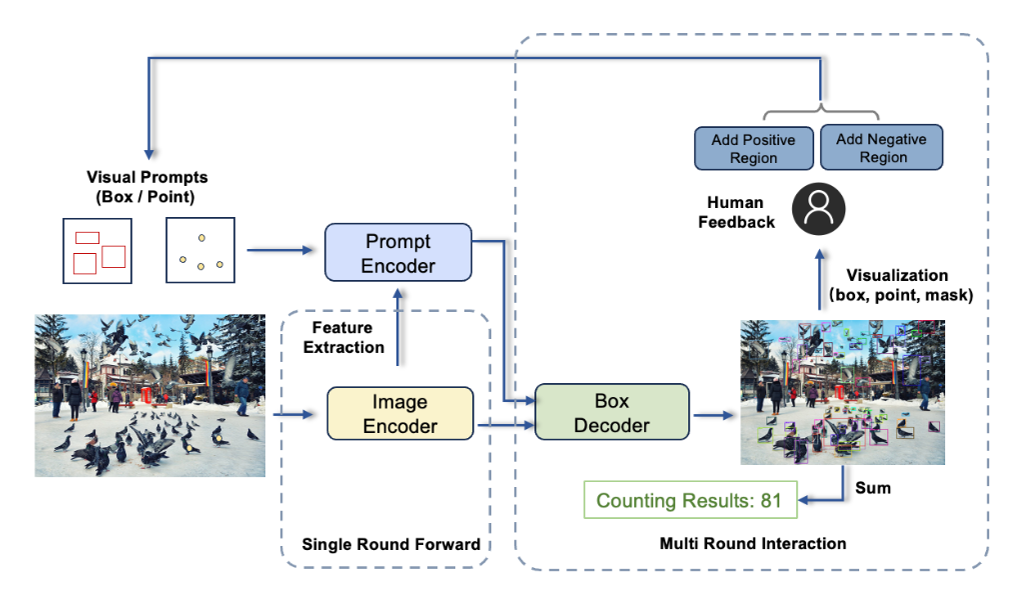

iVP では、ユーザーは個人的に「百聞は一見に如かず」というプロンプト エクスペリエンスのロックを解除できます。画像上の関心のあるオブジェクトにマークを付け、モデルに視覚的な例を提供し、モデルはターゲット画像内の類似したインスタンスをすべて検出します。プロセス全体は対話型で、わずか数ステップで簡単に完了できます。

iVP では、ユーザーは個人的に「百聞は一見に如かず」というプロンプト エクスペリエンスのロックを解除できます。画像上の関心のあるオブジェクトにマークを付け、モデルに視覚的な例を提供し、モデルはターゲット画像内の類似したインスタンスをすべて検出します。プロセス全体は対話型で、わずか数ステップで簡単に完了できます。

アイデア総研が 4 月にリリースした Grounded SAM (Grounding DINO SAM) は、かつて Github で非常に人気があり、これまでに 11,000 個のスターを集めています。テキストプロンプトのみをサポートするGrounded SAMとは異なり、今回リリースされたT-Rexモデルは、強力なインタラクションの作成に重点を置いたビジュアルプロンプト機能を提供します。

アイデア総研が 4 月にリリースした Grounded SAM (Grounding DINO SAM) は、かつて Github で非常に人気があり、これまでに 11,000 個のスターを集めています。テキストプロンプトのみをサポートするGrounded SAMとは異なり、今回リリースされたT-Rexモデルは、強力なインタラクションの作成に重点を置いたビジュアルプロンプト機能を提供します。

T-Rex は、すぐに使える強力な機能を備えており、再トレーニングや微調整を行わずに、トレーニング段階でモデルが一度も見たことのないオブジェクトを検出できます。このモデルは、カウントを含むすべての検出タスクに適用できるだけでなく、インテリジェントなインタラクティブな注釈シナリオのための新しいソリューションも提供します。

#チームは、視覚的プロンプト技術の開発が実際のシーンにおける問題点の観察から得られたことを明らかにしました。一部のパートナーは、ビジュアル モデルを使用してトラック上の商品の数を数えたいと考えていますが、このモデルではテキスト プロンプトだけでは各商品を個別に識別できません。その理由は、産業シーンでのオブジェクトは日常生活では稀であり、言葉で説明するのが難しいためです。この場合、視覚的な手がかりの方が明らかに効率的なアプローチです。同時に、直感的な視覚フィードバックと強力な対話性も、検出の効率と精度の向上に役立ちます。

#チームは、視覚的プロンプト技術の開発が実際のシーンにおける問題点の観察から得られたことを明らかにしました。一部のパートナーは、ビジュアル モデルを使用してトラック上の商品の数を数えたいと考えていますが、このモデルではテキスト プロンプトだけでは各商品を個別に識別できません。その理由は、産業シーンでのオブジェクトは日常生活では稀であり、言葉で説明するのが難しいためです。この場合、視覚的な手がかりの方が明らかに効率的なアプローチです。同時に、直感的な視覚フィードバックと強力な対話性も、検出の効率と精度の向上に役立ちます。

実際の使用要件に関する洞察に基づいて、チームは、複数の視覚的プロンプトを受け入れ、複数の画像にわたってプロンプトを表示できるモデルとして T-Rex を設計しました。最も基本的なシングルラウンド プロンプト モードに加えて、現在のモデルは次の 3 つの高度なモードもサポートしています。

- 肯定的な例と否定的な例モード:視覚的なプロンプトが曖昧で誤検出を引き起こすシナリオに適しています

- クロスピクチャ モード:次のような場合に適しています単一の参照画像を通じて検出を促す 彼が描いたシーン

- 同時に発表された技術レポートで、チームはティラノサウルス モデルの 4 つの主な特徴を要約しました:

- ビジュアル プロンプト: 視覚的な例を使用して検出ターゲットを指定し、まれに発生する問題を克服します。複雑なオブジェクトは言葉で完全に表現することが難しいため、迅速な効率が向上します。

- 直観的な視覚フィードバック: 境界ボックスなどの直観的な視覚フィードバックを提供して、ユーザーが検出結果を効率的に評価できるようにします

- 対話性: ユーザーは次のことができます。検出プロセスに便利に参加し、モデルの結果を正確に修正

- 研究チームは、ターゲット検出シナリオでは、視覚的な手がかりを追加することでテキスト キューの欠点の一部を補うことができると指摘しました。将来的には、この 2 つを組み合わせることで、より垂直な分野で CV テクノロジーの可能性がさらに解き放たれるでしょう。

ティラノサウルスモデルの技術的な詳細については、同時公開のテクニカルレポートをご参照ください。

iVPモデル ラボ: https://deepdataspace.com/playground/ivp

Github リンク: trex-counting.github.io

この作品は、IDEA Institute のコンピューター ビジョンおよびロボティクス研究センターから提供されました。チームの以前のオープンソース ターゲット検出モデル DINO は、COCO ターゲット検出ランキングで 1 位を獲得した最初の DETR モデルでした。Github で非常に人気のあるゼロショット検出器 Grounding DINO と、DINO はあらゆるオブジェクトを検出してセグメント化できます。グラウンデッド SAM、またこのチームの仕事

以上が新技術の発表、IDEA Research Institute が T-Rex モデルをリリース、ユーザーが画像上で直接「プロンプト」プロンプトを選択できるようになりましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7547

7547

15

15

1382

1382

52

52

83

83

11

11

22

22

90

90

パデュー大学による、時間をかける価値のある拡散モデルのチュートリアル

Apr 07, 2024 am 09:01 AM

パデュー大学による、時間をかける価値のある拡散モデルのチュートリアル

Apr 07, 2024 am 09:01 AM

拡散はより良いものを模倣するだけでなく、「創造」することもできます。拡散モデル(DiffusionModel)は、画像生成モデルである。 AI 分野でよく知られている GAN や VAE などのアルゴリズムと比較すると、拡散モデルは異なるアプローチを採用しており、その主な考え方は、最初に画像にノイズを追加し、その後徐々にノイズを除去するプロセスです。ノイズを除去して元の画像を復元する方法は、アルゴリズムの中核部分です。最後のアルゴリズムは、ランダムなノイズを含む画像から画像を生成できます。近年、生成 AI の驚異的な成長により、テキストから画像への生成、ビデオ生成など、多くのエキサイティングなアプリケーションが可能になりました。これらの生成ツールの背後にある基本原理は、以前の方法の制限を克服する特別なサンプリング メカニズムである拡散の概念です。

ワンクリックでPPTを生成!キミ: まずは「PPT出稼ぎ労働者」を普及させましょう

Aug 01, 2024 pm 03:28 PM

ワンクリックでPPTを生成!キミ: まずは「PPT出稼ぎ労働者」を普及させましょう

Aug 01, 2024 pm 03:28 PM

キミ: たった 1 文の PPT がわずか 10 秒で完成します。 PPTはとても面倒です!会議を開催するには PPT が必要であり、週次報告書を作成するには PPT が必要であり、投資を勧誘するには PPT を提示する必要があり、不正行為を告発するには PPT を送信する必要があります。大学は、PPT 専攻を勉強するようなものです。授業中に PPT を見て、授業後に PPT を行います。おそらく、デニス オースティンが 37 年前に PPT を発明したとき、PPT がこれほど普及する日が来るとは予想していなかったでしょう。 PPT 作成の大変な経験を話すと涙が出ます。 「20 ページを超える PPT を作成するのに 3 か月かかり、何十回も修正しました。PPT を見ると吐きそうになりました。」 「ピーク時には 1 日に 5 枚の PPT を作成し、息をすることさえありました。」 PPTでした。」 即席の会議をするなら、そうすべきです

CVPR 2024 のすべての賞が発表されました!オフラインでのカンファレンスには1万人近くが参加し、Googleの中国人研究者が最優秀論文賞を受賞した

Jun 20, 2024 pm 05:43 PM

CVPR 2024 のすべての賞が発表されました!オフラインでのカンファレンスには1万人近くが参加し、Googleの中国人研究者が最優秀論文賞を受賞した

Jun 20, 2024 pm 05:43 PM

北京時間6月20日早朝、シアトルで開催されている最高の国際コンピュータビジョンカンファレンス「CVPR2024」が、最優秀論文やその他の賞を正式に発表した。今年は、最優秀論文 2 件と学生優秀論文 2 件を含む合計 10 件の論文が賞を受賞しました。また、最優秀論文ノミネートも 2 件、学生優秀論文ノミネートも 4 件ありました。コンピュータービジョン (CV) 分野のトップカンファレンスは CVPR で、毎年多数の研究機関や大学が集まります。統計によると、今年は合計 11,532 件の論文が投稿され、2,719 件が採択され、採択率は 23.6% でした。ジョージア工科大学による CVPR2024 データの統計分析によると、研究テーマの観点から最も論文数が多いのは画像とビデオの合成と生成です (Imageandvideosyn

ベアメタルから 700 億のパラメータを備えた大規模モデルまで、チュートリアルとすぐに使えるスクリプトがここにあります

Jul 24, 2024 pm 08:13 PM

ベアメタルから 700 億のパラメータを備えた大規模モデルまで、チュートリアルとすぐに使えるスクリプトがここにあります

Jul 24, 2024 pm 08:13 PM

LLM が大量のデータを使用して大規模なコンピューター クラスターでトレーニングされていることはわかっています。このサイトでは、LLM トレーニング プロセスを支援および改善するために使用される多くの方法とテクノロジが紹介されています。今日、私たちが共有したいのは、基礎となるテクノロジーを深く掘り下げ、オペレーティング システムさえ持たない大量の「ベア メタル」を LLM のトレーニング用のコンピューター クラスターに変える方法を紹介する記事です。この記事は、機械がどのように考えるかを理解することで一般的な知能の実現に努めている AI スタートアップ企業 Imbue によるものです。もちろん、オペレーティング システムを持たない大量の「ベア メタル」を LLM をトレーニングするためのコンピューター クラスターに変換することは、探索と試行錯誤に満ちた簡単なプロセスではありませんが、Imbue は最終的に 700 億のパラメータを備えた LLM のトレーニングに成功しました。プロセスが蓄積する

C言語学習を始めるためのプログラミングソフト5選

Feb 19, 2024 pm 04:51 PM

C言語学習を始めるためのプログラミングソフト5選

Feb 19, 2024 pm 04:51 PM

C言語は広く使われているプログラミング言語であり、コンピュータプログラミングを志す人にとって必ず学ばなければならない基本的な言語の一つです。ただし、初心者にとって、特に関連する学習ツールや教材が不足しているため、新しいプログラミング言語を学習するのは難しい場合があります。この記事では、C言語初心者がすぐに始められるプログラミングソフトを5つ紹介します。最初のプログラミング ソフトウェアは Code::Blocks でした。 Code::Blocks は、無料のオープンソース統合開発環境 (IDE) です。

PyCharm Community Edition インストール ガイド: すべての手順をすばやくマスターする

Jan 27, 2024 am 09:10 AM

PyCharm Community Edition インストール ガイド: すべての手順をすばやくマスターする

Jan 27, 2024 am 09:10 AM

PyCharm コミュニティ版のクイック スタート: 詳細なインストール チュートリアル 完全な分析 はじめに: PyCharm は、開発者が Python コードをより効率的に作成できるようにする包括的なツール セットを提供する強力な Python 統合開発環境 (IDE) です。この記事では、PyCharm Community Edition のインストール方法を詳しく紹介し、初心者がすぐに使い始めるのに役立つ具体的なコード例を示します。ステップ 1: PyCharm Community Edition をダウンロードしてインストールする PyCharm を使用するには、まず公式 Web サイトからダウンロードする必要があります

AIの活用 | AIが一人暮らしの女の子の生活ビデオブログを作成、3日間で数万件の「いいね!」を獲得

Aug 07, 2024 pm 10:53 PM

AIの活用 | AIが一人暮らしの女の子の生活ビデオブログを作成、3日間で数万件の「いいね!」を獲得

Aug 07, 2024 pm 10:53 PM

Machine Power Report 編集者: Yang Wen 大型モデルや AIGC に代表される人工知能の波は、私たちの生活や働き方を静かに変えていますが、ほとんどの人はまだその使い方を知りません。そこで、直感的で興味深く、簡潔な人工知能のユースケースを通じてAIの活用方法を詳しく紹介し、皆様の思考を刺激するコラム「AI in Use」を立ち上げました。また、読者が革新的な実践的な使用例を提出することも歓迎します。ビデオリンク: https://mp.weixin.qq.com/s/2hX_i7li3RqdE4u016yGhQ 最近、Xiaohongshu で一人暮らしの女の子の生活 vlog が人気になりました。イラスト風のアニメーションといくつかの癒しの言葉を組み合わせれば、数日で簡単に習得できます。

技術初心者必読:C言語とPythonの難易度分析

Mar 22, 2024 am 10:21 AM

技術初心者必読:C言語とPythonの難易度分析

Mar 22, 2024 am 10:21 AM

タイトル: 技術初心者必読: 具体的なコード例を必要とする C 言語と Python の難易度分析 今日のデジタル時代において、プログラミング技術はますます重要な能力となっています。ソフトウェア開発、データ分析、人工知能などの分野で働きたい場合でも、単に興味があってプログラミングを学びたい場合でも、適切なプログラミング言語を選択することが最初のステップです。数あるプログラミング言語の中でも、C言語とPythonは広く使われているプログラミング言語であり、それぞれに独自の特徴があります。この記事ではC言語とPythonの難易度を分析します。