言い換えられたタイトルは次のとおりです: ByteDance と華東師範大学との協力: 小型モデルの文脈学習機能の探索

大規模言語モデル (LLM) は、モデルの微調整を必要とせずに、文脈学習を通じて少数の例から学習できることはよく知られています。現在、この文脈学習現象は大規模モデルでのみ観察できます。たとえば、GPT-4 や Llama などの大規模モデルは多くの分野で優れたパフォーマンスを示していますが、リソースの制約や高いリアルタイム要件のため、大規模なモデルは多くのシナリオで使用できません

#では、通常サイズのモデルにもこの機能はあるのでしょうか?小型モデルのコンテキスト学習機能を調査するために、Byte 大学と華東師範大学の研究チームは、シーン テキスト認識タスクに関する研究を実施しました。

現在、実際の応用シナリオでは、シーン テキスト認識は、さまざまなシーン、テキスト レイアウト、変形、照明の変更、ぼやけた書き込み、フォントの多様性など、さまざまな課題に直面しています。すべてのシナリオを処理できる統合テキスト認識モデルをトレーニングするのは困難です。

#この問題を解決する直接的な方法は、対応するデータを収集し、特定のシナリオでモデルを微調整することです。ただし、このプロセスにはモデルの再トレーニングが必要であり、計算量が多く、さまざまなシナリオに適応するために複数のモデルの重みを保存する必要があります。テキスト認識モデルにコンテキスト学習機能があれば、新しいシナリオに直面したときに、新しいシナリオでのパフォーマンスを向上させるためのプロンプトとして少量の注釈付きデータのみが必要となり、上記の問題が解決されます。ただし、シーンのテキスト認識はリソースに依存するタスクであり、大規模なモデルをテキスト認識装置として使用すると、大量のリソースが消費されます。研究者らは、予備的な実験観察を通じて、従来の大規模モデルのトレーニング方法がシーンのテキスト認識タスクには適していないことを発見しました。この問題を解決するために、ByteDance と華東師範大学の研究チームは、自己進化型テキスト認識装置 E2STR (Ego-Evolving Scene Text Recognizer) を提案しました。これは、コンテキスト学習機能を組み込んだ通常サイズのテキスト認識ツールであり、微調整を必要とせずに、さまざまなテキスト認識シナリオにすぐに適応できます。論文リンク: https://arxiv.org/pdf/2311.13120.pdf

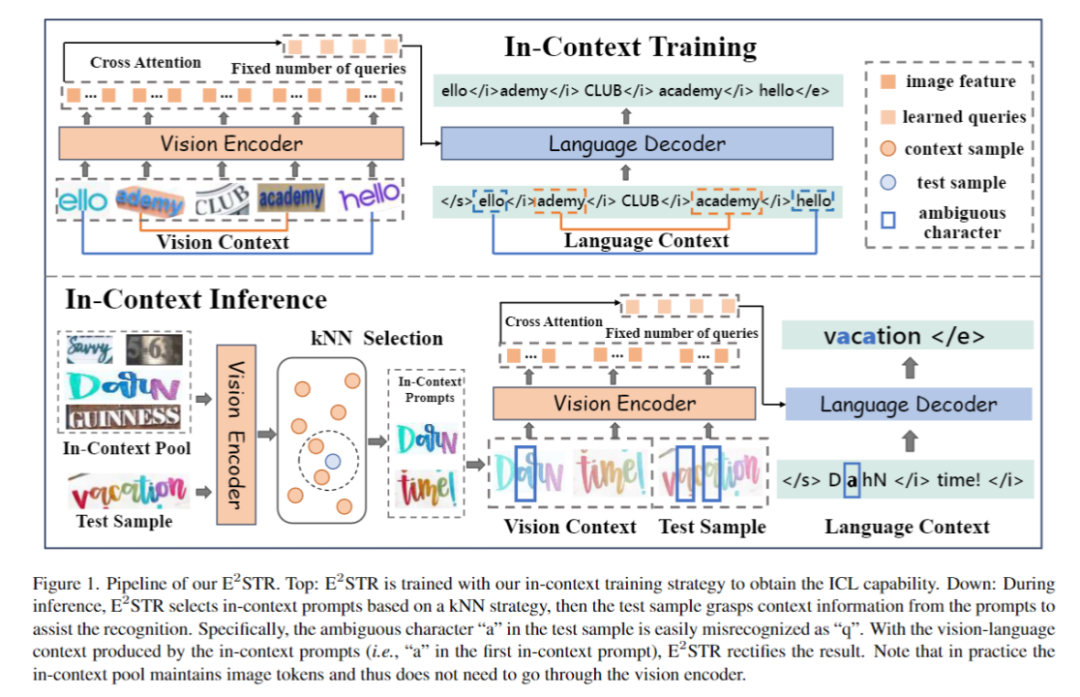

E2STR には、従来のデータで SOTA レベルに達するだけでなく、コンテキスト トレーニングおよびコンテキスト推論モードが装備されています。を設定しており、単一のモデルを使用してさまざまなシナリオでの認識パフォーマンスを向上させ、新しいシナリオへの迅速な適応を達成でき、微調整後の専用モデルの認識パフォーマンスを超えることさえあります。 E2STR は、テキスト認識タスクで効果的なコンテキスト学習機能を実現するには通常サイズのモデルで十分であることを示しています。

図 1 に、E2STR のトレーニングと推論のプロセスを示します。

#1. 基本的なテキスト認識トレーニング

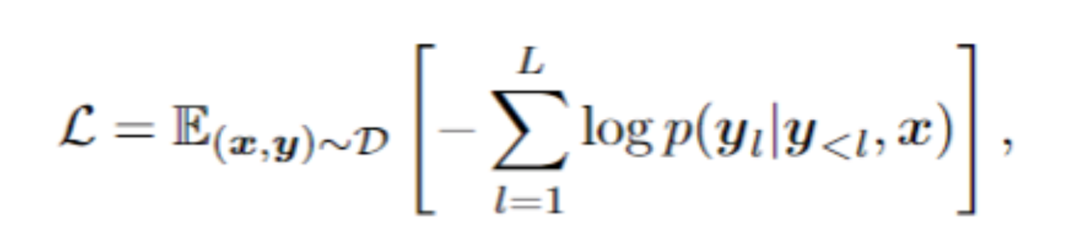

#基本的なテキスト認識トレーニング フェーズでは、自己回帰フレームワークを使用してビジュアル エンコーダーと言語デコーダ、目的はテキスト認識機能を取得することです:

#2. コンテキスト トレーニング

コンテキスト トレーニング フェーズ E2STR は、この記事で提案されているコンテキスト トレーニング パラダイムに従ってさらにトレーニングされます。この段階で、E2STR はさまざまなサンプル間のつながりを理解し、文脈上の手がかりから推論する能力を獲得します。

#図 2 に示すように、この記事では、シーン テキスト データをランダムにセグメント化して変換し、一連の「サブサンプル」を生成する ST 戦略を提案します。 。サブサンプルは視覚的にも言語的にも本質的にリンクされています。これらの本質的に関連するサンプルはシーケンスに結合され、モデルはこれらの意味的に豊富なシーケンスからコンテキストの知識を学習し、それによってコンテキストを学習する能力を獲得します。このステージでは、トレーニングに自己回帰フレームワークも使用します:

書き直す必要がある内容は次のとおりです: 3. 文脈に基づく推論

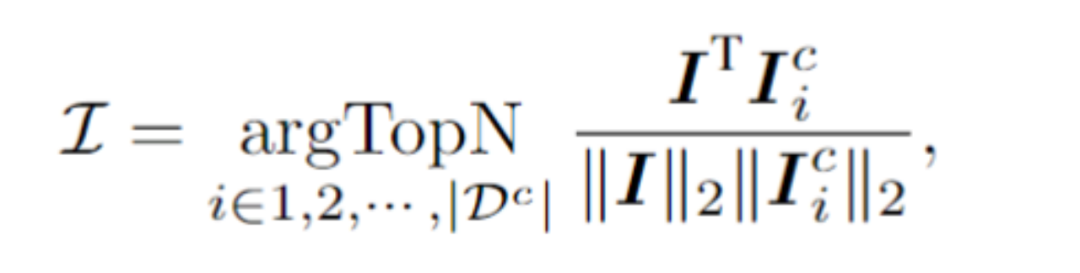

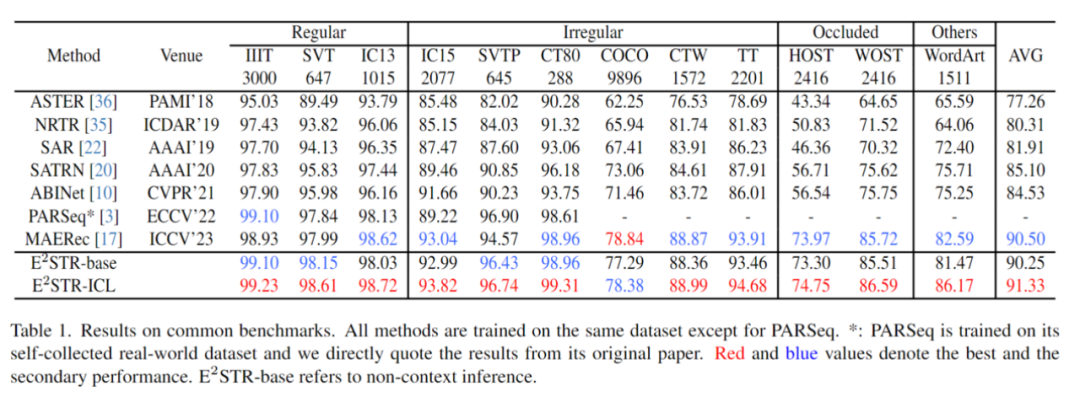

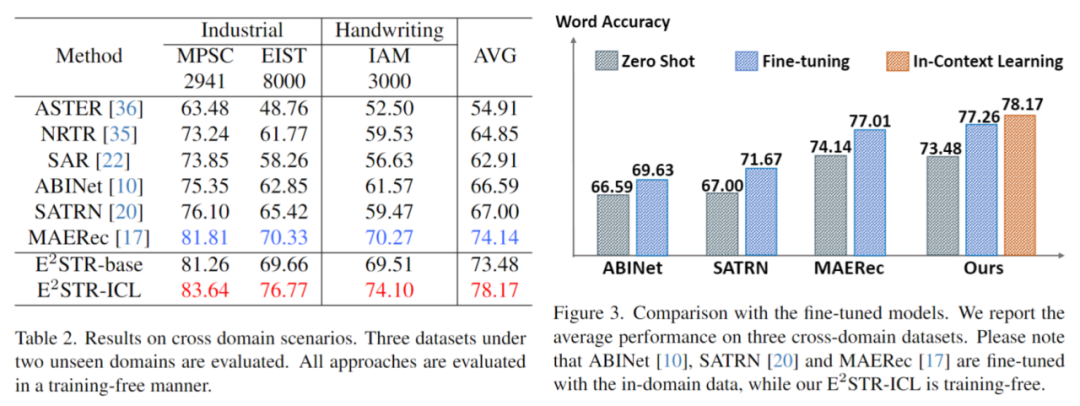

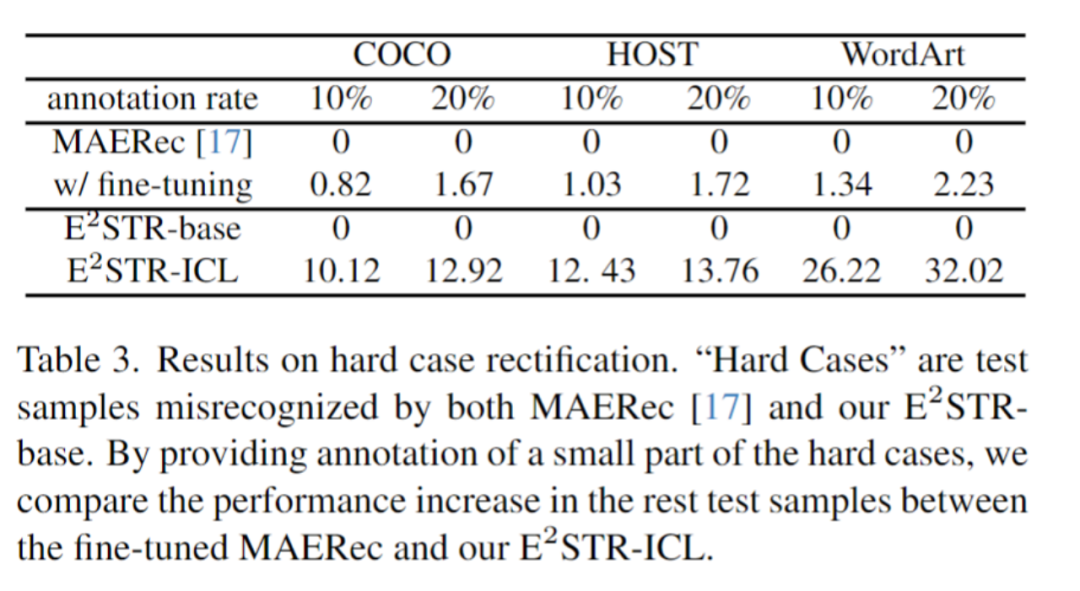

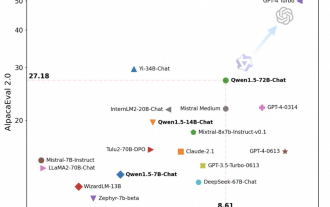

書き換えられた内容: 3. コンテキストに基づく推論 #テスト サンプルの場合、フレームワークは、視覚的潜在空間にあるコンテキスト キュー プールから N 個のサンプルを選択します。テストサンプルとの類似性が最も高くなります。具体的には、この記事では、ビジュアル トークン シーケンスのプーリングを平均することで画像埋め込み I を計算します。次に、画像埋め込みと I の間のコサイン類似度が最も高い上位 N 個のサンプルがコンテキスト プールから選択され、コンテキスト キューが形成されます。 コンテキスト キューとテスト サンプルが結合されてモデルに供給されると、E2STR はトレーニングなしでコンテキスト キューから新しい知識を学習します。これにより、テストサンプルの認識精度が向上します。コンテキスト キュー プールはビジュアル エンコーダーによって出力されたトークンのみを保持するため、コンテキスト キューの選択プロセスが非常に効率的になることに注意することが重要です。さらに、コンテキスト ヒント プールが小さく、E2STR では推論のトレーニングが必要ないため、追加の計算オーバーヘッドも最小限に抑えられます。 実験は主に 3 つの側面から実行されます: 従来のテキスト認識セット、クロスドメイン シーン認識、および困難なサンプル修正 #1. 従来のデータ セット トレーニング セットからランダムにいくつかのサンプル (1000、トレーニング セット内のサンプル数の 0.025%) を選択してコンテキスト プロンプト プールを形成し、それを 12 の一般的なシーン テキスト認識テスト セットでテストします。 ##E2STR は認識性能がほぼ飽和している従来のデータセットをさらに改善し、SOTA の性能を上回っていることがわかります。モデル 。 書き直す必要がある内容は次のとおりです。 2. クロスドメイン シナリオ 各テスト セットは、クロスドメインシナリオ ドメイン内トレーニングサンプルは 100 個のみ提供 トレーニングなしと微調整の比較結果は以下の通り E2STR は SOTA 法の微調整結果をも上回ります。 #書き直す必要がある内容は次のとおりです。 3. 難しいサンプルを修正します。 今後の見通し

実験

E2STR は、適切なトレーニングと推論戦略を使用すると、小規模モデルでも LLM と同様のコンテキスト内学習機能を備えられることを証明しています。リアルタイム要件が強い一部のタスクでは、小さなモデルを使用して新しいシナリオに迅速に適応することもできます。さらに重要なのは、単一モデルを使用して新しいシナリオへの迅速な適応を達成するこの方法により、統合された効率的な小規模モデルの構築に一歩近づくことができます。

以上が言い換えられたタイトルは次のとおりです: ByteDance と華東師範大学との協力: 小型モデルの文脈学習機能の探索の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7808

7808

15

15

1646

1646

14

14

1402

1402

52

52

1300

1300

25

25

1236

1236

29

29

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

0.この記事は何をするのですか?私たちは、多用途かつ高速な最先端の生成単眼深度推定モデルである DepthFM を提案します。従来の深度推定タスクに加えて、DepthFM は深度修復などの下流タスクでも最先端の機能を実証します。 DepthFM は効率的で、いくつかの推論ステップ内で深度マップを合成できます。この作品について一緒に読みましょう〜 1. 論文情報タイトル: DepthFM: FastMonocularDepthEstimationwithFlowMatching 著者: MingGui、JohannesS.Fischer、UlrichPrestel、PingchuanMa、Dmytr

エンコーダ/デコーダ アーキテクチャを放棄し、より効果的なエッジ検出に拡散モデルを使用する 国立防衛工科大学は DiffusionEdge を提案しました

Feb 07, 2024 pm 10:12 PM

エンコーダ/デコーダ アーキテクチャを放棄し、より効果的なエッジ検出に拡散モデルを使用する 国立防衛工科大学は DiffusionEdge を提案しました

Feb 07, 2024 pm 10:12 PM

現在のディープ エッジ検出ネットワークは通常、エンコーダ/デコーダ アーキテクチャを採用しています。このアーキテクチャには、マルチレベルの特徴をより適切に抽出するためのアップ サンプリング モジュールとダウン サンプリング モジュールが含まれています。ただし、この構造では、ネットワークが正確かつ詳細なエッジ検出結果を出力することが制限されます。この問題に対して、AAAI2024 に関する論文は新しい解決策を提供しています。論文のタイトル: DiffusionEdge:DiffusionProbabilisticModelforCrispEdgeDetection 著者: Ye Yunfan (国立国防技術大学)、Xu Kai (国立国防技術大学)、Huang Yuxing (国立国防技術大学)、Yi Renjiao (国立国防技術大学)、Cai Zhiping (防衛工科大学) 論文リンク:https://ar

Tongyi Qianwen が再びオープンソースになり、Qwen1.5 では 6 つのボリューム モデルが提供され、そのパフォーマンスは GPT3.5 を超えます

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen が再びオープンソースになり、Qwen1.5 では 6 つのボリューム モデルが提供され、そのパフォーマンスは GPT3.5 を超えます

Feb 07, 2024 pm 10:15 PM

春節に合わせて、Tongyi Qianwen Model (Qwen) のバージョン 1.5 がオンラインになりました。今朝、新しいバージョンのニュースが AI コミュニティの注目を集めました。大型モデルの新バージョンには、0.5B、1.8B、4B、7B、14B、72Bの6つのモデルサイズが含まれています。その中でも最強バージョンの性能はGPT3.5やMistral-Mediumを上回ります。このバージョンには Base モデルと Chat モデルが含まれており、多言語サポートを提供します。アリババの同義前文チームは、関連技術が同義前文公式ウェブサイトと同義前文アプリでもリリースされたと述べた。さらに、本日の Qwen 1.5 リリースには、32K のコンテキスト長のサポート、Base+Chat モデルのチェックポイントのオープン、および 32K のコンテキスト長のサポートなどのハイライトもあります。

大規模なモデルもスライスでき、Microsoft SliceGPT により LLAMA-2 の計算効率が大幅に向上します。

Jan 31, 2024 am 11:39 AM

大規模なモデルもスライスでき、Microsoft SliceGPT により LLAMA-2 の計算効率が大幅に向上します。

Jan 31, 2024 am 11:39 AM

大規模言語モデル (LLM) には通常、数十億のパラメーターがあり、数兆のトークンでトレーニングされます。ただし、このようなモデルのトレーニングとデプロイには非常にコストがかかります。計算要件を軽減するために、さまざまなモデル圧縮技術がよく使用されます。これらのモデル圧縮技術は一般に、蒸留、テンソル分解 (低ランク因数分解を含む)、枝刈り、および量子化の 4 つのカテゴリに分類できます。プルーニング手法は以前から存在していましたが、多くはパフォーマンスを維持するためにプルーニング後にリカバリ微調整 (RFT) を必要とするため、プロセス全体のコストが高くつき、拡張が困難になります。チューリッヒ工科大学とマイクロソフトの研究者は、この問題に対する SliceGPT と呼ばれる解決策を提案しました。この方法の中心となるアイデアは、重み行列の行と列を削除することでネットワークの埋め込みを減らすことです。

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

Gemini Pro に追いつき、推論機能と OCR 機能を向上させた LLaVA-1.6 は強力すぎます

Feb 01, 2024 pm 04:51 PM

Gemini Pro に追いつき、推論機能と OCR 機能を向上させた LLaVA-1.6 は強力すぎます

Feb 01, 2024 pm 04:51 PM

昨年 4 月、ウィスコンシン大学マディソン校、マイクロソフト リサーチ、コロンビア大学の研究者が共同で LLaVA (Large Language and Vision Assistant) をリリースしました。 LLaVA は小規模なマルチモーダル命令データセットでのみトレーニングされていますが、一部のサンプルでは GPT-4 と非常によく似た推論結果を示します。その後 10 月に、オリジナルの LLaVA に簡単な変更を加えて 11 のベンチマークの SOTA を更新した LLaVA-1.5 をリリースしました。このアップグレードの結果は非常に刺激的で、マルチモーダル AI アシスタントの分野に新たなブレークスルーをもたらします。研究チームは、推論、OCR、および

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

世界は狂ったように大きなモデルを構築していますが、インターネット上のデータだけではまったく不十分です。このトレーニング モデルは「ハンガー ゲーム」のようであり、世界中の AI 研究者は、データを貪欲に食べる人たちにどのように餌を与えるかを心配しています。この問題は、マルチモーダル タスクで特に顕著です。何もできなかった当時、中国人民大学学部のスタートアップチームは、独自の新しいモデルを使用して、中国で初めて「モデル生成データフィード自体」を実現しました。さらに、これは理解側と生成側の 2 つの側面からのアプローチであり、両方の側で高品質のマルチモーダルな新しいデータを生成し、モデル自体にデータのフィードバックを提供できます。モデルとは何ですか? Awaker 1.0 は、中関村フォーラムに登場したばかりの大型マルチモーダル モデルです。チームは誰ですか?ソフォンエンジン。人民大学ヒルハウス人工知能大学院の博士課程学生、ガオ・イージャオ氏によって設立されました。

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

何?ズートピアは国産AIによって実現するのか?ビデオとともに公開されたのは、「Keling」と呼ばれる新しい大規模な国産ビデオ生成モデルです。 Sora も同様の技術的ルートを使用し、自社開発の技術革新を多数組み合わせて、大きく合理的な動きをするだけでなく、物理世界の特性をシミュレートし、強力な概念的結合能力と想像力を備えたビデオを制作します。データによると、Keling は、最大 1080p の解像度で 30fps で最大 2 分の超長時間ビデオの生成をサポートし、複数のアスペクト比をサポートします。もう 1 つの重要な点は、Keling は研究所が公開したデモやビデオ結果のデモンストレーションではなく、ショートビデオ分野のリーダーである Kuaishou が立ち上げた製品レベルのアプリケーションであるということです。さらに、主な焦点は実用的であり、白紙小切手を書かず、リリースされたらすぐにオンラインに移行することです。Ke Ling の大型モデルは Kuaiying でリリースされました。