Amazon は、クラウド コンピューティングにおけるリーダーシップを守るためにあらゆる努力を払っています。一方では、自社のクラウド チップをアップグレードし、人工知能チャットボットである GPT の Amazon バージョンを開始しました。他方では、NVIDIA との協力を深め、NVIDIA チップをベースにした新しいサービスを開始し、NVIDIA と共同開発しました。スーパーコンピューター

AWS の副社長である Dave Brown 氏は、自社開発チップの設計を顧客にとって重要な実際のワークロードに重点を置くことで、AWS は最先端のクラウド インフラストラクチャを顧客に提供できると述べました。今回発売された Graviton 4 は、5 年以内に第 4 世代のチップ製品となり、生成 AI への関心が高まる中、第 2 世代の AI チップ Trainium 2 は、顧客がより低コストでより高いエネルギー効率で機械学習モデルをトレーニングできるよう支援します。

Graviton4 のコンピューティング パフォーマンスは、前世代と比較して最大 30% 向上しました

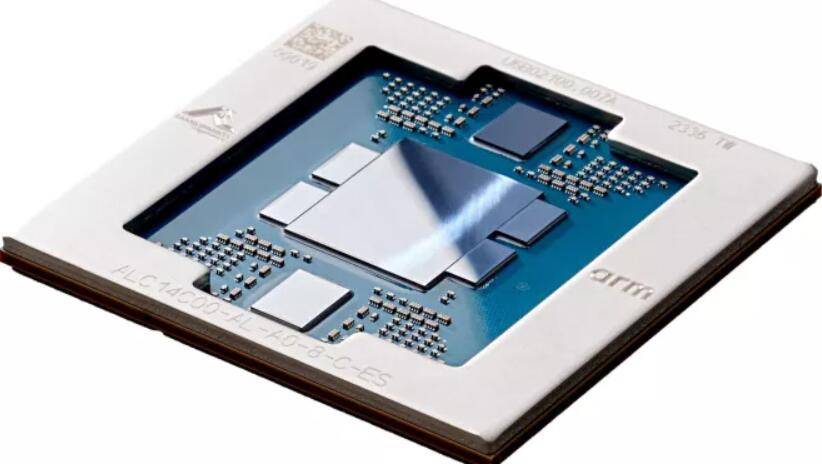

東部時間 11 月 28 日火曜日、Amazon のクラウド コンピューティング ビジネス AWS は、新世代の AWS 自社開発チップの発売を発表しました。中でも、汎用チップ Graviton4 の演算性能は前世代の Graviton3 に比べて最大 30% 向上し、コアは 50% 増加、メモリ帯域幅は 75% 増加し、最高のコストパフォーマンスとAmazon クラウド サーバー ホスティング サービス Amazon Elastic Compute Cloud (EC2) の効果によるエネルギー使用量。

Graviton4 は、すべての高速物理ハードウェア インターフェイスを完全に暗号化することでセキュリティを向上させます。 AWS によると、Graviton4 はメモリ最適化された Amazon EC2 R8g インスタンスで利用可能になり、顧客による高性能データベース、メモリ内キャッシュ、ビッグデータ分析ワークロードの実行の向上を支援します。 R8g インスタンスは、前世代の R7g インスタンスと比べて、最大 3 倍の vCPU と 3 倍のメモリを備えた、より大きなインスタンス サイズを提供します

今後数か月以内に、Graitons4 を搭載したコンピューターを発売する予定です。 AWS によると、プロジェクト Garviton が立ち上げられてから 5 年間で、200 万個を超える Garviton プロセッサが生産され、AWS EC2 の最初の 100 ユーザーが Graviton の使用を選択したとのことです

Trainium2 は 4 倍高速で、数兆のパラメーターを使用してモデルをトレーニングできます

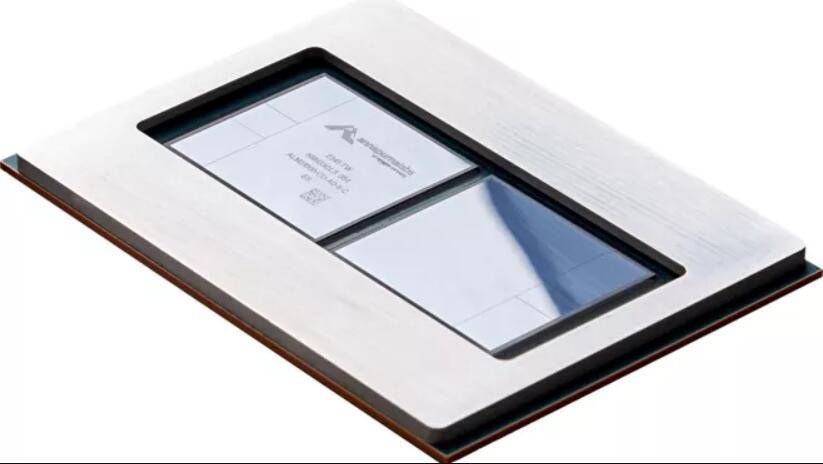

AWS は、前世代の Trainium1 より 4 倍高速な Trainium2 と呼ばれる新世代 AI チップを発売しました。 Trainium2 は EC2 UltraCluster に最大 100,000 個のチップをデプロイできるため、ユーザーはベース モデル (PM) と大規模言語モデル (LLM) を数兆のパラメータで短時間でトレーニングできます。前世代と比較して、Trainium2 のエネルギー利用量は 2 倍になりました

Trainium2 は Amazon EC2 Trn2 インスタンスで使用され、それぞれに 16 個の Trainium チップが含まれます。 Trn2 インスタンスは、顧客が次世代 EC2 UltraCluster のチップ アプリケーションの数を最大 100,000 個の Trainium2 チップに拡張し、AWS Elastic Fabrication Adapters (EFA) を介したペタバイト規模のネットワーク接続を通じて最大 65 Exach のコンピューティング能力を提供できるように設計されています

AWS によると、来年から新しいサービスのサポートに Trainium2 が使用される予定です

最初の主要顧客 DGX Cloud は、Grace Hopper GH200 NVL32 のアップグレード バージョンを使用しており、この GPU は最速の AI スーパーコンピューターを駆動します

年次カンファレンス re:Invent 中に、AWS と NVIDIA は火曜日、顧客の生成的な AI イノベーションを促進するために最先端のインフラストラクチャ、ソフトウェア、サービスを提供するための戦略的協力の拡大を発表しました。この協力には自社開発チップだけでなく、他の分野での協力も含まれます

AWS は、新しいマルチノード NVLink テクノロジー NVIDIA H200 Grace Hopper スーパー チップをクラウドで使用する最初のクラウド サービス プロバイダーになります。つまり、AWS は、Grace Hopper のアップグレード バージョンの最初の重要な顧客になります。

NVIDIA の H200 NVL32 マルチノード プラットフォームは、NVLink および NVSwitch テクノロジーを備えた 32 個の Grace Hopper チップを 1 つのインスタンスで使用します。このプラットフォームは、Amazon Network EFA に接続された Amazon EC2 インスタンス上で使用され、高度な仮想化 (AWS Nitro System) と超大規模クラスター (Amazon EC2 UltraClusters) によって強化され、Amazon と Nvidia の共同顧客がデプロイメントを数千に拡張できるようになります。 H200チップNVIDIA と AWS は、AWS 上で NVIDIA の AI Training-as-a-Service DGX Cloud をホストするために協力します。これは、GH200 NVL32 を搭載した最初の DGX クラウドとなり、開発者に最大の共有メモリを備えた単一インスタンスを提供します。 AWS の DGX クラウドは、最先端の生成 AI と 1 兆を超えるパラメータを持つ大規模言語モデルのトレーニング機能を強化します

NVIDIA と AWS は、世界最速の GPU を搭載した AI スーパーコンピューターを設計する Ceiba というプロジェクトで協力しています。 GH200 NVL32 と Amazon EFA の相互接続テクノロジーを搭載したこのコンピューターは大規模なシステムです。 16,384 個の GH200 スーパーチップを搭載し、65 エクサフロップスの AI 処理能力を備えています。 NVIDIA は、生成 AI イノベーションの次の波を推進するためにこれを使用する予定です

AWS は、チップとクラウド サービスの提供に加えて、Amazon Q と呼ばれる AI チャットボットのプレビュー バージョンもリリースしました。 Amazon Q は、生成 AI テクノロジーを使用して企業顧客のビジネス ニーズに基づいて機能する、新しいタイプのデジタル アシスタントです。企業顧客が情報を検索し、コードを記述し、ビジネス指標を確認するのに役立ちます

Q は、AWS 内のコードとドキュメントに関するトレーニングを受けており、開発者が AWS クラウドで使用できます。

開発者は Q を使用して、AWS 上でアプリケーションを作成し、ベストプラクティスを調査し、エラーを修正し、アプリケーションの新機能を記述する際の支援を受けることができます。ユーザーは、AWS コンソールから離れることなく、会話型 Q&A を通じて Q と対話して、新しい知識を学び、ベストプラクティスを調査し、AWS でアプリケーションを構築する方法を理解することができます

Amazon は、エンタープライズ インテリジェンス ソフトウェア、コールセンター ワーカー、物流管理向けのプログラムに Q を追加します。 AWS は、顧客は企業データや個人プロフィールに基づいて Q をカスタマイズできると述べています

会話型 Q&A は現在、AWS が提供するすべてのエンタープライズ リージョンでプレビューで利用可能です

以上がAmazon はクラウドの地位を守るために努力し、自社開発の AI チップをアップグレードし、チャットロボット Q をリリースし、Nvidia の新世代スーパーチップを初めて使用しましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。