13 の視覚言語タスクを完了してください!ハルビン工業大学、性能が5%向上したマルチモーダル大型モデル「Jiutian」をリリース

マルチモーダル大規模言語モデルにおける視覚情報の抽出が不十分であるという問題に対処するために、ハルビン工業大学 (深セン) の研究者は、二重層の知識を強化したマルチモーダル大規模言語モデルを提案しました。 JiuTian-ライオン)。

書き直す必要がある内容は次のとおりです: 論文リンク: https://arxiv.org/abs/2311.11860

GitHub: https://github.com/rshaojimmy/JiuTian

プロジェクト ホームページ: https://rshaojimmy.github.io/Projects/JiuTian-LION

既存の研究と比較して、Jutian は画像レベルの理解タスクと地域レベルの位置決めタスクの間の内部矛盾を初めて分析し、セグメント化された命令の微調整戦略とハイブリッドを提案しました。タスクの相互推進を両立するアダプタ。

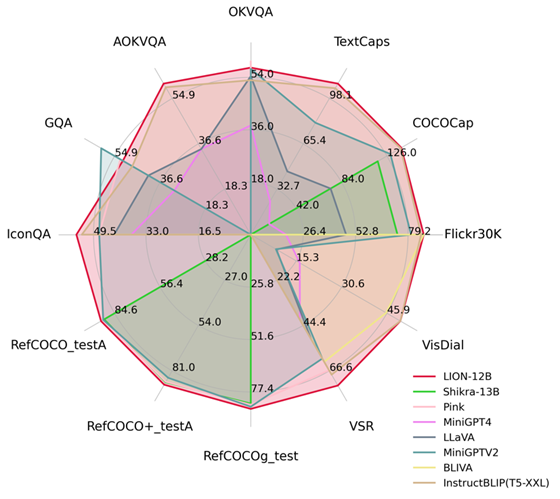

きめ細かい空間認識と高レベルの意味論的な視覚知識を注入することにより、Jutian は、画像の説明、視覚的な問題、視覚的なローカライゼーションを含む 17 の視覚言語タスクで大幅なパフォーマンスの向上を達成しました。たとえば、視覚的空間推論では最大 5% のパフォーマンス向上が見られ、13 の評価タスクにおいて国際トップレベルに達しています。パフォーマンスの比較を図 1 に示します。

図 1: 他の MLLM と比較して、Juitian はほとんどのタスクで最適なパフォーマンスを達成しました。

九天JiuTian-LION

大規模言語モデル (LLM) にマルチモーダル認識機能を提供することで、マルチモーダル大規模言語モデル (MLLM) を生成する取り組みが始まりました。多くの視覚言語タスクにおいて画期的な進歩を遂げました。ただし、既存の MLLM は主に、CLIP-ViT

などの画像とテキストのペアで事前トレーニングされたビジュアル エンコーダを使用します。これらのビジュアル エンコーダの主なタスクは、粗粒度の画像を学習することです。テキストモダリティは調整されていますが、詳細な視覚的理解を実現するための包括的な視覚認識と情報抽出機能が欠けています

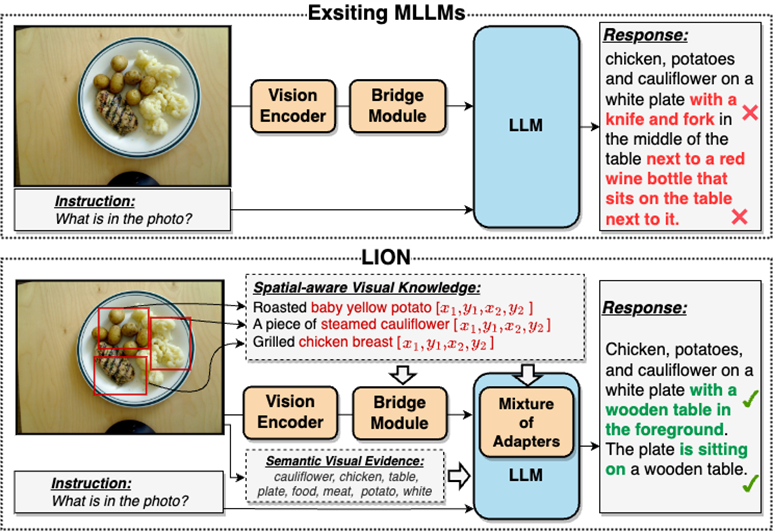

この視覚情報の抽出と理解は、ほとんどの場合不十分です。図 2

#に示すように、問題が不十分であると、視覚的位置特定バイアス、不十分な空間推論、物体の幻覚など、MLLM に複数の欠陥が発生します。図 2: JiuTian-LION は、二重層の視覚的知識で強化されたマルチモーダル大規模言語モデルです

JiuTian-LION を既存のマルチモーダル大規模言語モデル (MLLM) と比較します。きめの細かい空間認識の視覚的知識と高レベルの意味論的な視覚的証拠を注入することにより、MLLM の視覚理解能力を効果的に向上させ、より正確なテキスト応答を生成し、MLLM の幻覚現象を軽減します

二重層視覚知識強化マルチモーダル大規模言語モデル-JiuTian-LION

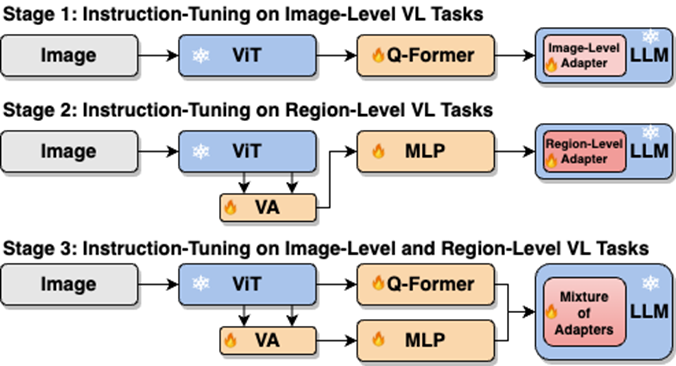

視覚情報の抽出と理解における MLLM の問題を解決するにはこの側面の欠点を解決するために、研究者らは、JiuTian-LION と呼ばれる 2 層の視覚的知識を強化した MLLM 手法を提案しました。具体的な手法のフレームワークを図 3 に示します。

この手法は、主に 2 つの側面から MLLM を強化し、きめの細かい空間認識視覚知識を段階的に統合します (きめの細かい空間認識の漸進的組み込み)視覚的な知識)と、ソフト プロンプトの下での高レベルのセマンティックな視覚的証拠のソフト プロンプト。

具体的には、研究者らは、画像レベルの理解タスクと領域レベルの位置特定タスクの間の内部矛盾を解決するために、セグメント化された命令の微調整戦略を提案しました。彼らは、MLLM に粒度の細かい空間認識の知識を徐々に注入します。同時に、高レベルの意味論的な視覚的証拠として画像ラベルを MLLM に追加し、ソフト ヒンティング手法を使用して、誤ったラベルによる潜在的な悪影響を軽減しました。 九天(JiuTian-LION) モデルのフレームワーク図は次のとおりです:

この作業では、セグメント化されたトレーニング戦略を使用して、まず Q-Former および Vision Aggregator-MLP ブランチに基づいてそれぞれ画像レベルの理解と地域レベルの測位タスクを学習し、次に、ルーティング メカニズムを備えたハイブリッド アダプターを利用します。最終トレーニング段階 2 つのタスクに関する知識向上モデルのさまざまなブランチのパフォーマンスを動的に統合します。

#この研究では、RAM を介して高レベルのセマンティックな視覚的証拠として画像タグも抽出し、高レベルのセマンティック インジェクションの効果を向上させるためのソフト プロンプト手法を提案します

きめ細かい空間認識視覚知識の漸進的融合

画像レベルの理解タスク (画像の説明と視覚的な質問を含む) を直接組み合わせる場合単一ステージのハイブリッド トレーニングを実行する場合、MLLM は 2 つのタスク間で内部矛盾に遭遇するため、すべてのタスクで全体的に良好なパフォーマンスを達成することはできません。

研究者らは、この内部対立は主に 2 つの問題によって引き起こされていると考えています。最初の問題は、地域レベルのモーダル アライメントの事前トレーニングが不足していることです。現在、地域レベルの測位機能を持つほとんどの MLLM は、まず事前トレーニングに大量の関連データを使用します。そうでない場合は、画像レベルの測位機能を使用することが困難になります。限られたトレーニングリソースに基づいたモーダルアライメント 地域レベルのタスクへの視覚的特徴の適応。

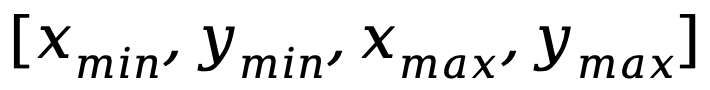

もう 1 つの問題は、画像レベルの理解タスクと領域レベルの位置特定タスクの間の入出力パターンの違いです。後者では、モデルがオブジェクトの座標に関する特定の短い文をさらに理解する必要があります (  形式で始まります)。上記の問題を解決するために、研究者らは、セグメント化された命令の微調整戦略とルーティング機構を備えたハイブリッドアダプターを提案しました。

形式で始まります)。上記の問題を解決するために、研究者らは、セグメント化された命令の微調整戦略とルーティング機構を備えたハイブリッドアダプターを提案しました。

図 4 に示すように、研究者は 1 段階の命令微調整プロセスを 3 つの段階に分割しました。

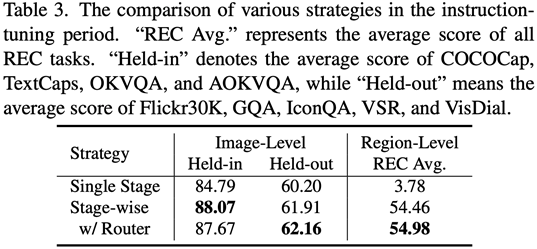

ViT、Q を使用- グローバルな視覚知識の画像レベルの理解タスクを学習するための元および画像レベルのアダプター; ビジョン アグリゲーター、MLP、および地域レベルのアダプターを使用して、きめの細かい空間認識視覚知識の地域レベルの位置決めタスクを学習する; ハイブリッドを提案する異なるブランチを動的に統合するためのルーティング メカニズムを備えたアダプター さまざまな粒度で学習された視覚的な知識。表 3 は、単一ステージのトレーニングに対するセグメント化された命令の微調整戦略のパフォーマンス上の利点を示しています。

図 4: セグメント化された命令の微調整戦略

ソフト プロンプトの下で挿入される高レベルのセマンティックな視覚的証拠については、書き換えが必要です

#研究者らは、MLLM の全体的な視覚認識の理解能力をさらに強化するために、高レベルの意味論的な視覚的証拠を効果的に補足するものとして画像ラベルを使用することを提案しています。 #Specific たとえば、最初に RAM を介してイメージ タグを抽出し、次に特定のコマンド テンプレート「に従って、次のタグの使用または部分的な使用が許可されています:」を使用してイメージ タグをラップします。コマンド テンプレートの「」は、学習可能なソフト プロンプト ベクトルに置き換えられます。

テンプレート内の特定のフレーズ「使用または部分的に使用」と組み合わせると、ソフト ヒント ベクトルは、誤ったラベルによる潜在的な悪影響を軽減するようにモデルをガイドできます。

研究者らは、画像キャプション (画像キャプション)、視覚的質問応答 (VQA)、および有向表現理解 (REC) を組み込みました。 17 のタスク ベンチマーク セットで評価されました。

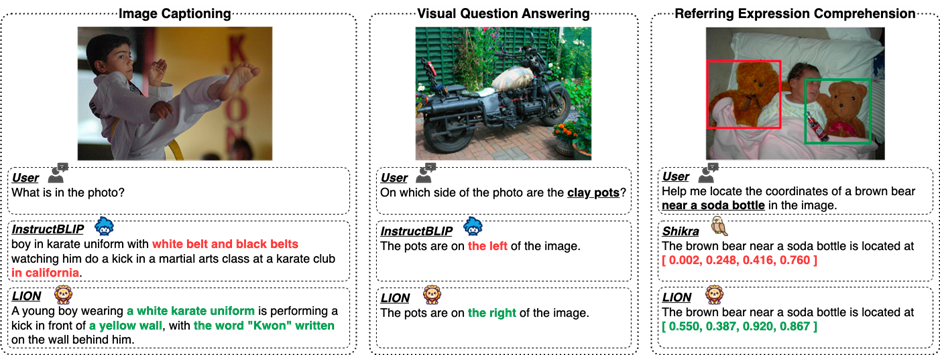

実験結果は、Juiutian が 13 の評価セットで国際トップレベルに到達したことを示しています。特に、InstructBLIP や Shikra と比較して、Jutian は画像レベルの理解タスクと領域レベルの位置決めタスクでそれぞれ包括的かつ一貫したパフォーマンスの向上を達成しており、視覚空間推論 (VSR) タスクでは最大 5% の向上を達成できます。

図 5 からわかるように、さまざまな視覚言語マルチモーダル タスクにおける Jiutian と他の MLLM の能力には差があり、きめ細かい視覚的理解と視空間推論能力において Jiutian の方が優れていることがわかります。また、錯覚を少なくしてテキスト応答を出力できるようになります。

#書き換えられた内容は次のとおりです。 5 番目の図は、9 日間の大規模モデルへの応答を示しています。 InstructBLIP と Shikra の能力差の定性分析

図 6 は、サンプル分析を通じて、Juitian モデルが画像レベルと地域レベルの両方の視覚言語タスクにおいて優れた理解および認識能力を備えていることを示しています。

6 番目の図: より多くの例の分析を通じて、画像と地域レベルの視覚的な観点から Jiutian 大型モデルの機能が実証されています。理解

#概要(1) この研究は、新しいマルチモーダル大規模言語モデル - Jiutian: 二重層の視覚的知識によって強化されたモデルを提案します。マルチモーダルな大規模言語モデル。

(2) この作業は、画像説明、視覚的質問応答、指示表現の理解などを含む 17 の視覚言語タスク ベンチマーク セットで評価され、そのうち 13 の評価セットが現在の最高のパフォーマンスに達しました。

(3) この研究では、画像レベルの理解タスクと領域レベルのローカリゼーションタスクの間の内部矛盾を解決するためのセグメント化された命令の微調整戦略を提案し、タスク間の 2 つの相互改善を実装します

(4) この研究では、画像レベルの理解と地域レベルの位置決めタスクをうまく統合して、視覚的なシーンを複数のレベルで包括的に理解することができ、この包括的なアプローチは将来的にも使用できます。具現化されたインテリジェントなシナリオに適用されることで、ロボットが現在の環境をより適切かつ包括的に識別して理解し、効果的な意思決定を行えるようになります。

以上が13 の視覚言語タスクを完了してください!ハルビン工業大学、性能が5%向上したマルチモーダル大型モデル「Jiutian」をリリースの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1664

1664

14

14

1421

1421

52

52

1315

1315

25

25

1266

1266

29

29

1239

1239

24

24

2025年のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの1つです

Apr 28, 2025 pm 08:12 PM

2025年のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの1つです

Apr 28, 2025 pm 08:12 PM

2025年の世界の上位10の暗号通貨取引所には、Binance、Okx、Gate.io、Coinbase、Kraken、Huobi、Bitfinex、Kucoin、Bittrex、Poloniexが含まれます。これらはすべて、高い取引量とセキュリティで知られています。

CでDMA操作を理解する方法は?

Apr 28, 2025 pm 10:09 PM

CでDMA操作を理解する方法は?

Apr 28, 2025 pm 10:09 PM

CのDMAとは、直接メモリアクセステクノロジーであるDirectMemoryAccessを指し、ハードウェアデバイスがCPU介入なしでメモリに直接データを送信できるようにします。 1)DMA操作は、ハードウェアデバイスとドライバーに大きく依存しており、実装方法はシステムごとに異なります。 2)メモリへの直接アクセスは、セキュリティリスクをもたらす可能性があり、コードの正確性とセキュリティを確保する必要があります。 3)DMAはパフォーマンスを改善できますが、不適切な使用はシステムのパフォーマンスの低下につながる可能性があります。実践と学習を通じて、DMAを使用するスキルを習得し、高速データ送信やリアルタイム信号処理などのシナリオでその効果を最大化できます。

CでChronoライブラリを使用する方法は?

Apr 28, 2025 pm 10:18 PM

CでChronoライブラリを使用する方法は?

Apr 28, 2025 pm 10:18 PM

CでChronoライブラリを使用すると、時間と時間の間隔をより正確に制御できます。このライブラリの魅力を探りましょう。 CのChronoライブラリは、時間と時間の間隔に対処するための最新の方法を提供する標準ライブラリの一部です。 Time.HとCtimeに苦しんでいるプログラマーにとって、Chronoは間違いなく恩恵です。コードの読みやすさと保守性を向上させるだけでなく、より高い精度と柔軟性も提供します。基本から始めましょう。 Chronoライブラリには、主に次の重要なコンポーネントが含まれています。STD:: Chrono :: System_Clock:現在の時間を取得するために使用されるシステムクロックを表します。 STD :: Chron

CでハイDPIディスプレイを処理する方法は?

Apr 28, 2025 pm 09:57 PM

CでハイDPIディスプレイを処理する方法は?

Apr 28, 2025 pm 09:57 PM

CでのハイDPIディスプレイの取り扱いは、次の手順で達成できます。1)DPIを理解してスケーリングし、オペレーティングシステムAPIを使用してDPI情報を取得し、グラフィックスの出力を調整します。 2)クロスプラットフォームの互換性を処理し、SDLやQTなどのクロスプラットフォームグラフィックライブラリを使用します。 3)パフォーマンスの最適化を実行し、キャッシュ、ハードウェアアクセラレーション、および詳細レベルの動的調整によりパフォーマンスを改善します。 4)ぼやけたテキストやインターフェイス要素などの一般的な問題を解決し、DPIスケーリングを正しく適用することで解決します。

Cのリアルタイムオペレーティングシステムプログラミングとは何ですか?

Apr 28, 2025 pm 10:15 PM

Cのリアルタイムオペレーティングシステムプログラミングとは何ですか?

Apr 28, 2025 pm 10:15 PM

Cは、リアルタイムオペレーティングシステム(RTOS)プログラミングでうまく機能し、効率的な実行効率と正確な時間管理を提供します。 1)Cハードウェアリソースの直接的な動作と効率的なメモリ管理を通じて、RTOのニーズを満たします。 2)オブジェクト指向の機能を使用して、Cは柔軟なタスクスケジューリングシステムを設計できます。 3)Cは効率的な割り込み処理をサポートしますが、リアルタイムを確保するには、動的メモリの割り当てと例外処理を避ける必要があります。 4)テンプレートプログラミングとインライン関数は、パフォーマンスの最適化に役立ちます。 5)実際のアプリケーションでは、Cを使用して効率的なロギングシステムを実装できます。

定量的交換ランキング2025デジタル通貨のトップ10の推奨事項定量取引アプリ

Apr 30, 2025 pm 07:24 PM

定量的交換ランキング2025デジタル通貨のトップ10の推奨事項定量取引アプリ

Apr 30, 2025 pm 07:24 PM

交換に組み込まれた量子化ツールには、1。Binance:Binance先物の定量的モジュール、低い取り扱い手数料を提供し、AIアシストトランザクションをサポートします。 2。OKX(OUYI):マルチアカウント管理とインテリジェントな注文ルーティングをサポートし、制度レベルのリスク制御を提供します。独立した定量的戦略プラットフォームには、3。3Commas:ドラッグアンドドロップ戦略ジェネレーター、マルチプラットフォームヘッジアービトラージに適しています。 4。Quadency:カスタマイズされたリスクしきい値をサポートするプロフェッショナルレベルのアルゴリズム戦略ライブラリ。 5。Pionex:組み込み16のプリセット戦略、低い取引手数料。垂直ドメインツールには、6。cryptohopper:クラウドベースの定量的プラットフォーム、150の技術指標をサポートします。 7。BITSGAP:

Cのスレッドパフォーマンスを測定する方法は?

Apr 28, 2025 pm 10:21 PM

Cのスレッドパフォーマンスを測定する方法は?

Apr 28, 2025 pm 10:21 PM

Cのスレッドパフォーマンスの測定は、標準ライブラリのタイミングツール、パフォーマンス分析ツール、およびカスタムタイマーを使用できます。 1.ライブラリを使用して、実行時間を測定します。 2。パフォーマンス分析にはGPROFを使用します。手順には、コンピレーション中に-pgオプションを追加し、プログラムを実行してGmon.outファイルを生成し、パフォーマンスレポートの生成が含まれます。 3. ValgrindのCallGrindモジュールを使用して、より詳細な分析を実行します。手順には、プログラムを実行してCallGrind.outファイルを生成し、Kcachegrindを使用して結果を表示することが含まれます。 4.カスタムタイマーは、特定のコードセグメントの実行時間を柔軟に測定できます。これらの方法は、スレッドのパフォーマンスを完全に理解し、コードを最適化するのに役立ちます。

MySQLにデータを挿入する効率的な方法

Apr 29, 2025 pm 04:18 PM

MySQLにデータを挿入する効率的な方法

Apr 29, 2025 pm 04:18 PM

MySQLでデータを挿入するための効率的な方法には、次のものが含まれます。1。insertInto ...値構文、2。LoadDatainFileコマンドの使用、3。トランザクション処理の使用、4。バッチサイズの調整、5。Insurtignoreまたは挿入の使用...